智能体记忆机制演进之路:从RAG到智能体记忆的演进

本文探讨了AI智能体记忆机制的演进过程,从最初的检索增强生成(RAG)到智能体RAG,再到智能体记忆系统。RAG通过外部知识源增强LLM回答,智能体RAG将其发展为工具调用形式,而智能体记忆则进一步实现了信息的读写功能。文章指出智能体记忆通过记忆管理系统,不仅能检索还能存储信息,使AI具备学习能力。虽然这是一个简化模型,实际实现涉及更复杂的记忆分类和管理策略。文章最后强调AI领域快速发展,鼓励读者

在学习AI智能体的记忆机制时,我发现自己被各种新术语搞得晕头转向。一开始是短期记忆和长期记忆,接着又出现了程序性记忆、情景记忆和语义记忆,让人更加困惑。但等等,语义记忆让我想起了一个熟悉的概念:检索增强生成(RAG)。

智能体中的记忆机制会不会是RAG从最初的形态演进到智能体RAG之后的下一步呢?从本质上讲,智能体中的记忆就是在大语言模型(LLM)的上下文窗口中进行信息的输入和输出。至于把这些信息称为"记忆"还是"事实",在这个抽象层面上都不是重点。

这篇文章将从一个不同的角度来介绍AI智能体中的记忆机制。我们不会(立即)讨论短期和长期记忆,而是从最初的RAG概念开始,逐步演进到智能体RAG,最后到达AI智能体的记忆机制。(需要注意的是,这只是一个简化的思维模型。智能体记忆这个完整的话题在底层实现上要复杂得多,涉及到诸如记忆管理系统等内容。)

RAG:一次性只读操作

检索增强生成(RAG)的概念在2020年由Lewis等人提出,并在2023年前后开始流行。这是第一个让无状态的LLM能够访问过去对话和训练期间未曾见过并存储在模型权重中的知识(参数化知识)的概念。

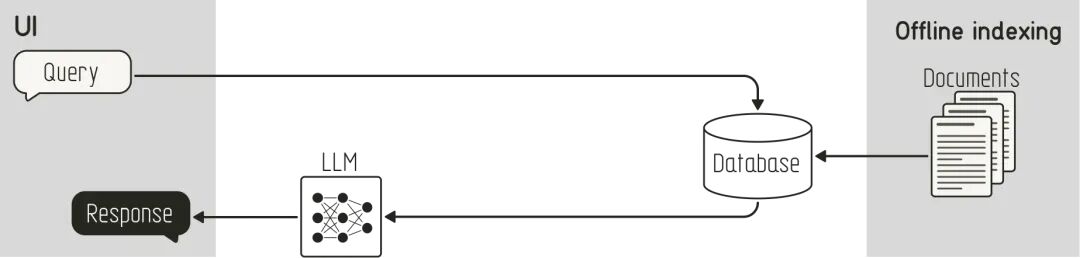

最初的RAG工作流程的核心思想非常直接,如下图所示:

- 离线索引阶段:将额外信息存储在外部知识源中(例如向量数据库)

- 查询阶段:使用用户的查询从外部知识源中检索相关上下文。将检索到的上下文连同用户查询一起输入LLM,获得基于这些额外信息的回答。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

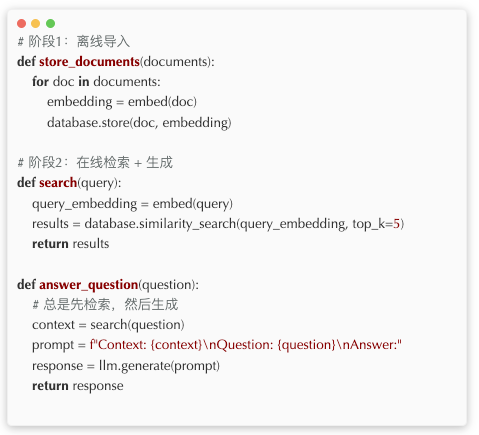

下面的伪代码展示了最初的RAG工作流程:

虽然最初的RAG方法在简单用例中能够有效减少幻觉问题,但它有一个关键限制:这是一次性的解决方案。

- 通常会从外部知识源检索额外信息,而不会先判断是否真的需要

- 信息只检索一次,不管检索到的信息是否相关或正确

- 所有额外信息都只来自一个外部知识源

这些限制意味着对于更复杂的用例,如果检索到的上下文与用户查询不相关甚至是错误的,LLM仍然可能产生幻觉。

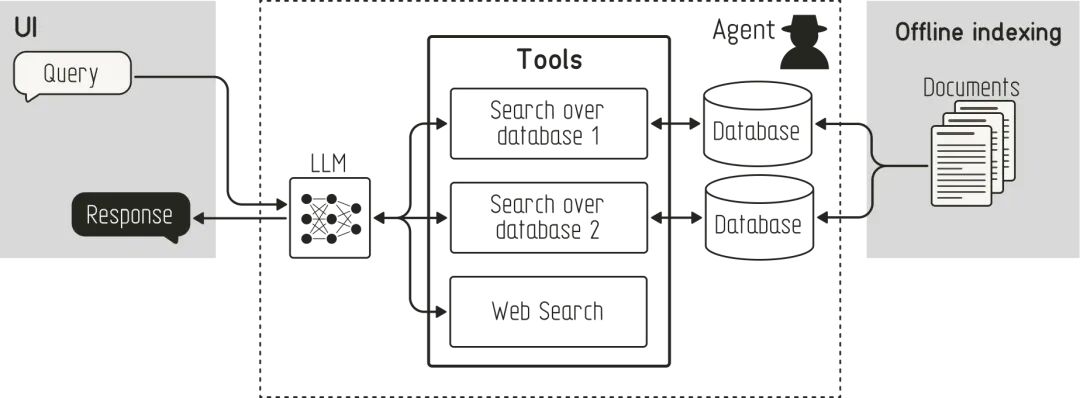

智能体RAG:通过工具调用实现只读

智能体RAG解决了最初RAG的许多局限性:它将检索步骤定义为智能体可以使用的工具。这一改变使得智能体能够首先判断是否需要额外信息,决定使用哪个工具进行检索(例如,存储专有数据的数据库与网络搜索),并评估检索到的信息是否与用户查询相关。

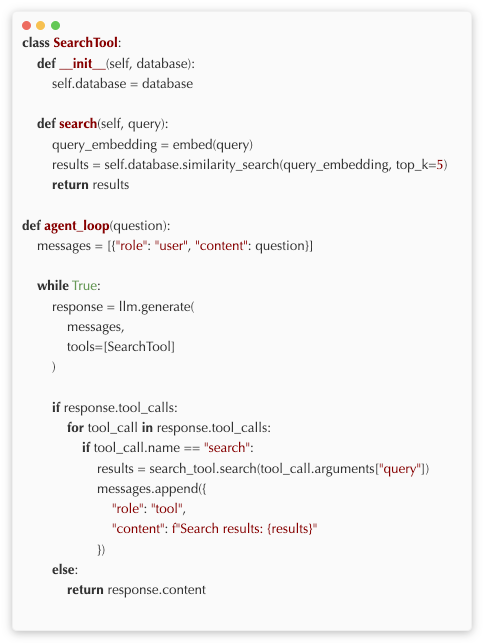

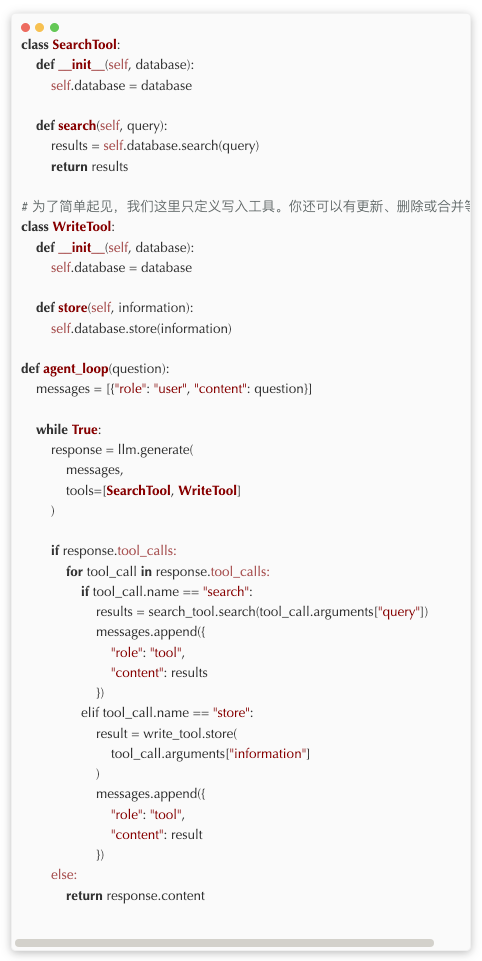

下面的伪代码展示了智能体如何在智能体RAG工作流程中调用SearchTool:

最初的RAG和智能体RAG的一个共同点是,信息是离线存储在数据库中的,而不是在推理过程中存储。这意味着数据只能被智能体检索,而不能在推理过程中写入、修改或删除。这个限制意味着最初的RAG和智能体RAG系统(默认情况下)都无法从过去的交互中学习和改进。

智能体记忆:通过工具调用实现读写

智能体记忆通过引入记忆管理概念,克服了最初RAG和智能体RAG的这一限制。这使得智能体能够从过去的交互中学习,并通过更个性化的方式提升用户体验。

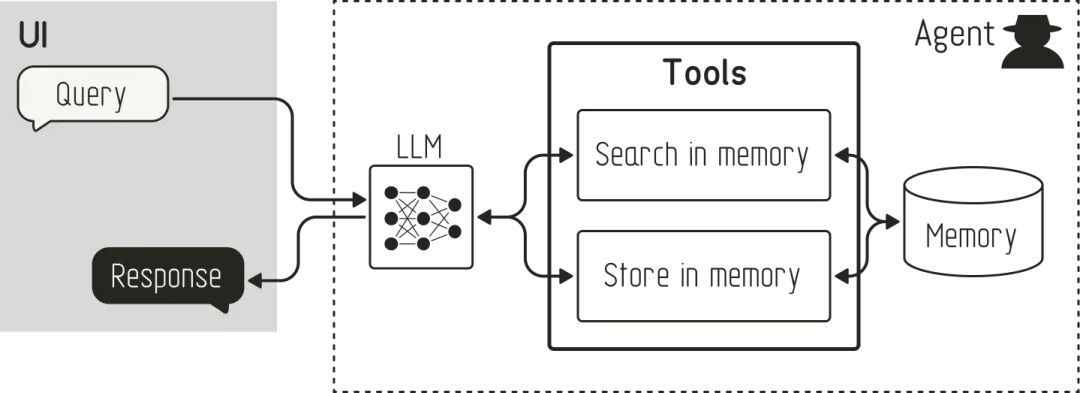

智能体记忆的概念建立在智能体RAG的基本原则之上。它同样使用工具从外部知识源(记忆)中检索信息。但与智能体RAG不同的是,智能体记忆还使用工具向外部知识源写入信息,如下所示:

这使得智能体不仅能够从记忆中回忆,还能够"记住"信息。在最简单的形式中,你可以在交互后将原始对话历史存储在一个集合中。然后,智能体可以搜索过去的对话来找到相关信息。如果你想扩展这一功能,可以提示记忆管理系统创建对话摘要以供将来参考。此外,你还可以让智能体在对话过程中注意到重要信息(例如,用户提到喜欢使用表情符号或提到自己的生日),并基于这个事件创建记忆。

下面的伪代码展示了智能体记忆的概念如何通过WriteTool扩展智能体RAG的思想,使智能体能够存储信息:

这个简化思维模型的局限性

如本文开头所述,这种对AI智能体记忆的比较只是一个简化的思维模型。它帮助我将其与我已经熟悉的概念联系起来。但为了避免让AI智能体记忆的整个话题看起来只是带有写操作的智能体RAG的扩展,我想强调一下这种简化的一些局限性:

上面对AI智能体记忆的说明为了清晰起见进行了简化。它只显示了单一的记忆源。然而,在实践中,你可以为不同类型的记忆使用多个源:你可以为以下内容使用单独的数据集合:

- "程序性"记忆(例如,“与用户互动时使用表情符号”)

- "情景性"记忆(例如,“用户在10月30日谈论计划旅行”)

- "语义性"记忆(例如,“埃菲尔铁塔高330米”)

正如CoALA论文中所讨论的。此外,你还可以为原始对话历史设置一个单独的数据集合。

上述说明的另一个简化是,它缺少超越CRUD操作的记忆管理策略,就像MemGPT中所见的那样。

此外,虽然智能体记忆实现了持久化,但它也引入了RAG和智能体RAG没有的新挑战:记忆损坏以及对记忆管理策略(如遗忘)的需求。

总结

从本质上讲,RAG、智能体RAG和智能体记忆都是关于如何创建、读取、更新和删除存储在外部知识源(例如文本文件或数据库)中的信息。

最初,优化最初RAG的关键焦点在于优化检索方面,例如使用不同的检索技术,如向量搜索、混合搜索或基于关键词的搜索(“如何检索信息”)。然后,焦点转向使用正确的工具从不同的知识源检索信息(“我需要检索信息吗?如果需要,从哪里检索?”)。在过去一年中,随着智能体记忆的出现,焦点再次转移。这次转向了信息是如何管理的:虽然RAG和智能体RAG非常关注检索方面,但记忆机制涵盖了在外部知识源中创建、修改和删除数据的过程。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

更多推荐

已为社区贡献92条内容

已为社区贡献92条内容

所有评论(0)