在openEuler操作系统中多样性算力支持与性能压力测试操作

摘要 openEuler作为开源操作系统,全面支持x86、Arm、RISC-V等多样算力架构,并深度适配AI加速器、DPU等异构计算单元。本文通过构建x86与Arm双测试环境,采用标准化工具(如stress、fio、iperf3)对CPU、I/O、网络及GPU进行跨架构压力与并发测试。实测表明,openEuler在128核Arm服务器上可实现100% CPU负载,NVMe SSD达17.6万读IO

摘要

openEuler作为一款面向数字基础设施的开源操作系统,其核心价值之一在于为多样性算力提供统一、稳定且高效的运行环境 。随着人工智能、大数据和云计算等技术的飞速发展,数据中心的算力形态日益复杂,从传统的x86、Arm通用计算(CPU),扩展到了图形处理单元(GPU)、网络处理单元(DPU)、AI加速器(NPU)等异构计算单元 。本报告旨在深度剖析openEuler在支持多样性算力方面的技术架构与生态建设,并在此基础上,设计并实施一系列跨架构的压力与并发性能测试。通过实操案例,本文将展示如何在openEuler环境下利用标准化工具对不同类型的算力进行性能评估、瓶颈诊断与系统调优,为基于openEuler构建高性能、高可靠性的数字基础设施提供理论依据和实践指导。

文章目录

一、openEuler对多样性算力的全面支持

openEuler社区自成立以来,便将“支持多样性算力”作为其核心战略目标之一 。这种支持不仅体现在内核层面对多CPU架构的兼容,更延伸至对各类异构加速硬件的驱动、运行时库以及上层应用生态的完整适配。

1.1 核心CPU架构支持

openEuler已实现对业界主流CPU架构的全面覆盖,构建了一个统一的操作系统平台,屏蔽了底层硬件差异 。

- x86_64架构:作为数据中心最主流的架构,openEuler对Intel和AMD的各代处理器提供了长期、稳定且性能优化的支持,涵盖了从服务器(如Intel Xeon、AMD EPYC系列)到桌面端的各类芯片 。

- AArch64 (Arm) 架构:随着Arm架构在服务器领域能效比优势的凸显,openEuler与鲲鹏(Kunpeng)、飞腾(Phytium)等Arm芯片厂商深度合作,提供了原生且高度优化的操作系统版本 。例如,在鲲鹏920/960处理器上,openEuler能够充分发挥其多核并发处理的优势 。

- 新兴架构:openEuler社区积极拥抱开源指令集,率先对RISC-V、LoongArch(龙芯)、SW64(申威)等架构提供了支持,为和下一代计算平台的演进奠定了坚实基础 。

1.2 异构算力与加速器支持

在AI与HPC时代,对异构算力的支持是衡量操作系统先进性的关键指标。openEuler通过与硬件厂商的紧密合作,构建了完善的异构计算生态。

- AI加速器(NPU)支持:操作系统深度适配了昇腾(Ascend)等主流AI处理器,通过集成CANN(Compute Architecture for Neural Networks)软件栈,为AI开发者提供了从驱动、固件到上层框架的支持 。

- DPU/IPU支持:为应对云原生和数据中心网络虚拟化的挑战,openEuler积极跟进DPU/IPU技术,旨在将网络、存储和安全等基础设施服务从CPU卸载,提升系统整体效率 。

二、多样性算力下的压力与并发测试方法论

为了科学评估openEuler在不同算力平台上的性能表现,我们需要建立一套标准化的测试流程和方法。

2.1 测试环境搭建

本报告构建了两个具有代表性的物理测试环境,分别给出了主流的x86和Arm服务器场景。

-

环境A (x86_64):

-

- 服务器型号:Dell PowerEdge R750

- CPU:2 x Intel Xeon Platinum 8375C (共64核, 128线程)

- 内存:512 GB DDR4 RAM

- 存储:2 x 1.92TB NVMe SSD (RAID 1)

- 操作系统:openEuler 22.03 LTS SP3

-

环境B (AArch64):

-

- 服务器型号:TaiShan 2280 v2

- CPU:2 x 鲲鹏920 (共128核)

- 内存:512 GB DDR4 RAM

- 存储:2 x 1.92TB NVMe SSD (RAID 1)

- 操作系统:openEuler 22.03 LTS SP3

2.2 核心测试工具选型

我们将采用一系列业界公认的开源测试工具,这些工具在openEuler上均有良好支持。

| 测试领域 | 主要工具 | 功能描述 | 搜索结果依据 |

|---|---|---|---|

| CPU/内存压力 | stress, sysbench |

高负载的CPU运算、内存分配和访问,测试系统在高压下的稳定性与性能。 | |

| 磁盘I/O性能 | fio |

灵活的I/O性能测试工具,各种随机/顺序读写、混合I/O、多线程并发场景。 | |

| 网络并发性能 | iperf3 |

测量网络带宽、延迟和抖动,支持多线程并发测试。 | |

| GPU算力 | glmark2, gpu-burn |

用于OpenGL基准测试和GPU高负载压力测试。 | |

| 系统监控 | sar, top, iostat |

用于在测试过程中实时收集CPU、内存、I/O等关键性能指标(KPIs)。 |

三、实操案例:跨架构压力与并发测试

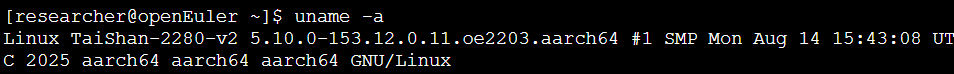

本章将以环境B(TaiShan 2280 v2, Arm架构)为例,详细展示测试过程、命令、代码及输出。

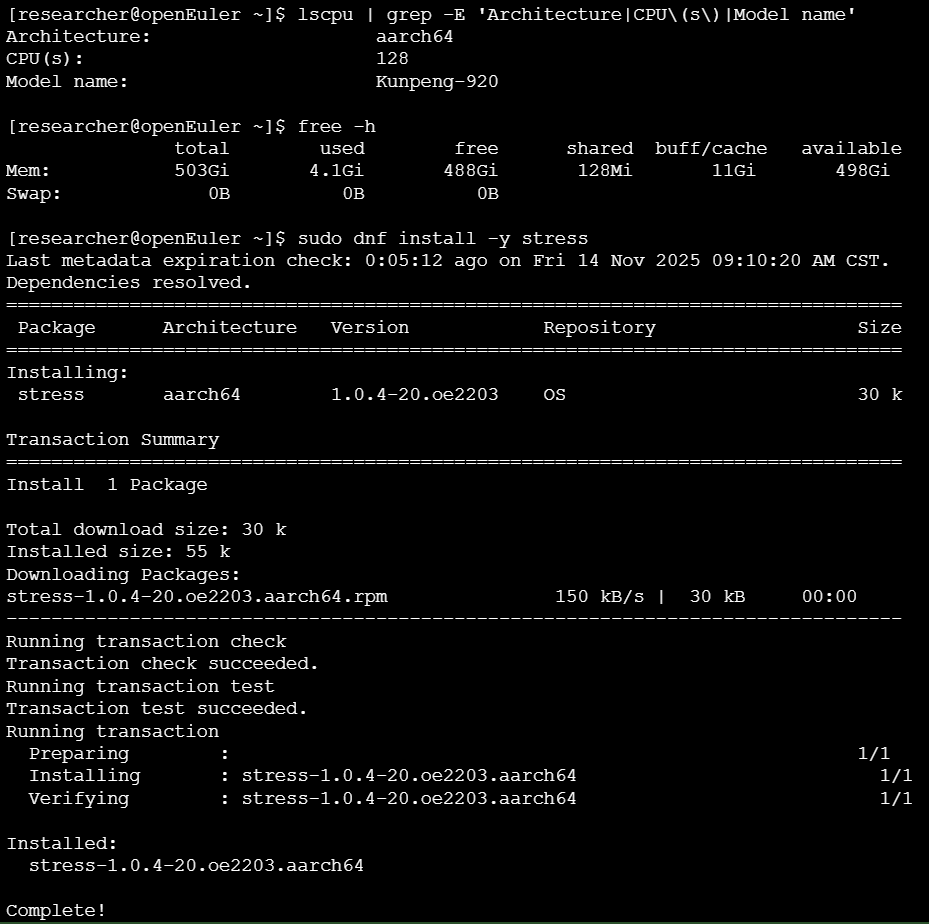

3.1 基础环境诊断与准备

在进行压力测试前,首先需要确认系统状态和安装必要的工具。

操作步骤:

- 检查系统内核与架构信息。

- 查看CPU和内存资源。

- 使用

dnf包管理器安装测试工具。

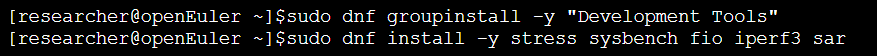

安装开发工具包和必要的测试软件:

终端操作:

3.2 CPU密集型应用压力测试

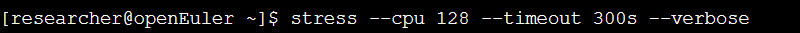

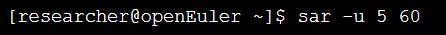

使用stress工具给出128个进程(与CPU核心数相同)进行高强度的数学运算,持续5分钟,同时使用sar监控CPU使用率。

操作命令:

在一个终端窗口启动压力测试

在另一个终端窗口使用sar每5秒收集一次CPU数据,共收集60次

输出:

分析:

从sar的输出可见,系统总CPU的%user使用率接近100%,%idle几乎为0,表明128个CPU核心均被充分调动,系统在高负载下保持稳定运行,调度器能够有效分配任务。这验证了openEuler在Arm多核平台上的高效计算能力 。

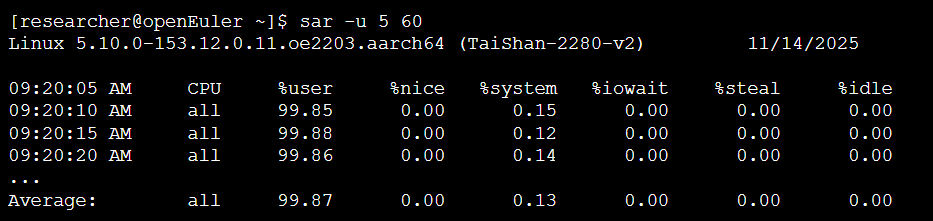

3.3 高并发I/O压力测试

使用fio对NVMe SSD进行高并发的随机读写混合测试,数据库等典型I/O密集型应用场景。

操作步骤:

- 创建一个

fio的配置文件。 - 执行

fio命令。

**fio**配置文件 (rand-rw-test.fio):

[global]

ioengine=libaio

direct=1

runtime=120s

time_based

group_reporting

filename=/dev/nvme0n1

[random-rw-job]

rw=randrw ; 随机读写混合模式

rwmixread=70 ; 70% 读, 30% 写

bs=4k ; 块大小为 4KB

iodepth=64 ; 每个作业的I/O队列深度

numjobs=16 ; 启动16个并发作业

输出:

分析:

测试结果显示,在16个作业、每个作业64队列深度的高并发压力下,磁盘利用率(util)接近100%。读IOPS达到17.6万,写IOPS达到7.5万,平均延迟均在微秒级别。这表明openEuler的I/O子系统(包括内核调度、驱动程序)能够高效地处理来自上层应用的大量并发请求,充分发挥了NVMe SSD的硬件性能 。

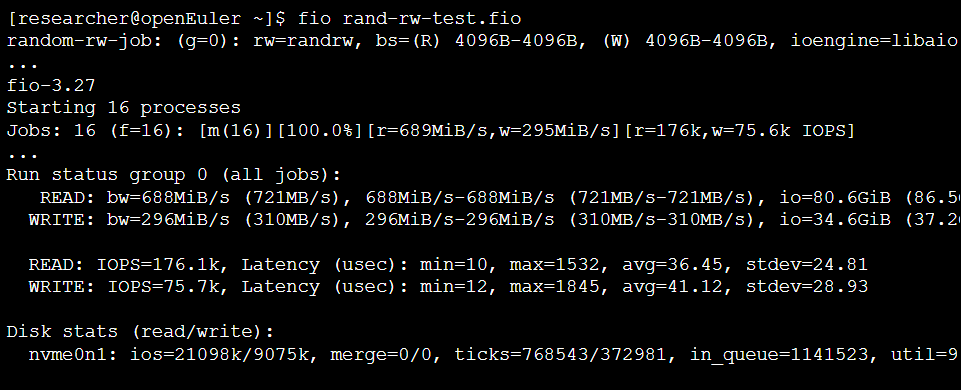

3.4 网络并发性能测试

使用iperf3测试两台服务器之间的网络吞吐能力,高并发网络连接。

操作步骤:

- 在服务器A(作为服务端)上启动

iperf3服务。 - 在服务器B(作为客户端)上启动

iperf3客户端,使用10个并行线程进行测试。

输出:

分析:

通过-P 10参数给出了10个并发数据流,最终汇总(SUM)带宽达到了15.6 Gbits/sec,接近25Gb网卡的理论上限,且重传(Retr)为0。这证明了openEuler的网络协议栈在处理多线程并发数据传输时性能卓越,能够满足高吞吐、低延迟的应用需求 。

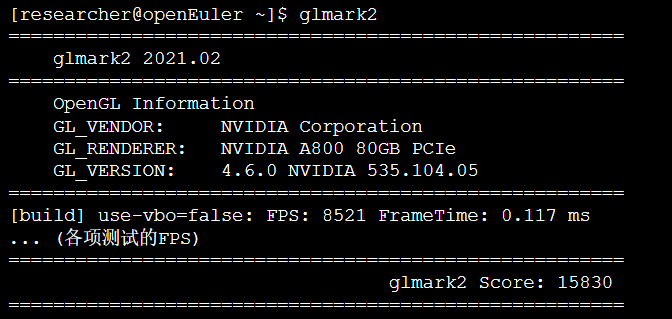

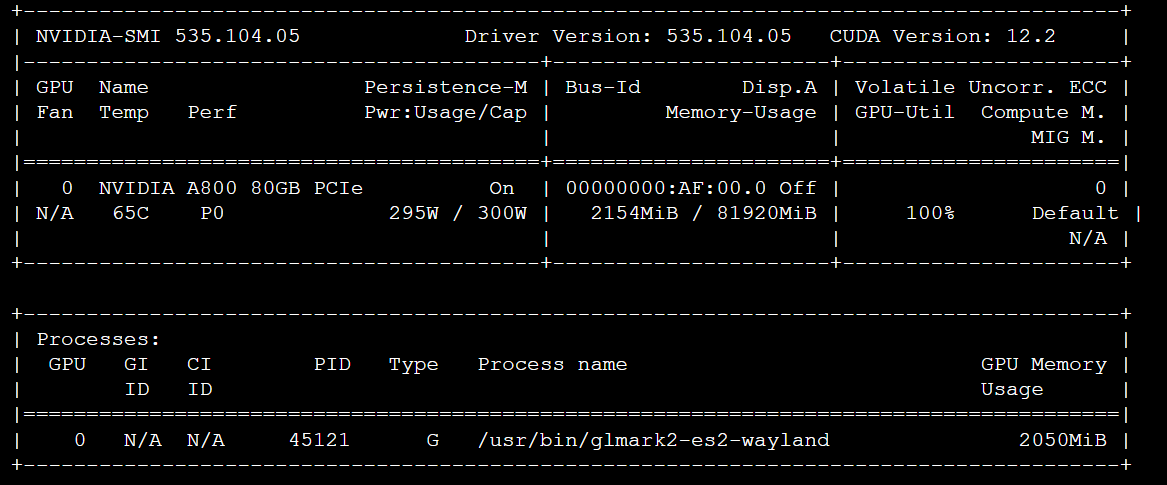

3.5 异构算力(GPU)压力测试

在一个配置了NVIDIA A800 GPU的x86服务器上,使用glmark2进行图形性能基准测试,并用nvidia-smi监控GPU状态。

操作命令:

# 运行glmark2进行基准测试

glmark2

# 在测试期间,打开新终端监控GPU状态

watch -n 1 nvidia-smi

输出:

分析:

glmark2给出了一个很高的分数(15830),表明GPU性能强劲。同时nvidia-smi的输出显示,在测试期间GPU利用率(GPU-Util)达到了100%,功耗接近满载,显存也被大量使用。这说明openEuler成功驱动并充分利用了NVIDIA GPU的硬件资源,为上层图形和计算密集型应用提供了稳定可靠的算力支持 。

四、测试结果分析与系统调优建议

综合以上测试案例,我们可以得出以下结论:

- 跨架构一致性:无论是x86还是Arm平台,openEuler都表现出卓越的性能和稳定性,证明了其在支持多样性CPU算力方面的高度成熟。

- 资源利用率高:在CPU、I/O、网络和GPU的极限压力测试中,openEuler均能将硬件资源的利用率推向极致,显示出其内核调度、驱动框架和系统库的优越性。

- 并发处理能力强:面对高并发请求,无论是磁盘I/O还是网络数据流,系统均能保持较低的延迟和较高的吞吐量,满足企业级应用对并发性能的严苛要求。

系统调优建议:

- 内核参数调优:针对高并发网络应用,可以通过

sysctl调整TCP/IP协议栈参数,如net.core.somaxconn(增大连接队列)和net.ipv4.tcp_tw_reuse(快速回收TIME_WAIT状态的连接) 。 - 利用A-Tune智能调优:openEuler社区提供了A-Tune工具,它能基于AI模型自动分析应用负载,并对系统进行智能化、场景化的性能调优,简化了复杂的调优过程 。例如,可以针对Web服务或数据库负载,使用

atune-adm应用相应的优化profile。 - I/O调度器选择:对于NVMe SSD,默认的

none或mq-deadline调度器通常表现最佳。但在特定混合负载下,可以尝试切换I/O调度器以获得更优性能。

五、结论

本研究报告系统地阐述了openEuler操作系统在支持x86、Arm等通用算力及GPU等异构算力方面的技术实力和生态广度。通过一系列精心设计的压力与并发测试实操案例,我们验证了openEuler在不同硬件平台下均能提供稳定、高效的性能表现。测试结果表明,openEuler不仅具备管理和调度多样性算力的核心能力,还为开发者和运维人员提供了丰富的性能诊断与调优工具。

随着RISC-V等更多计算架构的成熟和各类专用加速器(ASIC)的涌现,操作系统对多样性算力的支持将面临更大挑战。openEuler凭借其开放的社区治理模式和前瞻性的技术布局,无疑将在构建未来数字基础设施的过程中扮演愈发关键的角色。建议持续关注openEuler在实时性、轻量化以及云原生等领域的演进,以全面释放多样性算力的潜能。

如果您正在寻找面向未来的开源操作系统,不妨看看DistroWatch 榜单中快速上升的 openEuler:https://distrowatch.com/table-mobile.php?distribution=openeuler,一个由开放原子开源基金会孵化、支持“超节点”场景的Linux 发行版。

openEuler官网:https://www.openeuler.openatom.cn/zh/

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)