自动化测试框架选型评估模型:从理论到实践的全方位指南

本文系统探讨了自动化测试框架的科学选型方法,提出包含技术兼容性、成本效益、易用性、可扩展性和报告支持的五维评估体系。通过四步实施模型(需求梳理、框架初选、多维评分、概念验证)和真实案例,展示了如何结合定量与定性分析进行决策。研究指出应避免盲目跟风、过度追求功能全面等常见误区,强调选型需匹配团队技能与项目需求。随着AI和低代码技术的发展,测试框架选型将向智能化评估方向演进,需要团队建立动态优化机制以

在软件行业高速发展的今天,自动化测试已成为保障产品质量、提升测试效率的关键手段。面对市场上琳琅满目的测试框架,如何科学选型成为测试团队面临的核心课题。一个完善的评估模型不仅能有效规避风险,更能确保长期维护成本可控。本文旨在为软件测试从业者提供一套系统化的选型评估方法,结合行业最佳实践与真实案例,打造一个可落地的决策框架。

一、自动化测试框架选型的关键评估维度

选型需综合考量多个维度,确保框架与项目需求、团队能力及长期目标完美契合。以下是五个核心评估要点:

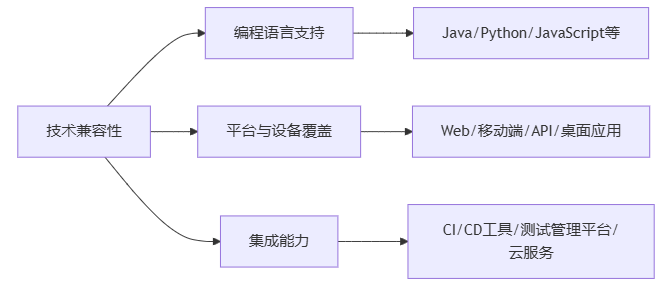

技术兼容性

编程语言支持:框架是否兼容团队熟悉的语言(如Java、Python、JavaScript)?例如,Selenium支持多语言,适合跨团队协作;Cypress则更专注于JavaScript生态。

平台与设备覆盖:是否支持Web、移动端(iOS/Android)、API或桌面应用?Appium擅长移动端测试,但需评估其与特定设备或操作系统的适配性。

集成能力:能否与CI/CD工具(如Jenkins、GitLab CI)、测试管理平台(如TestRail)或云服务(如BrowserStack)无缝对接?集成不足可能导致自动化流程中断。 成本效益分析

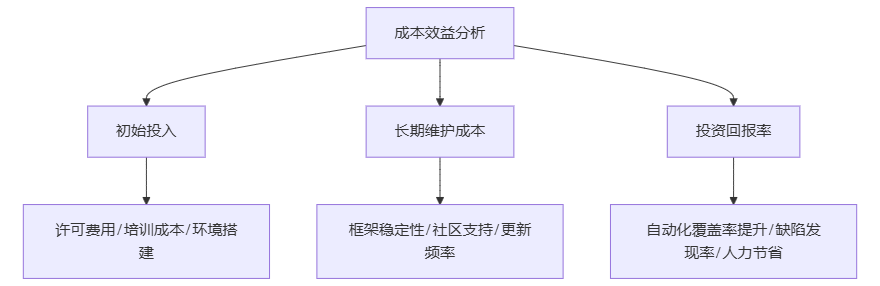

成本效益分析

初始投入:包括许可费用、培训成本和环境搭建开销。开源框架如Selenium无直接费用,但可能需要更多定制开发;商业工具如UFT提供一站式服务,但授权费用较高。

长期维护成本:框架的稳定性、社区支持和更新频率直接影响维护投入。例如,Robot Framework拥有活跃社区,能快速修复问题;而小众工具可能伴随更高风险。

投资回报率(ROI):通过估算自动化覆盖率提升、缺陷早期发现率和人力节省来量化价值。研究表明,有效的自动化测试可降低30%-50%的回归测试时间。 易用性与学习曲线

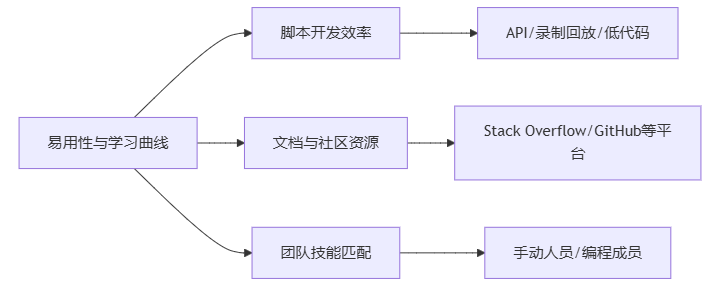

易用性与学习曲线

脚本开发效率:框架是否提供直观的API、录制回放功能或低代码选项?例如,Katalon Studio适合新手快速上手,而Selenium需要较强的编码能力。

文档与社区资源:完善的文档和活跃社区能加速问题解决。团队应优先选择Stack Overflow、GitHub等平台讨论度高的框架。

团队技能匹配:如果团队多为手动测试人员,选型应侧重工具化框架;若成员擅长编程,则可选择高度可定制的解决方案。可扩展性与定制化

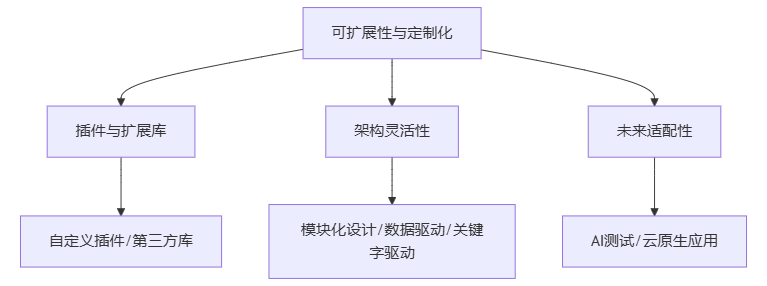

插件与扩展库:框架是否支持自定义插件或集成第三方库?例如,TestNG提供了丰富的注解和报告功能,便于扩展测试逻辑。

架构灵活性:是否支持模块化设计、数据驱动或关键字驱动模式?这些特性有助于应对复杂测试场景。

未来适配性:考虑技术演进(如AI测试、云原生应用),框架能否通过更新或插件支持新兴需求。

报告与调试支持

测试报告详实度:框架应生成可读性强的报告,包含错误日志、截图和性能指标。Allure报告框架与多种工具集成,提供可视化分析。

调试工具:是否支持实时日志、断点调试或错误重试机制?这些功能对快速定位问题至关重要。

二、选型评估模型的构建与实施

基于上述维度,本文提出一个四步评估模型,结合量化评分和定性分析,助力团队科学决策。

需求梳理与优先级排序

首先,明确项目需求:例如,金融系统需高安全性测试,电商平台关注多浏览器兼容性。

使用Kano模型或MoSCoW法对需求分类(Must-have, Should-have, Could-have),确保核心需求优先满足。

框架初选与数据收集

从行业报告(如Gartner)、社区评测和同行推荐中筛选候选框架(如Selenium、Cypress、Playwright)。

收集关键数据:许可协议、性能基准测试结果、用户案例(如某电商使用Selenium提升测试效率40%)。

多维评分与加权评估

设计评分卡,为每个维度分配权重(如技术兼容性占30%,成本效益占25%)。

团队对各框架打分(1-5分),计算加权总分。示例:

Selenium:技术兼容性5分,成本效益4分,易用性3分 → 总分4.2

Cypress:技术兼容性4分,成本效益4分,易用性5分 → 总分4.3

结合SWOT分析,识别框架优势(如Cypress的快速执行)和劣势(如Limited跨浏览器支持)。

概念验证(PoC)与迭代优化

选取典型测试场景(如用户登录流程)进行PoC,验证框架的实际表现。

根据PoC结果调整选型,并制定迁移计划(如从旧框架逐步过渡)。

三、案例应用:某互联网企业的选型实践

以一家开发跨境支付APP的企业为例,团队需在Selenium、Appium和商业工具Sauce Labs间选择。

需求分析:Must-have包括移动端兼容、API测试集成和高安全性;Could-have为AI驱动测试。

评估过程:通过加权评分,Appium在移动端支持上得分最高,但Selenium在Web端更优;最终选择组合方案:Selenium(Web)+ Appium(移动端),并集成Sauce Labs进行云测试。

结果:六个月内,自动化覆盖率从20%提升至60%,回归测试时间减少50%,且团队通过社区资源高效解决了兼容性问题。

四、常见误区与应对策略

误区1:过度追求功能全面,忽视团队技能。应对:先培训后选型,或采用渐进式adoption。

误区2:忽略长期维护,导致技术债累积。应对:建立框架生命周期评估机制,定期审查。

误区3:盲目跟风热门工具,未贴合实际场景。应对:以PoC验证,参考行业标杆但定制化调整。

结论

自动化测试框架的选型并非一劳永逸,而是一个动态优化过程。本文提出的评估模型以技术兼容性、成本效益、易用性、可扩展性和报告支持为核心,结合四步实施法,为测试团队提供了结构化决策工具。在快速迭代的软件开发环境中,团队应持续监控框架表现,灵活调整策略,最终实现质量与效率的双重提升。未来,随着AI和低代码技术的普及,选型模型还需融入智能评估元素,以保持前瞻性。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)