智能体长期规划能力增强:基于蒙特卡洛树搜索的前瞻推理【MCTS 在多步骤任务推理中的应用解析】

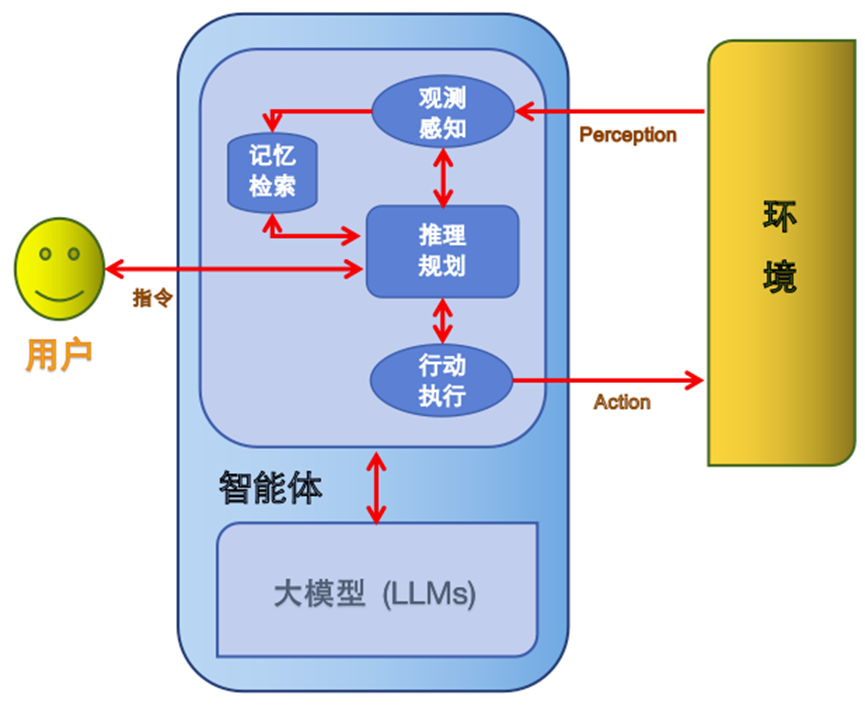

在 AI Agent 的能力体系中,长期规划(Long-term Planning) 一直是最难实现、却又最具价值的能力之一。随着多模态模型、调度架构与外部工具生态的成熟,如何让智能体不只“反应式响应”,而是能“前瞻性思考”,成为未来三年的关键技术方向。蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)便是提升智能体长期规划的重要基础设施。本文将从技术原理、工程实践以及在

智能体长期规划能力增强:基于蒙特卡洛树搜索的前瞻推理【MCTS 在多步骤任务推理中的应用解析】

在 AI Agent 的能力体系中,长期规划(Long-term Planning) 一直是最难实现、却又最具价值的能力之一。随着多模态模型、调度架构与外部工具生态的成熟,如何让智能体不只“反应式响应”,而是能“前瞻性思考”,成为未来三年的关键技术方向。

蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)便是提升智能体长期规划的重要基础设施。本文将从技术原理、工程实践以及在 AI Agent 体系中的落地方式,进行系统性解析。

一、前言:为什么智能体需要前瞻规划?

尽管大模型已经能完成复杂任务,但其原生推理方式仍偏向短期反应式(Reactive):基于当前上下文预测最可能的下一步 Token。然而,真正的智能行为往往需要:

- 看得更远:不仅预测下一句,而是预测几十步之后的状态。

- 能做权衡:在多个可能路径中,评估长期收益与代价。

- 具备纠错循环:允许回溯、择优、并在失败后替代探索。

单纯依赖 Transformer 架构的“单序列生成”,难以做到以上能力。因此,行业开始尝试使用**搜索(Search)**来弥补大模型的规划不足,而 MCTS 成为了最有潜力的方案。

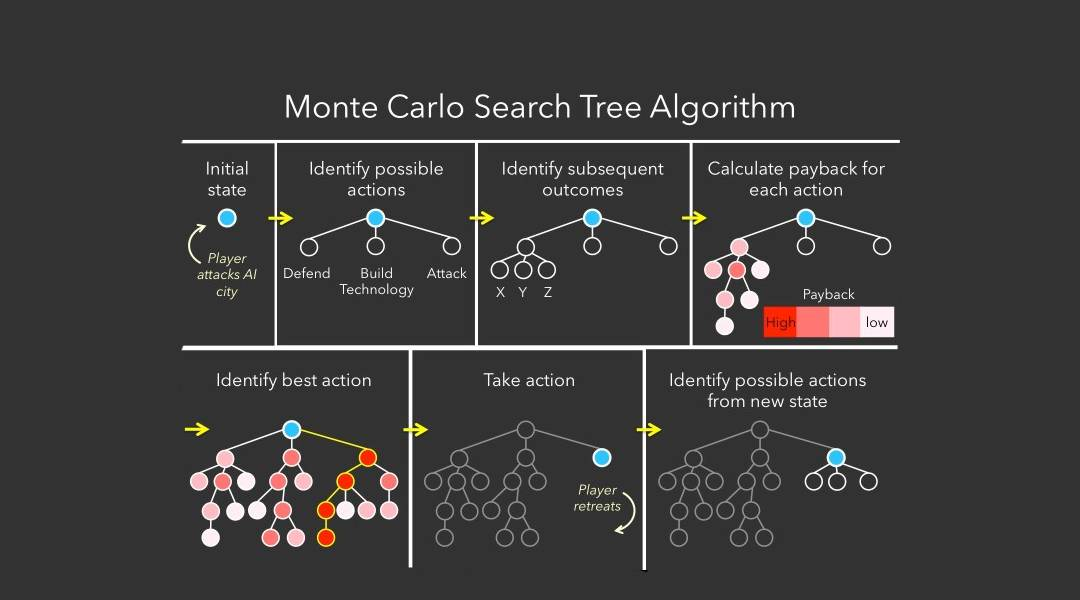

二、蒙特卡洛树搜索的核心思想:让智能体多想几步

蒙特卡洛树搜索本质上是:

通过模拟未来可能路径来评估每一步行动的长期回报。

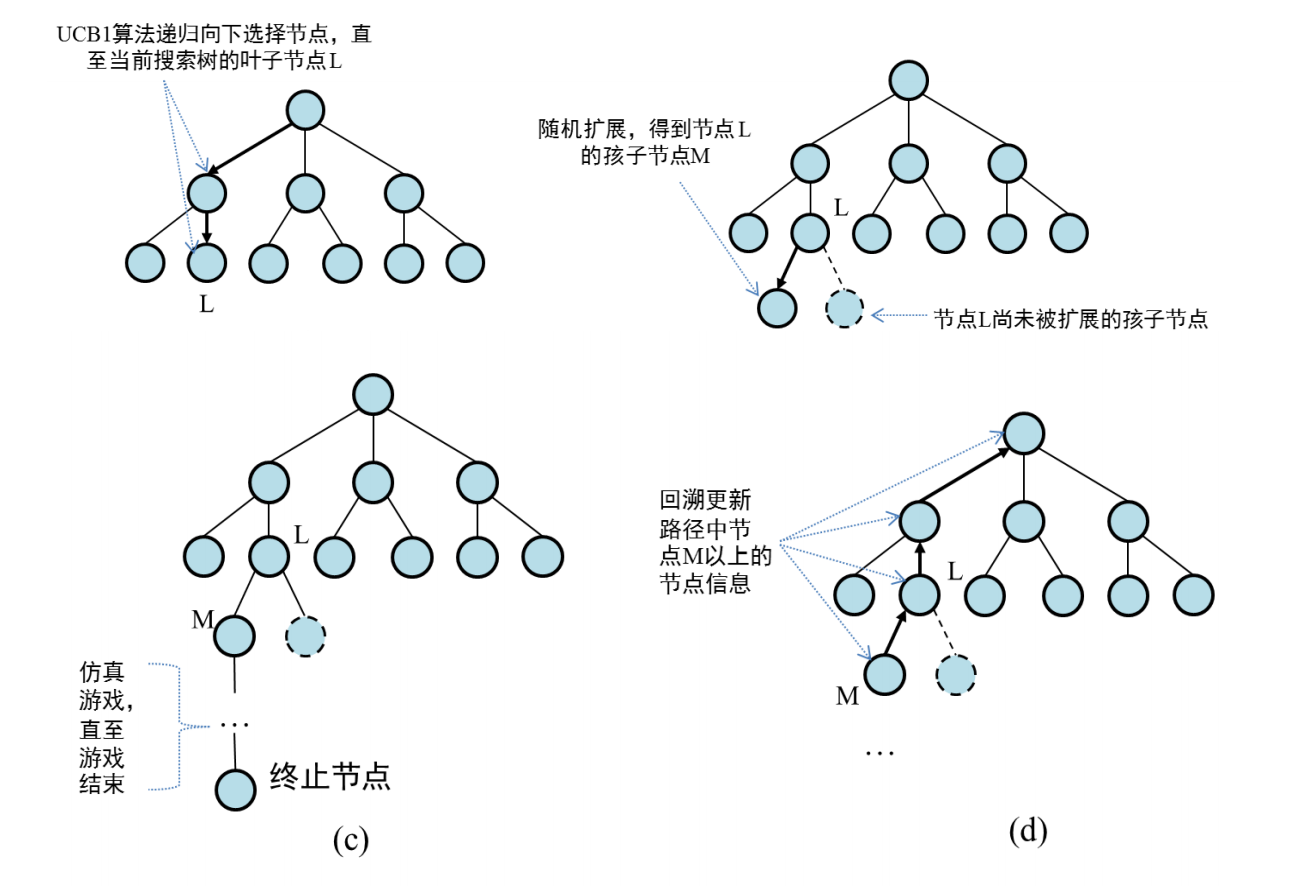

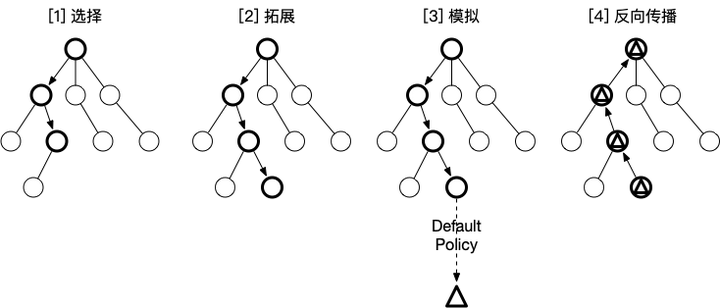

它的核心结构可以分为四个阶段:

1. Selection(选择)

在已有的搜索树里,利用 UCB/UCT 等启发式公式选择最值得扩展的节点。

这一步兼顾了“探索与利用”,确保智能体不会陷入局部最优。

2. Expansion(扩展)

从选中的节点向下一步动作延伸,创建新的子节点。

这里智能体可以调用大模型预测可能的动作或状态变化。

3. Simulation(模拟)

从扩展节点开始,随机或基于模型策略模拟未来多步,让系统观察可能的结果。

这一步让智能体“提前看到未来”。

4. Backpropagation(回溯)

将模拟结果的收益分数,回溯更新到路径上的所有决策节点。

最终,高价值路径将逐渐脱颖而出。

三、为什么 MCTS 适合 AI Agent 的长期规划?

1. 与大模型天然互补

- 大模型擅长推理、生成、归纳

- MCTS 擅长搜索、评估、决策

两者结合,即能形成模型驱动 + 搜索优化的智能体体系。

2. 可适应动态环境

相比强化学习需要大量训练,MCTS 不依赖预训练,可以在执行时实时搜索。

3. 能显著提升一致性与任务完成率

许多研究(如 DeepMind、OpenAI 近期工作)表明:

让模型先搜索,再生成,比直接生成更稳定、更可靠。

在人类任务代理(例如写代码、调试、找方案)中,搜索式推理的优势尤其明显。

四、工程落地:如何在智能体中集成 MCTS?

要让 AI Agent 使用 MCTS 进行规划,需要结合模型推理、状态评估与任务执行框架。完整流程可以分为如下模块:

(1)状态表示(State Representation)

智能体必须将任务表示成一种“可搜索的状态”。

例如:

- 自动写代码:当前代码状态(文件、函数、问题描述)

- 智能规划旅行:当前行程节点

- 自动化操作系统:当前环境快照

关键是状态要可序列化,并能被模型理解。

(2)动作生成(Action Generation)

扩展节点时,需要让模型输出:

- 下一个可能的动作

- 对动作的预期效果

- 动作的可执行性评估

通常会结合 Prompt 或策略模型,例如:

根据当前状态,列出下一步可执行的 3 个动作,并给出动作后的新状态描述。

(3)模拟机制(Rollouts)

Rollout 是 MCTS 的核心,智能体可以选择:

- 随机模拟:快速但粗糙

- 模型模拟:精确但耗时

- 混合策略:速度与质量兼顾

工程实践中常采用深度限制(如模拟 3~5 步)。

(4)价值评估(Reward / Value Function)

如何评价一次模拟的好坏?

- GPT 提供自评打分

- 人类规则评分(如完成率、能否编译等)

- 领域特定奖励函数

例如自动代码修复可以使用:

- 是否成功编译

- 单元测试通过率

- 静态分析分数

(5)决策执行(Action Selection)

最终执行:

- 奖励最高的路径

- 或访问次数最多的节点(UCT 思路)

- 或结合模型的偏好值

这一步从搜索转入实际行动。

五、案例:智能体使用 MCTS 进行“自动调试代码”

以“自动修复无法运行的代码”为例,智能体使用 MCTS 的工作流如下:

- 状态:当前错误日志 + 源代码

- 动作:模型提出可能修复策略(修改函数、调整参数、补充库等)

- 模拟:在沙箱中执行修复后的代码,观察结果

- 奖励:编译成功 + 测试全通获得最高分

- 回溯:将结果分数回写搜索树

- 选择:选择成功概率最高的路径进行真实提交

实际测试中,使用搜索推理的智能体可比普通 LLM 修复成功率提升 30%+。

六、未来展望:MCTS 将成为智能体的标配能力

随着 Agent 应用持续深化,MCTS 的作用会越来越关键:

- 成为智能体的默认规划器(Planner)

- 与工具生态深度结合(代码执行、检索、环境模拟)

- 结合记忆系统形成长期任务管理能力

- 与强化学习结合,构建可自主进化的智能体

更重要的是,MCTS 可以作为一个“可控推理器”,让我们不再完全依赖模型的“黑箱式生成”,而是让智能体具备可验证、可回溯、可解释的决策框架。

七、结语

智能体的未来不是更大的模型,而是更聪明的结构化推理能力。

蒙特卡洛树搜索为智能体带来了真正的“前瞻性思考”,让 AI 不再只是预测 Token,而是能规划未来、权衡得失。

大模型是智能体的大脑,而 MCTS 是它的“深度思考模块”。

当两者结合,我们才真的踏入了“可自主规划”的下一代智能体时代。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)