DeepSeek V3.2解析:671B参数如何实现“无损压缩“与Agent进化!

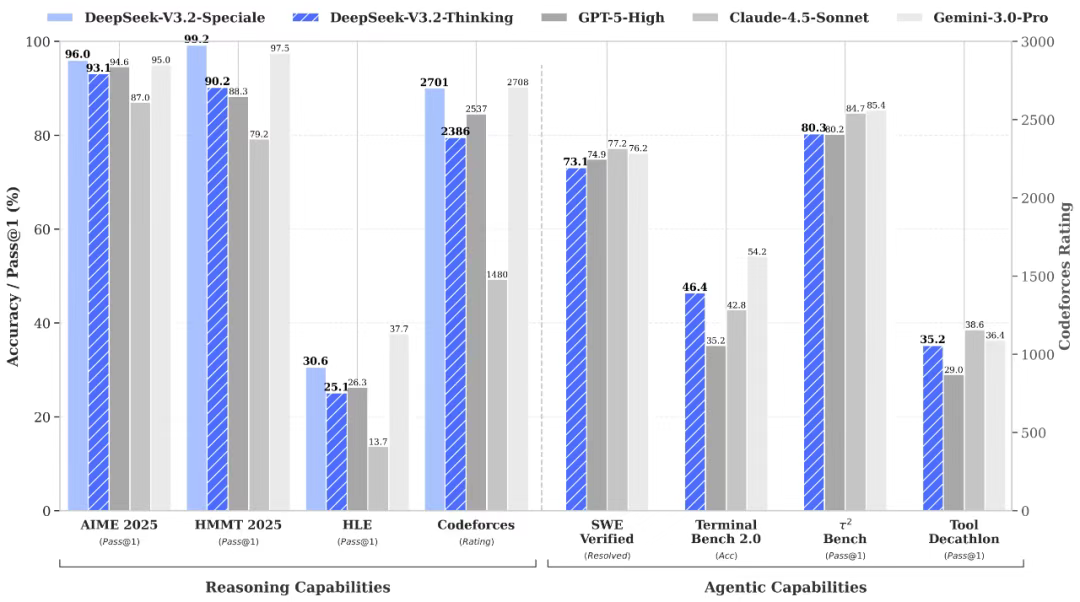

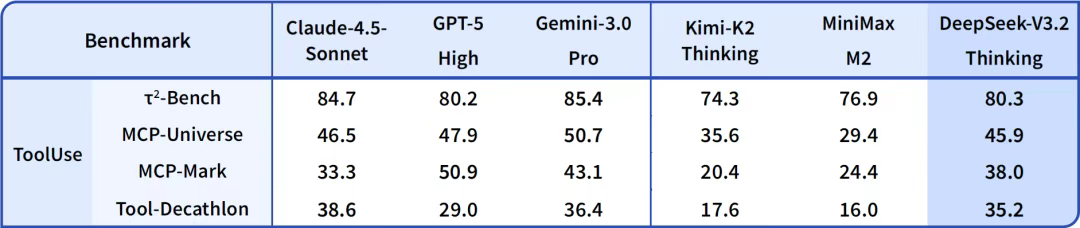

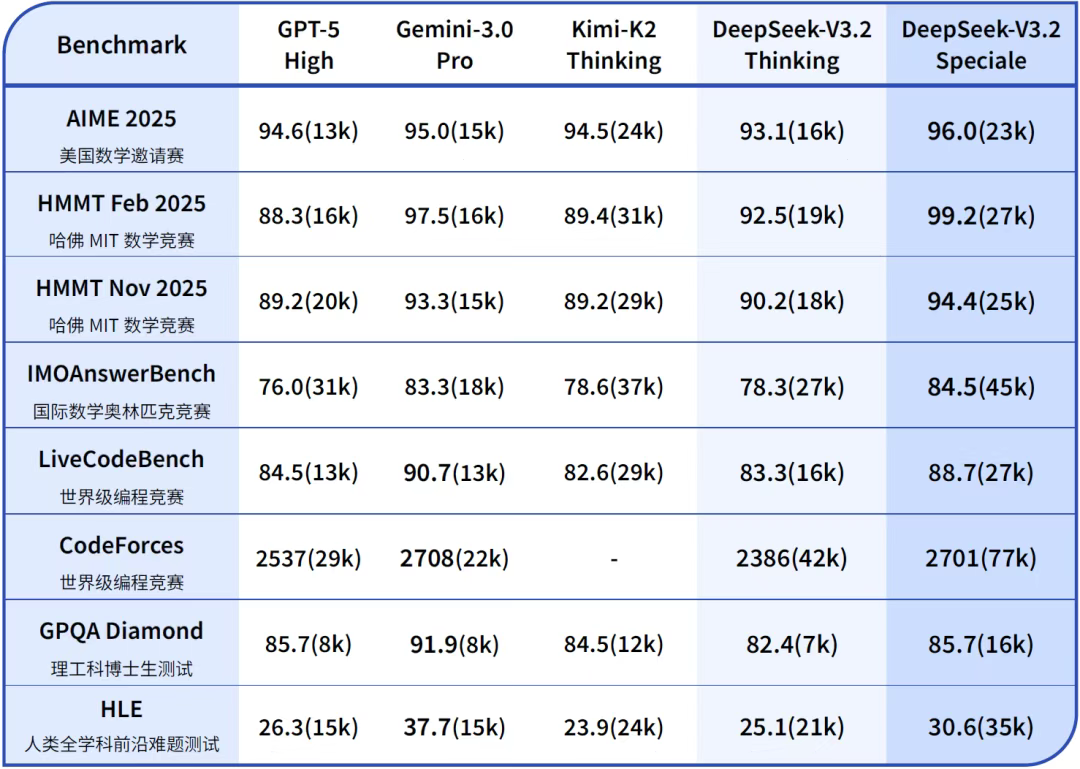

DeepSeek发布V3.2正式版,展示了一年来的技术进化路线:通过架构优化和强化学习,在不增加模型规模前提下提升思考密度与执行效率。V3.2引入DSA稀疏注意力机制实现"无损压缩",而V3.2-Speciale则是专为长思考能力设计的增强版。开源模型正通过架构创新追赶闭源模型,DeepSeek的性价比策略将在Agent落地时占据优势,其专注技术精进的路线展现了厚积薄发的行业智慧。

DeepSeek 昨晚更新并开源了 V3.2 正式版,同时带来了长思考增强版 V3.2-Speciale。

这次更新最大的亮点在于 Agent 能力的进化——模型终于学会了边想边做。

今天给家人们分享一些深度思考!

一年从 V3 到 V3.2,DeepSeek给我们有什么启发?

有人可能会觉得,月初才发 V3.2,元旦前估计就这了。

其实可以,先回顾一下 DeepSeek 一年来的发布:

- 2024/12/10:发布 DeepSeek V2.5

- 2024/12/26:发布 DeepSeek V3 间隔半个月,初见端倪

- 2025/1/20:发布 DeepSeek R1 间隔不到一个月,改写历史

- 2025/3/24:发布 DeepSeek-V3-0324,顺便一提:我自己今年消耗 token 最多应该就是 DeepSeek V3-0324,一方面是懒得改 API,一方面是够用

- 2025/5/28:发布 DeepSeek-R1-0528

- 2025/8/21:发布 DeepSeek V3.1,混合推理,不再发布单独的推理模型

- 2025/9/22:发布 DeepSeek-V3.1-Terminus,修复 V3.1 版本中的异常字符问题

- 2025/9/29:发布 DeepSeek-V3.2-Exp,间隔一周,引入 DSA 稀疏注意力机制,在不影响输出效果的前提下大幅降价

- 2025/10/23:发布 DeepSeek-OCR

- 2025/11/27:发布 DeepSeek-Math-V2

- 2025/12/1:发布 DeepSeek V3.2 正式版和DeepSeek-V3.2-Speciale

表面上看,DeepSeek 花了一整年只从 V3 走到 V3.2。

但实际上,DeepSeek 做的是一件事:在不增加模型规模的前提下,通过架构优化和强化学习,不断提升 思考密度 执行效率 和 Agent 能力,同时降低推理成本。

DeepSeek 是缺人力物力财力数据去训 T 级参数规模的模型吗?

我觉得不是。单纯就是发展路线的选择,我相信 DeepSeek 用一年时间,已经把 V3 的基模调出花了。

这种不为外部环境所动,坚持自我路线的节奏,太稳了,太可怕了。因为高速发展的创新产业,拼的就是机会成本,毕竟团队的人财物力都是有限的,可以探索的方向也是有限的。

从这种角度上讲,大家觉得,DeepSeek 是发 V4 更恐怖,还是发 V3.3、3.4…3.9…3.99 更恐怖呢?

DeepSeek 现在就给我这种,厚积薄发练内功的感觉。

想想,Ilya 前几天说 Scale 时代快结束了,要回归 Research 时代。有没有一种可能…DeepSeek 一直在 Research,没有 Scale 呢?(这里指参数量级,推理还是 scale 了的)

当别家粗放地把参数卷到碰数据墙,卷到了边际效应递减,单纯增加参数量带来的性能提升越来越小时,DeepSeek 搁这里精耕细作。

换句话说:671B 都这样了,1T 参数还不起飞咯!

回归 DeepSeek V3.2

扯远了,V3.2 不是独立的,是 V3.1 以来的延续。

V3.1 比较好理解,就是混合推理。

V3.2-Exp 主要是 DSA(稀疏注意力机制)。为了验证 DSA 的有效性,团队特意将 V3.2-Exp 的训练设置与 V3.1-Terminus 进行了严格对齐。在各领域的公开评测集上,DeepSeek-V3.2-Exp 的表现与 V3.1-Terminus 基本持平。

也就是说,V3.2-Exp 几乎实现「无损压缩」。模型在变快、变省资源的同时,智商并没有下降。

V3.2-Exp 解决了「效率」问题,V3.2 继续提升 Agent 和推理能力的改进版。

其次,就是工具使用融入思考过程,实现「思考-调用-再思考」。

这种能力不是凭空而来的。DeepSeek 在技术报告中透露,他们提出了一种大规模 Agent 训练数据合成方法。

他们构造了 1800+ 个环境 和 85,000+ 条复杂指令。这些任务具有一个鲜明的特征:「难解答,易验证」。这正是强化学习最喜欢的场景。通过这种大规模的合成数据训练,模型在并未针对特定工具进行特训的情况下,展现出了极强的泛化能力。

至于 DeepSeek-V3.2-Speciale,这个版本并不适合普通用户使用,它依然是一个「偏科生」,一个为了解题而生的长思考增强版,一个探索推理极限的特别版本。

Speciale 版本结合了 DeepSeek-Math-V2 的定理证明能力,通过数学竞赛的测评,在处理高度抽象的逻辑符号和严谨证明方面,已经达到了人类顶尖选手的水平。尽管有代价:Speciale 模型在处理任务时,会消耗显著更多的 Token。

最后

虽然,11月开源模型被闭源吊打的很惨,我们可以看到,开源模型对闭源模型的追赶速度并没有放缓,反而会因为架构创新而变得更具性价比。

Agent 的 token 消耗量是巨大的,所以当模型能力持平而 Agent 大量落地的时候,谁更有性价比就会成为决定因素。

别忘了,DeepSeek 是第一个发起模型价格战的鲶鱼,显然已经抢先占领了有利地形。

对了,梁文锋曾经说过:

数学和代码是 AGI 天然的试验场,有点像围棋,是一个封闭的、可验证的系统,有可能通过自我学习就能实现很高的智能。

Math-V2、Speciale 已经来了,Coder 还会远吗?V4 还会远吗?

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献476条内容

已为社区贡献476条内容

所有评论(0)