DeepSeek-V3.2的混合专家模型强化学习策略解析与部署安装使用方法

DeepSeek-V3.2系列开源大模型在2025年12月发布,实现了多项技术突破。其核心创新DSA稀疏注意力机制将长文本处理成本降低50%,推理能力媲美顶级闭源模型。该模型在数学推理、代码生成等任务中表现优异,API价格仅为同类产品的1/4。支持128K长文本处理、工具调用等高级功能,提供简洁的安装部署方案和量化加载选项。DeepSeek-V3.2通过开源生态推动AI技术普惠化,在性能、成本效益

引言:开源大模型的新里程碑

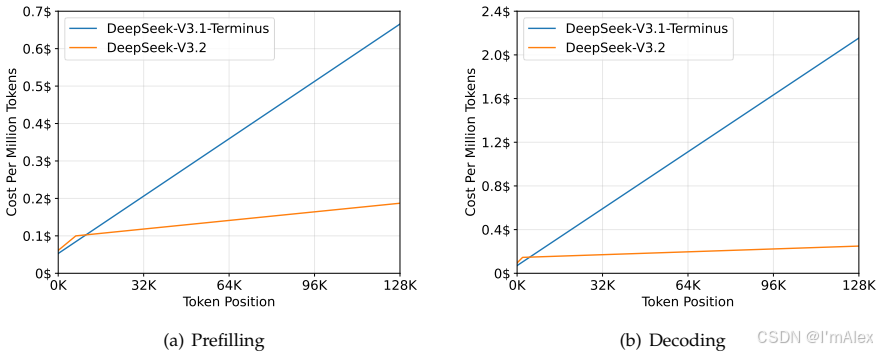

2025年12月,深度求索正式发布DeepSeek-V3.2系列模型,标志着开源大语言模型在推理能力、计算效率和实用价值上达到新的高度。该模型不仅在多项基准测试中媲美顶级闭源模型,更通过创新的稀疏注意力机制将长文本处理成本降低50%,为AI技术的普惠化发展树立了新标杆。

一、核心架构突破

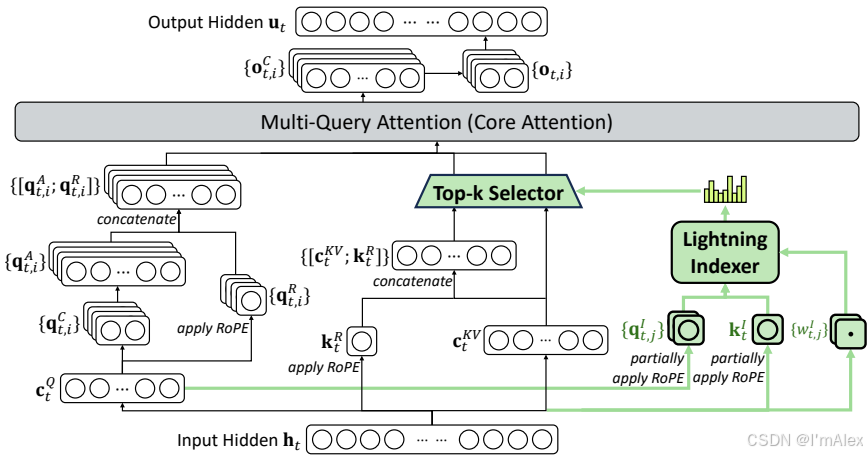

1.1 DSA稀疏注意力机制

DeepSeek稀疏注意力(DSA)是DeepSeek-V3.2的核心创新,通过闪电索引器和细粒度token选择机制,将注意力计算复杂度从O(L²)降至O(Lk)。这一突破性技术使模型在保持性能的同时,大幅提升了长文本处理效率。

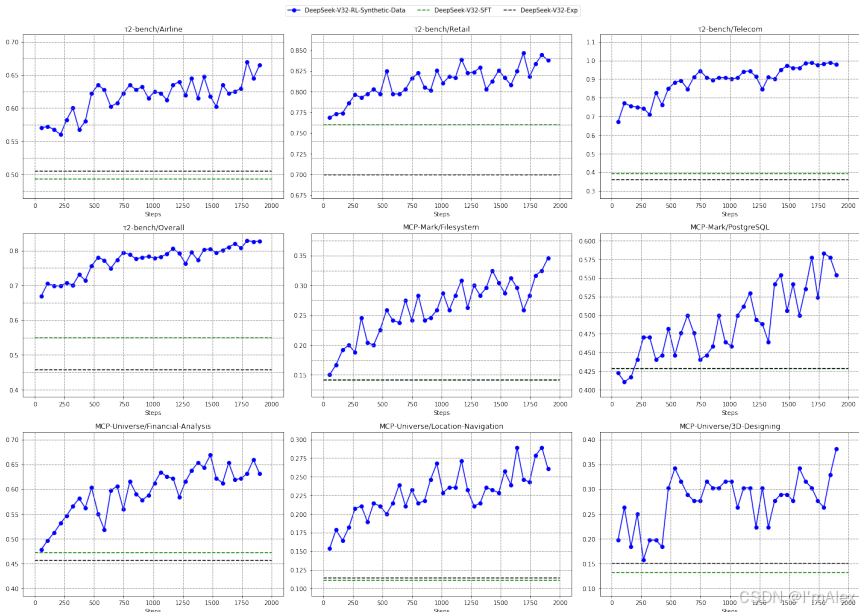

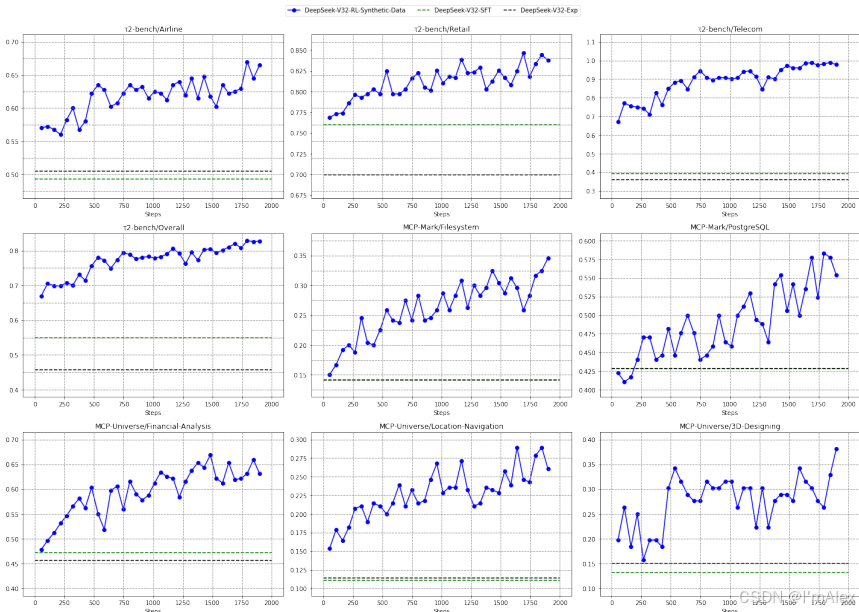

1.2 可扩展强化学习框架

通过组相对策略优化(GRPO)和无偏KL估计等技术,DeepSeek-V3.2实现了稳定的强化学习训练。后训练计算预算超过预训练成本的10%,为模型提供了强大的推理能力基础。

二、性能表现分析

2.1 基准测试成绩

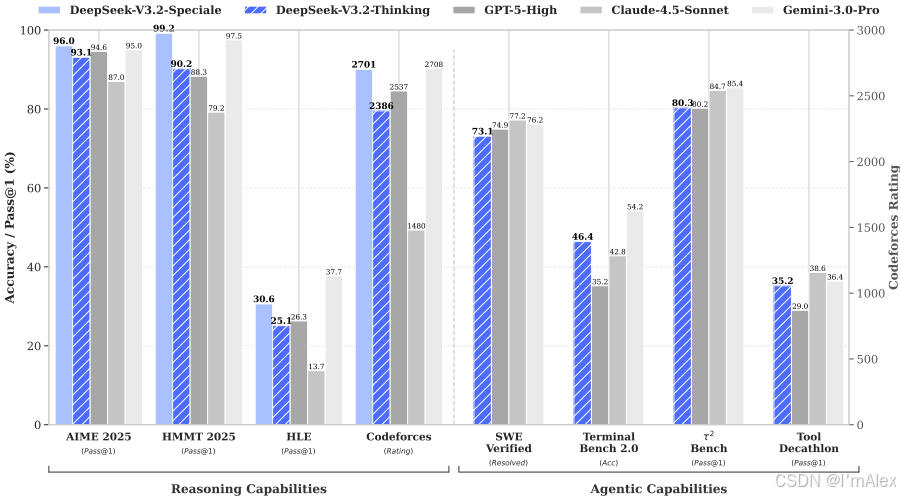

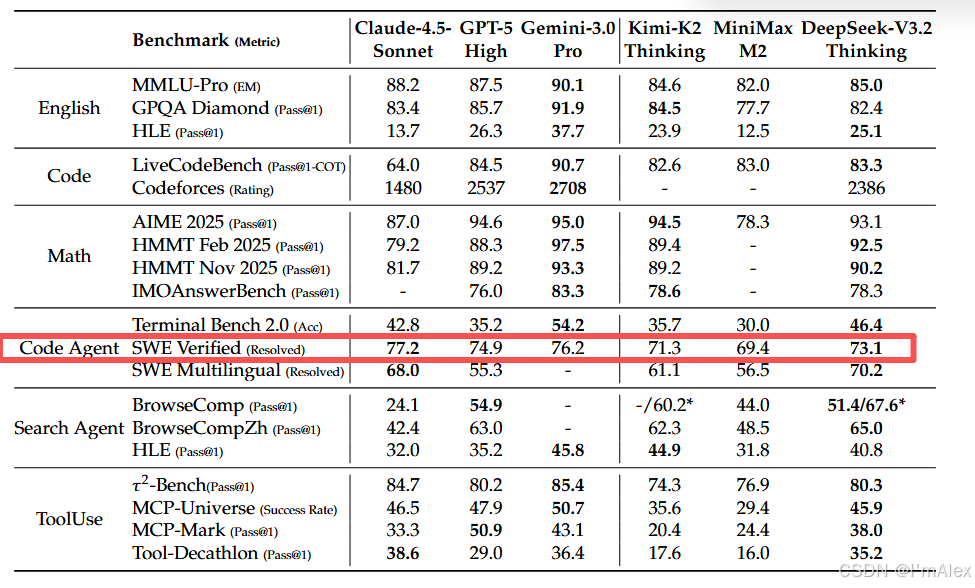

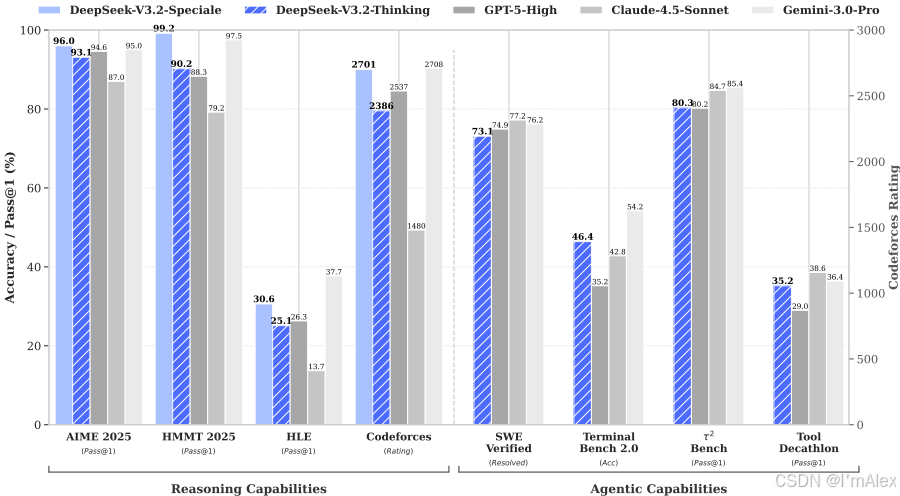

在MMLU-Pro、GPQA Diamond、AIME 2025等权威基准测试中,DeepSeek-V3.2展现出与GPT-5相媲美的性能。特别是在数学推理和代码生成任务中,模型表现接近顶尖闭源系统。

2.2 实际应用优势

DeepSeek-V3.2在智能体任务、工具调用和长文本处理等实际应用场景中表现优异。其API价格仅为GPT-5的1/4,为开发者提供了高性价比的解决方案。

三、安装与使用指南

3.1 环境配置与快速安装

系统要求:

- GPU内存:16GB以上(推荐24GB+)

- 系统内存:32GB以上

- Python 3.8-3.11,PyTorch 2.0+

安装命令:

pip install deepseek-ai transformers torch accelerate

3.2 模型加载与初始化

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "deepseek-ai/DeepSeek-V3.2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto"

)

3.3 基础推理功能

文本生成示例:

def generate_text(prompt):

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(**inputs, max_length=2048)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 使用示例

response = generate_text("请解释深度学习原理")

思考模式启用:

outputs = model.generate(

inputs.input_ids,

thinking_mode=True, # 启用思考模式

max_length=4096

)

3.4 高级功能配置

长文本处理优化:

def process_long_text(text, chunk_size=64000):

chunks = [text[i:i+chunk_size] for i in range(0, len(text), chunk_size)]

results = []

for chunk in chunks:

inputs = tokenizer(chunk, return_tensors="pt", truncation=True)

outputs = model.generate(**inputs)

results.append(tokenizer.decode(outputs[0]))

return "".join(results)

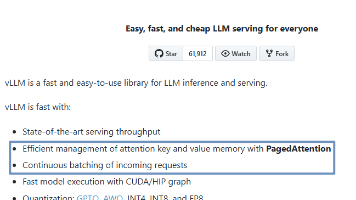

3.5 生产环境部署

API服务部署:

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/generate', methods=['POST'])

def api_generate():

data = request.json

prompt = data.get('prompt', '')

result = generate_text(prompt)

return jsonify({'response': result})

if __name__ == '__main__':

app.run(host='0.0.0.0', port=8080)

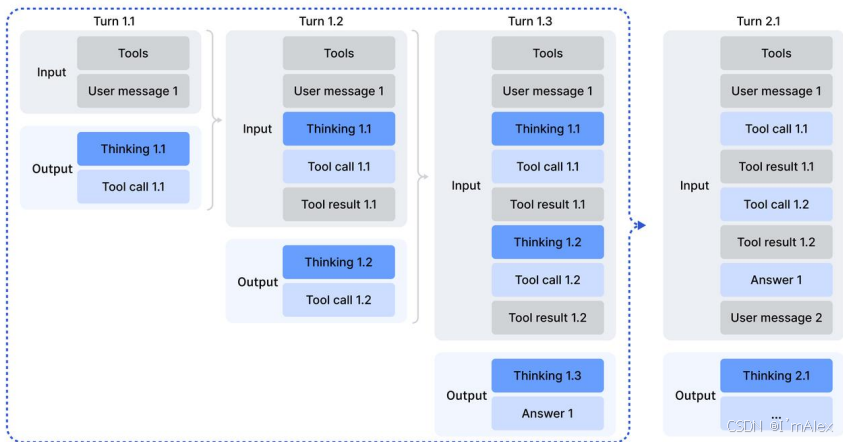

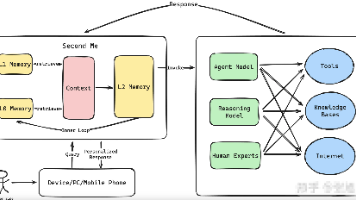

四、工具调用与智能体功能

4.1 思考与工具调用融合

DeepSeek-V3.2创新性地将思考过程融入工具调用场景,通过智能的上下文管理策略显著提升任务处理效率。

4.2 智能体任务处理

模型支持复杂的多步骤任务处理,在代码开发、数据分析和智能助手等场景中展现出色表现。通过大规模智能体任务合成,DeepSeek-V3.2在1,827个任务环境中实现了45.9%的成功率。

五、性能优化与最佳实践

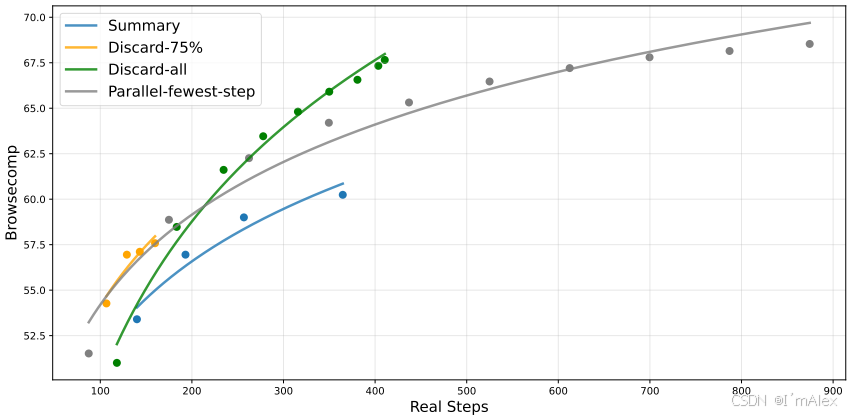

5.1 推理成本优化

DSA机制将核心注意力复杂度从O(L²)降至O(Lk),在128K上下文长度下实现解码成本降低52%,速度提升62.5%的显著效果。

5.2 内存优化方案

# 8位量化加载

model = AutoModelForCausalLM.from_pretrained(

"deepseek-ai/DeepSeek-V3.2",

load_in_8bit=True,

device_map="auto"

)

六、实际应用场景

6.1 代码开发与调试

在SWE-Verified基准测试中达到73.1%的解决率,为开发者提供高效的代码生成和调试支持。

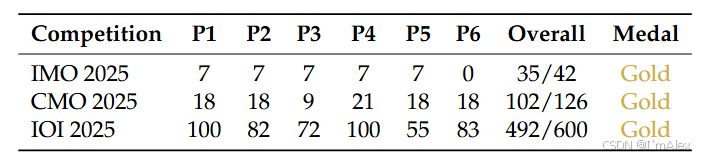

6.2 数学推理与科学计算

DeepSeek-V3.2-Speciale在IMO 2025、ICPC 2025等顶级竞赛中获得金牌,展现强大的数学推理能力。

6.3 长文档处理与分析

凭借DSA稀疏注意力机制,模型能够高效处理128K长文档,在学术研究和商业分析中具有重要价值。

七、技术优势总结

7.1 性能突破

- 推理能力追平GPT-5,在多项基准测试中表现优异

- 长文本处理效率提升50%以上

- 工具调用能力达到开源模型最高水平

7.2 成本效益

- API价格仅为闭源模型的1/4

- 支持本地部署,数据安全性高

- 完整的开源生态支持

7.3 易用性

- 简洁的API接口设计

- 丰富的文档和示例代码

- 活跃的开发者社区

八、发展前景与展望

DeepSeek-V3.2的开源发布为AI社区提供了强大的技术基础。未来,随着技术的持续优化和生态建设的完善,该模型有望在更多应用场景中发挥重要价值,推动AI技术向更加普惠、高效的方向发展。

结语

DeepSeek-V3.2通过创新的技术架构和卓越的性能表现,为开源大模型的发展树立了新的标杆。其平衡的效率与性能、丰富的功能特性以及友好的使用体验,使其成为当前最具价值的开源大语言模型之一,为AI技术的民主化进程做出了重要贡献。

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)