一文读懂谷歌TPU:Meta AI大模型为什么放弃英伟达选择谷歌TPU芯片?

Meta计划在2027年部署谷歌TPU芯片,引发行业关注。谷歌TPU作为专为AI计算设计的ASIC芯片,相比英伟达GPU具有更高能效和更低成本优势。TPU经过多代迭代,已形成从芯片到软件的全栈优化体系,特别适合AI推理场景。Meta等公司转向TPU,反映出AI行业正从训练转向推理优先,而谷歌通过垂直整合策略避免了英伟达的"CUDA税",使其在AI基础设施领域占据竞争优势。TPU

一文读懂谷歌TPU:Meta AI大模型为什么放弃英伟达选择谷歌TPU芯片?

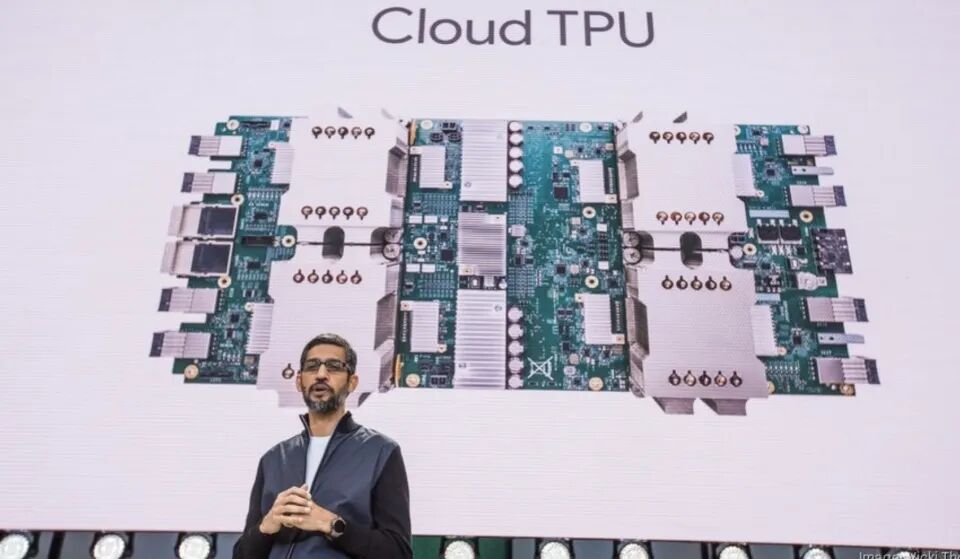

Alphabet兼谷歌首席执行官桑达尔·皮查伊

文章目录

摘要

近期,关于Meta计划在2027年将其数据中心部署谷歌TPU,以及2026年通过谷歌云租用TPU算力的消息,引发了业界广泛关注。这一消息无疑让英伟达面临巨大压力,因为GPU长期以来是AI计算的主流硬件,而谷歌的TPU(张量处理单元)凭借其高度定制化和超高能效,正逐渐成为AI计算的重要基础设施。

本文将详细分析谷歌TPU的发展历程及其优势,解释Meta为何决定放弃英伟达的GPU,转而选择谷歌TPU,并探讨TPU与英伟达GPU的不同哲学和竞争格局。

文章目录

一、TPU的前世今生

1.1 初心:解决AI计算瓶颈

谷歌TPU项目始于2015年,当时公司面临一个重要挑战:随着深度学习的广泛应用,尤其是在搜索、广告等核心业务中,全球数据中心的功耗急剧增加。GPU虽然适合训练大规模神经网络,但其在实时推理中的能效并不理想,且难以应对谷歌庞大的计算需求。即使购置更多的GPU,电力成本也将暴涨。

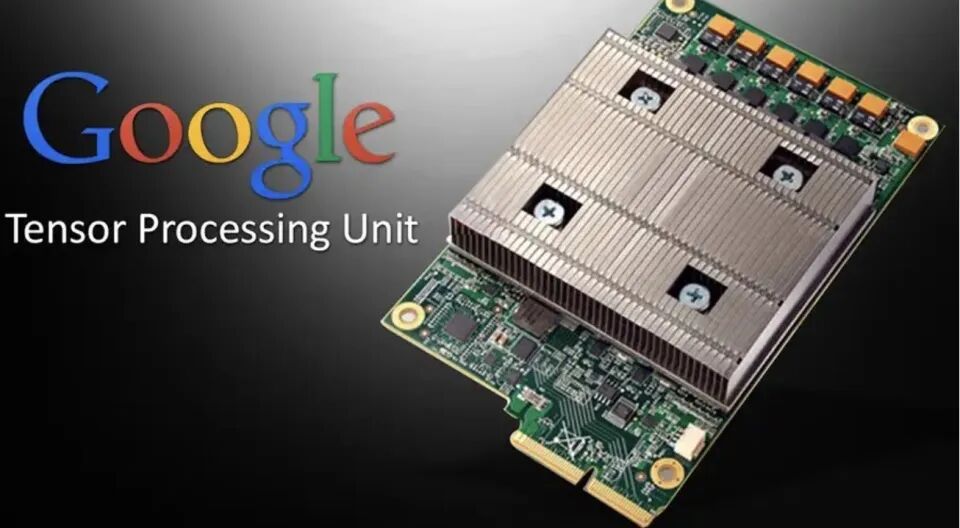

因此,谷歌决定开发一款专门的ASIC加速器——TPU(张量处理单元)。该芯片专门为深度学习中的矩阵运算优化,目标并非开发通用芯片,而是为特定任务提供超高能效。

2016年,TPU v1投入使用,支持谷歌翻译和搜索功能,证明了ASIC方案的可行性。随着Transformer架构的提出,谷歌意识到TPU是解决深度学习计算瓶颈的完美方案。

1.2 逐步扩展:TPU v2到v4

随着AI需求的不断增长,谷歌不断完善TPU。TPU v2、v3逐步开放给谷歌云客户,并利用XLA编译器、高效的Pod架构以及液冷系统,谷歌的TPU在AI训练和推理中逐步脱颖而出。尤其是TPU v4的发布,它通过4096颗芯片组成的超节点,借助自研的环形拓扑网络,极大提升了芯片之间的协作效率。

1.3 迈向推理时代:TPU v5p与v6

随着AI推理需求的增加,谷歌的TPU架构迎来了重要的变革。TPU v5p与v6的推出标志着谷歌的推理时代全面来临。v5p不仅在性能上大幅提升,还推出了弹性节点架构,支持企业按需扩展至近9000颗芯片的规模。特别是2024年发布的TPU v6,它通过优化的架构,专注于推理负载,能效提升67%,被定位为“推理时代最省钱的商业引擎”。

TPU的成功不仅在于硬件性能,更在于谷歌的全栈系统哲学,从芯片、软件到数据中心的深度整合,使得TPU在推理时能够以极低成本、高效能运行。

二、TPU与英伟达GPU的较量

2.1 英伟达的通用GPU路线

英伟达的GPU一直以来被认为是AI计算的黄金标准。GPU的通用性使其能够支持多种类型的计算任务,尤其适用于深度学习等大规模并行计算。然而,GPU的通用设计并非专为推理任务优化,它在处理推理时的能效远不如专用的ASIC芯片。

尽管英伟达通过CUDA生态锁定了大量开发者,但GPU的灵活性使其在推理时的效率不如TPU。更重要的是,英伟达的定价模式,使得云厂商需要支付高昂的“GPU税”,这无疑增加了AI企业的成本负担。

2.2 谷歌的专用TPU路线

相比之下,谷歌并不追求硬件的通用性,而是专注于深度学习特别是Transformer架构的推理优化。TPU的设计围绕矩阵乘法等特定运算任务展开,从而在深度学习计算中展现出极高的效率。

谷歌的TPU与英伟达GPU的不同之处在于系统级优化。谷歌通过控制整个硬件和软件栈的设计,使得TPU在训练和推理过程中能够实现系统级的性能优化,极大提高了运算效率和能效。

2.3 谷歌的全栈整合策略

谷歌的TPU并非孤立存在,而是与其全栈AI基础设施深度整合。从芯片设计到网络拓扑,再到软件调度,谷歌的每一环节都为TPU的高效运行做出了贡献。这种系统级的优化使得TPU在AI推理中具有了显著的竞争优势。

与此相比,英伟达尽管在GPU的硬件性能上遥遥领先,但其主要依赖外部厂商和开发者生态,无法像谷歌那样进行如此深度的优化。

三、推理时代的到来

随着大模型和推理的兴起,AI行业进入了一个全新的阶段。推理成本正在成为AI公司最大的支出之一,尤其是在大规模在线推理场景中。谷歌凭借TPU的高效性,在推理市场中迎来了巨大的机会。

Meta、Anthropic等头部模型公司已经开始转向TPU,这标志着TPU不仅在谷歌内部成为战略级资产,而且逐渐成为外部企业AI计算的首选。

四、告别昂贵的“CUDA税”

谷歌能够在推理时代获得优势,关键不仅仅在于TPU的硬件性能,而在于其全栈垂直整合策略。通过控制芯片设计、网络方案、数据中心和软件栈,谷歌能够避免GPU的高昂成本,并为客户提供更具竞争力的算力服务。

与英伟达不同,谷歌不需要支付“CUDA税”。通过自研TPU,谷歌不仅降低了内部成本,还能为云客户提供低成本的推理能力,从而吸引大量客户迁移到谷歌云平台。这使得谷歌的AI基础设施在成本效益上具备了显著优势。

五、谷歌的“经济支柱”

TPU已经成为谷歌的核心战略资产,它不仅支撑着谷歌内部AI模型的训练和推理,也正在推动谷歌云的快速增长。谷歌通过全栈整合的方式,将TPU打造成了AI计算领域的“经济支柱”,为未来的AI产业奠定了基础。

谷歌的全栈系统不仅优化了训练和推理的效率,还通过TPU的高效性降低了AI企业的整体算力开支。这一策略使得谷歌在AI推理时代拥有了强大的竞争力,并为公司带来了巨大的商业价值。

随着AI行业的发展,谷歌的TPU将在未来几年继续引领推理时代的浪潮,成为全球企业AI计算的首选平台。

参考素材:https://mp.weixin.qq.com/s/A4hU9UaURcYTcIofZx-b4Q

参考资料:https://baijiahao.baidu.com/s?id=1849744862166077562&wfr=spider&for=pc

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)