AI公司如何选择适合的GPU算力平台?

AI公司GPU算力平台的选择直接影响研发效率和业务发展。本文系统分析了不同发展阶段AI企业的算力需求特征,对比了公有云、专业智算云、私有中心等平台的优劣势,提出从资源能力、平台功能、服务质量、成本效益和安全合规五大维度评估。针对大模型研发、垂直应用等不同类型企业,给出差异化选型建议,并推荐采用需求梳理-市场调研-深度评估-小规模试用的科学选型流程。专业智算云平台如蓝耘科技(拥有20000+GPU资

对于AI公司而言,GPU算力平台的选择是一项关乎业务发展的战略决策。选对平台,可以加速模型迭代、控制研发成本、保障业务稳定;选错平台,则可能面临资源浪费、项目延期甚至数据安全风险。

本文将从AI公司的实际需求出发,系统分析GPU算力平台的选择策略,帮助技术决策者做出明智判断。

一、AI公司的算力需求特征分析

在选择平台之前,首先需要清晰认知自身的算力需求特征。

不同发展阶段的需求差异

初创探索期

处于这一阶段的AI公司通常团队规模较小,业务方向尚在验证中。算力需求呈现出高度不确定性,可能这个月需要大量GPU进行模型实验,下个月又进入数据标注和论文撰写阶段。这类公司最需要的是灵活性,避免重资产投入带来的财务压力。

快速成长期

业务方向明确后,AI公司进入快速迭代阶段。模型训练频繁,算力需求稳步上升。这一阶段既需要保证算力供给的稳定性,又要控制成本,为后续融资和商业化做好准备。

规模化运营期

当AI产品进入商业化阶段,推理服务的算力需求开始超过训练需求。稳定性、低延迟、高可用成为核心诉求,同时需要应对业务高峰期的弹性扩容需求。

不同业务类型的需求差异

大模型研发公司

专注于基础大模型研发的公司对算力的需求最为苛刻。千亿参数模型的训练需要数百甚至上千张高端GPU协同工作,对集群规模、网络带宽、存储性能都有极高要求。训练周期长达数周,任何中断都意味着巨大损失。

垂直应用开发商

基于开源模型进行微调和应用开发的公司,算力需求相对温和。通常需要中等规模的GPU资源进行模型微调,以及一定的推理资源支撑应用部署。

AIGC服务提供商

图像生成、视频合成等AIGC服务商的特点是推理请求波动大,需要根据用户访问量弹性调整资源。对响应延迟敏感,同时需要控制单次推理成本以保证业务毛利。

AI+行业解决方案商

服务于医疗、金融、制造等垂直行业的AI公司,往往面临严格的数据合规要求。算力平台的安全性、数据隔离能力、合规资质成为重要考量因素。

二、GPU算力平台的主要类型

市场上的GPU算力平台可分为以下几类,各有优劣。

公有云GPU服务

特点:由大型云厂商提供,资源池庞大,服务成熟度高,按需付费模式灵活。

优势:无需前期投入,弹性扩展能力强,配套服务完善。

局限:长期使用成本较高,高端GPU资源紧张时可能面临排队,对于超大规模训练任务的支持有限。

专业智算云平台

特点:专注于AI算力服务的垂直平台,如蓝耘智算云,针对AI训练场景进行深度优化。

优势:GPU资源更丰富,针对AI场景的优化更到位,性价比通常更高,技术支持更专业。

局限:生态丰富度可能不及综合云厂商。

蓝耘科技集团作为深耕专业领域20年的服务商,其元生代智算云平台汇聚了超过20000张高端GPU资源,专为AI训练和推理场景打造,已服务智源研究院、百度、商汤等众多知名AI企业。

自建私有算力中心

特点:企业自主采购硬件、建设机房、运维管理。

优势:完全自主可控,数据安全性最高,长期边际成本较低。

局限:前期投入巨大,建设周期长,需要专业运维团队,资源利用率优化困难。

混合算力架构

特点:结合自建算力和云端算力,根据业务需求灵活调配。

优势:兼顾安全性和弹性,成本优化空间大。

局限:架构复杂度高,需要统一的调度和管理能力。

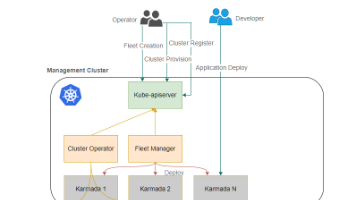

蓝耘智算云支持K8S混合云模式,可以帮助企业无缝整合自有资源和云端资源,实现算力的统一调度。

三、评估GPU算力平台的核心维度

维度一:资源能力

GPU型号与数量

首先要确认平台是否提供所需型号的GPU。对于大模型训练,A100、H100等高端GPU是必选;对于推理服务,A10、L40等可能更具性价比。

同时要关注平台的GPU总量和可用性。资源紧张的平台可能导致项目启动延迟。蓝耘智算云拥有超过20000张高端GPU资源,分布在全国6大数据中心,可以为客户提供充足的资源保障。

集群规模与互联

大规模训练对集群的要求不仅是GPU数量,更要关注互联架构。优质平台应提供NVLink、NVSwitch等高速卡间互联,以及InfiniBand或RoCE等高性能跨节点网络。

蓝耘智算云支持IB/RoCE组网,并实现了轨道优化、NUMA亲和性等高级调度特性,确保分布式训练的高效率。

存储性能

AI训练涉及大量数据读写,存储性能直接影响训练效率。要关注存储带宽、IOPS、容量等指标,以及是否支持高性能分布式文件系统。

维度二:平台能力

开发环境完善度

优秀的算力平台应该提供开箱即用的AI开发环境,包括主流框架预装、开发工具集成、镜像管理等功能。

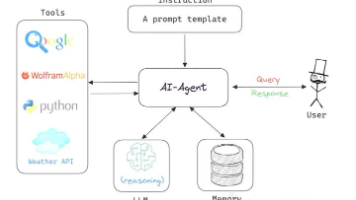

蓝耘元生代智算云平台预置了PyTorch、TensorFlow、DeepSpeed、PaddlePaddle等主流框架,集成Jupyter、VSCode、Web Terminal等开发工具,支持一键环境部署,让开发者专注于模型本身。

调度与编排

平台的任务调度能力决定了资源利用效率。要关注是否支持多租户隔离、优先级队列、弹性伸缩、断点续训等特性。

蓝耘智算云基于Kubernetes构建,支持单卡/单机、分布式、容错等多种调度模式,并提供专属资源组、轨道优化等高级功能。

模型与数据管理

完善的平台应提供数据集管理、模型版本控制、实验追踪等能力,帮助团队高效协作。

维度三:服务能力

技术支持水平

AI训练过程中难免遇到各种技术问题。平台的技术支持响应速度和专业程度直接影响项目进度。

蓝耘科技拥有超过数百名可调用的专业工程师,提供7×24小时技术支持,从环境部署、性能调优到故障排查,全程为客户保驾护航。

SLA保障

商业化应用对服务可用性有严格要求。要明确平台的SLA承诺,包括可用性指标、故障响应时间、补偿机制等。

蓝耘智算云提供99.9%的SLA保障,确保客户业务的稳定运行。

定制化能力

不同AI公司的需求存在差异。优质平台应具备一定的定制化能力,能够根据客户需求调整资源配置、部署方案等。

维度四:成本效益

定价模式

常见的定价模式包括按需计费(按实际使用时长付费)、包月/包年(固定费用,适合稳定需求)以及竞价实例(低价获取闲置资源,可能被中断)。

AI公司应根据自身需求特点选择合适的付费模式,或组合使用以优化成本。

蓝耘GPU算力租赁支持多种灵活的付费模式,帮助客户在保证算力供给的同时有效控制成本。

隐性成本

除了GPU租赁费用,还要考虑存储费用、网络流量费用、数据迁移成本等。全面核算总体拥有成本,避免预算超支。

性价比评估

不能单纯比较价格,而应该计算单位算力成本或单位训练任务成本。有些平台虽然单价高,但效率优化做得好,实际成本可能更低。

维度五:安全合规

数据安全

要关注平台的数据加密机制、访问控制能力、数据隔离方案等。对于涉及敏感数据的AI应用,这一点尤为重要。

蓝耘智算云采用多重数据加密技术,支持VPC网络隔离,并实施分布式存储和定期备份策略,全方位保障数据安全。

合规资质

根据业务需求,确认平台是否具备相关资质认证,如等保认证、ISO认证等。

蓝耘科技具备ISO9001质量管理体系认证、增值电信业务经营许可证、信息系统集成及服务资质等多项资质。

四、不同类型AI公司的选择建议

大模型研发公司

核心需求:大规模GPU集群、高速互联、长期稳定的资源供给

推荐方案:与专业智算云平台建立战略合作,锁定长期资源;考虑混合架构,核心训练任务使用专属资源,实验性任务使用弹性资源。

蓝耘智算云的裸金属调度模式非常适合大模型训练场景,可以提供用户自定义集群、K8S专属云等多种部署方式,支持TB级别裸光纤长传,满足超大规模训练需求。

垂直应用开发商

核心需求:性价比高的微调资源、便捷的开发环境、灵活的付费方式

推荐方案:选择提供丰富预置环境和按需付费的智算云平台,降低使用门槛和财务压力。

蓝耘智算云的轻量级容器调度模式预装AI开发工具套件,支持秒级交付和按需计费,非常适合中小规模的模型微调任务。

AIGC服务提供商

核心需求:弹性扩展能力、低推理延迟、成本可控

推荐方案:选择支持弹性伸缩的云平台,建立推理服务的自动扩缩容机制;关注平台的推理优化能力。

蓝耘智算云支持弹性扩缩容和API网关等推理服务特性,可以帮助AIGC服务商高效部署推理服务。

AI+行业解决方案商

核心需求:数据安全、合规资质、定制化服务

推荐方案:选择具备完善安全体系和合规资质的平台;考虑私有云或专属资源池方案。

蓝耘科技作为国家高新技术企业和北京市专精特新小巨人企业,具备完善的资质体系,可以为行业客户提供合规的算力服务。

五、选择流程与实践建议

步骤一:需求梳理

组织技术团队系统梳理算力需求,包括当前需求、未来6-12个月的增长预期、峰值与常态的差异等。形成书面的需求文档,作为选型的基础。

步骤二:市场调研

收集市场上主要GPU算力平台的信息,初步筛选3-5家符合基本要求的候选平台。可以通过官网资料、行业报告、同行推荐等渠道获取信息。

步骤三:深度评估

对候选平台进行深度评估,包括技术交流了解平台技术架构和能力边界,实际测试申请试用资源进行性能验证,案例参考了解平台服务过的类似客户案例,以及商务洽谈讨论定价方案和合作模式。

步骤四:小规模试用

选定1-2家平台进行小规模实际使用,验证其在真实业务场景中的表现。试用期间重点关注性能稳定性、技术支持响应、费用透明度等方面。

步骤五:决策与签约

综合评估试用结果,做出最终决策。签约时注意明确SLA条款、数据安全责任、价格调整机制等关键事项。

步骤六:持续优化

使用过程中持续监控资源利用效率和成本,根据业务发展调整资源配置,与平台方保持沟通,及时获取新功能和优惠政策。

六、蓝耘智算云:AI公司的可靠算力伙伴

蓝耘科技集团股份有限公司成立于2004年,总部位于北京,在上海、广州、成都、厦门等地设有分子公司,是一家专注于GPU算力解决方案与算力云服务的科技公司。

20年行业深耕

蓝耘深耕GPU算力领域20年,服务客户超过10000家,覆盖高校、科研、AI、汽车、互联网、政府、能源、医疗等25+行业。丰富的行业经验使蓝耘能够深刻理解不同客户的需求痛点,提供针对性的解决方案。

强大的资源能力

蓝耘GPU资源池拥有超过20000张高端GPU,分布在北京、上海、广州、厦门、秦皇岛、鄂尔多斯等地的6大数据中心。蓝耘北京酒仙桥智算中心采用液冷技术,有效提升单卡及集群计算效能,代表了先进的智算中心建设水平。

完善的产品矩阵

蓝耘提供完整的GPU算力服务矩阵。元生代智算云平台作为核心产品,提供从开发到部署的一站式AI开发环境。GPU算力解决方案为有自建需求的客户提供规划、采购、部署、运维的全流程服务。算力代运营服务帮助拥有GPU资源的客户实现资源的高效运营。

专业的服务团队

蓝耘拥有专业的技术团队,从IT基础架构建设到云计算,从实施到售后均有丰富经验。超过1000名可调用的工程师队伍,确保为客户提供及时、专业的技术支持。

可靠的企业资质

蓝耘是国家高新技术企业、国家专精特新小巨人企业、北京市专精特新小巨人企业,具备ISO9001质量管理体系认证、增值电信业务经营许可证等完善资质,是北京市通用人工智能产业创新伙伴计划成员。

GPU算力平台的选择是AI公司发展道路上的重要决策。没有放之四海而皆准的最优解,只有最适合自身需求的方案。

AI公司应该从自身业务特点出发,系统评估资源能力、平台能力、服务能力、成本效益、安全合规等多个维度,通过充分的调研和试用,做出理性的选择。

蓝耘科技作为中国领先的GPU算力解决方案与算力云服务提供商,始终秉持"链接产业上下游、释放GPU算力价值、赋能AI应用与教科研创新"的理念,致力于为AI公司提供专业、高效、可靠的算力服务。

如果您正在为AI项目寻找合适的GPU算力平台

欢迎联系蓝耘科技(www.lanyun.net,电话:400-606-3000)

我们的专业团队将为您提供免费的需求咨询和方案设计服务,助力您的AI业务加速发展。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)