【探索实战】Kurator分布式云原生平台企业级落地:从集群纳管到全局监控的完整实践

Kurator通过集成主流云原生技术栈并在其上构建统一抽象层,成功解决了分布式云原生环境的管理复杂性。其独特的Fleet概念和Attached Cluster设计,使企业能够以一致的方式管理分布在任何地方的Kubernetes集群。未来,随着边缘计算和AI原生应用的普及,Kurator有望进一步强化其在云边端一体化管理和AI工作负载调度方面的能力。对于正在数字化转型道路上的企业而言,Kurator

【探索实战】Kurator分布式云原生平台企业级落地:从集群纳管到全局监控的完整实践

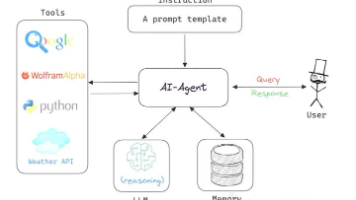

作为业界首个分布式云原生开源套件,Kurator旨在帮助企业快速构建开源开放的分布式云原生平台,实现跨云、跨边的数字化升级。本文将深入分享Kurator在企业环境中的实战经验,从环境搭建、功能实践到企业级落地,为开发者提供完整的分布式云原生解决方案。

一、Kurator分布式环境搭建:实战步骤与问题排查

1.1 环境准备与集群初始化

Kurator的安装遵循"基础设施即代码"理念,通过声明式API管理云、边缘或本地环境的基础设施。根据实战经验,环境搭建的核心步骤如下:

- 依赖检查:确保宿主机已安装Go 1.19+、Helm 3.0+及Docker等基础软件

- 源码编译:从官方仓库下载源码或Release包,构建

kurator可执行文件 - 集群纳管:对于现有Kubernetes集群,可通过AttachedCluster无侵入接入

这种设计允许Kurator纳管任何地点、由任何工具搭建的Kubernetes集群,让企业无需重建现有集群,大幅降低了迁移成本。

1.2 常见问题与解决方案

在安装过程中,可能会遇到以下几类典型问题:

- 镜像拉取失败:因网络限制导致

k8s.gcr.io访问超时,解决方案是替换镜像仓库为国内代理 - 集群状态同步延迟:多集群环境下控制面组件需要分钟级时间完成状态同步,可通过

kurator get fleet持续观察状态 - 权限配置错误:RBAC配置不当可能导致服务账户无法访问目标命名空间,需仔细检查ClusterRoleBinding的覆盖范围

实践表明,Kurator对硬件环境的要求并不高,但需要宿主机具有基本的操作系统和网络配置,以及Helm、Go等常用软件的支持。

二、统一应用分发:GitOps驱动的多集群部署实战

2.1 应用分发架构与配置

Kurator的统一应用分发采用GitOps方式,使得一键将应用部署到多个云环境成为可能。以下是一个典型的多集群应用分发配置:

apiVersion: apps.kurator.dev/v1alpha1

kind: Application

metadata:

name: gitrepo-kustomization-demo

namespace: default

spec:

source:

gitRepository:

interval: 3m0s

ref:

branch: master

timeout: 1m0s

url: https://github.com/stefanprodan/podinfo

syncPolicies:

- destination:

fleet: quickstart

kustomization:

interval: 5m0s

path: ./deploy/webapp

prune: true

timeout: 2m0s

这一配置实现了从Git仓库自动同步应用配置,并通过Fleet进行多集群同步和部署。

2.2 对云原生平台运维的价值分析

通过统一应用分发功能,企业能够获得显著的运维效能提升:

- 部署效率提升:应用部署从手工操作转为自动化流水线

- 一致性保障:Git仓库作为唯一信源,结合自动化同步机制,彻底避免配置漂移问题

- 运维复杂度降低:通过Fleet抽象,运维人员可以应用为中心管理资源,无需关心底层集群细节

在实际案例中,某实验室环境通过引入Kurator的统一应用分发,成功将应用发布耗时从42分钟缩短到7分钟,效率提升达83%。

三、企业级落地案例:智能音箱平台的云原生转型实践

3.1 技术选型与架构设计

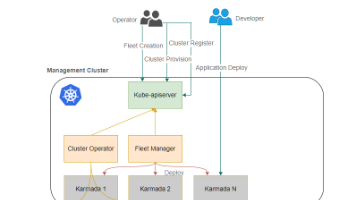

某智能音箱平台面临跨云边协同的需求,需要整合阿里云ACK、OpenStack私有云及边缘节点构建统一的云原生平台。在技术选型过程中,主要考量以下因素:

- 多云编排:基于Karmada实现应用跨集群调度

- 流量治理:通过Istio服务网格实现跨云流量管理

- 监控体系:采用Prometheus + Thanos构建全局监控

Kurator的Fleet概念为此提供了理想抽象,将多个集群视为单一逻辑单元管理,极大简化了多云环境的复杂性。

3.2 技术适配与挑战攻坚

在落地过程中,研发团队遇到了几个关键技术挑战:

- 网络连通性问题:不同云厂商的负载均衡器存在兼容性差异

- 资源异构性:边缘节点与云集群在资源配置上存在差异

- 证书管理:边缘证书30天过期问题,通过Kurator集成的cert-rotation CronJob解决

3.3 业务价值与效益分析

经过平台建设和业务迁移,该智能音箱平台获得了显著的商业价值:

- 运维效率提升:集群管理工作量减少,应用部署效率提升

- 成本优化:通过统一调度和智能伸缩,资源利用率提升

- 业务连续性保障:跨云容灾实现高可用性

- 故障定位效率:平均故障定位时间从55分钟缩短到10分钟,下降82%

四、统一监控与策略:全栈可观测性实践

4.1 基于Thanos的全局监控体系

Kurator提供基于Prometheus、Thanos、Grafana以及Fleet的多集群指标监控方案,以下是一个典型的Fleet监控配置:

apiVersion: fleet.kurator.dev/v1alpha1

kind: Fleet

metadata:

name: quickstart

namespace: default

spec:

clusters:

- name: kurator-member1

kind: AttachedCluster

- name: kurator-member2

kind: AttachedCluster

plugin:

metric:

thanos:

objectStoreConfig:

secretName: thanos-objstore

grafana: {}

该配置实现了多集群指标的统一收集和查询,每个集群运行一个Prometheus实例收集本地监控数据,通过Thanos Sidecar将数据推送到远程存储,最终由Thanos Query聚合所有数据并提供统一查询接口。

4.2 统一策略管理实践

Kurator通过集成Kyverno策略引擎,为多云、多集群环境提供统一的策略管理能力,以下是一个Pod安全策略的配置示例:

apiVersion: fleet.kurator.dev/v1alpha1

kind: Fleet

metadata:

name: quickstart

namespace: default

spec:

clusters:

- name: kurator-member1

kind: AttachedCluster

- name: kurator-member2

kind: Cluster

plugin:

policy:

kyverno:

podSecurity:

standard: baseline

severity: high

validationFailureAction: Audit

此配置为Fleet中的所有集群统一应用了Pod安全策略,当Pod配置违背安全策略时,会在创建过程中记录相应事件,有效保证了集群安全合规。

五、平台演进思考与最佳实践

5.1 Kurator在分布式云原生中的定位

Kurator并非简单的工具集成,而是通过"集成+抽象"的创新模式,将分布式云原生的复杂性封装为简洁API与策略。其核心价值体现在三个层面:

- 技术层面:统一抽象屏蔽底层异构性,提供一致性的管理体验

- 业务层面:加速应用交付与故障恢复,提升业务敏捷性

- 生态层面:推动CNCF技术栈的协同演进,避免厂商锁定

5.2 落地最佳实践

基于实战经验,我们总结出以下Kurator落地最佳实践:

- 渐进式采纳:从非核心业务开始试点,先使用统一应用分发和统一监控功能,再逐步扩展到统一流量治理和统一策略管理

- 团队能力建设:建立跨职能的云原生卓越中心,Kurator要求团队对Kubernetes、Istio、Prometheus等组件有基础认知

- 工具链整合:将Kurator与现有CI/CD工具链整合,形成完整的GitOps工作流

六、总结与展望

Kurator通过集成主流云原生技术栈并在其上构建统一抽象层,成功解决了分布式云原生环境的管理复杂性。其独特的Fleet概念和Attached Cluster设计,使企业能够以一致的方式管理分布在任何地方的Kubernetes集群。

未来,随着边缘计算和AI原生应用的普及,Kurator有望进一步强化其在云边端一体化管理和AI工作负载调度方面的能力。对于正在数字化转型道路上的企业而言,Kurator提供了一个成熟、开放且高效的技术选择,值得深入评估和采用。

参考资料

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)