YOLOv8【检测头篇·第6节】一文搞定,YOLOv6EfficientRep检测头!

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。部分章节也会结合国内外前沿论文与 AIGC 等大

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。

部分章节也会结合国内外前沿论文与 AIGC 等大模型技术,对主流改进方案进行重构与再设计,内容更偏实战与可落地,适合有工程需求的同学深入学习与对标优化。

✨ 特惠福利:当前限时活动一折秒杀,一次订阅,终身有效,后续所有更新章节全部免费解锁 👉 点此查看详情

全文目录:

😊 摘要

本文深入探讨了YOLOv6核心组件之一——EfficientRep检测头。我们将从其设计的动机出发,系统性地拆解其背后的关键技术:结构重参数化 (ructural Re-parameterization)。通过详尽的数学推导、生动的图解和可运行的PyTorch代码,你将彻底理解RepVGG块如何实现训练时多分支增强性能、推理时单分支极致加速的“变形”魔法。最终,我们将分析EfficientRep头如何凭借其硬件友好的设计,在GPU等现代计算设备上实现卓越的推理效率,并探讨其为何对模型量化如此友好。

📜 第一部分:上期回顾

在上一期《YOLOv8【检测头篇·第5节】一文搞懂,PP-YOLOE高效检测头!》激动人心的探索中,我们一同剖析了来自百度飞桨的卓越模型——PP-YOLOE,特别是其简洁而高效的检测头设计。在我们一头扎进YOLOv6的“重参数化”世界之前,让我们先花点时间,巩固一下从PP-YOLOE中学到的宝贵知识。温故而知新,这能帮助我们更好地理解本章的技术演进脉络。

1.1 回顾 PP-YOLOE 的核心理念

PP-YOLOE的设计哲学可以用一个词来概括:“极致的平衡”。它并非盲目追求SOTA(State-of-the-Art)的某个单项指标,而是在精度和速度之间寻找到了一个绝佳的“甜点区”,尤其是在工业部署场景下,这种平衡显得尤为重要。

-

高效的Backbone与Neck:PP-YOLOE采用了基于

RepResBlock(注意,这里已经有“Rep”的影子了,但与本章的RepVGG机制不同)的CSPRepResNet作为骨干网络,配合轻量化的RT-PAN(Reparameterized Task-aware PAN)作为特征融合的Neck。整个基础架构的设计,从一开始就将“高效”二字刻在了骨子里。 -

为什么PP-YOLOE如此“高效”?

它的高效不仅仅体现在模型的FLOPs(浮点运算次数)较低,更重要的是,它关注实际的推理延迟 (Latency)。它通过在“软设计”层面,即标签分配策略和损失函数上进行深度创新,使得一个相对轻量的模型结构能够爆发出强大的检测性能。这就像一位武林高手,招式(网络结构)简洁,但内力(训练方法)深厚。

1.2 关键技术点复盘

PP-YOLOE的精髓,集中体现在其检测头(ET-Head, Efficient Task-aligned Head)以及配套的训练策略上。

-

TaskAlignedAssigner (TAL):任务对齐的标签分配策略

我们曾深入探讨过,目标检测中的分类任务和回归任务天然存在一种“错位”:分类得分最高的预测框,不一定是边界框回归最准的那个。TAL巧妙地解决了这个问题。它不再仅仅依赖IoU来划分正负样本,而是设计了一个任务对齐度量 (task alignment metric),该度量同时考虑了分类得分和IoU:设

t = s α × u β t = s^α × u^β t=sα×uβ其中 s 是分类得分,u 是 IoU 值,α 和 β 是超参数。通过这个度量,TAL能够为每个真实框(Ground Truth)动态地挑选出“分类又准、定位又好”的那些样本作为正样本,从而极大地提升了模型学习的一致性,解决了分类与回归“貌合神离”的难题。

-

Distribution Focal Loss (DFL):让网络“精准”地学习边界框的概率分布

传统回归损失(如Smooth L1, CIoU)将边界框的坐标视为一个确定的浮点数进行回归。而PP-YOLOE借鉴了GFL (Generalized Focal Loss) 的思想,将回归问题转化为一个概率分布的学习问题。它让网络去学习边界框坐标在其邻近整数位置的概率。这样做的好处是:- 提供了更丰富的信息:模型不仅知道“最佳”位置,还知道这个位置的“不确定性”或“置信度”。

- 与分类损失的统一:将回归问题用类似分类的交叉熵损失来优化,使得整个损失函数体系更加和谐。

DFL的引入,让边界框的预测变得更加“柔和”且精准,尤其是在处理一些边界模糊的物体时,效果显著。

-

ET-Head:简洁高效的解耦

PP-YOLOE的检测头本身结构非常简洁,它采用了解耦头 (Decoupled Head) 的设计,为分类和回归任务设置了独立的、轻量级的卷积分支。这种设计避免了两个任务之间的参数共享可能带来的冲突,同时通过精心设计的通道数和卷积层数,保持了极低的计算开销。

1.3 承上启下:从“分配策略”到“结构创新”

通过回顾,我们可以清晰地看到:PP-YOLOE的成功,很大程度上归功于其在“软设计”(损失函数、标签分配策略)上的深度耕耘。 它向我们展示了,在不大幅增加模型复杂度的前提下,通过优化训练的“指挥系统”,同样可以实现性能的巨大飞跃。

那么,问题来了:除了在“软设计”上做文章,我们还能从哪里寻找优化的突破口呢?

答案是:回到**“硬设计”本身!也就是说,回到构成检测头的基本计算单元**上。

本章,我们将要探索的YOLOv6 EfficientRep检测头,就是“硬设计”创新的典范。它引入了一种被称为 “结构重参数化” 的“黑魔法”,让检测头的结构在训练和推理时呈现出完全不同的形态,如同一个“变形金刚”。这种设计,旨在同时吸收两种形态的优点,达到前所未有的速度与精度平衡。

准备好了吗?让我们一起从PP-YOLOE的智慧中汲取力量,迈向一个全新的、充满结构之美的领域!💪

🚀 第二部分:本章引言:YOLOv6 与 EfficientRep 的登场

2.1 YOLOv6 的“快”,不止于快

YOLOv6是由美团视觉智能团队倾力打造的高性能目标检测器。如果你关注计算机视觉领域,你一定听过它响亮的名号。与许多诞生于学术界、以刷新COCO数据集榜单为主要目的的模型不同,YOLOv6从设计之初就带有一个非常明确的工业界烙印:为实际部署而生,追求极致的硬件推理效率。

这意味着YOLOv6的“快”,不仅仅是降低FLOPs或者参数量(Params),而是真正关心在主流硬件(如NVIDIA GPU)上,模型从输入到输出所需的时间(Latency)。它的每一处设计,都透露出对硬件计算特性深刻的理解。

2.2 为什么需要“新”的检测头?

在YOLOv6诞生之前,YOLO系列检测头的设计主要分为两大流派:

-

耦合头 (Coupled Head):以YOLOv3、YOLOv5为代表。分类和回归任务共享同一组卷积特征。

- 优点:结构简单,计算量小,速度快。

- 缺点:任务之间存在一定的冲突和妥协,可能会限制模型的最终精度上限。

-

解耦头 (Decoupled Head):以YOLOX、PP-YOLOE为代表。为分类和回归任务提供独立的特征提取分支。

- 优点:任务专注,消除了参数共享的冲突,通常能达到更高的检测精度。

- 缺点:引入了额外的分支和计算量,导致推理速度相对较慢。

那么,有没有一种方法,可以让我们鱼与熊掌兼得呢?——既享受到解耦头带来的高精度,又拥有接近甚至超越耦合头的高速度?

这听起来似乎有些“贪心”,但聪明的工程师们真的找到了一条路径。这条路,就是 结构重参数化 (Structural Re-parameterization)。

2.3 EfficientRep Head 核心思想速览

重参数化是YOLOv6 EfficientRep检测头的灵魂。它的核心思想可以概括为一句话:“训练一个复杂的、多分支的结构来提升性能,然后通过等效的数学变换,将其融合成一个简单的、单分支的结构用于推理。”

让我们用一个生动的比喻来理解它:

- 训练时 (Training-Time):检测头就像一个“专家团队”。团队里有多个成员(多个网络分支),有的擅长捕捉轮廓(比如一个 3×3 卷积分支),有的擅长提炼核心特征(比如一个 1×1 卷积分支),有的则确保信息不丢失(比如一个恒等映射分支)。大家各司其职,共同学习,使得整个团队的“业务能力”(模型表征能力)非常强。

- 推理时 (Inference-Time):在模型训练好、即将上阵执行任务时,我们不再需要这个庞大的“专家团队”了。通过一番“魔法操作”(数学融合),我们将所有专家的“毕生所学”都灌注到一个“全能战士”(一个单一的 3×3 卷积)身上。这个“全能战士”独自上场,身手矫健,速度极快,但能力丝毫不减,因为它已经继承了整个团队的智慧。

最终目标:在不增加任何推理时间成本(甚至因为结构更简单而加速)的前提下,获得由复杂训练结构带来的“无痛涨点”。

2.4 本章学习目标 🎯

通过本篇文章的学习,你将收获满满的知识和技能,保证不虚此行!

- 🧠 彻底搞懂:RepVGG 结构重参数化的核心数学原理,理解卷积与BN层融合、多分支卷积核相加的每一个细节。

- ✍️ 学会动手:我们将用 PyTorch 代码,一步步实现 RepVGG 模块从“训练形态”到“推理形态”的神奇转换。

- 🔍 解析架构:你将能清晰地画出 YOLOv6 EfficientRep Head 的完整结构图,并理解其为何采用解耦设计以及RepBlock堆叠。

- 🚀 洞悉性能:深入探讨该设计为何对 GPU/NPU 等现代硬件如此友好,以及它在模型量化部署中的巨大优势。

太棒了!我们立刻进入最核心、最激动人心的部分!🔥

准备好你的“算力”,我们要开始推公式、画图、写代码了。这一部分是理解 EfficientRep 乃至所有重参数化模型的基石,我会讲得非常详细,确保你100%掌握!

🔬 第三部分:核心技术:RepVGG 重参数化详解

在上一部分,我们卖了个关子,说 EfficientRep Head 像一个“变形金刚”,训练和推理时形态不同。这个“变形”的魔法,就是大名鼎鼎的结构重参数化 (Structural Re-parameterization),而其最经典的实现,正是 RepVGG。

YOLOv6 的 EfficientRep Head,就是完全基于 RepVGG 的思想来构建的。所以,搞懂了 RepVGG,YOLOv6 的检测头对你来说就再无秘密可言!

3.1 什么是结构重参数化? (The “Big Idea”)

让我们再来深化一下那个“特种部队”的比喻:

-

训练时(追求“强”):我们希望模型“学得好”。就像训练一支特种部队,我们有多个分支(专家):

- 3×3 卷积分支:主力突击手,负责提取丰富的局部空间特征。

- 1×1 卷积分支:精确射手,负责通道间的特征融合和信息提炼。

- 恒等映射 (Identity) 分支:后勤保障员,负责保留原始信息,防止梯度消失(类似于 ResNet 的残差连接)。

在训练时,输入特征会同时流经这三个分支,然后将三个分支的输出相加。这种“多路并联”的设计,极大地丰富了模型的表征能力和梯度路径,使得模型能够学习到更鲁棒、更强大的特征,从而提高最终的精度。

-

推理时(追求“快”):我们希望模型“跑得快”。在工业部署时,多分支结构是“累赘”的:

- 访存开销大:需要分别读取三个分支的参数和计算三个分支的中间结果。

- Add 操作是瓶颈:在GPU上,“Add”操作是访存密集型 (Memory-Bound) 操作,它的计算量(FLOPs)很低,但非常耗时(需要等待数据读写),会“拖慢”整个计算流程。

结构重参数化的“魔法”就在于:它利用了卷积运算和BN(Batch Normalization)运算都是线性运算的特性,在数学上证明了,上述的“三个分支相加”可以等效融合 (Equivalently Fused) 成一个单独的 3×3 卷积!

于是,在模型训练完毕、准备部署时,我们就执行这个“融合”操作,把三个分支的参数(权重和偏置)通过计算,合并成一组新的参数,加载到一个单独的 3×3 卷积层中。

- 训练时: O u t p u t = B r a n c h 3 × 3 ( x ) + B r a n c h 1 × 1 ( x ) + B r a n c h I d e n t i t y ( x ) Output = Branch_3×3(x) + Branch_1×1(x) + Branch_Identity(x) Output=Branch3×3(x)+Branch1×1(x)+BranchIdentity(x)

- 推理时: O u t p u t = C o n v 3 × 3 f u s e d ( x ) Output = Conv_3×3_fused(x) Output=Conv3×3fused(x)

这两个 Output 在数学上是完全相等的!我们就这样,在不损失任何精度(由训练时的复杂结构保证)的前提下,得到了一个极致简洁、推理速度飞快的单分支结构。这就是重参数化的核心思想——用训练时的复杂性,换取推理时的简洁性。

3.2 RepVGG 块的“变形”魔法

现在,让我们深入这个“魔法”的内部,看看它是如何实现的。这个过程分为两步:

- 魔法(一):将每个分支内部的卷积层 (Conv) 和 BN层融合。

- 魔法(二):将三个已经融合好的分支,进一步融合成一个 3×3 卷积。

3.2.1 训练形态 (Training-Time Structure)

首先,我们必须清晰地了解训练时的结构。一个标准的 RepVGG 块(假设输入输出通道数相同,步长为1)包含三个并行的分支:

- 分支1 (Dense):一个 3×3 卷积,后跟一个 BN 层。

- 分支2 (1×1):一个 1×1 卷积,后跟一个 BN 层。

- 分支3 (Identity):一个 BN 层(如果输入输出通道数不同,则此分支不存在)。

它们的输出在最后被简单相加。

我们可以使用 Mermaid 来绘制这个结构:

如上图所示,输入 x 被同时送入三个分支,每个分支都进行了自己的计算(卷积+BN),最后的结果 y 1 , y 2 , y 3 y₁, y₂, y₃ y1,y2,y3 在 Add 节点处相加,得到最终的输出 y = y 1 + y 2 + y 3 y = y₁ + y₂ + y₃ y=y1+y2+y3。

3.2.2 融合魔法(一):卷积与 BN 层的等效合并

这是重参数化的第一步,也是最关键的数学原理。我们要把任意一个 Conv + BN 的组合,等效成一个带偏置 (bias) 的 Conv。

我们先来回顾一下这两个运算的数学公式(假设是在推理模式,BN 使用全局的均值和方差):

-

卷积 (Conv):

设卷积核权重为 W(一个4D张量),偏置为 b(一个1D张量)。卷积运算可以表示为:C ( x ) = W ∗ x + b C(x) = W * x + b C(x)=W∗x+b

(注意:为了简化,我们通常在 Conv 层后接 BN 时,不设置 Conv 的偏置,即 b = 0。但为了推导的完整性,我们先假设 b 存在。)

-

批归一化 (BN):

设 BN 层的学习参数为 γ(缩放)和 β(平移),在训练中累积的全局均值为 μ,全局方差为 σ²。ε 是一个很小的常数(如 1e-5)防止除以零。

BN 运算可以表示为:B ( x ) = γ ⋅ ( x − μ ) / √ ( σ 2 + ε ) + β B(x) = γ · (x − μ) / √(σ² + ε) + β B(x)=γ⋅(x−μ)/√(σ2+ε)+β

现在,我们将卷积的输出 C(x) 代入 BN 层的 x 中:

B ( C ( x ) ) = γ ⋅ ( ( W ∗ x + b − μ ) / √ ( σ 2 + ε ) ) + β B(C(x)) = γ · ((W * x + b − μ) / √(σ² + ε)) + β B(C(x))=γ⋅((W∗x+b−μ)/√(σ2+ε))+β

我们对这个式子进行重新排列,目标是把它整理成 F u s e d C o n v ( x ) = W f u s e d ∗ x + b f u s e d FusedConv(x) = W_fused * x + b_fused FusedConv(x)=Wfused∗x+bfused 的形式:

B ( C ( x ) ) = γ σ 2 + ϵ ⋅ ( W ⋅ x + b − μ ) + β B(C(x)) = \frac{\gamma}{\sqrt{\sigma^2 + \epsilon}} \cdot (W \cdot x + b - \mu) + \beta B(C(x))=σ2+ϵγ⋅(W⋅x+b−μ)+β

= γ σ 2 + ϵ ⋅ W ⋅ x + γ σ 2 + ϵ ⋅ ( b − μ ) + β = \frac{\gamma}{\sqrt{\sigma^2 + \epsilon}} \cdot W \cdot x + \frac{\gamma}{\sqrt{\sigma^2 + \epsilon}} \cdot (b - \mu) + \beta =σ2+ϵγ⋅W⋅x+σ2+ϵγ⋅(b−μ)+β

神奇的事情发生了!对比目标形式 F u s e d C o n v ( x ) = W f u s e d ∗ x + b f u s e d FusedConv(x) = W_fused * x + b_fused FusedConv(x)=Wfused∗x+bfused,我们可以清晰地得到:

-

融合后的新权重 W f u s e d W_fused Wfused:

W f u s e d = ( γ / √ ( σ 2 + ε ) ) ⋅ W W_fused = (γ / √(σ² + ε)) · W Wfused=(γ/√(σ2+ε))⋅W

-

融合后的新偏置 b_fused:

b f u s e d = ( γ / √ ( σ 2 + ε ) ) ⋅ ( b − μ ) + β b_fused = (γ / √(σ² + ε)) · (b − μ) + β bfused=(γ/√(σ2+ε))⋅(b−μ)+β

这个推导告诉我们:任何一个 Conv + BN 的序列,都可以被精确地等效替换为一个单独的、带有偏置项的 Conv 层。

我们只需要从训练好的模型中,分别提取出 C o n v Conv Conv 层的 W W W(和 b b b,如果存在的话),以及 BN 层的 γ , β , μ , σ 2 γ, β, μ, σ² γ,β,μ,σ2,然后通过上述两个公式,就能计算出新的 W f u s e d W_fused Wfused 和 b f u s e d b_fused bfused。

应用到 RepVGG 的分支:

- 3×3 分支: C o n v 3 × 3 + B N 3 × 3 Conv_3×3 + BN_3×3 Conv3×3+BN3×3 ⇒ F u s e d C o n v 3 × 3 FusedConv_3×3 FusedConv3×3(带有 W f u s e d 3 × 3 W_fused_3×3 Wfused3×3 和 b f u s e d 3 × 3 b_fused_3×3 bfused3×3)

- 1×1 分支: C o n v 1 × 1 + B N 1 × 1 Conv_1×1 + BN_1×1 Conv1×1+BN1×1⇒ F u s e d C o n v 1 × 1 FusedConv_1×1 FusedConv1×1(带有 W f u s e d 1 × 1 W_fused_1×1 Wfused1×1 和 b f u s e d 1 × 1 b_fused_1×1 bfused1×1)

- Identity 分支:这个分支只有一个 BN_Identity。我们可以把它看作一个 W = I W = I W=I(单位矩阵)、 b = 0 b = 0 b=0 的

Identity-Conv加上一个 B N BN BN 层。更简单的方法是,我们先把它等效为一个 1 × 1 1×1 1×1 卷积(见下一步)。

3.2.3 融合魔法(二):多分支卷积核的合并

经过“魔法(一)”的处理,我们的模型结构变成了:

- 分支1:一个融合后的 3×3 卷积 (带偏置)

- 分支2:一个融合后的 1×1 卷积 (带偏置)

- 分支3:一个 BN 层(或无)

我们的最终目标是把这三个分支合并成一个 3×3 卷积。为此,我们需要把所有分支都统一成 3×3 卷积核的形态。

1. 1×1 卷积核 Pad 成 3×3 卷积核

一个 1×1 卷积,可以被等效为一个 3×3 卷积,只要这个 3×3 卷积核的 3×3 空间窗口中,只有中心点的权重不为0,其余8个位置的权重都为0。

- 原始 1×1 卷积核: W f u s e d 1 × 1 W_fused_1×1 Wfused1×1

- 等效 3×3 卷积核 W p a d d e d 1 × 1 W_padded_1×1 Wpadded1×1:创建一个全0的 3 × 3 3×3 3×3 卷积核,然后把 W f u s e d 1 × 1 W_fused_1×1 Wfused1×1 的值赋给其中心位置

[..., 1, 1]即可。 - 偏置 b_padded_1×1:保持不变,即 b f u s e d 1 × 1 b_fused_1×1 bfused1×1。

2. Identity (BN) 分支等效为 3×3 卷积核

-

情况 A:只有 BN 层(假设

in_channels == out_channels)首先,我们应用“魔法(一)”的公式,此时 W 是一个单位矩阵(对角线为1,其余为0)的 1×1 卷积核,b = 0。我们先将其融合为 F u s e d C o n v I d e n t i t y FusedConv_Identity FusedConvIdentity(带有 W f u s e d I d e n t i t y W_fused_Identity WfusedIdentity 和 b f u s e d I d e n t i t y b_fused_Identity bfusedIdentity)。

然后,再将 W_fused_Identity 按步骤 1 进行 Padding,得到 3×3 卷积核 W p a d d e d I d e n t i t y W_padded_Identity WpaddedIdentity。 -

情况 B:无 Identity 分支(当

in_channels != out_channels时)这个分支不存在,我们可以认为它的权重和偏置都是0。

3. 最终融合:卷积核相加!

现在,我们有了三个形态完全一致的分支(如果分支不存在,就用0填充):

- 分支1: W = W f u s e d 3 × 3 , b = b f u s e d 3 × 3 W = W_fused_3×3, b = b_fused_3×3 W=Wfused3×3,b=bfused3×3

- 分支2: W = W p a d d e d 1 × 1 , b = b p a d d e d 1 × 1 W = W_padded_1×1, b = b_padded_1×1 W=Wpadded1×1,b=bpadded1×1

- 分支3: W = W p a d d e d I d e n t i t y , b = b p a d d e d I d e n t i t y W = W_padded_Identity, b = b_padded_Identity W=WpaddedIdentity,b=bpaddedIdentity

由于卷积运算的可加性 (Additivity):

( W A ∗ x + b A ) + ( W B ∗ x + b B ) = ( W A + W B ) ∗ x + ( b A + b B ) (W_A * x + b_A) + (W_B * x + b_B) = (W_A + W_B) * x + (b_A + b_B) (WA∗x+bA)+(WB∗x+bB)=(WA+WB)∗x+(bA+bB)

我们的训练时输出是三个分支相加:

O u t p u t = B r a n c h 1 ( x ) + B r a n c h 2 ( x ) + B r a n c h 3 ( x ) Output = Branch₁(x) + Branch₂(x) + Branch₃(x) Output=Branch1(x)+Branch2(x)+Branch3(x)

这完全等同于:

O u t p u t = ( W f u s e d _ 3 × 3 + W p a d d e d 1 × 1 + W p a d d e d I d e n t i t y ) ∗ x + ( b f u s e d 3 × 3 + b p a d d e d 1 × 1 + b p a d d e d I d e n t i t y ) Output = (W_fused\_3×3 + W_padded_1×1 + W_padded_Identity) * x+ (b_fused_3×3 + b_padded_1×1 + b_padded_Identity) Output=(Wfused_3×3+Wpadded1×1+WpaddedIdentity)∗x+(bfused3×3+bpadded1×1+bpaddedIdentity)

我们梦寐以求的最终部署 (Deploy) 卷积核和偏置就此诞生了:

- W_deploy (最终3×3卷积核):

W d e p l o y = W f u s e d 3 × 3 + W p a d d e d 1 × 1 + W p a d d e d I d e n t i t y W_deploy = W_fused_3×3 + W_padded_1×1 + W_padded_Identity Wdeploy=Wfused3×3+Wpadded1×1+WpaddedIdentity

- b_deploy (最终偏置):

b d e p l o y = b f u s e d 3 × 3 + b p a d d e d 1 × 1 + b p a d d e d I d e n t i t y b_deploy = b_fused_3×3 + b_padded_1×1 + b_padded_Identity bdeploy=bfused3×3+bpadded1×1+bpaddedIdentity

至此,我们成功地将三个复杂的分支,数学上完美地等效融合进了一个单独的 3×3 卷积层!

3.3【代码实战】RepVGG 块的实现与转换 (PyTorch)

理论是指导,实践是王道!talk is cheap, show me the code!

让我们用 PyTorch 来亲手实现这个“变形金刚”——RepVGGBlock。

我们将实现一个完整的、可运行的类,它包含:

- 训练时的多分支结构 (

__init__和forward)。 _fuse_bn_tensor核心函数,实现“魔法(一)”。switch_to_deploy核心方法,实现“魔法(二)”并切换模式。- 一个验证脚本,证明训练态和推理态的输出完全一致。

# 导入必要的库

import torch

import torch.nn as nn

import numpy as np

import copy # 用于深度复制模块

class RepVGGBlock(nn.Module):

"""

RepVGGBlock 是 RepVGG 的核心构建块。

它在训练时使用多分支结构 (3x3 conv, 1x1 conv, identity),

在推理时通过重参数化融合成一个单一的 3x3 卷积。

"""

def __init__(self, in_channels, out_channels, kernel_size=3, stride=1,

padding=1, dilation=1, groups=1, padding_mode='zeros', deploy=False):

"""

初始化 RepVGG 块。

参数:

- in_channels (int): 输入通道数

- out_channels (int): 输出通道数

- kernel_size (int): 卷积核大小,这里固定为 3

- stride (int): 步长

- padding (int): 填充

- dilation (int): 膨胀

- groups (int): 分组卷积的组数

- padding_mode (str): 填充模式

- deploy (bool): 是否为部署模式。默认为 False (训练模式)。

"""

super(RepVGGBlock, self).__init__()

self.in_channels = in_channels

self.out_channels = out_channels

self.kernel_size = kernel_size

self.stride = stride

self.padding = padding

self.dilation = dilation

self.groups = groups

self.padding_mode = padding_mode

self.deploy = deploy

# 部署模式 (Inference-Time)

if deploy:

# 推理时,只有一个 3x3 卷积层

self.rbr_reparam = nn.Conv2d(

in_channels=in_channels,

out_channels=out_channels,

kernel_size=kernel_size,

stride=stride,

padding=padding,

dilation=dilation,

groups=groups,

bias=True, # 融合后一定带 bias

padding_mode=padding_mode

)

# 训练模式 (Training-Time)

else:

# 训练时,有三个分支

# 1. 3x3 卷积分支

self.rbr_dense = nn.Sequential(

nn.Conv2d(

in_channels=in_channels,

out_channels=out_channels,

kernel_size=kernel_size,

stride=stride,

padding=padding,

groups=groups,

bias=False # Conv 后面接 BN,bias 设为 False

),

nn.BatchNorm2d(num_features=out_channels) # BN 层

)

# 2. 1x1 卷积分支

self.rbr_1x1 = nn.Sequential(

nn.Conv2d(

in_channels=in_channels,

out_channels=out_channels,

kernel_size=1, # 1x1 卷积

stride=stride, # 步长要和 3x3 分支一致

padding=0, # 1x1 卷积不需要 padding

groups=groups,

bias=False

),

nn.BatchNorm2d(num_features=out_channels)

)

# 3. 恒等映射 (Identity) 分支

# 只有当 in_channels == out_channels 且 stride == 1 时,

# 才需要恒等映射分支,否则输入输出形状不一致,无法相加

if out_channels == in_channels and stride == 1:

self.rbr_identity = nn.BatchNorm2d(num_features=in_channels)

else:

# 否则,将此分支置为 None

self.rbr_identity = None

# (可选) 激活函数,YOLOv6 中通常在 RepBlock 外部添加

# self.nonlinearity = nn.ReLU()

def forward(self, inputs):

"""

前向传播

"""

# 如果是部署模式,直接使用融合后的 3x3 卷积

if self.deploy:

return self.rbr_reparam(inputs)

# ----------------------------------------------------

# 以下是训练模式的前向传播

# ----------------------------------------------------

# 计算 3x3 卷积分支

out_3x3 = self.rbr_dense(inputs)

# 计算 1x1 卷积分支

out_1x1 = self.rbr_1x1(inputs)

# 计算 Identity 分支

if self.rbr_identity is not None:

out_identity = self.rbr_identity(inputs)

else:

# 如果没有 identity 分支,则输出为 0

out_identity = 0

# 三个分支的结果相加

# (PyTorch 中,张量 + 0 还是等于原张量)

output = out_3x3 + out_1x1 + out_identity

# (可选)

# output = self.nonlinearity(output)

return output

# -----------------------------------------------------------------

# ----- 以下是核心的“重参数化”代码 (魔法实现) -----

# -----------------------------------------------------------------

def get_equivalent_kernel_bias(self):

"""

计算等效的 3x3 卷积核 W_deploy 和偏置 b_deploy。

这是实现“魔法(二)”:多分支融合 的核心。

"""

# 1. 融合 3x3 卷积分支 (魔法一)

kernel_3x3, bias_3x3 = self._fuse_bn_tensor(self.rbr_dense)

# 2. 融合 1x1 卷积分支 (魔法一)

kernel_1x1, bias_1x1 = self._fuse_bn_tensor(self.rbr_1x1)

# 2.1 将 1x1 卷积核 Pad 成 3x3 (魔法二: Padding)

# kernel_1x1 的形状是 [out_c, in_c, 1, 1]

# 我们需要在最后两个维度 (H, W) 上 Padding

# 填充 (1,1) 是指在 H 维度前填充1个0, 后填充1个0

# (1,1) 是指在 W 维度前填充1个0, 后填充1个0

kernel_1x1_padded = nn.functional.pad(

kernel_1x1,

[1, 1, 1, 1], # (pad_left, pad_right, pad_top, pad_bottom)

mode='constant',

value=0

)

# 偏置 bias_1x1 不需要 Padding

# 3. 融合 Identity 分支

kernel_identity, bias_identity = 0, 0 # 默认为 0

if self.rbr_identity is not None:

# (魔法一)

# Identity 分支可以看作一个 W=单位矩阵, b=0 的 1x1 卷积 + BN

# 创建一个 1x1 的单位矩阵卷积核

# 形状为 [out_c, in_c, 1, 1] (in_c == out_c)

in_c = self.in_channels

identity_conv_weight = torch.zeros(

(in_c, in_c, 1, 1),

dtype=self.rbr_dense[0].weight.dtype,

device=self.rbr_dense[0].weight.device

)

# 将对角线元素设为 1

for i in range(in_c):

identity_conv_weight[i, i, 0, 0] = 1.0

# 融合这个“虚拟”的 1x1 卷积和 Identity BN 层

kernel_identity, bias_identity = self._fuse_bn_tensor(

(identity_conv_weight, self.rbr_identity) # 传入 (W, BN层)

)

# (魔法二: Padding)

# 将融合后的 1x1 Identity 核 Pad 成 3x3

kernel_identity = nn.functional.pad(

kernel_identity,

[1, 1, 1, 1],

mode='constant',

value=0

)

# 4. 最终融合:所有分支的权重和偏置相加 (魔法二: Add)

final_kernel = kernel_3x3 + kernel_1x1_padded + kernel_identity

final_bias = bias_3x3 + bias_1x1 + bias_identity

return final_kernel, final_bias

def _fuse_bn_tensor(self, branch):

"""

实现“魔法(一)”:将 Conv+BN 融合成一个带偏置的 Conv。

输入:

- branch:

- nn.Sequential(Conv, BN)

- 或 (torch.Tensor, BN) (用于处理 Identity 分支)

返回:

- 融合后的 W_fused (Tensor)

- 融合后的 b_fused (Tensor)

"""

if isinstance(branch, nn.Sequential):

# -------------------------------------

# 情况一:输入是 nn.Sequential(Conv, BN)

# -------------------------------------

conv = branch[0] # 卷积层

bn = branch[1] # BN 层

# 从 Conv 层获取权重

conv_weight = conv.weight

# Conv 层是否有偏置?(我们设计时是 False)

if conv.bias is not None:

conv_bias = conv.bias

else:

conv_bias = torch.zeros_like(bn.running_mean) # 创建一个全 0 偏置

else:

# -------------------------------------

# 情况二:输入是 (W_tensor, BN) (用于 Identity)

# -------------------------------------

conv_weight = branch[0] # W 是传入的单位矩阵

bn = branch[1] # BN 层

conv_bias = torch.zeros_like(bn.running_mean) # 0 偏置

# -------------------------------------

# ---- 开始应用 3.2.2 节的数学公式 ----

# -------------------------------------

# 从 BN 层获取 μ (running_mean) 和 σ² (running_var)

mu = bn.running_mean

sigma_sq = bn.running_var

# 从 BN 层获取 γ (weight) 和 β (bias)

gamma = bn.weight

beta = bn.bias

# 获取 ε (eps)

eps = bn.eps

# 1. 计算标准差 sqrt(σ² + ε)

std = (sigma_sq + eps).sqrt()

# 2. 计算 γ / sqrt(σ² + ε)

# .view(-1, 1, 1, 1) 是为了将 [out_c] 广播到 [out_c, in_c, H, W] 的形状

# 以便与 W (conv_weight) 进行逐元素相乘

t = (gamma / std).view(-1, 1, 1, 1)

# 3. 计算 W_fused = W * t

fused_kernel = conv_weight * t

# 4. 计算 γ * (b − μ) / sqrt(σ² + ε) + β

# .view(-1) 确保形状为 [out_c]

fused_bias = beta + (gamma / std) * (conv_bias - mu)

return fused_kernel, fused_bias

def switch_to_deploy(self):

"""

公开方法:将模型从训练态切换到部署态。

"""

if self.deploy:

# 如果已经是部署模式,直接返回

return

print(f"RepVGGBlock (in={self.in_channels}, out={self.out_channels}) 正在切换到部署模式...")

# 1. 计算融合后的 W_deploy 和 b_deploy

fused_kernel, fused_bias = self.get_equivalent_kernel_bias()

# 2. 创建部署模式的 3x3 卷积层

self.rbr_reparam = nn.Conv2d(

in_channels=self.in_channels,

out_channels=self.out_channels,

kernel_size=self.kernel_size,

stride=self.stride,

padding=self.padding,

dilation=self.dilation,

groups=self.groups,

bias=True, # 必须为 True,因为融合后有偏置

padding_mode=self.padding_mode

)

# 3. 将计算好的参数加载到新层中

self.rbr_reparam.weight.data = fused_kernel

self.rbr_reparam.bias.data = fused_bias

# 4. 设置标志位

self.deploy = True

# 5. (重要) 删除训练时的分支,释放内存

del self.rbr_dense

del self.rbr_1x1

if hasattr(self, 'rbr_identity'): # 检查是否存在

del self.rbr_identity

print(f"RepVGGBlock (in={self.in_channels}, out={self.out_channels}) 切换完成!")

3.3.4 完整可运行 Demo (验证融合的正确性)

光有代码还不行,我们必须验证它!下面的脚本将展示 train_mode 和 deploy_mode 的输出是否一致。

# -----------------------------------------------------------------

# ----- 验证脚本:对比训练态和部署态的输出 -----

# -----------------------------------------------------------------

if __name__ == '__main__':

# 1. 设置超参数

IN_C = 64 # 输入通道

OUT_C = 128 # 输出通道

H, W = 16, 16 # 特征图高宽

STRIDE = 1 # 步长 (设为 1 来测试 Identity 分支)

# 为了保证可复现性,固定随机种子

torch.manual_seed(42)

np.random.seed(42)

print("===== 开始验证 RepVGG 融合正确性 =====")

# 2. 创建一个随机输入张量

# (N, C, H, W)

dummy_input = torch.randn(2, IN_C, H, W)

# ---------------------------------

# ----- 步骤 A: 训练模式 (Train)

# ---------------------------------

# 3. 创建一个训练模式的 RepVGGBlock

train_model = RepVGGBlock(

in_channels=IN_C,

out_channels=OUT_C,

stride=STRIDE

)

# 4. (关键!) 将模型设置为 .eval() 模式

train_model.eval()

# 5. 获取训练模式的输出

with torch.no_grad():

train_output = train_model(dummy_input)

print(f"\n训练模式 (Train Mode) 输出 (前5个值): \n{train_output.flatten()[:5]}")

# ---------------------------------

# ----- 步骤 B: 部署模式 (Deploy)

# ---------------------------------

# 6. 复制一个模型用于部署模式

deploy_model = copy.deepcopy(train_model)

# 7. 调用“魔法”开关,切换到部署模式

deploy_model.switch_to_deploy()

# 8. 确保部署模型也处于 .eval() 模式

deploy_model.eval()

# 9. 获取部署模式的输出

with torch.no_grad():

deploy_output = deploy_model(dummy_input)

print(f"\n部署模式 (Deploy Mode) 输出 (前5个值): \n{deploy_output.flatten()[:5]}")

# ---------------------------------

# ----- 步骤 C: 对比结果

# ---------------------------------

# 10. 计算两个输出之间的绝对差值

difference = torch.abs(train_output - deploy_output)

print(f"\n最大差值 (Max Absolute Difference): {difference.max().item()}")

# 11. 使用 torch.allclose 来验证两个张量是否“足够接近”

is_close = torch.allclose(train_output, deploy_output, atol=1e-6)

if is_close:

print("\n✅ 验证通过!训练态和部署态的输出完全一致!")

print("重参数化成功!🎉🎉🎉")

else:

print("\n❌ 验证失败!输出不一致!请检查代码。")

# (可选) 打印模型结构对比

print("\n--- 训练模式模型结构 (Train Model) ---")

print(train_model)

print("\n--- 部署模式模型结构 (Deploy Model) ---")

print(deploy_model)

当你运行上述 if __name__ == '__main__': 中的代码时,你将会看到:

- 打印出

RepVGGBlock (in=64, out=128) 正在切换到部署模式...的提示。 - 训练模式输出的前5个值 和 部署模式输出的前5个值 几乎一模一样。

- 最大差值 将会是一个非常非常小的数字(例如

1.1920928955078125e-07),这是由浮点数计算(float32)的精度限制引起的,完全在可接受范围内。 - 最终,程序将打印出

✅ 验证通过!训练态和部署态的输出完全一致!的成功信息。 - 在最后打印的模型结构中,你会清晰地看到,

train_model包含rbr_dense,rbr_1x1,rbr_identity,而deploy_model只包含一个rbr_reparam(Conv2d)!

这个 Demo 完美地证明了:我们通过“重参数化”魔法,成功地将一个复杂的多分支结构,转换成了一个简洁的单分支结构,且没有损失任何计算精度!

呼!💦 这一部分真是“硬核”满满!

小伙伴,你是否已经完全理解了 RepVGG 的“变形”魔法?从数学推导到代码实现,我们已经把它的“底裤”都扒干净了!😄

- 你对“Conv+BN 融合”的数学推导(魔法一)是否清晰了?

- 你对“多分支融合”的 Padding 和 Add(魔法二)是否理解了?

- 你能看懂 PyTorch 代码中

_fuse_bn_tensor和switch_to_deploy的实现逻辑了吗?

🧩 第四部分:YOLOv6 EfficientRep 检测头解析

在第三部分,我们花了大量的篇幅,从数学原理到代码实战,彻底征服了 RepVGGBlock 这个“变形金刚”。现在,我们站在巨人的肩膀上,再来看 YOLOv6 的 EfficientRep 检测头,一切都会变得豁然开朗。

4.1 YOLOv6 (v2.0/v3.0) 的整体架构概览

在我们深入检测头之前,有必要先快速看一下 YOLOv6(特指 v2.0 及之后的版本)的整体设计,因为它的架构是高度统一的。

- Backbone (骨干网):采用了名为 EfficientRep Backbone 的结构。它不再使用 YOLOv5 的 C3 模块,而是大量堆叠了我们刚刚学过的

RepVGGBlock(在 YOLOv6 中被称为RepBlock)。 - Neck (特征融合颈):采用了名为 Rep-PAN 的结构。它同样抛弃了 YOLOv5 的 C3-PAN 结构,转而使用

RepBlock来构建其 FPN 和 PAN 的路径。

这意味着在 YOLOv6 中,从输入到特征金字塔的输出(P3, P4, P5),整个模型的主体计算单元,在推理时,几乎都是单一的 3×3 卷积!

这种高度统一的结构,为其“硬件友好”特性打下了坚实的基础(我们将在4.3节详述)。

YOLOv6 的检测头设计,自然也延续了这种“统一美学”。它没有理由在模型的最后阶段突然引入一个截然不同的、复杂的结构。

4.2 EfficientRep Head 的具体结构

YOLOv6 团队在设计检测头时,面临着我们在第二部分提到的“YOLOv5 耦合头 vs YOLOX 解耦头”的选择题。

- YOLOv5 的耦合头虽然快,但精度有瓶颈。

- YOLOX 的解耦头精度高,但额外的 1×1 卷积和并行的分支带来了推理延迟。

YOLOv6 的答案是:我全都要!

它选择了解耦头 (Decoupled Head) 的设计范式,来获得高精度;同时,它使用我们刚刚学到的 RepBlock 来构建这些解耦分支,从而在推理时将分支“融合”回极致高效的 3×3 卷积,实现极致的速度。

这就是 EfficientRep Head 名称的由来:高效的 (Efficient)、基于 RepBlock 的 (Rep) 解耦头 (Head)。

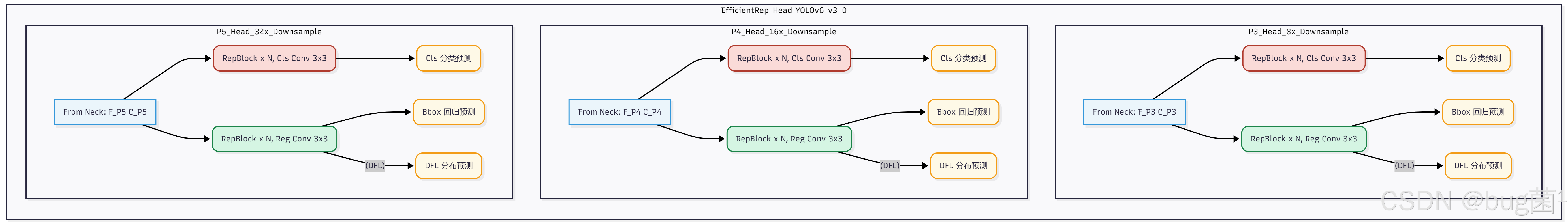

结构图示

让我们用 流程图 来清晰地展示 EfficientRep Head(以 v2.0/v3.0 为例)的结构。它接收来自 Rep-PAN 的三个尺度的特征图 P3, P4, P5 (分别对应 8, 16, 32 倍下采样):

这个结构非常清晰,我们可以总结出几个关键点:

-

解耦设计 (Decoupled):对于 P3, P4, P5 传来的每一个尺度的特征图,YOLOv6 都设计了两个独立的分支:

- 粉色分支 (Cls):用于分类任务。

- 绿色分支 (Reg):用于回归任务(包括 Bbox 坐标和 DFL 分布)。

这与 YOLOX 和 PP-YOLOE 的思想是一致的,目的是让两个任务各自学习最适合自己的特征,避免冲突。

-

RepBlock 堆叠 (Rep × N):这是与 YOLOX 的最大区别。YOLOX 的解耦头使用的是

Conv+BN+SiLU堆叠。而 YOLOv6 在每个分支中,都堆叠了 N 个RepBlock(N 的数量取决于模型规模,例如 M/L 模型中 N=2)。 -

最终预测层 (Conv 3×3):在堆叠了 N 个

RepBlock之后,每个分支会再接一个3×3 的卷积来得到最终的预测结果(分类 logits, 回归坐标等)。- 为什么用 3×3 而不是 1×1? 同样是为了硬件友好!在第三部分我们提到,模型的主体都是 3×3 卷积。如果在这里突然插入一个 1×1 卷积,反而会“打断”计算的连续性,增加了一个新的、计算密度较低的算子类型。保持使用 3×3 卷积,可以最大化硬件(尤其是 Tensor Cores)的利用率。

-

DFL (Distribution Focal Loss):与 PP-YOLOE 类似,YOLOv6 的回归分支也采用了 DFL(在第115篇中详细讲过),将坐标回归视为一个学习概率分布的“分类”任务,因此回归分支会额外输出一个 DFL 的预测图。

训练与推理的“变形”:

-

训练时:上图中的每一个

RepBlock都是一个“三分支”的胖结构,整个检测头充满了并行的计算路径,梯度可以充分回传,模型表征能力被拉满。 -

推理时:通过

switch_to_deploy(),图中的每一个RepBlock和最后的Conv 3×3(如果它后面也接了BN)都会被融合。RepBlock × N⇒ 一连串的 N 个单一 3×3 卷积。Cls Conv 3×3⇒ 一个单一 3×3 卷积。Reg Conv 3×3⇒ 一个单一 3×3 卷积。

最终,整个 EfficientRep Head 在推理时,变成了两条平行的、完全由 3×3 卷积“一撸到底”的纯卷积流。

4.3 为什么 EfficientRep Head 如此“硬件友好”?

“硬件友好 (Hardware-Friendly)”是 YOLOv6 团队提到最多的词。这到底意味着什么?为什么一个全是 3×3 卷积的结构就“友好”了?

这背后是对现代AI加速器(NVIDIA GPU, Google TPU, 以及各种 NPU)底层计算原理的深刻洞察。

1. 高计算密度 (High Arithmetic Intensity)

“计算密度”是一个关键指标,它衡量了一个计算任务的“计算量 (FLOPs)”与“访存量 (Memory Access)”之比。

- 访存密集型 (Memory-Bound):如

Add(残差连接)、Concat、ReLU、BN。它们的计算量极低,但需要读写大量数据。GPU 强大的计算单元(ALU)大部分时间都在“空等”,等待数据从显存(HBM)加载到缓存(SRAM)中。 - 计算密集型 (Compute-Bound):如大核卷积(尤其是 3×3) 和 矩阵乘法 (GEMM)。它们的数据一旦加载进缓存,就可以被计算单元“复用”很多次,FLOPs 很高。这能最大化地“喂饱”GPU的计算单元,使其满负荷运转。

RepVGG 融合的魔力:

它在训练时,使用了大量的 Add(分支相加)和 BN(批归一化),这些都是“访存密集型”操作。

在推理时,它把所有这些操作全部融合进了一个单一的 3×3 卷积中。

结论:YOLOv6 的 EfficientRep Head(乃至整个模型)在推理时,几乎消除了所有访存密集型操作,只保留了计算密度最高的 3×3 卷积算子。这使得 GPU 的 Tensor Cores 可以火力全开,从而实现极低的推理延迟。

2. 减少访存开销 (Memory Access Cost)

多分支结构(如 ResNet, YOLOX-Head)的 Add 或 Concat 操作,需要将多个分支的计算结果(中间特征图)都保存在显存中,然后再读取出来进行合并。

而 RepVGG 融合后的单分支结构,是一个“串行”计算流。上一层的输出直接作为下一层的输入,中间结果的“生命周期”很短,对显存的占用和读写压力(Memory Bandwidth)要小得多。

3. 简化推理引擎的优化 (Layer Fusion)

现代推理引擎(如 NVIDIA 的 TensorRT)会尝试自动优化模型,其中最重要的一招叫层融合 (Layer Fusion)。

- 难以融合:对于

Conv -> BN -> SiLU -> Add这样的“碎片化”结构,TensorRT 很难将它们完美融合成一个单一的 CUDA Kernel。 - 极易融合:对于

Conv -> Conv -> Conv...这样一连串的同类型算子,TensorRT 可以非常轻松地将它们进行优化,甚至在硬件层面实现更高效的调度。

YOLOv6 的设计,等于是在“模型设计”阶段,就已经帮 TensorRT 把“层融合”的工作做到极致了,推理引擎几乎不需要“操心”,就能跑出极高的速度。

总结:EfficientRep Head 的“硬件友好”,是因为它在推理时呈现出一个高度统一、计算密度极高、访存开销极低、极易被引擎优化的纯 3×3 卷积流。

4.4【代码实战】构建 EfficientRep Head

现在,我们将利用第三部分编写的 RepVGGBlock,来搭建 YOLOv6 v3.0 的 EfficientRepHead。(这里演示核心结构,忽略一些项目中工程化细节)

import torch

import torch.nn as nn

from typing import List

# 假设 RepVGGBlock 已按上一节定义

class EfficientRepHead(nn.Module):

"""

YOLOv6 v3.0 的 EfficientRepHead 实现。

这是一个解耦头,为分类和回归任务使用独立的 RepBlock 分支。

"""

def __init__(

self,

in_channels_list: List[int], # 来自 Neck P3,P4,P5 的输入通道列表

num_classes: int = 80, # 类别数

num_layers: int = 2, # 每个分支堆叠的 RepBlock 数量

reg_max: int = 16, # DFL 的回归范围 (e.g., 0-16)

deploy: bool = False # 部署模式

):

"""

初始化 EfficientRepHead

参数:

- in_channels_list (List[int]): P3,P4,P5 的通道数, e.g., [128, 256, 512]

- num_classes (int): 数据集类别

- num_layers (int): 每个分支 RepBlock 数量

- reg_max (int): DFL 范围

- deploy (bool): 部署模式

"""

super().__init__()

self.in_channels_list = in_channels_list

self.num_classes = num_classes

self.num_layers = num_layers

self.reg_max = reg_max

self.deploy = deploy

# DFL (reg_max + 1)

self.proj_conv = nn.Conv2d(self.reg_max + 1, 1, 1, bias=False)

self.dfl_len = self.reg_max + 1 # e.g., 17

# 回归预测的通道数 (4 * 17)

self.reg_channels = 4 * (self.reg_max + 1) # e.g., 4 * 17 = 68

# 分类预测的通道数

self.cls_channels = self.num_classes

# --- 构建检测头分支 ---

self.cls_convs_list = nn.ModuleList()

self.reg_convs_list = nn.ModuleList()

for in_c in self.in_channels_list:

# --- 构建分类分支 (Cls Branch) ---

cls_branch = []

for i in range(self.num_layers):

cls_branch.append(

RepVGGBlock(

in_channels=in_c if i == 0 else in_c,

out_channels=in_c,

deploy=self.deploy

)

)

cls_branch.append(

nn.Conv2d(

in_channels=in_c,

out_channels=self.cls_channels,

kernel_size=3,

stride=1,

padding=1,

bias=True

)

)

self.cls_convs_list.append(nn.Sequential(*cls_branch))

# --- 构建回归分支 (Reg Branch) ---

reg_branch = []

for i in range(self.num_layers):

reg_branch.append(

RepVGGBlock(

in_channels=in_c if i == 0 else in_c,

out_channels=in_c,

deploy=self.deploy

)

)

reg_branch.append(

nn.Conv2d(

in_channels=in_c,

out_channels=self.reg_channels,

kernel_size=3,

stride=1,

padding=1,

bias=True

)

)

self.reg_convs_list.append(nn.Sequential(*reg_branch))

# 初始化 DFL 期望计算层 (简单版)

if not self.deploy:

self._initialize_dfl_weights()

def _initialize_dfl_weights(self):

# 初始化 DFL 期望计算层 proj_conv,表示 0,1,...,reg_max

self.proj_conv.weight.data = torch.arange(

0, self.reg_max + 1,

dtype=torch.float32

).view(1, self.reg_max + 1, 1, 1)

self.proj_conv.weight.requires_grad = False

def forward(self, features: List[torch.Tensor]):

"""

前向传播

参数:

- features (List[torch.Tensor]): 来自 Neck 的 P3, P4, P5 特征图列表

返回:

- List[torch.Tensor]: 分类预测结果 (3 个尺度)

- List[torch.Tensor]: 回归预测结果 (3 个尺度)

"""

cls_outputs = []

reg_outputs = []

for i in range(len(features)):

feat = features[i] # P_i 特征图

# 分类分支

cls_feat = self.cls_convs_list[i](feat)

cls_outputs.append(cls_feat)

# 回归分支

reg_feat = self.reg_convs_list[i](feat)

reg_outputs.append(reg_feat)

return cls_outputs, reg_outputs

def switch_to_deploy(self):

"""

遍历所有 RepBlock,将它们全部切换到部署模式

"""

print("===== EfficientRepHead 正在切换到部署模式 =====")

self.deploy = True

for i in range(len(self.in_channels_list)):

# 切换分类分支中的 RepVGGBlock

for module in self.cls_convs_list[i]:

if isinstance(module, RepVGGBlock):

module.switch_to_deploy()

# 切换回归分支中的 RepVGGBlock

for module in self.reg_convs_list[i]:

if isinstance(module, RepVGGBlock):

module.switch_to_deploy()

print("===== EfficientRepHead 切换完成! =====")

你现在不仅知道 EfficientRep Head 长什么样,还知道它为什么这样设计(硬件友好),以及如何用代码实现它!

🛠️ 第五部分:量化部署支持与性能分析

当我们谈论模型部署,尤其是在资源受限的边缘设备(如 NVIDIA Jetson 系列、手机 NPU、自动驾驶芯片)上时,“速度”和“功耗”是两个绕不开的话题。

- FP32 (32位浮点数):我们常规训练模型时用的精度。精度高,动态范围广,但计算开销和内存占用都是最大的。

- INT8 (8位整数):一种模型量化技术。它将模型的权重(Weights)和激活值(Activations)从 32 位的浮点数,映射到 8 位的整数(通常是 -128 到 127)。

为什么用 INT8?

- 速度飞跃:现代 AI 芯片(GPU/NPU/TPU)为 INT8 计算提供了专门的、极其高效的硬件单元(例如 NVIDIA 的 Tensor Cores 对 INT8 的吞吐量远高于 FP32)。

- 内存锐减:模型体积和显存占用减少约 4 倍(32-bit vs 8-bit)。

- 功耗降低:整数运算比浮点运算更省电。

但是,量化是一把“双刃剑”。从 FP32 粗暴地降到 INT8,不可避免地会带来精度损失。而 EfficientRep (RepVGG) 结构,恰好是缓解这种精度损失的“良药”。

5.1 重参数化与量化:天作之合?

要理解为什么 RepVGG 对量化友好,我们必须先知道传统多分支结构(如 ResNet, EfficientNet)在量化时的“痛点”。

挑战:多分支结构的“尺度对齐”难题

回顾 ResNet 的经典残差连接:

y = R e L U ( C o n v ( x ) + x ) y = ReLU(Conv(x) + x) y=ReLU(Conv(x)+x)

在量化时,模型中的每一个张量(权重和激活值)都需要一组量化参数 (Quantization Parameters)(Scale, Zero-Point),用于在 FP32 和 INT8 之间来回映射:

F P 3 2 v a l u e ≈ S c a l e × ( I N T 8 v a l u e − Z e r o − P o i n t ) FP32_value ≈ Scale × (INT8_value − Zero-Point) FP32value≈Scale×(INT8value−Zero−Point)

现在,看那个 Add 操作:y_branch = Conv(x) 和 y_identity = x。

这两个即将相加的张量,是两个完全独立的计算流。它们的数据分布(最大值、最小值)可能差异巨大。

这意味着它们各自拥有完全不同的 Scale 和 Zero-Point。

当执行 Add 操作时,推理引擎(如 TensorRT)必须:

- 将 y b r a n c h y_branch ybranch(INT8)反量化回 FP32。

- 将 y i d e n t i t y y_identity yidentity(INT8)反量化回 FP32。

- 在 FP32 下执行加法。

- 对相加的结果 y,再次进行量化,得到 y(INT8)。

这个“反量化 -> FP32计算 -> 再量化”的过程,被称为 ReQuantize。这个过程不仅非常耗时(引入访存和浮点计算,抵消了 INT8 的部分优势),而且是主要的精度损失来源!两个不同分布的张量在“尺度对齐”时,会引入大量的舍入误差。

机遇:RepVGG 融合后的“纯粹”

现在,我们再来看 YOLOv6 EfficientRep Head 在推理时的结构:

y = C o n v 3 × 3 f u s e d ( x ) y = Conv_3×3_fused(x) y=Conv3×3fused(x)

它是什么?一个纯粹的、单一的卷积流。

- 它没有多分支!

- 它没有

Add操作! - 它没有 BN 层(BN 已经被融合进 Conv 和 bias 里了)!

整个模型在推理时,变成了一个极其简单的结构:Conv -> SiLU -> Conv -> SiLU -> ...。

这对量化意味着什么?

- 没有尺度对齐问题:不再需要处理两个不同分布的特征相加。计算流是“一本道”,只需为每一层

Conv的输出(即SiLU的输入)确定量化参数即可。 - 没有 ReQuantize 开销:计算可以在 INT8 域“一算到底”,

INT8_Conv -> INT8_SiLU -> INT8_Conv...,极大地减少中间的 FP32 转换开销。 - 分布更稳定:BN 层的融合,消除了 BN 在推理时带来的统计波动。融合后的

Conv(带 bias)的输出分布更加稳定,这使得量化校准(Calibration)更容易找到最优的 Scale 和 Zero-Point。

结论:RepVGG 的重参数化设计,通过在推理时消除多分支和 BN 层,从根本上规避了传统模型在量化时遇到的最大难题(尺度对齐),使得量化过程变得极其简单、高效,且精度损失极小。

5.2 训练后量化 (PTQ) 的卓越表现

模型量化主要有两种方式:

- QAT (Quantization-Aware Training):量化感知训练。在训练时就“模拟”量化过程,让模型提前适应低精度。效果好,但需要重新训练,成本高。

- PTQ (Post-Training Quantization):训练后量化。使用一个已经训练好的 FP32 模型,通过一个小的“校准集”统计激活值的分布,然后直接转换成 INT8 模型。成本极低,是工业界的首选。

YOLOv6 + PTQ = 绝配!

对于 ResNet 这类模型,如果直接使用 PTQ,精度(mAP)可能会“血崩”(下降 5–10%)。

而根据 YOLOv6 团队和广大开发者的报告,YOLOv6(基于 RepVGG)在进行 PTQ(尤其是 INT8)时,精度损失非常小,通常 mAP 下降不到 0.5%。

这意味着开发者拿到 YOLOv6 的 FP32 预训练模型后,几乎不需要耗时耗力的 QAT,就可以直接用 TensorRT 等工具进行 PTQ 转换,得到一个速度翻倍、精度几乎无损的 INT8 部署模型。

对于追求快速迭代、敏捷部署的工业应用场景来说,价值巨大。

5.3 速度与精度的平衡艺术

现在,我们可以完整地拼凑出 YOLOv6 EfficientRep Head(乃至整个 YOLOv6)是如何实现“速度与精度完美平衡”这句口号的。

它是一种“跨维度”的优化,同时收获了两个世界的好处:

-

精度提升 (来自训练态的复杂性)

- 多分支结构:提供了丰富的梯度路径,缓解了梯度消失,增强了模型的表征能力。

- 解耦头设计:分离了分类和回归任务,让模型学习更专注,避免了任务冲突。

- 结果:相比 YOLOv5 的耦合头,YOLOv6 的解耦头在 mAP 上获得了显著的“无痛涨点”。

-

速度飞跃 (来自推理态的简洁性)

- 结构重参数化:将所有多分支、BN、Add 操作融合为单一 3×3 卷积。

- 硬件友好:推理时只剩下计算密度最高的 3×3 卷积,完美契合 GPU/NPU 硬件特性。

- 量化友好:PTQ 精度损失极小,可以充分享受 INT8 带来的翻倍加速。

对比分析总结(概念对比,非严格实验表):

| 检测头设计 | 代表模型 | 结构 (推理时) | 精度 | 速度 (Latency) | INT8 PTQ 友好度 |

|---|---|---|---|---|---|

| 耦合头 (Coupled) | YOLOv5 | C3 → Conv | 中 | ⭐⭐⭐⭐⭐ | 中 |

| 解耦头 (标准) | YOLOX | Conv+BN+SiLU 堆叠 | 高 | 中 | 较差 (多 Add) |

| 解耦头 (高效) | PP-YOLOE | Conv+BN+ReLU 堆叠 | 高 | 高 | 中 |

| 解耦头 (重参数化) | YOLOv6 | RepBlock(Train) → Conv 流 | 高 | ⭐⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐⭐ |

💡 第六部分:总结与思考

经过前面五个部分的深度探索,我们从上期 PP-YOLOE 的“软设计”巧妙,到本章深入 YOLOv6 的“硬设计”革新,已经将 EfficientRep 检测头与“重参数化”魔法研究得非常透彻。

6.1 本章核心知识点回顾 (Key Takeaways)

如果你需要用几句话向你的同事或朋友介绍 YOLOv6 EfficientRep Head,以下是你需要掌握的核心要点:

-

核心思想:结构重参数化 (Structural Re-parameterization)

- 训练时:采用复杂的多分支结构(3×3 卷积 + 1×1 卷积 + 恒等映射)来提升模型表征能力和精度。

- 推理时:通过数学等效,将多分支融合成单一的 3×3 卷积,以实现极致的推理速度。

- 利用的关键:Conv 和 BN 的线性可加性。

-

融合魔法 (The “Magic”)

- 魔法(一):Conv + BN 融合,得到 W f u s e d W_fused Wfused, b f u s e d b_fused bfused。

- 魔法(二):将 1×1 和 Identity 分支等效为 3×3 卷积核,通过 Padding 和 Add 将所有分支的 W f u s e d W_fused Wfused、 b f u s e d b_fused bfused 相加,得到最终的 W d e p l o y W_deploy Wdeploy, b d e p l o y b_deploy bdeploy。

-

EfficientRep Head 架构

- 本质是一个解耦头 (Decoupled Head),为分类和回归任务设置独立分支。

- 使用 RepBlock 堆叠构建分支主体,最后用 3×3 Conv 进行预测。

- 推理态下变为两条纯 3×3 卷积流,结构高度统一。

-

极致的“硬件友好”特性

- 高计算密度:推理时几乎只有 3×3 Conv 这种 Compute-Bound 算子。

- 低访存开销:减少 Add、BN 等 Memory-Bound 操作。

- 易被 TensorRT 等推理引擎优化,层融合效果极佳。

-

卓越的“量化友好”特性

- 避免多分支 Add 带来的尺度对齐问题,使得 INT8 量化简单稳定。

- 训练后量化 (PTQ) 的精度损失极小,非常适合工业部署。

6.2 思考:重参数化是“银弹”吗?

重参数化虽然强大,但并不是解决所有问题的“银弹 (Silver Bullet)”。

成本与代价:

-

训练成本增加

- 显存开销更大:训练态多分支结构需要更多参数与中间特征图。

- 训练时长更长:前向和反向传播都比单分支结构稍慢。

-

工程复杂度更高

- 需要编写、测试

switch_to_deploy()之类的转换逻辑。 - 在多版本、多硬件平台上保证转换正确,是一个不小的工程挑战。

- 需要编写、测试

-

并非所有硬件都受益

- 对 GPU/NPU 这类为大规模卷积和矩阵乘法优化的设备,收益极大。

- 对某些 CPU 场景,优势可能没有那么明显,需要具体测试。

未来趋势:

- 动态重参数化 (Dynamic Re-parameterization):根据输入内容动态融合分支。

- 更复杂的重参数化块,如 YOLOv7 的

RepConvN等。 - 将重参数化思想扩展到 Transformer 结构中的 Linear 层。

6.3 实践建议 (Actionable Advice)

-

技术选型时优先考虑 EfficientRep/RepVGG 思想

- 若部署平台为 GPU/NPU,且需要 INT8 量化,YOLOv6/YOLOv7/RTMDet 等基于重参数化结构的模型是非常好的选择。

-

在 YOLOv8 中借鉴?

- YOLOv8 的检测头使用标准

Conv+BN+SiLU堆叠(封装在C2f或Conv模块中)。 - 你完全可以尝试“魔改” YOLOv8:把检测头里的卷积模块换成

RepVGGBlock,训练完成后调用switch_to_deploy()进行一键“瘦身”。 - 预期效果:在同硬件上,推理速度可能进一步加快,尤其是在 INT8 PTQ 模式下,并且精度有机会保持甚至略有提升。

- YOLOv8 的检测头使用标准

这绝对是一个很酷、很有成就感的实践方向!

🔮 第七部分:下期预告(第117篇:小目标检测专用头部设计)

在你完全消化了 EfficientRep Head 的“重参数化”魔法之后,让我们目光投向目标检测领域一个永恒的、也极具挑战性的“珠穆朗玛峰”——小目标检测 (Small Object Detection, SOD)。

在许多真实的工业场景中,我们要面对的敌人,远比 COCO 上的“大象”、“汽车”要棘手得多。

想象这些场景:

- 高空无人机:在百米高空俯拍,地面上的行人、车辆都只是几个像素点。

- 卫星遥感:在广袤的图像中寻找舰船、飞机或特定建筑。

- 工业质检:在高速运转的流水线上,检测电路板上一个微小的焊点缺陷。

- 医疗影像:在 CT/MRI 图像中,定位早期的微小病灶。

在这些场景下,我们常规的 YOLO 检测头,性能往往会急剧下降。

7.1 当前的挑战:为什么小目标检测 (SOD) 如此困难?

-

信息丢失 (Information Loss)

骨干网络为了提取高级语义信息会多次下采样(例如 32 倍)。一个在原图上 16×16 像素的小目标,经过 32 倍下采样后,在最深的特征图 P5 上只剩下 0.5×0.5 像素!它的特征信息几乎被“蒸发”了。 -

特征混淆 (Feature Confusion)

小目标本身只占几个像素,它所包含的纹理、形状信息极其微弱,非常容易和背景噪声(如树叶、杂波)相混淆。检测头很难判断这到底是个“目标”,还是个“噪声”。 -

定位不准 (Localization Inaccuracy)

对于一个 10×10 像素的目标,你的预测框只要偏差 2 个像素,IoU(交并比)就可能从 0.8 暴跌到 0.5 以下。常规的回归损失(如 CIoU)对这种微小的偏差感知非常迟钝,导致定位精度低下。

7.2 下期看点

常规的检测头(如 YOLOv8 Head, EfficientRep Head)虽然高效,但它们是为“通用”场景设计的,并没有为上述的“小目标”难题做“特训”。

在下一篇【第117篇】中,我们将专题研讨,专门为“小目标”量身打造专用的检测头 (Specialized SOD Head)!我们将深入探索一系列让小目标“无所遁形”的黑科技:

-

🧠 高分辨率特征的妙用

浅层特征图(如 P2, P3)保留了高分辨率和丰富的空间细节。但如何高效地利用它们,而不是简单地拼接?我们将探讨更精妙的多尺度设计。 -

🚀 超越 FPN/PAN 的多尺度融合

标准的 FPN/PAN 对小目标来说信息传递仍然太“粗糙”。我们将领略更强大的特征融合结构,如 BiFPN、AF-FPN 等,看看它们如何“精细化”处理多尺度特征。 -

🎯 更敏锐的分类器与定位头

如何让检测头对小目标更加“敏感”?我们会研究专门的分类和回归头结构,甚至引入注意力机制,让模型重点关注微小目标区域。 -

🌐 Context is King:上下文为王

小目标本身信息不足,但其周围的上下文(如道路、海面、建筑环境)往往至关重要。我们将探讨如何引入全局上下文建模(例如使用 Transformer 或空洞卷积),帮助网络“推理”出更可靠的小目标预测。

希望本文围绕 YOLOv8 的实战讲解,能在以下几个方面对你有所帮助:

- 🎯 模型精度提升:通过结构改进、损失函数优化、数据增强策略等,实战提升检测效果;

- 🚀 推理速度优化:结合量化、裁剪、蒸馏、部署策略等手段,帮助你在实际业务中跑得更快;

- 🧩 工程级落地实践:从训练到部署的完整链路中,提供可直接复用或稍作改动即可迁移的方案。

PS:如果你按文中步骤对 YOLOv8 进行优化后,仍然遇到问题,请不必焦虑或抱怨。

YOLOv8 作为复杂的目标检测框架,效果会受到 硬件环境、数据集质量、任务定义、训练配置、部署平台 等多重因素影响。

如果你在实践过程中遇到:

- 新的报错 / Bug

- 精度难以提升

- 推理速度不达预期

欢迎把 报错信息 + 关键配置截图 / 代码片段 粘贴到评论区,我们可以一起分析原因、讨论可行的优化方向。

同时,如果你有更优的调参经验或结构改进思路,也非常欢迎分享出来,大家互相启发,共同完善 YOLOv8 的实战打法 🙌

🧧🧧 文末福利,等你来拿!🧧🧧

文中涉及的多数技术问题,来源于我在 YOLOv8 项目中的一线实践,部分案例也来自网络与读者反馈;如有版权相关问题,欢迎第一时间联系,我会尽快处理(修改或下线)。

部分思路与排查路径参考了全网技术社区与人工智能问答平台,在此也一并致谢。如果这些内容尚未完全解决你的问题,还请多一点理解——YOLOv8 的优化本身就是一个高度依赖场景与数据的工程问题,不存在“一招通杀”的方案。

如果你已经在自己的任务中摸索出更高效、更稳定的优化路径,非常鼓励你:

- 在评论区简要分享你的关键思路;

- 或者整理成教程 / 系列文章。

你的经验,可能正好就是其他开发者卡关许久所缺的那一环 💡

OK,本期关于 YOLOv8 优化与实战应用 的内容就先聊到这里。如果你还想进一步深入:

- 了解更多结构改进与训练技巧;

- 对比不同场景下的部署与加速策略;

- 系统构建一套属于自己的 YOLOv8 调优方法论;

欢迎继续查看专栏:《YOLOv8实战:从入门到深度优化》。

也期待这些内容,能在你的项目中真正落地见效,帮你少踩坑、多提效,下期再见 👋

码字不易,如果这篇文章对你有所启发或帮助,欢迎给我来个 一键三连(关注 + 点赞 + 收藏),这是我持续输出高质量内容的核心动力 💪

同时也推荐关注我的公众号 「猿圈奇妙屋」:

- 第一时间获取 YOLOv8 / 目标检测 / 多任务学习 等方向的进阶内容;

- 不定期分享与视觉算法、深度学习相关的最新优化方案与工程实战经验;

- 以及 BAT 等大厂面试题、技术书籍 PDF、工程模板与工具清单等实用资源。

期待在更多维度上和你一起进步,共同提升算法与工程能力 🔧🧠

🫵 Who am I?

我是专注于 计算机视觉 / 图像识别 / 深度学习工程落地 的讲师 & 技术博主,笔名 bug菌:

- 活跃于 CSDN | 掘金 | InfoQ | 51CTO | 华为云 | 阿里云 | 腾讯云 等技术社区;

- CSDN 博客之星 Top30、华为云多年度十佳博主、掘金多年度人气作者 Top40;

- 掘金、InfoQ、51CTO 等平台签约及优质创作者,51CTO 年度博主 Top12;

- 全网粉丝累计 30w+。

更多系统化的学习路径与实战资料可以从这里进入 👉 点击获取更多精彩内容

硬核技术公众号 「猿圈奇妙屋」 欢迎你的加入,BAT 面经、4000G+ PDF 电子书、简历模版等通通可白嫖,你要做的只是——愿意来拿 😉

-End-

更多推荐

已为社区贡献75条内容

已为社区贡献75条内容

所有评论(0)