神经网络NN

神经元通过 “给输入加权重(突出重要信息)、减偏置(调整触发难度)、过激活函数(学习复杂规律)”,实现对信息的 “加工处理”—— 无数个这样的神经元按 “输入层→隐藏层→输出层” 连接,就组成了能解决复杂问题的神经网络。版权声明:本文为CSDN博主「意念回复」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。原文链接:https://blog.csdn.net/we

1.神经网络(neural network,缩写NN)或类神经网络,是一种模仿生物神经网络(动物的中枢神经系统,特别是大脑)的结构和功能的数学模型或计算模型,用于对函数进行估计或近似。

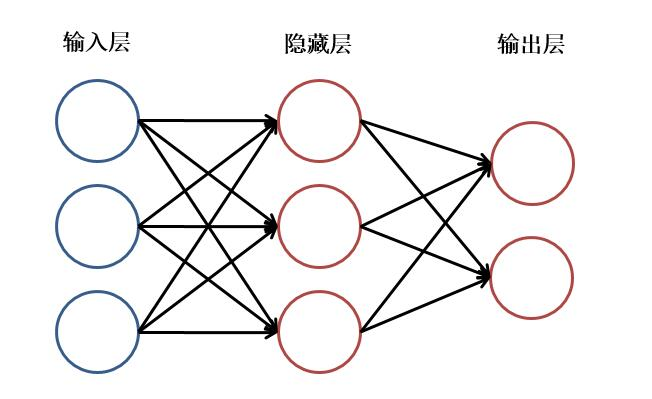

2.神经网络主要由:输入层,隐藏层,输出层构成。当隐藏层只有一层时,该网络为两层神经网络,由于输入层未做任何变换,可以不看做单独的一层。实际中,网络输入层的每个神经元代表了一个特征,输出层个数代表了分类标签的个数(在做二分类时,如果采用sigmoid分类器,输出层的神经元个数为1个;如果采用softmax分类器,输出层神经元个数为2个;如果是多分类问题,即输出类别>=3时,输出层神经元为类别个数),而隐藏层层数以及隐藏层神经元是由人工设定。一个基本的两层神经网络可见下图(注意:说神经网络多少层数的时候一般不包括输入层。 在神经网络中的激活主要讲的是梯度的更新的激活):

你可以把神经网络想象成一个 “特征加工工厂”,输入层 =“原材料”,隐藏层 =“加工车间”,输出层 =“最终产品”,而 “神经元” 就是工厂里的 “加工节点”。

1. 输入层:“原材料”—— 数据的特征

- 通俗理解:输入层的每个神经元,对应原始数据的一个 “特征”(比如判断一张图片是不是猫,特征可能是 “是否有胡须”“耳朵形状是否尖”“毛色是否为纯色” 等)。

- 关键特点:输入层只负责 “传递数据”,不做任何计算或变换(就像工厂的原材料入口,只把材料送进车间,不加工)。

- 例子:

- 用神经网络预测学生成绩:输入特征可能是 “复习时长”“刷题数量”“上课出勤率”,所以输入层有 3 个神经元。

- 用神经网络识别手写数字(0-9):每张图片按像素点输入(比如 28×28=784 个像素),所以输入层有 784 个神经元。

2. 隐藏层:“加工车间”—— 特征的提炼与组合

- 通俗理解:隐藏层是神经网络的 “核心”,负责把输入层的 “原始特征” 进行 “提炼、组合、转化”(比如把 “有胡须”“尖耳朵”“纯色毛” 这三个特征组合起来,变成 “猫的关键特征”)。

- 关键规则:

- 隐藏层是 “人工设定” 的:包括 “隐藏层层数”(1 层、2 层、多层)和 “每层的神经元个数”(比如 1 层隐藏层,含 10 个神经元)。

- 为什么叫 “隐藏”?因为它不直接接收原始数据,也不直接输出结果,是 “中间加工环节”,我们看不到它的具体工作过程,所以叫隐藏层。

- 层数定义的坑:题目里说 “隐藏层只有一层时,叫两层神经网络”,原因是:计数时通常不包括输入层(只算 “有计算功能的层”)。比如:

- 输入层(无计算)+ 1 层隐藏层(有计算)+ 输出层(有计算)→ 总共 “2 层网络”(隐藏层 + 输出层)。

- 输入层 + 2 层隐藏层 + 输出层 → 3 层网络(深度学习的入门结构)。

3. 输出层:“最终产品”—— 分类结果或预测值

- 通俗理解:输出层的神经元个数,对应我们要 “输出的结果类型”(分类标签的个数),是整个网络的 “最终答案”。

- 核心规则(重点!题目里的分类器区别):

- 二分类问题(结果只有 2 种,比如 “是 / 否”“合格 / 不合格”“猫 / 狗”):

- 用 sigmoid 分类器:输出层 1 个神经元(输出值在 0-1 之间,比如≥0.5 判定为 “是”,<0.5 判定为 “否”)。

- 例子:判断邮件是否为垃圾邮件 → 输出层 1 个神经元(0 = 正常邮件,1 = 垃圾邮件)。

- 用 softmax 分类器:输出层 2 个神经元(两个神经元的输出值相加 = 1,分别代表 “属于类别 A 的概率” 和 “属于类别 B 的概率”)。

- 例子:判断图片是猫还是狗 → 输出层 2 个神经元(第一个输出 0.8 = 猫的概率,第二个输出 0.2 = 狗的概率,取概率大的作为结果)。

- 用 sigmoid 分类器:输出层 1 个神经元(输出值在 0-1 之间,比如≥0.5 判定为 “是”,<0.5 判定为 “否”)。

- 多分类问题(结果≥3 种,比如识别数字 0-9、识别水果(苹果 / 香蕉 / 橙子)):

- 必须用 softmax 分类器,输出层神经元个数 =“类别总数”(每个神经元对应一个类别的概率,总和 = 1)。

- 例子:识别手写数字 0-9 → 输出层 10 个神经元(分别对应数字 0-9 的概率,比如第 5 个神经元输出 0.9,就判定为数字 5)。

- 总结:给输出层每个神经元分配一个 “唯一任务”(比如识别数字 0-9 时,每个神经元对应一个数字),经过 softmax 分类器处理后,所有神经元的概率加起来 = 1(所有可能性覆盖 100%),最终哪个神经元的概率最大,就判定输入数据属于这个神经元 “任务对应的结果”。

- 必须用 softmax 分类器,输出层神经元个数 =“类别总数”(每个神经元对应一个类别的概率,总和 = 1)。

-

“激活主要讲的是梯度的更新的激活”,:激活函数是让神经网络 “学会复杂规律” 的关键,而梯度更新是让网络 “越学越准” 的方式。

1. 激活函数:给 “加工车间” 加 “非线性能力”

- 通俗理解:如果没有激活函数,隐藏层的加工只是 “简单的线性组合”(比如 “胡须 + 尖耳朵 = 特征 A”),无法处理复杂问题(比如猫的特征不是简单相加,还有 “胡须长度”“耳朵角度” 等非线性关系)。

- 激活函数的作用:给每个神经元的输出加一个 “非线性变换”,让网络能学习复杂的规律(比如 sigmoid 函数把输出压缩到 0-1,ReLU 函数让无效特征 “归零”)。

- 为什么和 “梯度更新” 有关?:

- 神经网络学习的过程,是通过 “梯度下降” 调整每个神经元的参数(比如 “胡须特征的重要性”),让预测结果更准。

- 激活函数的选择,会影响 “梯度是否能有效传递”(比如有些激活函数会导致梯度消失,网络学不会),所以说 “激活主要讲的是梯度更新的激活”—— 核心是 “激活函数支撑了梯度更新,让网络能学习”。

-

2. 梯度更新:让网络 “知错就改”

- 通俗理解:网络第一次预测可能出错(比如把猫判成狗),梯度更新就是 “计算错误的程度”(比如 “差了多少”),然后反向调整隐藏层、输出层的参数(比如 “增加‘胡须’特征的重要性,降低‘体型大’特征的重要性”),下次预测就更准了。

- 激活函数在这里的作用:如果激活函数是 “线性的”,梯度会越来越小(梯度消失),参数无法调整;只有用 “非线性激活函数”,梯度才能有效传递,更新才能生效。

- 二分类问题(结果只有 2 种,比如 “是 / 否”“合格 / 不合格”“猫 / 狗”):

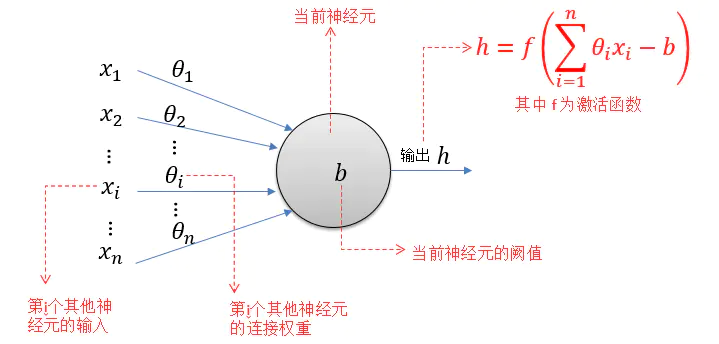

一、图中各元素的作用(对应 “快递分拣员” 的工作)

二、神经元的计算流程(四步运算)

图右上角的公式 h=f(∑i=1nθixi−b),就是神经元的 “计算流水线”,分 4 步:

1. 第一步:输入 × 权重 → 加权求和(计算 “信息的加权重要性”)

先把每个输入 xi 和对应的权重 θi 相乘,再把所有结果加起来:∑i=1nθixi=θ1x1+θ2x2+...+θnxn

- 例子:如果 x1 是 “复习时长”,θ1=0.8(权重高,说明复习时长很重要);x2 是 “刷题数”,θ2=0.5(权重低,影响较小)→ 这一步会突出 “复习时长” 的作用。

2. 第二步:减偏置 b → 调整 “触发阈值”

把第一步的结果减去偏置 b,得到 “加权和 - 偏置”:∑i=1nθixi−b

- 类比:分拣员的 “阈值”—— 如果 b=3,相当于 “只有加权和≥3,才会触发后续判断”(偏置越大,需要的加权和越高,神经元越难 “激活”)。

3. 第三步:过激活函数 f(⋅) → 非线性变换

把 “加权和 - 偏置” 的结果代入激活函数 f,得到最终输出 h。

- 常见激活函数:

- ReLU:把负数变成 0(只保留 “正向影响”);

- Sigmoid:把结果压缩到 0-1 之间(用于二分类的概率输出);

- Softmax:把多个神经元的输出转化为 “概率和为 1” 的结果(用于多分类)。

4. 第四步:输出 h → 传递给下一层

最终输出 h 会作为 “下一个神经元的输入 x”,继续参与后续计算(整个神经网络就是无数个这样的神经元 “连起来” 的结果)。

三、用 “学生及格预测” 的例子代入

假设这个神经元是 “隐藏层的某个神经元”,输入是 “复习时长 x1、刷题数 x2、出勤率 x3、作业完成率 x4”:

- 输入 x=[15,40,95,90](新学生的特征);

- 权重 θ=[0.1,0.05,0.03,0.02](模型训练后学到的 “重要性”);

- 偏置 b=3;

- 激活函数 f=ReLU。

计算过程:

- 加权和:0.1×15+0.05×40+0.03×95+0.02×90=1.5+2+2.85+1.8=8.15;

- 减偏置:8.15−3=5.15;

- 激活函数:ReLU(5.15)=5.15(ReLU 对正数直接输出本身);

- 输出 h=5.15 → 传递给下一层神经元,最终经过输出层的 Sigmoid 得到 “及格概率”。

核心总结

这个图的本质是:神经元通过 “给输入加权重(突出重要信息)、减偏置(调整触发难度)、过激活函数(学习复杂规律)”,实现对信息的 “加工处理”—— 无数个这样的神经元按 “输入层→隐藏层→输出层” 连接,就组成了能解决复杂问题的神经网络。

————————————————

版权声明:本文为CSDN博主「意念回复」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_39910711/article/details/100775918

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)