AAAI 2025 MENTOR

通过这三级对齐,MENTOR 既保留了多模态的语义补充能力,又死死锁住了“交互信息”这个核心,实现了效果与鲁棒性的双赢。

AAAI 2025 | MENTOR:重新思考多模态推荐中的模态对齐——让ID特征回归“C位”

论文标题:MENTOR: Multi-level Self-supervised Learning for Multimodal Recommendation

作者团队:Jinfeng Xu, Zheyu Chen, Shuo Yang, Jinze Li, Hewei Wang, Edith C. H. Ngai (香港大学, 香港理工大学, CMU)

收录会议:AAAI 2025

代码开源:GitHub链接

1. 背景:多模态推荐的现存问题

在推荐系统领域,数据稀疏性(Data Sparsity)一直是个大难题。为了解决这个问题,研究人员引入了多模态信息(如商品的图片、描述文本),希望利用这些丰富的语义信息来辅助推荐。

近年来的主流做法是利用 自监督学习(Self-supervised Learning, SSL) 来进行 跨模态对齐(Cross-modal Alignment)。简单来说,就是让商品的“图片特征”和“文本特征”在语义空间上尽可能接近。

但是,这种做法存在一个被忽视的隐患:

传统的跨模态对齐往往只关注模态之间的语义一致性,却忽略了推荐系统的核心——用户与物品的交互历史(即ID Embeddings)。

正如论文中的 Figure 1 所示:

- 传统对齐:强行拉近视觉和文本特征,结果可能导致它们整体偏离了ID特征所代表的真实交互偏好(Interaction Information)。

- 后果:模型“看懂”了多模态内容,却“忘”了用户到底喜欢买什么。

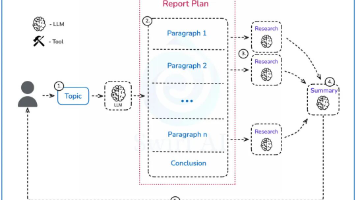

2. 核心创新:MENTOR 框架

为了解决上述问题,港大等机构的研究团队提出了 MENTOR(Multi-level sElf-supervised learNing for mulTimOdal Recommendation)。

核心思想:

不仅要对齐模态之间(如图文对齐),更重要的是要以 ID Embedding(交互信息)为锚点,将所有模态特征引导向 ID 特征靠拢。

MENTOR 的架构主要包含三个部分:

- 多模态信息编码器:利用图神经网络提取特征。

- 多级跨模态对齐(核心组件)。

- 通用特征增强(可选组件)。

2.1 多模态信息编码器 (Multimodal Information Encoder)

MENTOR使用了两种图结构来提取特征:

- 用户-物品异构图 (User-Item Heterogeneous Graph):利用 GCN 捕获高阶交互信息。

- 物品-物品同构图 (Item-Item Homogeneous Graph):利用 KNN 基于模态相似度构建,挖掘物品间的语义关联。

3. 多级跨模态对齐 (Multilevel Cross-Modal Alignment)

这是论文最精彩的部分。作者设计了三个层级的对齐任务,层层递进地将多模态特征“拉回”正轨。

Level 1: 标准模态对齐 (Standard Modality Alignment)

这是基础操作。直接对齐视觉特征 ( v v v) 和文本特征 ( t t t) 的分布(均值和方差),减小语义鸿沟。

- 目的:确保不同模态在语义上是相关的。

Level 2: ID 间接引导 (ID Indirect Guidance)

关键一步! 分别将视觉特征和文本特征与 ID Embedding 进行对齐。

- 公式直觉: L o s s ≈ D i s t ( V i s u a l , I D ) + D i s t ( T e x t u a l , I D ) Loss \approx Dist(Visual, ID) + Dist(Textual, ID) Loss≈Dist(Visual,ID)+Dist(Textual,ID)

- 目的:利用历史交互信息(ID)来修正单一模态的表征,防止它们在语义对齐时“跑偏”。

Level 3: ID 直接引导 (ID Direct Guidance)

在这一层,模型将视觉和文本融合后的特征(Fused Modality)与 ID 特征对齐,同时也再次平衡各个单模态与融合模态的关系。

- 目的:确保最终用于预测的融合特征完美保留了用户偏好信息。

总结:通过这三级对齐,MENTOR 既保留了多模态的语义补充能力,又死死锁住了“交互信息”这个核心,实现了效果与鲁棒性的双赢。

4. 通用特征增强 (General Feature Enhancement)

为了进一步提升模型的鲁棒性(Robustness),MENTOR 引入了一个可选的辅助任务,包含两个方面:

- 特征掩码 (Feature Masking):

- 随机 Mask 掉一部分特征,然后通过对比学习(Contrastive Learning)重建,迫使模型学习更鲁棒的特征表示。

- 图扰动 (Graph Perturbation):

- 在图结构中加入随机噪声,构建增强视图,通过 InfoNCE Loss 进行对比学习。

这一步虽然是可选的,但实验证明它能进一步提升模型在稀疏数据下的表现。

5. 实验结果

论文在三个经典的 Amazon 数据集(Baby, Sports, Clothing)上进行了验证,对比了包括 MMSSL, BM3, LGMRec, FREEDOM 等在内的 SOTA 模型。

主要结论:

-

全面超越:MENTOR 在所有数据集上的 Recall@20 和 NDCG@20 指标均取得了最佳成绩。相比最佳 Baseline 提升了 4.59% ~ 6.12%。

-

有效性验证:消融实验显示,去掉“多级对齐”组件后性能下降明显,证明了该组件的核心作用。

-

效率优秀:虽然引入了多级对齐,但相比于一些复杂的基于扩散模型(DiffMM)或超图(LGMRec)的方法,MENTOR 的训练时间和显存占用都更有优势(见论文 Table 3)。

- 可视化证明:t-SNE 可视化展示了 MENTOR 成功将视觉和文本模态的分布拉近了 ID 模态,验证了设计初衷。

本文内容基于 AAAI 2025 论文整理,部分内容由LLM总结,如需引用请参考原论文。参考文献:

Xu, Jinfeng, et al. “Mentor: multi-level self-supervised learning for multimodal recommendation.” Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 39. No. 12. 2025.

multimodal recommendation." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 39. No. 12. 2025.

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)