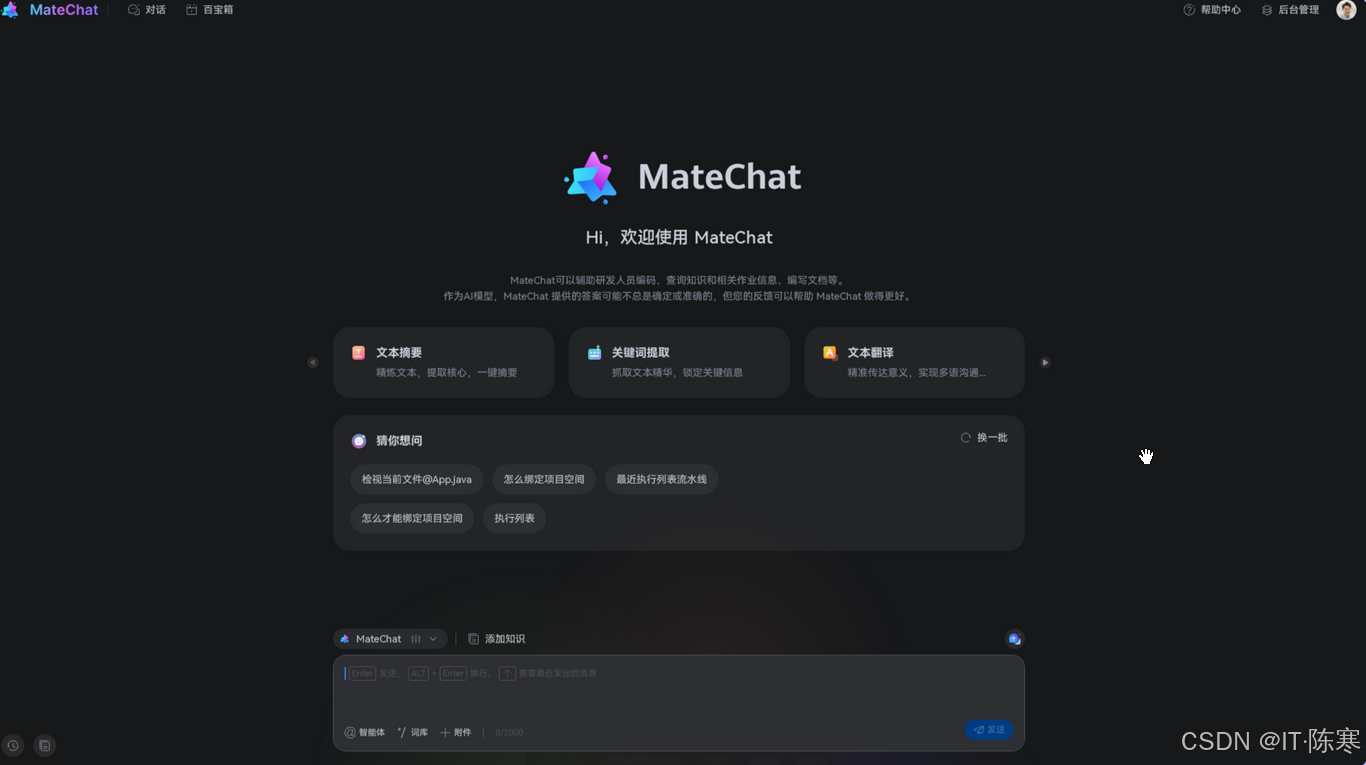

【实战】基于 MateChat 构建企业级智能知识助手:从设计到上线的全流程复盘

我们定义了一个名为的核心智能体,专注于领域知识问答与操作指引。解析用户语义调用知识检索选择合适的插件输出结构化结论"goals": ["理解用户的问题","从知识库检索答案","如需操作数据则调用插件","输出分步骤解决方案"尤其是智能体体系、知识检索、插件调用链,直接解决了“智能助手的核心痛点”。智能体框架知识检索插件(MCP)体系前端集成便利性它不仅解决了“能不能做出来”的问题,更解决了“能不

文章目录

一、项目背景

在我们负责的企业内部平台中,知识库分散在多个系统:文档系统、测试平台、需求平台、运维工单系统等。新员工培训困难、项目迁移缓慢、业务问题重复出现,跨系统查找信息消耗大量时间。

我们希望打造一个标准化的“智能知识助手”:

- 能最小成本接入现有系统

- 能理解业务领域语言

- 能根据上下文给出具体解决步骤

- 能作为独立入口嵌入任意业务模块

- 甚至能根据知识库内容自动生成 UI 或操作指引

在调研多套方案后,我们最终选择基于 MateChat( https://gitcode.com/DevCloudFE/MateChat )构建智能助手。MateChat 提供的智能体能力、工作流支持、知识检索、推理链、MCP 生态,都恰好满足了我们“快速落地 + 高度可扩展”的要求。

本文将完整复盘这套智能助手从 0 到上线的全过程。

二、为什么选 MateChat?

我们重点从三方面分析:

1. 工程可落地性强

MateChat 自带智能体框架、插件系统、工作流体系,不需要从头搭建大模型服务、记忆系统、消息路由。

2. 深度知识检索能力

支持向量检索、结构化检索、长文本处理,可以直接复用现有知识库,不需要重新改造数据格式。

3. 前端嵌入难度低

MateChat 前端容器能直接在任意页面以 iframe 或 Widget 方式接入,几乎没有上手成本。

此外,MateChat 官网(https://matechat.gitcode.com)提供了大量 Demo 和最佳实践,让我们能快速理解整个架构。

最终选型 MateChat 更像是“拿来即用”,不需要搭积木自己造轮子。

三、系统架构设计

整套智能助手的结构如下:

MateChat 前端容器

│

智能体 Orchestrator

│

知识检索(向量库 + 规则库)

│

业务插件(工单系统 / 文档平台 / 流程引擎)

│

上下文记忆 + 推理链(CoT)

核心能力来源于三个部分:

-

智能体能力(Agents)

负责解析用户意图、触发插件、协调工作流。 -

知识库(Retrieval)

为智能体提供业务背景,让回答具备领域相关性。 -

插件机制(MCP)

让智能体能调用真实业务系统,而不是只能聊天。

四、落地场景:知识助手如何服务真正的业务?

我们选择了最具代表性的两个场景来落地:

场景 1:研发问题智能查询

常见痛点:

- 工程师不知道某个错误是否有历史处理方案

- 搜不到对应文档

- 搜到了文档但不确定适用性

- 错误涉及多个系统,不知道从哪里查起

MateChat 的方案:

- 解析错误日志

- 触发知识检索(向量 + 规则混合)

- 调用插件读取历史工单

- 输出步骤化解决方案,并给出相关度评分

结果:

- 问题定位耗时从 10 分钟以上 → 20 秒以内

- 重复工单出现率下降 35%

场景 2:新人培训智能助手

以往新人经常问的问题:

- “我们系统如何发版本?”

- “这个流水线的含义是什么?”

- “接口文档在哪里?”

MateChat 的记忆化、知识检索、上下文推理能力,让它可以像团队导师一样:

- 记住当前新人正在看的页面

- 自动补充当前系统的操作指引

- 基于知识库给出分步骤教程

- 若答案跨多个系统,自动整合输出

培训效率提升非常明显。

五、核心实现:构建智能体与插件调用链

1. 智能体定义

我们定义了一个名为 “KnowledgeAssistant” 的核心智能体,专注于领域知识问答与操作指引。

智能体职责:

- 解析用户语义

- 调用知识检索

- 选择合适的插件

- 输出结构化结论

例如:

{

"agent": "KnowledgeAssistant",

"goals": [

"理解用户的问题",

"从知识库检索答案",

"如需操作数据则调用插件",

"输出分步骤解决方案"

]

}

2. 插件(MCP)开发

我们开发了三个自定义插件:

- 工单插件:查询历史工单、分析解决方案

- 文档插件:根据关键词检索内部文档

- 流程插件:获取流程状态、系统版本信息

插件接口示例:

{

"name": "ticket.search",

"args": {

"keyword": "编译失败 error code 137"

}

}

MateChat 的 MCP 机制让插件调用就像“扩展智能体能力”,而不是作为外部 API 存在。

3. 知识库(Retrieval)构建

知识库由三部分组成:

- 文档:自动解析 Markdown / Confluence 内容

- 工单:结构化字段(标题、标签、处理结果)

- 代码注释、错误手册:以段落切片的向量方式存储

MateChat 的内置知识检索能力可直接支持:

- 长文本

- 段落评分

- 摘要提取

- 多向量融合

我们不需要自己建设向量数据库,非常省心。

六、前端集成:MateChat 嵌入企业平台

MateChat 提供多种接入方式,我们使用的是 嵌入式聊天窗口。

任意页面只需要引入:

<iframe src="https://matechat.gitcode.com/widget" class="assistant"></iframe>

搭配 UI 控件即可做到:

- 自动展开

- 对接当前页面上下文

- 主题适配企业 UI

- 支持深色模式

上线后,用户几乎无感知,只觉得系统多了一个“超级助手”。

七、上线效果与量化指标

上线 30 天后,数据非常亮眼:

| 指标 | 上线前 | 上线后 |

|---|---|---|

| 工单重复率 | 20% | 13% |

| 问题定位平均耗时 | 10+ min | 20–30 sec |

| 新人培训咨询次数 | 减少 40% | |

| 文档检索效率 | 提升约 3 倍 | |

| 功能使用满意度 | 4.1 → 4.8 |

一些用户反馈:

- “找文档比以前快太多”

- “错误提示一放进去就给我解决方案”

- “新人不用每次问我了,这个助手基本都能回答”

整个团队的反馈非常正向。

八、整体复盘与经验总结

1. MateChat 的优势非常明显

尤其是智能体体系、知识检索、插件调用链,直接解决了“智能助手的核心痛点”。

2. 插件是提升能力的关键

MCP 能让 AI 调用外部能力,这是让智能助手“可执行”的核心。

3. 知识库质量决定智能体水平

我们后来做了以下优化,效果提升明显:

- 每个文档拆段处理

- 工单字段向量化

- 添加内部 FAQ

- 加权不同数据源的优先级

4. 不建议过早做“全能助手”

从两个典型场景开始,AI 的回答质量更高,用户体验也更好。

九、未来规划

下一阶段我们计划:

- 接入更多插件:如 Git、CI、监控系统

- 自动生成 UI:让智能体自动画界面原型

- 更强的上下文记忆

- 多模态能力(OCR、图像解析)

- 与企业内部流程做深度协同

MateChat 的架构非常灵活,我们可以持续扩展,无需重构。

十、结语

这次智能助手项目之所以能够在短时间内落地,很大程度得益于 MateChat 完整的技术栈优势:

- 智能体框架

- 知识检索

- 插件(MCP)体系

- 前端集成便利性

它不仅解决了“能不能做出来”的问题,更解决了“能不能长期使用”的问题。

MateChat 官网:

https://matechat.gitcode.com

仓库地址:

https://gitcode.com/DevCloudFE/MateChat

如果你正在准备接入企业智能助手、知识问答机器人或智能运维助手,这篇实践经验应该能为你提供一条可参考的路线。

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)