服务运营 | LLM如何破局医疗资源分配?ChatGPT-4o实现手术分配及床位调度

研究不仅对比了传统精确算法和启发式方法,还在不同问题规模下评估了七种主流LLM(包括OpenAI 的 ChatGPT-3.5和ChatGPT-3.5、Google 的 LaMDA 2 和 PaLM 2、Meta AI 的 LLaMA 2、阿里巴巴的 Qwen 和百度的 Ernie),发现ChatGPT-4o在减少加班时间、平滑床位需求峰值方面表现最优。与传统仅依赖数学优化的方法不同,LLM具备整合

编者按:

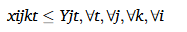

随着大语言模型(LLM)能力的飞速发展,其在复杂医疗系统中正逐渐走向实践。本文探索了基于提示词工程、检索增强生成(RAG)与工具调用的LLM方法,用于手术室、术后床位和外科医生的资源分配问题。研究不仅对比了传统精确算法和启发式方法,还在不同问题规模下评估了七种主流LLM(包括OpenAI 的 ChatGPT-3.5和ChatGPT-3.5、Google 的 LaMDA 2 和 PaLM 2、Meta AI 的 LLaMA 2、阿里巴巴的 Qwen 和百度的 Ernie),发现ChatGPT-4o在减少加班时间、平滑床位需求峰值方面表现最优。更值得注意的是,LLM能够融合历史经验与新数据,无需重新优化即可适应患者数量的动态变化,为医疗资源管理提供了高效、灵活的解决方案。这一研究为ORMS领域提供了新的视角,也揭示了LLM在复杂系统优化中的巨大潜力。

研究动机与研究问题

研究背景

手术室、术后床位与医护人员的分配,是医疗系统运营管理的核心挑战,也是一个经典而复杂的优化问题。它不仅涉及多目标(如最小化成本、减少加班、平抑需求高峰),更因其动态(患者到达与资源状态的实时变化)和高不确定性(手术时长、术后恢复等随机因素)的特点,对传统优化方法构成了巨大挑战。

该问题中具有大量约束以及整数变量,列生成等精确算法计算耗时,NSGA-II等启发式算法需精心设计且可能陷入局部最优。此外,它们在面对问题规模变化或新数据时往往需要重新优化,运行时间是其应用瓶颈。

大语言模型(LLMs)在认知、推理与代码生成能力上的突破,为破解上述复杂调度难题提供了全新的解决思路。与传统仅依赖数学优化的方法不同,LLM具备整合多源信息(如实时数据、医疗指南)的能力,并能通过自然语言理解与生成,弥合不同利益相关者之间的沟通鸿沟。

本研究旨在超越传统范式,系统性地探索LLM 在医疗资源分配中的应用潜力。本文致力于构建一个能够动态适应问题规模与需求变化、无需重新优化即可快速响应的智能决策框架,以突破传统方法在运行时和灵活性上的限制。

手术资源配置的基本参数及模型

这部分属于用数学语言描述研究问题,并非传统论文中的建模部分,这部分模型可以作为提示词一部分输入LLM中。模型主要优化择期手术患者的手术室和术后床位分配。目标包括最大限度地降低手术室的总成本(包括开放成本和加班费)、减少外科医生的加班时间以及减少床位的高峰需求。这有助于错开患者手术并减少床位空闲。参数、变量和符号如下所述

参数和变量

- xijtkx_{ijtk}xijtk:决策变量,指示手术iii是否在第ttt天由医生kkk在手术室jjj执行(若是则为 1,否则为 0)

- yjty_{jt}yjt:决策变量,指示手术室jjj在第ttt天是否开放(开放为 1,否则为 0)

- R,RmaxR, RmaxR,Rmax:外科医生的正常和最长工作时间

- Q,QmaxQ, QmaxQ,Qmax:手术室的正常和最长开放时间

- aaa:手术室的每小时加班费

- CCC:单个手术室开放一天的固定成本

- DiD_iDi:患者iii的手术时间

- LosiLos_iLosi:患者iii的住院天数

目标函数

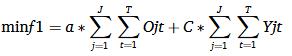

f1:最小化手术室总运营费用,包括加班成本和开放成本。

f2:最小化所有医生的总加班时长。

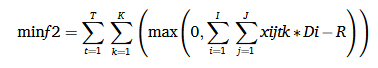

f3:平衡床位负荷,最小化最大的恢复床位占用,BtB_tBt是第ttt天床位需求。

约束条件

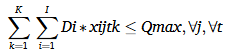

约束(1) 计算了手术室jjj第ttt天的加班时长

约束(2) 确保手术室开放时间不超过最大限制

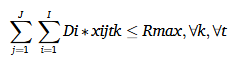

约束(3) 确保外科医生的工作时间不超过最大允许限制

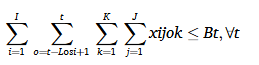

约束(4)计算每天占用康复床位的患者数量

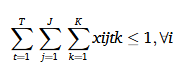

约束 (5) 规定每位患者只能接受一次手术

约束 (6)表示患者只能被分配到开放的手术室中

方法论:LLM求解框架详解

技术三元组

提示词工程(Prompt Engineering)

提示工程是与LLM交互以确保高质量、相关和实用的输出的过程。通过提供具体的提示,模型可以为任务提供优化建议。伪代码 1 表示解决医疗资源分配的提示工程。将复杂的多目标资源分配问题“翻译”给LLM理解,并约束其输出格式。

伪代码 1:解决医疗资源分配的提示工程

第 1 步:问题理解和上下文分析

示例任务:了解医院资源分配的背景,包括择期患者、手术室和术后床位。

第 2 步:构建提示 - 分配手术室和术后恢复床位

示例提示:将手术室和术后恢复床位分配给者以尽量减少资源压力。

第 3 步:构建提示 - 解释约束和目标函数

示例提示:例如尽量减少加班和平衡床位需求。

第 4 步:输入 - 患者和资源数据收集

示例输入:输入 50 名择期患者的数据集,包括手术持续时间,住院时间,和可执行手术的外科医生。

第 5 步:数据预处理和归一化

示例任务:标准化手术持续时间、住院时间,以确保数据输入的一致性。

第 6 步:LLM生成的解决方案和决策解释

示例输出:在第 1 天将患者 A 分配到手术室 1,确保恢复床位可用性 5天。

解释:这最大限度地减少了手术室和外科医生的加班时间。

检索增强生成(Retrieval-augmented generation, RAG)

LLM通过RAG技术可以动态集成历史数据与实时新数据(如新入院患者信息、资源可用性变化),这是实现动态自适应的关键。RAG 是一种结合检索和生成的技术。它首先从知识库中检索相关信息,然后使用 LLM 生成相应的输出。这种方法的优点是在生成响应时使用特定的上下文和最新信息。在医疗资源分配中,RAG的应用包括:

a) 数据使用:RAG加载数据,包括患者信息和医疗资源的可用性,例如手术室可用性和床位占用率。这确保了生成的解决方案以准确和最新的信息为基础。

b) 动态适应变化:RAG 使 LLM 能够通过将历史经验与新数据相结合来动态适应问题规模或资源需求的变化,而无需完全重新优化。

工具调用 (Tool Utilization)

LLM与外部工具(如数学模型求解器、可视化工具)协同工作,完成其不擅长的精确计算(如调用MATLAB执行部分优化)和结果呈现。工具调用涉及将LLM与其他软件工具相结合以解决更复杂的任务。例如,将模型与数据分析、优化算法或绘图工具集成。医疗资源分配中的具体应用包括:

a) 与工具集成:将 LLM 与现有工具相结合,自动生成和解决手术安排、床位分配等优化模型。

b) 结果可视化:使用绘图工具生成可视化输出,例如显示手术室可用性的条形图。

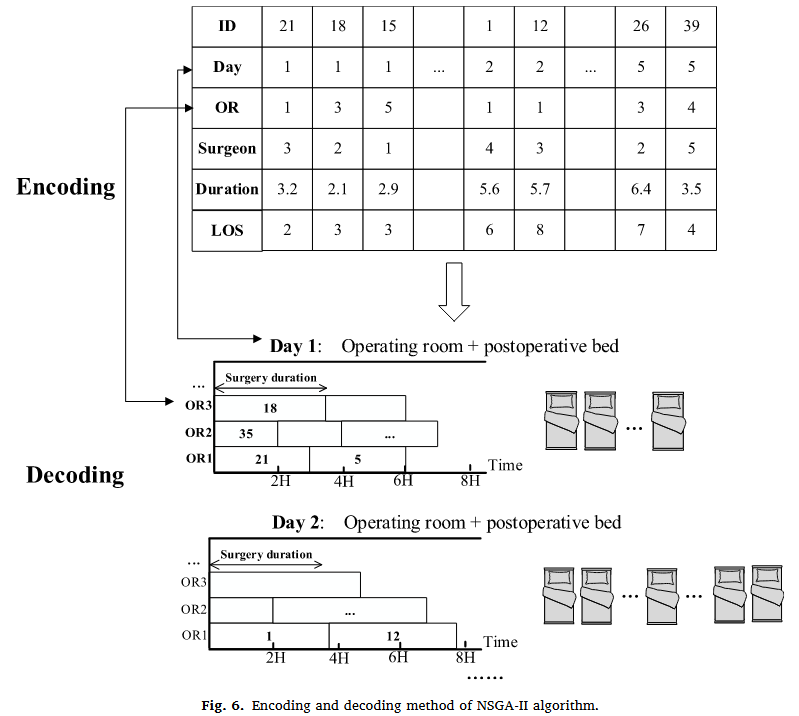

框架流程

在管理手术室、术后床位和医护人员的分配时,提示工程可用于定义特定的资源分配问题;RAG可用于从医院信息系统中检索实时入住状态和患者数据,以生成优化建议;工具集成可以完成复杂的计算,并提供直观的分析结果。伪代码 2 概述了使用 LLM 解决医疗资源分配的过程,框架如图所示。

伪代码 2:LLM 解决医疗资源分配的框架

步骤 1.初始化问题参数:

- 定义患者数据:手术持续时间、住院时长和可操作手术的医生。

- 设置资源限制:手术室容量、恢复床位限制和工作时间。

步骤 2.应用提示工程:

- 为优化目标构建特定于任务的提示

- 在提示中包含约束和输入数据。

步骤 3.执行检索增强生成:

- 加载医院数据(例如,手术室占用率、手术队列)。

- 检索患者信息或资源需求的变化 。

步骤 4.利用工具集成:

- 将输入和检索到的数据传递给优化求解器(例如 MATLAB 模型)。

- 生成并可视化中间解决方案(例如,手术室的甘特图)。

步骤 5.输出解决方案:

- 以用户友好的格式显示最终的资源分配计划。

- 提供决策的详细解释(例如,“在第 2 天将患者 A 分配到手术室 1,以尽量减少床位需求”)。

步骤 6.处理数据或资源需求的变化:

- 加载新数据并将其与历史见解集成。

- 根据更新的需求动态调整约束或优先级

步骤 7.最终确定并导出:

- 保存分配计划和结果。

- 呈现可视化摘要(例如手术室时间表、床位利用率趋势)。

实验设计与结果:LLM vs. 传统方法

实验设计

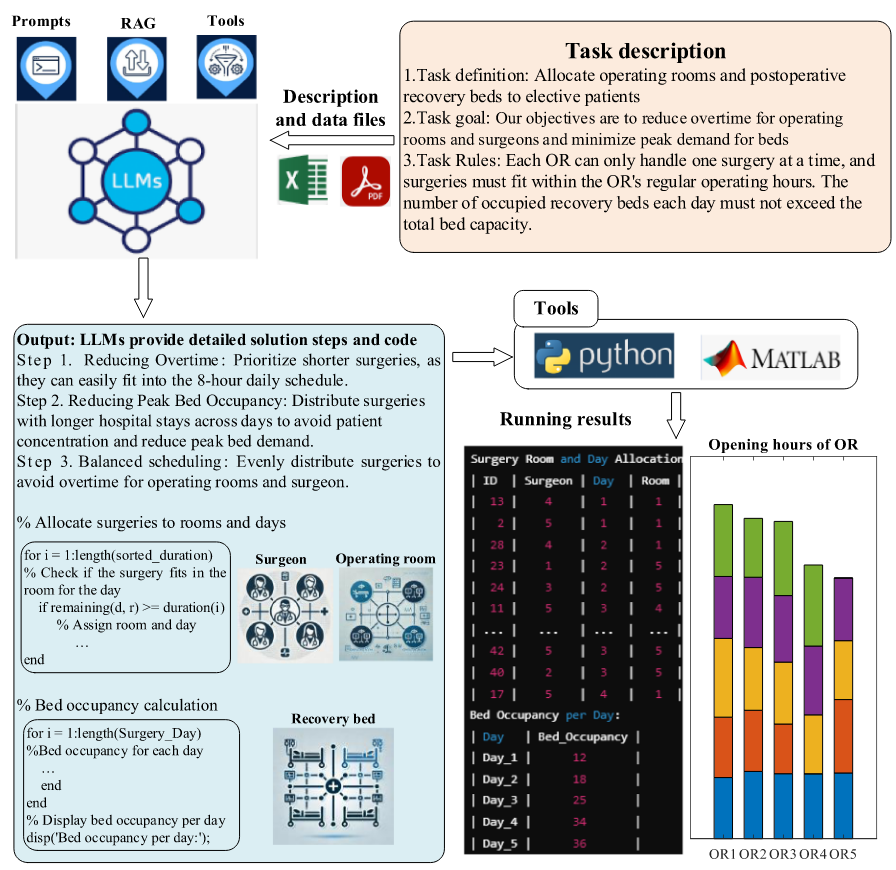

实际应用涉及在法国里昂的一家医院为择期患者分配手术室和术后床位,为期一周。如表1所示,择期手术患者共有50例,每项信息包括手术持续时间(以小时为单位)及其恢复时长(以天为单位)。

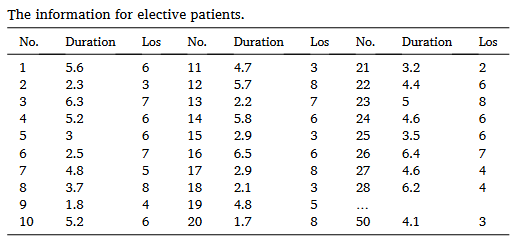

表2显示了模型的参数设置,包括手术室数量、计划周期等

LLM横向对比

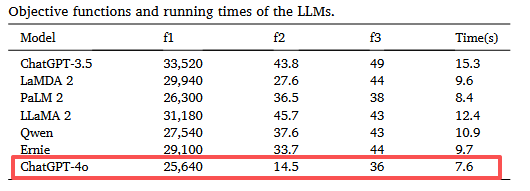

本节将GPT-4o与几个领先的 LLM 进行了比较实验,包括 OpenAI 的 ChatGPT-3.5、Google 的 LaMDA 2 和 PaLM 2、Meta AI 的 LLaMA 2、阿里巴巴的 Qwen 和百度的 Ernie

其中ChatGPT-4o综合表现最佳,在减少手术室/医生加班时间(f1, f2)、平抑床位需求高峰(f3)上效果显著,且响应速度最快。同时其他LLM(如PaLM 2, Qwen)可能出现“幻觉”和遗漏分配问题。

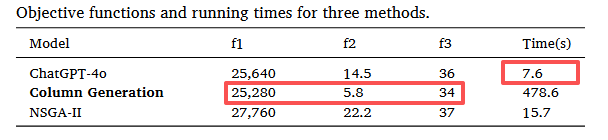

与传统算法对比

为了表明 LLM 在解决多目标资源分配问题方面的有效性,将其性能与两种传统方法进行了比较:精确算法(列生成)和启发式算法NSGA-II(Non-dominated Sorting Genetic Algorithm II)。算法具体流程可见原文中伪代码3和伪代码4,算法参数设定见原文中表4.

- 质量:ChatGPT-4o的解质量接近列生成的最优解,且显著优于NSGA-II。

- 效率:ChatGPT-4o的求解速度远超列生成算法(7.6s vs. 478.6s),也快于NSGA-II。突出其“思考”一次即输出方案的高效性。

- 统计显著性:检验结果(p<0.1),证明ChatGPT-4o的绩效提升具有统计显著性。见原文中5.2.2

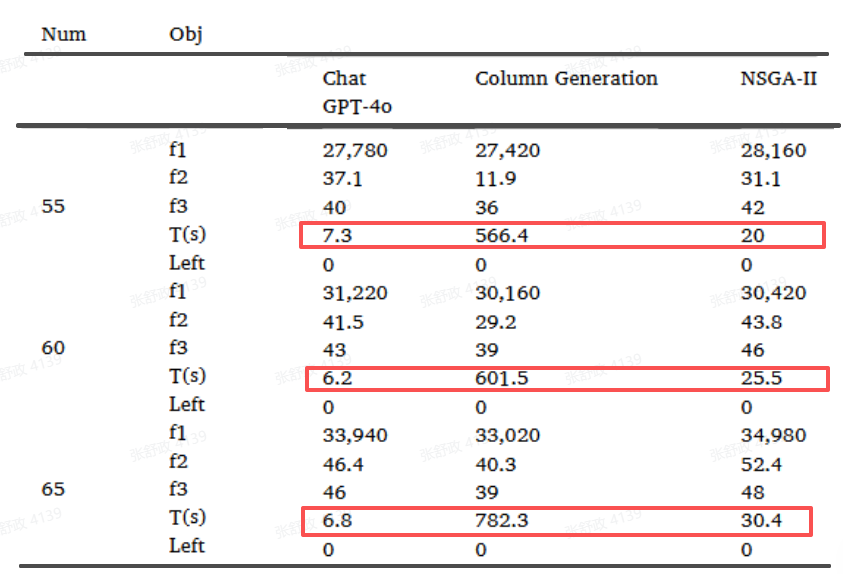

敏感性分析

下表包括三个目标函数、运行时间以及由于分配过程中的错误而未分配的患者数量。可以看出随着问题规模(患者数从50增至65)增大,传统算法运行时间急剧增加,而LLM的运行时间保持稳定甚至下降。

特别地,对于LLM来说,当患者规模发生变化时,RAG 会动态合并新数据,例如患者信息和手术室可用性,使LLM能够通过将先前的经验(如上文输出的50名患者手术分配)与新的输入相结合来生成更新的分配计划,而无需完全重新优化。减少了运行时间,解决了传统方法的局限性,并推进了 LLM 驱动的动态资源分配。

讨论与启示

- 总结贡献:本研究验证了LLM在复杂优化问题中的有效性,提供了一种将LLM与运筹学方法相结合的范式。

- 实践意义:LLM为开发实时、动态、自适应的资源调度系统提供了可能,尤其适合需求波动大、环境不确定的应用场景。

- 局限与未来方向:提及研究的局限性(如依赖数据质量、输出的随机性)以及未来可研究方向(如引入不确定性、与更复杂的优化模型结合、处理紧急插队事件等)。

- 再次强调LLM为ORMS领域,特别是医疗资源管理带来的新机遇,鼓励学者关注并探索这一充满潜力的交叉研究方向。

参考文献:

Wan, F., Wang, K., Wang, T., Qin, H., Fondrevelle, J., & Duclos, A. (2025). Enhancing healthcare resource allocation through large language models. Swarm and Evolutionary Computation, 94, 101859. https://doi.org/10.1016/j.swevo.2025.101859

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)