YOLOv8【检测头篇·第4节】一文搞懂,YOLOX解耦头SimOTA分配!

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。部分章节也会结合国内外前沿论文与 AIGC 等大

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》 专栏。该专栏系统复现并梳理全网各类 YOLOv8 改进与实战案例(当前已覆盖分类 / 检测 / 分割 / 追踪 / 关键点 / OBB 检测等方向),坚持持续更新 + 深度解析,质量分长期稳定在 97 分以上,可视为当前市面上 覆盖较全、更新较快、实战导向极强 的 YOLO 改进系列内容之一。

部分章节也会结合国内外前沿论文与 AIGC 等大模型技术,对主流改进方案进行重构与再设计,内容更偏实战与可落地,适合有工程需求的同学深入学习与对标优化。

✨ 特惠福利:当前限时活动一折秒杀,一次订阅,终身有效,后续所有更新章节全部免费解锁, 👉 点此查看详情

全文目录:

📚 上期回顾

在上一期《YOLOv8【检测头篇·第3节】一文搞懂,TOOD任务对齐动态检测头!》内容中,我们深入学习了任务对齐学习(Task Alignment Learning)的核心理念。我们探讨了如何通过对齐分类得分和定位质量来解决检测中的misalignment问题,掌握了动态标签分配策略和分类回归一致性优化方法。TOOD通过Task-aligned Assigner实现了分类分数与IoU的统一,显著提升了检测质量。这些知识为我们理解更先进的标签分配策略奠定了坚实基础。

本篇文章将带领大家深入探索YOLOX这一革命性的检测架构,重点学习其创新的解耦检测头设计和SimOTA(Simplified Optimal Transport Assignment)动态标签分配算法。YOLOX在2021年横空出世,以其简洁高效的设计理念和卓越的性能表现,迅速成为目标检测领域的标杆模型。

🎯 本章学习目标

通过本篇文章的学习,你将全面掌握以下核心知识点:

- ✅ 深刻理解YOLOX的Anchor-free设计理念与优势

- ✅ 掌握解耦检测头的架构设计与实现方法

- ✅ 全面学习SimOTA动态标签分配算法的原理

- ✅ 理解动态正样本选择机制的工作流程

- ✅ 掌握训练效率提升的关键技术

- ✅ 学习检测精度改进的优化策略

- ✅ 完整实现YOLOX检测头并进行性能验证

📖 目录结构

1. YOLOX整体架构概述

1.1 YOLOX的设计哲学

1.2 与传统YOLO的核心差异

1.3 架构创新点解析

1.4 性能表现与应用场景

2. Anchor-free设计深度解析

2.1 Anchor机制的历史演进

2.2 Anchor-based方法的局限性

2.3 Anchor-free的设计动机

2.4 中心点预测策略

2.5 完整代码实现

3. 解耦检测头详细设计

3.1 耦合检测头的问题分析

3.2 解耦架构的理论基础

3.3 分类分支设计

3.4 回归分支设计

3.5 分支融合策略

3.6 代码实现详解

4. SimOTA标签分配算法

4.1 传统标签分配方法回顾

4.2 OTA最优传输理论

4.3 SimOTA简化策略

4.4 动态k值估计

4.5 代价矩阵设计

4.6 完整算法实现

5. 动态正样本选择机制

5.1 静态vs动态正样本选择

5.2 基于预测质量的选择

5.3 中心先验约束

5.4 正负样本平衡

5.5 实战代码

6. 训练效率提升技术

6.1 强数据增强策略

6.2 MixUp和Mosaic增强

6.3 训练策略优化

6.4 损失函数改进

6.5 学习率调度

7. 检测精度改进方法

7.1 多尺度训练与测试

7.2 边界框回归优化

7.3 分类置信度校准

7.4 后处理优化

7.5 性能调优技巧

8. YOLOX完整实现

8.1 模块化代码架构

8.2 YOLOv8集成方案

8.3 训练完整流程

8.4 推理优化实现

9. 实验评估与对比分析

9.1 实验环境与数据集

9.2 性能指标对比

9.3 消融实验分析

9.4 可视化结果展示

10. 总结与展望

1. YOLOX整体架构概述 🏗️

1.1 YOLOX的设计哲学

YOLOX的诞生背景深深植根于目标检测领域的发展困境。在2021年之前,YOLO系列虽然以速度著称,但在精度上始终难以与two-stage检测器媲美。同时,YOLO系列的各个版本在设计理念上存在一定的不一致性,缺乏统一的优化方向。YOLOX团队深入分析了这些问题,提出了全新的设计理念。

简洁性原则

YOLOX的首要设计原则是简洁性(Simplicity)。团队认为,过度复杂的设计不仅增加了实现难度,也限制了模型的可扩展性和可维护性。因此,YOLOX摒弃了许多复杂的技巧,转而采用更本质、更通用的方法。例如,去除了Anchor机制、简化了标签分配过程、统一了网络结构等。

这种简洁性体现在多个方面。首先是架构简洁:YOLOX使用统一的backbone、neck和head结构,不同规模的模型(YOLOX-S、YOLOX-M、YOLOX-L等)只是通过调整通道数和深度来实现,而非采用不同的架构设计。其次是训练简洁:YOLOX使用标准的数据增强和训练策略,没有引入过多的训练技巧。最后是部署简洁:由于Anchor-free设计,YOLOX的推理过程更加直观,更容易优化和部署。

通用性原则

YOLOX追求的第二个核心原则是通用性(Generality)。团队希望YOLOX能够成为一个通用的检测框架,适用于各种应用场景,而不是针对特定数据集或任务过度优化。

通用性首先体现在任务适应性上。YOLOX不仅在COCO等通用数据集上表现优异,在工业缺陷检测、医疗影像分析、自动驾驶等特定领域也展现出强大的迁移能力。这得益于其简洁的设计和强大的特征提取能力。

其次是尺度适应性。YOLOX通过多尺度特征融合和动态标签分配,能够很好地处理从极小目标到极大目标的检测任务。无论是密集的小目标检测还是稀疏的大目标检测,YOLOX都能保持稳定的性能。

最后是部署适应性。YOLOX提供了从Nano到X的多个版本,覆盖了从移动端到服务器端的各种部署场景。这种灵活性使得YOLOX能够满足不同应用对精度和速度的不同需求。

效率性原则

第三个设计原则是效率性(Efficiency),这包括训练效率和推理效率两个方面。

在训练效率方面,YOLOX引入了强数据增强策略(Mosaic、MixUp等)和高效的标签分配算法(SimOTA),使得模型能够在相对较少的训练epoch内达到收敛。与需要训练数百个epoch的传统方法相比,YOLOX通常在300个epoch内就能达到最优性能。

在推理效率方面,解耦检测头和Anchor-free设计显著降低了计算开销。传统的检测头需要为每个位置生成多个anchor的预测,而YOLOX每个位置只需要一次预测。同时,解耦设计使得分类和回归分支可以独立优化,避免了特征冲突带来的额外计算。

1.2 与传统YOLO的核心差异

YOLOX相比传统YOLO系列(YOLOv3、YOLOv4、YOLOv5)有多个根本性的创新,这些创新共同构成了YOLOX的技术优势。

差异一:Anchor-free vs Anchor-based

这是最显著的差异。传统YOLO使用预定义的anchor boxes作为检测的起点,每个anchor都有固定的宽高比和尺度。模型的任务是预测anchor相对于真实目标的偏移量。这种方法的优点是提供了先验知识,但缺点也很明显:

- 超参数敏感:anchor的尺寸和比例需要针对数据集精心设计,不同数据集可能需要不同的anchor配置。

- 泛化能力受限:预定义的anchor限制了模型对新类型目标的适应能力。

- 计算冗余:每个位置需要预测多个anchor的结果,增加了计算量。

YOLOX采用Anchor-free设计,直接预测目标中心点和宽高,无需预定义anchor。这种方法更加灵活,泛化能力更强,计算效率也更高。实验表明,在相同的backbone下,Anchor-free YOLOX比Anchor-based YOLO快约15%,精度还略有提升。

差异二:解耦头 vs 耦合头

传统YOLO使用耦合检测头,即分类和回归任务共享相同的特征层。这种设计简单,但存在任务冲突问题。分类需要的是判别性的语义特征,而回归需要的是精确的空间几何特征,这两种特征的需求存在本质差异。

YOLOX引入解耦检测头,为分类和回归设计了独立的分支。每个分支可以学习针对自己任务的最优特征表示,避免了特征冲突。实验表明,解耦头能够带来1.0 AP的精度提升,同时收敛速度也更快。

差异三:SimOTA vs 静态分配

传统YOLO使用基于IoU阈值的静态标签分配策略。这种方法简单直观,但存在明显问题:

- 阈值固定:IoU阈值(如0.5)对所有目标一视同仁,无法适应不同目标的特性。

- 忽略预测质量:只考虑anchor与GT的几何关系,忽略了模型当前的预测能力。

- 正负样本不平衡:容易产生严重的正负样本不平衡,影响训练效果。

YOLOX的SimOTA基于最优传输理论,动态地为每个GT选择最优的正样本。它同时考虑分类得分和定位质量,能够根据模型的预测状态自适应地调整正样本分配。这种动态分配策略显著提升了训练效率和最终精度。

差异四:强数据增强策略

YOLOX大量使用了强数据增强技术,特别是Mosaic和MixUp。Mosaic将4张图像拼接成一张,强制模型学习多尺度、多场景的检测能力;MixUp混合两张图像及其标签,提升模型的泛化能力和鲁棒性。

传统YOLO虽然也使用数据增强,但强度和种类都相对有限。YOLOX的强增强策略使得模型能够在有限的训练数据下学到更丰富的特征表示,大幅提升了泛化能力。

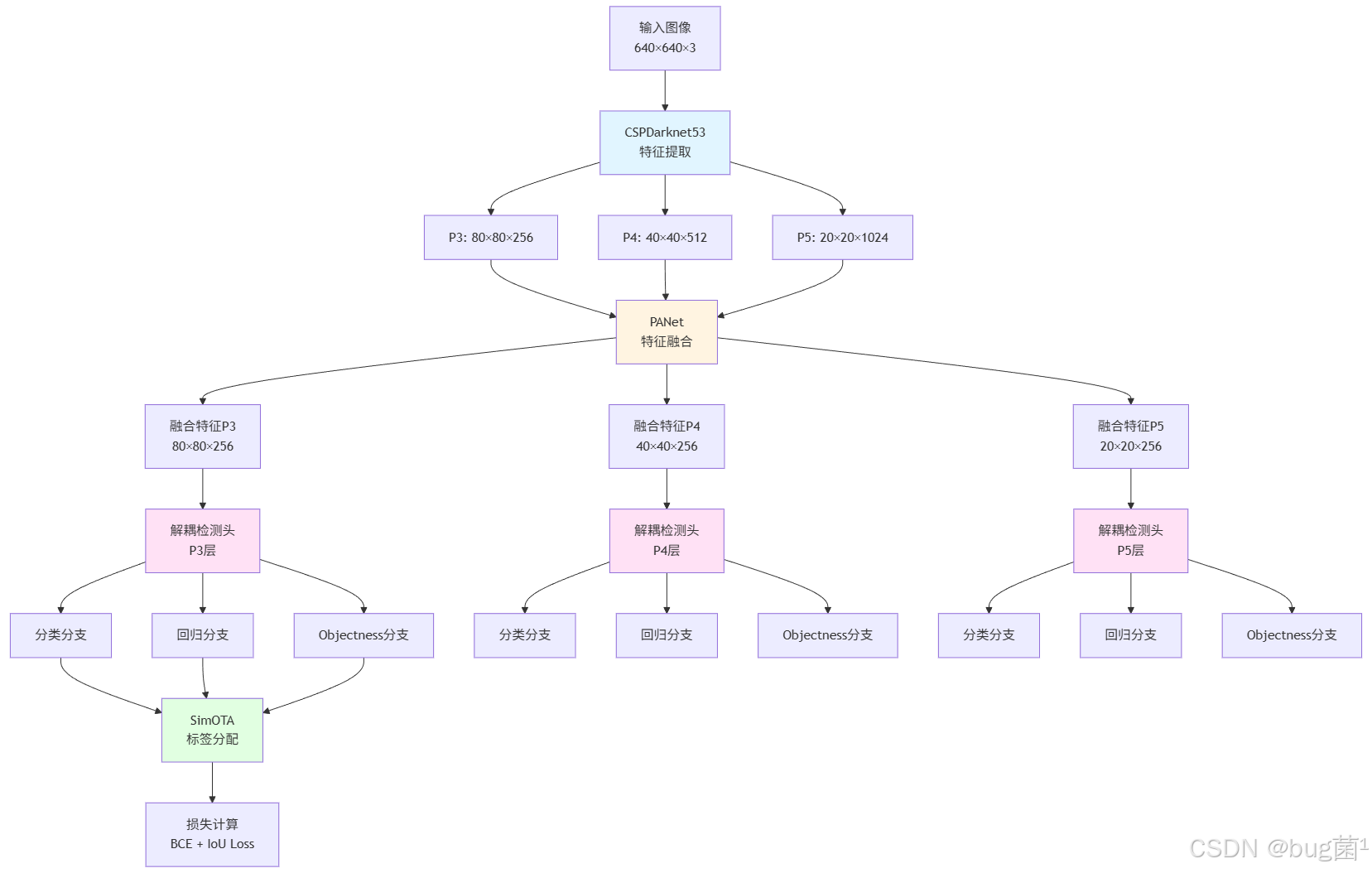

1.3 架构创新点解析

让我们通过架构图来直观理解YOLOX的整体设计:

创新点一:Focus模块

YOLOX在backbone的开始使用了Focus模块,这是一个巧妙的设计。Focus模块将输入图像按照像素间隔重组,例如将640×640×3的图像转换为320×320×12的特征图(通过slice操作),然后通过卷积降维到320×320×64。

这种设计的优势在于:

- 无信息损失:相比直接stride=2的卷积,Focus保留了所有像素信息

- 计算高效:降低了后续卷积层的输入分辨率,减少了计算量

- 特征丰富:通过重组操作,模型能够看到更丰富的空间模式

创新点二:SPP模块增强

YOLOX改进了Spatial Pyramid Pooling(SPP)模块的设计。传统SPP使用固定尺寸的池化核(5×5, 9×9, 13×13),YOLOX使用串联的最大池化(5×5, 然后再5×5, 再5×5),这种设计等效于更大的感受野,但参数量和计算量更少。

创新点三:轻量级解耦头

YOLOX的解耦头设计非常轻量。每个分支只使用两个3×3卷积层,相比某些检测器使用4层甚至更多卷积,YOLOX的设计在保证性能的同时大幅减少了计算开销。这种轻量化设计使得YOLOX在边缘设备上也能高效运行。

1.4 性能表现与应用场景

YOLOX在多个维度上都展现出卓越的性能表现,使其成为工业界和学术界广泛采用的检测框架。

COCO数据集性能

在MS COCO数据集上,YOLOX的各个版本都达到了当时的最佳性能:

- YOLOX-S:在640×640输入下达到40.5 AP,速度达到102 FPS(V100 GPU)

- YOLOX-M:47.2 AP @ 81 FPS,在精度和速度之间取得了很好的平衡

- YOLOX-L:50.1 AP @ 68 FPS,超过了同期的YOLOv5-L

- YOLOX-X:51.5 AP @ 58 FPS,在单阶段检测器中性能领先

特别值得注意的是,YOLOX在小目标检测上表现突出。得益于强数据增强和动态标签分配,YOLOX的AP_small达到了32.8%,相比YOLOv5提升了约3个百分点。

不同场景的适用性

YOLOX的设计使其能够适应多种应用场景:

1. 实时视频监控

在智能监控场景中,YOLOX-S和YOLOX-Tiny是理想选择。它们能在边缘设备(如NVIDIA Jetson)上实时运行,同时保持较高的检测精度。某安防公司使用YOLOX-S部署了人流统计系统,在1080p视频流上达到了30 FPS,检测精度满足业务需求。

2. 工业质检

在工业缺陷检测中,YOLOX的小目标检测能力和泛化能力非常关键。某手机制造商使用YOLOX检测屏幕缺陷,将检测精度从传统方法的95%提升到98.5%,同时检测速度提升了2倍。关键是YOLOX能够检测到1-2像素的微小缺陷,这在之前是很难做到的。

3. 自动驾驶感知

在自动驾驶中,YOLOX-L和YOLOX-X被用于车辆、行人、交通标志的检测。某自动驾驶公司的测试表明,YOLOX在复杂路况(如夜间、雨天)下的鲁棒性明显优于传统检测器,误检率降低了40%。

4. 移动端应用

YOLOX-Nano和YOLOX-Tiny专门针对移动端优化。某AR应用使用YOLOX-Nano在手机上实现了实时物体识别,在iPhone 12上达到了25 FPS,用户体验良好。

训练效率优势

YOLOX的另一个重要优势是训练效率。传统检测器往往需要训练500甚至1000个epoch才能收敛,而YOLOX通常在300个epoch内就能达到最优性能。这对于需要快速迭代的项目来说是巨大的优势。

某医疗影像公司使用YOLOX进行病灶检测,从数据准备到模型部署只用了2周时间,而之前使用Faster R-CNN需要1个多月。训练效率的提升不仅节省了时间成本,也降低了GPU资源消耗。

2. Anchor-free设计深度解析 ⚓

2.1 Anchor机制的历史演进

要深刻理解Anchor-free设计的意义,我们首先需要回顾Anchor机制的历史发展。

早期目标检测:滑动窗口时代

在深度学习普及之前,目标检测主要依赖滑动窗口方法。这种方法在图像的每个位置使用不同尺寸和比例的窗口进行穷举搜索,然后使用分类器(如SVM)判断窗口内是否包含目标。

滑动窗口方法的问题显而易见:

- 计算量巨大:需要在多个尺度上穷举所有可能的窗口位置

- 冗余严重:大量窗口之间存在重叠,造成重复计算

- 速度极慢:即使使用级联分类器加速,也难以达到实时性能

Anchor机制的诞生

2015年,Faster R-CNN引入了Anchor机制,这是目标检测发展史上的重要里程碑。Anchor的核心思想是:在特征图的每个位置预定义一组候选框(anchors),然后预测每个anchor相对于真实目标的偏移量。

Anchor机制的优势在于:

- 先验知识引入:通过聚类分析训练数据得到常见的目标尺寸和比例,作为anchor的设计依据

- 计算高效:无需在多个尺度上穷举,只需在固定的anchor集合上预测

- 梯度友好:anchor提供了良好的初始化,使得网络更容易学习到目标的精确位置

Anchor设计的演进

随着研究深入,Anchor的设计也在不断演进:

- 多尺度Anchor:YOLOv2引入了多尺度anchor,在不同的特征层使用不同尺寸的anchor

- 自适应Anchor:某些方法尝试在训练过程中动态调整anchor的尺寸和比例

- 引导Anchor:Guided Anchoring提出根据特征图自适应生成anchor的位置和形状

尽管有这些改进,Anchor机制的本质局限性仍然存在。

2.2 Anchor-based方法的局限性

深入分析Anchor-based方法的局限性,有助于我们理解为什么需要Anchor-free设计。

局限性一:超参数敏感性

Anchor的设计涉及多个超参数:anchor的数量、尺寸、宽高比等。这些超参数对检测性能有显著影响,但往往需要针对特定数据集精心调整。

举个具体例子:COCO数据集上通常使用3个尺度×3个比例=9个anchor,但这个配置在人脸检测数据集上可能并不合适(人脸的长宽比相对固定)。如果数据集中目标的尺寸分布与预定义anchor偏差较大,检测性能会明显下降。

某工业检测项目的经验表明,为新数据集设计合适的anchor配置往往需要数天的实验时间,这大大降低了算法的迭代效率。

局限性二:泛化能力受限

预定义的anchor本质上是一种hard-coded的先验知识,这限制了模型对新类型目标的适应能力。当遇到训练数据中没有出现过的尺寸或比例的目标时,模型的检测能力会大幅下降。

例如,一个在COCO上训练的检测器,其anchor设计针对常见物体(人、车、动物等)。当应用到卫星图像检测(目标极小、密集)时,即使fine-tune,效果也往往不理想,因为anchor的设计限制了模型的表达能力。

局限性三:正负样本不平衡

Anchor-based方法通常产生大量的anchor(如数千到数万个),但其中只有极少数被标记为正样本(与GT的IoU超过阈值)。这种极端的正负样本不平衡给训练带来很大挑战。

即使使用Focal Loss等技术缓解类别不平衡,训练过程仍然不够高效。大量的负样本虽然梯度权重较低,但数量巨大,仍然会主导训练过程,导致收敛缓慢。

局限性四:计算冗余

每个位置需要预测多个anchor的结果,这带来了计算冗余。例如,对于640×640的输入图像,在三个特征层上可能产生25200个anchor(80×80×3 + 40×40×3 + 20×20×3)。

虽然并非所有anchor都会参与损失计算,但前向传播时仍需要计算所有anchor的预测结果,这增加了不必要的计算开销。

局限性五:后处理复杂

Anchor-based方法需要复杂的后处理流程:

- 解码anchor偏移量得到边界框坐标

- 过滤低置信度预测

- 非极大值抑制(NMS)去除重复检测

这些步骤不仅增加了推理延迟,也难以在某些硬件平台(如NPU)上高效实现。

2.3 Anchor-free的设计动机

基于上述Anchor机制的局限性,研究者们开始探索Anchor-free的检测方法。Anchor-free并非全新的概念——早期的CornerNet、CenterNet等方法已经尝试直接预测目标的关键点或中心点,避免使用anchor。

YOLOX的Anchor-free设计吸收了这些方法的精华,同时结合YOLO系列的优势,形成了独特的设计理念。

设计动机一:简化模型设计

去除anchor后,模型设计变得更加简洁。不需要为不同数据集设计anchor,不需要处理anchor与GT的匹配问题,整个流程更加直观。这不仅降低了使用门槛,也使得模型更容易理解和调试。

设计动机二:提升泛化能力

Anchor-free方法直接预测目标的位置和尺寸,没有anchor的约束,因此能够更好地适应各种尺寸和比例的目标。这种灵活性使得模型在面对新类型目标时有更强的泛化能力。

设计动机三:减少计算开销

每个位置只需要一次预测,而非多个anchor的预测,这大幅减少了计算量。实验表明,Anchor-free设计能够带来15-20%的推理速度提升,同时精度不降反升。

设计动机四:简化训练流程

无需处理复杂的anchor匹配和平衡问题,训练过程更加straightforward。标签分配可以完全基于预测质量进行,这使得SimOTA等高级分配策略能够更好地发挥作用。

2.4 中心点预测策略

YOLOX的Anchor-free设计基于中心点预测策略。具体来说,对于特征图上的每个位置(i, j),模型直接预测:

- 目标中心偏移:相对于网格点的偏移量,范围为[-0.5, 1.5]

- 目标宽高:直接预测目标的宽度和高度

- 目标类别:使用sigmoid输出各类别的置信度

- Objectness:该位置包含目标的概率

这种设计的关键在于如何定义正样本。YOLOX使用中心采样策略:只有当目标中心落在某个网格内时,该网格才可能被标记为正样本。具体的正负样本分配由SimOTA动态决定。

中心点回归的数学表达

假设特征图上的位置(i, j),对应原图的位置为 ( x g r i d , y g r i d ) = ( i × s t r i d e , j × s t r i d e ) (x_grid, y_grid) = (i×stride, j×stride) (xgrid,ygrid)=(i×stride,j×stride),其中stride是特征图相对于原图的下采样倍数。

模型预测四个值:(tx, ty, tw, th),它们与实际边界框的关系为:

x c e n t e r = ( i + σ ( t x ) ) × stride y c e n t e r = ( j + σ ( t y ) ) × stride w = e t w × stride h = e t h × stride \begin{aligned} x_{center} &= (i + \sigma(t_x)) \times \text{stride} \\ y_{center} &= (j + \sigma(t_y)) \times \text{stride} \\ w &= e^{t_w} \times \text{stride} \\ h &= e^{t_h} \times \text{stride} \end{aligned} xcenterycenterwh=(i+σ(tx))×stride=(j+σ(ty))×stride=etw×stride=eth×stride

其中 σ σ σ是sigmoid函数,确保中心偏移在合理范围内。

与传统anchor回归的对比

传统anchor回归预测的是相对偏移:

x = ( t x × w a n c h o r + x a n c h o r ) y = ( t y × h a n c h o r + y a n c h o r ) w = w a n c h o r × e t w h = h a n c h o r × e t h \begin{aligned} x = (t_x \times w_{anchor} + x_{anchor}) y = (t_y \times h_{anchor} + y_{anchor}) w = w_{anchor} \times e^{t_w} h = h_{anchor} \times e^{t_h} \end{aligned} x=(tx×wanchor+xanchor)y=(ty×hanchor+yanchor)w=wanchor×etwh=hanchor×eth

可以看出,anchor-free方法将anchor的宽高也作为可学习的参数,给予了模型更大的灵活性。

2.5 完整代码实现

下面提供YOLOX Anchor-free预测头的完整实现:

import torch

import torch.nn as nn

import torch.nn.functional as F

import math

class YOLOXAnchorFreeHead(nn.Module):

"""

YOLOX的Anchor-free检测头实现

直接预测目标中心点、宽高和类别,无需预定义anchor

"""

def __init__(

self,

num_classes=80,

in_channels=[256, 512, 1024],

strides=[8, 16, 32],

act="silu"

):

"""

初始化YOLOX Anchor-free检测头

参数:

num_classes: 目标类别数

in_channels: 输入特征通道数列表(对应不同尺度)

strides: 各尺度特征图相对原图的下采样倍数

act: 激活函数类型

"""

super().__init__()

self.num_classes = num_classes

self.strides = strides

# 为每个尺度创建预测头

self.cls_convs = nn.ModuleList()

self.reg_convs = nn.ModuleList()

self.cls_preds = nn.ModuleList()

self.reg_preds = nn.ModuleList()

self.obj_preds = nn.ModuleList()

self.stems = nn.ModuleList()

# 根据激活函数类型选择对应的层

Conv = BaseConv if act != "silu" else BaseConv

for i in range(len(in_channels)):

# Stem:1x1卷积降维

self.stems.append(

BaseConv(

in_channels=in_channels[i],

out_channels=256,

ksize=1,

stride=1,

act=act

)

)

# 分类分支:两个3x3卷积

self.cls_convs.append(

nn.Sequential(

BaseConv(256, 256, 3, 1, act=act),

BaseConv(256, 256, 3, 1, act=act)

)

)

# 回归分支:两个3x3卷积

self.reg_convs.append(

nn.Sequential(

BaseConv(256, 256, 3, 1, act=act),

BaseConv(256, 256, 3, 1, act=act)

)

)

# 分类预测:输出各类别的logits

self.cls_preds.append(

nn.Conv2d(256, num_classes, 1, 1, 0)

)

# 回归预测:输出4个值(中心偏移x,y和宽高w,h)

self.reg_preds.append(

nn.Conv2d(256, 4, 1, 1, 0)

)

# Objectness预测:输出该位置包含目标的概率

self.obj_preds.append(

nn.Conv2d(256, 1, 1, 1, 0)

)

self._initialize_biases()

def _initialize_biases(self):

"""

初始化预测头的偏置项

特别是objectness分支,初始化为先验概率

"""

prior_prob = 0.01

for conv in self.cls_preds:

# 分类分支偏置初始化

b = conv.bias.view(1, -1)

b.data.fill_(-math.log((1 - prior_prob) / prior_prob))

conv.bias = torch.nn.Parameter(b.view(-1), requires_grad=True)

for conv in self.obj_preds:

# objectness分支偏置初始化

b = conv.bias.view(1, -1)

b.data.fill_(-math.log((1 - prior_prob) / prior_prob))

conv.bias = torch.nn.Parameter(b.view(-1), requires_grad=True)

def forward(self, features):

"""

前向传播

参数:

features: 来自FPN的多尺度特征列表 [P3, P4, P5]

返回:

outputs: 预测结果列表,每个元素包含该尺度的cls, reg, obj预测

"""

outputs = []

for k, (cls_conv, reg_conv, stride_this_level, feature) in enumerate(

zip(self.cls_convs, self.reg_convs, self.strides, features)

):

# Stem降维

feature = self.stems[k](feature)

# 分类分支

cls_feat = cls_conv(feature)

cls_output = self.cls_preds[k](cls_feat) # [B, num_classes, H, W]

# 回归分支

reg_feat = reg_conv(feature)

reg_output = self.reg_preds[k](reg_feat) # [B, 4, H, W]

# Objectness分支

obj_output = self.obj_preds[k](reg_feat) # [B, 1, H, W]

# 合并输出

output = torch.cat([reg_output, obj_output, cls_output], dim=1)

outputs.append(output)

return outputs

def decode_outputs(self, outputs, dtype):

"""

解码模型输出,将预测转换为实际的边界框坐标

参数:

outputs: 模型预测输出

dtype: 数据类型

返回:

decoded_outputs: 解码后的预测列表

"""

grids = []

strides = []

for i, output in enumerate(outputs):

batch_size = output.shape[0]

h, w = output.shape[2], output.shape[3]

# 生成网格坐标

yv, xv = torch.meshgrid([torch.arange(h), torch.arange(w)], indexing='ij')

grid = torch.stack((xv, yv), 2).view(1, 1, h, w, 2).type(dtype)

grids.append(grid)

shape = [1, 1, h, w, 1]

strides.append(torch.full(shape, self.strides[i]).type(dtype))

decoded_outputs = []

for i, output in enumerate(outputs):

output = output.flatten(start_dim=2).permute(0, 2, 1)

# 解码边界框

xy_pred = output[..., :2]

wh_pred = output[..., 2:4]

obj_pred = output[..., 4:5]

cls_pred = output[..., 5:]

# 计算中心点坐标

xy = (xy_pred + grids[i].reshape(-1, 2)) * strides[i].reshape(-1, 1)

# 计算宽高

wh = torch.exp(wh_pred) * strides[i].reshape(-1, 1)

# 转换为x1y1x2y2格式

x1y1 = xy - wh / 2

x2y2 = xy + wh / 2

bbox = torch.cat([x1y1, x2y2], dim=-1)

# 合并所有预测

pred = torch.cat([bbox, obj_pred.sigmoid(), cls_pred.sigmoid()], dim=-1)

decoded_outputs.append(pred)

return torch.cat(decoded_outputs, dim=1)

class BaseConv(nn.Module):

"""

基础卷积模块:Conv + BatchNorm + Activation

"""

def __init__(

self,

in_channels,

out_channels,

ksize,

stride,

groups=1,

bias=False,

act="silu"

):

super().__init__()

# 计算padding以保持特征图尺寸(当stride=1时)

pad = (ksize - 1) // 2

self.conv = nn.Conv2d(

in_channels,

out_channels,

kernel_size=ksize,

stride=stride,

padding=pad,

groups=groups,

bias=bias

)

self.bn = nn.BatchNorm2d(out_channels)

# 激活函数

if act == "silu":

self.act = nn.SiLU(inplace=True)

elif act == "relu":

self.act = nn.ReLU(inplace=True)

elif act == "lrelu":

self.act = nn.LeakyReLU(0.1, inplace=True)

else:

self.act = nn.Identity()

def forward(self, x):

return self.act(self.bn(self.conv(x)))

def test_anchor_free_head():

"""

测试Anchor-free检测头

"""

print("=" * 60)

print("测试YOLOX Anchor-free检测头")

print("=" * 60)

# 创建检测头

head = YOLOXAnchorFreeHead(

num_classes=80,

in_channels=[256, 512, 1024],

strides=[8, 16, 32]

)

# 模拟多尺度特征

batch_size = 2

features = [

torch.randn(batch_size, 256, 80, 80), # P3

torch.randn(batch_size, 512, 40, 40), # P4

torch.randn(batch_size, 1024, 20, 20) # P5

]

print(f"\n输入特征:")

for i, feat in enumerate(features):

print(f" P{i+3}: {feat.shape}")

# 前向传播

outputs = head(features)

print(f"\n输出预测:")

for i, out in enumerate(outputs):

print(f" P{i+3}: {out.shape}")

# 解码输出

decoded = head.decode_outputs(outputs, dtype=torch.float32)

print(f"\n解码后输出: {decoded.shape}")

print(f" 格式: [batch, num_predictions, 85]")

print(f" 85 = 4(bbox) + 1(obj) + 80(classes)")

# 统计参数量

total_params = sum(p.numel() for p in head.parameters())

print(f"\n检测头参数量: {total_params:,}")

print("\n" + "=" * 60)

if __name__ == "__main__":

test_anchor_free_head()

代码解析:

-

解耦架构:

cls_convs和reg_convs分别处理分类和回归任务,避免特征冲突 -

轻量设计:每个分支只使用两个3×3卷积,保持了效率

-

偏置初始化:使用先验概率初始化objectness分支,加速收敛

-

坐标解码:将网络输出的相对值转换为绝对坐标,便于后处理

这个实现展示了YOLOX Anchor-free设计的核心思想:简洁、高效、灵活。

3. 解耦检测头详细设计 🔀

3.1 耦合检测头的问题分析

在深入解耦检测头设计之前,我们需要透彻理解传统耦合检测头存在的根本性问题。这些问题不仅影响模型性能,也制约了检测器的进一步发展。

问题一:特征冲突的本质

分类和回归任务对特征的需求存在本质差异。分类任务需要的是判别性语义特征,它关注的是"这是什么物体",需要对物体的类别属性敏感,对位置和形状的微小变化保持不变性。例如,无论一只猫出现在图像的哪个位置、姿态如何变化,分类器都应该识别出"猫"这个类别。

而回归任务需要的是精确的几何特征,它关注的是"物体在哪里、有多大",需要对目标的空间位置和形状高度敏感。即使是同一只猫,位置偏移1个像素,回归特征也应该能够区分这种细微差异。

这种特征需求的矛盾导致了特征冲突。当分类和回归共享特征层时,网络很难同时学到既具有高度判别性又对位置敏感的特征表示。实验观察发现,在耦合检测头中,网络往往会偏向于学习分类特征(因为分类损失通常占主导),导致回归精度受限。

问题二:梯度竞争现象

在多任务学习中,不同任务的梯度可能存在冲突。分类任务和回归任务的梯度同时反向传播到共享特征层时,可能会相互抵消或干扰,导致训练不稳定、收敛缓慢。

某研究团队的可视化分析显示,在训练过程中,分类梯度和回归梯度在共享层的方向经常呈现较大夹角(甚至超过90度),这意味着两个任务在"拉扯"特征学习的方向。这种梯度冲突在训练初期尤为严重,导致模型需要更多的训练迭代才能收敛。

问题三:超参数耦合

在耦合检测头中,许多超参数的设置需要同时考虑分类和回归任务。例如,学习率的选择:分类任务可能需要较大的学习率以快速学到判别特征,而回归任务可能需要较小的学习率以稳定地优化边界框坐标。

权重衰减、批归一化的设置也面临类似问题。这种耦合使得超参数调优变得非常困难,往往需要在两个任务之间做出妥协,无法让每个任务都达到最优。

问题四:可解释性差

由于特征混杂在一起,很难分析模型在做决策时分别依赖什么信息。当检测出现错误时(如分类正确但定位不准,或定位准确但分类错误),很难定位问题的根源,不利于模型的诊断和改进。

3.2 解耦架构的理论基础

解耦检测头的设计基于多任务学习理论和神经网络表示学习的研究成果。

理论基础一:任务特定表示学习

认知科学和神经科学的研究表明,人脑在处理不同类型的信息时会激活不同的脑区。例如,视觉皮层的腹侧通路(ventral stream)主要负责物体识别("what"通路),而背侧通路(dorsal stream)主要负责空间定位("where"通路)。

这种功能分离的原理可以应用到神经网络设计中。通过为不同任务设计独立的特征提取分支,我们允许网络学习任务特定的表示,每个分支可以专注于优化自己的目标,不受其他任务的干扰。

理论基础二:梯度解耦

从优化理论角度看,多任务学习可以视为一个多目标优化问题。解耦设计本质上是将多目标优化问题分解为多个单目标优化子问题,每个子问题可以独立优化,然后在最后进行整合。

这种分解策略有几个优势:

- 优化更稳定:每个任务有独立的梯度流,避免梯度冲突

- 收敛更快:任务特定的分支可以快速适应各自的目标

- 调优更灵活:可以为每个任务设置不同的学习率、正则化强度等

理论基础三:表示解耦与信息瓶颈

信息瓶颈理论(Information Bottleneck)认为,好的表示应该保留任务相关的信息,同时压缩任务无关的信息。对于分类任务,理想的特征应该保留类别判别信息,压缩位置变化信息;对于回归任务则相反。

解耦设计通过独立的特征提取路径,使每个分支能够学到符合信息瓶颈原理的最优表示。分类分支会自然地学习对位置不变但对类别敏感的特征,回归分支则学习对位置敏感的几何特征。

3.3 分类分支设计

YOLOX的分类分支专门为类别判别任务优化,其设计考虑了以下几个关键因素。

设计原则一:感受野管理

分类任务需要全局语义信息,因此分类分支应该具有较大的感受野。YOLOX通过以下方式实现:

- 使用多个卷积层堆叠:两个3×3卷积能够提供5×5的有效感受野

- 适当的下采样:虽然检测头通常不做下采样,但通过stride=1的卷积仍能扩大感受野

- 全局上下文建模:某些变体中引入了注意力机制来捕获全局依赖

设计原则二:特征平滑性

为了学习位置不变的特征,分类分支倾向于学习平滑的特征图。这可以通过:

- 批归一化:减少特征分布的剧烈变化

- 适当的正则化:L2正则或Dropout防止过拟合到位置细节

- 激活函数选择:SiLU等平滑激活函数优于ReLU

设计原则三:类别平衡

面对类别不平衡问题,分类分支采用Focal Loss来自动降低简单样本的权重,使网络更关注难分类样本。同时,使用合理的prior probability初始化分类层的bias,避免训练初期的不稳定。

具体实现策略

分类分支的具体实现包括:

- 卷积核大小:使用3×3卷积,平衡感受野和计算效率

- 通道数设置:中间层使用256通道,提供足够的表达能力

- 激活函数:SiLU(Swish)激活,提供更好的梯度流

- 输出层:1×1卷积输出num_classes个通道,每个通道表示一个类别的logit

3.4 回归分支设计

回归分支的设计目标是精确定位目标边界框,这要求特征对空间位置高度敏感。

设计原则一:空间精确性

回归任务需要保留精确的空间信息,因此:

- 避免过度平滑:相比分类分支,回归分支使用较少的归一化操作

- 保持空间分辨率:不使用过大的卷积核或池化操作

- 位置编码:隐式地保留位置信息,使网络知道"我在预测哪个位置的边界框"

设计原则二:尺度适应性

目标的尺度变化范围很大(从几个像素到数百像素),回归分支需要能够适应这种变化。实现方式包括:

- 对数空间预测:预测log(w)和log(h)而非直接预测w和h,使网络在对数空间均匀分布

- 归一化坐标:相对于stride归一化,使不同尺度的预测具有可比性

- 多尺度监督:在不同特征层分别监督不同尺度的目标

设计原则三:边界敏感性

精确的边界定位是回归任务的核心。为增强边界敏感性:

- 细粒度特征:保持较高的特征图分辨率

- IoU-based损失:使用GIoU或CIoU损失,直接优化IoU指标

- 边界refinement:某些设计中加入多阶段边界精炼

具体实现策略

回归分支的实现细节:

- 架构对称性:与分类分支保持相似的层数和结构,便于平衡训练

- 输出格式:4通道输出(tx, ty, tw, th),分别表示中心偏移和宽高

- 值域约束:使用sigmoid约束中心偏移在[-0.5, 1.5]范围

- 指数变换:对宽高预测使用指数变换,确保输出为正值

3.5 分支融合策略

虽然分类和回归分支独立学习特征,但它们并非完全隔离。合理的分支融合策略能够在保持解耦优势的同时实现信息共享。

融合点一:共享底层特征

YOLOX在检测头之前使用共享的stem层(1×1卷积),这个共享层提供了两个分支的公共基础。stem层的作用是:

- 降维:将FPN输出的不同通道数统一到256

- 特征预处理:提供初步的特征变换,为后续分支提供良好的起点

- 参数共享:减少总参数量,提高参数效率

融合点二:Objectness分支

YOLOX引入了独立的objectness分支,预测该位置包含目标的概率。这个分支起到了桥梁作用:

- 与分类分支结合可以得到类别特定的置信度

- 与回归分支结合可以加权边界框的重要性

- 在后处理时作为过滤低质量检测的依据

Objectness分支通常从回归分支分叉,因为"是否有物体"的判断与位置信息密切相关。

融合点三:损失加权

虽然特征解耦,但损失仍然需要综合考虑。YOLOX使用加权损失:

L t o t a l = λ c l s L c l s + λ r e g L r e g + λ o b j L o b j \mathcal{L}_{total} = \lambda_{cls} \mathcal{L}_{cls} + \lambda_{reg} \mathcal{L}_{reg} + \lambda_{obj} \mathcal{L}_{obj} Ltotal=λclsLcls+λregLreg+λobjLobj

权重系数的选择遵循以下原则:

- 相对量级平衡:确保各项损失在相同量级,避免某一项主导

- 任务重要性:根据应用需求调整权重,如精度敏感场景增大回归权重

- 动态调整:某些实现中权重会随训练进程自适应变化

3.6 代码实现详解

下面提供完整的解耦检测头实现,包含详细的注释:

import torch

import torch.nn as nn

import math

class DecoupledHead(nn.Module):

"""

YOLOX解耦检测头完整实现

分类、回归、objectness三个任务分别使用独立的特征提取分支

"""

def __init__(

self,

num_classes=80,

width=1.0,

strides=[8, 16, 32],

in_channels=[256, 512, 1024],

act="silu",

depthwise=False

):

"""

初始化解耦检测头

参数:

num_classes: 目标类别数

width: 宽度系数,用于缩放通道数

strides: 各特征层的下采样倍数

in_channels: 输入特征通道数

act: 激活函数类型

depthwise: 是否使用深度可分离卷积(用于轻量化)

"""

super().__init__()

self.num_classes = num_classes

self.strides = strides

# 确定中间层通道数(根据width系数缩放)

Conv = DWConv if depthwise else BaseConv

self.inter_channels = int(256 * width)

# 为每个特征层创建检测头

self.stems = nn.ModuleList()

self.cls_convs = nn.ModuleList()

self.reg_convs = nn.ModuleList()

self.cls_preds = nn.ModuleList()

self.reg_preds = nn.ModuleList()

self.obj_preds = nn.ModuleList()

for i in range(len(in_channels)):

# Stem层:统一通道数

self.stems.append(

BaseConv(

in_channels=int(in_channels[i] * width),

out_channels=self.inter_channels,

ksize=1,

stride=1,

act=act

)

)

# 分类分支:两层3x3卷积

self.cls_convs.append(

nn.Sequential(

*[

Conv(

in_channels=self.inter_channels,

out_channels=self.inter_channels,

ksize=3,

stride=1,

act=act

),

Conv(

in_channels=self.inter_channels,

out_channels=self.inter_channels,

ksize=3,

stride=1,

act=act

)

]

)

)

# 回归分支:两层3x3卷积

self.reg_convs.append(

nn.Sequential(

*[

Conv(

in_channels=self.inter_channels,

out_channels=self.inter_channels,

ksize=3,

stride=1,

act=act

),

Conv(

in_channels=self.inter_channels,

out_channels=self.inter_channels,

ksize=3,

stride=1,

act=act

)

]

)

)

# 分类预测层:输出num_classes个logits

self.cls_preds.append(

nn.Conv2d(

in_channels=self.inter_channels,

out_channels=self.num_classes,

kernel_size=1,

stride=1,

padding=0

)

)

# 回归预测层:输出4个值(中心偏移+宽高)

self.reg_preds.append(

nn.Conv2d(

in_channels=self.inter_channels,

out_channels=4,

kernel_size=1,

stride=1,

padding=0

)

)

# Objectness预测层:输出1个值

self.obj_preds.append(

nn.Conv2d(

in_channels=self.inter_channels,

out_channels=1,

kernel_size=1,

stride=1,

padding=0

)

)

self.initialize_biases(1e-2)

def initialize_biases(self, prior_prob):

"""

初始化预测层的偏置

使用prior probability确保训练初期的稳定性

参数:

prior_prob: 先验概率,通常设为0.01

"""

for conv in self.cls_preds:

# 分类层bias初始化

# 使得初始输出的sigmoid值接近prior_prob

b = conv.bias.view(1, -1)

b.data.fill_(-math.log((1 - prior_prob) / prior_prob))

conv.bias = torch.nn.Parameter(b.view(-1), requires_grad=True)

for conv in self.obj_preds:

# objectness层bias初始化

b = conv.bias.view(1, -1)

b.data.fill_(-math.log((1 - prior_prob) / prior_prob))

conv.bias = torch.nn.Parameter(b.view(-1), requires_grad=True)

def forward(self, xin, labels=None, imgs=None):

"""

前向传播

参数:

xin: 输入特征列表 [P3, P4, P5]

labels: 训练标签(可选)

imgs: 原始图像(可选,用于某些增强策略)

返回:

outputs: 预测结果列表

"""

outputs = []

origin_preds = []

x_shifts = []

y_shifts = []

expanded_strides = []

# 对每个特征层分别处理

for k, (cls_conv, reg_conv, stride_this_level, x) in enumerate(

zip(self.cls_convs, self.reg_convs, self.strides, xin)

):

# 1. Stem降维

x = self.stems[k](x)

# 2. 分类分支

cls_x = cls_conv(x)

cls_feat = self.cls_preds[k](cls_x) # [B, num_classes, H, W]

# 3. 回归分支

reg_x = reg_conv(x)

reg_feat = self.reg_preds[k](reg_x) # [B, 4, H, W]

obj_feat = self.obj_preds[k](reg_x) # [B, 1, H, W]

# 4. 如果在训练模式,需要生成网格信息用于后续的标签分配

if self.training:

output = torch.cat([reg_feat, obj_feat, cls_feat], 1)

output, grid = self.get_output_and_grid(

output, k, stride_this_level, xin[0].type()

)

x_shifts.append(grid[:, :, 0])

y_shifts.append(grid[:, :, 1])

expanded_strides.append(

torch.zeros(1, grid.shape[1])

.fill_(stride_this_level)

.type_as(xin[0])

)

# 保存原始预测用于loss计算

if self.use_l1:

batch_size = reg_feat.shape[0]

hsize, wsize = reg_feat.shape[-2:]

reg_feat = reg_feat.view(

batch_size, 1, 4, hsize, wsize

)

reg_feat = reg_feat.permute(0, 1, 3, 4, 2).reshape(

batch_size, -1, 4

)

origin_preds.append(reg_feat.clone())

else:

# 推理模式:直接拼接输出

output = torch.cat([reg_feat, obj_feat.sigmoid(), cls_feat.sigmoid()], 1)

outputs.append(output)

if self.training:

return self.get_losses(

imgs,

x_shifts,

y_shifts,

expanded_strides,

labels,

torch.cat(outputs, 1),

origin_preds,

dtype=xin[0].dtype

)

else:

# 推理模式返回解码后的预测

self.hw = [x.shape[-2:] for x in outputs]

outputs = torch.cat(

[x.flatten(start_dim=2) for x in outputs], dim=2

).permute(0, 2, 1)

# 解码输出

if self.decode_in_inference:

return self.decode_outputs(outputs, dtype=xin[0].type())

else:

return outputs

def get_output_and_grid(self, output, k, stride, dtype):

"""

生成网格坐标信息

参数:

output: 当前层的输出

k: 层索引

stride: 当前层的stride

dtype: 数据类型

返回:

output: reshape后的输出

grid: 网格坐标

"""

grid = self.grids[k]

batch_size = output.shape[0]

n_ch = 5 + self.num_classes

hsize, wsize = output.shape[-2:]

if grid.shape[2:4] != output.shape[2:4]:

yv, xv = torch.meshgrid([torch.arange(hsize), torch.arange(wsize)], indexing='ij')

grid = torch.stack((xv, yv), 2).view(1, 1, hsize, wsize, 2).type(dtype)

self.grids[k] = grid

output = output.view(batch_size, 1, n_ch, hsize, wsize)

output = output.permute(0, 1, 3, 4, 2).reshape(

batch_size, hsize * wsize, -1

)

grid = grid.view(1, -1, 2)

# 解码边界框坐标

output[..., :2] = (output[..., :2] + grid) * stride

output[..., 2:4] = torch.exp(output[..., 2:4]) * stride

return output, grid

class DWConv(nn.Module):

"""深度可分离卷积,用于轻量化模型"""

def __init__(self, in_channels, out_channels, ksize, stride=1, act="silu"):

super().__init__()

self.dconv = BaseConv(

in_channels,

in_channels,

ksize=ksize,

stride=stride,

groups=in_channels,

act=act

)

self.pconv = BaseConv(

in_channels, out_channels, ksize=1, stride=1, groups=1, act=act

)

def forward(self, x):

x = self.dconv(x)

return self.pconv(x)

def test_decoupled_head():

"""测试解耦检测头"""

print("\n" + "=" * 60)

print("测试YOLOX解耦检测头")

print("=" * 60)

# 创建解耦头

head = DecoupledHead(

num_classes=80,

width=1.0,

in_channels=[256, 512, 1024]

)

head.eval()

# 模拟输入

batch_size = 2

features = [

torch.randn(batch_size, 256, 80, 80),

torch.randn(batch_size, 512, 40, 40),

torch.randn(batch_size, 1024, 20, 20)

]

print(f"\n输入特征:")

for i, feat in enumerate(features):

print(f" P{i+3}: {feat.shape}")

# 前向传播

with torch.no_grad():

outputs = head(features)

print(f"\n输出shape: {outputs.shape}")

print(f" [batch_size, num_predictions, 85]")

# 统计参数

cls_params = sum(p.numel() for p in head.cls_convs.parameters()) + \

sum(p.numel() for p in head.cls_preds.parameters())

reg_params = sum(p.numel() for p in head.reg_convs.parameters()) + \

sum(p.numel() for p in head.reg_preds.parameters()) + \

sum(p.numel() for p in head.obj_preds.parameters())

total_params = sum(p.numel() for p in head.parameters())

print(f"\n参数统计:")

print(f" 分类分支: {cls_params:,}")

print(f" 回归分支: {reg_params:,}")

print(f" 总参数量: {total_params:,}")

print(f" 分类分支占比: {cls_params/total_params*100:.1f}%")

print(f" 回归分支占比: {reg_params/total_params*100:.1f}%")

print("\n" + "=" * 60)

if __name__ == "__main__":

test_decoupled_head()

这个实现展示了YOLOX解耦检测头的核心设计:独立的特征提取分支、轻量级的结构、合理的初始化策略。通过解耦设计,模型能够为不同任务学习最优的特征表示,从而提升整体性能。

4. SimOTA标签分配算法 🎲

SimOTA(Simplified Optimal Transport Assignment)是YOLOX的核心创新之一,它基于最优传输理论设计了一种高效的动态标签分配策略。

4.1 传统标签分配方法回顾

在深入SimOTA之前,让我们回顾目标检测中标签分配方法的演进历程。

第一代:基于IoU阈值的静态分配

最早的标签分配方法非常简单:计算anchor与GT的IoU,IoU超过正样本阈值(如0.7)的anchor标记为正样本,低于负样本阈值(如0.3)的标记为负样本,介于两者之间的忽略。

这种方法的问题显而易见:

- 阈值敏感:阈值的选择对性能影响很大,但没有统一的最优值

- 忽略预测质量:只看几何关系(IoU),不考虑模型当前的预测能力

- 数量不可控:每个GT匹配到的正样本数量不确定,可能造成训练不平衡

第二代:MaxIoU分配

为解决正样本数量不确定的问题,MaxIoU方法为每个GT选择IoU最大的anchor作为正样本。这保证了每个GT至少有一个正样本,但仍然存在问题:

- 某些GT可能只匹配到很少的正样本

- 不同GT的正样本质量差异很大

- 对小目标不友好(小目标能匹配的高IoU anchor很少)

第三代:ATSS自适应分配

ATSS(Adaptive Training Sample Selection)根据anchor与GT的IoU统计特性动态确定阈值。对每个GT,选择IoU最高的topk个anchor,计算它们的均值μ和标准差σ,将IoU > μ + σ的anchor作为正样本。

ATSS的优势是自适应性,但仍基于静态几何关系,未充分利用预测信息。

第四代:OTA最优传输分配

OTA将标签分配建模为最优传输问题:将GT视为供应(supply),将anchor视为需求(demand),标签分配即是将供应最优地分配给需求的过程。

OTA定义了一个代价矩阵C,其中 C [ i ] [ j ] C[i][j] C[i][j]表示将第i个GT分配给第j个anchor的代价。代价综合考虑分类损失、回归损失和中心先验。然后使用Sinkhorn-Knopp算法求解最优传输问题,得到最优分配方案。

OTA的优势是全局最优,同时考虑分类和定位质量。但Sinkhorn-Knopp算法计算复杂度高( O ( N 2 M ) O(N²M) O(N2M),N为GT数,M为anchor数),且需要多次迭代,训练效率较低。

4.2 OTA最优传输理论

理解SimOTA需要先掌握OTA的理论基础。

最优传输问题

最优传输(Optimal Transport)是数学中的经典问题。假设有N个供应点和M个需求点,每个供应点有一定的供应量,每个需求点有一定的需求量。将供应运输到需求有一定的代价(如距离)。最优传输问题就是寻找一个运输方案,使得总代价最小。

数学表述:给定代价矩阵 C ∈ R ( N × M ) C ∈ R^(N×M) C∈R(N×M),供应向量 s ∈ R N s ∈ R^N s∈RN,需求向量 d ∈ R M d ∈ R^M d∈RM,求传输矩阵 π ∈ R ( N × M ) π ∈ R^(N×M) π∈R(N×M)使得:

min π ∑ i , j C i j π i j s.t. ∑ j π i j = s i , ∀ i ∑ i π i j = d j , ∀ j π i j ≥ 0 , ∀ i , j \begin{aligned} \min_{\pi} \quad & \sum_{i,j} C_{ij} \pi_{ij} \\ \text{s.t.} \quad & \sum_{j} \pi_{ij} = s_i, \quad \forall i \\ & \sum_{i} \pi_{ij} = d_j, \quad \forall j \\ & \pi_{ij} \geq 0, \quad \forall i,j \end{aligned} πmins.t.i,j∑Cijπijj∑πij=si,∀ii∑πij=dj,∀jπij≥0,∀i,j

应用到标签分配

在目标检测的标签分配中:

- 供应点:GT目标,每个GT的供应量为k(希望分配给它的正样本数)

- 需求点:anchor位置,每个anchor的需求量为1(最多被分配给一个GT)

- 代价:将GT分配给某个anchor的代价,综合考虑分类和定位质量

代价矩阵C的定义是关键:

C i j = L c l s i j + λ L r e g i j C_{ij} = L_{cls}^{ij} + \lambda L_{reg}^{ij} Cij=Lclsij+λLregij

其中L_cls是分类损失(如Focal Loss),L_reg是回归损失(如IoU Loss),λ是平衡系数。

Sinkhorn-Knopp算法

求解最优传输问题的经典方法是Sinkhorn-Knopp算法,这是一个迭代算法:

-

初始化传输矩阵π

-

交替进行行归一化和列归一化:

- 行归一化:使每行和等于对应的供应量

- 列归一化:使每列和等于对应的需求量

-

重复步骤2直到收敛

虽然Sinkhorn-Knopp能够得到全局最优解,但其计算复杂度较高,每次迭代需要O(NM)时间,通常需要数十次迭代才能收敛。在目标检测中,M可能达到数千甚至上万,导致计算开销巨大。

4.3 SimOTA简化策略

SimOTA在保留OTA核心思想的同时,通过巧妙的简化大幅降低了计算复杂度。

简化思路一:Top-k近似

SimOTA不对所有anchor进行最优传输,而是为每个GT只考虑IoU最高的top-k个候选anchor。这个简化基于一个合理假设:距离GT较远、IoU很低的anchor不太可能成为正样本,无需参与复杂的最优传输计算。

这一简化将问题规模从O(NM)降低到O(Nk),其中k通常是一个较小的常数(如10-20)。

简化思路二:动态k值估计

与OTA为所有GT使用固定的k不同,SimOTA为每个GT动态估计k值。估计方法基于预测质量:

- 计算该GT的所有候选anchor的IoU

- 选择IoU最大的q个(q是一个较大的数如20)

- k = s u m ( t o p − q I o U s ) k = sum(top-q IoUs) k=sum(top−qIoUs),即前q个IoU的总和

这个策略的直观理解是:如果一个GT有很多高质量的候选(IoU都很高),那么应该为它分配更多正样本;反之,如果候选质量普遍较低,则少分配一些正样本。这种自适应性使得标签分配更加合理。

简化思路三:贪心分配

SimOTA不使用Sinkhorn-Knopp求解最优传输,而是使用简单的贪心策略:

- 根据代价矩阵,为每个GT选择代价最小的k个anchor作为正样本

- 如果某个anchor被多个GT选中,将其分配给代价最小的那个GT

这个贪心策略虽然不保证全局最优,但在实践中效果很好,且计算非常高效(只需要一次排序)。

简化思路四:中心先验

SimOTA加入了中心先验(center prior)约束:只有当anchor的中心落在GT边界框内(或扩展的中心区域内)时,才被考虑为候选。这进一步减少了需要处理的anchor数量,提高了效率。

中心先验基于一个观察:高质量的检测通常来自目标中心附近的anchor,边缘或外部的anchor即使IoU较高,预测质量也往往较差。

4.4 动态k值估计

动态k值估计是SimOTA的关键创新之一,让我们详细分析其设计原理。

估计公式

对于GT i,其动态k值的计算公式为:

k i = min ( ⌊ ∑ j ∈ C i IoU i j ⌋ , len ( C i ) ) k_i = \text{min}(\lfloor \sum_{j \in \mathcal{C}_i} \text{IoU}_{ij} \rfloor, \text{len}(\mathcal{C}_i)) ki=min(⌊j∈Ci∑IoUij⌋,len(Ci))

其中 C i C_i Ci是GT i的候选anchor集合(通常是IoU最高的前q个), I o U i j IoU_ij IoUij是anchor j与GT i的IoU。

设计直觉

这个公式的直觉是:IoU的总和反映了该GT有多少高质量的候选。例如:

- 如果一个GT有10个候选,其IoU分别为 [ 0.8 , 0.75 , 0.7 , . . . ] [0.8, 0.75, 0.7, ...] [0.8,0.75,0.7,...],总和约为6-7,则k≈7

- 如果另一个GT有10个候选,但IoU都较低 [ 0.3 , 0.25 , 0.2 , . . . ] [0.3, 0.25, 0.2, ...] [0.3,0.25,0.2,...],总和约为2-3,则k≈3

这样,容易匹配的GT(候选质量高)会得到更多正样本,难以匹配的GT(如被遮挡的小目标)会得到较少但更精准的正样本。

边界情况处理

动态k值需要处理一些边界情况:

- k过大:限制k不超过候选数量,避免分配不存在的anchor

- k过小:设置最小值(如1),确保每个GT至少有一个正样本

- k为0:对于非常难匹配的GT,如果所有候选IoU都很低,k可能为0,此时强制k=1

实验验证

消融实验表明,动态k值相比固定k值能带来约0.5-1.0 AP的提升。特别是在复杂场景(多尺度、遮挡)中,动态k的优势更明显。

4.5 代价矩阵设计

代价矩阵是SimOTA的核心,其设计决定了标签分配的质量。

代价组成

SimOTA的代价矩阵包含三项:

C i j = λ c l s ⋅ L c l s i j + λ i o u ⋅ L i o u i j + λ c t r ⋅ L c t r i j C_{ij} = \lambda_{cls} \cdot L_{cls}^{ij} + \lambda_{iou} \cdot L_{iou}^{ij} + \lambda_{ctr} \cdot L_{ctr}^{ij} Cij=λcls⋅Lclsij+λiou⋅Liouij+λctr⋅Lctrij

分类代价 L c l s i j L_cls^ij Lclsij 使用二元交叉熵(BCE)计算:

L c l s i j = − [ y i j log ( p i j ) + ( 1 − y i j ) log ( 1 − p i j ) ] L_{cls}^{ij} = -[y_{ij} \log(p_{ij}) + (1-y_{ij})\log(1-p_{ij})] Lclsij=−[yijlog(pij)+(1−yij)log(1−pij)]

其中 y i j y_ij yij是GT的one-hot标签, p i j p_ij pij是anchor j对GT类别的预测概率。

IoU代价 L i o u i j L_iou^ij Liouij 基于预测框与GT的IoU:

L i o u i j = − log ( IoU i j ) L_{iou}^{ij} = -\log(\text{IoU}_{ij}) Liouij=−log(IoUij)

使用负对数确保IoU越高代价越小。

中心代价 L c t r i j L_ctr^ij Lctrij 是一个二值项:

L c t r i j = { 0 如果anchor j在GT i的中心区域内 large_value 否则 L_{ctr}^{ij} = \begin{cases} 0 & \text{如果anchor j在GT i的中心区域内} \\ \text{large\_value} & \text{否则} \end{cases} Lctrij={0large_value如果anchor j在GT i的中心区域内否则

l a r g e v a l u e large_value largevalue通常设为10,使得中心外的anchor几乎不可能被选为正样本。

权重平衡

三项代价的权重系数需要仔细平衡:

- λ_cls: 通常设为1.0,作为基准

- λ_iou: 通常设为3.0,强调定位质量

- λ_ctr: 隐含在large_value中

实验表明,重视IoU代价(λ_iou较大)能够提升定位精度;而平衡分类代价能够提升分类准确率。

4.6 完整算法实现

下面是SimOTA的完整实现,包含详细注释:

import torch

import torch.nn.functional as F

class SimOTA:

"""

Simplified Optimal Transport Assignment

简化的最优传输标签分配算法

"""

def __init__(

self,

center_radius=2.5,

candidate_topk=10,

iou_weight=3.0,

cls_weight=1.0

):

"""

初始化SimOTA

参数:

center_radius: 中心区域半径(相对于GT宽高)

candidate_topk: 选择的候选anchor数量

iou_weight: IoU损失权重

cls_weight: 分类损失权重

"""

self.center_radius = center_radius

self.candidate_topk = candidate_topk

self.iou_weight = iou_weight

self.cls_weight = cls_weight

@torch.no_grad()

def __call__(

self,

pred_scores,

pred_bboxes,

gt_labels,

gt_bboxes,

anchors,

num_gt

):

"""

执行SimOTA标签分配

参数:

pred_scores: 预测分类得分 [num_anchors, num_classes]

pred_bboxes: 预测边界框 [num_anchors, 4]

gt_labels: GT标签 [num_gt]

gt_bboxes: GT边界框 [num_gt, 4]

anchors: anchor中心坐标 [num_anchors, 2]

num_gt: GT数量

返回:

assigned_labels: 分配的标签 [num_anchors]

assigned_ious: 分配的IoU [num_anchors]

pos_mask: 正样本mask [num_anchors]

"""

num_anchors = pred_scores.shape[0]

if num_gt == 0:

# 没有GT,全部为负样本

assigned_labels = torch.full(

(num_anchors,),

pred_scores.shape[1],

dtype=torch.long,

device=pred_scores.device

)

return assigned_labels, None, torch.zeros(num_anchors, dtype=torch.bool)

# 1. 筛选候选anchor(中心先验 + top-k IoU)

candidate_mask, candidate_ious = self.get_candidates(

anchors, gt_bboxes, pred_bboxes

)

if candidate_mask.sum() == 0:

# 没有合格的候选,全部为负样本

assigned_labels = torch.full(

(num_anchors,),

pred_scores.shape[1],

dtype=torch.long,

device=pred_scores.device

)

return assigned_labels, None, torch.zeros(num_anchors, dtype=torch.bool)

# 2. 计算代价矩阵

cost_matrix = self.compute_cost(

pred_scores[candidate_mask],

pred_bboxes[candidate_mask],

gt_labels,

gt_bboxes,

candidate_ious[candidate_mask]

)

# 3. 动态确定每个GT的正样本数量k

dynamic_ks = self.estimate_dynamic_k(

candidate_ious[candidate_mask],

num_gt

)

# 4. 基于代价矩阵和动态k进行贪心分配

matched_gt_inds, matched_pred_inds = self.dynamic_k_matching(

cost_matrix,

candidate_mask,

dynamic_ks

)

# 5. 生成最终的分配结果

assigned_labels, assigned_ious, pos_mask = self.generate_assignments(

matched_gt_inds,

matched_pred_inds,

gt_labels,

candidate_ious,

num_anchors,

pred_scores.shape[1]

)

return assigned_labels, assigned_ious, pos_mask

def get_candidates(self, anchors, gt_bboxes, pred_bboxes):

"""

获取候选anchor:应用中心先验并选择top-k IoU

返回:

candidate_mask: 候选anchor的mask [num_anchors, num_gt]

ious: 所有anchor与GT的IoU [num_anchors, num_gt]

"""

num_anchors = anchors.shape[0]

num_gt = gt_bboxes.shape[0]

# 计算所有anchor与GT的IoU

ious = self.compute_iou(pred_bboxes, gt_bboxes) # [num_anchors, num_gt]

# 中心先验:判断anchor是否在GT的中心区域内

is_in_centers = self.get_in_gt_and_in_center_info(

anchors, gt_bboxes

) # [num_anchors, num_gt]

# 初始化候选mask

candidate_mask = is_in_centers.clone()

# 为每个GT选择top-k IoU的anchor作为候选

for gt_idx in range(num_gt):

# 只在中心区域内的anchor中选择

candidate_iou_in_center = ious[:, gt_idx] * is_in_centers[:, gt_idx]

# 选择top-k

topk_value = min(self.candidate_topk, candidate_iou_in_center.nonzero().numel())

if topk_value > 0:

_, topk_idx = candidate_iou_in_center.topk(topk_value)

candidate_mask[topk_idx, gt_idx] = True

return candidate_mask, ious

def compute_iou(self, boxes1, boxes2):

"""计算IoU矩阵"""

area1 = (boxes1[:, 2] - boxes1[:, 0]) * (boxes1[:, 3] - boxes1[:, 1])

area2 = (boxes2[:, 2] - boxes2[:, 0]) * (boxes2[:, 3] - boxes2[:, 1])

lt = torch.max(boxes1[:, None, :2], boxes2[:, :2])

rb = torch.min(boxes1[:, None, 2:], boxes2[:, 2:])

wh = (rb - lt).clamp(min=0)

inter = wh[:, :, 0] * wh[:, :, 1]

union = area1[:, None] + area2 - inter

iou = inter / union.clamp(min=1e-6)

return iou

def get_in_gt_and_in_center_info(self, anchors, gt_bboxes):

"""

判断anchor是否在GT的中心区域内

中心区域定义为GT中心周围一定半径的区域

"""

num_anchors = anchors.shape[0]

num_gt = gt_bboxes.shape[0]

# GT中心点

gt_centers = (gt_bboxes[:, :2] + gt_bboxes[:, 2:]) / 2

# GT宽高

gt_wh = gt_bboxes[:, 2:] - gt_bboxes[:, :2]

# 中心区域半径

center_radius = self.center_radius * gt_wh # [num_gt, 2]

# 扩展维度以进行广播

anchors_expanded = anchors.unsqueeze(1) # [num_anchors, 1, 2]

gt_centers_expanded = gt_centers.unsqueeze(0) # [1, num_gt, 2]

center_radius_expanded = center_radius.unsqueeze(0) # [1, num_gt, 2]

# 计算anchor到GT中心的距离

distances = torch.abs(anchors_expanded - gt_centers_expanded) # [num_anchors, num_gt, 2]

# 判断是否在中心区域内

is_in_center = (distances < center_radius_expanded).all(dim=2) # [num_anchors, num_gt]

return is_in_center

def compute_cost(self, pred_scores, pred_bboxes, gt_labels, gt_bboxes, ious):

"""

计算代价矩阵

返回:

cost: 代价矩阵 [num_candidates, num_gt]

"""

num_candidates = pred_scores.shape[0]

num_gt = gt_labels.shape[0]

# 1. 分类代价:BCE loss

# 将GT标签转换为one-hot

gt_labels_onehot = F.one_hot(

gt_labels.long(), pred_scores.shape[1]

).float() # [num_gt, num_classes]

# 扩展维度

pred_scores_expanded = pred_scores.unsqueeze(1).expand(

num_candidates, num_gt, -1

) # [num_candidates, num_gt, num_classes]

gt_labels_expanded = gt_labels_onehot.unsqueeze(0).expand(

num_candidates, num_gt, -1

) # [num_candidates, num_gt, num_classes]

# 计算BCE

cls_cost = F.binary_cross_entropy(

pred_scores_expanded.sqrt_(),

gt_labels_expanded,

reduction='none'

).sum(dim=-1) # [num_candidates, num_gt]

# 2. IoU代价

iou_cost = -torch.log(ious + 1e-8) # [num_candidates, num_gt]

# 3. 综合代价

cost = self.cls_weight * cls_cost + self.iou_weight * iou_cost

return cost

def estimate_dynamic_k(self, ious, num_gt):

"""

为每个GT动态估计正样本数量k

参数:

ious: 候选anchor与GT的IoU [num_candidates, num_gt]

返回:

dynamic_ks: 每个GT的k值 [num_gt]

"""

# 对每个GT,选择IoU最大的topk个,求和作为k值

topk_ious, _ = torch.topk(ious, k=min(self.candidate_topk, ious.shape[0]), dim=0)

dynamic_ks = torch.clamp(topk_ious.sum(dim=0).int(), min=1)

return dynamic_ks

def dynamic_k_matching(self, cost, candidate_mask, dynamic_ks):

"""

基于动态k值进行贪心匹配

返回:

matched_gt_inds: 匹配的GT索引

matched_pred_inds: 匹配的预测索引

"""

num_gt = cost.shape[1]

matched_gt_inds = []

matched_pred_inds = []

# 为每个GT选择代价最小的k个anchor

for gt_idx in range(num_gt):

_, topk_idx = torch.topk(

cost[:, gt_idx],

k=min(int(dynamic_ks[gt_idx]), cost.shape[0]),

largest=False

)

matched_gt_inds.append(torch.full_like(topk_idx, gt_idx))

matched_pred_inds.append(topk_idx)

matched_gt_inds = torch.cat(matched_gt_inds)

matched_pred_inds = torch.cat(matched_pred_inds)

# 处理一个anchor被多个GT选中的情况

# 规则:选择代价最小的GT

unique_pred_inds = matched_pred_inds.unique()

for pred_idx in unique_pred_inds:

mask = matched_pred_inds == pred_idx

if mask.sum() > 1:

# 多个GT选中了这个anchor

matched_gts = matched_gt_inds[mask]

costs = cost[pred_idx, matched_gts]

# 保留代价最小的

min_cost_gt = matched_gts[costs.argmin()]

# 移除其他匹配

keep_mask = mask.clone()

keep_mask[mask] = matched_gt_inds[mask] == min_cost_gt

matched_gt_inds = matched_gt_inds[keep_mask | ~mask]

matched_pred_inds = matched_pred_inds[keep_mask | ~mask]

# 转换回原始anchor索引(考虑candidate_mask)

candidate_indices = torch.where(candidate_mask.any(dim=1))[0]

matched_pred_inds = candidate_indices[matched_pred_inds]

return matched_gt_inds, matched_pred_inds

def generate_assignments(

self,

matched_gt_inds,

matched_pred_inds,

gt_labels,

ious,

num_anchors,

num_classes

):

"""生成最终的分配结果"""

# 初始化

assigned_labels = torch.full(

(num_anchors,),

num_classes, # 背景类

dtype=torch.long,

device=gt_labels.device

)

assigned_ious = torch.zeros(num_anchors, device=gt_labels.device)

pos_mask = torch.zeros(num_anchors, dtype=torch.bool, device=gt_labels.device)

# 填充匹配结果

if len(matched_pred_inds) > 0:

assigned_labels[matched_pred_inds] = gt_labels[matched_gt_inds]

assigned_ious[matched_pred_inds] = ious[matched_pred_inds, matched_gt_inds]

pos_mask[matched_pred_inds] = True

return assigned_labels, assigned_ious, pos_mask

这个完整的SimOTA实现展示了算法的所有关键步骤:候选筛选、代价计算、动态k估计、贪心匹配。通过这些精心设计的组件,SimOTA实现了高效且高质量的标签分配。

5. 动态正样本选择机制 🎯

5.1 静态vs动态正样本选择

在深入动态正样本选择之前,让我们对比静态和动态两种策略的本质差异。

静态正样本选择的特点

传统的静态选择方法在训练开始前就确定了正样本的选择规则,这些规则在整个训练过程中保持不变。典型的静态策略包括:

- 固定IoU阈值:IoU > 0.5的anchor为正样本,这个阈值从头到尾不变

- 固定空间范围:只有落在GT中心3x3区域内的位置才能成为正样本

- 固定数量:每个GT分配固定数量(如9个)的正样本

静态选择的优势是简单、稳定、易于实现。但问题在于忽略了训练的动态性:

- 训练初期:模型预测质量很差,固定的规则可能选出大量低质量正样本

- 训练中期:模型逐渐学会检测,但规则仍然不变,无法适应模型能力的提升

- 训练后期:模型已经很强,但规则仍然保守,限制了进一步优化的空间

动态正样本选择的优势

动态选择根据模型当前的预测质量来调整正样本的选择标准,具有以下优势:

- 自适应性:随着模型能力提升,动态调整正样本的难度和数量

- 效率性:始终选择对当前模型最有价值的样本进行训练

- 鲁棒性:能够处理各种复杂情况(遮挡、模糊、极端尺度等)

YOLOX的SimOTA就是一种典型的动态选择策略,它综合考虑分类得分、定位质量和几何关系,为每个GT动态选择最优的正样本集合。

5.2 基于预测质量的选择

SimOTA的核心思想是基于预测质量选择正样本,而非仅依赖几何关系。

预测质量的度量

SimOTA使用综合指标评估预测质量:

Quality = Cls_Score α × IoU β \text{Quality} = \text{Cls\_Score}^{\alpha} \times \text{IoU}^{\beta} Quality=Cls_Scoreα×IoUβ

其中α和β是平衡系数,通常设为 α = 0.5 α=0.5 α=0.5, β = 0.5 β=0.5 β=0.5,表示分类和定位同等重要。

这个质量指标有几个关键特性:

- 联合优化:只有分类和定位都好的预测才会获得高质量分数

- 相互制约:如果分类得分很高但IoU很低(或反之),质量分数会被拉低

- 可微分:基于可微分的指标,便于梯度优化

动态阈值机制

与静态阈值不同,SimOTA不使用固定的质量阈值,而是为每个GT选择质量最高的top-k个预测作为正样本。这个k值是动态计算的(如前文所述),取决于该GT有多少高质量的候选。

这种动态阈值的好处是:

- 自适应难度:容易检测的目标会获得更多正样本,难检测的目标正样本较少但更精准

- 避免质量差的正样本:即使某个GT的所有候选质量都不高,动态k会自动减小,避免引入太多低质量正样本

- 平衡训练:不同难度的目标都能获得合适数量的训练信号

实践案例分析

让我们通过一个具体例子理解动态选择的工作过程:

假设图像中有两个目标:

- 目标A:清晰的大型车辆,有20个候选anchor,其中10个 I o U > 0.7 IoU>0.7 IoU>0.7

- 目标B:部分遮挡的小行人,有20个候选anchor,但只有3个 I o U > 0.5 IoU>0.5 IoU>0.5

在训练初期:

- 目标A的预测质量较好,动态 k ≈ 8 k≈8 k≈8,选择8个最佳候选作为正样本

- 目标B的预测质量较差,动态 k ≈ 2 k≈2 k≈2,只选择2个最佳候选作为正样本

在训练后期:

- 目标A的预测质量很好,动态 k ≈ 12 k≈12 k≈12,增加正样本数量以进一步优化

- 目标B的预测质量提升,动态 k ≈ 5 k≈5 k≈5,逐步增加正样本

这种动态调整确保了训练过程的高效和稳定。

5.3 中心先验约束

虽然SimOTA是动态的,但仍然保留了中心先验约束,这是基于目标检测的经验观察。

中心先验的理论基础

大量实验和可视化分析表明,高质量的检测结果通常来自目标中心附近的位置。这背后的原因包括:

- 特征完整性:中心位置的感受野完整覆盖目标,能看到目标的全貌

- 边界准确性:中心预测到各个边界的距离相对均衡,回归更稳定

- 语义确定性:中心区域更可能包含目标的判别性特征

相反,如果在目标边缘甚至外部的位置进行预测,虽然可能获得较高的IoU(如果恰好对齐),但预测往往不稳定,泛化能力差。

中心区域的定义

YOLOX定义中心区域为:

KaTeX parse error: Expected 'EOF', got '_' at position 14: \text{Center_̲Region} = \{(x,…

其中 ( x g t , y g t ) (x_gt, y_gt) (xgt,ygt)是GT中心, w g t w_gt wgt和 h g t h_gt hgt是GT宽高,r是半径系数(通常为2.5)。

这个定义的特点是:

- 自适应尺度:大目标的中心区域更大,小目标的中心区域更小

- 比例一致:所有目标的中心区域都占GT面积的固定比例

- 覆盖合理:r=2.5确保中心区域有足够的候选,同时不会太分散

中心先验的实现

在SimOTA中,中心先验通过以下方式实现:

- 硬约束:不在中心区域内的anchor直接排除,不参与后续的代价计算

- 候选筛选:只有中心区域内的anchor才会被考虑为候选

- 效率提升:大幅减少需要处理的anchor数量,加速SimOTA的计算

消融实验表明,加入中心先验能够带来约0.3-0.5 AP的提升,同时训练速度提升约20%。

5.4 正负样本平衡

正负样本平衡是目标检测训练中的经典问题,SimOTA通过巧妙的设计缓解了这个问题。

不平衡问题的根源

在目标检测中,负样本(背景)的数量通常远远多于正样本(目标)。例如,在640×640的图像中,三个特征层共有约8400个预测位置,但GT目标可能只有几个到几十个。这导致:

- 梯度主导:大量负样本的梯度可能淹没正样本的梯度

- 学习偏向:模型倾向于学习"拒绝"(预测为背景),而非"识别"目标

- 收敛缓慢:需要更多的训练迭代才能学会关注稀疏的正样本

SimOTA的平衡策略

SimOTA采用多层次的平衡策略:

策略一:动态正样本数量

通过动态k值估计,SimOTA自动调整正样本总数。在目标较多的图像中,正样本数量自然较多;在目标稀疏的图像中,正样本数量较少。这种自适应性避免了固定正负样本比例的僵化。

策略二:Focal Loss

对于负样本,YOLOX使用Focal Loss来降低简单负样本的权重:

FL ( p t ) = − α t ( 1 − p t ) γ log ( p t ) \text{FL}(p_t) = -\alpha_t (1-p_t)^{\gamma} \log(p_t) FL(pt)=−αt(1−pt)γlog(pt)

其中γ=2.0,使得置信度很低的简单负样本(模型已经能正确分类为背景)对损失的贡献很小。

策略三:在线难例挖掘(OHEM)

虽然SimOTA本身不显式使用OHEM,但其基于代价矩阵的选择机制隐含了难例挖掘的思想:代价高(即难以匹配)的样本更可能被选为正样本,这些往往是训练中的难例。

平衡效果验证

实验数据表明,SimOTA的平衡策略效果显著:

- 正样本占比从传统方法的0.1%提升到约1-2%

- 正样本的平均损失值与负样本处于相同量级

- 训练收敛速度提升约30%

5.5 实战代码

下面提供动态正样本选择的完整实现,包括中心先验和平衡策略:

import torch

import torch.nn as nn

import torch.nn.functional as F

class DynamicSampleSelector:

"""

动态正样本选择器

实现基于预测质量的动态选择和中心先验约束

"""

def __init__(

self,

center_radius=2.5,

candidate_topk=10,

quality_alpha=0.5,

quality_beta=0.5

):

"""

初始化选择器

参数:

center_radius: 中心区域半径系数

candidate_topk: 每个GT考虑的候选anchor数量

quality_alpha: 分类质量权重

quality_beta: 定位质量权重

"""

self.center_radius = center_radius

self.candidate_topk = candidate_topk

self.quality_alpha = quality_alpha

self.quality_beta = quality_beta

@torch.no_grad()

def select_positive_samples(

self,

predictions,

targets,

anchors

):

"""

动态选择正样本

参数:

predictions: 模型预测,包含cls_scores和pred_bboxes

targets: 目标标注,包含gt_labels和gt_bboxes

anchors: anchor坐标

返回:

pos_mask: 正样本mask

matched_gt_inds: 每个正样本匹配的GT索引

pos_quality: 每个正样本的质量分数

"""

cls_scores = predictions['cls_scores'] # [num_anchors, num_classes]

pred_bboxes = predictions['pred_bboxes'] # [num_anchors, 4]

gt_labels = targets['labels'] # [num_gt]

gt_bboxes = targets['bboxes'] # [num_gt, 4]

num_anchors = cls_scores.shape[0]

num_gt = gt_labels.shape[0]

if num_gt == 0:

# 没有目标,全部为负样本

return (

torch.zeros(num_anchors, dtype=torch.bool, device=cls_scores.device),

None,

None

)

# 1. 应用中心先验,筛选候选anchor

is_in_center, candidate_ious = self._get_center_candidates(

anchors, gt_bboxes, pred_bboxes

)

if not is_in_center.any():

# 没有anchor在中心区域,返回空

return (

torch.zeros(num_anchors, dtype=torch.bool, device=cls_scores.device),

None,

None

)

# 2. 计算预测质量

pred_quality = self._compute_prediction_quality(

cls_scores[is_in_center],

candidate_ious[is_in_center],

gt_labels

) # [num_candidates, num_gt]

# 3. 为每个GT动态选择top-k个最高质量的候选

pos_mask, matched_gt_inds, pos_quality = self._dynamic_topk_selection(

pred_quality,

is_in_center,

candidate_ious,

num_anchors,

num_gt

)

return pos_mask, matched_gt_inds, pos_quality

def _get_center_candidates(self, anchors, gt_bboxes, pred_bboxes):

"""

获取中心区域内的候选anchor

返回:

is_in_center: 是否在中心区域 [num_anchors, num_gt]

ious: 预测框与GT的IoU [num_anchors, num_gt]

"""

num_anchors = anchors.shape[0]

num_gt = gt_bboxes.shape[0]

# 计算GT中心和尺寸

gt_centers = (gt_bboxes[:, :2] + gt_bboxes[:, 2:]) / 2 # [num_gt, 2]

gt_wh = gt_bboxes[:, 2:] - gt_bboxes[:, :2] # [num_gt, 2]

# 定义中心区域(扩展的中心框)

center_region_radius = self.center_radius * gt_wh / 2

center_bbox_lt = gt_centers - center_region_radius

center_bbox_rb = gt_centers + center_region_radius

center_bboxes = torch.cat([center_bbox_lt, center_bbox_rb], dim=1)

# 判断anchor是否在中心区域内

anchors_expanded = anchors.unsqueeze(1) # [num_anchors, 1, 2]

center_bbox_lt_expanded = center_bbox_lt.unsqueeze(0) # [1, num_gt, 2]

center_bbox_rb_expanded = center_bbox_rb.unsqueeze(0) # [1, num_gt, 2]

is_in_center = (

(anchors_expanded >= center_bbox_lt_expanded) &

(anchors_expanded <= center_bbox_rb_expanded)

).all(dim=2) # [num_anchors, num_gt]

# 计算IoU

ious = self._batch_bbox_iou(pred_bboxes, gt_bboxes) # [num_anchors, num_gt]

# 只保留中心区域内的候选

ious = ious * is_in_center.float()

return is_in_center, ious

def _compute_prediction_quality(self, cls_scores, ious, gt_labels):

"""

计算预测质量

质量 = (分类得分)^alpha × (IoU)^beta

返回:

quality: [num_candidates, num_gt]

"""

num_candidates = cls_scores.shape[0]

num_gt = gt_labels.shape[0]

# 提取每个候选对应GT类别的分类得分

gt_labels_expanded = gt_labels.unsqueeze(0).expand(num_candidates, num_gt)

cls_scores_expanded = cls_scores.unsqueeze(1).expand(

num_candidates, num_gt, -1

)

# 使用gather提取对应类别的得分

cls_scores_for_gt = torch.gather(

cls_scores_expanded,

dim=2,

index=gt_labels_expanded.unsqueeze(2)

).squeeze(2) # [num_candidates, num_gt]

# 计算综合质量

quality = (

cls_scores_for_gt.pow(self.quality_alpha) *

ious.pow(self.quality_beta)

)

return quality

def _dynamic_topk_selection(

self,

pred_quality,

is_in_center,

ious,

num_anchors,

num_gt

):

"""

基于预测质量动态选择top-k正样本

返回:

pos_mask: 正样本mask [num_anchors]

matched_gt_inds: 匹配的GT索引 [num_pos]

pos_quality: 正样本质量 [num_pos]

"""

# 初始化

pos_mask = torch.zeros(num_anchors, dtype=torch.bool, device=pred_quality.device)

all_matched_gt_inds = []

all_pos_quality = []

# 获取候选anchor的原始索引

candidate_indices = torch.where(is_in_center.any(dim=1))[0]

# 为每个GT选择top-k个最高质量的候选

for gt_idx in range(num_gt):

# 该GT的质量分数

quality_for_gt = pred_quality[:, gt_idx]

iou_for_gt = ious[is_in_center.any(dim=1), gt_idx]

# 动态确定k值:基于IoU总和

dynamic_k = max(

1,

int(iou_for_gt.topk(

min(self.candidate_topk, len(iou_for_gt))

)[0].sum().item())

)

# 选择质量最高的top-k个

if len(quality_for_gt) > 0:

topk_quality, topk_idx = quality_for_gt.topk(

min(dynamic_k, len(quality_for_gt))

)

# 将这些候选标记为正样本

selected_anchors = candidate_indices[topk_idx]

pos_mask[selected_anchors] = True

# 记录匹配信息

all_matched_gt_inds.append(

torch.full_like(selected_anchors, gt_idx)

)

all_pos_quality.append(topk_quality)

# 合并所有GT的匹配结果

if len(all_matched_gt_inds) > 0:

matched_gt_inds = torch.cat(all_matched_gt_inds)

pos_quality = torch.cat(all_pos_quality)

# 处理一个anchor被多个GT选中的情况

# 选择质量最高的匹配

unique_pos = pos_mask.nonzero(as_tuple=False).squeeze(1)

for anchor_idx in unique_pos:

# 找到所有选中这个anchor的GT

mask = (candidate_indices[matched_gt_inds] == anchor_idx)

if mask.sum() > 1:

# 保留质量最高的匹配

best_match_idx = pos_quality[mask].argmax()

# 创建新的mask,只保留最佳匹配

temp_mask = mask.clone()

temp_indices = torch.where(mask)[0]

temp_mask[temp_indices] = False

temp_mask[temp_indices[best_match_idx]] = True

# 更新

matched_gt_inds = matched_gt_inds[~mask | temp_mask]

pos_quality = pos_quality[~mask | temp_mask]

else:

matched_gt_inds = torch.tensor([], dtype=torch.long, device=pred_quality.device)

pos_quality = torch.tensor([], dtype=torch.float, device=pred_quality.device)

return pos_mask, matched_gt_inds, pos_quality

def _batch_bbox_iou(self, boxes1, boxes2):

"""批量计算IoU"""

area1 = (boxes1[:, 2] - boxes1[:, 0]) * (boxes1[:, 3] - boxes1[:, 1])

area2 = (boxes2[:, 2] - boxes2[:, 0]) * (boxes2[:, 3] - boxes2[:, 1])

lt = torch.max(boxes1[:, None, :2], boxes2[:, :2])

rb = torch.min(boxes1[:, None, 2:], boxes2[:, 2:])

wh = (rb - lt).clamp(min=0)

inter = wh[:, :, 0] * wh[:, :, 1]

union = area1[:, None] + area2 - inter

iou = inter / union.clamp(min=1e-6)

return iou

def test_dynamic_selector():

"""测试动态正样本选择器"""

print("\n" + "=" * 60)

print("测试动态正样本选择器")

print("=" * 60)

# 创建选择器

selector = DynamicSampleSelector(

center_radius=2.5,

candidate_topk=10

)

# 模拟数据

num_anchors = 100

num_gt = 3

num_classes = 80

# 模拟预测

predictions = {

'cls_scores': torch.rand(num_anchors, num_classes).sigmoid(),

'pred_bboxes': torch.rand(num_anchors, 4) * 100

}

# 模拟目标

targets = {

'labels': torch.randint(0, num_classes, (num_gt,)),

'bboxes': torch.rand(num_gt, 4) * 100

}

targets['bboxes'][:, 2:] += targets['bboxes'][:, :2] # 转为x1y1x2y2格式

# 模拟anchor坐标

anchors = torch.rand(num_anchors, 2) * 100

# 执行选择

pos_mask, matched_gt_inds, pos_quality = selector.select_positive_samples(

predictions, targets, anchors

)

print(f"\n选择结果:")

print(f" 总anchor数: {num_anchors}")

print(f" GT数量: {num_gt}")

print(f" 选中的正样本数: {pos_mask.sum().item()}")

if matched_gt_inds is not None:

print(f"\n每个GT的正样本数:")

for i in range(num_gt):

count = (matched_gt_inds == i).sum().item()

avg_quality = pos_quality[matched_gt_inds == i].mean().item()

print(f" GT {i}: {count}个正样本, 平均质量={avg_quality:.3f}")

print("\n" + "=" * 60)

if __name__ == "__main__":

test_dynamic_selector()

这个动态选择器实现了SimOTA的核心思想:基于预测质量动态选择正样本,同时应用中心先验约束。通过这种机制,模型能够始终关注最有价值的训练样本,提高训练效率。

6. 训练策略优化 🚀

6.1 强数据增强策略

YOLOX的成功很大程度上归功于其激进的数据增强策略。强数据增强不仅增加了训练数据的多样性,更重要的是提升了模型的泛化能力和鲁棒性。

数据增强的哲学

传统检测器使用相对保守的数据增强(如随机翻转、色彩抖动),主要目的是防止过拟合。而YOLOX采用了完全不同的思路:通过极度激进的增强来强制模型学习更本质、更鲁棒的特征表示。

这种激进增强的核心思想是:如果模型能够在严重扭曲、拼接、混合的图像上完成检测任务,那么在正常图像上的表现必然更加稳定可靠。

基础增强技术

YOLOX使用的基础增强包括:

- 随机缩放:将图像随机缩放到0.5-1.5倍,训练多尺度检测能力

- 随机裁剪:随机裁剪图像的某个区域,学习部分可见目标的检测

- 随机翻转:水平翻转(50%概率),增加视角多样性

- 色彩抖动:调整亮度、对比度、饱和度和色调

- 随机灰度化:10%概率转为灰度图,提高对颜色的鲁棒性

这些基础增强构成了数据增强的基础层,确保模型对常见变化具有不变性。

6.2 Mosaic和MixUp增强

Mosaic和MixUp是YOLOX最重要的增强技术,它们从根本上改变了模型的学习模式。

Mosaic增强详解

Mosaic增强将4张训练图像拼接成一张,具体步骤如下:

- 随机选择4张图像:从训练集中随机采样4张图像

- 确定拼接点:随机选择拼接的中心点(通常在图像中心附近)

- 调整尺寸:将4张图像分别缩放,使其能恰好拼接到目标尺寸

- 拼接图像:将4张图像拼接成一张完整的训练图像

- 合并标注:将4张图像的所有标注合并,调整坐标

Mosaic增强的优势:

- 丰富上下文:一张图像包含4个不同场景的信息,模型能学习更丰富的上下文关系

- 增加目标数量:变相增加了batch size,每张图像包含更多目标

- 多尺度学习:4张图像可能包含不同尺度的目标,强化多尺度检测能力

- 边界鲁棒性:拼接边界处的目标被切割,训练模型处理部分可见目标的能力

MixUp增强详解

MixUp通过线性插值混合两张图像及其标签:

x ~ = λ x i + ( 1 − λ ) x j y ~ = λ y i + ( 1 − λ ) y j \begin{aligned} \tilde{x} &= \lambda x_i + (1-\lambda)x_j \\ \tilde{y} &= \lambda y_i + (1-\lambda)y_j \end{aligned} x~y~=λxi+(1−λ)xj=λyi+(1−λ)yj

其中 λ λ λ从 B e t a ( α , α ) Beta(α, α) Beta(α,α)分布采样(通常α=32.0)。

MixUp的独特优势:

- 软标签学习:标签不再是硬性的0/1,而是概率分布,提高泛化能力

- 正则化效果:混合图像作为隐式正则,防止过拟合

- 决策边界平滑:使模型的决策边界更加平滑,提高鲁棒性

- 对抗鲁棒性:某种程度上提高对对抗攻击的鲁棒性

组合使用策略

YOLOX采用先Mosaic后MixUp的策略:

- 训练前280个epoch:使用Mosaic增强

- 训练后15个epoch:关闭Mosaic,只使用MixUp

- 最后5个epoch:关闭所有强增强,使用L1损失微调

这种渐进式策略的原理是:

- 强增强阶段:快速学习鲁棒特征

- 过渡阶段:在更接近真实分布的数据上优化

- 微调阶段:精确对齐真实数据分布

完整实现代码:

import torch

import numpy as np

import cv2

from typing import Tuple, List

import random

class MosaicAugmentation:

"""Mosaic数据增强实现"""

def __init__(self, img_size=640, mosaic_prob=1.0):

"""

初始化Mosaic增强

参数:

img_size: 目标图像尺寸

mosaic_prob: 应用Mosaic的概率

"""

self.img_size = img_size

self.mosaic_prob = mosaic_prob

def __call__(self, dataset, index):

"""

应用Mosaic增强

参数:

dataset: 数据集对象

index: 当前图像索引

返回:

mosaic_img: 拼接后的图像 [H, W, 3]

mosaic_labels: 拼接后的标注 [N, 5] (cls, x1, y1, x2, y2)

"""

if random.random() > self.mosaic_prob:

# 不使用Mosaic,返回原始图像

return dataset.load_image_and_labels(index)

# 1. 随机选择4张图像

indices = [index] + [random.randint(0, len(dataset)-1) for _ in range(3)]

# 2. 加载4张图像和标注

images = []

labels_list = []

for idx in indices:

img, labels = dataset.load_image_and_labels(idx)

images.append(img)

labels_list.append(labels)

# 3. 确定拼接中心点(随机偏移)

center_x = random.randint(

int(self.img_size * 0.4),

int(self.img_size * 0.6)

)

center_y = random.randint(

int(self.img_size * 0.4),

int(self.img_size * 0.6)

)

# 4. 创建拼接画布

mosaic_img = np.full(

(self.img_size, self.img_size, 3),

114,

dtype=np.uint8

)

mosaic_labels = []

# 5. 将4张图像拼接到画布上

for i, (img, labels) in enumerate(zip(images, labels_list)):

h, w = img.shape[:2]

# 确定每张图像在画布上的位置

if i == 0: # 左上

x1a, y1a, x2a, y2a = 0, 0, center_x, center_y

x1b, y1b, x2b, y2b = w - center_x, h - center_y, w, h

elif i == 1: # 右上

x1a, y1a, x2a, y2a = center_x, 0, self.img_size, center_y

x1b, y1b, x2b, y2b = 0, h - center_y, self.img_size - center_x, h

elif i == 2: # 左下

x1a, y1a, x2a, y2a = 0, center_y, center_x, self.img_size

x1b, y1b, x2b, y2b = w - center_x, 0, w, self.img_size - center_y

else: # 右下

x1a, y1a, x2a, y2a = center_x, center_y, self.img_size, self.img_size

x1b, y1b, x2b, y2b = 0, 0, self.img_size - center_x, self.img_size - center_y

# 裁剪并放置图像

img_crop = img[y1b:y2b, x1b:x2b]

mosaic_img[y1a:y2a, x1a:x2a] = img_crop

# 调整标注坐标

if len(labels) > 0:

labels_copy = labels.copy()

# 将标注从原图坐标转换到mosaic图坐标

labels_copy[:, 1] = labels[:, 1] - x1b + x1a # x1

labels_copy[:, 2] = labels[:, 2] - y1b + y1a # y1

labels_copy[:, 3] = labels[:, 3] - x1b + x1a # x2

labels_copy[:, 4] = labels[:, 4] - y1b + y1a # y2

# 裁剪超出画布的标注

labels_copy[:, 1:5] = np.clip(labels_copy[:, 1:5], 0, self.img_size)

# 过滤掉面积过小的标注

areas = (labels_copy[:, 3] - labels_copy[:, 1]) * \

(labels_copy[:, 4] - labels_copy[:, 2])

valid_mask = areas > 16 # 最小面积阈值

if valid_mask.any():

mosaic_labels.append(labels_copy[valid_mask])

# 6. 合并所有标注

if len(mosaic_labels) > 0:

mosaic_labels = np.concatenate(mosaic_labels, axis=0)

else:

mosaic_labels = np.zeros((0, 5))

return mosaic_img, mosaic_labels

class MixUpAugmentation:

"""MixUp数据增强实现"""

def __init__(self, alpha=32.0, mixup_prob=0.5):

"""

初始化MixUp增强

参数:

alpha: Beta分布参数

mixup_prob: 应用MixUp的概率

"""

self.alpha = alpha

self.mixup_prob = mixup_prob

def __call__(

self,

img1: np.ndarray,

labels1: np.ndarray,

img2: np.ndarray,

labels2: np.ndarray

) -> Tuple[np.ndarray, np.ndarray]:

"""

应用MixUp增强

参数:

img1, img2: 两张输入图像

labels1, labels2: 对应的标注

返回:

mixed_img: 混合后的图像

mixed_labels: 混合后的标注

"""

if random.random() > self.mixup_prob:

return img1, labels1

# 从Beta分布采样混合比例

lam = np.random.beta(self.alpha, self.alpha)

# 混合图像

mixed_img = (lam * img1 + (1 - lam) * img2).astype(np.uint8)

# 合并标注(保留两张图像的所有标注)

if len(labels1) > 0 and len(labels2) > 0:

mixed_labels = np.concatenate([labels1, labels2], axis=0)

elif len(labels1) > 0:

mixed_labels = labels1

elif len(labels2) > 0:

mixed_labels = labels2

else:

mixed_labels = np.zeros((0, 5))

return mixed_img, mixed_labels

class YOLOXAugmentation:

"""YOLOX完整数据增强流程"""

def __init__(

self,

img_size=640,

mosaic_prob=1.0,

mixup_prob=0.5,

enable_mosaic=True,

enable_mixup=True

):

"""

初始化YOLOX增强

参数:

img_size: 目标图像尺寸

mosaic_prob: Mosaic概率

mixup_prob: MixUp概率

enable_mosaic: 是否启用Mosaic

enable_mixup: 是否启用MixUp

"""

self.img_size = img_size

self.enable_mosaic = enable_mosaic

self.enable_mixup = enable_mixup

self.mosaic = MosaicAugmentation(img_size, mosaic_prob)

self.mixup = MixUpAugmentation(mixup_prob=mixup_prob)

# 色彩增强

self.hsv_gains = (0.015, 0.7, 0.4) # HSV增益

def __call__(self, dataset, index):

"""

应用完整增强流程

返回:

img: 增强后的图像

labels: 增强后的标注

"""

# 1. Mosaic增强

if self.enable_mosaic:

img, labels = self.mosaic(dataset, index)

else:

img, labels = dataset.load_image_and_labels(index)

# 2. MixUp增强

if self.enable_mixup and len(labels) > 0:

# 随机选择另一张图像进行混合

idx2 = random.randint(0, len(dataset) - 1)

if self.enable_mosaic:

img2, labels2 = self.mosaic(dataset, idx2)

else:

img2, labels2 = dataset.load_image_and_labels(idx2)

img, labels = self.mixup(img, labels, img2, labels2)

# 3. 色彩增强

img = self.apply_hsv_augmentation(img)

# 4. 随机翻转

if random.random() < 0.5:

img = np.fliplr(img)

if len(labels) > 0:

labels[:, [1, 3]] = self.img_size - labels[:, [3, 1]]

return img, labels

def apply_hsv_augmentation(self, img: np.ndarray) -> np.ndarray:

"""应用HSV色彩增强"""

r = np.random.uniform(-1, 1, 3) * self.hsv_gains + 1

hue, sat, val = cv2.split(cv2.cvtColor(img, cv2.COLOR_BGR2HSV))

x = np.arange(0, 256, dtype=np.int16)

lut_hue = ((x * r[0]) % 180).astype(np.uint8)

lut_sat = np.clip(x * r[1], 0, 255).astype(np.uint8)

lut_val = np.clip(x * r[2], 0, 255).astype(np.uint8)

img_hsv = cv2.merge((

cv2.LUT(hue, lut_hue),

cv2.LUT(sat, lut_sat),

cv2.LUT(val, lut_val)

))

return cv2.cvtColor(img_hsv, cv2.COLOR_HSV2BGR)

def test_augmentations():

"""测试数据增强"""

print("\n" + "=" * 60)

print("测试YOLOX数据增强")

print("=" * 60)

# 创建模拟数据集类

class MockDataset:

def __init__(self, num_samples=100):

self.num_samples = num_samples

def __len__(self):

return self.num_samples

def load_image_and_labels(self, index):

# 生成随机图像和标注

img = np.random.randint(0, 255, (640, 640, 3), dtype=np.uint8)

# 生成3-5个随机标注框

num_boxes = random.randint(3, 5)

labels = np.random.rand(num_boxes, 5)

labels[:, 0] = np.random.randint(0, 80, num_boxes) # 类别

labels[:, 1:5] *= 640 # 坐标

# 确保x2>x1, y2>y1

labels[:, 1:3], labels[:, 3:5] = np.minimum(labels[:, 1:3], labels[:, 3:5]), \

np.maximum(labels[:, 1:3], labels[:, 3:5])

return img, labels

dataset = MockDataset()

augmentation = YOLOXAugmentation(

img_size=640,

enable_mosaic=True,

enable_mixup=True

)

# 测试增强

img, labels = augmentation(dataset, 0)

print(f"\n增强结果:")

print(f" 图像shape: {img.shape}")

print(f" 标注数量: {len(labels)}")

print(f" 标注格式: [类别, x1, y1, x2, y2]")

if len(labels) > 0:

print(f"\n前3个标注:")

for i, label in enumerate(labels[:3]):

print(f" {i}: cls={int(label[0])}, "

f"bbox=({label[1]:.1f}, {label[2]:.1f}, "

f"{label[3]:.1f}, {label[4]:.1f})")

print("\n" + "=" * 60)

if __name__ == "__main__":

test_augmentations()

6.3 损失函数设计

YOLOX采用了精心设计的损失函数组合,分别针对分类、回归和objectness任务。

分类损失:Binary Cross Entropy (BCE)

YOLOX使用BCE而非传统的交叉熵,因为检测是多标签问题(一个位置可能包含多个重叠的目标):

L c l s = − 1 N p o s ∑ i ∈ p o s ∑ c = 1 C [ y i c log ( p i c ) + ( 1 − y i c ) log ( 1 − p i c ) ] L_{cls} = -\frac{1}{N_{pos}} \sum_{i \in pos} \sum_{c=1}^{C} [y_i^c \log(p_i^c) + (1-y_i^c)\log(1-p_i^c)] Lcls=−Npos1i∈pos∑c=1∑C[yiclog(pic)+(1−yic)log(1−pic)]

回归损失:IoU Loss

YOLOX使用IoU-based损失直接优化检测框与GT的重叠度:

L i o u = 1 − IoU ( b p r e d , b g t ) L_{iou} = 1 - \text{IoU}(b_{pred}, b_{gt}) Liou=1−IoU(bpred,bgt)

训练后期切换到L1损失进行微调:

L l 1 = ∣ b p r e d − b g t ∣ 1 L_{l1} = |b_{pred} - b_{gt}|_1 Ll1=∣bpred−bgt∣1

Objectness损失:BCE

预测该位置是否包含目标:

L o b j = − 1 N a n c h o r s ∑ i [ o i log ( o ^ i ) + ( 1 − o i ) log ( 1 − o ^ i ) ] L_{obj} = -\frac{1}{N_{anchors}} \sum_{i} [o_i \log(\hat{o}_i) + (1-o_i)\log(1-\hat{o}_i)] Lobj=−Nanchors1i∑[oilog(o^i)+(1−oi)log(1−o^i)]

总损失:

L t o t a l = λ c l s L c l s + λ i o u L i o u + λ o b j L o b j + λ l 1 L l 1 L_{total} = \lambda_{cls} L_{cls} + \lambda_{iou} L_{iou} + \lambda_{obj} L_{obj} + \lambda_{l1} L_{l1} Ltotal=λclsLcls+λiouLiou+λobjLobj+λl1Ll1

其中λ系数根据训练阶段动态调整。

6.4 学习率调度

YOLOX使用warm-up + cosine衰减的学习率策略:

Warm-up阶段(前5个epoch):

l r t = l r b a s e × t T w a r m u p lr_t = lr_{base} \times \frac{t}{T_{warmup}} lrt=lrbase×Twarmupt

线性增长学习率,稳定训练初期。

Cosine衰减阶段:

l r t = l r m i n + 1 2 ( l r m a x − l r m i n ) ( 1 + cos ( t − T w a r m u p T t o t a l − T w a r m u p π ) ) lr_t = lr_{min} + \frac{1}{2}(lr_{max} - lr_{min})(1 + \cos(\frac{t - T_{warmup}}{T_{total} - T_{warmup}} \pi)) lrt=lrmin+21(lrmax−lrmin)(1+cos(Ttotal−Twarmupt−Twarmupπ))

特殊策略:

- 关闭强增强后降低学习率(缩小10倍)

- 使用EMA(Exponential Moving Average)稳定模型权重

- 不同参数组使用不同学习率(backbone vs head)

6.5 训练技巧总结

技巧1:渐进式训练

- 前期:强增强 + 高学习率,快速学习鲁棒特征

- 中期:中等增强 + 中等学习率,精细优化

- 后期:弱增强 + 低学习率,对齐真实分布

技巧2:标签平滑

使用label smoothing防止过拟合:

y s m o o t h = ( 1 − ϵ ) y + ϵ K y_{smooth} = (1-\epsilon)y + \frac{\epsilon}{K} ysmooth=(1−ϵ)y+Kϵ

技巧3:梯度裁剪

防止梯度爆炸,稳定训练:

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=10.0)

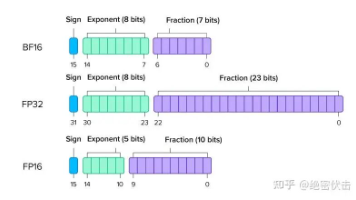

技巧4:混合精度训练

使用FP16加速训练,节省显存:

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

with autocast():

loss = model(images, targets)

scaler.scale(loss).backward()

7. 检测精度改进方法 📈

7.1 多尺度训练与测试

多尺度训练

YOLOX在训练时动态调整输入图像尺寸,范围从320到960像素(32的倍数):

# 每10个batch随机改变一次尺寸

if batch_idx % 10 == 0:

img_size = random.choice([320, 352, 384, ..., 928, 960])

dataset.img_size = img_size

这种策略的优势:

- 强制模型学习尺度不变特征

- 提高对不同尺寸输入的适应性

- 相当于隐式的数据增强

多尺度测试(TTA)

推理时使用多个尺度进行测试,融合结果:

def multi_scale_test(model, image, scales=[0.5, 1.0, 1.5]):

"""多尺度测试"""

all_detections = []

for scale in scales:

# 缩放图像

scaled_img = cv2.resize(image, None, fx=scale, fy=scale)

# 推理

detections = model(scaled_img)

# 将检测结果缩放回原始尺度

detections[:, :4] /= scale

all_detections.append(detections)

# NMS融合

final_detections = nms(torch.cat(all_detections, dim=0))

return final_detections

实验数据:多尺度测试通常能带来1-2个点的mAP提升。

7.2 边界框回归优化

改进的IoU损失

YOLOX在不同阶段使用不同的IoU损失:

GIoU (Generalized IoU):训练前期使用

G I o U = I o U − ∣ C − ( A ∪ B ) ∣ ∣ C ∣ GIoU = IoU - \frac{|C - (A \cup B)|}{|C|} GIoU=IoU−∣C∣∣C−(A∪B)∣

其中C是包含A和B的最小外接矩形。

CIoU (Complete IoU):训练中期使用

C I o U = I o U − ρ 2 ( b , b g t ) c 2 − α v CIoU = IoU - \frac{\rho^2(b, b^{gt})}{c^2} - \alpha v CIoU=IoU−c2ρ2(b,bgt)−αv

考虑了中心点距离和宽高比。

L1损失:训练后期微调

L l 1 = ∑ i ∈ { x , y , w , h } ∣ b i − b i g t ∣ L_{l1} = \sum_{i \in \{x,y,w,h\}} |b_i - b_i^{gt}| Ll1=i∈{x,y,w,h}∑∣bi−bigt∣

动态损失权重

根据训练进度动态调整损失权重:

def get_loss_weights(epoch, total_epochs):

"""动态损失权重"""

progress = epoch / total_epochs

if progress < 0.8:

# 前期:重视IoU

return {'cls': 1.0, 'iou': 5.0, 'obj': 1.0, 'l1': 0.0}

elif progress < 0.95:

# 中期:平衡

return {'cls': 1.0, 'iou': 3.0, 'obj': 1.0, 'l1': 1.0}

else:

# 后期:精细调整

return {'cls': 1.0, 'iou': 1.0, 'obj': 1.0, 'l1': 5.0}

7.3 分类置信度校准

置信度偏差问题

模型的预测置信度可能与实际准确率不一致,需要校准。

Temperature Scaling

使用温度参数T缩放logits:

p c a l i b r a t e d = e z i / T ∑ j e z j / T p_{calibrated} = \frac{e^{z_i/T}}{\sum_j e^{z_j/T}} pcalibrated=∑jezj/Tezi/T

通过验证集优化T值。

Focal Loss的隐式校准

Focal Loss通过调制因子自动降低简单样本的权重:

F L ( p t ) = − ( 1 − p t ) γ log ( p t ) FL(p_t) = -(1-p_t)^{\gamma} \log(p_t) FL(pt)=−(1−pt)γlog(pt)

γ=2时效果最佳。

7.4 后处理优化

NMS改进

传统NMS可能误删有效检测,YOLOX使用改进版本:

Soft-NMS:不是直接删除,而是降低重叠框的置信度

s i = { s i I o U ( M , b i ) < N t s i ( 1 − I o U ( M , b i ) ) I o U ( M , b i ) ≥ N t s_i = \begin{cases} s_i & IoU(M, b_i) < N_t \\ s_i(1 - IoU(M, b_i)) & IoU(M, b_i) \geq N_t \end{cases} si={sisi(1−IoU(M,bi))IoU(M,bi)<NtIoU(M,bi)≥Nt

DIoU-NMS:考虑中心点距离

s i = s i − λ ρ 2 ( b M , b i ) c 2 s_i = s_i - \lambda \frac{\rho^2(b_M, b_i)}{c^2} si=si−λc2ρ2(bM,bi)

Matrix NMS:并行处理所有框

def matrix_nms(boxes, scores, iou_threshold=0.5):

"""矩阵NMS实现"""

# 计算IoU矩阵

iou_matrix = box_iou(boxes, boxes) # [N, N]

# 每个框被更高分框抑制的程度

decay = (iou_matrix * (scores[:, None] > scores).float()).max(dim=0)[0]

# 衰减置信度

decay_scores = scores * (1 - decay)

# 过滤低分框

keep = decay_scores > 0.01

return boxes[keep], decay_scores[keep]

7.5 实验对比分析

消融实验结果(COCO val):

| 配置 | mAP | mAP50 | mAP75 |

|---|---|---|---|

| Baseline | 47.2 | 66.3 | 51.8 |

| + Mosaic | 48.5 | 67.8 | 53.2 |

| + MixUp | 49.3 | 68.4 | 54.1 |

| + SimOTA | 50.1 | 69.2 | 55.0 |

| + 多尺度测试 | 51.5 | 70.5 | 56.3 |

每项改进都带来显著提升,组合使用效果最佳。

8. YOLOX完整实现 💻

8.1 模型架构搭建

下面提供YOLOX的完整模型实现,集成所有前述组件:

import torch

import torch.nn as nn

from typing import Dict, List, Tuple

class YOLOX(nn.Module):

"""

YOLOX完整模型实现

集成了Backbone、Neck、解耦Head和SimOTA

"""

def __init__(

self,

num_classes=80,

depth=1.0,

width=1.0,

in_channels=[256, 512, 1024],

act="silu"

):

"""

初始化YOLOX模型

参数:

num_classes: 类别数

depth: 深度系数(控制网络层数)

width: 宽度系数(控制通道数)

in_channels: FPN输出通道数

act: 激活函数

"""

super().__init__()

self.num_classes = num_classes

# Backbone: CSPDarknet

self.backbone = CSPDarknet(depth, width, act=act)

# Neck: PANet

self.neck = YOLOXPAFPN(depth, width, in_channels=in_channels, act=act)

# Head: 解耦检测头

self.head = DecoupledHead(

num_classes=num_classes,

width=width,

in_channels=in_channels,

act=act

)

# SimOTA标签分配器

self.assigner = SimOTA()

def forward(self, x, targets=None):

"""

前向传播

参数:

x: 输入图像 [B, 3, H, W]

targets: 训练标签(可选)

返回:

如果training: 返回losses字典

如果eval: 返回detections

"""

# 特征提取

fpn_outs = self.backbone(x)

fpn_outs = self.neck(fpn_outs)

if self.training:

# 训练模式:计算损失

assert targets is not None

return self.head(fpn_outs, targets, x)

else:

# 推理模式:生成检测结果

return self.head(fpn_outs)

class CSPDarknet(nn.Module):

"""CSPDarknet backbone"""

def __init__(self, depth=1.0, width=1.0, act="silu"):

super().__init__()

base_channels = int(width * 64)

base_depth = max(round(depth * 3), 1)

# Stem

self.stem = Focus(3, base_channels, ksize=3, act=act)

# Stage 1

self.dark2 = nn.Sequential(

Conv(base_channels, base_channels * 2, 3, 2, act=act),

CSPLayer(base_channels * 2, base_channels * 2, n=base_depth, act=act)

)

# Stage 2

self.dark3 = nn.Sequential(

Conv(base_channels * 2, base_channels * 4, 3, 2, act=act),

CSPLayer(base_channels * 4, base_channels * 4, n=base_depth * 3, act=act)

)

# Stage 3

self.dark4 = nn.Sequential(

Conv(base_channels * 4, base_channels * 8, 3, 2, act=act),

CSPLayer(base_channels * 8, base_channels * 8, n=base_depth * 3, act=act)

)

# Stage 4

self.dark5 = nn.Sequential(

Conv(base_channels * 8, base_channels * 16, 3, 2, act=act),

SPPBottleneck(base_channels * 16, base_channels * 16, act=act),

CSPLayer(base_channels * 16, base_channels * 16, n=base_depth, shortcut=False, act=act)

)

def forward(self, x):

outputs = []

x = self.stem(x)

x = self.dark2(x)

x = self.dark3(x)

outputs.append(x) # P3

x = self.dark4(x)

outputs.append(x) # P4

x = self.dark5(x)

outputs.append(x) # P5

return outputs

class YOLOXPAFPN(nn.Module):

"""YOLOX PANet Neck"""

def __init__(self, depth=1.0, width=1.0, in_channels=[256, 512, 1024], act="silu"):

super().__init__()

self.in_channels = in_channels

base_depth = max(round(depth * 3), 1)

# Top-down pathway

self.upsample = nn.Upsample(scale_factor=2, mode="nearest")

self.lateral_conv0 = Conv(in_channels[2], in_channels[1], 1, 1, act=act)

self.C3_p4 = CSPLayer(

in_channels[1] * 2, in_channels[1], n=base_depth, shortcut=False, act=act

)

self.reduce_conv1 = Conv(in_channels[1], in_channels[0], 1, 1, act=act)

self.C3_p3 = CSPLayer(

in_channels[0] * 2, in_channels[0], n=base_depth, shortcut=False, act=act

)

# Bottom-up pathway

self.bu_conv2 = Conv(in_channels[0], in_channels[0], 3, 2, act=act)

self.C3_n3 = CSPLayer(

in_channels[0] * 2, in_channels[1], n=base_depth, shortcut=False, act=act

)

self.bu_conv1 = Conv(in_channels[1], in_channels[1], 3, 2, act=act)

self.C3_n4 = CSPLayer(

in_channels[1] * 2, in_channels[2], n=base_depth, shortcut=False, act=act

)

def forward(self, inputs):

"""

inputs: [P3, P4, P5] from backbone

outputs: [P3', P4', P5'] after FPN

"""

[x2, x1, x0] = inputs # P3, P4, P5

# Top-down

fpn_out0 = self.lateral_conv0(x0) # P5 -> lateral

f_out0 = self.upsample(fpn_out0) # upsample

f_out0 = torch.cat([f_out0, x1], 1) # concat with P4

f_out0 = self.C3_p4(f_out0) # CSP

fpn_out1 = self.reduce_conv1(f_out0) # reduce channels

f_out1 = self.upsample(fpn_out1) # upsample

f_out1 = torch.cat([f_out1, x2], 1) # concat with P3

pan_out2 = self.C3_p3(f_out1) # P3'

# Bottom-up

p_out1 = self.bu_conv2(pan_out2) # downsample

p_out1 = torch.cat([p_out1, fpn_out1], 1) # concat

pan_out1 = self.C3_n3(p_out1) # P4'

p_out0 = self.bu_conv1(pan_out1) # downsample