从模型到系统:大模型工程师面试的硬核技能全景图

【摘要】大模型岗位正在重塑技术面试规则,要求候选人具备算法原理、工程实践和系统部署的综合能力。在算法层面,需深入理解Transformer机制、推理优化及训练范式选择;工程实践需掌握RAG架构设计、Agent开发及评估体系构建;系统部署则关注推理加速、弹性扩缩容等规模化挑战。优秀候选人应能结合定量分析和架构思维,展示从模型优化到生产落地的全链路能力,体现AI能力×工程能力×交付能力的复合价值。面试

目录

一、为什么大模型岗位正在重塑技术面试规则?

过去十年,面试考点核心在数据库、操作系统、分布式、算法题——而现在,越来越多企业发现,仅会写代码,不足以驾驭智能系统。

模型上线要算 Token、要控延迟、要做灰度,理解 Transformer 不够,还得会构建 RAG、优化吞吐、排查 OOM、做评估与可观测性。

大模型工程师=AI能力 × 工程能力 × 系统交付能力

企业选人看的不是“会不会调 API”,而是:

| 考察维度 | 核心问题举例 |

|---|---|

| 算法原理 | 能否讲明 Attention、KV Cache 为什么降延迟? |

| 推理与训练 | BF16、FP8、Qwen、DeepSeek、Llama3 差在哪? |

| RAG / Fine-tune | 什么时候检索好?什么时候微调更划算? |

| Agent 工程 | 如何让模型具备可控行为与外部调用能力? |

| 多并发部署 | 怎么顶住 10k QPS 的生成服务? |

| 评估与对齐 | 如何让模型输出稳定、可靠、可审计? |

本文不是入门教程,而是一份面向面试官视角的技术地图:

读完后你会明确知道下一次面试你应该怎么讲、讲到什么层级才算“过关”。

接下来,我们围绕三大面试核心能力展开:

① 算法原理与模型细节

② 开发实践与工程链路

③ 部署、并发、监控与企业落地

二、算法原理篇:自注意力、推理加速与训练范式问到什么深度才是合格?

1)Transformer 讲清楚,才能迈入面试门槛

几乎所有面试都会问 —— Attention 工作机制。

你不仅要解释公式,还要回答模型为何可以并行训练、为何比 RNN 更适合长依赖。

回答示范:

Self-Attention 通过 Query/Key/Value 计算 token 间的相关性,得到加权表示;

多头 Attention 允许模型在不同子空间并行建模语义关系;

Transformer 结构完全基于矩阵运算,无需序列步进,因此训练可批量并行处理。

但真正的面试难点在于——深入问你:

| 深度提问 | 能力检验点 |

|---|---|

| 为什么 KV Cache 能显著降低推理延迟? | 是否理解推理阶段无需重复计算 Key/Value |

| RoPE(旋转位置编码)怎么编码相对位置信息? | 是否了解大模型长上下文解决方案 |

| MOE 路由如何选择专家? | 能否讲明 GShard、Switch Transformer 原理 |

| FP8/FP4 量化怎么做精度补偿? | 是否理解 KV 精度对推理稳定性的影响 |

如果你能画出 Attention 数据流图、对 KV Cache 优化做定量分析,那在面试官眼里,你已经不是“会模型的人”,而是“能优化模型的人”。

2)训练范式:Fine-Tuning vs LoRA vs SFT vs RLHF

一流工程师不会只说“微调能更贴业务”。

需要回答:

- 什么时候训练?什么时候只做 RAG?

- LoRA 训练降低显存为何有效?Rank 与表达能力关系如何?

- SFT / RLHF 在对齐与可控性中的差异?

清晰答法示例:

| 方法 | 适用场景 | 优点 | 限制 |

|---|---|---|---|

| RAG | 知识库问答、事实增强 | 成本低、不改模型权重 | 推理依赖检索质量 |

| SFT | 行为教学与任务风格一致时 | 训练简单、效果直观 | 对齐不足、易过拟合 |

| LoRA | 小样本、专用领域迁移 | 显存节省 4~16 倍 | 高秩任务可能表达不足 |

| RLHF | 对齐价值观、安全策略 | 可控性强 | 训练复杂、成本高 |

回答做到这个颗粒度,面试官会知道你不仅“会跑训练”,还理解为什么这样做。

三、开发实践篇:一个高质量 LLM 服务是如何被构建出来的?

模型是核心,但 能力落地靠工程链路支撑。

如果你的面试回答能从 “代码” → “架构” → “可观测性” → “调优手段” 逐层展开,你会被视为可以接手业务的工程师。

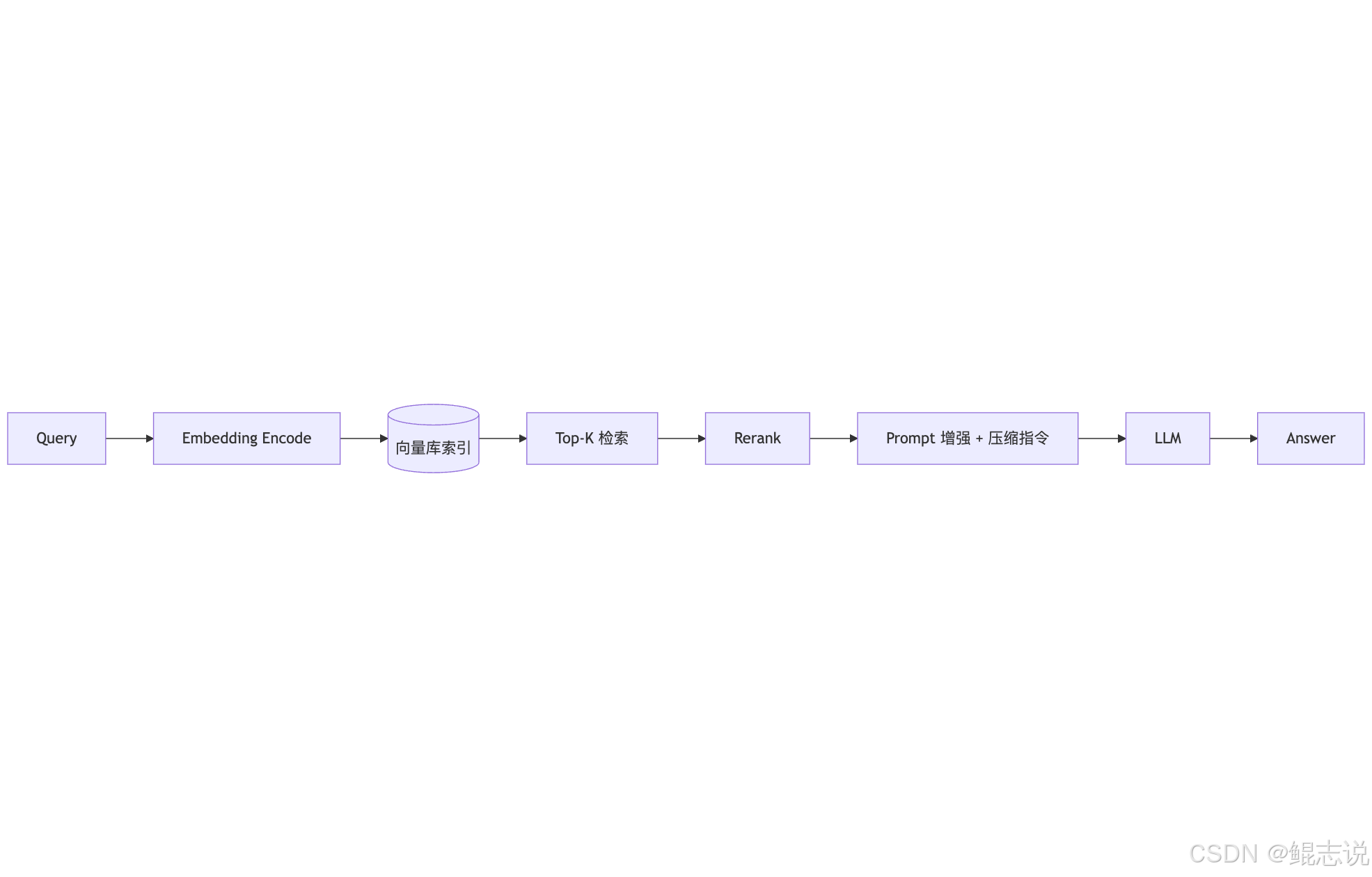

1)RAG 架构你必须讲清楚到可落地

优秀候选人会不仅画流程,还会讲:

- chunk 分块为什么决定召回效果?

- embedding 模型必须与语义空间对齐?

- Top-K 不稳定如何加入重排或 cross rerank?

示例流程 ↓(面试可直接画)

真正的加分点是补一句:

实际业务中 RAG 合格指标不是准确率,而是能够回答/拒答的稳定性与事实一致性,因此要加入 chunk-overlap + 文档可信度评分,并针对失败样本做反向 embedding 扩训。

这句话体现的是线下可验证 + 线上可追踪的工程思维。

2)Agent 与 Function Calling 的设计要点(面试高频区)

你要展示你知道——大模型不是问答工具,而是可控的执行体。

优秀回答应包含:

- 工具 schema JSON 如何设计?

- 什么时候分多 Agent 协作?

- 如何做任务拆解与失败回退?

一个能在面试中脱颖而出的回答方式:

用户 → Planner(任务拆解)

→ 执行器(并发下单、检索、写库)

→ 回执与审计

然后你再补一句:

可控智能体的本质不是调用工具,而是可审计、可回滚、可解释的任务执行流程。

这是 CTO 会点头的回答。

3)评估体系是面试最容易拉开差距的部分

多数候选人止步于 BLEU/ROUGE,

但真正的大模型工程师会讲这些:

✔ prompt 回归测试

✔ 行为稳定性(同问多次相似性/漂移率)

✔ RAG 中检索覆盖率/文档证据率

✔ 业务成功率(task-success-rate)

甚至可以给公式:

Success = correct * coverage * stability

能讲出评估体系,你就是能把模型推到生产的人。

四、系统部署篇:10 QPS 到 10k QPS 的大模型服务该如何扩展?

面试官眼里真正有含金量的回答要覆盖:

| 能力 | 关键点 |

|---|---|

| 推理加速 | KV Cache、prefill/decoding 分离、Flash-Attention |

| 多卡训练 / 推理 | 张量并行、流水并行、MoE expert parallel |

| 弹性扩缩容 | autoscaling、冷启动优化、fast-load权重 |

| 吞吐优化 | batching 策略、调度排队、流式推理切片 |

| 缓存策略 | 热门 Query embedding 缓存、向量索引缓存 |

最容易拿高分的讲解方式:

不谈理论,谈吞吐模型。

示例回答可这样说:

吞吐 TPS ~= batch_size / (推理延迟 × decode_token_cost)

要提升 QPS:

1) 加大批量合并请求(动态 batching)

2) 降低 decode 代价(KV Cache / quantization)

3) 多副本负载均衡 + 分级缓存

这类结构清晰的回答,面试官会直接写:✔“能驾驭线上环境”。

五、候选人高分表达模板(四句话面试直击要害)

讲原理 → 讲场景选择 → 讲工程落地 → 讲可观测与评估

举例 —— 当被问 “RAG 与微调怎么选?”

知识频繁变动/事实依赖强 → RAG

行为模式统一/风格约束明显 → SFT/LoRA

落地关注 chunk overlap、向量空间对齐、Rerank

上线需引入失败样本回归与证据链路审计

一句话就暴露你是否真的做过生产系统。

最后

- 好看的皮囊千篇一律,有趣的鲲志一百六七!

- 如果觉得文章还不错的话,可以点赞+收藏+关注 支持一下,鲲志的主页 还有很多有趣的文章,欢迎小伙伴们前去点评

- 如果有什么需要改进的地方还请大佬指出❌

- 欢迎学习交流|商务合作|共同进步!

- ❤️ kunzhi96 公众号【鲲志说】

书籍推荐

懂算法、精工程、善部署的“大模型工程师”正站在时代风口,《大模型工程师面试:算法原理、开发实践与系统部署》系统介绍了了大模型工程师岗位所需的理论基础与实战技能,围绕算法原理、开发实践与系统部署三大维度展开,可以帮助希望系统转型为大模型工程师的开发者成功通过面试。

书籍名称:《大模型工程师面试:算法原理、开发实践与系统部署》

内容介绍

《大模型工程师面试:算法原理、开发实践与系统部署》的特色是以工程实践能力+面试胜任能力为导向,各章内容都从实际面试出发,归纳整理出15类500余道高频面试题,每类列举若干典型问题并附答案,同时还提供了200余道自测题,使求职者在巩固知识的同时,测试自己能力水平

适合人群

- 适合有一定AI基础、希望进入大模型领域的软件工程师、算法工程师、系统架构师;

- 准备求职或转型到大模型领域的初中级从业者和高年级研究生。

免费送书

————————————————

⚠️:两种送书方式可以重复叠加获奖🏆

方式一 博客送书

本篇文章送书 🔥1本 评论区抽1位小伙伴送书

📆 活动时间:截止到 2025-12-04 20:00:00

🎁 抽奖方式:利用网络公开的在线抽奖工具进行抽奖

🤚 开奖条件:大于10个字的评论超过20条

💡 参与方式:关注、点赞、收藏 + 任意大于10个字的评论

方式二 公众号送书

关注公众号,参与评论,有机会获得📖哦!

📆 活动时间:截止到 2025-12-04 20:00:00

💡 参与方式:关注、点赞、推荐 + 文章留言

🎁 获奖方式:留言点赞数量最高者获得本书(数量相同者则以留言时间早者为准)

具体参与方式可➕kunzhi96,体验更多白嫖书籍的玩法

自主购买

小伙伴也可以访问链接进行自主购买哦~

直达京东购买链接🔗:《大模型工程师面试:算法原理、开发实践与系统部署》

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)