当AI能写代码时,顶级工程师在做什么?大模型时代的系统架构思维重塑

《AI时代工程师的转型:从代码生产者到系统定义者》 本文探讨了大模型时代下工程师角色的本质转变。随着AI编程工具的普及,工程师的核心价值正从"代码实现"转向"系统设计"。通过阿里云等企业的实践案例,文章揭示了AI在代码生成中的局限性:缺乏战略意图理解、无法全局优化、无责任主体性等问题。 文章提出工程师需要重构三大核心能力: 1.精准的问题定义力:运用第一性原

引言:从"编码自动化"到"智能协作者"的临界点

2023年,GitHub官方报告显示:Copilot用户编码速度平均提升55%,代码采纳率达35%,每周生成超过400亿行代码。表面看,这是一个编程效率革命的时代。但微软内部技术复盘揭示了一个反直觉的事实:使用Copilot的团队代码提交频率增加了40%,而产品上线速度仅提升18%。

"问题不在于写代码的速度,而在于定义正确问题、识别隐性约束和权衡长期代价的能力。"微软技术院士、前Azure CTO Mark Russinovich在2023年Build大会技术分享中一针见血。当AI能生成语法完美的函数,工程师的价值正在经历一场静默革命——从"代码生产者"跃迁为"系统架构师"。

这不是一个假设性讨论。GitHub在2023年安全报告显示,Copilot生成的代码中,40%存在潜在安全漏洞,包括硬编码凭证、未验证的输入和不安全的依赖。这意味着:当编写代码变得容易,定义正确问题、识别隐性约束、承担最终责任的能力变得更加珍贵。

本文将深入剖析大模型时代下,顶级工程师如何重构自身能力体系,通过系统架构思维建立新的技术护城河。这不是一篇关于Prompt工程的指南,而是一份面向未来的工程师生存与发展手册。

第一部分:AI的能力边界——为何它无法接管系统设计?

1.1 语义理解 ≠ 意图理解

阿里云通义实验室在2023年分享了一个典型案例:团队使用大模型自动生成一个电商推荐系统的代码。AI完美实现了协同过滤算法,甚至添加了精妙的性能优化。然而,当产品经理看到结果时,却指出这与业务目标南辕北辙——当前阶段的核心指标是"新用户留存率",而非"点击率"。AI理解了"如何实现推荐",却无法理解"为何需要这个推荐"背后的战略意图。

代码示例:语义理解与意图理解的差异

# AI生成的代码:基于点击率优化的推荐算法

def generate_recommendations(user_id, items):

# 基于历史点击行为计算相似度

user_clicks = get_user_clicks(user_id)

item_similarities = calculate_item_similarity(user_clicks, items)

return sorted(items, key=lambda x: item_similarities[x.id], reverse=True)[:10]

# 人类工程师修改:基于新用户留存的战略重构

def generate_new_user_recommendations(user_id, items, user_profile):

# 识别新用户(注册时间<7天)

if user_profile.registration_days < 7:

# 优先推荐能展示平台多样性的商品,而非仅高点击率商品

diverse_items = filter_diverse_categories(items, min_categories=5)

# 结合用户初始兴趣标签

personalized_items = personalize_by_initial_interests(diverse_items, user_profile.initial_interests)

return personalized_items[:10]

else:

# 老用户仍使用点击率优化

return generate_recommendations(user_id, items)1.2 局部最优 ≠ 全局最优

谷歌在2022年分享的Bard内部开发经验揭示了这一问题。AI能生成高质量的单个函数,但当集成到整个系统时,出现了严重的资源争用问题。AI优化了代码的简洁性和执行速度,却忽略了服务网格中的超时设置、重试策略和熔断机制,导致级联故障。

阿里云工程师在一次技术复盘中总结:"大模型是优秀的'局部优化器',但系统架构需要'全局思考者'。当AI建议使用10个微服务实现一个功能时,人类工程师需要问:这些服务的监控成本、网络延迟、数据一致性如何保障?"

1.3 无主体性 = 无责任归属

在金融行业,这一问题尤为突出。蚂蚁集团技术负责人在2023年分享:他们严格限制大模型在核心交易系统中的使用,因为"当AI生成的代码导致资损时,无法追究模型的责任,最终承担责任的是人类工程师"。因此,他们在架构中强制要求:

- 所有AI生成代码必须通过静态分析和人工审核

- 关键路径必须有"人类决策点"

- 完整的操作审计日志,记录谁触发了AI、谁审核了输出

1.4 缺乏跨域协同视角

微软Azure团队在2023年分享的案例显示:当使用GitHub Copilot开发云服务时,AI生成的代码往往忽略基础设施约束。一个看似完美的算法在本地运行良好,但在Kubernetes集群中因内存限制频繁崩溃。工程师需要额外添加资源请求/限制配置、水平扩展策略和优雅降级逻辑。

架构图:AI生成代码的完整生命周期管理

+--------------+ +----------------+ +---------------+ +---------------+

| 问题定义与 | -->| AI生成代码 | -->| 人工审核与 | --> | 集成与部署 |

| 边界设定 | |(含成本/风险分析)| | 系统适配 | |(含监控/告警) |

+--------------+ +----------------+ +---------------+ +---------------+

| | | |

v v v v

+--------------+ +----------------+ +---------------+ +---------------+

| 业务目标 | | 代码质量检查 | | 架构兼容性 | | 运行时表现 |

| 战略约束 | | 安全漏洞扫描 | | 资源需求评估 | | 成本分析 |

+--------------+ +----------------+ +---------------+ +---------------+AI是强大的"执行代理",但不是"系统所有者"。工程师的核心价值在于整合碎片、定义边界、承担后果。

第二部分:新护城河——顶级工程师的三大核心能力重构

2.1 能力支柱一:精准的问题定义力(Problem Framing)

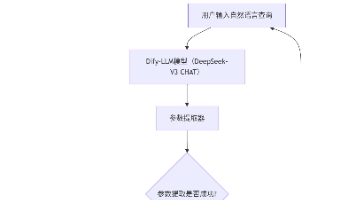

阿里云在推广通义灵码(AI编程助手)时发现,高效使用它的工程师与普通工程师的最大区别不在编码能力,而在于问题定义能力。高效用户会提供精确的上下文:"我需要一个线程安全的缓存实现,最大1000条记录,超过时按LRU淘汰,需要监控缓存命中率"。而普通用户只说:"帮我写个缓存"。

实战方法:第一性原理拆解框架

- 回归本质:这个功能要解决用户的什么根本问题?

- 识别约束:技术/合规/资源/时间上的硬性限制是什么?

- 定义成功:如何量化衡量这个方案是否成功?

阿里云某P8工程师分享的案例:当产品经理提出"需要更快的搜索体验",他没有直接优化算法,而是通过用户行为分析发现,80%的用户只使用前3个筛选条件。最终方案不是升级搜索引擎,而是重新设计筛选界面,将常见组合预设为快捷选项,使用户任务完成时间减少65%,且无需改动核心系统。

2.2 能力支柱二:高阶的架构抽象力(Architectural Abstraction)

在大模型时代,架构设计的核心挑战是如何将AI组件无缝集成到系统中,同时控制其不确定性。阿里云的内部架构指南提出了"AI-Ready系统"设计原则:

架构模式:AI服务的隔离与治理

class AIServiceGateway:

"""

AI服务网关:隔离AI不确定性,提供统一治理能力

"""

def __init__(self, ai_provider, fallback_provider=None):

self.ai_provider = ai_provider # AI服务提供者

self.fallback_provider = fallback_provider or RuleBasedFallback() # 降级策略

self.circuit_breaker = CircuitBreaker(failure_threshold=5, recovery_timeout=30) # 熔断器

self.cost_tracker = TokenCostTracker() # 成本跟踪器

def generate_response(self, context, max_tokens=1000, timeout=5.0):

"""

生成AI响应,内建防护机制

"""

try:

# 1. 成本预检查

estimated_tokens = self._estimate_tokens(context)

if not self.cost_tracker.can_spend(estimated_tokens):

return self._handle_budget_exceeded(context)

# 2. 调用AI,带超时控制

with timeout_context(timeout):

response = self.circuit_breaker.call(

lambda: self.ai_provider.generate(context, max_tokens)

)

# 3. 验证与净化输出

if not self._validate_response(response):

return self._handle_invalid_response(context, response)

# 4. 记录成本

self.cost_tracker.record_spend(estimated_tokens)

return response

except CircuitBreakerOpenException:

# 熔断时使用降级策略

return self.fallback_provider.generate(context)

except TimeoutException:

# 超时时使用缓存或降级

return self._handle_timeout(context)

except Exception as e:

# 兜底异常处理

logger.error(f"AI service failed: {str(e)}")

return self.fallback_provider.generate(context)阿里内部数据显示,采用此模式的团队,AI服务调用错误率下降70%,且问题定位时间从平均45分钟减少到5分钟。

2.3 能力支柱三:审慎的技术判断力(Technical Judgment)

在AI时代,技术判断的复杂度显著提升。阿里云技术委员会在2023年提出了"技术决策四象限"框架,评估引入AI组件的综合价值:

|

决策维度 |

传统考量 |

AI时代新增考量 |

|

商业价值 |

功能完成度、用户体验 |

个性化能力、交互自然度 |

|

实施成本 |

开发时间、基础设施成本 |

Token成本、模型微调成本、人工审核成本 |

|

长期维护 |

代码可维护性、文档完整性 |

模型漂移风险、Prompt维护复杂度 |

|

战略契合 |

技术栈一致性、团队能力匹配 |

数据积累价值、AI能力壁垒建设 |

案例:阿里云某产品团队在2023年面临是否使用大模型重构日志分析功能的决策:

1. 表面吸引力:大模型能理解自然语言查询,降低用户使用门槛

2. 深层考量:

- 成本结构变化:传统方案按计算资源付费,AI方案按Token量付费,月活用户增加10倍将导致成本爆炸

- 可靠性风险:日志分析是运维关键路径,AI的不确定性可能导致故障诊断延误

- 数据敏感性:客户日志包含敏感信息,上传至第三方API存在合规风险

最终团队采用混合架构:核心分析引擎保持规则驱动,仅在用户交互层引入AI,且所有敏感数据在本地脱敏处理。这一决策使产品保持了99.95%的SLA,同时用户满意度提升40%。

这三大能力共同构成工程师的"认知操作系统",使其能在AI辅助下做出更优、更负责任的系统设计。

第三部分:实战框架——面向AI原生时代的架构设计五原则

3.1 原则一:人机职责显性化(Explicit Human-AI Boundary)

阿里云在内部推行"人机协作映射表",明确每个环节的负责人:

| 业务环节 | AI职责 | 人类职责 | 交接点 |

|--------------|--------------------|------------------- ------|----------------|

| 代码生成 | 生成初始实现 | 审核逻辑正确性、边界条件 | 代码评审 |

| 异常处理 | 提供可能原因建议 | 决策处理策略、通知相关方 | 告警确认 |

| 配置优化 | 建议参数调整 | 评估风险、审批执行 | 变更控制流程 |

| 安全审计 | 扫描已知漏洞模式 | 分析业务逻辑漏洞、战略风险 | 安全评审会议 |实施工具:阿里内部开发的代码标记规范

# AI-GENERATED-BLOCK [START]

# 生成者: Tongyi-Copilot v3.2

# 生成时间: 2023-11-26 14:30:22

# 审核人: @zhangwei

# 审核时间: 2023-11-26 15:45:10

# 审核意见: 已添加空值检查和超时控制

def process_user_input(input_data):

# [AI生成的代码逻辑]

...

# AI-GENERATED-BLOCK [END]3.2 原则二:韧性内生于架构(Resilience by Design)

阿里云通义实验室的实践表明,AI系统的韧性设计必须前置。他们为通义灵码开发了多层次的防护机制:

架构图:AI服务弹性架构

+-----------------------+

| 用户请求 |

+-----------+-----------+

|

v

+-----------------------+

| 请求验证与清洗 | --> 恶意输入拦截

+-----------+-----------+

|

v

+-----------------------+ +------------------+

| AI服务路由 +--->| 熔断器状态检查 |

+-----------+-----------+ +------------------+

|

v

+-----------------------+ +------------------+

| 执行策略选择 +--->| 1. 正常: 调用AI |

| | | 2. 熔断: 降级 |

| |<---+ 3. 限流: 排队 |

+-----------+-----------+ +------------------+

|

v

+-----------------------+ +------------------+

| 结果验证与净化 +--->| 格式校验 |

| | | 内容安全过滤 |

| |<---+ 业务规则检查 |

+-----------+-----------+ +------------------+

|

v

+-----------------------+

| 返回结果 |

+-----------------------+代码示例:熔断器实现

public class AICircuitBreaker {

private static final int FAILURE_THRESHOLD = 5;

private static final long RECOVERY_TIMEOUT_MS = 30000;

private AtomicInteger failureCount = new AtomicInteger(0);

private AtomicLong lastFailureTime = new AtomicLong(0);

private volatile boolean isCircuitOpen = false;

public <T> T executeWithCircuitBreaker(Supplier<T> aiOperation, Supplier<T> fallbackOperation) {

if (isCircuitOpen) {

if (System.currentTimeMillis() - lastFailureTime.get() > RECOVERY_TIMEOUT_MS) {

// 尝试半开状态

if (failureCount.compareAndSet(FAILURE_THRESHOLD, FAILURE_THRESHOLD - 1)) {

isCircuitOpen = false;

try {

return aiOperation.get();

} catch (Exception e) {

recordFailure();

return fallbackOperation.get();

}

}

}

return fallbackOperation.get();

}

try {

T result = aiOperation.get();

failureCount.set(0); // 成功时重置计数

return result;

} catch (Exception e) {

recordFailure();

if (failureCount.get() >= FAILURE_THRESHOLD) {

isCircuitOpen = true;

}

return fallbackOperation.get();

}

}

private void recordFailure() {

failureCount.incrementAndGet();

lastFailureTime.set(System.currentTimeMillis());

}

}3.3 原则三:成本与性能透明化

阿里云内部监控平台"天眼"为AI服务开发了专门的Cost-Performance Dashboard,实时展示:

- 每千次调用的Token消耗与成本

- P50/P95/P99延迟分布

- 错误率与重试率

- 资源利用率(GPU/CPU/内存)

监控指标实践:

# prometheus监控指标定义

- name: ai_service_token_usage

help: "Total tokens used by AI service"

labels: [service_name, model_version, environment]

- name: ai_service_cost_usd

help: "Estimated cost in USD for AI service calls"

labels: [service_name, cost_center, team]

- name: ai_response_latency_seconds

help: "Latency of AI responses in seconds"

buckets: [0.1, 0.5, 1.0, 2.0, 5.0, 10.0]

- name: human_review_rate

help: "Percentage of AI outputs requiring human review"

labels: [service_name, risk_level]阿里某BU在实施此监控后,发现某推荐功能的Token成本超出预期23倍,优化后每月节省8万美元。更重要的是,团队开始在设计阶段就考虑成本因素,而非事后补救。

第四部分:典型场景深度剖析——阿里云智能客服系统重构

背景:2023年初,阿里云客服系统面临挑战:每日10万+咨询中,30%是重复问题,人工响应速度慢,用户满意度仅为78%。

初始方案(单纯AI替代):

- 使用大模型自动生成回答

- 期望:减少50%人工坐席,提升响应速度

问题暴露:

- 用户投诉增加40%:AI给出错误解决方案

- 安全事件:AI泄露了一个客户的内部API密钥

- 成本失控:复杂问题需多次交互,Token成本超出预算3倍

重构方案(系统架构思维):

1. 分层设计:

- L1:规则引擎处理FAQ(覆盖60%简单问题)

- L2:AI生成回答,但限定在知识库范围内

- L3:复杂问题转人工,AI辅助提供知识卡片

2. 人机协作流程:

+------------+ +------------+ +------------+ +------------+

| 用户提问 | --> | 意图识别 | --> | 策略路由 | --> | 执行引擎 |

+------------+ +------------+ +------------+ +------------+

| |

v v

+------------+ +------------+

| 简单问题 | | 复杂问题 |

| (规则匹配) | | (AI+人工) |

+------------+ +------------+3. 关键技术创新:

- 知识约束机制:AI只能从预批准知识库中引用信息

def generate_response(query, knowledge_base):

# 1. 从知识库检索相关片段

relevant_snippets = knowledge_base.semantic_search(query, top_k=5)

# 2. 构建受限上下文

context = "\n".join([f"Source[{i+1}]: {snippet.content}" for i, snippet in enumerate(relevant_snippets)])

# 3. 生成回答,但强制引用来源

prompt = f"""

你是一个专业客服,只能基于以下信息回答问题:

{context}

问题:{query}

要求:

1. 如果信息不足,明确告知"我无法回答这个问题"

2. 每个关键信息必须标注来源编号

3. 不要编造数据或细节

"""

response = llm.generate(prompt)

# 4. 后处理:验证引用完整性

if not verify_citations(response, relevant_snippets):

return "这个问题需要人工专家解答,请稍等..."

return response- 人工干预通道:当问题涉及账户安全、费用争议等敏感话题时,自动转人工

- 持续学习闭环:将人工修正的答案自动回流至知识库

成果:

- 用户满意度:从78%提升至93%

- 人工坐席需求:减少35%(而非预期的50%,但服务质量大幅提升)

- 平均响应时间:从3.2分钟降至45秒

- 安全事件:零重大事故

一位资深客服主管的评价:"AI没有取代我们,而是让我们从重复劳动中解放,专注于真正需要人类同理心和专业判断的复杂场景。"

结语:成为AI时代的"系统建筑师"

当GitHub Copilot能写出完美的排序算法,Stack Overflow出现大量AI生成答案,我们不禁要问:工程师的价值何在?

答案不在工具的熟练度,而在系统的定义权。顶级工程师正在成为"系统建筑师"——他们不仅设计技术架构,更定义人机边界、成本模型、演进路径和伦理框架。他们懂得:代码可以被生成,但责任无法被外包;功能可以被复制,但判断难以被替代。

阿里云一位P9架构师在内部分享中说:"十年前,我们比拼的是代码数量;五年前,是架构复杂度;今天,是系统思考的深度与广度。"这不是工程师角色的降级,而是一次质的跃迁——从技术执行者到系统定义者,从功能实现者到价值创造者。

在这个智能涌现的时代,真正的技术护城河不在于掌握了多少AI工具,而在于能否用系统思维驾驭这些工具,为它们划定边界、定义目标、承担责任。当你能够清晰地回答"这个AI组件为何存在?它如何与人类协作?失败时如何保障?",你就已经站在了技术金字塔的顶端。

工程师们,放下对"被取代"的恐惧,拥抱"被增强"的机遇。不是AI将取代我们,而是懂得与AI协作的工程师将取代那些不肯改变的人。在这个人机共生的新纪元,让我们以架构思维为剑,以系统思考为盾,共同构建一个技术向善的未来。

核心行动清单:

停止优化代码行数,开始优化系统决策质量

为每个AI组件定义明确的职责边界和失败策略

建立成本-性能-风险的全面监控体系

在架构设计中前置伦理与合规考量

持续提升问题定义能力,而非仅优化解决方案

在这个充满不确定性的时代,最确定的事是:伟大的系统,永远始于伟大的设计者。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)