AI技术与控制措施 (AI安全管理三)

摘要:本文系统分析了AI技术规模化应用中的安全与合规挑战,提出覆盖数据、模型、算力三大维度的全生命周期控制框架。针对机器学习、深度学习、生成式AI等核心技术,结合行业案例详细剖析典型风险点(如数据偏见、模型黑箱、隐私泄露)及控制措施(数据脱敏、模型加密、Prompt过滤)。通过构建"横向覆盖+纵向穿透"的技术控制体系,实现从数据采集到模型退出的全流程风险管理,为企业平衡技术创新

引言

AI技术的规模化应用不仅重塑了业务流程,也带来了技术层面的安全与合规挑战——模型漏洞、数据泄露、算力滥用等风险直接影响AI系统的可靠性。本文聚焦AI核心技术原理与落地场景,构建全生命周期技术控制框架,通过数据、模型、算力三大维度的关键控制措施,结合行业标杆案例与工具链实操,帮助企业实现“技术创新+风险可控”的平衡,适用于技术架构师、AI安全工程师、运维管理人员等群体。

1. 核心AI技术原理与应用场景

1.1 机器学习(ML)技术体系

1.1.1 技术原理

机器学习通过算法让系统从数据中学习规律,无需显式编程即可完成决策。核心流程包括:数据预处理→特征工程→模型训练→评估优化→部署推理。按学习方式分为:

- 监督学习:基于标注数据训练(如分类、回归);

- 无监督学习:从无标注数据中挖掘规律(如聚类、降维);

- 半监督学习:结合少量标注数据与大量无标注数据(如半监督分类)。

1.1.2 典型应用场景与风险点

| 应用场景 | 技术选型 | 核心风险点 |

|---|---|---|

| 金融风控 | 逻辑回归、随机森林、XGBoost | 特征偏见导致歧视、模型过拟合引发误判 |

| 用户画像 | K-Means聚类、PCA降维 | 隐私数据泄露、画像标签越权使用 |

| 设备故障预测 | 时序LSTM、ARIMA | 数据滞后性导致预测失效、模型漂移 |

1.1.3 行业案例

某能源企业采用随机森林算法构建风机故障预测模型,通过分析10万+条设备运行数据,预测准确率达92%,但初期因未控制特征中的“地域偏差”(部分地区数据缺失),导致北方冬季故障误判率高达15%,后续通过补充数据与特征筛选控制风险。

1.2 深度学习(DL)技术体系

1.2.1 技术原理

深度学习是机器学习的子集,基于神经网络(多层感知机)处理复杂数据,核心优势在于自动提取高阶特征。主流技术方向包括:

- 卷积神经网络(CNN):擅长图像/语音识别(如CNN+ResNet用于医疗影像诊断);

- 循环神经网络(RNN/LSTM/Transformer):处理时序数据(如LSTM用于股价预测);

- 多模态学习:融合文本、图像、语音等多源数据(如CLIP模型用于跨模态检索)。

1.2.2 典型应用场景与控制需求

| 应用场景 | 技术选型 | 核心控制需求 |

|---|---|---|

| 医疗影像诊断 | CNN+注意力机制 | 模型可解释性、误诊风险控制 |

| 自动驾驶感知 | 3D CNN+LiDAR融合 | 实时性保障、对抗性攻击防护 |

| 智能客服语音识别 | Transformer+CTC解码 | 语音数据隐私保护、识别错误修正 |

1.2.3 技术特点与控制难点

- 优势:处理非结构化数据能力强,准确率高(如医疗影像诊断准确率超95%);

- 难点:模型“黑箱”特性导致可解释性差,训练需海量数据易引发隐私风险,算力消耗大。

1.3 生成式AI(AIGC)技术体系

1.3.1 技术原理

生成式AI基于大语言模型(LLM)、扩散模型等,通过学习数据分布生成全新内容(文本、图像、代码等)。核心技术包括:

- 大语言模型(LLM):GPT系列、文心一言、通义千问(基于Transformer架构,千亿级参数);

- 图像生成模型:Stable Diffusion、MidJourney(扩散模型,基于文本prompt生成图像);

- 代码生成模型:GitHub Copilot、CodeLlama(基于代码数据集训练)。

1.3.2 典型应用场景与风险控制

| 应用场景 | 技术选型 | 核心风险控制措施 |

|---|---|---|

| 企业文档生成 | GPT-4企业版、通义千问 | Prompt过滤、生成内容人工复核 |

| 产品设计图生成 | Stable Diffusion | 版权校验、敏感内容拦截 |

| 辅助编程 | GitHub Copilot | 代码安全扫描、开源协议合规检查 |

1.3.3 行业案例

某科技公司采用GPT-4企业版构建内部文档生成工具,通过以下控制措施规避风险:1)自定义敏感词库+语义分析过滤违规Prompt;2)生成文档自动标注“AI生成+人工审核”标识;3)限制训练数据为企业内部合规文档,避免隐私泄露,使违规内容生成率从12%降至0.8%。

1.4 强化学习(RL)与其他AI技术

1.4.1 强化学习

- 原理:智能体通过与环境交互,基于奖励机制优化行为策略(如Q-Learning、DQN);

- 应用:机器人控制、游戏AI、智能调度(如物流路径优化);

- 控制重点:奖励函数设计避免“短视行为”(如调度AI为短期效率牺牲长期成本)、环境模拟真实性验证。

1.4.2 其他技术

- 联邦学习(FL):多参与方在不共享原始数据的情况下联合训练模型,控制数据泄露风险;

- 知识图谱(KG):结构化存储实体关系,用于智能搜索、风控关联分析,控制知识准确性与更新及时性。

2. AI技术层面控制框架

2.1 全生命周期控制体系

AI技术控制需覆盖“数据→训练→部署→运维→退出”全流程,构建“横向覆盖+纵向穿透”的框架:

# AI技术控制全生命周期框架

## 1. 数据阶段(输入控制)

- 数据采集合规性控制

- 数据质量与安全性控制

## 2. 训练阶段(过程控制)

- 模型训练环境安全

- 训练过程监控与审计

- 模型公平性与伦理控制

## 3. 部署阶段(输出控制)

- 模型部署环境隔离

- 接口安全与访问控制

- 输出结果校验与过滤

## 4. 运维阶段(持续控制)

- 模型漂移监控

- 安全漏洞扫描与修复

- 算力资源管控

## 5. 退出阶段(收尾控制)

- 模型与数据销毁

- 残留风险清理

2.2 控制框架核心原则

- 左移防控:将控制措施提前至数据采集与模型设计阶段(如训练前进行数据合规审核);

- 最小权限:数据、模型、算力的访问权限按“必要最小”分配(如普通员工无法访问模型核心参数);

- 可追溯性:全流程日志留存(数据流转、模型训练、接口调用),留存期≥6个月;

- 动态适配:随技术迭代更新控制措施(如生成式AI新增Prompt安全控制)。

2.3 跨层级协同控制

- 技术层:工具自动化控制(如数据脱敏工具、模型加密工具);

- 流程层:标准化操作流程(SOP)+ 双人复核机制;

- 管理层:责任分工明确(如数据安全负责人、模型安全专员)。

3. 关键控制措施(数据、模型、算力)

3.1 数据安全控制

3.1.1 数据采集与合规控制

-

合规授权:

- 措施:采用“明确告知+用户同意”机制,采集数据需与业务目的匹配;

- 工具:隐私政策生成工具、用户授权管理系统;

- 案例:某电商平台采集用户行为数据时,通过弹窗明确告知“用于个性化推荐”,用户可一键撤销授权,授权率从85%提升至92%,合规风险下降60%。

-

数据质量控制:

- 措施:自动清洗(去重、补缺失值、异常值检测)、数据血缘追踪;

- 工具:Python Pandas、Apache Griffin、FineDataLink;

- 标准:数据完整性≥98%,异常值占比≤2%,数据血缘覆盖率100%。

3.1.2 数据存储与传输安全

| 控制措施 | 技术实现 | 工具推荐 |

|---|---|---|

| 数据加密 | 存储加密(AES-256)、传输加密(TLS 1.3) | OpenSSL、阿里云KMS、AWS KMS |

| 数据脱敏 | 静态脱敏(替换/掩码)、动态脱敏(实时过滤) | 华为DataMasker、Oracle Data Masking |

| 数据隔离 | 按业务线/敏感度分层存储 | 数据安全网关、物理隔离存储 |

3.1.3 数据访问控制

- 措施:基于角色(RBAC)+ 属性(ABAC)的访问控制,多因素认证(MFA);

- 工具:Apache Ranger、KeyCloak、企业IAM系统;

- 案例:某金融机构对客户信贷数据设置访问权限,仅风控团队可访问完整数据,其他部门仅能查看脱敏后的数据,数据泄露事件发生率从1.2次/年降至0。

3.2 模型安全控制

3.2.1 模型训练阶段控制

-

训练环境安全:

- 措施:隔离训练环境(独立GPU集群)、禁止外接移动设备、训练过程加密;

- 工具:Kubernetes隔离容器、VMware虚拟化环境;

- 要求:训练环境需通过等保三级认证,日志留存≥1年。

-

模型公平性与伦理控制:

- 措施:采用AI Fairness 360工具审计偏见,优化训练数据分布;

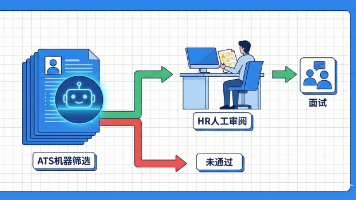

- 案例:某招聘AI初期因训练数据中男性样本占比70%,导致女性候选人通过率低25%,通过补充女性样本+调整模型权重,偏见差异率降至3%以内。

3.2.2 模型部署与运行控制

-

模型安全防护:

- 措施:模型加密(同态加密、联邦学习)、模型水印(嵌入隐形标识)、对抗性训练;

- 工具:Microsoft SEAL(同态加密)、IBM AI Adversarial Robustness Toolkit、DigitalAI Model水印工具;

- 案例:某自动驾驶公司对核心感知模型采用同态加密部署,即使模型文件被窃取,未授权方也无法解析使用。

-

模型输出控制:

- 措施:输出结果校验(与历史正常结果比对)、敏感内容过滤、人工复核(高风险场景);

- 工具:自定义规则引擎、NLP语义分析工具;

- 标准:高风险场景(如医疗诊断、金融审批)人工复核率100%,输出错误率≤0.5%。

3.2.3 模型运维阶段控制

- 模型漂移监控:

- 措施:实时监控模型准确率、召回率,设定漂移阈值(如准确率下降≥5%触发预警);

- 工具:MLflow、Prometheus+Grafana、Evidently AI;

- 模型版本管理:

- 措施:版本编号(如Vx.y.z)、版本回滚机制、变更审计;

- 工具:DVC、GitLab Model Registry。

3.3 算力安全控制

3.3.1 算力资源隔离与管控

-

环境隔离:

- 措施:训练/推理环境物理隔离、生产/测试环境分离、不同业务线算力隔离;

- 工具:Kubernetes Namespace、Docker容器、物理服务器分区;

- 案例:某互联网公司将生成式AI推理算力与核心业务算力隔离,避免AI高负载导致核心业务卡顿。

-

资源使用管控:

- 措施:算力配额分配(按部门/项目设定GPU/CPU使用上限)、动态调度(高峰时段优先保障核心业务);

- 工具:Kubernetes HPA(Horizontal Pod Autoscaler)、NVIDIA GPU Manager;

- 标准:算力资源利用率≥70%,核心业务算力保障率100%。

3.3.2 算力安全防护

- 措施:GPU漏洞扫描(如NVIDIA GPU漏洞CVE-2023-25515)、算力节点访问控制、能耗监控;

- 工具:Nessus、OpenVAS、NVIDIA Data Center Security;

- 案例:某云计算厂商通过定期扫描GPU节点漏洞,及时修复缓冲区溢出漏洞,避免攻击者通过算力节点入侵AI系统。

3.4 接口与集成安全控制

3.4.1 API接口安全控制

| 控制措施 | 技术实现 | 工具推荐 |

|---|---|---|

| 身份认证 | API密钥、OAuth 2.0、JWT | Apigee、Kong API Gateway |

| 访问限流 | 单IP/用户调用频率限制 | Nginx、Kong限流插件 |

| 数据加密 | 接口传输TLS加密、请求/响应签名 | OpenSSL、API签名工具 |

| 日志审计 | 接口调用日志全留存 | ELK Stack、Splunk |

3.4.2 系统集成安全

- 措施:接口兼容性测试、第三方系统安全评估、集成后的整体安全测试;

- 工具:Postman(接口测试)、OWASP ZAP(渗透测试);

- 案例:某银行将AI风控模型与核心交易系统集成时,先通过第三方安全评估发现3个接口漏洞(如未授权访问),修复后再上线,避免集成风险。

4. 工具链与实操案例

4.1 技术控制工具链全景图

| 控制维度 | 核心工具 | 功能特点 | 适用场景 |

|---|---|---|---|

| 数据安全 | Apache Ranger | 细粒度数据访问控制、审计日志 | 企业级数据湖/数据仓库 |

| 华为DataMasker | 动态/静态脱敏、支持多种数据格式 | 金融、医疗等敏感数据场景 | |

| 模型安全 | IBM AI Security Toolkit | 模型漏洞扫描、对抗性训练、公平性审计 | 全行业AI模型安全控制 |

| MLflow | 模型版本管理、训练过程监控 | 模型全生命周期管理 | |

| 算力安全 | Kubernetes | 容器隔离、资源调度 | 分布式AI训练/推理环境 |

| NVIDIA DCGM | GPU监控、能耗管理、漏洞扫描 | GPU集群安全管控 | |

| 接口安全 | Kong API Gateway | 认证、限流、日志审计 | AI API接口统一管控 |

| 综合控制 | 奇安信AI安全平台 | 全生命周期安全管控、自动化检测 | 大型企业AI系统 |

4.2 企业实操案例(某制造企业AI质检系统)

4.2.1 项目背景

该企业采用CNN+Transformer模型构建工业产品质检系统,日处理10万+张产品图像,需保障模型准确率、数据安全与算力稳定。

4.2.2 技术控制措施落地

- 数据控制:

- 采用华为DataMasker对产品图像中的敏感标识(如客户Logo)脱敏;

- 用Apache Griffin进行数据质量监控,确保图像清晰度≥90%,标注准确率≥99%;

- 模型控制:

- 训练环境采用Kubernetes隔离容器,禁止外接网络;

- 部署IBM AI Security Toolkit进行模型漏洞扫描,修复2个高危漏洞(模型投毒风险);

- 用MLflow管理模型版本,设定“准确率≥98%”为上线阈值;

- 算力控制:

- 分配8台GPU服务器作为专属算力集群,与其他业务隔离;

- 通过NVIDIA DCGM监控GPU负载,避免过载导致推理延迟;

- 接口控制:

- 用Kong API Gateway管控质检系统接口,设置单IP每日调用上限1000次;

- 接口传输采用TLS 1.3加密,调用日志留存1年。

4.2.3 实施效果

- 模型准确率稳定在98.5%,误判率从3%降至0.8%;

- 未发生数据泄露、模型安全事件;

- 算力资源利用率从65%提升至82%,推理延迟≤200ms。

4.3 中小微企业轻量化控制方案

对于资源有限的中小微企业,推荐“工具轻量化+流程标准化”方案:

- 数据控制:用Python Pandas做数据清洗,开源脱敏工具(如DataMasker Community Edition);

- 模型控制:采用开源MLflow管理模型,定期用OWASP AI Security Top 10进行漏洞自查;

- 算力控制:用云厂商GPU实例(如阿里云GPU服务器),按使用量付费,避免硬件投入;

- 接口控制:用Nginx做简单的接口限流与认证,日志留存6个月。

5. 技术控制效果评估

5.1 评估指标体系

| 评估维度 | 核心指标 | 目标值 | 测量方法 |

|---|---|---|---|

| 数据安全 | 数据泄露事件数 | 0起/年 | 安全审计、日志分析 |

| 数据合规通过率 | 100% | 合规自查、第三方评估 | |

| 模型安全 | 模型漏洞修复率 | ≥95% | 漏洞扫描报告 |

| 模型漂移预警及时率 | 100% | 监控平台数据 | |

| 算力安全 | 算力资源利用率 | ≥70%且≤90% | 资源监控工具 |

| 算力故障恢复时间 | ≤1小时 | 故障处置记录 | |

| 接口安全 | 接口攻击拦截率 | ≥99% | WAF日志分析 |

| 接口调用成功率 | ≥99.9% | 接口监控平台 |

5.2 评估方法与周期

- 日常评估:自动化工具实时监控(如模型漂移、接口攻击);

- 季度评估:全流程安全扫描(数据、模型、算力、接口)+ 漏洞修复验证;

- 年度评估:第三方安全评估机构进行全面渗透测试与合规审计;

- 触发式评估:新增AI功能、技术架构变更、发生安全事件后,立即开展专项评估。

5.3 持续优化机制

- 建立问题清单:记录评估发现的风险点(如“模型漂移监控阈值不合理”);

- 制定整改计划:明确责任人、完成时限(如“调整漂移阈值从5%至3%,3个工作日内完成”);

- 优化控制措施:根据技术迭代更新控制方案(如生成式AI新增Prompt安全过滤规则)。

6. 总结

AI技术与控制的核心是“以技术对抗技术风险”,通过全生命周期控制框架,聚焦数据、模型、算力三大核心维度,结合工具自动化与流程标准化,实现风险的提前防控与持续管控。企业需根据自身规模、业务场景选择适配的控制方案——大型企业可搭建综合安全平台,中小微企业可采用轻量化工具组合,关键在于“左移防控+动态适配”。

未来,随着生成式AI、AGI等技术的演进,AI控制将面临更多新挑战(如AI自主决策的伦理控制),需持续关注技术趋势与安全工具更新,确保控制措施的有效性与前瞻性。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)