当 AR 遇见 AI:用 Rokid Glass 打造你的专属编程“副驾”

随着增强现实(AR)与人工智能(AI)技术的深度融合,智能眼镜作为新兴的交互终端,正逐渐从概念走向现实。本文将深入探讨如何利用 Rokid Glass 及其提供的 SDK,从零开始构建一个功能强大的“AI 编程助手”。该应用旨在将开发者的双手从键盘上解放出来,通过语音交互与悬浮的 AR 界面,实现随时随地的代码查询、逻辑梳理、Bug 解析乃至代码生成。

目录

摘要:

随着增强现实(AR)与人工智能(AI)技术的深度融合,智能眼镜作为新兴的交互终端,正逐渐从概念走向现实。本文将深入探讨如何利用 Rokid Glass 及其提供的 SDK,从零开始构建一个功能强大的“AI 编程助手”。该应用旨在将开发者的双手从键盘上解放出来,通过语音交互与悬浮的 AR 界面,实现随时随地的代码查询、逻辑梳理、Bug 解析乃至代码生成。我们将重点阐述应用的整体设计思路、手机与眼镜协同工作的技术架构、基于 Rokid SDK 的核心功能实现,并结合大语言模型(LLM)探讨 AI 工作流的构建细节。本文不仅是一次 AR 应用开发的实践分享,更是一次对未来编程范式的探索,希望能为广大开发者在 AR+AI 领域的创新带来启发。

一、引言:当 AR 遇见 AI,下一代计算平台已来

2025 年,我们见证了人工智能以前所未有的速度融入各行各业,从根本上改变着信息创作、知识获取乃至与数字世界交互的方式。以大语言模型(LLM)为代表的生成式 AI,不仅在云端大放异彩,更开始向个人设备渗透,预示着一个由 AI 驱动的“个人助理”时代正悄然来临。与此同时,增强现实(AR)技术也走过了初期的探索,逐渐成为消费电子市场中备受瞩目的焦点。当我们将这两股强大的技术浪潮汇聚在一起,会碰撞出怎样的火花?

答案或许就是下一代个人计算平台的雏形。

传统的计算设备,无论是个人电脑还是智能手机,都将我们的交互限制在二维的屏幕之内。而 AR 眼镜,则致力于将数字信息无缝叠加到我们的物理世界之上,为我们提供一个永不离线的、与现实融为一体的“信息图层”。想象一下,当 AI 的智慧不再局限于一块冰冷的屏幕,而是能够通过 AR 眼镜,以第一视角实时、直观地呈现在我们眼前,这将带来何等颠覆性的体验。我们可以随时随地唤醒一个无所不知的“专家”,它能“看见”我们所见的,“听见”我们所闻的,并结合我们所处的环境,提供最精准、最即时的帮助。

这并非遥远的科幻构想,以 Rokid Glass 为代表的新一代消费级 AI 眼镜,正让这一切变得触手可及。它轻便的形态、出色的显示效果以及开放的开发者生态,为我们提供了一个绝佳的平台,去探索 AR+AI 的无限可能。

本文将以一个具体而有趣的实践案例——“AI 编程助手”——为切入点,详细阐述如何基于 Rokid Glass 及其提供的 SDK,打造一个能够解放开发者双手的编程“副驾”。我们将从应用构思、技术选型、架构设计,到结合 Rokid SDK 的核心代码实现,再到 AI 工作流的构建,一步步为你揭示从 0 到 1 构建一个实用 AR+AI 应用的全过程。

希望这次探索,不仅能为广大开发者朋友们提供一份详尽的 Rokid Glass 开发指南,更能抛砖引玉,激发大家对于 AR+AI 应用场景的无限想象,共同迎接下一代计算平台的到来。

二、构思核心应用:打造一个永不离线的“编程副驾”

1. 痛点:现代开发的“上下文切换”之困

作为开发者,我们每天都在与海量的“上下文”作斗争:

-

IDE 与浏览器的频繁切换: 遇到一个陌生的 API,第一反应是

Alt+Tab打开浏览器搜索,在海量标签页中找到答案,再切回 IDE。这个过程不仅打断心流,也消耗着宝贵的注意力。

-

“金鱼般”的记忆: 刚刚记住的命令行参数、复杂的 Git 指令、某个库的特定用法,在敲下几个字符后就忘得一干二净。

-

“当局者迷”的困境: 面对一个棘手的 Bug,我们常常会陷入思维定式,反复检查同一段代码却找不到问题所在,此时多么希望有一个“旁观者”能给点提示。

这些看似微不足道的“小摩擦”,日积月累,构成了我们开发效率的主要瓶颈。我们不禁会想:有没有一种更高效、更沉浸的交互方式,能让我们始终聚焦于核心的编码任务,将这些“辅助工作”无缝地融入我们的工作流中?

2. 愿景:Rokid Glass 上的 AI 编程助手

我们的答案是:一个基于 Rokid Glass 的 AI 编程助手。

它不是要取代你的 IDE,而是要成为你视线中的“第二块屏幕”,一个永远在线、听候调遣的“编程副驾”。它将 AI 的智慧与 AR 的直观相结合,旨在解决上述所有痛点。

想象一下这样的工作场景:

你正专注于编写一段复杂的业务逻辑,突然忘记了某个 Spring Boot 注解的具体用法。你无需离开当前的 IDE 窗口,只需轻声说一句:“Hey Rokid,帮我查一下

@RestController和@Controller的区别。”瞬间,一段精炼的解释和代码示例便以半透明卡片的形式,悬浮在你电脑屏幕的侧上方,既不遮挡你的代码,又能让你一目了然。你看完后,说一句“关闭”,卡片便消失无踪,整个过程行云流水,你的思绪从未中断。

你在调试一段 Python 脚本,遇到了一个

KeyError。你对着眼镜说:“Hey Rokid,分析一下这个错误。” 眼镜通过与手机的协同,甚至可以(在授权后)“看到”你屏幕上的错误堆栈,然后为你提供几种常见的错误原因和排查建议,例如“检查字典中是否存在该键”、“确认数据源是否返回了预期的格式”等等。

这就是我们希望构建的应用——一个真正懂你、为你分忧的 AI 编程伙伴。

3. 核心功能设计

为了实现这个愿景,我们为这个“AI 编程助手”设计了以下几个核心功能模块:

-

语音驱动的即时问答(Instant Q&A):

- 交互方式: 通过“唤醒词 + 问题”的方式,随时向 AI 提问。

- 内容范围: 涵盖编程语言语法、框架用法、算法实现、命令行工具、设计模式等一切开发相关知识。

- 呈现方式: 在眼镜的虚拟屏幕上以文本、代码块或列表的形式清晰展示。

-

AI 工作流(AI Workflow):

- 交互方式: 通过更复杂的语音指令,执行一系列预设的动作流。

- 应用场景:

- 代码生成: “帮我写一个 Java 单例模式的实现。”

- 代码解释: “解释一下这段 Go 代码的作用。”(未来可结合摄像头或屏幕共享实现)

- Bug 分析与建议: “分析一下这个

NullPointerException的可能原因。” - 代码重构建议: “这段代码有什么可以优化的地方?”

-

纯手机端应用配合:

- 作用: 手机 App 作为眼镜的“大脑”和“网络连接器”。

- 功能:

- 负责运行与大语言模型(LLM)交互的逻辑,处理计算密集型任务。

- 提供一个图形化界面,用于配置 AI 模型(如更换 API Key、选择不同模型)、查看历史问答记录、自定义工作流等。

- 作为眼镜与外部服务(如 GitHub、Jira)连接的桥梁。

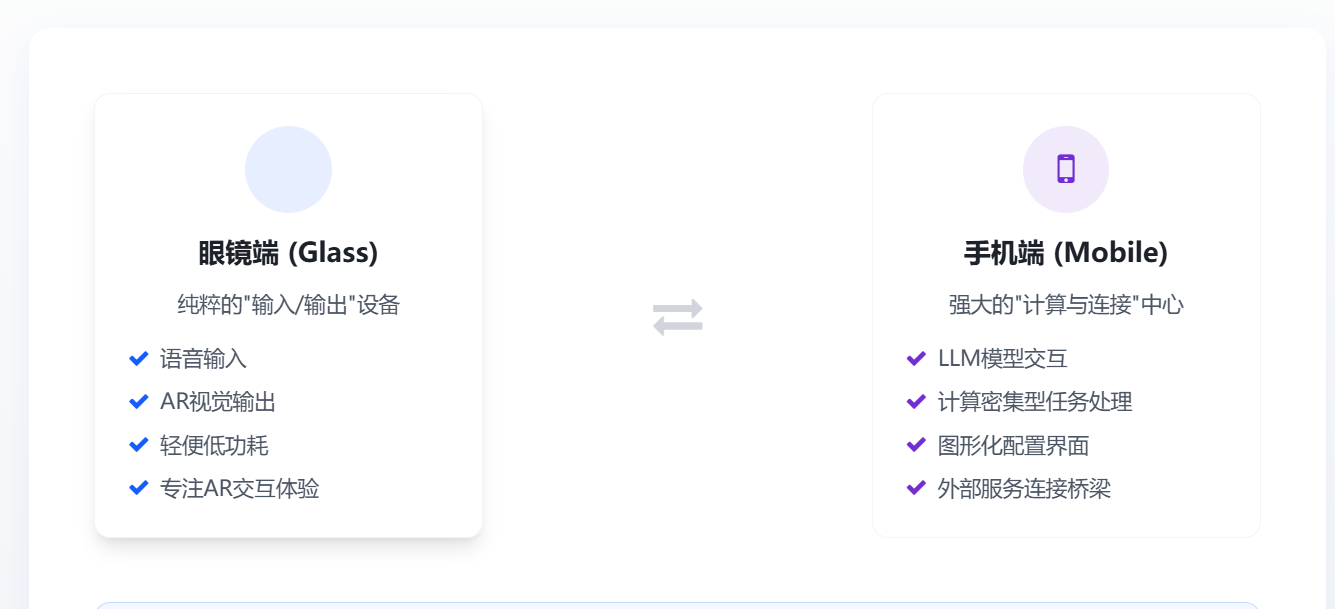

通过这套设计,我们将眼镜端(Glass)定位为纯粹的“输入/输出”设备,专注于提供最佳的 AR 交互体验;而将手机端作为强大的“计算与连接”中心。这种分工明确的架构,既能保证眼镜端的轻便与低功耗,又能充分利用手机的计算能力和生态,是当前阶段实现复杂 AR+AI 应用的最佳实践。

三、技术架构:眼镜与手机的“二重奏”

一个稳定、高效且可扩展的架构,是成功应用的基础。在“AI 编程助手”中,我们采用了**眼镜端(Glass)+ 手机端(Phone)**协同工作的分布式架构。这种架构充分利用了两种设备的优势,形成了一套“前台交互,后台计算”的经典模式。

1. 架构总览

下图清晰地展示了整个应用的数据流和组件关系:

核心流程说明:

- 用户输入: 用户通过 Rokid Glass 的麦克风发出语音指令,例如“Hey Rokid,什么是 RESTful API?”。

- 眼镜端处理:

- 眼镜内置的 语音识别模块(由 Rokid SDK 提供能力)将用户的语音实时转换为文本。

- 意图识别模块 对文本进行初步解析。如果是简单的本地指令(如“打开设置”、“返回”),则直接处理;如果是需要 AI 能力的复杂查询,则将文本指令通过蓝牙或 Wi-Fi 发送给手机端 App。

- 手机端处理:

- 手机 App 的 核心业务逻辑 模块接收到来自眼镜的文本指令。

- 它根据预设的规则,将用户的自然语言问题包装成一个结构化的 Prompt,这个 Prompt 会包含必要的上下文信息和格式要求,以便让 LLM 更好地理解意图。

- LLM Service 模块负责调用外部的云端大语言模型 API(如 OpenAI 的 GPT 系列、Google 的 Gemini、或者其他开源模型),并将构建好的 Prompt 发送出去。

- 在接收到 LLM 返回的结果后,核心业务逻辑模块会对其进行 解析和格式化,将其处理成适合在眼镜端展示的数据结构(例如,一个包含标题、文本和代码块的 JSON 对象)。

- 结果呈现:

- 格式化后的数据通过无线通信链路回传给眼镜端。

- 眼镜端的 UI 渲染模块 接收到数据后,根据预定义的 UI 模板,动态生成对应的 AR 界面。

- 最终,一个清晰、美观的问答卡片被渲染到 虚拟屏幕 上,呈现在用户眼前。

2. 技术选型与考量

-

眼镜端应用(Glass App):

- 开发模式: 纯眼镜端应用。我们将使用 Rokid 提供的原生 SDK(假设为 Java/Kotlin for Android)进行开发。

- 核心职责:

- 管理应用的生命周期。

- 调用 Rokid SDK 的

SpeechAPI 获取语音识别结果。 - 调用

DisplayAPI 在虚拟屏幕上渲染 UI。 - 维护与手机 App 的通信链路(使用蓝牙或 Wi-Fi P2P)。

- 设计原则: 保持轻量。眼镜端只做“显示器”和“麦克风”,避免任何耗时或计算密集型操作,以确保最佳的性能和续航。

-

手机端应用(Phone App):

- 开发框架: 可以选择原生开发(Android/iOS),也可以选择跨平台框架如 Flutter 或 React Native,以便未来扩展。这里我们以 原生 Android (Kotlin) 为例。

- 核心职责:

- 作为应用的“大脑”,实现所有复杂的业务逻辑。

- 集成大语言模型的 SDK 或直接通过 HTTP Client 调用其 API。

- 管理与眼镜端的通信。

- 提供设置界面,让用户可以配置 API Key、选择模型、管理历史记录等。

- 设计原则: 功能强大。手机端承担所有“重活”,包括网络请求、数据处理、缓存管理等。

-

通信协议:

- 选型: 蓝牙(Bluetooth Low Energy, BLE)或 Wi-Fi Direct。

- 考量:

- 蓝牙 BLE: 功耗低,连接相对稳定,适合传输指令和短文本等小数据包。是本应用场景的首选。

- Wi-Fi Direct: 传输速率高,适合传输图片、音视频等大数据。如果未来应用需要支持屏幕共享或摄像头视频流分析,可以考虑使用 Wi-Fi 作为补充。

- 数据格式: 使用 JSON 作为标准的数据交换格式。定义清晰的数据结构,如

QueryRequest和AnswerResponse,确保两端的数据解析一致。

通过这样的架构设计,我们成功地将一个复杂的 AR+AI 应用拆解成了两个高内聚、低耦合的子系统,使得开发、测试和未来的功能扩展都变得更加清晰和高效。

四、深入技术实现:用代码连接 AR 与 AI

重要声明: 本章节中的所有代码均为伪代码(Pseudo-code),旨在阐述核心设计思想与模块交互逻辑,并非可直接编译运行的生产代码。文中所提及的 Rokid SDK 相关类名(如

RokidSpeechManager)、方法及参数均为根据通用 SDK 设计模式进行的合理推断,可能与 Rokid 官方发布的最新 SDK 存在差异。在实际开发中,请务必以 Rokid 开发者中心提供的官方文档和代码示例 为最终依据。

理论的价值在于实践。在这一章节,我们将深入探讨眼镜端和手机端应用的核心代码实现,看看它们是如何通过 Rokid SDK 和网络通信,共同奏响这曲 AR 与 AI 的“二重奏”。

1. 数据契约:定义通信的语言

在开始编码前,首先要定义两端通信的数据格式。我们使用 JSON,并定义两个核心数据类:

// 1. 从眼镜 -> 手机的请求

data class QueryRequest(

val queryText: String, // 用户语音识别出的原始文本

val timestamp: Long // 请求时间戳

)

// 2. 从手机 -> 眼镜的响应

data class AnswerResponse(

val title: String, // 卡片标题,例如 "关于 @RestController"

val content: String, // 主要文本内容

val code: String? = null, // 可选的代码块

val status: String // 状态: "success", "error", "loading"

)

这个清晰的数据契约是两端协同工作的基础。

2. 眼镜端 App 核心实现 (Glass App)

眼镜端 App 的职责是:听、说、显示。

// GlassMainActivity.kt - 眼镜端主活动

class GlassMainActivity : Activity() {

private lateinit var speechManager: RokidSpeechManager // 假设的 Rokid 语音SDK管理器

private lateinit var displayManager: RokidDisplayManager // 假设的 Rokid 显示SDK管理器

private lateinit var communicationService: BluetoothService // 我们自己实现的蓝牙通信服务

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

// 1. 初始化服务

initSpeech();

initDisplay();

initCommunication();

}

// 初始化语音识别

private fun initSpeech() {

speechManager = RokidSpeechManager.getInstance()

speechManager.setWakeupWord("Hey Rokid") // 设置唤醒词

speechManager.setSpeechCallback(object : SpeechCallback {

// 当识别到最终结果时回调

override fun onSpeechResult(text: String) {

// 显示加载动画

displayManager.showCard(AnswerResponse(title = "思考中...", content = "", status = "loading"))

// 将识别到的文本通过蓝牙发送给手机

communicationService.sendQuery(QueryRequest(queryText = text, timestamp = System.currentTimeMillis()))

}

})

speechManager.start() // 启动语音服务

}

// 初始化显示管理器

private fun initDisplay() {

displayManager = RokidDisplayManager.getInstance(this)

}

// 初始化与手机的通信

private fun initCommunication() {

communicationService = BluetoothService.getInstance()

communicationService.setMessageListener(object : MessageListener {

// 当收到来自手机的消息时回调

override fun onAnswerReceived(response: AnswerResponse) {

// 在虚拟屏幕上显示收到的答案卡片

displayManager.showCard(response)

}

})

communicationService.connectToPhone()

}

}

代码解读:

initSpeech(): 我们配置并启动了RokidSpeechManager。设置了唤醒词“Hey Rokid”,并在onSpeechResult回调中获取识别出的文本。这是我们应用的“耳朵”。onSpeechResult(): 一旦识别到用户的完整问题,我们立即通过communicationService将其封装成QueryRequest对象发送给手机,并先在眼镜上显示一个“思考中”的加载状态。initCommunication(): 我们初始化了蓝牙服务,并设置了一个监听器。当手机处理完问题,将AnswerResponse发回时,onAnswerReceived会被触发。onAnswerReceived(): 在这个回调中,我们调用RokidDisplayManager.showCard(),将 AI 的答案渲染到虚拟屏幕上。这是我们应用的“嘴巴”和“画布”。

3. 手机端 App 核心实现 (Phone App)

手机端 App 是我们应用的“大脑”,负责处理所有重计算和网络任务。

// PhoneMainActivity.kt - 手机端主活动

class PhoneMainActivity : Activity() {

private lateinit var communicationService: BluetoothService // 与眼镜端配对的蓝牙服务

private lateinit var llmService: LLMService // 封装了LLM API调用的服务

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

// 1. 初始化服务

llmService = LLMService()

initCommunication();

}

// 初始化与眼镜的通信

private fun initCommunication() {

communicationService = BluetoothService.getInstance()

communicationService.setMessageListener(object : MessageListener {

// 当收到来自眼镜的查询时回调

override fun onQueryReceived(request: QueryRequest) {

// 使用协程在后台线程发起网络请求

GlobalScope.launch(Dispatchers.IO) {

try {

val answer = llmService.askLLM(request.queryText)

// 将获取到的答案发送回眼镜

communicationService.sendAnswer(answer)

} catch (e: Exception) {

// 如果出错,发送一个错误信息回眼镜

val errorResponse = AnswerResponse(title = "出错了", content = e.message ?: "未知错误", status = "error")

communicationService.sendAnswer(errorResponse)

}

}

}

})

communicationService.startListening() // 开始监听来自眼镜的连接

}

}

// LLMService.kt - 负责与大语言模型API交互

class LLMService {

private val httpClient = OkHttpClient()

private val llmApiEndpoint = "https://api.example-llm.com/v1/chat"

private val apiKey = "YOUR_API_KEY" // 用户的API Key

suspend fun askLLM(query: String): AnswerResponse {

// 1. 构建 Prompt

val prompt = "你是一个资深的软件开发专家。请用简洁、清晰的语言回答以下问题,如果适合,请提供代码示例。

问题:$query"

// 2. 构建网络请求

val requestBody = """

{

"model": "gpt-4-turbo",

"messages": [{"role": "user", "content": "$prompt"}]

}

""".trimIndent()

val request = Request.Builder()

.url(llmApiEndpoint)

.header("Authorization", "Bearer $apiKey")

.post(requestBody.toRequestBody("application/json".toMediaType()))

.build()

// 3. 发起异步请求并等待结果

val response = httpClient.newCall(request).execute()

// 4. 解析LLM的返回结果,并将其转换为我们定义的 AnswerResponse 格式

val llmResult = parseLLMResponse(response.body?.string()) // parseLLMResponse 是一个自定义的解析函数

return llmResult

}

// ... parseLLMResponse(...) 实现细节省略 ...

}

代码解读:

initCommunication(): 手机端的蓝牙服务处于监听状态。一旦收到来自眼镜的QueryRequest,onQueryReceived回调就会被触发。onQueryReceived(): 我们立即启动一个后台协程来处理这个请求,避免阻塞主线程。这是 Android 开发中处理网络请求的标准做法。LLMService.askLLM(): 这是与 AI 交互的核心。- 构建 Prompt:我们不仅仅是把用户的问题直接发给 AI,而是在前面加上了一段“角色扮演”的指令(“你是一个资深的软件开发专家…”),这被称为 Prompt Engineering,可以极大地提升 AI 回答的专业性和准确性。

- 网络请求:使用 OkHttp 构建一个标准的 POST 请求,调用云端 LLM 的 API。

- 解析结果:在拿到 API 的 JSON 返回后,我们需要写一个解析函数

parseLLMResponse,从中提取出我们需要的内容,并填充到AnswerResponse对象中。

- 错误处理:在

try-catch块中,我们捕获了可能发生的网络异常或 API 错误,并将一个格式化的错误信息返回给眼镜端,提升了应用的鲁棒性。

通过以上代码,我们完成了一个从语音输入到 AR 显示的完整闭环。这个实现虽然是伪代码,但它清晰地展示了开发一个真实 AR+AI 应用所需的技术栈、关键步骤和设计思想。

五、探讨 AI 工作流:从“问答”到“执行”

如果说即时问答是“AI 编程助手”的基础,那么 AI 工作流(AI Workflow) 则是它通往真正智能的阶梯。简单的问答只是被动地响应知识,而工作流则意味着应用能够理解用户的 意图,并主动地、结构化地完成一系列 任务。

1. 什么是 AI 工作流?

在我们的应用中,AI 工作流指的是:将用户的复杂指令分解为一系列预定义的、可由 AI 执行的原子任务,并通过程序化的方式组合和调用,最终完成一个特定目标。

例如,当用户说:“Hey Rokid,帮我用 Java 写一个线程安全的懒汉式单例模式”,一个简单的大模型可能会直接返回一段代码。但一个基于工作流的应用会这样做:

- 意图识别: 从指令中识别出核心意图是

GENERATE_CODE(生成代码)。 - 参数提取: 提取出关键参数:

language: "Java",pattern: "Singleton",type: "Thread-safe Lazy-loading"。 - 模板调用: 激活一个专门用于生成设计模式代码的 Prompt 模板,并将提取的参数填入其中。

- 质量增强: 在 Prompt 中额外增加指令,要求 AI “为代码添加详细的注释”、“解释为什么这样实现是线程安全的”以及“提供一个测试该单例的 main 函数示例”。

- 格式化输出: 将 AI 返回的结果解析成一个结构化的

AnswerResponse对象,其中title是“Java 线程安全懒汉单例”,content是解释,code是代码块。

这个过程,就是一个简单的 AI 工作流。它将一个模糊的用户需求,转化成了一个精准、高质量的工程输出。

2. 在手机端构建工作流引擎

我们的工作流引擎将构建在手机 App 的“核心业务逻辑”层。下面是一个简化的实现思路:

// IntentRecognizer.kt - 简单的意图识别器

object IntentRecognizer {

fun recognize(text: String): Pair<String, Map<String, String>> {

val lowerText = text.toLowerCase()

return when {

lowerText.contains("写一个") || lowerText.contains("生成") -> {

"GENERATE_CODE" to extractParamsForGeneration(lowerText)

}

lowerText.startsWith("解释") || lowerText.startsWith("分析") -> {

"EXPLAIN_CODE" to mapOf("target" to text)

}

// ... 其他意图规则

else -> "GENERAL_QA" to mapOf("query" to text)

}

}

// ... extractParamsForGeneration 的实现细节省略

}

// WorkflowEngine.kt - 工作流引擎

class WorkflowEngine(private val llmService: LLMService) {

suspend fun execute(intent: String, params: Map<String, String>): AnswerResponse {

return when (intent) {

"GENERATE_CODE" -> executeGenerateCodeWorkflow(params)

"EXPLAIN_CODE" -> executeExplainCodeWorkflow(params)

"GENERAL_QA" -> llmService.askLLM(params["query"] ?: "")

else -> AnswerResponse(title = "错误", content = "无法理解的指令", status = "error")

}

}

private suspend fun executeGenerateCodeWorkflow(params: Map<String, String>): AnswerResponse {

val language = params["language"] ?: "通用"

val feature = params["feature"] ?: "代码"

// 1. 使用专门的Prompt模板

val prompt = PromptTemplates.generateCode(language, feature)

// 2. 调用LLM Service

val result = llmService.askLLMWithPrompt(prompt)

// 3. 对结果进行后处理,例如代码高亮、格式化等

return postProcessCode(result)

}

// ... 其他工作流的实现 ...

}

// 在 PhoneMainActivity 中使用

// ...

override fun onQueryReceived(request: QueryRequest) {

GlobalScope.launch(Dispatchers.IO) {

// 1. 意图识别

val (intent, params) = IntentRecognizer.recognize(request.queryText)

// 2. 执行对应的工作流

val answer = workflowEngine.execute(intent, params)

communicationService.sendAnswer(answer)

}

}

代码解读:

IntentRecognizer: 这是一个简陋但有效的意图识别器。在实际应用中,这里可以替换为更复杂的 NLP 模型,甚至可以让另一个 LLM 来做意图识别。WorkflowEngine: 这是工作流的核心。它根据识别出的intent,分发到不同的处理函数中。executeGenerateCodeWorkflow: 每一个execute...函数都代表一个工作流。它负责:- 选择并填充 Prompt 模板:这是保证输出质量的关键。我们可以为不同任务(代码生成、Bug 分析、代码重构)设计不同的、高度优化的 Prompt。

- 调用 LLM:将精心构建的 Prompt 发送给大模型。

- 后处理(Post-processing):对 LLM 返回的原始文本进行加工,例如提取代码块、添加语法高亮标记、转换 Markdown 格式等,使其更适合在 AR 眼镜上展示。

3. Prompt Engineering 的艺术

工作流的灵魂在于 Prompt Engineering。一个好的 Prompt 应该像一份清晰的“任务需求文档”。

以“Bug 分析”工作流为例,一个好的 Prompt 模板可能长这样:

角色: 你是一位拥有超过20年经验的资深系统架构师,尤其擅长高并发系统的故障排查。

背景: 我在开发一个 [语言] 应用时遇到了一个错误。这是错误的堆栈信息:

[用户提供的错误堆栈]这是可能相关的代码片段:

[用户提供的代码片段,未来可通过摄像头或屏幕共享获取]任务:

- 根本原因分析: 请分析导致这个错误最可能的 3 个根本原因,并按可能性从高到低排序。

- 解决方案: 针对每个原因,提供一个具体的、可操作的解决方案,并附上修正后的代码示例。

- 预防措施: 提供 1-2 条建议,帮助我未来避免同类错误。

输出格式: 请严格按照以下 Markdown 格式返回,不要有任何多余的寒暄。

### Bug 分析报告 **错误类型:** `[AI自动识别的错误类型]` --- #### 可能性最高的根本原因 **分析:** ... **解决方案:** ```[语言] // 修正后的代码 …… ## 第二种可能的原因 …… --- `

通过这样结构化、角色化、任务化的 Prompt,我们不再是“请求”AI,而是在“指挥”AI,让它像一个真正的专家团队一样,为我们提供一份详尽、专业的分析报告。

六、总结与展望:开启“空间计算”的开发者新纪元

1. 实践总结

通过本次从 0 到 1 构建“AI 编程助手”的实践,我们不仅探索了 Rokid Glass 作为下一代信息交互终端的巨大潜力,也验证了一套切实可行的 AR+AI 应用开发范式。

我们的核心收获包括:

- 架构模式的验证: “眼镜端轻交互 + 手机端重计算”的分布式架构,在当前硬件和网络条件下,是平衡性能、功耗和功能复杂度的最优解。它使得 AR 眼镜可以保持轻便和长续航,同时又能借助手机强大的计算和连接能力,实现媲美桌面级的 AI 应用体验。

- SDK 的价值: Rokid 提供的 SDK 在整个开发流程中扮演了至关重要的角色。它屏蔽了复杂的硬件驱动细节,让我们能以熟悉的 Android 开发模式,轻松调用语音识别、空间显示等核心 AR 功能,极大地降低了开发门槛,使开发者可以将精力聚焦于应用逻辑和创意的实现。

- 工作流的威力: 我们证明了,通过精巧的意图识别和 Prompt Engineering,我们可以将大语言模型从一个“聊天机器人”升级为一个“任务执行引擎”。这为开发更强大、更智能的 AR+AI 应用开辟了广阔的想象空间。

2. 未来展望

我们所构建的“AI 编程助手”仅仅是一个开始,一个对未来工作方式的初步探索。站在“空间计算”时代的黎明,我们能看到更多激动人心的可能性正在地平线上升起:

-

多模态输入的融合: 未来的 AI 助手将不仅仅能“听”,更能“看”。结合 Rokid Glass 的摄像头,AI 将能够实时识别我们眼前的物理世界。

- AR 实时翻译: 看到一段外文菜单或路牌,眼镜中直接浮现出翻译好的母语。

- 可视化编程: 看着屏幕上的 UI 设计图,直接对 AI 说:“帮我用 SwiftUI 实现这个登录界面”,AI 识别图像并自动生成代码。

- 物理世界交互: 看着一台复杂的服务器,AI 能识别出型号,并直接在你的视野中叠加出它的端口说明和操作手册。

-

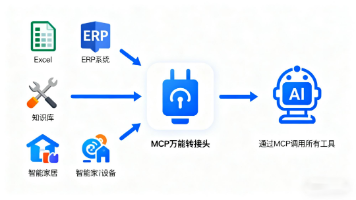

更深度的系统集成: AI 助手将与操作系统和第三方应用进行更深度的集成,成为一个无处不在的“超级入口”。

- 连接开发工具链: 在 IDE 中收到报错,AI 助手自动帮你创建 Jira Ticket,关联到对应的代码文件,并 @ 相关的同事。

- 联动企业知识库: 询问公司内部的技术规范或业务流程,AI 助手直接从 Confluence 或内部文档中检索并给出答案。

-

从“助手”到“代理”(Agent): 最终,AI 将从一个被动响应的“助手”,进化为一个能够理解复杂目标、自主规划和执行任务的“智能代理”。你或许只需要对它说:“发布这个新功能”,它就会自动完成运行测试、代码打包、部署上线、发布通知等一系列操作。

结语

我们正处在一个波澜壮阔的技术变革前夜。AR 眼镜为我们打开了通往“空间计算”的大门,而 AI 则为这个新世界注入了灵魂。像 Rokid Glass 这样的设备,以及它背后开放的开发者生态,正在为我们这一代开发者提供前所未有的机遇——我们不再仅仅是为屏幕编写程序的工程师,我们正在成为构建数字世界与物理世界桥梁的建筑师。

希望本文的探索能为你带来启发。让我们一起戴上想象力的眼镜,用代码去创造那个属于所有人的、更加智能、更加便捷的未来。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)