YOLOv11 改进 - 注意力机制 | ContextAggregation上下文聚合模块:多尺度上下文信息融合机制,增强小目标特征判别力

本文介绍了CONTAINER(上下文聚合网络)及其在YOLOv11中的结合应用。CONTAINER是一个多头上下文聚合的通用构建模块,提供了统一视角,将CNNs、Transformers和MLP - Mixers视为聚合空间上下文方法的特例。它能利用长程交互,同时利用局部卷积操作的归纳偏差,实现更快收敛。该模块通过可学习参数结合静态和动态亲和矩阵进行上下文聚合。我们将ContextAggregat

前言

本文介绍了CONTAINER(上下文聚合网络)及其在YOLOv11中的结合应用。CONTAINER是一个多头上下文聚合的通用构建模块,提供了统一视角,将CNNs、Transformers和MLP - Mixers视为聚合空间上下文方法的特例。它能利用长程交互,同时利用局部卷积操作的归纳偏差,实现更快收敛。该模块通过可学习参数结合静态和动态亲和矩阵进行上下文聚合。我们将ContextAggregation模块集成进YOLOv11,替代部分原有模块。

文章目录: YOLOv11改进大全:卷积层、轻量化、注意力机制、损失函数、Backbone、SPPF、Neck、检测头全方位优化汇总

专栏链接: YOLOv11改进专栏

文章目录

介绍

摘要

卷积神经网络(CNNs)在计算机视觉领域占据主导地位,并衍生出众多高效架构变体。近年来,源于自然语言处理(NLP)的Transformer架构逐渐被引入计算机视觉应用,早期研究仍采用CNN骨干网络,而最新进展则转向端到端无CNN的纯Transformer解决方案。值得关注的是,近期研究表明基于简单多层感知机(MLP)的架构即使不包含传统卷积或Transformer组件,亦能生成有效的视觉表征。尽管CNNs、Transformers及MLP-Mixers在形式上呈现显著差异,本文提出统一理论框架,揭示这些架构实则为神经网络堆栈中空间上下文聚合通用方法的特例。基于此理论洞察,我们提出了CONTAINER(上下文聚合网络)架构,该通用构建模块采用多头上下文聚合机制,既能如Transformer般有效捕获长程依赖关系,又保留了局部卷积操作的归纳偏置优势,从而实现了CNN特有的快速收敛特性。实验结果表明,CONTAINER架构在ImageNet数据集上仅使用22M参数即达到82.7%的Top-1准确率,较DeiT-Small提升2.8个百分点,且仅需200训练周期即可收敛至79.9%的Top-1准确率。相较于基于Transformer的方法在大尺度输入图像下游任务中存在的扩展性局限,我们提出的高效网络CONTAINER-LIGHT可无缝集成于DETR、RetinaNet和Mask-RCNN等目标检测与实例分割框架,在检测mAP指标上分别达到38.9、43.8和45.1,掩码mAP达到41.3,相比同等计算复杂度与参数规模的ResNet-50骨干网络分别提升6.6、7.3、6.9和6.6个百分点。在自监督学习方面,与DeiT在DINO框架下的性能对比也显示出显著优势。相关代码已在GitHub平台开源发布。

文章链接

论文地址:论文地址

代码地址:代码地址

基本原理

关键组成部分和机制

-

输入表示:

- 输入图像表示为 X ∈ R C × H × W X \in \mathbb{R}^{C \times H \times W} X∈RC×H×W,其中 C C C 是通道数, H × W H \times W H×W 是空间维度。该图像被展平为一系列标记 { X i ∈ R C ∣ i = 1 , … , N } \{X_i \in \mathbb{R}^C | i = 1, \ldots, N\} {Xi∈RC∣i=1,…,N},其中 N = H × W N = H \times W N=H×W。

-

亲和矩阵:

-

定义亲和矩阵 A ∈ R N × N A \in \mathbb{R}^{N \times N} A∈RN×N 以表示上下文聚合的邻域。该矩阵决定了信息在特征空间中的传播方式。聚合函数可以表示为:

Y = ( A V ) W 1 + X , Y = (A V) W_1 + X, Y=(AV)W1+X,其中 V ∈ R N × C V \in \mathbb{R}^{N \times C} V∈RN×C 是通过线性投影 V = X W 2 V = X W_2 V=XW2 从 X X X 获得的变换版本。 W 1 W_1 W1 和 W 2 W_2 W2 是可学习参数。

-

-

多头聚合:

-

为了增加建模能力,使用多个亲和矩阵,创建几条上下文信息的路径。多头版本的聚合函数为:

Y = Concat ( A 1 V 1 , … , A M V M ) W 2 + X , Y = \text{Concat}(A_1 V_1, \ldots, A_M V_M) W_2 + X, Y=Concat(A1V1,…,AMVM)W2+X,其中每个 A m A_m Am (对 m = 1 , … , M m = 1, \ldots, M m=1,…,M)是表示特征空间内不同关系的亲和矩阵,增强了相比单头版本的表示能力。

-

-

不同架构中的上下文聚合:

-

Transformers:利用基于投影的query-key对之间相似性动态生成的亲和矩阵。自注意机制可以表示为:

A s a m = Softmax ( Q m K m T C / M ) , A_{sa}^m = \text{Softmax}\left(\frac{Q_m K_m^T}{\sqrt{C/M}}\right), Asam=Softmax(C/MQmKmT),

其中 Q m Q_m Qm 和 K m K_m Km 是query和key投影。这种方法捕捉实例级信息,但计算密集。 -

深度卷积:并行融合空间和通道信息,使用从卷积核导出的静态和稀疏亲和矩阵。这种方法高效且适合捕捉局部上下文。

-

MLP-Mixer:使用转置MLP操作进行上下文聚合,具有密集亲和矩阵:

A m l p = ( W M L P ) T , A_{mlp} = (W_{MLP})^T, Amlp=(WMLP)T,

其中 W M L P W_{MLP} WMLP 是可学习参数。

-

-

统一框架:CONTAINER:

- CONTAINER(上下文聚合网络)模块通过可学习参数结合静态和动态亲和矩阵,提供灵活而强大的上下文聚合方法。一般形式为:

Y = ( α A ( X ) + β A ) V W 2 + X , Y = (\alpha A(X) + \beta A)V W_2 + X, Y=(αA(X)+βA)VW2+X,

其中 A ( X ) A(X) A(X) 是动态亲和矩阵, A A A 是静态亲和矩阵。 α \alpha α 和 β \beta β 是可学习参数。

- CONTAINER(上下文聚合网络)模块通过可学习参数结合静态和动态亲和矩阵,提供灵活而强大的上下文聚合方法。一般形式为:

核心代码

YOLOv11引入代码

在根目录下的ultralytics/nn/目录,新建一个 attention目录,然后新建一个以 ContextAggregation为文件名的py文件, 把代码拷贝进去。

需要安装mmvc,建议百度安装,容易失败!

import torch

import torch.nn as nn

from mmcv.cnn import ConvModule

from mmcv.cnn import ConvModule, caffe2_xavier_init, constant_init

class ContextAggregation(nn.Module):

def __init__(self, in_channels, reduction=1):

super(ContextAggregation, self).__init__()

self.in_channels = in_channels

self.reduction = reduction

self.inter_channels = max(in_channels // reduction, 1)

conv_params = dict(kernel_size=1, act_cfg=None)

self.a = ConvModule(in_channels, 1, **conv_params)

self.k = ConvModule(in_channels, 1, **conv_params)

self.v = ConvModule(in_channels, self.inter_channels, **conv_params)

self.m = ConvModule(self.inter_channels, in_channels, **conv_params)

self.init_weights()

def init_weights(self):

for m in (self.a, self.k, self.v):

caffe2_xavier_init(m.conv)

constant_init(self.m.conv, 0)

def forward(self, x):

n = x.size(0)

c = self.inter_channels

a = self.a(x).sigmoid()

k = self.k(x).view(n, 1, -1, 1).softmax(2)

v = self.v(x).view(n, 1, c, -1)

y = torch.matmul(v, k).view(n, c, 1, 1)

y = self.m(y) * a

return x + y

注册

在ultralytics/nn/tasks.py中进行如下操作:

步骤1:

from ultralytics.nn.attention.ContextAggregation import ContextAggregation

步骤2

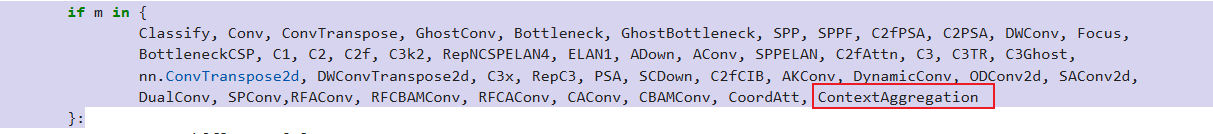

修改def parse_model(d, ch, verbose=True):

if m in {

Classify, Conv, ConvTranspose, GhostConv, Bottleneck, GhostBottleneck, SPP, SPPF, C2fPSA, C2PSA, DWConv, Focus,

BottleneckCSP, C1, C2, C2f, C3k2, RepNCSPELAN4, ELAN1, ADown, AConv, SPPELAN, C2fAttn, C3, C3TR, C3Ghost,

nn.ConvTranspose2d, DWConvTranspose2d, C3x, RepC3, PSA, SCDown, C2fCIB, AKConv, DynamicConv, ODConv2d, SAConv2d,

DualConv, SPConv,RFAConv, RFCBAMConv, RFCAConv, CAConv, CBAMConv, CoordAtt, ContextAggregation

}:

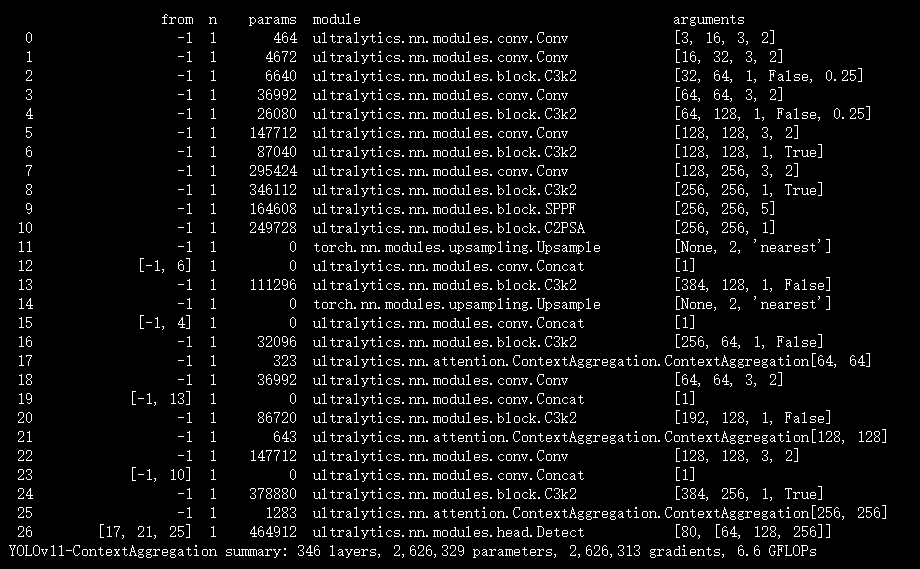

配置yolov11-ContextAggregation.yaml

ultralytics/cfg/models/11/yolov11-ContextAggregation.yaml

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLO11 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolo11n.yaml' will call yolo11.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.50, 0.25, 1024] # summary: 319 layers, 2624080 parameters, 2624064 gradients, 6.6 GFLOPs

s: [0.50, 0.50, 1024] # summary: 319 layers, 9458752 parameters, 9458736 gradients, 21.7 GFLOPs

m: [0.50, 1.00, 512] # summary: 409 layers, 20114688 parameters, 20114672 gradients, 68.5 GFLOPs

l: [1.00, 1.00, 512] # summary: 631 layers, 25372160 parameters, 25372144 gradients, 87.6 GFLOPs

x: [1.00, 1.50, 512] # summary: 631 layers, 56966176 parameters, 56966160 gradients, 196.0 GFLOPs

# YOLO11n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 2, C3k2, [256, False, 0.25]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 2, C3k2, [512, False, 0.25]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 2, C3k2, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 2, C3k2, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

- [-1, 2, C2PSA, [1024]] # 10

# YOLO11n head

head:

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 2, C3k2, [512, False]] # 13

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 2, C3k2, [256, False]] # 16 (P3/8-small)

- [-1, 1, ContextAggregation, [256]] #17

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 13], 1, Concat, [1]] # cat head P4

- [-1, 2, C3k2, [512, False]] # 20 (P4/16-medium)

- [-1, 1, ContextAggregation, [512]] # 21

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 10], 1, Concat, [1]] # cat head P5

- [-1, 2, C3k2, [1024, True]] # 24 (P5/32-large)

- [-1, 1, ContextAggregation, [1024]] # 25

- [[17, 21, 25], 1, Detect, [nc]] # Detect(P3, P4, P5)

实验

脚本

import warnings

warnings.filterwarnings('ignore')

from ultralytics import YOLO

if __name__ == '__main__':

# 修改为自己的配置文件地址

model = YOLO('/root/ultralytics-main/ultralytics/cfg/models/11/yolov11-ContextAggregation.yaml')

# 修改为自己的数据集地址

model.train(data='/root/ultralytics-main/ultralytics/cfg/datasets/coco8.yaml',

cache=False,

imgsz=640,

epochs=10,

single_cls=False, # 是否是单类别检测

batch=8,

close_mosaic=10,

workers=0,

optimizer='SGD',

amp=True,

project='runs/train',

name='ContextAggregation',

)

结果

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)