电动汽车车队虚拟发电厂的强化学习控制策略探索

电动汽车车队虚拟发电厂的强化学习控制策略本论文基于 RL 代理的开发,该代理通过家庭环境中的电动汽车充电站管理 VPP。VPP 的主要优化目标是:填谷、削峰和随时间推移实现零负荷(供需负荷平衡)。为实现目标而采取的主要行动是:储存可再生能源资源并在高需求时向电网中推电。虚拟发电厂环境的开发基于 DAI-Labor 的 ELVIS(电动汽车基础设施模拟器)。大纲:本研究旨在研究一般家庭能源生产和储存

电动汽车车队虚拟发电厂的强化学习控制策略 本论文基于 RL 代理的开发,该代理通过家庭环境中的电动汽车充电站管理 VPP。 VPP 的主要优化目标是:填谷、削峰和随时间推移实现零负荷(供需负荷平衡)。 为实现目标而采取的主要行动是:储存可再生能源资源并在高需求时向电网中推电。 虚拟发电厂环境的开发基于 DAI-Labor 的 ELVIS(电动汽车基础设施模拟器)。 大纲: 本研究旨在研究一般家庭能源生产和储存的可持续生活方式。 本论文的主要目标是探索自给自足能源系统的边界,该系统的电力来自电网且费用最低。 能源生产手段是光伏太阳能电池板模块和家用风力涡轮机。 存储系统基于电动汽车电池。 RL 代理将负责管理电动汽车的电力资源,以保证电动汽车离开时剩余的最低电量,并优化电网的调峰和填谷。

在追求可持续能源生活方式的浪潮中,电动汽车车队虚拟发电厂(VPP)的强化学习控制策略成为了一个极具吸引力的研究领域。今天咱们就来深入探讨一下相关内容。

研究背景与目标

本研究的大方向是探究一般家庭能源生产和储存的可持续生活方式。核心目标呢,是探索自给自足能源系统的边界,而且得是从电网获取电力费用最低的那种。想象一下,自家的能源系统既能满足日常用电,还能在费用上精打细算,是不是很美好?

实现这一目标,咱们得靠多种能源生产和存储手段。能源生产这边,光伏太阳能电池板模块和家用风力涡轮机挑起大梁。存储系统则基于电动汽车电池,这就把电动汽车和家庭能源管理紧密联系起来啦。

VPP 的优化目标

VPP 有几个关键的优化目标,分别是填谷、削峰以及随时间推移达成零负荷,也就是供需负荷平衡。填谷,就是在用电低谷的时候储存多余的电能;削峰则是在用电高峰减少对电网的依赖,降低峰值负荷。而零负荷,就是让家庭的能源供需达到一个完美的平衡状态。

达成目标的行动策略

为了实现这些目标,主要采取的行动是储存可再生能源资源,并在高需求时向电网中推电。这就像是一个聪明的管家,在能源富裕的时候存起来,需要的时候再拿出来用。

RL 代理的关键作用

这里 RL 代理可是重中之重。它负责管理电动汽车的电力资源,不仅要保证电动汽车离开时剩余最低电量,让车主不用担心车没电,还得优化电网的调峰和填谷。

咱们来简单看段代码示例(以 Python 和简单的强化学习框架为例):

import numpy as np

# 定义状态空间,例如包括当前电量、时间、电价等信息

class State:

def __init__(self, current_battery_level, time_of_day, electricity_price):

self.current_battery_level = current_battery_level

self.time_of_day = time_of_day

self.electricity_price = electricity_price

# 定义动作空间,例如充电、放电、不操作

ACTION_CHARGE = 0

ACTION_DISCHARGE = 1

ACTION_IDLE = 2

# RL 代理类

class RLAgent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.q_table = np.zeros((state_size, action_size))

def choose_action(self, state):

# 简单的贪心策略,实际应用可能更复杂

return np.argmax(self.q_table[state])

# 虚拟发电厂环境类

class VPPEnvironment:

def __init__(self, initial_battery_level, max_battery_level):

self.current_battery_level = initial_battery_level

self.max_battery_level = max_battery_level

def step(self, action):

if action == ACTION_CHARGE:

if self.current_battery_level < self.max_battery_level:

self.current_battery_level += 1

reward = -1 # 充电消耗成本,奖励为负

else:

reward = -10 # 电池已满还充电,给予较大惩罚

elif action == ACTION_DISCHARGE:

if self.current_battery_level > 0:

self.current_battery_level -= 1

reward = 1 # 放电获得收益,奖励为正

else:

reward = -10 # 电池没电还放电,给予较大惩罚

else:

reward = 0 # 不操作奖励为0

# 简单返回下一状态信息

next_state = State(self.current_battery_level, 0, 0)

return next_state, reward

代码分析

- 状态空间定义:

State类定义了状态空间,包含当前电池电量currentbatterylevel、时间timeofday和电价electricity_price等关键信息。这些信息对于 RL 代理做出决策至关重要,比如在电价低的时候充电更划算。 - 动作空间定义:通过定义

ACTIONCHARGE、ACTIONDISCHARGE和ACTION_IDLE来明确代理可以采取的动作,充电、放电或者不操作。 - RL 代理类:

RLAgent类初始化了 Q 表qtable,Q 表用于存储在每个状态下采取不同动作的预期奖励值。chooseaction方法目前采用简单的贪心策略,即选择 Q 值最大的动作,实际应用中可以采用更复杂的探索 - 利用平衡策略,如 ε - 贪心策略等。 - 虚拟发电厂环境类:

VPPEnvironment类模拟了虚拟发电厂的环境。step方法根据代理采取的动作更新环境状态,并返回相应的奖励。比如充电时消耗成本奖励为负,放电获得收益奖励为正,如果违反电池电量限制则给予较大惩罚。

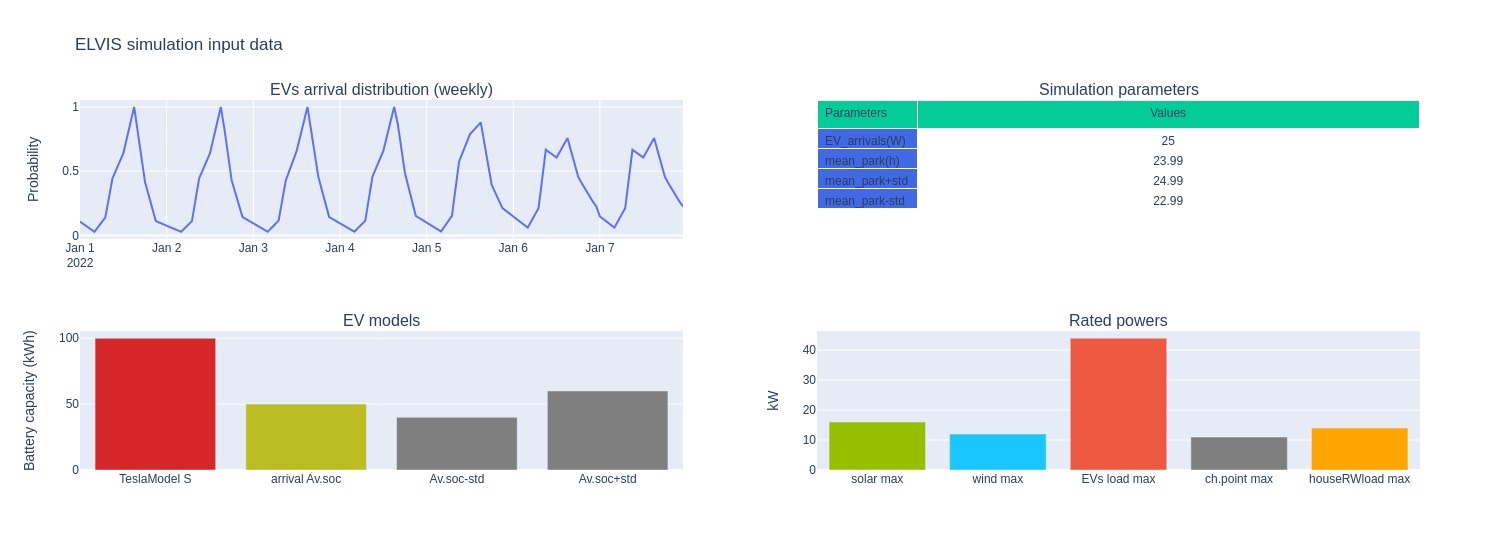

虚拟发电厂环境开发

虚拟发电厂环境的开发基于 DAI - Labor 的 ELVIS(电动汽车基础设施模拟器)。这个模拟器为我们搭建虚拟发电厂环境提供了便利,能更真实地模拟电动汽车充电、能源交互等场景,让我们的 RL 代理在接近实际的环境中学习和优化策略。

通过对电动汽车车队虚拟发电厂强化学习控制策略的研究,我们有望在未来实现更加智能、高效且经济的家庭能源管理,推动可持续能源生活方式的广泛应用。希望今天的分享能让大家对这个有趣的领域有更深入的了解。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)