【每天一个AI小知识】:什么是门控循环单元?

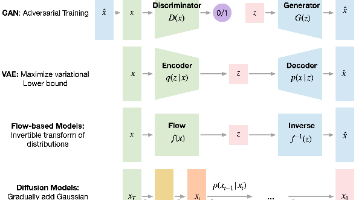

摘要:门控循环单元(GRU)是LSTM的简化版本,通过将遗忘门和输入门合并为更新门、取消输出门并引入重置门,实现了参数减少33%的高效记忆管理。GRU保持了LSTM处理长期依赖的能力,在自然语言处理、语音识别等领域表现优异,特别适合实时性要求高或资源受限的场景。虽然对超长序列的处理略逊于LSTM,但其训练速度快、结构简洁的优势使其成为深度学习中的重要选择。GRU的设计体现了"简化即高效&

目录

一、记忆的简化:从复杂门控到高效智能

1.1 引子:茶馆里的续篇

在上一期的故事中,我们认识了记忆茶馆里的老先生,他用河流比喻记忆,解释了长短期记忆网络(LSTM)如何像河流一样管理记忆。今天,当我们再次来到茶馆时,发现老先生正在和一位年轻人讨论着什么。

"LSTM虽然强大,但就像一条蜿蜒复杂的大河,管理起来需要太多的闸门和河道,"年轻人皱着眉头说,"有没有更简洁高效的方式来管理记忆呢?"

老先生笑了笑,指了指茶馆角落的一个竹制茶壶:"你看这个茶壶,它只有一个壶盖和一个壶嘴,却能很好地控制茶水的进出。有时候,简单反而更高效。"

这个故事,正是门控循环单元(GRU)的设计理念——在保持LSTM核心功能的同时,通过简化门控机制,实现更高效的记忆管理。

1.2 LSTM的困境:复杂带来的代价

虽然LSTM解决了传统RNN的长期依赖问题,但它的复杂性也带来了一些挑战:

- 参数过多:LSTM有三个门控(遗忘门、输入门、输出门)和一个记忆细胞,参数数量庞大

- 计算复杂:每个时间步都需要进行大量的矩阵运算,训练和推理速度较慢

- 调参困难:过多的参数导致模型难以调优,容易出现过拟合

- 内存占用大:需要存储大量的中间状态,不适合资源受限的设备

正是这些问题,催生了GRU的诞生——一种更简洁、更高效的循环神经网络变体。

二、GRU的诞生:记忆管理的轻量化革命

2.1 GRU的基本概念

门控循环单元(Gated Recurrent Unit,简称GRU)是由Cho等人在2014年提出的一种循环神经网络变体。它的核心思想是:简化LSTM的门控机制,同时保持其强大的记忆能力。

GRU的主要创新点包括:

- 将LSTM的遗忘门和输入门合并为一个"更新门"

- 取消了LSTM的输出门,将细胞状态和隐藏状态合并

- 引入了"重置门"来控制历史信息的影响

这些简化使得GRU的参数数量比LSTM减少了约33%,同时保持了相似的记忆能力。

2.2 GRU的核心结构

GRU的核心结构比LSTM简单,主要包含三个组件:

- 重置门(Reset Gate):决定如何结合历史信息和当前输入

- 更新门(Update Gate):决定保留多少历史信息和添加多少新信息

- 隐藏状态(Hidden State):同时承担记忆存储和信息输出的角色

这些组件协同工作,实现了GRU的记忆管理功能。

三、GRU的工作原理:简化而不简单的记忆管理

3.1 重置门:历史信息的过滤器

重置门的作用是控制历史信息对当前决策的影响程度。它的工作原理如下:

工作原理:

- 输入:当前时刻的输入 (

) 和上一时刻的隐藏状态 (

)

- 输出:一个0到1之间的值,1表示完全保留历史信息,0表示完全忽略历史信息

- 数学公式:

其中 () 是sigmoid激活函数,将值压缩到0-1之间

示例:在句子"我喜欢吃苹果,你喜欢吃____"中,当处理"你"这个词时,重置门会帮助网络弱化"我"的信息,因为当前的主语已经改变。

3.2 更新门:记忆的新旧平衡器

更新门是GRU的核心,它同时承担了LSTM中遗忘门和输入门的角色,决定了历史信息的保留程度和新信息的添加程度。

工作原理:

- 输入:当前时刻的输入 (

) 和上一时刻的隐藏状态 (

)

- 输出:一个0到1之间的值,1表示完全保留历史信息,0表示完全使用新信息

- 数学公式:

示例:在句子"今天天气很好,我们去____"中,当处理"去"这个词时,更新门会帮助网络保留"今天天气很好"的信息,同时添加"我们去"的新信息。

3.3 候选隐藏状态:新信息的生成器

候选隐藏状态用于生成可能被添加到隐藏状态中的新信息,它会受到重置门的影响。

工作原理:

- 输入:当前时刻的输入 (

) 和经过重置门过滤的历史隐藏状态 (

)

- 输出:一个包含新信息的候选隐藏状态

- 数学公式:

这里使用tanh函数是为了将值压缩到-1到1之间

示例:在处理"去"这个词时,候选隐藏状态会生成与"去"相关的动作信息,如"公园"、"散步"、"旅行"等。

3.4 隐藏状态更新:记忆的最终整合

隐藏状态是GRU中唯一的记忆载体,它的更新结合了历史信息和新生成的候选信息。

工作原理:

- 输入:上一时刻的隐藏状态 (

)、更新门 (

) 和候选隐藏状态 (

)

- 输出:新的隐藏状态 (

)

- 数学公式:

这个公式可以理解为:

-

:根据更新门保留的历史信息

:根据更新门添加的新信息

示例:在预测句子的最后一个词时,隐藏状态会整合"今天天气很好,我们去"的所有信息,最终预测出"公园"或"散步"等词。

四、GRU的工作流程:一个完整的例子

为了更好地理解GRU的工作原理,让我们通过一个具体的例子来演示它的完整工作流程。

4.1 例子:预测句子的下一个词

假设我们有一个句子:"今天阳光明媚,我决定____",我们需要预测最后一个词。

步骤1:处理第一个词"今天"

- 重置门:由于是第一个词,没有历史信息,所以输出接近1

- 更新门:由于是第一个词,需要完全使用新信息,所以输出接近0

- 候选隐藏状态:生成包含"今天"信息的候选状态

- 隐藏状态:包含"今天"的信息

步骤2:处理第二个词"阳光"

- 重置门:保留"今天"的信息,输出接近1

- 更新门:保留部分"今天"的信息,输出在0.5左右

- 候选隐藏状态:生成包含"阳光"信息的候选状态

- 隐藏状态:整合"今天阳光"的信息

步骤3:处理第三个词"明媚"

- 重置门:保留"今天阳光"的信息,输出接近1

- 更新门:保留部分历史信息,输出在0.5左右

- 候选隐藏状态:生成包含"明媚"信息的候选状态

- 隐藏状态:整合"今天阳光明媚"的信息

步骤4:处理第四个词"我"

- 重置门:弱化前面的天气信息,输出在0.3左右

- 更新门:保留部分天气信息,输出在0.4左右

- 候选隐藏状态:生成包含"我"信息的候选状态

- 隐藏状态:整合"今天阳光明媚,我"的信息

步骤5:处理第五个词"决定"

- 重置门:保留前面的信息,输出接近1

- 更新门:保留部分历史信息,输出在0.5左右

- 候选隐藏状态:生成包含"决定"信息的候选状态

- 隐藏状态:整合"今天阳光明媚,我决定"的完整信息

最终,网络根据隐藏状态中的完整信息,可能预测出"出去"、"散步"或"旅行"等词。

4.2 GRU高效性的关键

在这个例子中,GRU通过两个门控机制就实现了LSTM三个门控的功能,这正是它高效的关键:

- 门控机制的简化:将遗忘门和输入门合并为更新门,减少了参数数量

- 状态的统一:将细胞状态和隐藏状态合并,简化了信息传递过程

- 重置门的灵活控制:通过重置门动态调整历史信息的影响,提高了模型的适应性

- 计算效率的提升:减少了约33%的参数,训练和推理速度更快

五、GRU与LSTM的对比:简化与强大的平衡

5.1 结构对比

| 组件 | LSTM | GRU |

|---|---|---|

| 门控数量 | 3个(遗忘门、输入门、输出门) | 2个(重置门、更新门) |

| 状态类型 | 2种(细胞状态、隐藏状态) | 1种(隐藏状态) |

| 记忆存储 | 细胞状态 | 隐藏状态 |

| 输出控制 | 输出门 | 直接输出隐藏状态 |

5.2 性能对比

| 特性 | LSTM | GRU |

|---|---|---|

| 参数数量 | 多(标准RNN的4倍) | 中(标准RNN的3倍) |

| 训练速度 | 慢 | 快 |

| 推理速度 | 慢 | 快 |

| 记忆能力 | 强 | 较强 |

| 对长序列的处理 | 更好 | 良好 |

| 调参复杂度 | 高 | 中 |

| 数据需求量 | 大 | 中等 |

5.3 适用场景对比

| 场景 | LSTM更适合 | GRU更适合 |

|---|---|---|

| 超长序列处理(>1000时间步) | ✅ | ⭕ |

| 有限数据量的任务 | ⭕ | ✅ |

| 实时性要求高的应用 | ⭕ | ✅ |

| 资源受限的设备 | ⭕ | ✅ |

| 需要精确记忆的任务 | ✅ | ⭕ |

在实际应用中,研究人员和工程师通常会同时尝试LSTM和GRU,根据具体任务选择性能更好的模型。

六、GRU的应用场景:高效记忆的广泛应用

GRU凭借其高效性和良好的记忆能力,在许多领域都取得了出色的应用效果。

6.1 自然语言处理

- 机器翻译:GRU在机器翻译任务中表现出色,能够高效处理长句子

- 文本生成:用于生成新闻、诗歌、对话等,训练速度比LSTM更快

- 情感分析:分析文本的情感倾向,如积极、消极或中性

- 命名实体识别:识别文本中的人名、地名、组织机构名等

6.2 语音处理

- 语音识别:将语音转换为文本,实时性要求高,GRU的高效性非常适合

- 语音合成:将文本转换为语音,需要处理序列数据

- 说话人识别:识别不同说话人的声音特征

6.3 时间序列预测

- 股票价格预测:分析历史股票价格,预测未来走势

- 气象预测:基于历史气象数据,预测未来天气

- 交通流量预测:预测道路拥堵情况,优化交通调度

6.4 其他领域

- 视频分析:分析视频中的动作序列

- 推荐系统:根据用户的历史行为,推荐个性化内容

- 生物信息学:分析DNA、蛋白质等生物序列数据

七、GRU的实现:代码示例

为了让大家更直观地了解GRU的实现,我们将使用Python和NumPy库来实现一个简单的GRU模型,用于预测句子的下一个词。

import numpy as np

# 定义sigmoid激活函数

def sigmoid(x):

return 1 / (1 + np.exp(-x))

# 定义tanh激活函数

def tanh(x):

return np.tanh(x)

# 定义GRU单元类

class GRUCell:

def __init__(self, input_size, hidden_size):

# 初始化权重和偏置

self.W_r = np.random.randn(hidden_size, hidden_size + input_size) * 0.01

self.b_r = np.zeros((hidden_size, 1))

self.W_z = np.random.randn(hidden_size, hidden_size + input_size) * 0.01

self.b_z = np.zeros((hidden_size, 1))

self.W = np.random.randn(hidden_size, hidden_size + input_size) * 0.01

self.b = np.zeros((hidden_size, 1))

def forward(self, x, h_prev):

# 拼接输入和上一时刻的隐藏状态

concat = np.concatenate((h_prev, x), axis=0)

# 计算重置门

r = sigmoid(np.dot(self.W_r, concat) + self.b_r)

# 计算更新门

z = sigmoid(np.dot(self.W_z, concat) + self.b_z)

# 计算候选隐藏状态

# 先将重置门应用到上一时刻的隐藏状态

r_h_prev = r * h_prev

# 拼接处理后的隐藏状态和当前输入

concat_candidate = np.concatenate((r_h_prev, x), axis=0)

# 生成候选隐藏状态

h_tilde = tanh(np.dot(self.W, concat_candidate) + self.b)

# 更新隐藏状态

h = (1 - z) * h_tilde + z * h_prev

return h

# 示例用法

if __name__ == "__main__":

# 定义参数

input_size = 10 # 输入特征维度

hidden_size = 5 # 隐藏状态维度

# 创建GRU单元

gru_cell = GRUCell(input_size, hidden_size)

# 随机生成输入和初始状态

x = np.random.randn(input_size, 1)

h_prev = np.zeros((hidden_size, 1))

# 前向传播

h = gru_cell.forward(x, h_prev)

print("隐藏状态 h:", h)

这个简单的GRU实现展示了GRU的核心工作原理,包括两个门控机制的计算和隐藏状态的更新过程。与LSTM相比,GRU的实现更加简洁,参数数量也更少。

八、GRU的优缺点:简化的两面性

8.1 优点

- 高效性:参数数量比LSTM少33%,训练和推理速度更快

- 简洁性:结构简单,易于理解和实现

- 良好的记忆能力:在大多数任务上表现与LSTM相当

- 资源友好:占用内存少,适合资源受限的设备

- 调参相对简单:需要调整的超参数较少

8.2 缺点

- 记忆能力略逊:在处理超长序列(>1000时间步)时,性能可能不如LSTM

- 理论复杂度:虽然结构简化,但仍然有一定的理论复杂度

- 可解释性差:内部工作机制仍然不够直观

- 对超参数敏感:学习率等超参数的选择仍然会影响性能

九、GRU的未来发展:从简化到智能化

随着深度学习的发展,GRU也在不断进化,出现了许多新的变体和改进方法。

9.1 GRU的改进变体

- Bidirectional GRU:双向GRU同时从序列的正向和反向进行处理,能够捕捉更多的上下文信息

- Stacked GRU:堆叠多个GRU层,能够学习更复杂的特征表示

- Residual GRU:引入残差连接,缓解深层GRU的梯度消失问题

- Attention-GRU:结合注意力机制,让模型更好地关注序列中的重要部分

9.2 与其他技术的结合

- GRU与Transformer的结合:将GRU的序列建模能力与Transformer的并行计算能力结合

- GRU与强化学习的结合:在强化学习中使用GRU来建模序列决策过程

- GRU与图神经网络的结合:处理图结构的序列数据

9.3 应用领域的扩展

- 边缘计算:由于GRU高效的特性,适合在边缘设备上部署

- 实时应用:在语音识别、实时翻译等对延迟要求高的应用中发挥优势

- 小样本学习:在数据量有限的情况下,GRU的简洁性有助于避免过拟合

十、哲学思考:简化与效率的智慧

GRU的发明不仅仅是技术上的创新,也蕴含着深刻的哲学思想。

10.1 简化是一种智慧

GRU告诉我们,复杂并不总是最好的。有时候,通过巧妙的简化,可以在保持核心功能的同时,提高效率和性能。这种简化的智慧,在生活和工作中同样适用。

10.2 平衡是一种艺术

GRU在简化和功能之间找到了很好的平衡。它没有为了极致的简化而牺牲核心功能,也没有为了完整的功能而保持复杂的结构。这种平衡的艺术,是设计任何系统都需要遵循的原则。

10.3 适应是一种能力

GRU的设计体现了适应不同场景的能力。它可以在资源受限的设备上高效运行,也可以在数据充足的情况下表现出色。这种适应能力,是人工智能系统发展的重要方向。

10.4 选择是一种决策

GRU中的重置门和更新门,本质上是在做一系列的选择:选择保留什么信息,选择添加什么信息。这种选择的能力,是智能的重要体现。

十一、总结:高效记忆的革命

门控循环单元(GRU)的发明,是人工智能领域的一次高效记忆革命。它通过巧妙的门控机制简化,在保持LSTM核心功能的同时,实现了更高的效率和更好的性能。

从茶馆老先生的茶壶比喻到GRU的复杂公式,从简单的句子预测到复杂的机器翻译系统,GRU用它简洁而高效的设计,正在改变我们与人工智能的交互方式。

正如记忆茶馆里的老先生所说:"有时候,简单反而更高效。" GRU正是这句话的完美体现。它告诉我们,在追求智能的道路上,简化和效率同样重要。

随着研究的不断深入,我们有理由相信,未来的GRU将更加智能化、高效化,为人类带来更多的惊喜和便利。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)