人工智能治理与项目管理(AI安全管理一)

引言

在AI技术飞速渗透各行各业的今天,“重开发、轻治理”已成为导致70% AI项目失败的核心原因(Gartner, 2023)。人工智能治理与项目管理作为贯穿AI全生命周期的核心体系,构建了从战略对齐到落地执行的完整框架,涵盖利益相关方协同、合规管控、资产治理、安全保障等关键环节。其核心要求从业者具备“政策制定、风险管控、技术落地”三位一体的综合能力,本文将基于全球主流治理框架与行业最佳实践,结合招商银行、美的集团、恒天然等标杆案例与可复用工具模板,详细拆解每个核心知识点,为AI项目的规范化推进提供实操指南。

模块A:利益相关方考量、行业框架与法规要求

1.1 人工智能治理概念

1.1.1 人工智能准备度(行业成熟度评估模型实操)

AI准备度是企业启动AI项目的前提基础,需基于整合COBIT、NIST框架的行业通用AI成熟度评估模型,从组织、技术、数据、人才四大维度进行系统性评分(满分100分,≥70分为合格):

| 评估维度 | 核心指标 | 评分标准(示例) | 行业基准值 |

|---|---|---|---|

| 组织准备 | 跨部门协作机制 | 建立AI指导委员会(15分),业务-IT-法务常态化联动(10分) | 22分 |

| 技术准备 | 算力支撑能力 | 具备GPU集群(10分),支持分布式训练(8分),异构架构适配(7分) | 20分 |

| 数据准备 | 数据治理成熟度 | 数据完整性≥95%(10分),分类分级完成(8分),合规授权率100%(7分) | 23分 |

| 人才准备 | 专业团队配置 | 数据科学家≥2名(8分),AI安全专员≥1名(7分),全员合规培训覆盖率100%(5分) | 18分 |

实操工具:行业通用AI准备度自评问卷(含50个细分问题),支持自动生成差距分析报告,可通过主流AI治理平台下载获取。

1.1.2 可行性分析(三维度全流程论证)

AI项目可行性需围绕技术、经济、法律三大维度展开严谨论证,结合迈瑞医疗AI病历系统落地经验:

-

技术可行性:

- 数据验证:通过小样本测试验证数据充足性(如医疗AI需≥10万份标注病历);

- 算法适配:用POC(概念验证)测试算法精度(重症诊断AI需≥95%准确率);

- 集成兼容性:验证与现有系统(如医院HIS系统)的接口适配性,避免“数据孤岛”。

-

经济可行性(CBA成本效益分析模板):

| 成本项(3年周期) | 金额(万元) | 效益项(3年周期) | 金额(万元) |

|---|---|---|---|

| 数据采集标注 | 280 | 人工成本节约(医生工时减少) | 1200 |

| GPU集群采购 | 450 | 误诊损失降低 | 800 |

| 人才薪酬 | 600 | 患者满意度提升收益 | 300 |

| 合规改造 | 120 | 间接品牌价值提升 | 500 |

| 合计 | 1450 | 合计 | 2800 |

-

ROI计算:(2800-1450)/1450×100%≈93.1%(医疗AI行业平均ROI为85%)。

-

法律可行性:

- 数据合规核查:采用“数据地图”工具梳理数据流,确保符合《生成式AI服务管理暂行办法》;

- 责任风险评估:参考加拿大航空AI聊天机器人误导用户的败诉案例,明确AI输出的人工审核义务。

1.2 企业治理主体的角色

1.2.1 利益相关方协同机制(招商银行案例)

招商银行成立由CEO挂帅的AI治理委员会,构建“三层级协同架构”:

- 决策层(董事会+高管):审批“招银智库AI小研”等重大项目,年度拨付2.3亿元AI专项预算;

- 执行层(业务+IT+法务):

- 业务部门:提出投研报告生成需求,参与数据标注(准确率≥98%);

- IT团队:搭建混合云AI架构,支撑5秒生成研报摘要的性能需求;

- 法务部:审核AI生成内容的合规性,规避金融信息披露风险;

- 监督层(内审+合规部):每季度开展AI合规审计,2024年发现并整改3类17项风险点。

1.2.4 人工智能章程(可直接复用模板框架)

AI章程作为治理体系的“根本大法”,需包含以下核心条款(参考COBIT、OECD最佳实践):

# XX企业人工智能章程(V1.0)

## 1. 总则

1.1 愿景:通过负责任AI应用,实现[业务目标,如“金融服务效率提升30%”]

1.2 适用范围:全公司AI项目(含自研、外购、合资开发)

1.3 核心原则:合规优先、风险可控、公平透明、权责清晰

## 2. 治理架构

2.1 AI指导委员会:由CEO、CTO、CISO、业务负责人组成,每月召开例会

2.2 执行团队:AI架构师(1名)、数据治理专员(2名)、伦理审查员(1名)

## 3. 决策流程

3.1 立项审批:≥500万元项目需委员会全票通过

3.2 变更管理:模型架构调整需合规部备案

3.3 退出机制:连续3个月ROI<10%的项目强制下线

## 4. 责任划分

- 业务部门:需求提出与效果验证

- IT部门:技术实现与安全防护

- 法务部门:合规审核与风险应对

1.2.5 人工智能指导委员会(权责清单)

| 决策类型 | 触发条件 | 决策流程 | 责任主体 |

|---|---|---|---|

| 项目立项 | 预算≥100万元 | 业务部门申请→执行团队评估→委员会投票(≥2/3同意) | 委员会全体 |

| 资源调配 | 跨部门算力冲突 | 申请方提交需求→架构师评估→CTO审批 | CTO |

| 风险处置 | 模型偏见投诉≥3起 | 合规部调查→出具整改方案→委员会审批 | 合规负责人 |

1.3 人工智能标准、框架与法规

1.3.1 核心框架深度解析(2024更新版)

| 框架名称 | 核心定位 | 最新动态(2024) | 企业落地要点 |

|---|---|---|---|

| COBIT 5 for AI | IT治理延伸至AI领域 | 新增生成式AI治理模块 | 建立“政策-标准-流程”三级管控体系 |

| NIST AI RMF | 风险管理导向 | 发布V2.0版,强化模型漂移监控 | 按“治理-映射-测量-管理”四阶段落地 |

| 欧盟AI法案 | 合规约束导向 | 2024年6月正式生效,高风险AI强制合规评估 | 医疗、金融AI需提交12项合规证明材料 |

| OECD AI原则 | 全球通用准则 | 新增环境影响评估要求 | 将碳排放指标纳入AI项目考核 |

1.3.2 2024关键法规合规要求

- 国内法规:

- 《生成式AI服务管理暂行办法》:2024年实施备案制,企业需提交训练数据合规报告、内容过滤机制说明;

- 算法备案:金融、医疗领域AI算法需在网信部门备案,备案通过率仅68%(常见驳回原因:未说明算法公平性保障措施);

- 国际法规:

- GDPR强化版:对AI数据处理新增“目的限制”要求,禁止超范围使用用户数据训练模型;

- 美国AI法案:要求大模型训练数据需标注版权来源,违者最高罚款年收入的4%。

1.4 人工智能用例与局限性

1.4.1 行业标杆用例拆解(2024最新)

| 行业 | 标杆案例 | 技术路径 | 关键成功因素 |

|---|---|---|---|

| 金融 | 招商银行“AI小研” | 大模型+金融知识库 | 跨部门数据融合(整合财报、新闻、交易数据) |

| 制造 | 美的集团智能选型系统 | 物理模型+机器学习 | 100+高精度工业数据平台支撑 |

| 医疗 | 迈瑞医疗重症诊断AI | 多模态大模型(文本+设备数据) | 医生深度参与模型迭代(反馈率≥90%) |

| 零售 | 某电商智能推荐系统 | 协同过滤+深度学习 | 数据分类分级治理(用户隐私数据脱敏处理) |

| 乳业 | 恒天然AI研发平台 | 生成式AI+仿真筛选 | 数据标准化+专家反馈闭环 |

1.4.2 核心局限性与解决方案

| 局限性类型 | 具体表现 | 解决方案(企业实践) |

|---|---|---|

| 模型幻觉 | 医疗AI编造药物剂量 | 接入权威知识库(如药典数据库),设置输出校验规则 |

| 数据依赖 | 标注数据稀缺 | 采用弱监督学习,结合AI辅助标注(标注效率提升40%) |

| 业务适配 | 大模型推理延迟 | 模型量化压缩(精度损失≤2%),边缘计算部署 |

| 伦理风险 | 招聘AI性别歧视 | 采用IBM AI Fairness 360工具审计,优化训练数据平衡度 |

| 认知短板 | 长期记忆缺失 | 结合AGI评估框架优化模型架构,强化工作记忆模块 |

1.5 业务案例、需求与价值评估

1.5.1 投资回报率(ROI)精细化计算

AI项目ROI需采用“全成本核算”方法,计入隐性成本:

ROI = (直接收益+间接收益-显性成本-隐性成本) / (显性成本+隐性成本) × 100%

-

隐性成本包含:

- 模型维护成本(年度约为开发成本的20%);

- 技能培训成本(人均AI合规培训费用≥3000元);

- 风险准备金(按项目预算的5%计提)。

-

案例:美的集团AI选型系统投入1200万元,3年显性成本+隐性成本合计1800万元,直接收益(工时节约)+间接收益(售后成本降低)合计4320万元,ROI=(4320-1800)/1800×100%=140%。

模块B:人工智能相关战略、政策与程序

1.6 人工智能战略

1.6.4 自主开发vs外购决策矩阵(2024优化版)

| 决策维度 | 自主开发(美的集团案例) | 外购(中小银行实践) |

|---|---|---|

| 决策阈值 | 核心业务场景、数据敏感、ROI≥120% | 非核心场景、上线周期≤3个月、预算≤500万 |

| 实施要点 | 搭建100+工业数据平台,自主训练模型 | 选择通过ISO 42001认证的供应商,签订数据安全协议 |

| 风险控制 | 分阶段验证(POC→试点→推广),每阶段通过率≥90% | 供应商准入审核(5项合规指标+3项技术指标),季度安全审计 |

| 成本结构 | 前期投入高(开发成本占比60%),长期维护成本低 | 前期投入低(订阅费占比80%),年度维护成本递增10% |

1.6.6 共享责任模型(合同核心条款)

在供应商合作模式下,需在合同中明确责任划分(参考COBIT框架建议):

-

供应商责任:

- 提供模型安全测试报告(含对抗性攻击测试结果);

- 数据传输采用AES-256加密,存储符合三级等保要求;

- 7×24小时故障响应,故障恢复时间≤4小时;

-

企业责任:

- 明确AI使用边界,禁止超范围部署;

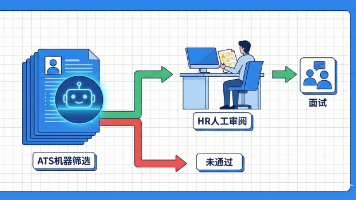

- 对AI输出进行人工复核(高风险场景复核率100%);

- 建立用户反馈机制,及时上报违规输出。

1.7 人工智能可接受使用政策(企业实操版)

基于行业最佳实践与国内法规要求,核心条款应包括:

# 人工智能可接受使用政策

## 1. 使用范围

✅ 允许:内部文档生成、客户服务辅助、数据分析建模

❌ 禁止:生成涉密文件、恶意内容、替代人工决策(高风险场景)

## 2. 数据使用规范

2.1 禁止上传:客户身份证号、商业机密、未授权第三方数据

2.2 训练数据要求:需具备合法授权,标注准确率≥98%

2.3 数据留存:生成式AI训练数据留存期≤6个月,到期自动销毁

## 3. 责任归属

3.1 员工需对AI输出进行审核(审核记录留存1年)

3.2 违规使用导致的损失,由使用者与部门负责人承担连带责任

## 4. 安全要求

4.1 仅允许使用企业授权的AI工具(如ChatGPT企业版、飞书智能助手)

4.2 每月开展AI安全培训,考核通过率≥95%

1.8 人工智能政策开发

1.8.1 政策开发六步法(IBM实践)

- 需求调研:访谈10+业务部门,收集30+核心需求(如数据安全、算法公平性);

- 框架设计:参考COBIT、OECD原则,搭建“总则-具体规范-实施保障”结构;

- 内容编写:由法务、IT、业务联合编写,明确条款可操作性(如“算法偏见审计每季度1次”);

- 内部评审:组织跨部门评审会,收集修改意见(修改率≤20%);

- 试点运行:选择1-2个AI项目试点应用,持续优化(试点周期≥1个月);

- 正式发布:经AI指导委员会审批后发布,每年更新1次。

1.8.2 负责任AI原则落地工具包

| 原则 | 落地工具 | 实操步骤 |

|---|---|---|

| 公平性 | IBM AI Fairness 360 | 1. 导入训练数据;2. 选择公平性指标(如 demographic parity);3. 生成偏见审计报告;4. 应用去偏算法优化 |

| 透明度 | 模型可解释性报告模板 | 1. 说明算法类型与核心参数;2. 展示决策逻辑流程图;3. 列出影响决策的Top5特征 |

| 安全性 | OWASP AI Security Top 10 | 1. 针对模型投毒、数据泄露等10类风险进行测试;2. 制定防护措施(如模型加密、访问控制) |

| 隐私保护 | 差分隐私工具(如TensorFlow Privacy) | 1. 设置隐私预算(ε值);2. 对训练数据添加噪声;3. 验证数据可用性(准确率损失≤3%) |

1.9 人工智能流程与手册

1.9.1 利用AI生成流程手册的标准化流程

-

数据准备阶段:

- 收集现有SOP文档、历史案例(格式统一为PDF/Word);

- 标注核心要素(如职责分工、时间节点、风险点);

-

工具选择与配置:

- 推荐工具:ChatGPT企业版(数据私有化部署)、飞书智能助手;

- 配置Prompt:

“基于以下SOP文档,生成[业务场景]AI项目流程手册,包含目的、范围、职责、步骤、风险点、应急措施,格式为Markdown,语言简洁专业” -

生成与优化:

- 首次生成后,人工审核准确性(如步骤完整性、职责清晰度);

- 补充行业know-how(如金融AI需加入合规审核步骤);

-

版本管理:

- 采用“业务线-年份-版本号”命名规则(如“金融-2024-V1.0”);

- 关联AI项目迭代计划,同步更新(如模型升级后更新操作步骤)。

1.10 伦理考量

1.10.2 偏差与公平性治理全流程

-

偏差识别:

- 数据偏差:用Python Pandas分析训练数据分布(如性别比例、地域分布);

- 算法偏差:通过AI Fairness 360计算不同群体的错误率差异(允许差异≤5%);

-

偏差矫正:

- 数据层面:补充少数群体数据,采用SMOTE算法平衡数据分布;

- 算法层面:调整模型权重,引入公平性约束(如正则化项);

-

持续监控:

- 每季度开展偏见审计,生成公平性报告;

- 建立用户投诉渠道,及时响应算法歧视反馈。

1.10.5 知识产权(IP)合规管理

-

训练数据合规:

- 采用“授权+溯源”机制,签订数据使用协议(明确使用权、期限、费用);

- 规避风险:避免使用盗版数据(参考Anthropic公司侵权败诉案例,赔偿金额达2100万美元);

-

生成内容权属:

- 内部使用:版权归企业所有,需标注“AI生成+人工审核”;

- 对外发布:需获得生成式AI供应商授权,明确知识产权归属;

-

专利保护:

- 核心算法申请发明专利(如美的集团AI选型算法已获3项专利);

- 技术秘密保护(如模型架构、超参数配置需签订保密协议)。

1.10.7 环境影响治理(绿色AI实践)

-

碳排放管控:

- 算力优化:采用混合精度训练(FP16+FP32),碳排放降低40%;

- 绿色算力:选择水电驱动的数据中心(如阿里云张北数据中心);

-

资源节约:

- 模型复用:搭建企业级模型仓库,复用预训练模型(如BERT-base),减少重复训练;

- 动态调度:通过Kubernetes实现算力资源动态分配,利用率提升至85%以上;

-

量化指标:AI项目碳排放量需≤50吨CO₂/年(参考OECD建议标准)。

模块C:人工智能资产与数据生命周期管理

1.11 人工智能资产识别与盘点

1.11.1 资产分类与元数据标准(可直接复用)

参考CSDN架构师实践经验,AI资产分为四大类,元数据标准如下:

| 资产类型 | 分类框架 | 核心元数据字段(必填) |

|---|---|---|

| 数据资产 | 业务线→数据类型→功能(如:电商→用户行为→复购预测) | data_id、名称、来源、采集时间、合规状态、负责人 |

| 模型资产 | 业务线→功能→版本(如:金融→反欺诈→v3.0) | model_id、算法类型、训练数据、精度指标、部署状态、负责人 |

| 算力资产 | 类型→用途(如:GPU集群→训练/推理) | resource_id、配置参数、使用部门、利用率、维护周期 |

| 文档资产 | 类型→关联资产(如:模型卡片→反欺诈模型v3.0) | doc_id、关联资产ID、创建时间、更新周期、访问权限 |

资产盘点模板(Excel可下载):

AI资产盘点表(2024版)

├─ 基础信息(资产ID、名称、分类、负责人、部门)

├─ 技术信息(数据/模型/算力具体参数)

├─ 管理信息(生命周期阶段、风险等级、合规状态)

└─ 变更记录(更新时间、变更内容、审批人)

1.11.2 盘点方法与工具组合

| 盘点阶段 | 方法 | 工具 | 实操要点 |

|---|---|---|---|

| 初步摸底 | 问卷调查 | 问卷星+企业协作平台 | 设计20+核心问题(如“是否有未文档化的AI模型”) |

| 深入挖掘 | 结构化访谈 | 录音整理工具+访谈提纲 | 访谈对象覆盖IT、业务、法务(每部门≥2人) |

| 精准识别 | 自动化扫描 | MLflow(模型)+Prometheus(算力) | 定时扫描(每周1次),自动更新资产状态 |

| 验证确认 | 文档审查 | Confluence+数据字典 | 核对资产元数据与实际文档一致性(一致性≥98%) |

1.12 数据生命周期全流程管控

1.12.1 数据生命周期六阶段管理(帆软+行业最佳实践融合)

| 生命周期阶段 | 管理目标 | 核心措施 | 工具链 |

|---|---|---|---|

| 生成阶段 | 标准化、合规化 | 统一数据填报模板,自动校验格式(如手机号、身份证号正则校验) | FineReport、自研填报平台 |

| 采集阶段 | 准确、及时 | 多源数据集成(ETL工具),数据血缘追踪(记录数据流转路径) | FineDataLink、Apache NiFi |

| 存储阶段 | 安全、高效 | 冷热分层存储(热数据存SSD,冷数据存对象存储),AES-256加密 | Hive、S3、阿里云OSS |

| 处理阶段 | 高质量、可用 | 自动清洗(去重、补缺失值)、数据增强(SMOTE、随机森林) | FineBI、Python Pandas、Scikit-learn |

| 使用阶段 | 合规、可控 | 基于角色的访问控制(RBAC),数据脱敏(如手机号显示为138****1234) | 数据安全网关、脱敏工具 |

| 归档与销毁 | 合规、低成本 | 按法规要求归档(金融数据保存≥5年),到期自动销毁(多次覆写) | 归档系统、数据销毁工具 |

1.12.4 数据采集合规实操要点

-

consent机制设计:

- 明确告知:通过弹窗告知用户数据用途(如“您的浏览数据将用于个性化推荐”)、保留期限;

- 可撤销授权:提供便捷的授权撤销入口(如APP设置页面),撤销后24小时内删除数据;

-

用途适配控制:

- 建立数据用途清单,采集数据需与清单匹配(如用户消费数据不可用于信贷评估);

- 超范围使用需重新获取授权;

-

数据滞后性管理:

- 实时场景(如风控):数据采集与使用时间差≤1小时;

- 非实时场景(如用户画像):数据更新周期≤7天。

1.12.10 模型卡片规范(行业通用模板)

# 模型卡片(Model Card)- 反欺诈模型v3.0

## 1. 基本信息

- 模型ID:FIN-FRAUD-v3.0

- 开发团队:金融AI组(负责人:张三,联系方式:zhangsan@xx.com)

- 上线时间:2024-05-10

- 生命周期阶段:生产中

## 2. 技术参数

- 算法类型:XGBoost+LightGBM集成模型

- 训练数据:2023-01至2024-03金融交易数据(1000万条,合规授权率100%)

- 超参数:学习率=0.05,树深度=8,迭代次数=100

- 性能指标:准确率=97.2%,召回率=96.8%,F1分数=97.0%

## 3. 适用范围

- 推荐场景:信用卡交易欺诈检测(单笔金额≤5万元)

- 禁忌场景:信贷审批、大额转账风控

## 4. 风险提示

- 潜在偏见:对新用户(开户≤3个月)误判率较高(约8%)

- 性能边界:节假日交易高峰期(如双11)准确率下降2-3%

- 安全隐患:需防范 adversarial example 攻击

## 5. 维护信息

- 更新周期:每季度迭代1次

- 监控指标:准确率、召回率、误判率(每日监控)

- 应急方案:准确率低于95%时自动切换至v2.0版本

模块D:人工智能安全项目开发与管理

1.13 人工智能安全项目开发

1.13.1 核心原则:信任但验证(全流程验证机制)

- 信任基础构建:

- 供应商准入:选择具备CMMI 5级、ISO 27001认证的供应商;

- 技术选型:采用成熟框架(如TensorFlow、PyTorch),避免自研小众框架;

1.13.2全流程验证节点

| 项目阶段 | 验证内容 | 验证方法 | 通过率要求 |

|---|---|---|---|

| 需求阶段 | 安全需求完整性 | 需求评审会(法务+安全+业务) | 100% |

| 开发阶段 | 代码安全、模型安全 | 静态代码扫描、模型加密测试 | ≥95% |

| 测试阶段 | 对抗性攻击、数据泄露 | OWASP AI Security测试套件 | ≥98% |

| 上线阶段 | 合规性、性能稳定性 | 第三方合规审计、压力测试 | 100% |

| 运维阶段 | 模型漂移、异常访问 | 实时监控平台 | 持续达标 |

1.13.3 指定人工智能负责人(岗位说明书)

| 岗位名称 | AI安全负责人 | 汇报对象 | CISO(首席信息安全官) |

|---|---|---|---|

| 任职要求 | 1. 具备CISM认证;2. 5年以上AI安全相关经验;3. 熟悉AI框架与合规法规 | ||

| 核心职责 | 1. 制定AI安全政策与流程(年度更新1次);2. 组织安全风险评估(每季度1次);3. 协调跨部门安全协作;4. 主导AI安全事件响应(响应时间≤4小时);5. 开展AI安全培训(年度覆盖率100%) | ||

| 考核指标 | 1. AI安全事件发生率≤1次/年;2. 合规审计问题整改率100%;3. 安全培训考核通过率≥95% |

1.14 人工智能安全项目组成要素

1.14.2 AI安全vs保障AI安全(防护体系构建)

| 维度 | AI安全(保护AI系统本身) | 保障AI安全(防止AI被滥用) |

|---|---|---|

| 防护目标 | 模型不被窃取、数据不泄露、系统不被攻击 | 不生成有害内容、不产生歧视性决策、不被用于恶意行为 |

| 核心技术 | 1. 模型加密(同态加密、联邦学习);2. 访问控制(RBAC+ABAC);3. 入侵检测(异常行为识别) | 1. 内容过滤(关键词+语义分析);2. 算法监管(决策日志审计);3. 使用权限管控(功能限制) |

| 实践案例 | 某金融机构对反欺诈模型采用联邦学习训练,避免数据集中存储 | 某社交平台AI聊天机器人设置敏感词库,实时过滤恶意内容 |

1.14.4 项目指标设计(KPI/KRI)精细化管理

| 指标类型 | 核心指标 | 目标值 | 测量方法 | 数据来源 |

|---|---|---|---|---|

| KPI(绩效指标) | 模型安全测试通过率 | ≥95% | 统计OWASP AI Security测试通过项占比 | 安全测试平台 |

| AI安全事件响应时间 | ≤4小时 | 从事件发现到初步处置的时间 | 事件管理系统 | |

| 合规审计问题整改率 | 100% | 已整改问题数/总问题数 | 合规管理平台 | |

| KRI(风险指标) | 模型异常访问次数 | ≤1次/月 | 统计非授权访问、异常IP访问次数 | 日志审计系统 |

| 数据泄露风险等级 | 低风险及以下 | 按影响范围、严重程度评级(高/中/低) | 风险评估工具 | |

| 算法偏见投诉量 | 0起/季度 | 统计用户关于算法歧视的有效投诉 | 客服系统 |

1.15 人工智能赋能的安全能力

1.15.3 AI赋能供应链安全管理(全生命周期管控)

-

供应商准入阶段:

- AI风险评估:利用NLP技术分析供应商舆情、合规记录,预测风险等级;

- 资质审核:自动校验供应商AI产品的合规认证(如欧盟AI法案高风险认证);

-

合作运行阶段:

- 实时监控:AI驱动的供应链安全平台,监控供应商数据传输、模型更新等行为;

- 合规扫描:自动扫描供应商AI产品的合规性变化(如法规更新后的适配情况);

-

应急响应阶段:

- 风险预警:AI预测供应链中断风险(如供应商数据中心故障),提前制定预案;

- 快速处置:自动识别供应商数据泄露等安全事件,触发响应流程。

模块E:业务连续性与事件响应

1.16 准备阶段核心工作

1.16.1 文档体系建设(行业推荐清单)

| 文档名称 | 核心内容 | 更新频率 | 责任部门 |

|---|---|---|---|

| AI事件响应预案 | 事件分级标准、响应流程、责任分工、处置措施 | 每半年1次 | IT+安全部 |

| 业务连续性计划(BCP) | 关键AI业务清单、灾备方案、恢复目标(RTO/RPO) | 每年1次 | 业务+IT部 |

| 模型备份与恢复流程 | 备份策略(全量+增量)、恢复步骤、验证方法 | 每季度1次 | AI团队 |

| 应急联系人清单 | 内外部联系人、联系方式、响应时间 | 每月更新 | 安全部 |

1.16.3 桌面演练(标准化流程)

-

演练准备:

- 场景设计:覆盖数据泄露、模型投毒、AI输出错误等6类典型场景;

- 角色分配:总指挥(CTO)、技术处置组、业务恢复组、沟通组、合规组;

-

演练执行:

- 流程:场景导入→团队响应→处置决策→效果评估(时长2-3小时);

- 工具:模拟攻击平台、应急响应系统、视频会议工具;

-

复盘优化:

- 输出问题清单(如“响应流程不清晰”“技术处置耗时过长”);

- 制定整改计划(明确责任人、完成时限),整改完成率需100%。

1.19 响应阶段关键流程(人机协同)

| 步骤 | 核心动作 | 工具/方法 | 责任方 | 时间要求 |

|---|---|---|---|---|

| 遏制 | 1. 隔离受影响AI系统(断开网络/暂停服务);2. 保存现场数据(日志、模型版本) | 访问控制列表、系统隔离工具 | 技术处置组 | ≤30分钟 |

| 根除 | 1. 定位风险根源(如模型漏洞、数据污染);2. 彻底清除威胁(修复漏洞/替换干净数据) | 安全扫描工具、模型审计平台 | 技术处置组+安全部 | ≤2小时 |

| 恢复 | 1. 启动备份模型/数据(按RPO要求恢复);2. 灰度发布验证(先试点再全量) | 数据备份系统、灰度发布工具 | IT+业务部 | ≤1.5小时 |

| 复盘 | 1. 分析事件原因、影响范围;2. 优化响应流程与防护措施 | 复盘会议、文档记录工具 | 总指挥+全组 | 事件后24小时内 |

1.21 传统vs AI驱动的事件响应对比(效能分析)

| 对比维度 | 传统事件响应 | AI驱动的事件响应(某互联网企业实践) |

|---|---|---|

| 检测能力 | 依赖人工监控,平均检测时间(MTTD)≥8小时 | 自动化实时检测,MTTD≤30分钟,异常识别准确率≥92% |

| 处理效率 | 人工分析决策,平均处置时间(MTTR)≥24小时 | AI辅助决策,MTTR≤4小时,处理效率提升83% |

| 适用场景 | 常规安全事件(如账号泄露) | 复杂AI特有事件(如模型漂移、对抗攻击) |

| 人力成本 | 需5-8人团队,年度成本≥200万元 | 需2-3人团队(AI辅助),年度成本≤80万元 |

| 优势 | 流程成熟,风险可控 | 快速响应、大规模处理、精准决策 |

| 挑战 | 难以应对AI新型威胁 | 误报率控制(需≤5%)、算法对抗风险 |

| 最佳实践 | 建立标准化响应流程 | 人机协同(AI检测+人工复核),持续优化模型 |

模块总结

人工智能治理与项目管理是AI规模化落地的“压舱石”,其核心价值在于通过“系统化框架+实操工具+持续优化”闭环,平衡技术创新与风险管控。本章从利益相关方协同、战略政策制定、资产数据治理、安全项目落地、事件响应五大维度,整合了COBIT、NIST、OECD等权威框架、行业标杆案例与可复用模板,构建了全流程管理体系。

实践中需重点关注三大关键点:一是治理体系需与业务目标深度对齐(如招商银行AI战略直接支撑零售业务效率提升);二是工具与流程的协同(如用MLflow管理模型资产,用AI Fairness 360保障算法公平性);三是动态适配能力(随法规更新、技术演进持续优化治理框架)。

后续可进一步深入学习:① AI风险评估方法论(NIST AI RMF实操);② 生成式AI专项治理方案;③ 跨行业AI治理案例拆解(如医疗、制造行业的特殊要求)。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)