Dify构建测试智能体平台

Dify 构建的不是又一个测试工具,而是一个会学习、会决策、会协作的测试智能体生态。✅ 需求一出,用例自生✅ 代码一改,风险自知✅ 执行一败,根因自明——你就实现了AI 原生的质量工程。未来的测试团队,不是人+工具,而是人+智能体。现在,就是构建它的最好时机。

·

构建基于 Dify 的测试智能体平台,是将 AI 能力系统化注入软件测试全生命周期的关键一步。它不再是单点工具(如用例生成),而是一个可扩展、可协作、可进化的智能测试中枢,融合需求理解、风险分析、用例设计、执行监控与知识沉淀。

一、平台定位:测试领域的“Copilot + 决策引擎”

✨ 目标:

让每一位测试工程师拥有一个 7x24 小时在线、懂业务、会推理、能执行 的 AI 助手。

核心价值

| 角色 | 获得的能力 |

|---|---|

| 测试工程师 | 自动生成高覆盖用例、智能推荐测试重点、自动分析失败根因 |

| 开发工程师 | 提交代码后自动获得测试建议、缺陷预防提示 |

| 测试经理 | 实时掌握质量风险热力图、资源分配建议 |

| 产品经理 | 需求变更后自动评估影响范围、验证点清单 |

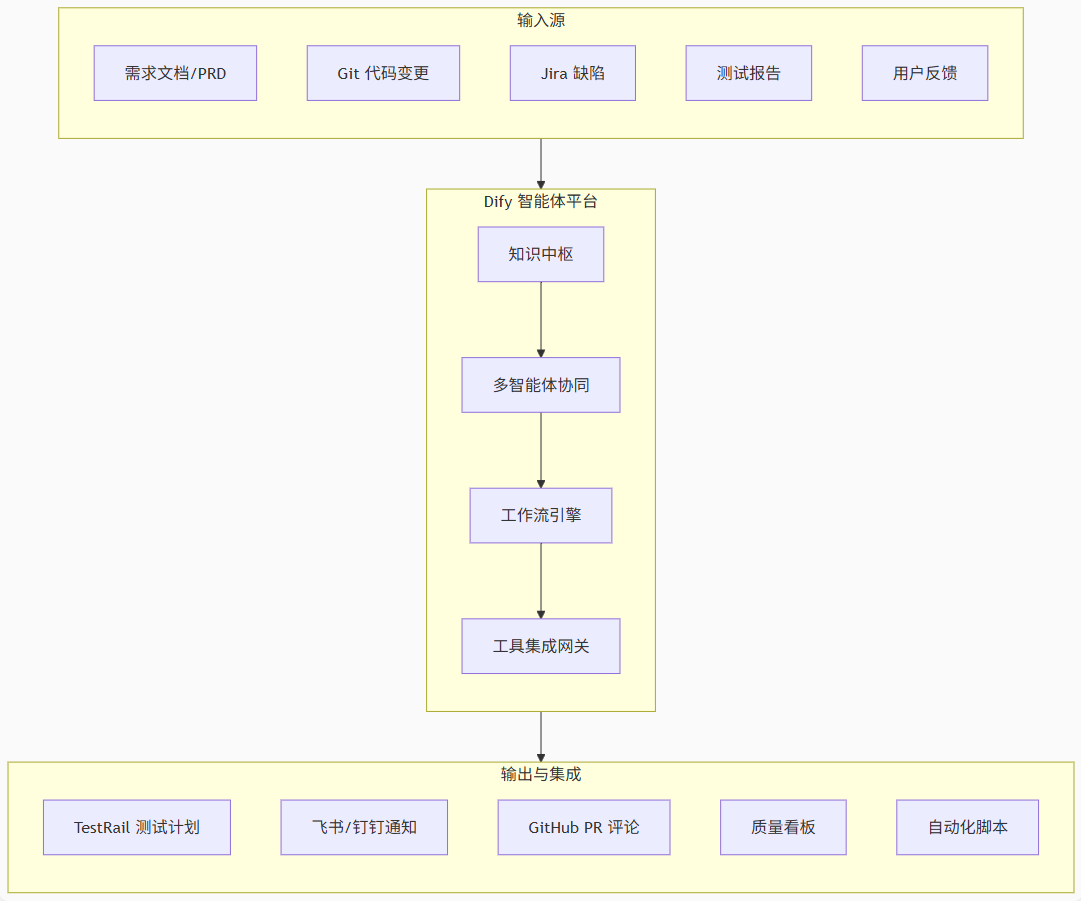

二、整体架构:四层智能体平台

三、核心模块详解

1. 知识中枢(Knowledge Hub)

- 作用:为所有智能体提供统一、权威、实时的上下文

- 内容:

- 结构化 PRD(含验收标准)

- 接口契约(OpenAPI/Swagger)

- 历史缺陷库(带根因标签)

- 测试策略规范(如《边界测试 Checklist》)

- 业务术语表(避免歧义)

- 实现:

- 在 Dify 中创建 专属知识库

- 启用 RAG(检索增强生成)

- 定期自动同步 Confluence/Jira/TestRail

📌 关键:知识必须结构化 + 版本化,避免 LLM 幻觉

2. 多智能体协同(Multi-Agent Collaboration)

在 Dify 中构建 角色化智能体,各司其职:

| 智能体名称 | 职责 | 触发条件 |

|---|---|---|

| 需求分析师 Agent | 解析 PRD,提取验收条件、边界规则 | 新 PRD 上传 / 需求变更 |

| 风险雷达 Agent | 分析 Git Diff,识别高风险模块 | 代码 Push / PR 创建 |

| 用例设计师 Agent | 生成结构化测试用例(含 GWT) | 需求确认 / 风险识别 |

| 执行监督 Agent | 监控自动化结果,分析失败根因 | Jenkins 构建完成 |

| 知识沉淀 Agent | 将有效用例/根因归档到知识库 | 用例通过验证 / 缺陷关闭 |

💡 协同机制:通过 Dify 工作流(Workflow) 串联多个 Agent

3. 工作流引擎(Workflow Engine)

示例:PR 触发的端到端测试决策流

关键节点配置(Dify 工作流)

- LLM 节点:调用不同 Agent 的 Prompt

- 条件判断:

if risk_level == "High" - 工具调用:

- HTTP 请求:调用 GitLab API 获取 Diff

- Webhook:推送任务到 TestRail

- 自定义函数:校验用例是否覆盖边界值

4. 工具集成网关(Tool Integration Gateway)

Dify 支持通过 HTTP 插件 或 自定义工具 对接外部系统:

| 系统 | 集成方式 | 能力 |

|---|---|---|

| GitLab/GitHub | Webhook + REST API | 获取代码变更、评论 PR |

| Jira/TestRail | REST API + Token | 创建缺陷、同步测试计划 |

| Jenkins/CI | Webhook 监听 | 触发分析、获取测试报告 |

| 飞书/钉钉 | 机器人 Webhook | 发送通知、审批请求 |

| 内部知识库 | 数据库连接 / API | 实时查询业务规则 |

🔒 安全:所有密钥通过 Dify “变量管理” 加密存储

四、典型应用场景

场景 1:需求 → 测试用例自动转化

- 输入:PRD 文档(Markdown)

- 流程:

- 需求分析师 Agent 提取验收条件

- 用例设计师 Agent 生成边界/异常/安全用例

- 自动创建 TestRail 测试计划

- 输出:结构化用例 + 覆盖率报告

场景 2:代码提交 → 智能测试建议

- 输入:Git Push Event

- 流程:

- 风险雷达 Agent 分析变更模块

- 结合历史缺陷,判定风险等级

- 高风险 → 生成深度测试方案;低风险 → 快速放行

- 输出:PR 评论:“建议重点测试库存扣减并发场景”

场景 3:自动化失败 → 根因分析

- 输入:Allure 报告摘要

- 流程:

- 执行监督 Agent 分析错误日志

- 比对历史相似失败

- 输出排查建议:“可能是 Mock 服务未启动”

- 输出:自动创建 Jira 子任务或评论到 Slack

五、确保准确性与可信度(关键!)

参考前文所述 四重保障体系:

- 精准输入:预处理数据,结构化上下文

- 约束推理:强 Schema 输出 + 规则兜底

- 外部验证:高风险建议需人工确认

- 持续进化:建立反馈闭环,优化 Prompt

📊 监控指标:

- 建议采纳率 ≥80%

- 误报率 ≤10%

- 平均修正耗时 <2 分钟

六、落地路线图(分阶段实施)

| 阶段 | 目标 | 周期 | 产出 |

|---|---|---|---|

| Phase 1 (试点) |

单点突破: PR 触发测试建议 |

2~4 周 | Dify 工作流 + GitHub 集成 |

| Phase 2 (扩展) |

覆盖核心链路: 需求→用例→执行分析 |

6~8 周 | 多 Agent 协同 + TestRail 集成 |

| Phase 3 (平台化) |

全流程智能: 质量风险看板 + 知识自沉淀 |

3 个月+ | 企业级测试智能体平台 |

七、技术栈建议

| 组件 | 推荐方案 |

|---|---|

| AI 平台 | Dify(开源版 or 企业版) |

| 大模型 | GPT-4o / Claude 3.5 / Qwen-Max(按场景选) |

| 知识库 | Dify 内置向量库 + Confluence 同步 |

| CI/CD | Jenkins / GitLab CI |

| 测试管理 | TestRail / Xray / Zephyr |

| 通知 | 飞书机器人 / 钉钉机器人 |

结语:从“工具辅助”到“智能协同”

Dify 构建的不是又一个测试工具,

而是一个会学习、会决策、会协作的测试智能体生态。

当你做到:

- ✅ 需求一出,用例自生

- ✅ 代码一改,风险自知

- ✅ 执行一败,根因自明

——你就实现了 AI 原生的质量工程。

未来的测试团队,不是人+工具,而是人+智能体。

现在,就是构建它的最好时机。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)