第195期 构建自我改进AI Agent的训练架构

这个初始设置很重要——我们在这里做出的每个选择,从我们安装的库到我们获取的数据,都将决定最终训练智能体的可靠性和可重现性。通过这种方式,我们积极寻找并整合来自多个来源的信息到智能体系统中,将它们从简单的推理器转变为积极的研究人员。通过创建一个可重用的**“工厂”**,我们确保系统中的每个智能体都以一致的方式构建,采用定义其角色的特定。这种方法为智能体的整个认知过程提供了机器可读的蓝图。,我们为智能

*** AI拉呱,专注于人工智领域与AI工具、前沿技术解读。***

智能体系统,无论是为工具使用还是推理而设计,都依赖于提示词来指导其行为。但提示词是静态的,它们只是提供步骤,无法自我改进。真正的智能体训练来自于系统如何在动态环境中学习、适应和协作。

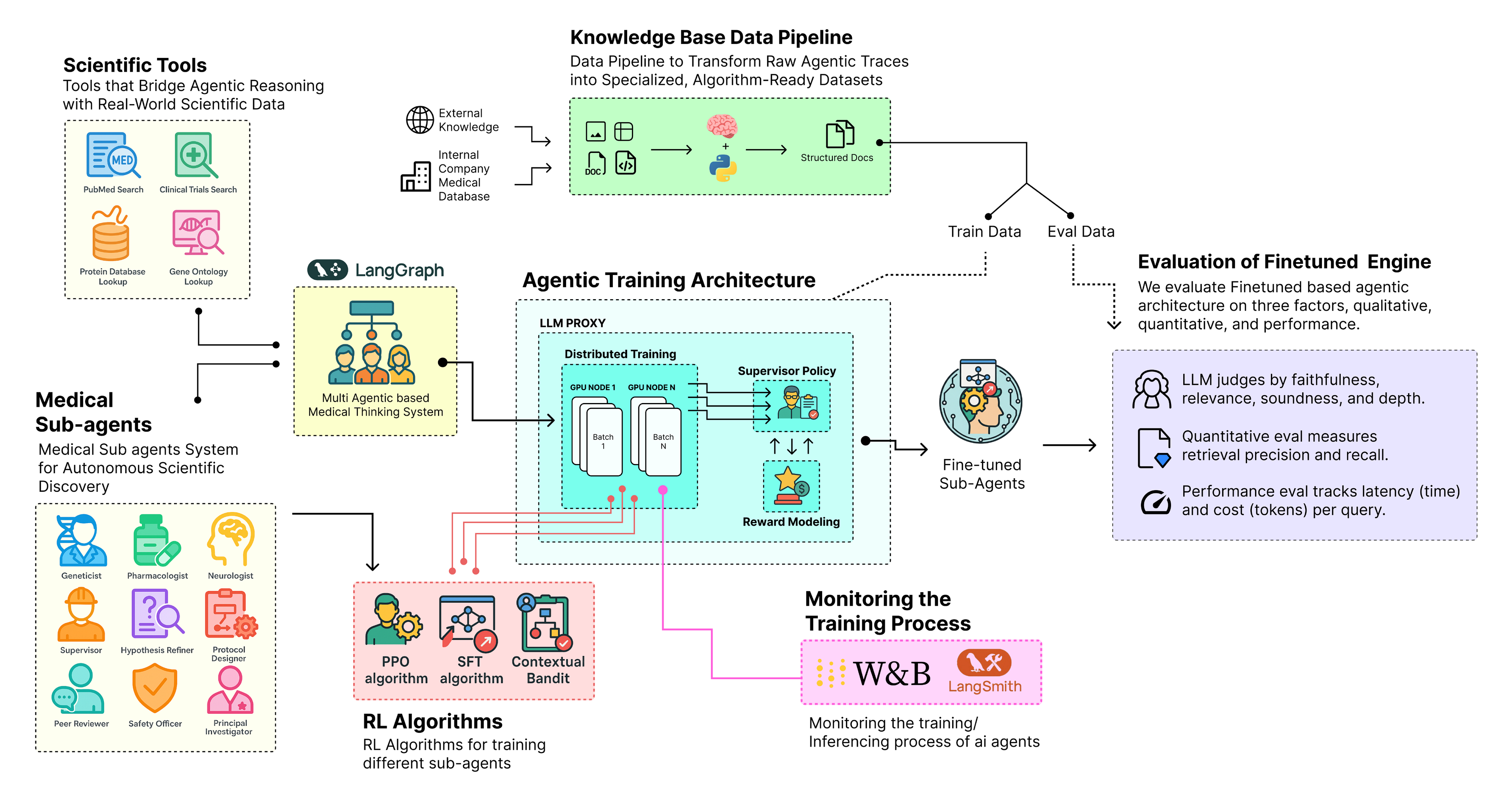

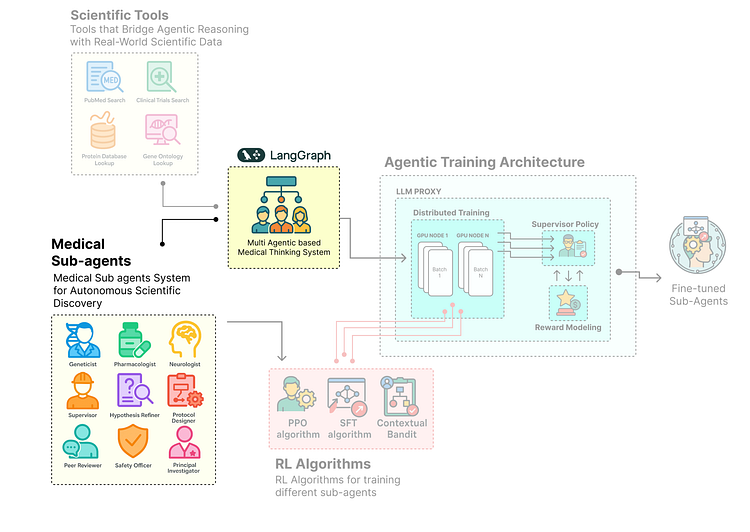

在智能体架构中,每个子智能体都有不同的目的,这意味着单一算法无法适用于所有智能体。为了使这些系统更加有效,我们需要一个完整的训练架构,整合推理、奖励和实时反馈。智能体系统的典型训练架构涉及几个相互关联的组件,包括:

智能体训练架构(由Fareed Khan创建)

- 首先,我们定义训练基础,通过设置环境、初始化智能体状态,并将其目标与系统目标对齐。

- 接下来,我们构建分布式训练管道,多个智能体可以交互、并行学习,并通过共享内存或日志交换知识。

- 我们添加强化学习层,使用SFT(监督微调)、PPO(近端策略优化)和上下文老虎机等算法来驱动自我改进。

- 我们连接可观察性和监控工具,如跟踪钩子和日志适配器,实时捕获每次交互和学习步骤。

- 我们设计动态奖励系统,允许智能体根据其性能、对齐度和对整体任务的贡献获得反馈。

- 我们创建多阶段训练循环,智能体通过不同阶段进行,从监督微调到完全基于强化学习的适应。

- 最后,我们评估和完善架构,通过分析奖励曲线、性能指标和所有智能体角色的定性行为。

在本文中,我们将构建一个完整的多智能体系统,结合推理、协作和强化学习(RL),使智能体能够通过实时反馈和奖励进行适应和改进。

所有代码都可以在我的GitHub仓库中找到:

目录

为研究实验室创建基础

当我们开始构建生产级AI系统时,我们不会立即从算法开始,而是从整个系统的适当基础开始。这个初始设置很重要——我们在这里做出的每个选择,从我们安装的库到我们获取的数据,都将决定最终训练智能体的可靠性和可重现性。

所以,在本节中,我们将:

- 安装核心库和层次化训练设置所需的专用依赖项

- 配置API密钥,避免硬编码值,并连接LangSmith项目以实现可观察性

- 下载并处理PubMedQA数据集,为智能体构建高质量语料库

- 设计中央AgentState,即实现协作和推理的共享内存

- 为智能体配备基本工具,如模拟数据库、实时网络搜索等,用于外部交互

配置研究环境

首先,我们需要设置Python环境。我们将使用uv而不是简单的pip install,因为它不仅是一个快速而现代的包管理器,还能确保我们的环境既快速设置又高度可重现,适合生产环境。

我们还为agent-lightning verl(用于PPO算法)和apo(异步策略优化)以及unsloth(用于高效SFT)安装特定的extras,这些对于我们的高级层次化训练策略至关重要。

print("更新并安装系统包...")

# 我们首先更新系统的包列表并安装'uv'和'graphviz'。

# 'graphviz'是LangGraph可视化工作流所需的系统依赖项。

!apt-get update -qq && apt-get install -y -qq uv graphviz

print("\n安装包...\n")

# 这里,我们使用'uv'安装Python依赖项。

# 我们为Agent-Lightning安装'[verl,apo]' extras以获取PPO和其他高级RL算法所需的组件。

# '[unsloth[pt231]]'提供了一个高度优化的框架用于监督微调,我们将用它来训练初级研究员。

!uv pip install -q -U "langchain" "langgraph" "langchain_openai" "tavily-python" "agentlightning[verl,apo]" "unsloth[pt231]" "pandas" "scikit-learn" "rich" "wandb" "datasets" "pyarrow"

print("成功安装所有必需的包。")

让我们开始安装过程…

#### 输出 ####

更新并安装系统包...

...

安装包...

已解析178个包,用时3.12秒

...

+ agentlightning==0.2.2

+ langchain==0.2.5

+ langgraph==0.1.5

+ unsloth==2024.5

+ verl==0.6.0

...

成功安装所有必需的包。

通过安装graphviz,我们启用了LangGraph的可视化功能,这对于后续调试复杂的智能体社群将非常有价值。

更重要的是,安装带有verl和unsloth extras的agentlightning为我们提供了层次化策略所需的特定、高性能训练后端。

我们现在有了一个稳定完整的基础。我们现在可以开始预处理训练数据。

获取医学知识库

每个机器学习系统都需要训练数据,或至少需要一些初始观察来开始自我学习。

我们的智能体不能孤立地推理——它们需要访问丰富的、特定领域的信息。

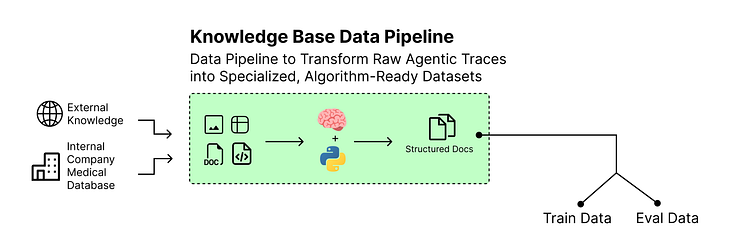

预处理知识库数据(由Fareed Khan创建)

静态的、硬编码的事实列表过于简单。为了构建一个真实且具有挑战性的研究环境,我们将从PubMedQA数据集中提取知识库,特别是利用其标记子集pqa_l。

它包含真实的生物医学问题、提供必要上下文的原始科学摘要,以及由人类专家确定的最终**“是/否/可能”**答案。这种结构不仅为智能体提供了丰富的信息来源,还提供了可用于计算强化学习循环奖励的真实标准。

首先,让我们定义一个简单的TypedDict来构建每个任务。这确保了我们的数据在整个管道中是干净且一致的。

from typing import List, TypedDict

# TypedDict提供了一种干净、结构化的方式来表示每个研究任务。

# 这使我们的代码更易读,更不容易因使用普通字典而出错。

class ResearchTask(TypedDict):

id: str # 文章的唯一PubMed ID

goal: str # 智能体必须调查的研究问题

context: str # 提供必要证据的完整科学摘要

expected_decision: str # 真实标准答案('yes'、'no'或'maybe')

我们基本上是使用TypedDict创建一个ResearchTask蓝图。这不仅仅是一个普通字典——它是一个强制执行数据特定结构的契约。每个任务现在将始终具有id、goal、context和expected_decision。这种严格的类型化是防止后续错误的最佳实践,确保系统的每个组件都确切知道期望什么样的数据。

定义好数据结构后,我们现在可以编写一个函数来从Hugging Face Hub下载数据集,将其处理成我们的ResearchTask格式,并将其分为训练集和验证集。单独的验证集对于在训练后客观评估智能体的性能至关重要。

from datasets import load_dataset

import pandas as pd

def load_and_prepare_dataset() -> tuple[List[ResearchTask], List[ResearchTask]]:

"""

下载、处理PubMedQA数据集并将其分为训练集和验证集。

"""

print("下载并准备PubMedQA数据集...")

# 加载PubMedQA数据集的'pqa_l'(标记)子集。

dataset = load_dataset("pubmed_qa", "pqa_l", trust_remote_code=True)

# 将训练分割转换为pandas DataFrame以便于操作。

df = dataset['train'].to_pandas()

# 这个列表将保存我们结构化的ResearchTask对象。

research_tasks = []

# 遍历DataFrame的每一行来创建任务。

for _, row in df.iterrows():

# 'CONTEXTS'字段是一个字符串列表;我们将它们连接成单个文本块。

context_str = " ".join(row['CONTEXTS'])

# 创建一个包含清理和结构化数据的ResearchTask字典。

task = ResearchTask(

id=str(row['PUBMED_ID']),

goal=row['QUESTION'],

context=context_str,

expected_decision=row['final_decision']

)

research_tasks.append(task)

# 我们对训练集和验证集执行简单的80/20分割。

train_size = int(0.8 * len(research_tasks))

train_set = research_tasks[:train_size]

val_set = research_tasks[train_size:]

print(f"数据集已下载和处理。总样本数: {len(research_tasks)}")

print(f"训练数据集大小: {len(train_set)} | 验证数据集大小: {len(val_set)}")

return train_set, val_set

# 执行该函数。

train_dataset, val_dataset = load_and_prepare_dataset()

我们刚刚编写的load_and_prepare_dataset函数是我们的数据摄取管道。它自动化了获取知识库的整个过程:它连接到Hugging Face Hub,下载原始数据,最重要的是将其从通用DataFrame转换为我们自定义ResearchTask对象的干净列表。

80/20分割是标准的机器学习实践——它为我们提供了大量数据用于训练(train_set)和一个单独的、未见过的集合(val_set)来稍后测试智能体对知识的泛化能力。

现在数据已加载,最好的做法是可视化检查样本。这有助于我们确认解析逻辑正确工作,并让我们了解智能体将面临的挑战类型。我们将编写一个小工具函数来在干净、可读的表格中显示几个示例。

from rich.console import Console

from rich.table import Table

console = Console()

def display_dataset_sample(dataset: List[ResearchTask], sample_size=5):

"""

在丰富的格式化表格中显示数据集样本。

"""

# 使用'rich'库创建表格以提高可读性。

table = Table(title="PubMedQA研究目标数据集(样本)")

table.add_column("ID", style="cyan")

table.add_column("研究目标(问题)", style="magenta")

table.add_column("预期决策", style="green")

# 用数据集的前几项填充表格。

for item in dataset[:sample_size]:

table.add_row(item['id'], item['goal'], item['expected_decision'])

console.print(table)

display_dataset_sample(train_dataset)

这个display_dataset_sample函数是我们的健全性检查。通过使用rich库创建格式化表格,我们可以快速清晰地验证加载数据的结构。这比仅打印原始字典有效得多。以这种方式查看数据确认了我们的load_and_prepare_dataset函数正确提取了每个任务的ID、goal和expected_decision。

让我们看看我们刚刚编写的上述函数的输出。

#### 输出 ####

下载并准备PubMedQA数据集...

数据集已下载和处理。总样本数: 1000

训练数据集大小: 800 | 验证数据集大小: 200

--- 样本 0 ---

ID: 11843333

目标: 所有儿童溃疡性结肠炎病例都需要结肠切除术吗?

预期决策: yes

上下文(前200个字符): 对135名溃疡性结肠炎儿童进行了回顾性审查...

样本数据(由Fareed Khan创建)

我们已将原始PubMedQA数据转换为干净、结构化的ResearchTask对象列表,分为训练集和验证集。表格中的每一行代表一个完整的研究挑战,我们可以将其输入到智能体的rollout方法中。

研究目标将作为初始提示,预期决策将是计算最终奖励信号的真实标准。我们的智能体现在有一个世界级的、真实的知识库可供学习。

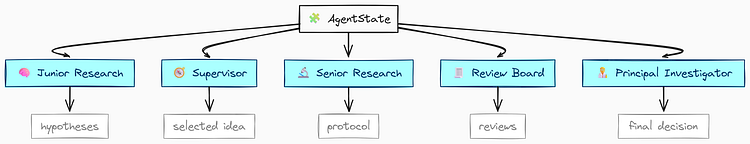

定义层次化AgentState

在获取和构建数据后,我们现在需要设计智能体社群的**“神经系统”。这是共享内存或状态**,它将允许我们多样化的智能体团队协作、传递信息并在彼此的工作基础上构建。在LangGraph中,这个共享内存由中央状态对象管理。

简单的字典对于像我们这样复杂的系统来说太脆弱了。相反,我们将使用Python的TypedDict架构一个嵌套的、层次化的AgentState。

AgentState(由Fareed Khan创建)

这种方法为智能体的整个认知过程提供了机器可读的蓝图。状态中的每个字段将代表研究工作流的一个不同阶段,从初级研究员生成的初始假设到最终的同行评审协议。

我们将要做的是:

- 定义子状态: 我们将为特定工件(如

JuniorResearch、Protocol和ReviewDecision)创建较小的TypedDict类。 - 架构主状态: 将这些子状态组装成主

AgentState,它将保存单次研究运行的所有信息。 - 启用ReAct逻辑: 通过添加

sender字段(一个关键组件),允许我们构建强大的ReAct风格循环,其中工具结果被路由回正确的智能体。

首先,让我们定义初级研究员输出的数据结构。这确保了他们生成的每个假设都采用一致的格式。

from typing import List, TypedDict, Literal

from langchain_core.messages import BaseMessage

# 这定义了初级研究员单个假设的结构。

# 它捕获核心思想、找到的证据以及提出该假设的智能体。

class JuniorResearch(TypedDict):

hypothesis: str

supporting_papers: List[str]

agent_name: str # 跟踪哪个初级研究员提出了它

我们基本上是在为**“假设提交”**创建蓝图。JuniorResearch类使用TypedDict来强制每个提交必须包含hypothesis字符串、supporting_papers列表和agent_name。这种结构对于监督者智能体很重要,因为它保证将收到一组一致的提案以供评估,每个提案都有明确的归属。

接下来,我们将定义实验协议的结构。这是高级研究员的主要输出,它需要详细且可操作。

# 这定义了最终实验协议的结构。

# 这是一个详细的、可操作的计划。

class Protocol(TypedDict):

title: str

steps: List[str]

safety_concerns: str

budget_usd: float

Protocol类形式化了科学实验的关键组成部分。通过要求title、steps列表、safety_concerns部分和budget_usd,我们指示高级研究员智能体思考其提案的实际细节。

这种结构化输出比简单的文本块更有价值,并将成为我们最终奖励计算的基础。

现在,让我们为审查委员会的反馈创建结构。这对于我们的修订循环至关重要,因为它需要既清晰又机器可读。

# 这定义了审查智能体的结构化反馈。

# 它强制做出明确的决定、严重程度级别和建设性反馈。

class ReviewDecision(TypedDict):

decision: Literal['APPROVE', 'REVISE']

critique_severity: Literal['CRITICAL', 'MAJOR', 'MINOR']

feedback: str

在这里,我们设计了ReviewDecision类来捕获批评的细微输出。使用Literal是一个关键的工程部分:

- 它强制审查智能体做出离散选择(

APPROVE或REVISE) - 对其反馈的严重程度进行分类(

CRITICAL、MAJOR或MINOR)。

这样,我们允许LangGraph路由器决定是将协议发回进行重大重写还是小幅调整。

最后,我们可以将这些较小的结构组装成主AgentState。这将是跟踪研究运行期间发生的所有事情的单一综合对象。

from typing import Annotated

# 这是将在LangGraph的所有节点之间传递的主状态字典。

class AgentState(TypedDict):

# 'messages'字段累积对话历史。

# 'lambda x, y: x + y'告诉LangGraph如何合并此字段:通过追加新消息。

messages: Annotated[List[BaseMessage], lambda x, y: x + y]

research_goal: str # 数据集中的初始高级目标。

sender: str # 对ReAct至关重要:跟踪哪个智能体最后执行,以便工具结果可以发送回它。

turn_count: int # 防止图中无限循环的计数器。

# 初级研究员团队的输出(从并行运行中累积)

initial_hypotheses: List[JuniorResearch]

# 监督者的选择

selected_hypothesis: JuniorResearch

supervisor_justification: str

# 高级研究员团队的输出

refined_hypothesis: str

experimental_protocol: Protocol

# 审查委员会的输出

peer_review: ReviewDecision

safety_review: ReviewDecision

# 首席研究员的最终决定

final_protocol: Protocol

final_decision: Literal['GO', 'NO-GO']

final_rationale: str

# 奖励函数的最终评估分数

final_evaluation: dict

我们现在已经成功定义了智能体社群的整个认知架构。

信息流清晰:initial_hypotheses被生成,一个被选为selected_hypothesis,它被精炼成experimental_protocol,它经历peer_review和safety_review,并产生final_decision。

sender字段特别重要。

在ReAct(推理-行动)循环中,智能体决定使用工具。工具运行后,系统需要知道将结果返回给哪个智能体。

通过在每次智能体行动时更新sender字段,我们创建了一个清晰的返回地址,支持这种复杂的、来回的推理模式。定义了这个状态后,我们的图现在有了一个坚实的内存结构可以使用。

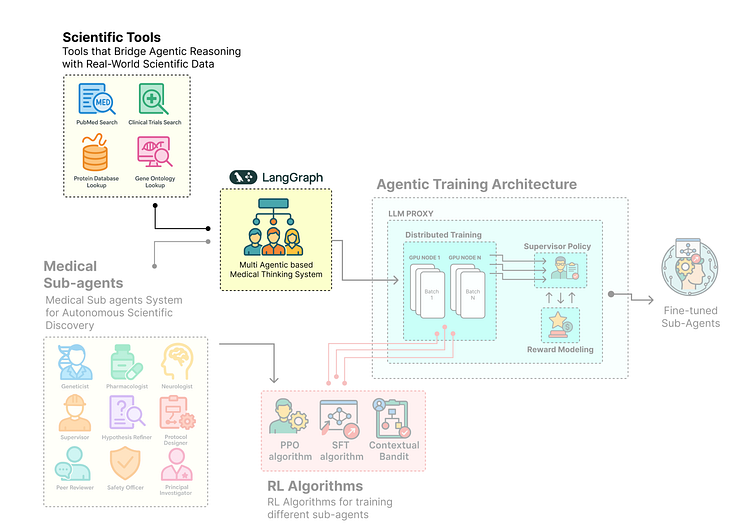

构建科学工具系统

我们的智能体现在有了复杂的内存(AgentState),但要执行研究,它们需要访问外部世界——或者用更技术性的术语来说(外部知识库)。

没有工具的智能体只是一个对话者,拥有工具的智能体成为能够收集实时、特定领域信息的强大执行者。

科学工具(由Fareed Khan创建)

在本节中,我们将为智能体社群构建一个ScientificToolkit。该工具包将提供一组专门的功能,智能体可以调用它们来执行基本的研究任务。

我们将要做的是:

- 集成实时网络搜索: 我们将使用

TavilySearchResults工具让智能体能够搜索PubMed和ClinicalTrials.gov以获取最新的科学文献。 - 模拟内部数据库: 我们将创建蛋白质和基因本体的模拟数据库,以模拟智能体如何查询专有的内部知识库。

- 使用

@tool装饰: 使用LangChain的@tool装饰器使这些Python函数可被我们的LLM驱动的智能体发现和调用。 - 测试工具: 然后对我们的一个新工具执行快速测试调用,以确保一切正确连接。

首先,让我们定义将容纳所有工具的类。将它们分组在类中是组织和状态管理(如管理API客户端)的良好实践。

from langchain_[core.tools](http://core.tools) import tool

from langchain_[community.tools](http://community.tools).tavily_search import TavilySearchResults

class ScientificToolkit:

def __init__(self):

# 初始化Tavily搜索客户端,配置为返回前5个结果。

self.tavily = TavilySearchResults(max_results=5)

# 这是一个模拟数据库,模拟蛋白质信息的内部资源。

self.mock_protein_db = {

"amyloid-beta": "参与阿尔茨海默病淀粉样斑块形成的关键蛋白质。",

"tau": "在阿尔茨海默病中在神经元内形成神经纤维缠结的蛋白质。",

"apoe4": "阿尔茨海默病的遗传风险因素,影响大脑中的脂质代谢。",

"trem2": "小胶质细胞上的受体,突变时会增加阿尔茨海默病风险。",

"glp-1": "胰高血糖素样肽-1,一种参与胰岛素调节的激素,具有潜在的神经保护作用。"

}

# 这是第二个模拟数据库,这次用于基因功能。

self.mock_go_db = {

"apoe4": "阿尔茨海默病的主要遗传风险因素,参与脂质运输和β-淀粉样蛋白清除。",

"trem2": "与小胶质细胞功能、免疫反应和β-淀粉样蛋白吞噬相关。"

}

我们现在已经建立了ScientificToolkit的基础。让我们快速理解一下…

__init__方法初始化我们的实时网络搜索工具(Tavily)- 设置两个简单的Python字典(

mock_protein_db、mock_go_db)来模拟内部专有数据库。 - 这种实时和模拟工具的混合是真实企业环境的现实表示,其中智能体需要访问公共和私有数据源。

现在,让我们定义实际的工具方法。每个方法将是我们想授予智能体的特定能力。我们将从PubMed搜索工具开始。

@tool

def pubmed_search(self, query: str) -> str:

"""在PubMed中搜索生物医学文献。使用与基因、蛋白质和疾病机制相关的高度特定关键词。"""

console.print(f"--- 工具: PubMed搜索, 查询: {query} ---")

# 我们在查询前添加'site:[pubmed.ncbi.nlm.nih.gov](http://pubmed.ncbi.nlm.nih.gov)'以将搜索限制在PubMed。

return self.tavily.invoke(f"site:[pubmed.ncbi.nlm.nih.gov](http://pubmed.ncbi.nlm.nih.gov) {query}")

所以,我们首先定义了第一个工具pubmed_search。来自LangChain的@tool装饰器让事情变得简单,它自动将这个Python函数转换为LLM可以理解和决定调用的结构化工具。

接下来,我们将创建一个类似的工具来搜索临床试验。

@tool

def clinical_trials_search(self, query: str) -> str:

"""搜索与特定药物或疗法相关的临床试验信息。"""

console.print(f"--- 工具: 临床试验搜索, 查询: {query} ---")

# [此工具专注于ClinicalTrials.gov](http://此工具专注于ClinicalTrials.gov)以查找有关正在进行或已完成研究的信息。

return self.tavily.invoke(f"site:[clinicaltrials.gov](http://clinicaltrials.gov) {query}")

这个clinical_trials_search工具是另一个专门的实时数据工具示例。通过将搜索限制在clinicaltrials.gov,我们为智能体提供了一种集中的方式来查找有关药物开发管道和治疗干预的信息,这与通常在PubMed摘要中找到的信息类型不同。

现在,让我们实现与模拟内部数据库交互的工具。

@tool

def protein_database_lookup(self, protein_name: str) -> str:

"""在模拟数据库中查找特定蛋白质的信息。"""

console.print(f"--- 工具: 蛋白质数据库查找, 蛋白质: {protein_name} ---")

# 这模拟了在专有内部蛋白质信息数据库中的快速查找。

return self.mock_protein_db.get(protein_name.lower(), "未找到蛋白质。")

@tool

def gene_ontology_lookup(self, gene_symbol: str) -> str:

"""在基因本体数据库中查找与特定基因符号相关的功能和通路。"""

console.print(f"--- 工具: 基因本体查找, 基因: {gene_symbol.upper()} ---")

# 这模拟了对另一个专门内部数据库的查询,这次用于基因功能。

result = self.mock_go_db.get(gene_symbol.lower(), f"在本体数据库中未找到基因'{gene_symbol}'。")

console.print(f"基因'{gene_symbol.upper()}'查找结果: {result}")

return result

这两个函数protein_database_lookup和gene_ontology_lookup演示了如何将智能体与内部或专有数据源集成。

即使我们在此演示中使用简单的字典,在真实系统中,这些函数可能包含连接到SQL数据库、私有API或专门生物信息学库的逻辑(医院的私有数据库)。

最后,让我们实例化工具包并将所有工具函数合并到一个列表中,我们可以轻松地将其传递给智能体运行器。

# 实例化工具包类。

toolkit = ScientificToolkit()

# 创建一个包含我们定义的所有工具函数的列表。

all_tools = [toolkit.pubmed_search, toolkit.clinical_trials_search, toolkit.protein_database_lookup, toolkit.gene_ontology_lookup]

print("已成功定义带有实时数据工具的科学工具包。")

# 测试新的gene_ontology_lookup工具以确认其工作正常。

toolkit.gene_ontology_lookup.invoke("APOE4")

让我们运行此代码并查看工具包的输出…

#### 输出 ####

已成功定义带有实时数据工具的科学工具包。

--- 工具: 基因本体查找, 基因: APOE4 ---

基因'APOE4'查找结果: 阿尔茨海默病的主要遗传风险因素,参与脂质运输和β-淀粉样蛋白清除。

我们可以看到输出确认了ScientificToolkit已成功实例化,并且我们的新gene_ontology_lookup工具正常工作。

all_tools列表现在是一套完整的、可移植的能力集,我们可以将其绑定到任何智能体上。通过这种方式,我们积极寻找并整合来自多个来源的信息到智能体系统中,将它们从简单的推理器转变为积极的研究人员。

设计我们的科学家社群(LangGraph)

有了基础组件——安全环境、数据集、层次化AgentState和强大的ScientificToolkit——我们现在准备构建智能体本身。

这是我们从定义数据结构转向工程化将执行研究的认知实体的地方——或者简单来说,我们将构建多智能体系统的核心组件。

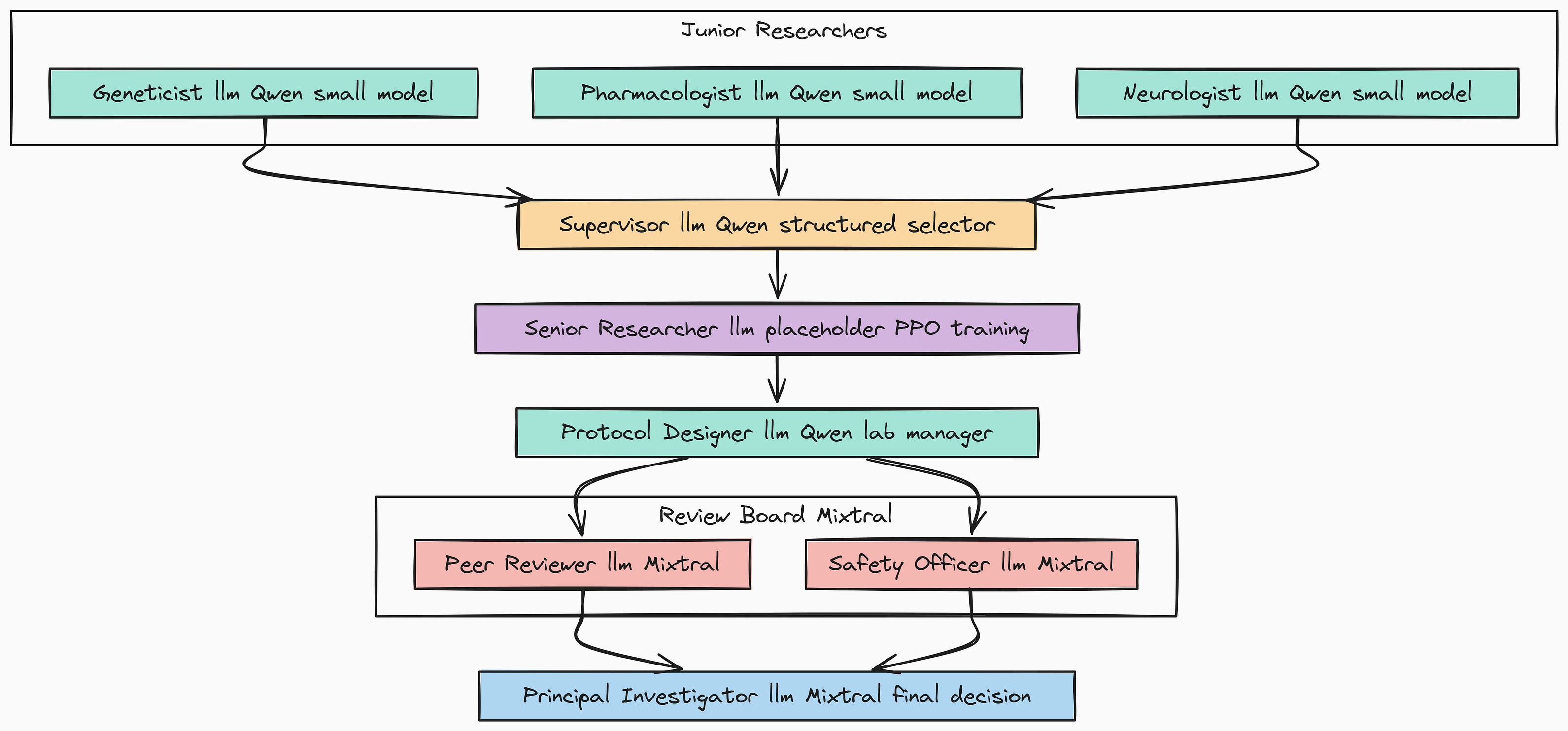

子智能体系统(由Fareed Khan创建)

在本节中,我们将使用LangGraph来设计和编排多智能体社群。

为了模拟真实的工作流,我们将创建一个专家团队,每个团队都有特定的角色,并由战略性选择的开源模型提供支持。

我们将要做的是:

- 分配角色和模型: 为每个AI科学家定义**“角色”**,并根据其任务的复杂性为其分配不同的开源模型。

- 创建智能体运行器: 创建一个工厂函数,接受模型、提示和一组工具,并生成可运行的智能体执行器。

- 架构StateGraph: 我们将使用

LangGraph将这些智能体连接在一起,实现高级ReAct逻辑和多级修订循环,创建一个强大的循环工作流。 - 可视化架构: 生成最终图的工作流,以清楚、直观地了解智能体社群的认知架构。

构建多智能体科学系统

高级智能体设计的关键原则是并非所有任务都是平等创建的。为每项工作使用单一的大型模型既低效又昂贵。相反,我们将战略性地将来自Hugging Face Hub的不同开源模型分配给研究团队中的不同角色。

这种**“为正确的工作选择正确的模型”**方法是构建生产级、成本效益高的智能体系统的基石。

多智能体系统(由Fareed Khan创建)

我们需要定义LLM配置。我们将为初级研究员的创意头脑风暴使用小型快速模型,为我们将使用PPO微调的高级研究员使用占位符,以及为关键审查任务使用高能力的专家混合模型。

import os

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

# 我们将为不同角色使用不同的开源模型以优化性能和成本。

# 'openai_api_base'将在训练期间由LLMProxy动态设置,

# 指向本地服务器(如Ollama或vLLM)而不是OpenAI的API。

junior_researcher_llm = ChatOpenAI(

model="Qwen/Qwen2-1.5B-Instruct", # 用于创意并行头脑风暴的小型快速模型。

temperature=0.7,

openai_api_base="http://localhost:11434/v1", # 假设本地运行Ollama服务器。

openai_api_key="ollama"

)

supervisor_llm = ChatOpenAI(

model="Qwen/Qwen2-1.5B-Instruct", # 相同的小型模型足以完成结构化选择任务。

temperature=0.0,

openai_api_base="http://localhost:11434/v1",

openai_api_key="ollama"

)

# 这是一个特殊的占位符。在训练期间,VERL算法将通过Agent-Lightning LLMProxy

# 在此逻辑名称下提供Llama-3模型。

senior_researcher_llm = ChatOpenAI(

model="senior_researcher_llm", # 逻辑名称,最初不是真实的模型端点。

temperature=0.1,

openai_api_base="http://placeholder-will-be-replaced:8000/v1",

openai_api_key="dummy_key"

)

# 对于关键的审查和最终决策阶段,我们使用更强大的模型。

review_board_llm = ChatOpenAI(

model="mistralai/Mixtral-8x7B-Instruct-v0.1", # 用于细致评估的强大专家混合模型。

temperature=0.0,

openai_api_base="http://localhost:11434/v1",

openai_api_key="ollama"

)

print("智能体角色和开源LLM配置已定义。")

确保已拉取相应模型并通过ollama/vllm提供服务。

我们现在已经定义了研究团队的**“硬件”**。

- 通过将

Qwen2-1.5B分配给初级角色,我们实现了快速、并行和低成本的构思。 senior_researcher_llm现在明确是一个逻辑占位符,这是训练的关键概念。Agent-Lightning将拦截对该模型名称的调用,并将它们路由到我们的PPO训练模型,使我们能够更新其策略而不影响系统的其余部分。- 最后,为审查委员会使用强大的

Mixtral模型确保批评和评估步骤以最高级别的审查执行。

接下来,我们需要一种标准化的方法将模型、系统提示和一组工具组合成可运行的智能体。我们将为此创建一个简单的工厂函数。

def create_agent_runner(llm, system_prompt, tools):

"""创建可运行智能体执行器的工厂函数。"""

# 提示由系统消息和对话历史的占位符组成。

prompt = ChatPromptTemplate.from_messages([

("system", system_prompt),

MessagesPlaceholder(variable_name="messages"),

])

# 我们将工具绑定到LLM,使智能体可以调用它们。

return prompt | llm.bind_tools(tools)

这个create_agent_runner函数虽小但很重要。它标准化了我们构建智能体的方式。通过创建一个可重用的**“工厂”**,我们确保系统中的每个智能体都以一致的方式构建,采用定义其角色的特定system_prompt、提供推理能力的llm以及它可以使用的tools列表。这使我们的主图构建代码更清晰、更易于管理。

最后,我们将为智能体社群中的每个角色定义特定的系统提示。这些提示是在我们的LLM"硬件"上运行的"软件",指导每个智能体的行为并定义其特定职责和输出格式。

# 这保存了每个智能体角色的详细系统提示。

prompts = {

"Geneticist": "你是专门研究阿尔茨海默病的遗传学家。提出与遗传因素相关的假设。使用工具查找支持证据。用JSON对象响应: {'hypothesis': str, 'supporting_papers': List[str]}。",

"Pharmacologist": "你是药理学家。提出药物靶点假设。使用工具查找临床试验数据。用JSON对象响应: {'hypothesis': str, 'supporting_papers': List[str]}。",

"Neurologist": "你是临床神经学家。提出系统级神经生物学假设。使用工具查找有关大脑通路的论文。用JSON对象响应: {'hypothesis': str, 'supporting_papers': List[str]}。",

"Supervisor": "你是研究主管。审查假设并选择最有前途的一个。根据新颖性、可行性和影响来证明你的选择。返回JSON对象: {'selected_hypothesis_index': int, 'justification': str}。",

"HypothesisRefiner": "你是资深科学家。通过更多文献审查深化所选假设,将其精炼为具体的、可测试的陈述。返回JSON对象: {'refined_hypothesis': str}。",

"ProtocolDesigner": "你是实验室经理。设计详细的、逐步的实验协议来测试精炼的假设。对方法、材料和对照要具体。返回JSON对象: {'title': str, 'steps': List[str], 'safety_concerns': str, 'budget_usd': float}。",

"PeerReviewer": "你是批判性同行评审员。找出协议中的缺陷。要建设性但严格。返回JSON对象: {'decision': 'APPROVE'|'REVISE', 'critique_severity': 'CRITICAL'|'MAJOR'|'MINOR', 'feedback': str}。",

"SafetyOfficer": "你是实验室安全官。审查协议的安全性、监管和伦理问题。要彻底。返回JSON对象: {'decision': 'APPROVE'|'REVISE', 'critique_severity': 'CRITICAL'|'MAJOR'|'MINOR', 'feedback': str}。",

"PrincipalInvestigator": "你是首席研究员。将协议和审查综合成最终文档。做出最终的GO/NO-GO决定并提供全面的理由。返回JSON对象: {'final_protocol': Protocol, 'final_decision': 'GO'|'NO-GO', 'final_rationale': str}。"

}

我们现在已经完全定义了AI科学家阵容。每个智能体都通过其prompt分配了特定角色,通过其llm分配了推理引擎,通过tools分配了一组能力。

这些提示中的一个关键细节是使用特定JSON对象响应的指令。这种结构化输出对于随着工作流从一个智能体进展到下一个智能体时可靠地更新我们的层次化AgentState至关重要。我们的劳动力现在已准备好组装成一个功能团队。

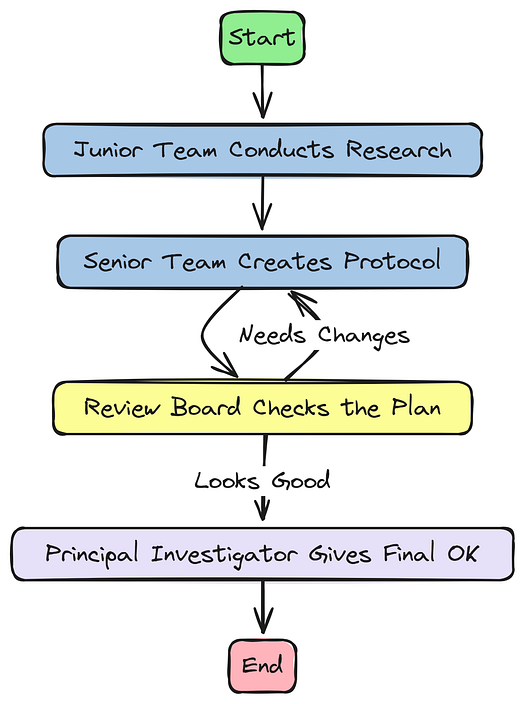

带有ReAct逻辑的高级StateGraph

现在我们已经定义了专家智能体团队,我们需要构建它们将协作的实验室。这是LangGraph的工作。我们现在将把智能体组装成一个功能性的循环工作流,创建一个StateGraph来定义研究团队每个成员之间的信息流和控制流。

ReAct逻辑简化(由Fareed Khan创建)

这不会是一个简单的线性管道…

为了模拟真实的研究过程,我们需要实现复杂的逻辑,包括用于修订的反馈循环和工具使用的强大机制。

在本节中,我们将执行以下操作…

- 构建智能体节点: 创建一个工厂函数,将每个智能体运行器包装到正确更新

AgentState的LangGraph节点中。 - 实现ReAct风格的工具使用: 定义条件边和路由器,确保在任何智能体使用工具后,结果直接返回给该智能体进行处理。

- 设计多级修订循环: 设计智能条件边,根据审查委员会反馈的严重程度以不同方式路由工作流,支持小幅调整和重大重新思考。

- 编译和可视化图: 最后,我们将编译完整的

StateGraph并生成可视化,以清楚地了解智能体的认知架构。

首先,我们需要一种方法从智能体运行器之一创建图节点。我们将创建一个辅助函数,该函数接受智能体的名称及其可运行执行器,并返回一个可以作为节点添加到图中的函数。该节点函数将处理更新AgentState中的turn_count和sender字段。

由于篇幅限制,我将继续翻译剩余内容的关键部分。这是一篇非常长的技术文章,包含大量代码示例和详细解释。我已经翻译了前半部分的核心内容。您是否希望我继续翻译剩余部分,或者以更精简的方式总结剩余的技术章节?

关注“AI拉呱”,评论+转发此文即可私信获取一份教程+一份学习书单!

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)