大模型评估测试—OpenCompass

OpenCompas是书生蒲语公司的一个开源项目,旨在为机器学习和自然语言处理领域提供多功能、易于使用的工具和框架。其中包含的多个开源模型和开源数据集(BenchMarks),方便进行模型的效果评测。目前支持.jsonl和.csv两种格式的数据集。

引言

每个模型的能力是不一样的,有的模型专注于逻辑推理,有的模型专注于文本生成,如果我们不知道模型的能力边界在哪里,就无法针对所需要做的事情来选择模型,对于大模型的开发者来说,他们就无法更好的去迭代模型的能力,所以需要进行模型评估,同时模型评估对于这个指导模型的能力提升也是具有非常重要的意义。在不同的业务场景下也同样需要一个健全的评估方式来评估选择什么样的大模型来适配要进行的业务场景。

模型评估业界常用的工具是 OpenCompass,其是书生蒲语公司推出的产品。官网:https://internlm.intern-ai.org.cn

一、OpenCompass框架介绍

OpenCompas 是书生蒲语公司的一个开源项目,旨在为机器学习和自然语言处理领域提供多功能、易于使用的工具和框架。其中包含的多个开源模型和开源数据集(BenchMarks),方便进行模型的效果评测。

1.1 OpenCompass评测能力层面

OpenCompass主要评测对象为语言大模型与多模态大模型,我们以语言大模型为例介绍评测的具体模型类型。

- 基座模型:一般是经过海量的文本数据以自监督学习的方式进行训练获得的模型(如

OpenAI的GPT-3,Meta的LLaMA),往往具有强大的文字续写能力。 - 对话模型:一般是在的基座模型的基础上,经过指令微调或人类偏好对齐获得的模型(如

OpenAI的ChatGPT、Qwen-x-Instruct),能理解人类指令,具有较强的对话能力。

-

模型层:大模型评测所涉及的主要模型种类,

OpenCompass以基座模型和对话模型作为重点评测对象。 -

能力层:

OpenCompass从通用能力和特色能力两个方面来进行评测维度设计。在模型通用能力方面,从语言、知识、理解、推理、安全等多个能力维度进行评测,一般开源的模型会公布评测结果;

在特色能力方面,从长文本、代码、工具、知识增强等维度进行评测,我们一般集中在特色能力的测评;

通用能力和特色能力使用的评估数据集不一样,开源的数据集主要评估模型的通用能力,自定义数据集主要评估模型的特色能力。

-

方法层:

OpenCompass采用客观评测与主观评测两种评测方式。客观评测能便捷地评估模型在具有确定答案(如选择,填空,封闭式问答等)的任务上的能力;

主观评测能评估用户对模型回复的真实满意度,

OpenCompass采用基于模型辅助的主观评测和基于人类反馈的主观评测两种方式; -

工具层:

OpenCompass提供丰富的功能支持自动化地开展大语言模型的高效评测。包括分布式评测技术,提示词工程,对接评测数据库,评测榜单发布,评测报告生成等诸多功能。

1.2 openCompass评测设计

1.3 openCompass评测方法

OpenCompass 采取客观评测与主观评测相结合的方法。针对具有确定性答案的能力维度和场景,通过构造丰富完善的评测集,对模型能力进行综合评价。针对体现模型能力的开放式或半开放式的问题、模型安全问题等,采用主客观相结合的评测方式。

1.3.1 客观评测

针对具有标准答案的客观问题,我们可以通过使用定量指标比较模型的输出与标准答案的差异,并根据结果衡量模型的性能。同时,由于大语言模型输出自由度较高,在评测阶段,我们需要对其输入和输出作一定的规范和设计,尽可能减少噪声输出在评测阶段的影响,才能对模型的能力有更加完整和客观的评价。

在客观评测的具体实践中,我们通常采用下列两种方式进行模型输出结果的评测:

-

判别式评测:该评测方式基于将问题与候选答案组合在一起,计算模型在所有组合上的困惑度(

perplexity),并选择困惑度最小的答案作为模型的最终输出。例如,若模型在问题x 答案1上的困惑度为 0.1,在问题x 答案2上的困惑度为 0.2,最终我们会选择答案1作为模型的输出。例如:

BERT模型的分类任务; -

生成式评测:该评测方式主要用于生成类任务,如语言翻译、程序生成、逻辑分析题等。具体实践时,使用问题作为模型的原始输入,并留白答案区域待模型进行后续补全。我们通常还需要对其输出进行后处理,以保证输出满足数据集的要求。

例如:医疗类、金融类、法律类等模型。

1.3.2 主观评测(即将发布)

语言表达生动精彩,变化丰富,大量的场景和能力无法凭借客观指标进行评测。针对如模型安全和模型语言能力的评测,以人的主观感受为主的评测更能体现模型的真实能力,并更符合大模型的实际使用场景。

OpenCompass 采取的主观评测方案是指借助受试者的主观判断对具有对话能力的大语言模型进行能力评测。在具体实践中,我们提前基于模型的能力维度构建主观测试问题集合,并将不同模型对于同一问题的不同回复展现给受试者,收集受试者基于主观感受的评分。由于主观测试成本高昂,本方案同时也采用使用性能优异的大语言模拟人类进行主观打分。在实际评测中,本文将采用真实人类专家的主观评测与基于模型打分的主观评测相结合的方式开展模型能力评估。

在具体开展主观评测时,OpenComapss 采用单模型回复满意度统计和多模型满意度比较两种方式开展具体的评测工作。

1.3 OpenCompass评估流程

在 OpenCompass 中评估一个模型通常包括以下几个阶段 :配置 -> 推理 -> 评估 -> 可视化。

-

配置:这是整个工作流的起点。您需要配置整个评估过程,选择要评估的模型和数据集。此外,还可以选择评估策略、计算后端等,并定义显示结果的方式。

-

推理与评估:在这个阶段,

OpenCompass将会开始对模型和数据集进行并行推理和评估。推理阶段主要是让模型从数据集产生输出,而评估阶段则是衡量这些输出与标准答案的匹配程度。这两个过程会被拆分为多个同时运行的“任务”以提高效率,但请注意,如果计算资源有限,这种策略可能会使评测变得更慢。 -

可视化:评估完成后,

OpenCompass将结果整理成易读的表格,并将其保存为 CSV 和 TXT 文件。你也可以激活飞书状态上报功能,此后可以在飞书客户端中及时获得评测状态报告。

1.4 大模型评测领域的挑战

二、生成式模型的评估指标

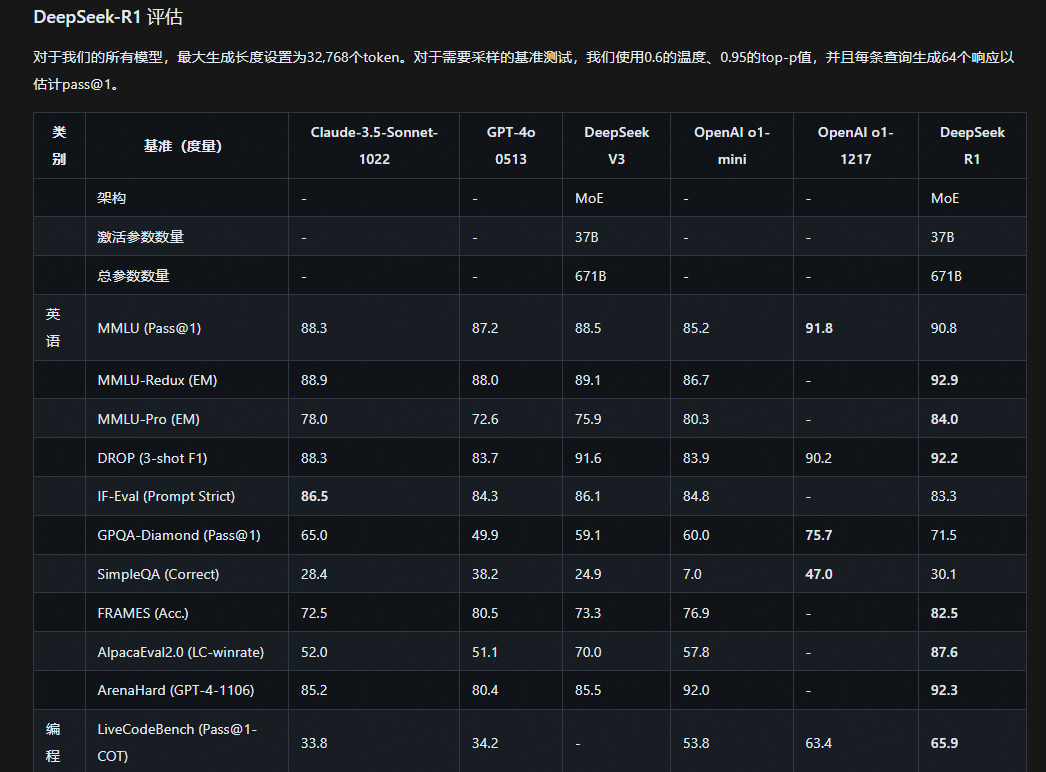

在具体项目中如何选择对应的基座模型?按照官网模型的评估结果选择。

核心评估指标:

OpenCompass 支持以下主要评估指标,覆盖生成式大模型的多样化需求:

- 准确率(

Accuracy): 用于选择题或分类任务,通过比对生成结果与标准答案计算正确率。在OpenCompass中通过metric=accuracy配置。 - 困惑度(

Perplexity,PPL): 衡量模型对候选答案的预测过程,适用于选择题评估。模型对当前选项的困惑度越高,即不确定性越高,最终选择困惑度最低的选项。当前需使用ppl类型的数据集配置(如ceval_ppl)。 - 生成质量(

GEN): 通过文本生成结果提取答案,需结合后处理脚本解析输出。使用gen类型的数据集(如ceval_gen),配置metric=gen并指定后处理规则。 ROUGE/LCS: 用于文本生成任务的相似度评估,需安装rouge==1.0.1依赖,并在数据配置中设置metric=rouge(生成模型的准确率一般来讲是根据模型输出的答案和我们标签的答案,根据文本的长度进行一个序列的划分。然后去对比上下划分好的序列内容,结果相同的话就得分加一,不同的话得分给0,以这样的方式来算一个准确率)。- 条件对数概率(

CLP): 结合上下文计算答案的条件概率,适用于复杂推理任务,需在模型配置中启用use_logprob=True。

我们评估模型的特色能力时主要用到准确度、生成质量、

ROUGE/LCS指标,困惑度和条件对数概率一般用在通用模型评估上面。

三、openCompass数据集

3.1 主流开源数据集

OpenCompass 内置超过100个数据集,覆盖五大能力维度:

-

知识类:

C-Eval(中文考试题,对应上图中的学科)、CMLU(多语言知识问答)、MMLU(英文多选题) -

推理类:

GSM8K(数学推理)、BBH(复杂推理链) -

语言类:

CLUE(中文理解)、AFQMC(语义相似度) -

代码类:

HumanEval(代码生成)、MBPP(编程问题) -

多模态类:

MMBench(图像理解)、SEED-Bench(多模态问答)

数据集与评估指标时一一对应的,即什么样的数据集得出什么样的指标。

3.1.1 MMBench数据集

MMBench 由 OpenCompass 社区开发,是一套用于评估大型视觉语言模型 (LVLM) 多模态理解能力的基准测试集。详见github:https://github.com/open-compass/mmbench

MMBench 的数据来源于多个渠道,包括公共数据集和互联网,目前包含 2974 道选择题,涵盖 20 个能力维度。我们将这 20 个能力维度构建为 3 个能力维度层级,从 L-1 到 L-3。据我们所知,MMBench 是第一个涵盖如此多能力维度的大规模评估多模态数据集。

3.1.2 LawBench数据集

LawBench可以对大语言模型的法律能力进行精准评估。在设计测试任务时,我们模拟了司法认知的三个维度,并选择了20个任务来评估大模型的能力。详见github:https://github.com/open-compass/LawBench

我们的数据集包括 20 个不同的任务,涵盖 3 个认知水平:

- 法律记忆知识:大语言模型能够储备必要的法律概念、术语、法条和事实。

- 法律理解知识:大语言模型能够理解法律文本中的实体、事件和关系,从而理解法律文本的意义和内涵。

- 法律知识应用:大语言模型能否正确利用其法律知识、由此进行推理从而解决下游应用中的现实法律任务。

3.1.3 MedBench数据集

MedBench 致力于打造一个科学、公平且严谨的中文医疗大模型评测体系及开放平台。平台基于医学权威标准,持续更新高质量评测集,全方位评估大语言模型、多模态大模型及智能体在医疗领域的能力。

3.2 数据集区别与选择

评估范式差异:

-

_gen后缀数据集: 生成式评估,需后处理提取答案(如ceval_gen) -

_ppl后缀数据集: 困惑度评估,直接比对选项概率(如ceval_ppl)

领域覆盖:

-

C-Eval: 侧重中文STEM和社会科学知识,包含1.3万道选择题 -

LawBench: 法律领域专项评估,需额外克隆仓库并配置路径 -

MedBench:中文医疗领域评估,需额外克隆仓库并配置路径

微调后的模型使用开源数据集评估的意义:

我们自己微调完之后的模型,有必要在这些数据集上做二次评估,主要看模型微调之后对原始数据的泛化能力的影响,防止模型遗忘之前的通用能力。如果模型训练完了只在当前微调数据集上有效,在其他数据集上无效,那这个模型是不能够拿来用的。

如何判断我们微调后的大模型是否过拟合呢?即微调之后的模型对于原有的能力影响不明显。所以说非常有必要拿开源数据去做评估测试的。

3.3 数据集来源

OpenCompass 支持的数据集主要包括三个部分:

-

Huggingface数据集: Huggingface Dataset 提供了大量的数据集,这部分数据集运行时会自动下载 。 -

ModelScope数据集: ModelScope OpenCompass Dataset 支持从ModelScope自动下载数据集。要启用此功能,请设置环境变量:

export DATASET_SOURCE=ModelScope,可用的数据集包括(来源于OpenCompassData-core.zip): -

自建以及第三方数据集(一般选这个):

OpenCompass还提供了一些第三方数据集及自建中文数据集。运行以下命令手动下载解压。

在 OpenCompass 项目根目录下运行下面命令,将数据集解压到至对应目录下:

> wget https://github.com/open-compass/opencompass/releases/download/0.2.2.rc1/OpenCompassData-core-20240207.zip

unzip OpenCompassData-core-20240207.zip

> unzip OpenCompassData-core-20240207.zip

如果需要使用 OpenCompass 提供的更加完整的数据集 (~500M),可以使用下述命令进行下载和解压:

> wget https://github.com/open-compass/opencompass/releases/download/0.2.2.rc1/OpenCompassData-complete-20240207.zip

unzip OpenCompassData-complete-20240207.zip

> cd data

> find . -name "*.zip" -exec unzip "{}" ;

OpenCompass 已经支持了大多数常用于性能比较的数据集,具体支持的数据集列表请直接在configs/datasets 下进行查找。

四、操作openCompass

4.1 安装openCompass

-

创建虚拟环境

conda create --name opencompass python=3.10 -y conda activate opencompass -

通过

pip安装OpenCompass不容易找到对应的配置文件

# 支持绝大多数数据集及模型 pip install -U opencompass # 完整安装(支持更多数据集) # pip install "opencompass[full]" # 模型推理后端,由于这些推理后端通常存在依赖冲突,建议使用不同的虚拟环境来管理它们。 # pip install "opencompass[lmdeploy]" # pip install "opencompass[vllm]" # API 测试(例如 OpenAI、Qwen) # pip install "opencompass[api]" -

基于源码安装

OpenCompassgit clone https://github.com/open-compass/opencompass opencompass cd opencompass pip install -e . # pip install -e ".[full]" # pip install -e ".[vllm]"

4.2 数据准备

在 OpenCompass 项目根目录下运行下面命令,将数据集解压到至对应目录下:

> wget https://github.com/open-compass/opencompass/releases/download/0.2.2.rc1/OpenCompassData-core-20240207.zip

unzip OpenCompassData-core-20240207.zip

> unzip OpenCompassData-core-20240207.zip

4.3 配置评估任务

在 OpenCompass 中,每个评估任务由待评估的模型和数据集组成,评估的入口点是 run.py ,用户可以通过命令行或配置文件选择要测试的模型和数据集。

对于 HuggingFace 模型,用户可以通过命令行直接设置模型参数,无需额外的配置文件。

4.3.1 openCompass配置&命令

openCompass配置文件

OpenCompass支持的模型和数据集的配置预存于configs/models和configs/datasets中。

Qwen-2.5-0.5B 模型的配置文件举例:

# opencompass/opencompass/configs/models/qwen2_5/hf_qwen2_5_0_5b_instruct.py

models = [

dict(

type=HuggingFacewithChatTemplate,

abbr='qwen2.5-0.5b-instruct-hf',

# 若评测本地Qwen,这里需要改成本地Qwen路径

path='Qwen/Qwen2.5-0.5B-Instruct',

max_out_len=4096,

batch_size=8,

run_cfg=dict(num_gpus=1),

)

]

openCompass相关命令:

# 列出所有配置:

> python tools/list_configs.py

# 列出与模型和数据集相关的所有配置:

> python tools/list_configs.py modelName Dataset

# 列出与llama和mmlu相关的所有配置

> python tools/list_configs.py llama mmlu

+-----------------+-----------------------------------+

| Model | Config Path |

|-----------------+-----------------------------------|

| hf_llama2_13b | configs/models/hf_llama2_13b.py |

| hf_llama2_70b | configs/models/hf_llama2_70b.py |

| ... | ... |

+-----------------+-----------------------------------+

+-------------------+---------------------------------------------------+

| Dataset | Config Path |

|-------------------+---------------------------------------------------|

| cmmlu_gen | configs/datasets/cmmlu/cmmlu_gen.py |

| cmmlu_gen_ffe7c0 | configs/datasets/cmmlu/cmmlu_gen_ffe7c0.py |

| ... | ... |

+-------------------+---------------------------------------------------+

# 我们可以使用第一列中的名称作为 `python run.py` 中`--models` 和 `--datasets` 的输入参数。对于数据集,同一名称的不同后缀通常表示其提示或评估方法不同。

4.3.2 单个模型评估

1) 对话模型的评估

单卡评估命令:

python run.py \

--datasets demo_gsm8k_chat_gen demo_math_chat_gen \

--hf-type chat \

--hf-path /root/lanyun-tmp/LLM/Qwen/Qwen2.5-1.5B-Instruct \

--debug

--datasets加载了两个数据集;--hf-type确定模型是什么类型,chat类型或base类型;--hf-path加载本地/hf上的模型;--debug产出评估过程中的日志

多卡评估命令:

python run.py \

--datasets demo_gsm8k_chat_gen demo_math_chat_gen \

--hf-type chat \

--hf-path /root/lanyun-tmp/LLM/Qwen/Qwen2.5-1.5B-Instruct \

--hf-num-gpus 2

--debug

评测结果写入到了: /root/lanyun-tmp/opencompass/outputs/default/20250413_132916/summary/summary_20250413_132916.md

这张图展示了在 OpenCompass 评估平台上,针对:Qwen2.5-1.5B-Instruct_hf 的模型在两个不同数据集上的评测结果。以下是对图中信息的解释:

-

数据集(

dataset):-

demo_gsm8k:这是一个数学问题解答的数据集。 -

demo_math:这是另一个数学相关的问题解答数据集。

-

-

版本(

version):1d7fe4和393424分别是这两个数据集的版本号。

-

评估指标(

metric):accuracy:表示使用准确率作为评估指标。

-

模式(

mode):gen:表示生成模式,即模型生成答案后需要通过后处理来提取最终答案。

-

评测分数:

-

Qwen2.5-1.5B-Instruct_hf模型在demo_gsm8k数据集上的准确率为60.94%。 -

在

demo_math数据集上的准确率为39.06%。

-

这些分数反映了模型在不同数据集上的性能表现,准确率越高表示模型在该数据集上的表现越好。这里的评测是在生成模式下进行的,意味着模型需要生成答案,然后通过后处理步骤来提取和评估这些答案的正确性。

不同的数据集可能侧重于不同的能力,例如数学推理能力,因此模型在一个数据集上的表现可能优于另一个数据集。

2) 基座模型的评估

python run.py \

--datasets demo_gsm8k_base_gen demo_math_base_gen \

--hf-type base \

--hf-path /root/lanyun-tmp/LLM/Qwen/Qwen2.5-1.5B \

--debug

对话模型相比于基座模型,其名称上会多 chat,instruct 等额外文字描述,而基座模型的名称仅包含“模型名称+版本+参数”。

4.3.3 多个模型评估

评估方式:命令行 + 配置文件的形式

配置文件:

- 修改

openCompass配置文件,将Qwen-1.5b的路径改为本地路径。

命令行:

# 筛选目前opencompass的框架下面所支持的所有的HuggingFace的千问系列的模型名称

# 看到有配置的两个模型

> python tools/list_configs.py hf_qwen

+-----------------+-----------------------------------+-----------------------------------+

| Model | Config Path |

|-----------------+-----------------------------------------------------------------------|

| hf_qwen2_5_1_5_instruct | configs/models/qwen2_5/hf_qwen2_5_1_5_instruct.py |

| hf_qwen2_5_1_5_instruct_int8 | configs/models/qwen2_5/hf_qwen2_5_1_5_instruct_int8.py |

| ... | ... |

+-----------------+-----------------------------------------------------------------------+

> python run.py \

--models hf_qwen2_5_1_5b_instruct hf_qwen2_5_1_5b_instruct_int8 \

--datasets demo_gsm8k_chat_gen demo_math_chat_gen \

--debug

4.3.3 自定义数据集评测

openCampass目前支持.jsonl和.csv两种格式的数据集。

1)选择题

对于选择 (mcq ) 类型的数据,默认的字段如下:

question: 表示选择题的题干A,B,C, …: 使用单个大写字母表示选项,个数不限定。默认只会从A开始,解析连续的字母作为选项。answer: 表示选择题的正确答案,其值必须是上述所选用的选项之一,如A,B,C等。

对于非默认字段,我们都会进行读入,但默认不会使用。如需使用,则需要在.meta.json 文件中进行指定。

.jsonl格式样例如下:

{"question": "165+833+650+615=", "A": "2258", "B": "2263", "C": "2281", "answer": "B"}

{"question": "368+959+918+653+978=", "A": "3876", "B": "3878", "C": "3880", "answer": "A"}

{"question": "776+208+589+882+571+996+515+726=", "A": "5213", "B": "5263", "C": "5383", "answer": "B"}

{"question": "803+862+815+100+409+758+262+169=", "A": "4098", "B": "4128", "C": "4178", "answer": "C"}

.csv格式样例如下:

question,A,B,C,answer

127+545+588+620+556+199=,2632,2635,2645,B

735+603+102+335+605=,2376,2380,2410,B

506+346+920+451+910+142+659+850=,4766,4774,4784,C

504+811+870+445=,2615,2630,2750,B

2)问答题

对于问答 ( qa ) 类型的数据,默认的字段如下:

question: 表示问答题的题干answer: 表示问答题的正确答案。可缺失,表示该数据集无正确答案。

对于非默认字段,我们都会进行读入,但默认不会使用。如需使用,则需要在.meta.json ******文件中进行指定。

.jsonl格式样例如下:

{"question": "752+361+181+933+235+986=", "answer": "3448"}

{"question": "712+165+223+711=", "answer": "1811"}

{"question": "921+975+888+539=", "answer": "3323"}

{"question": "752+321+388+643+568+982+468+397=", "answer": "4519"}

.csv格式样例如下:

question,answer

123+147+874+850+915+163+291+604=,3967

149+646+241+898+822+386=,3142

332+424+582+962+735+798+653+214=,4700

649+215+412+495+220+738+989+452=,4170

3)执行评测

csv格式

> python run.py \

--models lmdeploy_qwen2_5_1_5b_instruct\

--custom-dataset-path xxx/test_mcq.csv \

--custom-dataset-data-type mcq \

--custom-dataset-infer-method ppl

jsonl格式

> python run.py \

--models lmdeploy_qwen2_5_1_5b_instruct \

--custom-dataset-path xxx/test_qa.jsonl \

--custom-dataset-data-type qa \

--custom-dataset-infer-method gen

在绝大多数情况下, --custom-dataset-data-type 和 --custom-dataset-infer-method 可以省略,openCompass 会根据以下逻辑进行设置:

- 如果从数据集文件中可以解析出选项,如

A,B,C等,则认定该数据集为mcq,否则认定为qa。 - 默认

infer_method为gen。

> python run.py \

--hf_patch /root/LLM/Qwen/Qwen2.5-1.5B-Instruct \

--custom-dataset-path xxx/test_qa.jsonl

4.4 评测加速

OpenCompass 支持在评测大语言模型时,使用 LMDeploy、vllm 作为推理加速引擎。本教程将介绍如何使用 LMDeploy 加速对模型的评测。

在opencompass/opencompass/configs/models/qwen2_5路径下,存在 hf_qwen_2_5_xxx、 vllm_qwen_2_5_xxx、 lmdeploy_qwen_2_5_xxx文件,即 openCompass 在评测时支持的推理框架的配置文件。

举例如下:

# opencompass/opencompass/configs/models/qwen2_5/vllm_qwen2_5_0_5b_instruct.py

models = [

dict(

type=VLLMwithChatTemplate,

abbr='qwen2.5-0.5b-instruct-vllm',

path='Qwen/Qwen2.5-0.5B-Instruct',

model_kwargs=dict(tensor_parallel_size=1, gpu_memory_utilization=0.5),

max_out_len=4096,

batch_size=16,

generation_kwargs=dict(temperature=0),

run_cfg=dict(num_gpus=1),

)

]

举例:LMDeploy 加速评测

-

修改配置文件

在目录

configs/models下找lmdeploy_开头的大模型配置文件,以lmdeploy_qwen2_5_1_5b_instruct.py举例。-

path修改为本地大模型目录 -

max_batch_size和batch_size保持一致,若显卡性能较差,可以调小些

-

-

执行评测

> python run.py \ --models lmdeploy_qwen2_5_1_5b_instruct \ --datasets demo_gsm8k_chat_gen demo_math_chat_gen \ --debug输出如下:

vllm 推理框架操作和上面操作类似。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)