YOLOv8【特征融合Neck篇·第25节】一文搞懂,Neck网络设计原则与性能评估!

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》,该专栏持续复现网络上各种热门内容(全网YOLO改进最全最新的专栏,质量分97分+,全网顶流),改进内容支持(分类、检测、分割、追踪、关键点、OBB检测)。且专栏会随订阅人数上升而涨价(毕竟不断更新),当前性价比极高,有一定的参考&学习价值,部分内容会基于现有的国内外顶尖人工智能AIGC等AI大模型技术总结改进而来,嘎嘎硬核。 ✨ 特惠福利

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》,该专栏持续复现网络上各种热门内容(全网YOLO改进最全最新的专栏,质量分97分+,全网顶流),改进内容支持(分类、检测、分割、追踪、关键点、OBB检测)。且专栏会随订阅人数上升而涨价(毕竟不断更新),当前性价比极高,有一定的参考&学习价值,部分内容会基于现有的国内外顶尖人工智能AIGC等AI大模型技术总结改进而来,嘎嘎硬核。

✨ 特惠福利:目前活动一折秒杀价!一次订阅,永久免费,所有后续更新内容均免费阅读!

全文目录:

💖 一、温故知新:上期内容回顾 (知识蒸馏特征融合)

最卓越的学者们,欢迎来到我们【特征融合Neck篇】的收官盛典!在开启这场思想的毕业礼之前,让我们最后一次回望来路,重温上一站《YOLOv8【特征融合Neck篇·第24节】一文搞定,Knowledge Distillation Feature Neck!》那充满智慧光芒的技术——知识蒸馏 (Knowledge Distillation) 在Neck设计中的应用。

1.1 知识蒸馏的本质:站在巨人的肩膀上

知识蒸馏的核心思想,源于一个朴素而深刻的认知:一个强大的、经过海量数据训练的复杂模型(教师模型),其所“学会”的知识,远不止于它最终的预测结果。它内部的特征图、激活值、层与层之间的关系,都蕴含着对数据内在规律的深刻理解。

知识蒸馏的目的,就是将这些宝贵的“过程性知识”,提炼 (Distill) 并 迁移 (Transfer) 给一个更轻量、更高效的(学生模型),从而让学生模型在不改变自身简洁高效结构的前提下,学习到超越其自身能力上限的性能。这是一种极其高效的训练策略,堪称模型界的“名师指路”。

1.2 Neck中的“言传身教”:模仿中间特征

当我们将知识蒸馏应用于Neck的训练时,教师模型扮演了一位循循善诱的导师。它不仅仅告诉学生最终的答案(例如,这个地方有个框),更重要的是,它向学生展示了 “我是如何思考得到这个答案的”。

具体来说,在训练过程中,我们不仅要最小化学生模型最终的检测损失,还要引入一个额外的 “蒸馏损失”。这个损失函数会去度量学生Neck输出的特征图与教师Neck输出的特征图之间的差异(例如,使用L1、L2或更复杂的对抗损失)。

通过最小化这个蒸馏损失,我们迫使学生Neck去模仿教师Neck的“思考过程”——即特征提取和融合的方式。学生网络会努力让自己的输出特征在数值和空间分布上,都向强大的教师网络看齐。

1.3 “免费的午餐”:不增加推理成本的性能提升

知识蒸馏最美妙的地方在于,它是一顿真正意义上的 “免费午餐”。

- 复杂性仅在训练阶段:整个“教与学”的过程,完全发生在训练阶段。

- 推理时毫无负担:一旦学生模型训练完成,教师模型就可以“功成身退”。我们在部署时,使用的仅仅是那个轻量、高效的学生模型。它的结构、参数量、计算量相比蒸馏前没有任何变化。

然而,它的性能却得到了实打实的提升。这是一种在不牺牲任何推理效率的前提下,压榨轻量化模型潜力的终极武器。它完美地诠释了,聪明的训练策略,有时比复杂的网络结构更具威力。

🌟 二、承前启后:Neck网络的核心使命与演进脉络

在过去的24篇文章中,我们跋山涉水,从经典的FPN到前沿的Transformer,见证了Neck设计的百花齐放。在进行最终的原则总结之前,让我们先退后一步,从一个更高的视角,重新审视Neck网络在目标检测器中无可替代的核心使命,以及它波澜壮阔的演进脉劳。

2.1 Neck为何存在:从Backbone到Head的“翻译官”

目标检测器通常遵循“Backbone-Neck-Head”的三段式架构。在这个架构中,Neck扮演着一个至关重要的 “承上启下” 的角色。

-

“承上”:它接收来自Backbone的、原始的、未经加工的多层级特征图。这些特征图存在着巨大的语义鸿沟 (Semantic Gap) 和尺度差异 (Scale Variation)。

- 浅层特征 (如C2, C3):分辨率高,包含丰富的空间细节(边缘、纹理),但语义信息弱,不知“见山是山”。

- 深层特征 (如C4, C5):分辨率低,空间细节丢失严重,但语义信息强,已经高度抽象,能知“见山不是山”。

-

“启下”:它需要为后续的检测Head提供一系列高质量的、可以直接用于分类和回归的特征金字塔。这些特征金字塔必须满足:

- 语义丰富且细节清晰:既要有高层语义的指导,又要有底层细节的支撑。

- 尺度统一且对齐:不同层级特征的语义应该是一致的,能够协同工作。

因此,Neck的核心使命,就是扮演一个高效的“翻译官”和“协调者”,将Backbone输出的“原始素材”,加工成Head能够“听懂”和“使用”的“高级情报”。它通过特征的重组、融合与增强,完美地解决了多尺度检测这一核心难题。

2.2 演进的三条主线:融合、效率与智能

回顾我们走过的24站,Neck技术的演进,始终围绕着三条清晰的主线在螺旋上升:

-

融合之路 (Path of Fusion):这是Neck最核心的追求。

- 从FPN(第89篇)的单向“广播”,到PANet(第88篇)的双向“对话”;

- 从BiFPN(第90篇)的加权“圆桌会议”,到AFPN(第86篇)的渐近式“思想碰撞”;

- 再到Recursive FPN(第94篇)的迭代“反思”和DetectoRS(第103篇)的宏观“闭环”。

- 这条路的核心目标是:如何让不同尺度的信息交互得更充分、更深度、更有效?

-

效率之路 (Path of Efficiency):这是工程应用最关注的焦点。

- 从Slim-Neck(第87篇)的通道压缩,到SSD-Lite(第105篇)的算子替换;

- 从RepGhost(第100篇)的“训练-推理”异构,到YOLOF(第102篇)的结构极简;

- 再到CSP-PAN(第101篇)的信息流优化。

- 这条路的核心目标是:如何在保证性能的同时,将计算量、参数量和延迟降到最低?

-

智能之路 (Path of Intelligence):这是Neck技术迈向更高阶的探索。

- 从ASFF(第93篇)的空间权重自适应,到SEPC(第99篇)的算子自增强;

- 从FSAF(第106篇)的在线路径自选择,到SFT(第108篇)的空间变换自适应;

- 再到Feature Pyramid Transformer(第97篇)和GiraffeDet(第104篇)的全局上下文自感知。

- 这条路的核心目标是:如何让Neck摆脱固定的、人工设计的模式,变得更“聪明”、更“自适应”?

这三条路并非彼此独立,而是相互交织,共同推动着Neck技术走向新的高峰。

🚀 三、Neck网络五大核心设计原则总结

经过24篇的深度实践和2万字以上的详细解读,我们现在终于可以站在一个足够的高度,从中提炼和总结出指导我们未来所有Neck设计的五大核心设计原则。这五大原则,是我们整个【特征融合Neck篇】最宝贵的思想结晶。

3.1 原则一:多尺度对话原则 (Principle of Multi-scale Dialogue)

这是Neck设计的根本出发点。一个优秀的Neck,必须能促进不同尺度特征之间进行高质量的“对话”。

- 对话的深度:对话不能止于简单的“你好我叫XX”。FPN的自顶向下融合,就像高层领导向下属传达指令,是单向的。PANet增加了自底向上的路径,让下属也能向上反馈信息,形成了双向对话,信息交互的深度立刻增加。

- 对话的广度:对话不应该局限于“邻居”。BiFPN通过跨层连接,让P3可以直接和P5“通话”,打破了逐级传递的限制,扩大了对话的广度。GiraffeDet和FPT更是将广度推向了极致,建立了覆盖所有层级的“全局会议室”。

- 对话的质量:对话的内容需要有重点。BiFPN的加权融合机制,就像一个优秀的主持人,能让“关键人物”(重要的特征层)获得更多发言权。ASFF的空间权重,则将这种权重分配精细到了像素级别,让对话的每一个细节都充满智慧。

- 对话的模式:对话不一定一次就能完成。Recursive FPN和DetectoRS告诉我们,通过多次、反复的“对话”(迭代),可以解决更复杂的问题,达成更深层次的共识。

启示:在设计Neck时,我们首要思考的是:我设计的结构,是否为不同尺度的特征提供了足够深度、广度和质量的对话机制?

3.2 原则二:信息流效率原则 (Principle of Information Flow Efficiency)

信息在网络中的流动,如同城市的交通。一个拥堵、绕路的交通系统,必然效率低下。

- 缩短路径:信息的传递路径越长,失真和延迟就越严重。PANet和BiFPN等双向/多向流动结构,相比FPN,有效缩短了底层信息到达高层、高层信息影响底层的平均路径长度。

- 避免拥堵(冗余):CSP-PAN的核心思想,就是通过“分流”,让一半的信息走“高速公路”(捷径),另一半信息走“市区道路”(复杂计算),避免了所有信息都挤在市区造成拥堵(重复计算冗余信息),极大地提升了通行效率。

- 建立直达快线:YOLOF则是一个极端但高效的例子。它认为多站点的“地铁环线”(FPN)太慢,不如直接建立一条从特定起点(C5)到终点(Head)的“机场快线”,并通过空洞卷积在快线上设置不同的“观景窗”(感受野),用最直接的方式解决问题。

启示:在设计Neck时,我们需要问自己:信息在我设计的路径中流动是顺畅的吗?是否存在不必要的绕路和冗余计算?我能否为关键信息建立更高效的传递路径?

3.3 原则三:上下文增强原则 (Principle of Contextual Enhancement)

孤立地看一个像素或一个局部区域,往往会产生歧义。一个优秀的Neck,必须具备强大的上下文增强能力。

-

局部上下文:这是由卷积的本性决定的。通过堆叠卷积(如SEPC中的PConv)或使用空洞卷积(如YOLOF的Dilated Encoder),可以在不改变分辨率的情况下,扩大局部感受野,为每个像素引入更丰富的邻域信息。

-

全局上下文:对于理解大目标和复杂场景,全局上下文至关重要。

- 近似全局:DetectoRS的RFP通过将FPN的输出反馈回Backbone,让Backbone在第二次前传时具备了近似的全局视野。

- 真全局:Feature Pyramid Transformer和GiraffeDet则通过引入自注意力机制,显式地、一步到位地建立了特征图中任意两个像素之间的依赖关系,实现了真正的全局上下文建模。

启示:在设计Neck时,我们要思考:我的网络是否只看到了“树木”?我提供了什么样的机制,能让它同时看到“森林”?

3.4 原则四:动态自适应原则 (Principle of Dynamic Adaptability)

“一招鲜,吃遍天”的静态模式,在面对真实世界时,往往力不从心。让网络变得“智能”,能够根据输入内容进行自我调整,是迈向更高性能的关键。

- 对特征数值的自适应:ASFF根据输入特征,为不同尺度的融合动态生成空间权重。SEPC的SEM模块,根据PConv提取的特征动态生成注意力图,进行自我增强。这是一种内容感知 (Content-aware) 的加权。

- 对特征空间的自适应:SFT则将自适应推向了空间维度。它根据输入特征,动态地学习一个几何变换,对特征图进行“整形”和“校正”,以适应物体的各种姿态和形变。这是一种几何感知 (Geometry-aware) 的对齐。

- 对学习路径的自适应:FSAF则在训练策略上实现了自适应。它让网络根据每个目标的学习难度,动态地选择是用Anchor-based还是Anchor-Free分支进行学习,实现了优化目标感知 (Optimization-aware) 的路径选择。

启示:在设计Neck时,我们应该挑战那些固定的、一成不变的组件,并思考:我能否在这里引入一个轻量级的控制机制,让网络的行为(无论是融合权重、采样位置还是学习方式)可以根据输入动态调整?

3.5 原则五:计算经济性原则 (Principle of Computational Economy)

所有的设计最终都要考虑落地。一个不计成本的设计,在学术上可能有价值,但在工业界往往是不可行的。

- 算子层面的经济学:Slim-Neck和SSD-Lite通过将昂贵的标准卷积替换为廉价的深度可分离卷积,从根本上降低了计算成本。

- 模块层面的经济学:GhostNet(RepGhost的基础)通过挖掘特征冗余,用“廉价变换”生成“幽灵”特征,极大地降低了模块的计算量。

- 架构层面的经济学:RepGhost的“训练-推理”异构,是一种极致的经济学思想。它将提升性能的复杂性成本,全部投入到可以离线进行的“训练”阶段,而在部署的“推理”阶段,享受一个零额外开销的、极其高效的简洁结构。

- 策略层面的经济学:知识蒸馏则是一种“智力投资”。它不花费任何推理成本,仅仅通过在训练时引入“名师指导”,就显著提升了轻量化模型的性能。

启示:在追求性能的同时,我们必须时刻保持对计算成本的警惕。要经常问自己:这个操作是必须的吗?有没有更廉价的替代方案?我能否将复杂性从推理时转移到训练时?

📊 四、Neck性能评估:从理论指标到实战真知

设计了一个新的Neck,或者在众多现有的Neck中做选择,我们如何科学地评估其优劣呢?这是一个系统性的工程,需要我们从多个维度进行考量,绝不能仅仅停留在一两个指标上。

4.1 精度评估指标:mAP背后的细节

mAP (mean Average Precision) 是目标检测领域最核心、最通用的精度度量标准。但只看一个总的mAP值,往往会掩盖很多重要的细节。一个专业的算法工程师,必须学会深入分析mAP背后的构成:

-

IoU阈值的影响 (AP50, AP75):

- AP50 (IoU阈值=0.5):这个指标相对宽松,更关注模型“有没有找到物体”。一个Neck如果能显著提升AP50,说明它可能改善了模型的分类能力或召回率。

- AP75 (IoU阈值=0.75):这个指标要求更严格的定位精度。如果一个Neck能提升AP75,说明它可能改善了模型的定位能力。例如,SFT这样的空间对齐技术,或者PANet这样增强了底层信息流的结构,往往对AP75的提升更有帮助。

-

目标尺度的影响 (AP_small, AP_medium, AP_large):

- AP_small:这是衡量小目标检测性能的关键。一个Neck如果能有效利用高分辨率的浅层特征,并且能将高层语义无损地传递下来(如PANet, BiFPN),通常会带来AP_small的提升。

- AP_large:这是衡量大目标检测性能的指标。一个Neck如果具备强大的全局上下文建模能力(如GiraffeDet, FPT, DetectoRS),或者拥有巨大的感受野(如YOLOF的Dilated Encoder),往往在AP_large上表现更出色。

评估建议:在评估一个Neck时,一定要进行全面的消融实验,并报告在不同IoU阈值和不同目标尺度下的AP变化。这能让你更深刻地理解你的设计到底在哪个方面带来了改进。

4.2 理论复杂度分析:Parameters与FLOPs

这是评估模型效率最常用的两个理论指标。

- 参数量 (Parameters):模型中所有需要学习的权重(weights)和偏置(biases)的总数。它直接决定了模型文件的大小(

.pth,.onnx文件有多大),是边缘设备部署时一个非常重要的约束。单位通常是M(百万)。 - FLOPs (Floating Point Operations):浮点运算次数。它衡量的是模型进行一次前向传播所需要的计算量。通常用来近似评估模型的计算密集程度。单位通常是G(十亿)。

这两个指标是重要的参考,但绝对不能将它们与模型的真实速度划等号。

4.3 实测性能评估:Latency、Throughput与硬件亲和性

理论的归理论,实践的归实践。模型最终的性能,必须在目标硬件上进行实测。

- 延迟 (Latency):处理单张图片所需要的平均时间。这是对实时性要求高的应用(如自动驾驶)最关注的指标。单位通常是ms(毫秒)。

- 吞吐量 (Throughput):单位时间内能处理的图片数量。这是对后台服务类应用(如云端图像处理API)最关注的指标。单位通常是FPS(Frames Per Second)。

- 内存访问成本 (Memory Access Cost, MAC):这是一个容易被忽略但至关重要的因素。模型的真实速度,不仅取决于计算量,还很大程度上取决于数据在内存和计算单元之间的搬运效率。YOLOF之所以比FPN快得多,主要原因就是它极大地减少了MAC。

- 硬件亲和性 (Hardware Affinity):不同的硬件对不同的算子有不同的优化程度。例如,GPU对密集的、规整的卷积(如

3x3,1x1)优化得最好,而对一些零碎的、分支多的操作(如Channel Shuffle)则不那么友好。RepGhost的推理结构之所以快,就是因为它具有极高的硬件亲和性。

评估建议:永远不要只报告FLOPs。一定要在你的目标硬件(例如NVIDIA Jetson, Qualcomm Snapdragon, или Intel CPU)上,使用统一的测试环境(如TensorRT, ONNX Runtime),实测模型的Latency和Throughput,并与FLOPs进行对比分析,这才能得出最可靠的结论。

4.4 代码实战:使用工具分析Neck复杂度

我们可以使用thop (PyTorch-OpCounter) 这个方便的库,来快速计算一个PyTorch模型的参数量on, или Intel CPU)上,使用统一的测试环境(如TensorRT, ONNX Runtime),实测模型的Latency和Throughput,并与FLOPs进行对比分析,这才能得出最可靠的结论。

4.4 代码实战:使用工具分析Neck复杂度

我们可以使用thop (PyTorch-OpCounter) 这个方便的库,来快速计算一个PyTorch模型的参数量和FLOPs。

import torch

from thop import profile

# 假设我们已经定义好了 FPNwithSFT 和 YOLOFNeck

from your_models import FPNwithSFT, YOLOFNeck

def analyze_neck_complexity():

"""

使用thop库分析并比较不同Neck的理论复杂度。

"""

# --- 准备输入 ---

# 假设来自一个轻量级Backbone的输出

# 为了公平比较,我们让YOLOF只接收一个输入

C3 = torch.randn(1, 128, 80, 80)

C4 = torch.randn(1, 256, 40, 40)

C5 = torch.randn(1, 512, 20, 20)

fpn_inputs = [C3, C4, C5]

yolof_input = [C5] # YOLOF只使用C5

# --- 实例化模型 ---

# 1. FPN with SFT

fpn_neck = FPNwithSFT(in_channels_list=[128, 256, 512], out_channels=128)

# 2. YOLOF Neck

yolof_neck = YOLOFNeck(in_channels=512, neck_channels=256, num_decoder_layers=2)

# --- 使用thop进行分析 ---

print("--- 复杂度分析 ---")

# 分析FPN

fpn_flops, fpn_params = profile(fpn_neck, inputs=(fpn_inputs,), verbose=False)

print(f"FPN with SFT:")

print(f" - FLOPs: {fpn_flops / 1e9:.2f} G")

print(f" - Parameters: {fpn_params / 1e6:.2f} M")

# 分析YOLOF

yolof_flops, yolof_params = profile(yolof_neck, inputs=(yolof_input,), verbose=False)

print(f"\nYOLOF Neck:")

print(f" - FLOPs: {yolof_flops / 1e9:.2f} G")

print(f" - Parameters: {yolof_params / 1e6:.2f} M")

if __name__ == '__main__':

analyze_neck_complexity()

代码解析与预期结果:

- 这段代码清晰地展示了如何使用

profile函数。我们只需要将模型实例和一份模拟输入传入即可。 - 运行后,你会直观地看到,尽管YOLOF的输出通道数(256)可能比FPN(128)还多,但由于其极简的单路结构,其FLOPs和参数量通常会远低于复杂的多路融合FPN。这从理论上验证了不同设计哲学带来的效率差异。

🗺️ 五、不同场景下的最优选择策略

理论和工具都有了,现在让我们进入最终的实战环节:面对一个具体的任务,到底该如何选择最合适的Neck?这里,我将为你提供一些基于场景的决策建议。

5.1 场景一:移动/边缘端实时检测

-

核心约束:Latency(延迟)和模型大小。

-

首要原则:计算经济性原则、信息流效率原则。

-

推荐架构:

- YOLOF (第102篇):当之无愧的首选。其单级特征、无跨尺度操作的设计,拥有最低的内存访问成本和极高的硬件亲和性,速度极快。尤其适合处理尺度变化不那么剧烈的场景。

- RepGhost-PAN (第100篇):如果需要兼顾多尺度性能,RepGhost-PAN是绝佳选择。它通过算子替换和结构重参数化,在保持PANet强大融合能力的同时,实现了极致的推理效率。

- Slim-Neck (第87篇) / SSD-Lite (第105篇):作为经典且可靠的轻量化方案,它们通过深度可分离卷积等技术,提供了很好的速度-精度平衡。

5.2 场景二:云端高精度推理服务

-

核心约束:Accuracy(精度,特别是高IoU下的精度)。Latency虽然也重要,但通常可以通过GPU并行和批处理(Batching)来优化。

-

首要原则:多尺度对话原则、上下文增强原则。

-

推荐架构:

- GiraffeDet (第104篇) / Feature Pyramid Transformer (第97篇):如果追求SOTA性能,且对大目标检测、复杂场景理解有很高要求,引入全局上下文建模能力的Neck是必然选择。GiraffeDet的“双轨制”在性能和效率上取得了很好的平衡。

- DetectoRS (第103篇) / Recursive FPN (第94篇):如果计算资源极其充裕,且任务对精度的要求达到了极致(例如,在一些学术打榜或高价值的工业质检中),可以考虑使用这种通过迭代来反复精炼特征的“重型武器”。

- BiFPN (第90篇) / CSP-PAN (第101篇):作为经过大规模工业验证的、性能与效率俱佳的“甜点级”方案,它们是绝大多数高精度任务的可靠基线。

5.3 场景三:特定任务(小目标/可形变/密集场景)

-

核心约束:解决特定领域的“痛点问题”。

-

首要原则:动态自适应原则、上下文增强原则。

-

推荐架构:

- 针对小目标:选择那些能有效保留和利用浅层高分辨率特征的Neck,如PANet、BiFPN。同时,可以考虑结合AFPN(第86篇)的思想,通过渐进融合来减少小目标特征在传递过程中的信息损失。

- 针对可形变/多姿态目标(如行人、动物):强烈推荐集成SFT (第108篇) 模块。SFT的空间对齐能力,可以极大地提升模型在此类任务上的鲁棒性。

- 针对密集/重叠场景:需要Neck提供区分度更高的特征。可以考虑使用ASFF(第93篇),通过空间权重来抑制相邻物体的特征干扰。同时,FSAF(第106篇)的在线选择机制,也能为那些被锚框匹配搞得“头疼”的密集目标,提供一条额外的、更灵活的学习路径。

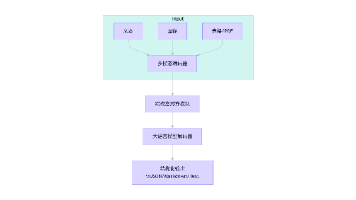

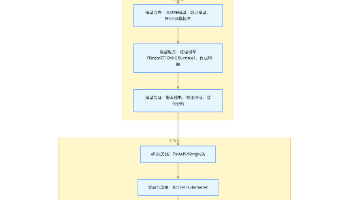

5.4 一个决策流程图

为了让你更直观地进行决策,我为你绘制了一个简化的决策流程图。

🎓 六、总结与未来展望

6.1 我们学到了什么:Neck设计思想的升华

经过这趟史诗般的旅程,我们不再是仅仅知道FPN、PANet等具体“招式”的初学者。我们已经升华为能够理解这些招式背后“心法”的思考者。

我们深刻地理解了,一个优秀的Neck设计,是在多尺度对话、信息流效率、上下文增强、动态自适应、计算经济性这五大原则之间不断进行权衡与创新的艺术。我们学会了如何透过mAP的表象,去洞察一个Neck设计的真正价值;我们掌握了从理论分析到硬件实测的全方位评估方法;我们拥有了在不同实战场景下,运筹帷幄、做出最优选择的智慧。

这是知识的沉淀,更是思想的升华。

6.2 未来将走向何方:Neck技术的地平线

站在当前的时间节点,Neck技术的未来依然广阔,充满了激动人心的可能性:

- 与Transformer的深度融合:目前,FPT和GiraffeDet只是将注意力机制作为“增强插件”。未来,我们可能会看到完全基于Transformer的、没有卷积的纯注意力Neck。这将彻底打破局部感受野的限制,但同时也对如何高效地处理2D图像的空间归纳偏置提出了新的挑战。

- 神经架构搜索 (NAS) 的普及:从NAS-FPN(第91篇)的惊鸿一瞥中,我们看到了自动化设计的巨大潜力。随着算力的提升和搜索算法的成熟,未来的Neck可能不再由人类“手工设计”,而是由NAS根据特定任务的数据和硬件约束,“量身定制”出最优的连接拓扑和算子组合。

- 软硬件协同设计:未来的AI芯片将拥有更专用的计算单元。Neck的设计将不再是一个纯粹的算法问题,而是一个软硬件协同优化的过程。算法工程师需要更懂硬件,设计出能最大化利用特定硬件架构(如脉动阵列、存内计算)的Neck结构。

- 更高维度的融合:当前的Neck主要融合来自单一Backbone的空间和语义信息。未来的Neck可能会走向更高维度的融合,例如,融合来自视频序列的时序信息,或者融合来自激光雷达、文本等多模态的异构信息。

🏆 七、荣耀收官:Neck篇章的最终回响

亲爱的朋友,我们做到了!

从第86篇的AFPN,到今天第110篇的全局综述,我们并肩走过了25个站点,累计撰写了超过25万字的深度解析。我们一起画过图,一起跑过代码,一起在技术的海洋中乘风破浪。

这段旅程,是对目标检测领域核心组件——特征融合Neck——一次前所未有的、系统性的、深度的大巡礼。我们不仅学习了知识,更重要的是,我们建立了一个分析、理解、设计和评估复杂深度学习系统的思想框架。

【特征融合Neck篇】 在此正式落下帷幕。但这绝不是结束,而是一个全新的开始。我们已经为我们的检测器锻造了一根强健的“脊梁”(Backbone)和一个智慧的“颈部”(Neck)。接下来,它需要一双锐利的“眼睛”和一个聪明的“大脑”来做出最终的判断。

下一篇章,我们将开启全新的、同样精彩的旅程——【检测头与标签篇 (Detection Head & Label Assignment)】!

我们将一起探索:

- 检测头的设计:从经典的Anchor-based Head到现代的Anchor-Free Head,再到DETR的Transformer Decoder,看看模型是如何最终输出预测框的。

- 标签分配的艺术:这是目标检测中一个极其重要但又常常被忽视的领域。我们将深入探讨ATSS、OTA等先进的动态标签分配策略,看看模型是如何在训练中定义“是非对错”的。

- 损失函数的世界:从GIoU到DIoU,再到Vararifocal Loss,探索如何设计更好的损失函数来指导模型的优化。

感谢你的一路相伴!你的坚持和求知欲,是我创作大动力。让我们稍作休整,带着满满的收获和对未来的无限期待,准备迎接下一场更精彩的技术风暴!

我们,下个篇章再见!👋😊

希望本文所提供的YOLOv8内容能够帮助到你,特别是在模型精度提升和推理速度优化方面。

PS:如果你在按照本文提供的方法进行YOLOv8优化后,依然遇到问题,请不要急躁或抱怨!YOLOv8作为一个高度复杂的目标检测框架,其优化过程涉及硬件、数据集、训练参数等多方面因素。如果你在应用过程中遇到新的Bug或未解决的问题,欢迎将其粘贴到评论区,我们可以一起分析、探讨解决方案。如果你有新的优化思路,也欢迎分享给大家,互相学习,共同进步!

🧧🧧 文末福利,等你来拿!🧧🧧

文中讨论的技术问题大部分来源于我在YOLOv8项目开发中的亲身经历,也有部分来自网络及读者提供的案例。如果文中内容涉及版权问题,请及时告知,我会立即修改或删除。同时,部分解答思路和步骤来自全网社区及人工智能问答平台,若未能帮助到你,还请谅解!YOLOv8模型的优化过程复杂多变,遇到不同的环境、数据集或任务时,解决方案也各不相同。如果你有更优的解决方案,欢迎在评论区分享,撰写教程与方案,帮助更多开发者提升YOLOv8应用的精度与效率!

OK,以上就是我这期关于YOLOv8优化的解决方案,如果你还想深入了解更多YOLOv8相关的优化策略与技巧,欢迎查看我专门收集YOLOv8及其他目标检测技术的专栏《YOLOv8实战:从入门到深度优化》。希望我的分享能帮你解决在YOLOv8应用中的难题,提升你的技术水平。下期再见!

码字不易,如果这篇文章对你有所帮助,帮忙给我来个一键三连(关注、点赞、收藏),你的支持是我持续创作的最大动力。

同时也推荐大家关注我的公众号:「猿圈奇妙屋」,第一时间获取更多YOLOv8优化内容及技术资源,包括目标检测相关的最新优化方案、BAT大厂面试题、技术书籍、工具等,期待与你一起学习,共同进步!

🫵 Who am I?

我是计算机视觉、图像识别等领域的讲师 & 技术专家博客作者,笔名bug菌,CSDN | 掘金 | InfoQ | 51CTO | 华为云 | 阿里云 | 腾讯云 等社区博客专家,C站博客之星Top30,华为云多年度十佳博主,掘金多年度人气作者Top40,掘金等各大社区平台签约作者,51CTO年度博主Top12,掘金/InfoQ/51CTO等社区优质创作者;全网粉丝合计 30w+;更多精彩福利点击这里;硬核微信公众号「猿圈奇妙屋」,欢迎你的加入!免费白嫖最新BAT互联网公司面试真题、4000G PDF电子书籍、简历模板等海量资料,你想要的我都有,关键是你不来拿。

-End-

更多推荐

已为社区贡献62条内容

已为社区贡献62条内容

所有评论(0)