【必收藏】从零构建大模型(二):数据获取与清洗全攻略,小白也能快速上手

大语言模型构建的核心在于高质量数据集的建立。文章详细介绍了两大数据来源:网络文本(如Common Crawl)和知识库(如维基百科),以及数据清洗与预处理四步流程:质量筛选、文本标准化、去重处理和语种过滤。同时,讲解了如何设计数据结构(文档、问答、对话格式)和生成标准化文件,帮助读者系统构建适合大模型训练的高质量数据集,为从零构建大模型奠定坚实基础。

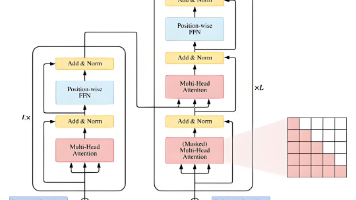

大语言模型通过在海量无标注文本数据上进行训练,实现“量变引起质变”,让模型学习人类语言的内在规律和世界知识。当模型的参数规模(通常达到千亿级别)和训练数据量突破某个临界点时,会产生一种名为 “涌现” 的能力,即模型可以完成一些它未被明确训练过的复杂任务,如逻辑推理、代码生成等。

如何构建大语言模型?我将通过一系列文章带领大家从0到1快速构建大语言模型的底层逻辑和技术体系。有了完整的知识体系,每个人可以结合自身情况和具体业务场景选择适合自己的方式开发和应用大语言模型。

今天开始第二部分内容:构建大规模数据集。

一、数据获取与收集

大型语言模型的有效性与其训练所用的文本数据的规模和质量直接相关。获取足够大的数据集(通常以TB甚至PB为单位)是构建大语言模型的一个基础步骤。

主要数据来源有哪些?

-

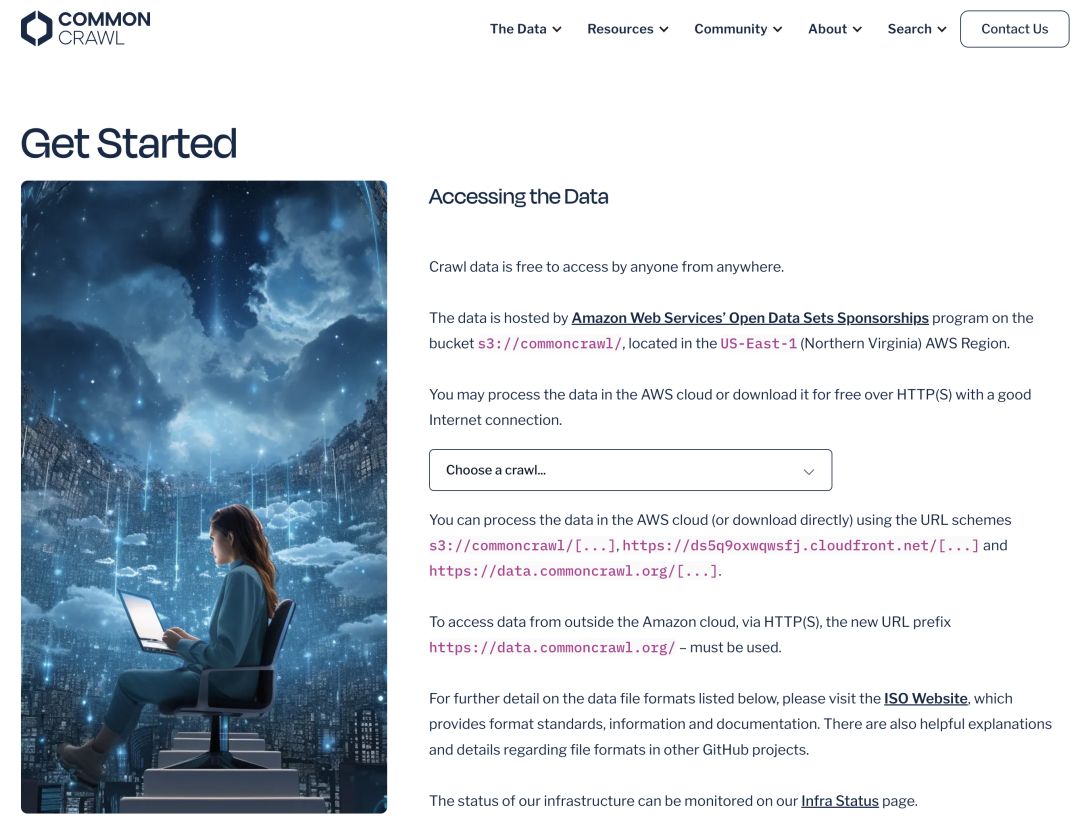

(1)网络文本:Common Crawl等公开网络存档,提供海量但质量不一的网页内容

-

Common Crawl (CC) 语料库是最大且常用的资源之一。它通过大规模网络爬取操作收集,代表了公共网络很大一部分的快照。Common Crawl 公开提供数PB的原始网页数据、元数据和提取的文本,通常每隔一两个月发布新的爬取数据集。

-

Common Crawl 提供的原始网页数据、元数据和提取的文本价值是什么?

-

Common Crawl数据为大语言模型训练提供了不可替代的真实语言环境。其核心价值在于完整保留了人类语言的真实样貌——不仅包含规范的新闻和学术文本,更涵盖了日常对话、社交媒体、地方方言等鲜活的语言使用场景。这种真实性帮助模型超越教科书式的语言学习,真正理解语言在实际生活中的运用方式。

与经过人工整理的维基百科或专业书籍相比,Common Crawl呈现出语言的“原生态”,包括口语化表达、新兴词汇和语言演变痕迹。虽然数据噪声较多,但通过严格的质量过滤和分层处理,我们能够从中提取出最具训练价值的精华内容,使模型获得对真实语言世界的深刻理解能力。

-

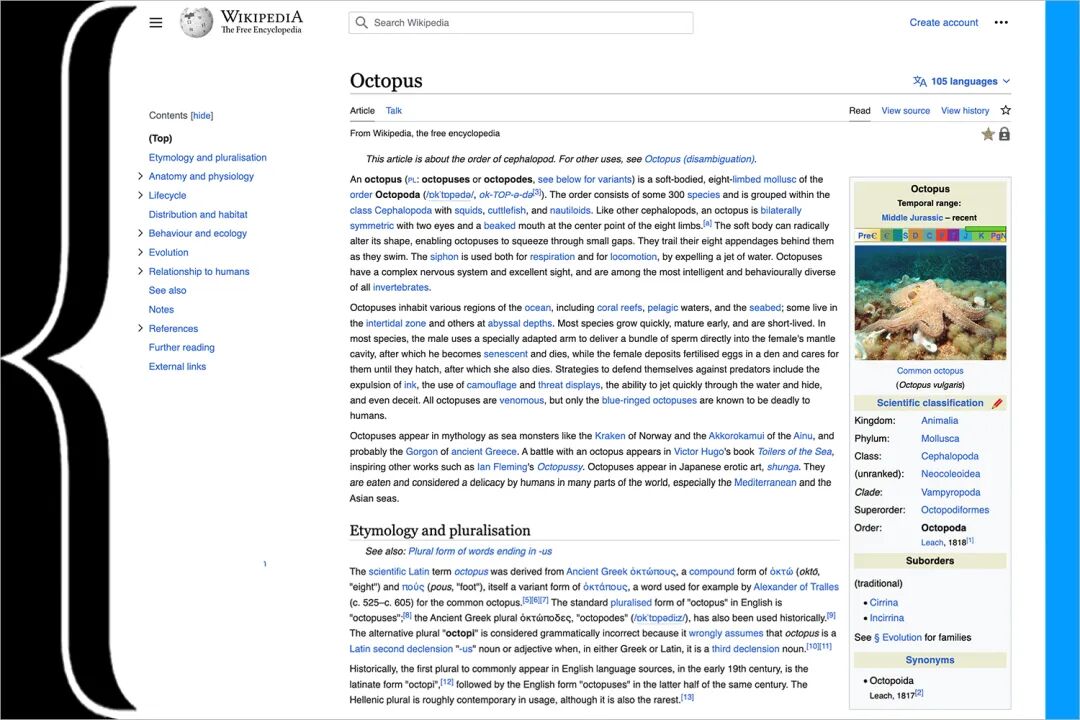

(2)知识库:维基百科等结构化知识资源,提供高质量且经过审核的文本内容

维基百科作为全球最大的多语言百科全书,它提供了系统化、结构化的知识体系。与Common Crawl的自然语言素材形成鲜明对比,维基百科内容经过严格的编辑审核和社区验证,具有高度的事实准确性和逻辑严谨性。

- 维基百科提供的结构化、高质量和经过审核的文本内容价值是什么?

维基百科的独特价值体现在其清晰的知识组织结构——每个条目都采用统一的百科文体,包含明确的概念定义、分类体系和内在逻辑关系。这种结构化为模型提供了理想的知识学习框架,帮助其建立准确的概念理解和推理能力。同时,维基百科强大的内部链接网络构建了完整的知识图谱,使模型能够学习不同概念间的关联关系。

尽管在语言多样性方面不如网络文本,但维基百科在知识准确性和结构性方面的优势无可替代。通过与Common Crawl等资源配合使用,既能保证模型获得准确的知识基础,又能保持对真实语言环境的适应能力。

二、构建数据集

原始文本数据,特别是来自网络爬取这样的大型数据源,在有效用于训练大型语言模型之前,需要大幅整理。通过过滤低质量内容、规范化文本表示、移除不必要内容、识别和处理重复文档等方法,将原始文本数据转换为高质量数据集。

数据清洗与预处理的流程是什么?

原始数据 → 质量筛选 → 文本标准化 → 去重处理 → 语种过滤 → 高质量数据

第一步:质量筛选

质量筛选是整个流程的基石。首先通过规则方法快速过滤明显低质内容,如过短文本和乱码字符;随后运用机器学习分类器深入评估文本的可读性和信息密度。这一步骤确保了后续处理环节能够在高质量数据基础上进行,为整个流程打下坚实基础。

第二步:文本标准化

在质量筛选的基础上,文本标准化着力解决格式不一致问题。通过统一字符编码、规范标点使用、标准化数字日期表示等操作,建立一致的文本表示规范。这一步有效消除了数据中的格式噪声,使得后续的去重和语种识别能够更加准确。

第三步:去重处理

完成标准化后,去重处理进一步提升数据质量。采用MinHash等算法检测不同粒度的重复内容,结合语义相似度计算识别近似重复文本。这一环节显著提升了数据集的信息密度,为模型训练提供了更优质的学习素材。

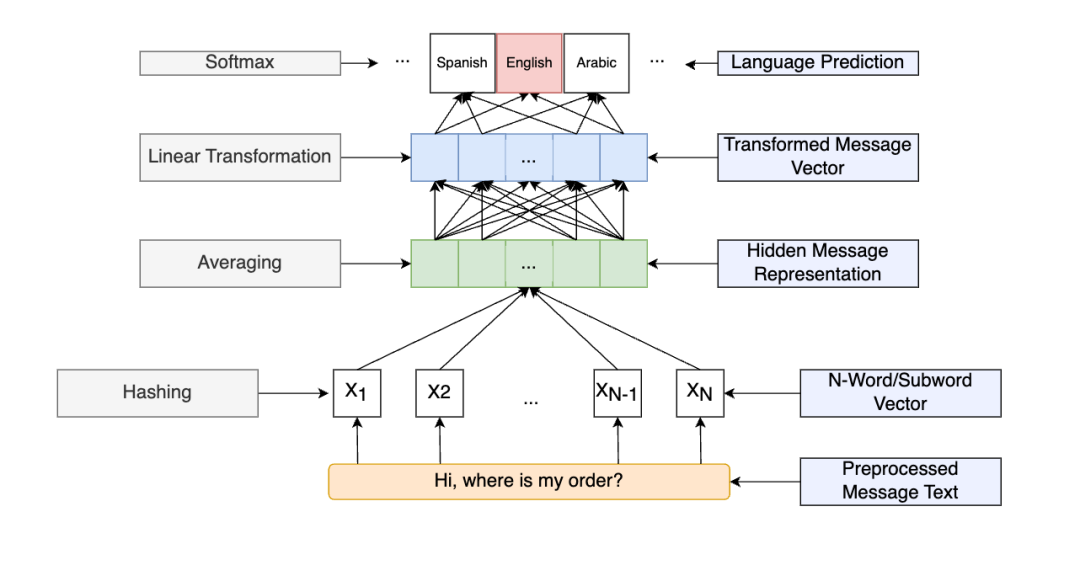

第四步:语种过滤

作为流程的最后关卡,语种过滤确保数据的语言纯净度。使用FastText等高精度工具识别语种,精准过滤非目标语言内容。这一步既保证了单语言模型的训练效果,也为多语言模型的语种比例控制提供了重要保障。

如何构建数据集?从原始文本到结构化数据

数据集构建的核心是将收集来的海量原始文本,系统性地整理成适合大模型学习的标准化格式。这个过程需要经过两个关键阶段的精心处理,才能将杂乱的文本转化为有效的学习资源。

第一步:设计数据结构 - 为模型准备"学习材料"

首先,我们需要根据不同的训练目标,设计合适的数据结构。这就好比为不同的课程准备相应的教材,每种格式都服务于特定的学习目的。

(1)文档格式(Document Format):适用于基础语言能力训练

- 将完整的文章、书籍章节或长段落作为一个独立的数据单元

- 帮助模型学习语言的基本规律和长文本理解

- 典型应用:维基百科条目、新闻长文、书籍内容

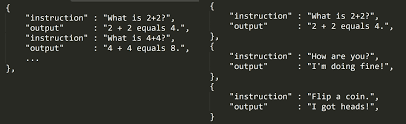

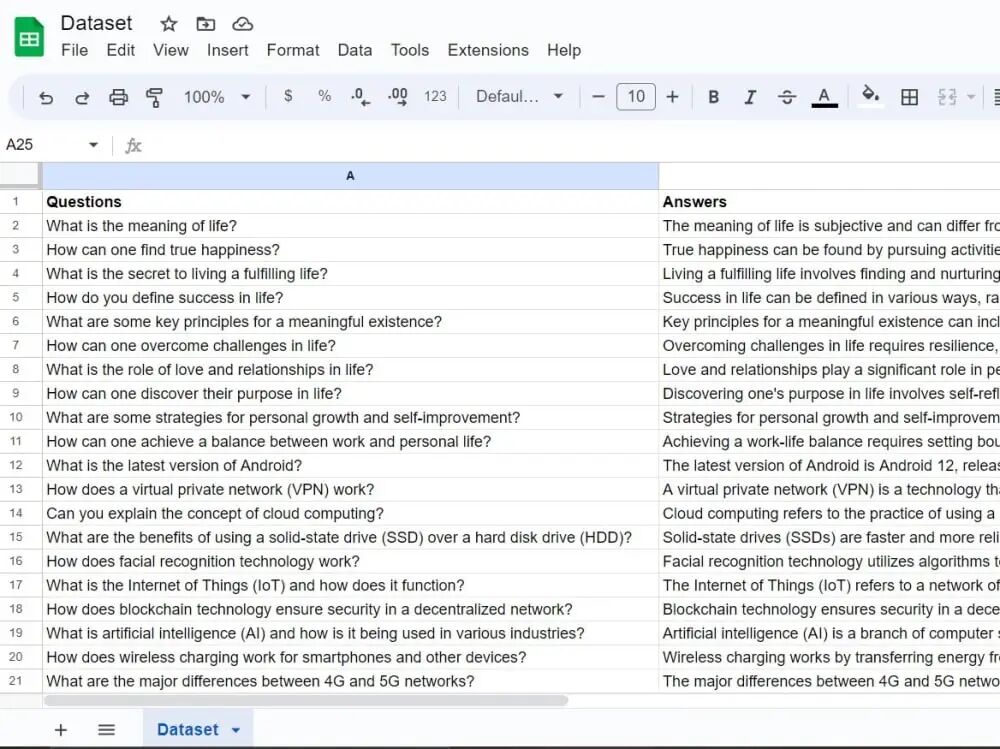

(2)问答格式(Q&A Format):专注于指令遵循能力

- 每个数据单元包含清晰的指令和对应的标准回答

- 训练模型理解问题并给出准确答案的能力

- 典型应用:翻译任务、知识问答、指令执行

(3)对话格式(Dialogue Format):培养交互沟通能力

- 记录完整的对话流程,保持上下文的连贯性

- 训练模型进行多轮对话和上下文理解

- 典型应用:客服对话、开放域聊天、任务型对话

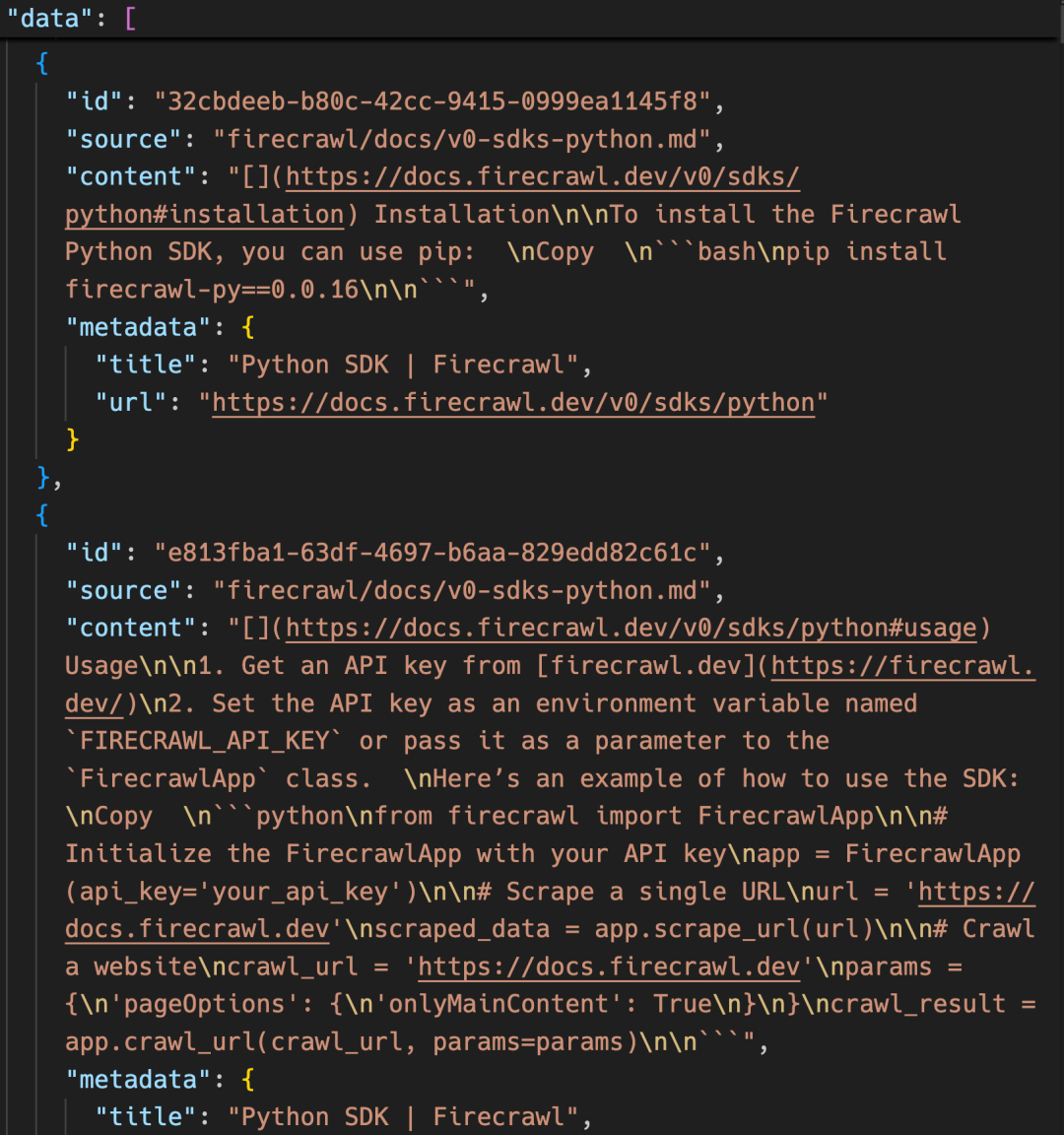

在确定基本格式后,我们还需要为每个数据单元添加重要的元数据信息,包括文本来源、内容分类和质量评分等。这些信息就像给每份材料贴上了详细的标签,为后续的数据筛选和训练策略提供了重要依据。

第二步:生成标准化文件 - 创建系统的"学习课程"

当所有数据都按照统一的结构整理完成后,我们需要将其保存为标准化的文件格式。最常用的是JSONL格式,即每行存储一个完整的数据样本。这种格式既保证了数据的完整性,又便于模型的读取和处理。

(1)每行包含一个独立的数据样本,确保训练时的独立性

(2)样本内部字段结构统一,方便模型解析学习

(3)支持大规模数据的流式读取,提升训练效率

例如,一个完整的数据集文件可能包含这样的内容:

{“text”: “深度学习是机器学习的一个重要分支…”, “source”: “textbook”, “category”: “AI”}

{“instruction”: “翻译成中文”, “input”: “Good morning”, “output”: “早上好”, “source”: “translation”}

{“conversation”: [{“role”: “user”, “content”: “你好”}, {“role”: “assistant”, “content”: “你好!有什么可以帮您的?”}]}

通过这种系统化的整理,原始文本实现了三个重要转变:

(1)数据变得标准化。统一的结构使模型能够以一致的方式处理所有学习材料,大大提高了学习效率。

(2)数据变得可筛选。借助详细的元数据,我们可以根据具体需求选择特定类型或质量的数据进行训练,实现更精准的教学目标。

(3)数据变得易使用。良好的组织结构让模型能够高效读取和处理数据,确保训练过程的稳定性和可靠性。

这种精心构建的数据集为大模型提供了优质的学习基础,一个好的数据集不仅包含高质量的内容,更需要有清晰合理的结构设计,这才是成功训练大模型的关键所在。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献391条内容

已为社区贡献391条内容

所有评论(0)