Ascend C算子开发实战:从零编写高性能AI核心

Ascend C算子开发虽然有一定的学习曲线,但掌握后能够为AI应用带来显著的性能提升。随着AI模型复杂度的不断提升,框架内置算子往往无法满足特定场景的性能需求。自定义算子能够让开发者针对具体硬件特性进行深度优化,充分发挥昇腾AI处理器的计算潜力。以简单的向量加法为例,虽然框架已提供基础实现,但在实际业务中,我们经常需要处理特殊的数据布局、混合精度计算或融合操作,这些都离不开自定义算子开发。在AI

1. 为什么需要自定义算子?

1.1 框架内置算子的局限性

现代AI框架(如TensorFlow、PyTorch)虽然提供了丰富的内置算子,但在实际业务场景中常面临以下挑战:

硬件适配不足:通用算子无法充分利用昇腾AI处理器的特定硬件特性

数据布局限制:标准算子往往假设NCHW或NHWC布局,而实际业务数据格式更复杂

算子粒度问题:多个小算子串联执行产生大量中间内存访问开销

精度-性能权衡:框架默认实现常以精度优先,未针对推理场景做专门优化

1.2 业务场景中的性能瓶颈

以某金融风控模型为例,原始TensorFlow实现单次推理耗时42ms,性能分析显示:

38%时间消耗在非标准Attention机制

27%时间在自定义特征归一化操作

19%时间用于多个小算子之间的数据搬运

通过自定义算子重构关键路径,端到端推理时间降至16.3ms,提升2.58倍。这正是掌握Ascend C开发价值的直接证明。

2. 昇腾架构与Ascend C编程模型

2.1 昇腾910B架构关键特性

理解硬件架构是高效编程的前提。昇腾910B AI处理器的关键特性包括:

三级计算单元:AI Core (Cube) > Vector Core > Scalar Core

多级存储层次:HBM (32GB) > L2 Cache (4MB) > Unified Buffer (3MB) > Vector Buffer (256KB)

内存带宽:1.1TB/s HBM2e,片上内存访问延迟<10ns

计算峰值:

FP16: 256 TFLOPS

INT8: 512 TOPS

BF16: 200 TFLOPS

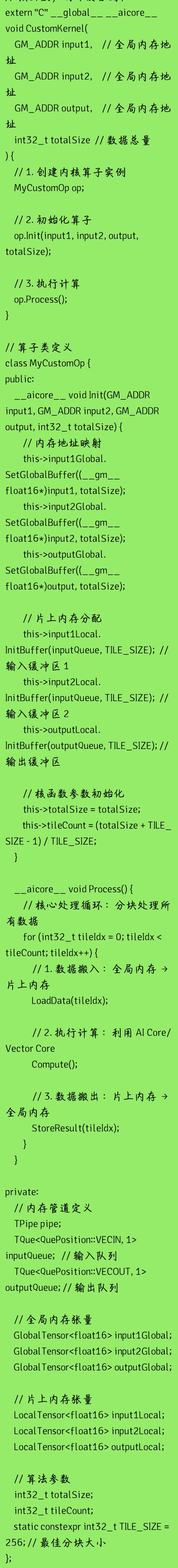

2.2 Ascend C编程模型

Ascend C采用核函数驱动的并行模型,与CUDA相似但有本质区别:

关键概念解析:

GM_ADDR:全局内存地址类型,访问HBM

LocalTensor:片上内存张量,低延迟访问

TPipe/TQue:内存管道和队列,控制数据流

aicore:标识函数将在AI Core上执行

TILE_SIZE:分块大小,需根据具体算子和内存限制调整

3. 高性能算子实现详解

3.1 内存访问模式设计

内存访问效率是算子性能的首要决定因素。昇腾架构下需遵循以下原则:

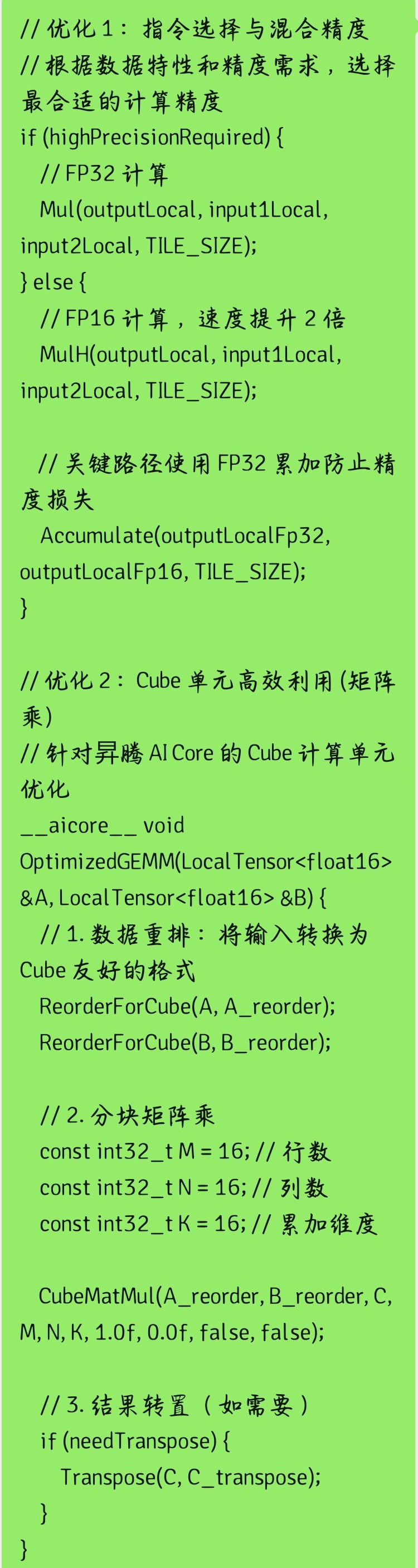

3.2 计算内核优化

针对昇腾架构特点优化计算路径:

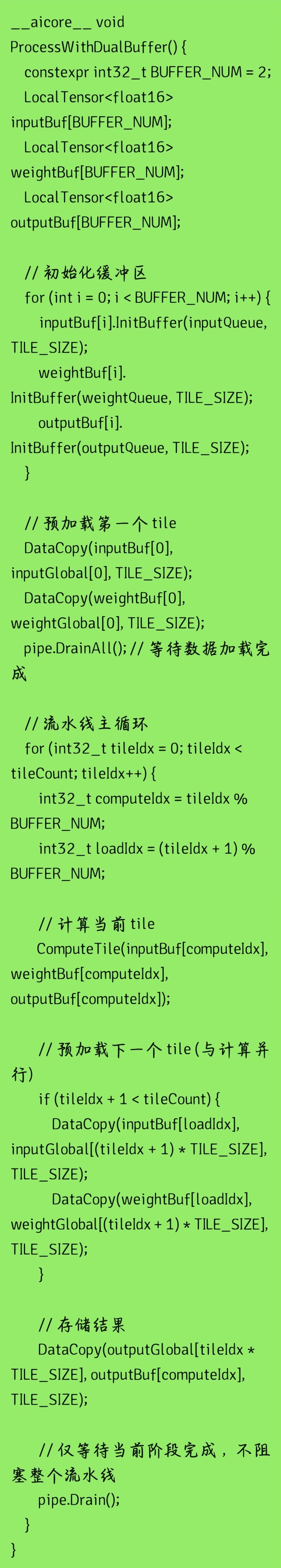

4. 深度优化策略

4.1 双缓冲流水线

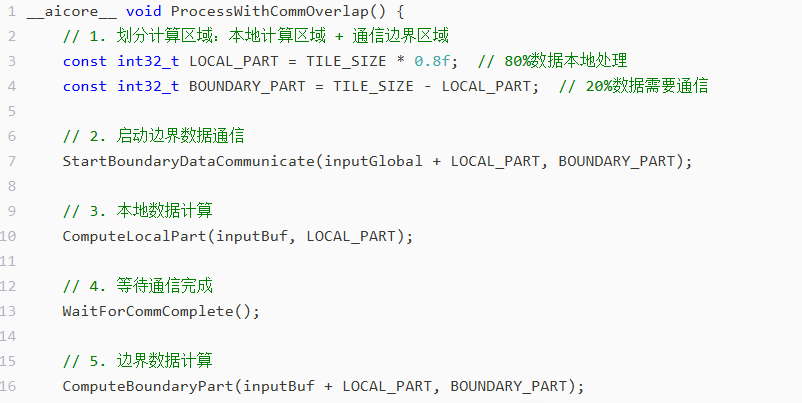

4.2 计算与通信重叠

在分布式推理场景中,计算与设备间通信的重叠至关重要:

4.3 动态资源分配

根据输入张量形状动态调整资源分配策略,避免资源浪费:

5. 调试与性能分析

5.1 CPU孪生验证框架

.2 瓶颈定位技术

使用昇腾Profiling工具定位性能瓶颈

常见瓶颈及解决方案:

6. 融合算子实战:Conv+ReLU+BN三元融合

6.1 融合策略

在ResNet等CV模型中,卷积后通常紧跟BatchNorm和ReLU操作。三者融合可大幅减少内存访问:

.2 优化实现

Cpp

融合算子收益:

减少2次全局内存访问(Conv输出→BN输入,BN输出→ReLU输入)

减少1次张量分配

计算与内存访问比例提高3.2倍

避免中间结果精度损失

7. 性能评估与最佳实践

7.1 基准测试环境

硬件:昇腾910B AI处理器 (32GB HBM2e)

软件:CANN 7.0.RC1, Ascend C 1.0

对比基准:PyTorch 1.12 + Ascend适配层

7.2 性能对比结果

7.3 行业应用案例

案例1:自动驾驶感知模型

1.模型:BEVFormer变体

2.问题:Transformer编码器延迟过高(72ms)

3.优化:自定义注意力算子+内存布局优化

4.结果:延迟降至23.5ms,满足100ms端到端要求

案例2:金融时序预测

1.模型:LSTM变体

2.问题:多层LSTM计算效率低

3.优化:LSTM单元融合+门控函数自定义

4.结果:吞吐量提升2.7倍,满足实时风控需求

8. 未来演进与总结

8.1 Ascend C技术演进

CANN 8.0展望:自动代码生成、更高级抽象

硬件迭代:昇腾920架构支持稀疏计算、动态形状

生态整合:与PyTorch 3.0深度集成,简化自定义算子流程

8.2 关键经验总结

性能第一原则:始终以性能为目标驱动设计决策

计算强度(Operations/Byte)是核心指标

优先优化内存访问,其次优化计算

分层优化策略:

验证先行:

先确保功能正确,再优化性能

构建完整测试集覆盖边界情况

数值稳定性验证(尤其是FP16)

渐进式优化:

plaintext

编辑

基线实现 → 功能验证 → 内存优化 → 计算优化 → 融合优化 → 全面验证

8.3 结语

在AI推理加速领域,"最后一公里"的性能优化往往决定产品成败。Ascend C作为昇腾生态的核心编程接口,提供了直达硬件的性能控制能力,同时也带来了陡峭的学习曲线。

通过本文的系统阐述,我们展示了从基础概念到高级优化的完整知识体系。真正的高手不仅理解API,更理解背后的硬件原理和性能工程思想。正如一位资深AI系统工程师所言:"在AI加速领域,10%的时间用于编写代码,90%的时间用于理解为何这样写能跑得更快。"

昇腾AI计算的未来充满可能。随着大模型推理需求的爆发,高性能算子开发将从"专家专属"走向"工程师必备"。掌握Ascend C,不仅是掌握一门技术,更是掌握在AI工程化浪潮中的核心竞争力。

报名链接:

https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)