【收藏学习】混合专家模型(MoE)深度解析:大模型稀疏化革命与实战应用(上)

混合专家模型(MoE)通过"稀疏激活"机制提升大模型性能与效率。它由多个"专家子模型"和智能路由器组成,每个输入仅由少数适配专家处理,实现"大模型能力"与"小模型效率"的平衡。MoE解决了传统稠密模型计算成本高、资源利用率低的问题,但也面临专家负载不均衡的挑战,需要负载均衡技术优化。

引言

在一座热闹的 AI 工坊里,住着一位全能的 “稠密工匠”。无论收到什么任务 —— 处理标点符号、解析动词含义、计算数字、描述视觉场景,他都得亲力亲为。起初,工坊订单不多,他还能应付;可随着订单量暴增(对应大模型规模扩大),这位工匠每天忙得焦头烂额,不仅处理速度越来越慢,还经常因为精力分散而出错(对应稠密模型计算成本飙升、性能瓶颈)。

工坊主人看在眼里,急在心里。他想出一个办法:招聘几位 “专项工匠”—— 有人专攻标点处理,有人擅长动词解析,有人精通数字计算,有人专注视觉描述,再请一位 “调度员” 负责根据订单类型,将任务精准分配给对应的专项工匠。改造后,工坊效率大幅提升:每个工匠只处理自己擅长的任务,速度更快、准确率更高,即便订单量翻倍,也能轻松应对(对应 MoE 模型的稀疏激活与高效扩维优势)。

这个小故事,正是混合专家模型(Mixture of Experts, MoE)要解决的核心问题:如何在有限计算资源下,让模型既能 “变大变强”,又不陷入 “算力泥潭”。本文将从 MoE 的核心定义、架构组件、关键技术、跨领域扩展到实战案例,为研究生及领域从业者提供一份全面且深入的解析。

一、什么是混合专家模型(MoE)?

混合专家模型(MoE,Mixture of Experts)是一种基于 “分而治之” 思想的神经网络优化技术,核心目标是在不显著增加计算成本的前提下,通过引入多个 “专家子模型” 和 “智能路由机制”,提升大型语言模型(LLMs)及视觉模型的性能与效率。

1.1 核心定位:解决大模型的 “规模困境”

模型规模是提升性能的关键,但传统稠密模型存在明显瓶颈:

- 计算成本呈指数级增长:稠密模型的所有参数在每次前向传播时均被激活,规模扩大必然导致推理速度骤降、显存占用飙升;

- 资源利用率低下:单一模型难以同时精通所有任务场景,大量参数在处理特定任务时处于 “无效激活” 状态。

MoE 的突破在于:用 “稀疏激活” 替代 “全参数激活”,通过路由机制让每个输入仅由少数适配的 “专家” 处理,实现 “大模型能力” 与 “小模型效率” 的平衡。其显著优势包括:

- 计算效率更高:相同计算预算下,MoE 可支持更大的模型或数据集规模;

- 训练速度更快:预训练阶段比稠密模型更快达到同等性能水平;

- 泛化能力更强:多个专家分工协作,可捕捉更细粒度的任务特征。

1.2 术语辨析:混合专家模型 vs 专家混合模型

- 混合专家模型:强调 “多个专家协同工作”,适用于描述机器学习领域中通过组合子模型处理复杂任务的场景;

- 专家混合模型:侧重于 “专家的动态组合方式”,更适合描述神经网络架构中路由机制的核心作用。

两者本质无本质差异,本文统一使用 “混合专家模型(MoE)” 表述。

1.3 核心架构:专家与路由器的 “双人舞”

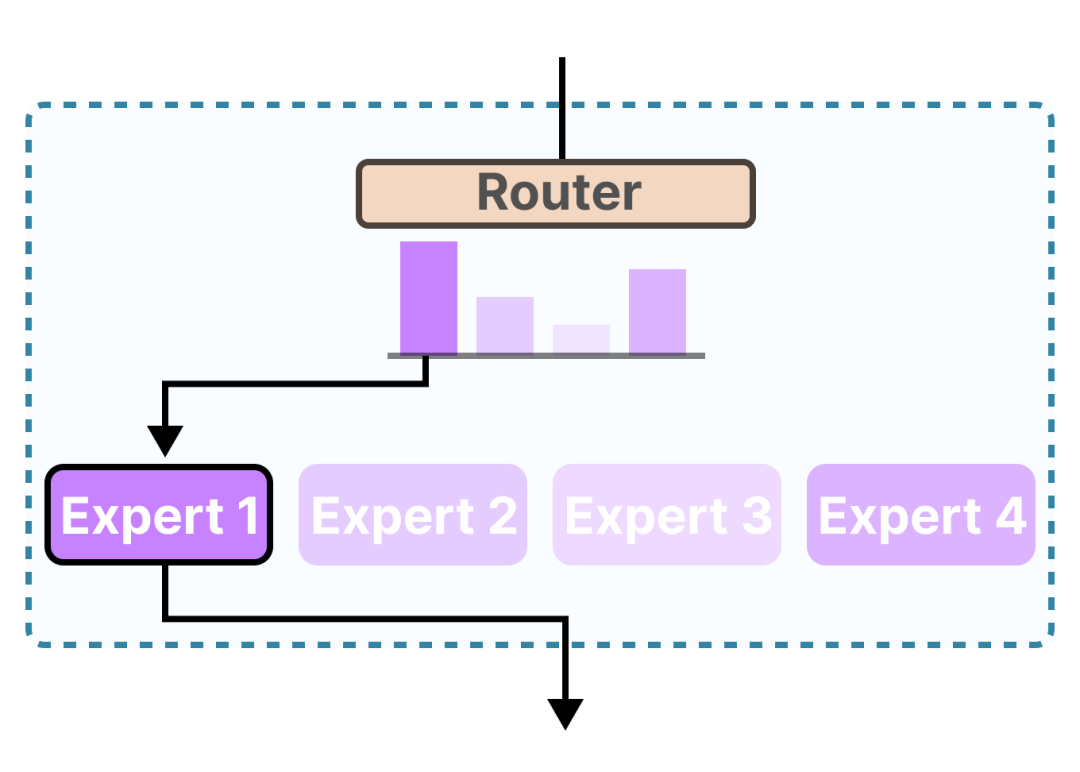

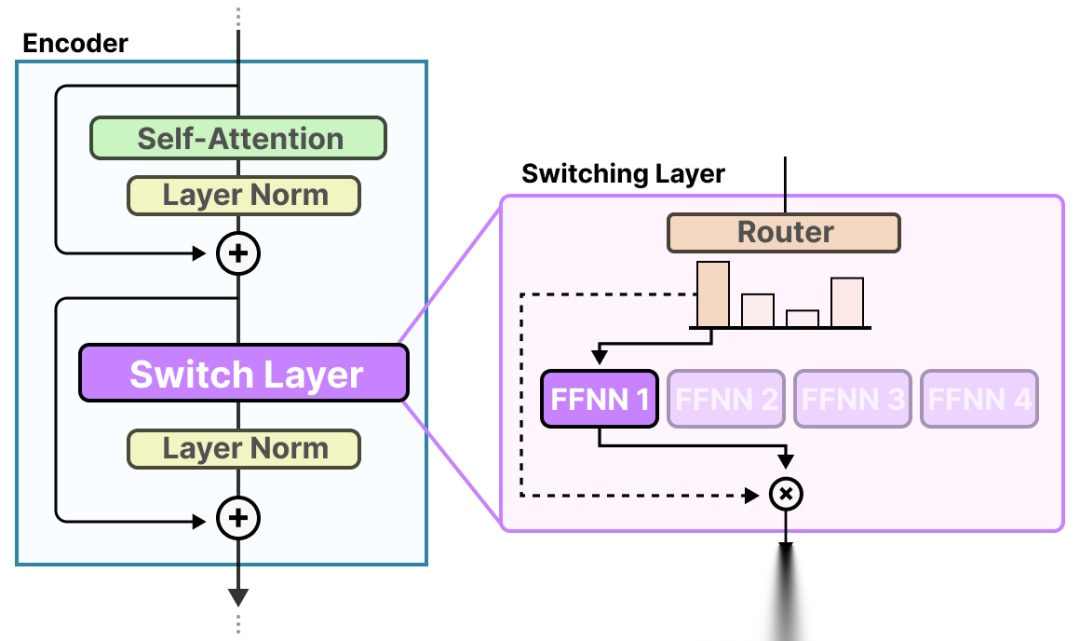

MoE 的结构由两个不可分割的核心组件构成,如同工坊中的 “专项工匠” 与 “调度员”:

(1)专家(Experts)

- 本质:替代传统 Transformer 中单一前馈神经网络(FFNN)的子模块,每个专家本身也是一个完整的 FFNN 结构;

- 特点:不擅长特定 “学科领域”(如心理学、生物学),而专注于处理特定上下文的 token 类型(如标点、动词、数字、视觉描述等);

- 定位:并非完整的 LLM,而是 LLM 架构中负责特定任务的 “专项子模块”。

(2)路由器(Router / 门控网络)

- 本质:一个轻量的 FFNN,专门负责 “任务分配”;

- 作用:根据输入 token 的向量表示,输出一组概率分布,据此选择最适合处理该 token 的专家;

- 分类:

- 稀疏 MoE:每次仅选择少数专家(如 Top-1、Top-2)参与计算,是当前 LLM 的主流实现;

- 稠密 MoE:所有专家均参与计算,但参与程度由路由概率加权控制,计算成本较高。

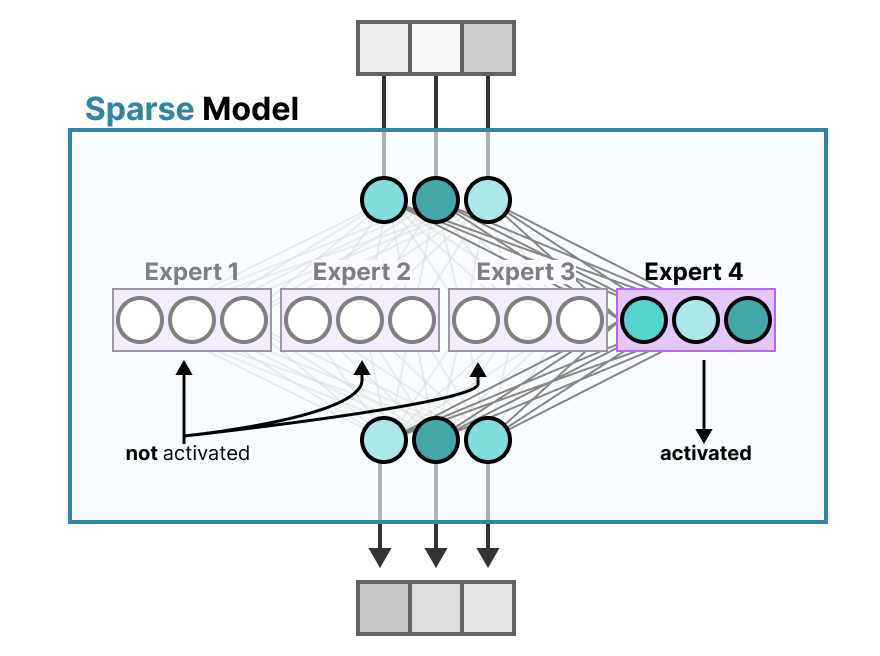

图1:MoE核心架构示意图

在 MoE 架构的大语言模型中,每一层 FFNN 都会被替换为 “路由器 + 多个专家” 的组合,形成层级化的稀疏处理结构:

图2:MoE架构在LLM中的层级分布

二、专家模块:从稠密层到稀疏层的范式转变

要理解专家模块的工作原理,首先需要明确其 “替代对象”—— 传统 Transformer 中的稠密 FFNN 层,以及两者的核心差异。

2.1 稠密层:MoE 的 “前身” 与局限

专家混合模型的设计出发点,是 LLM 中最基础的组件 —— 前馈神经网络(FFNN, Feedforward Neural Network)。Transformer 里的 FFNN(前馈神经网络),就像给注意力机制挑好的“上下文信息”做二次加工——把零散的关联理顺、变深,挖出数据里更隐蔽、更复杂的联系。

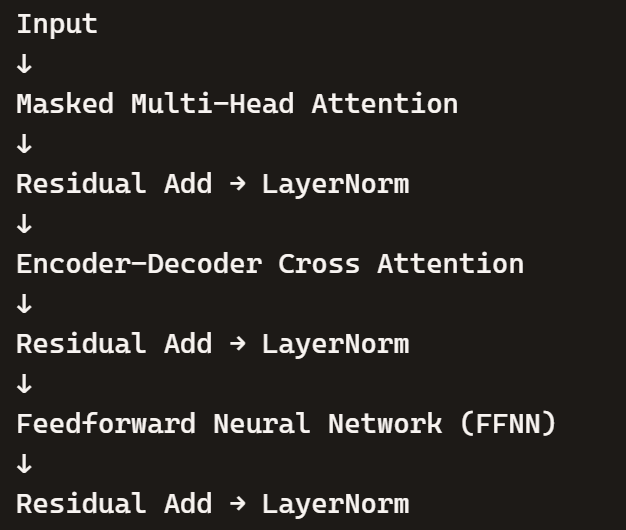

(1)不同 Transformer 架构中 FFNN 的位置

- 普通 Transformer(post-ln):

LayerNorm 放在残差连接之后,即 Residual Add + LayerNorm。这种结构最早出现在原始 Transformer(Vaswani et al., 2017)中。每个子层(注意力、FFNN)都先进行残差连接,再做 LayerNorm。

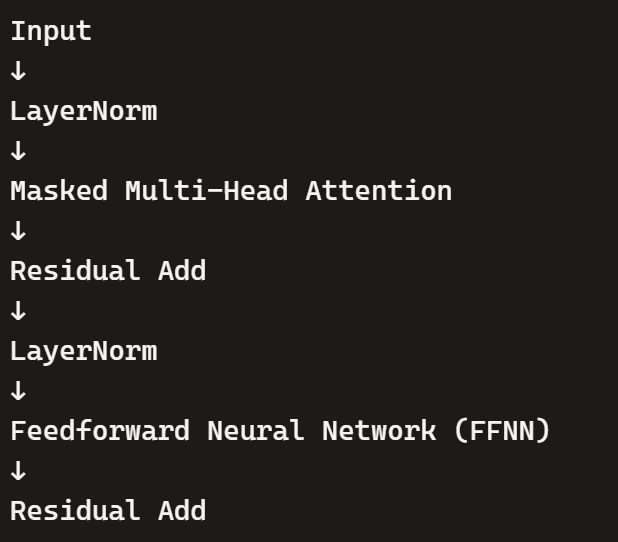

- 仅解码器 Transformer(pre-ln,如 GPT 系列):

LayerNorm 放在子层之前,即 LayerNorm → 子层 → Residual Add。

GPT 系列采用这种结构,训练更稳定,梯度传播更顺畅。

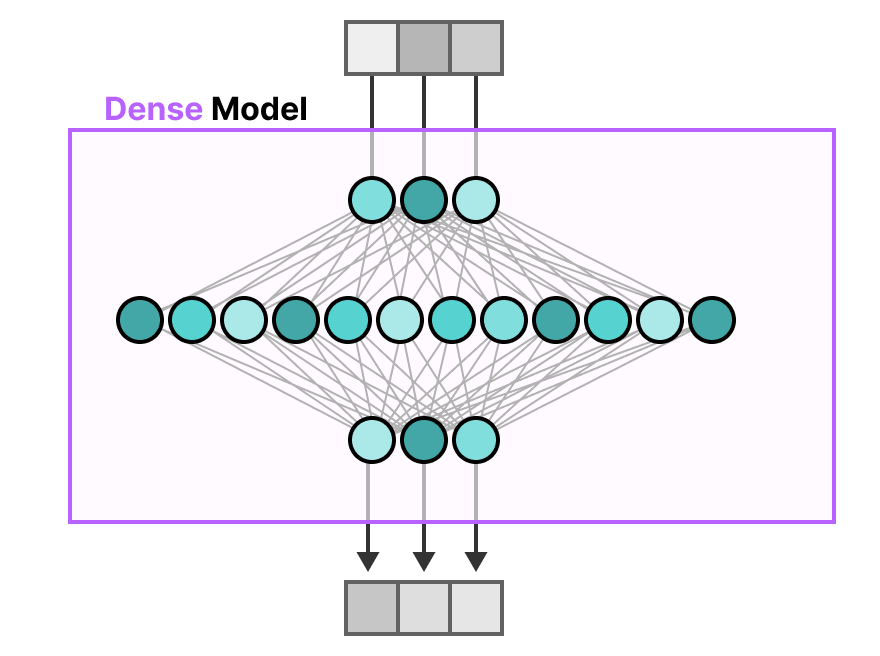

(2)稠密层的核心局限

传统 FFNN 被称为 “稠密模型”,因为其所有参数(权重 + 偏置)在每次前向传播时都会被激活。随着模型规模扩大,FFNN 的参数数量呈指数级增长,为了捕捉复杂特征,它需要对输入数据进行 “维度扩展”(如从 512 维扩展到 2048 维),导致计算成本急剧上升。

图3:稠密模型参数全激活示意图

2.2 稀疏层:MoE 的 “核心创新”

与稠密模型不同,稀疏模型(MoE 属于典型的稀疏模型)仅激活部分参数—— 将一个稠密 FFNN 拆分为多个独立的 “专家 FFNN”,训练时让每个专家学习不同的任务特征,推理时仅激活与当前输入最相关的少数专家。

(1)稀疏激活的核心逻辑

- 训练阶段:每个专家专注于学习某类特定 token 的处理逻辑(如标点、动词、数字等),形成 “专项能力”;

- 推理阶段:路由器根据输入 token 的特征,选择最适配的专家进行处理,未被选中的专家参数不激活,从而节省计算资源。

图4:稀疏模型仅激活部分专家示意图

(2)稀疏层的优势验证

当输入 “1+1=?” 这样的数字计算任务时,稀疏模型会精准激活 “数字处理专家”,而标点、动词、视觉描述等专家均处于 “休眠状态”,计算成本仅为稠密模型的 1/4(假设 4 个专家),但处理精度更高。

2.3 专家的 “专项能力”:到底学到了什么?

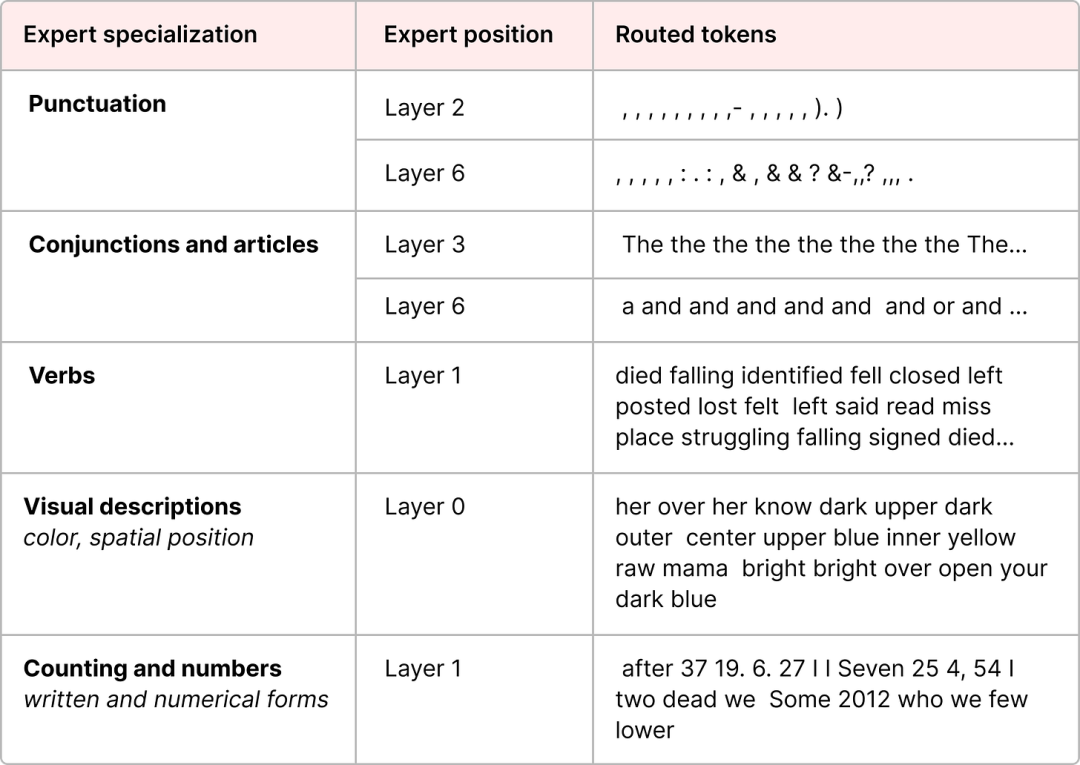

MoE 中的 “专家” 并非 “领域专家”,而是 “token 类型专家”。ST-MoE 论文通过实验验证,编码器模型中的专家会表现出明显的 “专门化” 特征,具体如下表所示:

图5:编码器模型专家专门化表现

这张图展示了 Transformer 模型中不同层对语言特征的“专家化”处理能力,也就是每一层在处理不同类型的语言信息时表现出特定的偏好或专长。它揭示了模型内部的“分工协作”现象,类似于人脑中不同区域处理不同任务。例如第一个Expert specialization为标点符号(Punctuation),则Layer 2 和 Layer 6 对标点非常敏感。

而解码器模型(如 GPT 系列)中的专家,虽未表现出明显的 “领域专门化”,但仍会聚焦于处理特定类型的 token(如语法结构相关 token)。Mixtral 8x7B 论文通过 “颜色标记法” 验证:每个 token 会被第一个适配的专家处理,且专家更关注语法结构而非领域知识。

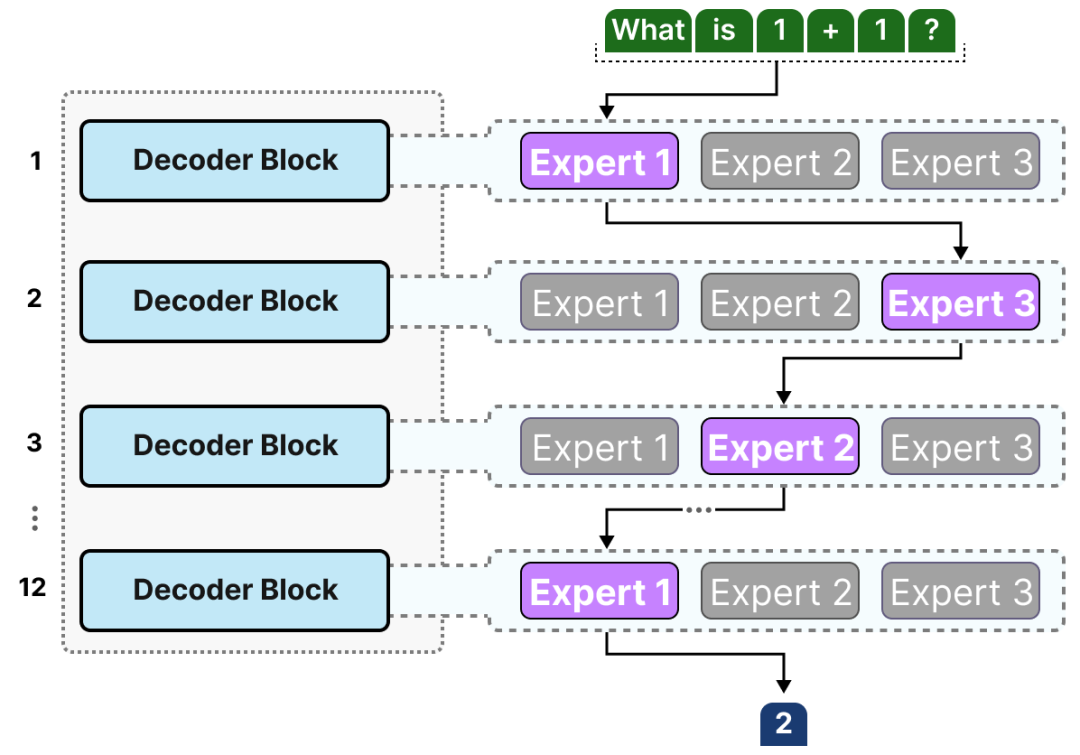

2.4 专家的架构细节

尽管可将专家理解为 “稠密 FFNN 的拆分片段”,但实际上每个专家都是完整的 FFNN 结构,包含 “输入投影→激活→输出投影” 的全流程。在多解码器块的 LLM 中,一段文本的生成过程会经过多层专家的协同处理,不同 token 会根据自身特征选择不同的专家路径,形成 “动态计算流”,即每个 token 在模型内部的处理路径是动态选择的。

图6:多解码器块中专家的协同处理流程

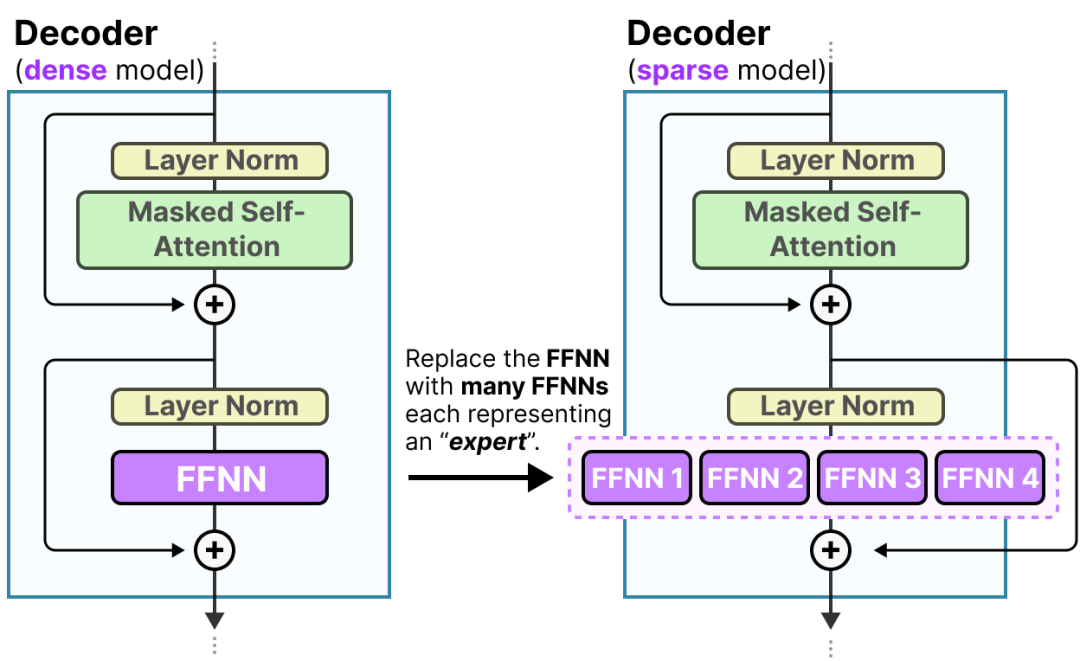

将 MoE 层融入 Decoder 块后,其结构对比的如下:

-

稠密模型 Decoder 块(左图):1 个 FFNN 处理所有 token;

-

稀疏模型 Decoder 块(右图):多个 FFNN(专家)并行,由路由器分配任务。

图7:稠密模型与稀疏模型Decoder Block结构对比

三、路由机制:MoE 的 “智能调度核心”

如果说专家是 MoE 的 “执行单元”,那么路由器就是 MoE 的 “大脑”—— 它决定了每个 token 该交给哪个专家处理,直接影响模型的性能与效率。本节将深入解析路由机制的工作原理、核心挑战及解决方案。

3.1 路由器的本质与核心作用

路由器本身是一个轻量的 FFNN,其核心任务是:根据输入 token 的向量表示,计算每个专家对该 token 的 “适配概率”,并选择最优专家组合。

(1)路由器的两种工作模式

- 稀疏 MoE(主流,右图):每次仅选择 Top-k 个专家(k 通常为 1 或 2),未被选中的专家不参与计算,大幅降低推理成本;

- 稠密 MoE(左图):所有专家均参与计算,但每个专家的输出会乘以对应的路由概率(权重),最终加权求和得到结果,计算成本较高。

图8:稀疏MoE与稠密MoE的路由模式对比

(2)MoE 层的完整构成

路由器 + 一组专家(通常为 4~8 个)构成一个完整的 MoE 层(图中Switch Layer),其在 Transformer 架构中的融入方式如下:

图9:MoE层融入Transformer的结构示意图

3.2 专家选择的完整过程

路由器选择专家的过程可分为三个核心步骤,本质是 “分数计算→概率转换→专家选择” 的闭环:

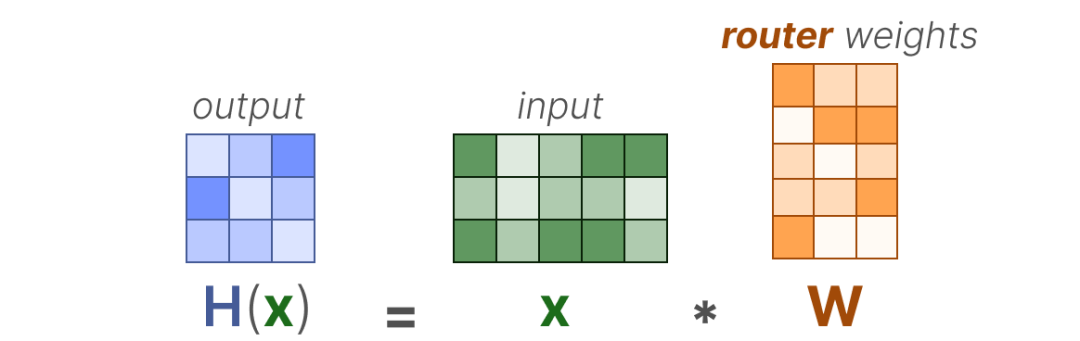

步骤 1:计算专家适配分数

设输入 token 的向量表示为(维度为),路由权重矩阵为(维度为,为专家数量),则每个专家对该 token 的适配分数计算为:

该分数表示 token 与每个专家的 “匹配程度”,分数越高,适配性越强。

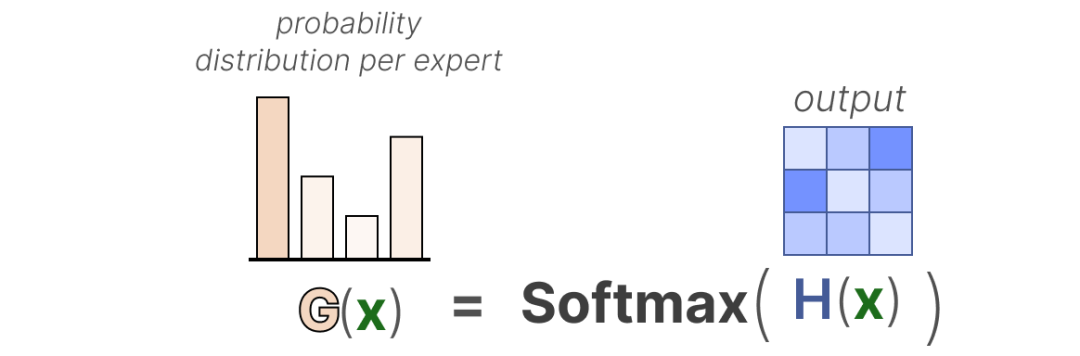

步骤 2:转换为概率分布

通过 SoftMax 函数将适配分数转换为概率分布,确保所有专家的概率和为 1:

其中表示第个专家被选中的概率。

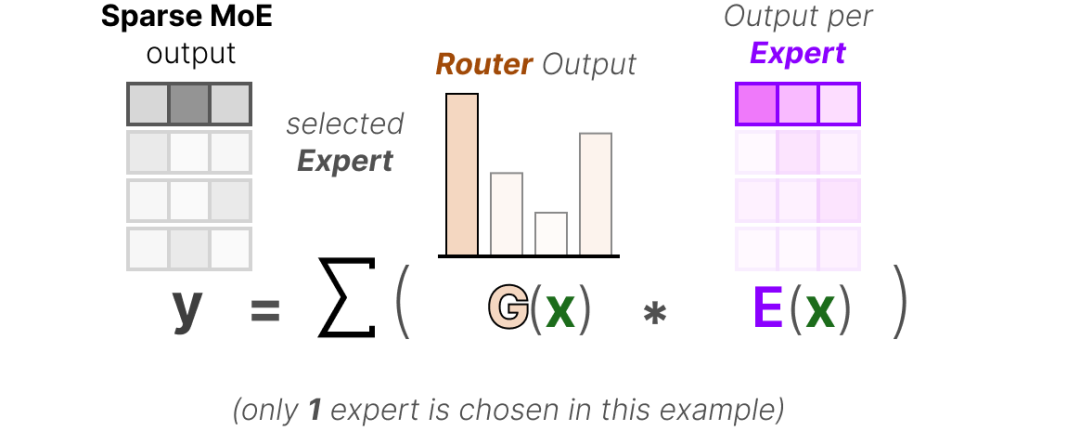

步骤 3:选择专家并加权输出

根据概率分布,选择概率最高的 Top-k 个专家(稀疏 MoE),每个选中专家的输出会乘以对应的概率,最终加权求和得到该 token 在 MoE 层的输出:

其中表示第个专家对输入的处理结果。

图10:专家选择的完整流程

3.3 路由的核心挑战:专家负载不均衡

尽管路由机制看似简单,但在实际训练中会面临一个关键问题:部分专家学得更快、适配场景更广,导致路由器频繁选择这些 “热门专家”,而其他 “冷门专家” 几乎得不到训练机会。

这种 “负载不均衡” 会引发两大问题:

- 热门专家过拟合:频繁处理各类 token,导致泛化能力下降;

- 冷门专家欠拟合:缺乏训练数据,无法形成有效的专项能力,模型整体性能受损。

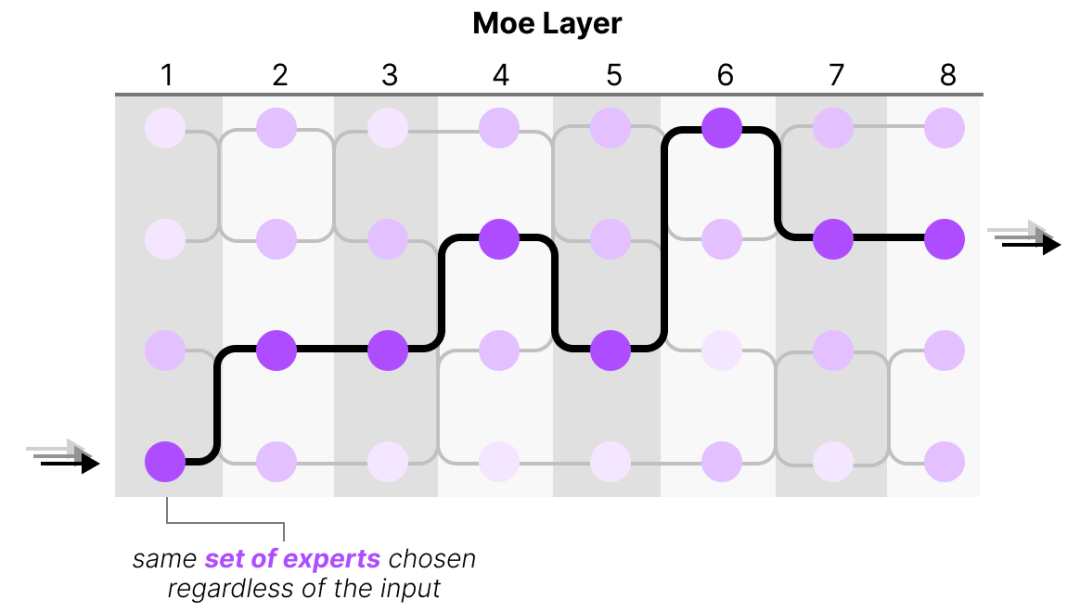

图11中,每一列代表 MoE 层中的一个位置(可能是多个 MoE 层或多个 token 的处理步骤)。每列中的圆点是不同的专家模块(Experts),例如 FFNN 子网络。深紫色圆点表示被激活的专家。黑色路径连接这些激活的专家,表示数据流经的路线。

图下方的说明指出:“same set of experts chosen regardless of the input”(无论输入如何,选择的专家都是同一组),意味着模型没有根据输入 token 的语义或特征动态选择专家,而是不约而同选择相同专家,这使得路由器形同虚设,无法实现 MoE 的“按需激活”优势。

图11:专家负载不均衡示意图

为解决这一问题,研究者提出了 “负载均衡” 技术体系,核心思路是通过 “策略约束 + 损失优化”,强制路由器公平分配任务给所有专家。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献248条内容

已为社区贡献248条内容

所有评论(0)