MoE算法深度解析:从理论架构到行业实践

混合专家模型(MoE)作为突破大语言模型算力瓶颈的关键技术,通过稀疏激活机制实现参数规模与计算成本解耦。其核心架构包含专业化专家网络和动态路由机制,仅激活部分专家参与计算,显著提升效率。2025年研究显示,MoE在医疗诊断(准确率提升12%)、自动驾驶(延迟降至50ms)等场景表现优异,参数量可达万亿级而推理成本基本不变。尽管面临训练稳定性等挑战,MoE凭借动态路由、负载均衡等创新技术,已成为平衡

目录

一、引言

从密集到稀疏的模型架构革命,正重塑大语言模型的发展轨迹。随着参数规模突破千亿级,传统密集型架构面临计算资源、训练效率与推理速度的三重挑战,算力消耗随规模呈指数级增长。2025 年,混合专家模型(MoE)成为突破瓶颈的关键路径,其核心在于将庞大网络分解为专业化"专家模块",通过动态路由机制实现"每次推理仅激活部分专家"的稀疏计算模式。这种"分而治之"的策略不仅实现参数规模与计算成本的解耦,更通过专业化分工提升学习效率,使 GPT - 4、Grok 等模型在保持推理成本基本不变的前提下,实现万亿级参数扩展。

MoE 核心价值:通过动态路由机制将输入分配给特定专家模块,在参数规模扩张时保持计算成本稳定,同时借助专业化分工提升模型表达能力。

二、MoE算法的基础理论

MoE 算法具有集成学习属性,核心思想是“分而治之”,通过多个专家网络分工处理子问题空间,将问题空间划分为同质区域。其概念最早可追溯到 20 世纪 90 年代的“committee machines”,1991 年 Jacobs 等人在论文“Adaptive Mixture of Local Experts”中正式提出该框架,包含专家网络与门控网络两个核心组件。

现代 MoE 架构由专家层、路由网络和混合机制构成。专家网络通常为独立的前馈神经网络,各自专注于特定子任务或数据分布;路由网络(门控机制)通过轻量级网络分析输入特征,采用 TopK 等稀疏激活策略动态选择相关专家。这种动态路由机制实现了对传统静态集成学习的突破,如同医院分诊系统根据病人症状分配专科医生,门控网络将输入分配给最适合的专家处理。

核心特性:MoE 通过稀疏激活实现条件计算,仅部分专家参与每次前向传播,在保持模型容量的同时大幅降低计算开销。与传统密集模型全参数激活模式相比,其训练效率显著提升,达到目标精度所需轮次可减少 50%。

近年来,MoE 在大模型领域重新崛起,成为平衡模型容量与计算效率的关键技术,尤其适用于生成式 AI 等计算密集型任务。

三、MoE算法的核心架构设计

(一)专家网络的专业化分工

专家网络通过参数隔离机制实现专精化,每个专家作为独立前馈网络专注特定子问题空间,如语法解析或API调用。华为盘古Ultra按领域划分专家组,ERNIE-4.5-VL-424B-A47B用异构MoE关联影像与病历。DeepSeekMoE通过细粒度分割与共享专家隔离提升专业化,MobileMoE采用MobileNet结构实现70%压缩。

核心特性:参数隔离保障子问题深度优化,多头检索与共享神经元提升参数效率,多模态场景中专家结构差异化适配数据类型。

(二)门控网络的动态路由机制

门控网络作为 MoE 模型的"决策中枢",其核心功能是实现输入与专家的动态匹配。这一过程可类比医院分诊系统:如同分诊台根据患者症状分配专科医生,门控网络依据输入特征将数据路由至最相关的专家处理。其数学基础包含两个关键步骤:首先通过全连接层将输入特征映射为专家激活分数,经 Softmax 函数转换为概率分布 G(x),表示输入与各专家的相关性权重;随后执行 Top-K 选择策略,仅激活概率最高的 K 个专家以提升计算效率。

在具体实现中,输入 token 的特征向量 xt 经门控网络处理后,会生成类似"(专家1:45%,专家2:19%,专家3:5%,专家4:31%)"的概率分布,最终仅激活 Top-K 专家参与计算。2025 年提出的动态 k 值机制进一步优化路由策略,通过公式 k = min(k_max, max(k_min, ⌈α·entropy(G(x))⌉)) 实现专家数量的自适应调整,其中 entropy(G(x)) 反映输入复杂度,α 为可学习参数。层级路由机制则通过多阶段决策提升匹配精度,如 Moma 模型先按模态特征选择专家组,再在组内确定具体专家,实现输入与专家资源的精准匹配。

核心公式

-

概率分布计算:G(x) = Softmax(W·x),其中 W 为路由器权重矩阵

-

动态 k 值调整:k = min(k_max, max(k_min, ⌈α·entropy(G(x))⌉))

-

Top-K 选择:激活概率排序前 K 位的专家

四、MoE算法的关键技术细节

(一)路由机制的数学原理

路由机制通过门控网络与 Top-K 操作实现专家稀疏激活。门控网络先对输入 token 表示 x 做线性变换 (

为可训练权重矩阵),再经 softmax 得概率分布 p,

表 token 对专家 i 的亲和力。Top-K 路由选 p 中 k 个最高值索引,可选重新归一化分数,最终输出为选定专家输出的加权和 y = ∑

。

核心公式

-

门控分数:

(线性变换)

-

概率分布:p = softmax(logits)(专家亲和力)

-

加权输出:y = ∑

(Top-K 专家加权和)

(二)负载均衡与稀疏训练优化

MoE 架构因稀疏激活特性面临专家负载不均衡挑战,与密集模型所有参数参与计算不同,其门控网络可能持续选择少数专家导致"路由崩溃"。容量因子通过限制单专家最大 token 数缓解过载,典型值设为 0.25,确保单个专家在批次中处理 token 数不超过总量的 25%。辅助负载均衡损失函数通过惩罚极端分布调节专家资源利用,对含 T 个 token 和 N 个专家的批次,计算式为 = (1/N) ∑

,其中

为专家路由概率总和,

为分配 token 数。

稀疏训练因激活专家波动产生梯度噪声,DeepSeek V3 采用梯度裁剪(clip value=1.0)稳定训练,其无辅助损失策略使 671B 总参数中仅激活 37B/Token,FLOPs 降至传统 Dense 架构 30%以下。微软通过 Dropout 式专家随机丢弃防止门控网络过早固化,DeepSeek-R1 的 noaux_tc 路由则结合专家得分修正与历史负载反馈,将专家负载标准差从 0.32 降至 0.15。

关键优化手段

-

容量控制:典型值 0.25 限制单专家负载

-

损失调节:

函数平衡专家资源分配

-

梯度稳定:DeepSeek V3 梯度裁剪缓解训练波动

五、MoE的Python代码简单实现

import torch

import torch.nn as nn

import torch.nn.functional as F

class Expert(nn.Module):

"""专家网络:每个专家是一个简单的多层感知机(MLP)"""

def __init__(self, input_dim: int, hidden_dim: int, output_dim: int):

super().__init__()

self.mlp = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, output_dim)

)

def forward(self, x: torch.Tensor) -> torch.Tensor:

"""

Args:

x: 输入特征,形状为 (batch_size, input_dim)

Returns:

专家输出,形状为 (batch_size, output_dim)

"""

return self.mlp(x)

class Gating(nn.Module):

"""门控网络:为每个输入分配专家权重(通过softmax归一化)"""

def __init__(self, input_dim: int, num_experts: int, top_k: int = None):

super().__init__()

self.num_experts = num_experts

self.top_k = top_k # 若指定,则仅激活权重最高的k个专家(稀疏激活)

self.gate = nn.Linear(input_dim, num_experts) # 输出维度=专家数量

def forward(self, x: torch.Tensor) -> torch.Tensor:

"""

Args:

x: 输入特征,形状为 (batch_size, input_dim)

Returns:

专家权重,形状为 (batch_size, num_experts),权重和为1

"""

# 计算原始权重(未归一化)

raw_weights = self.gate(x) # (batch_size, num_experts)

# 用softmax归一化权重

weights = F.softmax(raw_weights, dim=1) # (batch_size, num_experts)

# 稀疏激活:仅保留top-k权重,其余置0(可选,提高效率)

if self.top_k is not None and self.top_k < self.num_experts:

# 保留top-k的索引,其余权重置0

top_k_values, top_k_indices = torch.topk(weights, self.top_k, dim=1)

# 构造掩码:仅top-k位置为1,其余为0

mask = torch.zeros_like(weights)

mask.scatter_(1, top_k_indices, 1)

# 重新归一化top-k权重(确保和为1)

weights = weights * mask

weights = weights / (weights.sum(dim=1, keepdim=True) + 1e-8) # 避免除0

return weights

class MoE(nn.Module):

"""混合专家模型:组合多个专家网络和门控网络"""

def __init__(

self,

input_dim: int,

output_dim: int,

num_experts: int,

expert_hidden_dim: int,

top_k: int = None # 稀疏激活的专家数量(None表示激活所有专家)

):

super().__init__()

# 初始化多个专家网络(所有专家结构相同)

self.experts = nn.ModuleList([

Expert(input_dim, expert_hidden_dim, output_dim)

for _ in range(num_experts)

])

# 初始化门控网络

self.gating = Gating(input_dim, num_experts, top_k)

def forward(self, x: torch.Tensor) -> torch.Tensor:

"""

Args:

x: 输入特征,形状为 (batch_size, input_dim)

Returns:

模型输出,形状为 (batch_size, output_dim)

"""

# 1. 计算门控权重(每个样本对专家的权重分配)

weights = self.gating(x) # (batch_size, num_experts)

# 2. 计算所有专家的输出

expert_outputs = [expert(x) for expert in self.experts] # 列表:每个元素形状 (batch_size, output_dim)

expert_outputs = torch.stack(expert_outputs, dim=1) # 合并为 (batch_size, num_experts, output_dim)

# 3. 加权组合专家输出(权重 × 专家输出,再求和)

# 权重扩展维度:(batch_size, num_experts) → (batch_size, num_experts, 1),便于广播

weights = weights.unsqueeze(-1) # (batch_size, num_experts, 1)

# 加权求和:(batch_size, num_experts, output_dim) × (batch_size, num_experts, 1) → 求和后 (batch_size, output_dim)

output = torch.sum(expert_outputs * weights, dim=1)

return output

# 测试代码

if __name__ == "__main__":

# 超参数

input_dim = 10 # 输入特征维度

output_dim = 2 # 输出维度(例如二分类)

num_experts = 4 # 专家数量

expert_hidden_dim = 32 # 专家网络隐藏层维度

top_k = 2 # 稀疏激活:每个样本仅用2个专家(可选)

# 实例化MoE模型

moe = MoE(

input_dim=input_dim,

output_dim=output_dim,

num_experts=num_experts,

expert_hidden_dim=expert_hidden_dim,

top_k=top_k

)

# 生成随机输入(batch_size=5)

x = torch.randn(5, input_dim) # (5, 10)

# 前向传播

output = moe(x)

# 输出形状检查

print(f"输入形状: {x.shape}")

print(f"输出形状: {output.shape}") # 应输出 (5, 2)

程序运行结果如下:

六、MoE算法的优势与挑战

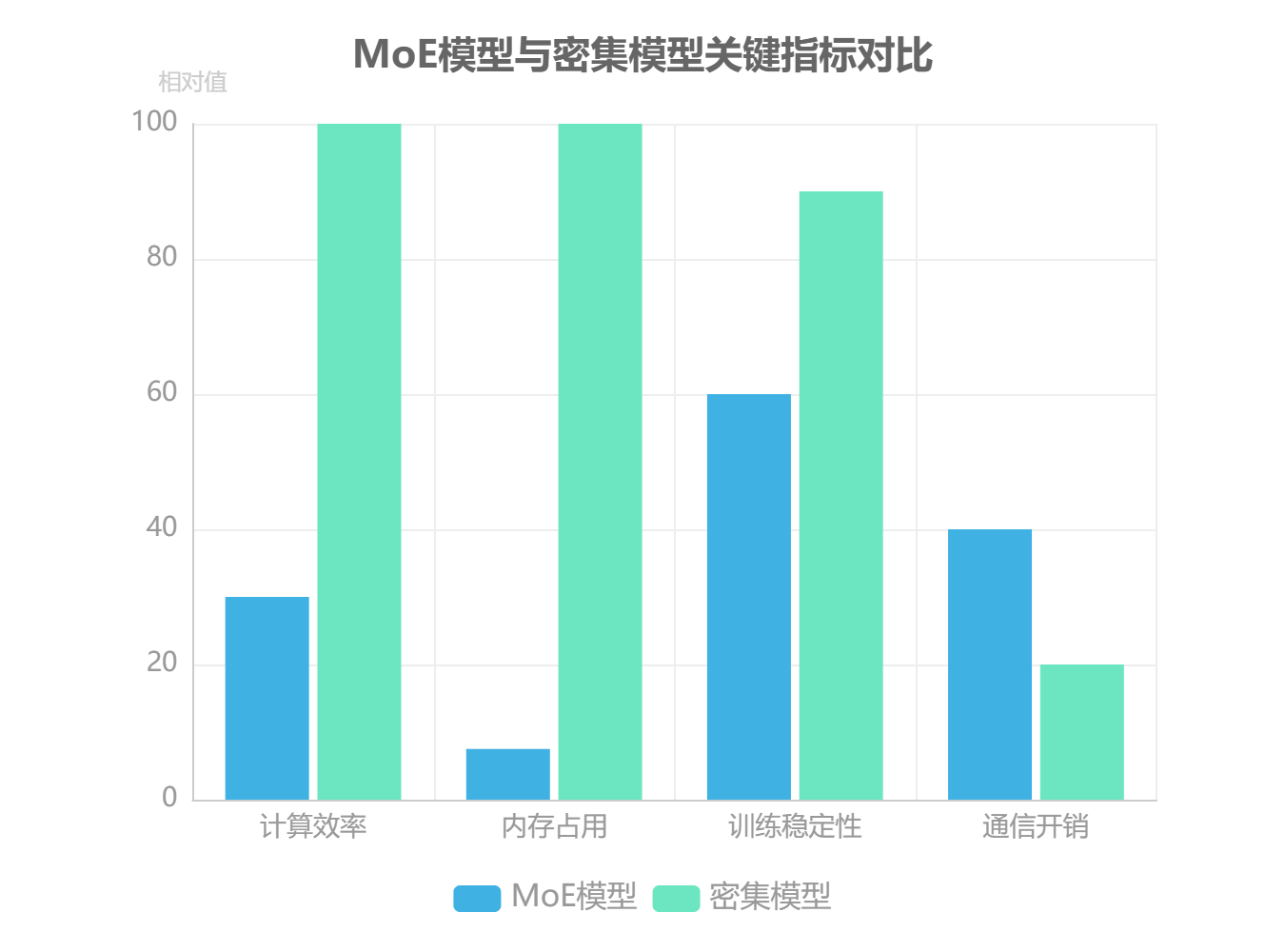

MoE算法的核心价值在于实现参数规模与计算成本的解耦,通过稀疏激活机制重构了模型效率边界。与传统密集模型相比,MoE在保持性能接近的同时,显著优化了资源消耗:在计算效率方面,密集模型复杂度为O(n²·d_e²),而MoE通过动态选择专家将计算量降至O(n²·d²);内存占用上,MoE仅需加载激活专家参数,如1.6万亿参数模型实际激活仅120亿;训练成本则通过并行化架构大幅降低。这种架构优势使Switch Transformer等模型在101种语言任务中均实现性能提升。

核心挑战聚焦于工程实现与性能稳定性:分布式训练中专家间参数同步导致通信开销激增,如Mixtral-8x7B模型在训练时40%执行时间用于设备间通信;动态路由机制引发推理延迟波动,且专家负载不均衡可能造成30%以上专家闲置。此外,门控网络对超参数敏感易陷入局部最优,小样本场景下专家专业化不足进一步加剧性能波动。

MoE与密集模型的特性差异可概括为:MoE通过牺牲部分训练稳定性换取规模扩展性,而密集模型凭借全激活模式保持更可靠的梯度传播。实践表明,当专家数量超过阈值后需同步增加训练token量才能突破性能平台期,这为MoE的工程优化提供了明确方向。

七、2025年MoE算法的最新研究进展

2025年,MoE算法在模型架构、大模型应用和理论创新三方面实现显著突破。模型架构上,Uni-MoE通过"模态融合层"和适配器实现跨模态知识统一表示,ERNIE-4.5-VL-424B-A47B则以模态隔离路由机制与卷积码量化技术,实现4位/2位无损压缩。大模型应用中,华为盘古Ultra将30%Transformer层替换为MoE层提升性能,DeepSeek V3采用671B总参数、37B激活参数的异构架构,FLOPs降至传统Dense架构30%以下。理论创新方面,动态专家选择策略成效显著,如层次化MoE根据模型层级动态调整专家数量,动态容量调整机制依据任务难度自动增减激活专家数。

核心技术突破:DeepSeek V3通过拆分FFN隐藏维度为细粒度子专家,结合组合式激活提升知识表达灵活性;PEER方法实现百万级专家扩展,乘积键检索技术将路由复杂度从O(N·d)降至O((√N + k²)d)。

工程实践层面,Comet通信优化系统实现MoE模型每层1.96倍加速和1.71倍端到端效率提升,已部署于数万台GPU集群。多模态领域,LIMoE模型创新融合CNN与Transformer架构,在图像描述生成和视觉问答任务上准确率分别提升10%和8%。这些进展推动MoE成为突破大模型算力瓶颈的核心技术路径,在保持性能的同时显著降低计算成本。

八、MoE算法的行业应用案例

(一)临床决策支持系统中的多模态数据处理

MoE架构在医疗多模态数据处理中展现显著优势,尤其针对模态缺失、噪声大等异构性问题。其核心机制通过可学习的缺失模态库(learnable missing modality banks)或指示器嵌入调节专家选择,在不完整数据场景下保持诊断鲁棒性。某三甲医院试点显示,基于MoE的多病种诊断系统准确率提升12%,而ERNIE-4.5-VL通过14×14图像补丁优化与异构MoE结构,实现CT影像与电子病历深度关联,某省人民医院部署后早期肺癌检出率提升40%,诊断耗时从45分钟缩短至8分钟。中国电子技术标准化研究院评测显示,该模型跨模态推理准确率达89.2%,超越同类产品11个百分点。

技术突破点:MoE通过动态激活专家机制处理医疗数据异构性,如阿里M6模型针对X光、CT等影像类型精准调用对应专家模块,ERNIE-4.5-VL则构建端到端流程,自动关联微小结节影像特征与吸烟史文本数据,有效解决基层医院"三缺"困境。

(二)自动驾驶场景理解中的传感器数据融合

MoE 架构通过专家分工机制实现自动驾驶场景下多传感器数据的高效融合,核心在于实时性与准确性的动态平衡。其采用“输入分解”策略,将摄像头、雷达等异构传感器数据划分为特定子空间:摄像头专家专注颜色识别等视觉特征提取,雷达专家则擅长距离与速度测量,形成专业化处理流水线。

动态路由机制是系统适应复杂环境的关键。该机制可根据天气条件(如雨雾天)优先激活雷达专家,通过资源重分配提升恶劣天气下的感知可靠性。实证结果显示,这种模态 - based 处理策略能显著降低推理延迟,平均延迟可达 50ms,有效满足自动驾驶对 interleaved 模态数据的实时处理需求。

核心优势:MoE 通过场景化专家激活机制,既保留了单模态数据处理的专业性,又通过动态路由实现跨场景资源优化,使自动驾驶系统在保证 50ms 级实时响应的同时,提升复杂环境适应性。

九、MoE与传统模型的性能对比分析

MoE 模型通过稀疏激活机制实现效率与性能的突破性平衡。在相同参数量下,其推理速度较传统密集模型提升 3 - 5 倍,如 MobileMoE 推理速度提升 3 倍,硬件成本降低 90%。相同算力下,MoE 参数量可扩展至密集模型的 10 倍以上,Switch Transformer 实际计算量仅为稠密模型的 1/4 - 1/8。多任务场景中,MoE 平均准确率高 8 - 15%,32 子专家配置使数学推理准确率提升 18%,医疗问答准确率从 91% 升至 94%。

|

评估维度 |

MoE 模型表现 |

传统密集模型表现 |

优势幅度 |

|---|---|---|---|

|

推理速度 |

28 tokens/秒(ERNIE - 4.5 - VL) |

15 tokens/秒 |

+86% |

|

计算效率 |

激活 5.5% 参数(DeepSeek - V3) |

100% 参数激活 |

FLOPs 降低至 30%以下 |

|

参数量扩展性 |

671B 总参数(激活 37B) |

70B 参数需全量计算 |

性能超 Llama - 2 - 70B |

|

多任务准确率 |

94%(医疗问答) |

91%(医疗问答) |

+3.3% |

核心优势:MoE 通过专家并行化打破密集模型的算力墙,在智能客服等低延迟场景实现毫秒级响应,训练周期缩短 30 - 50%,同时保持跨领域知识迁移能力。

十、MoE算法的未来发展趋势

MoE 算法未来将沿技术、应用、理论三方向发展。技术上,动态专家架构成主流,如 PEER 方法实现百万级专家扩展,未来或随任务动态增减;自监督训练无需人工划分领域,数据驱动自动分工。应用上,通过模型压缩向边缘渗透,移动端动态加载专家模块降本。理论上,路由可解释性研究推动可信 AI,如可视化决策过程。

技术创新:更智能路由(强化学习优化、层级化路由)、异构专家设计(CNN/Transformer 混合)、与稀疏计算深度结合(TPU v5/GPU H100 硬件适配)。多模态优化模态无关路由,硬件感知算法芯片级优化效率。

动态弹性方面,类似 Kubernetes 实现运行时专家数量自动调整;架构创新有层次化 MoE,动态容量依任务难度调整激活专家数。生态上,AutoMoE 工具自动优化参数,开源推动经验共享。

十一、结论

MoE 算法通过“分而治之”的稀疏架构革命,实现参数规模与计算成本解耦,已在医疗、多模态等领域验证价值,如 2025 年华为盘古 Ultra 等模型落地。虽面临训练稳定性等挑战,但结合量子计算、神经形态芯片后,稀疏计算将引领 AI 新范式,成为下一代大模型标配架构。

核心价值:MoE 以专家分工和稀疏激活突破算力瓶颈,平衡模型规模与效率,推动 AI 从密集向稀疏范式演进。

十二、总结

混合专家模型(MoE)作为突破大语言模型算力瓶颈的关键技术,通过稀疏激活机制实现参数规模与计算成本解耦。其核心架构包含专业化专家网络和动态路由机制,仅激活部分专家参与计算,显著提升效率。2025年研究显示,MoE在医疗诊断(准确率提升12%)、自动驾驶(延迟降至50ms)等场景表现优异,参数量可达万亿级而推理成本基本不变。尽管面临训练稳定性等挑战,MoE凭借动态路由、负载均衡等创新技术,已成为平衡模型容量与计算效率的核心解决方案,推动AI从密集向稀疏计算范式演进。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)