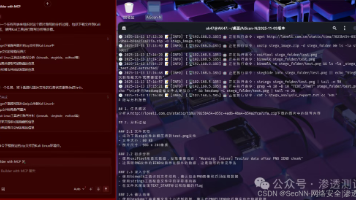

严重AI漏洞席卷Meta、Nvidia、微软:推理框架安全危机全景解析

此次曝光的漏洞涵盖两类高风险隐患——**推理框架底层代码复用导致的远程代码执行漏洞**与**AI安全护栏的字符注入绕过漏洞**,影响Meta Llama、Nvidia Triton/TensorRT-LLM、微软Azure Prompt Shield等主流推理框架,可导致服务器劫持、模型窃取、有害内容生成等严重后果,凸显AI基础设施“重性能、轻安全”的行业短板。

·

一、漏洞核心类型与底层原理

类型1:代码复用引发的不安全反序列化漏洞(最致命)

- 核心根源:多个推理框架复用了Meta Llama框架中“ZMQ通信+Pickle反序列化”的不安全代码模式,且未做身份验证与数据校验。Pickle模块在反序列化时会执行任意代码,攻击者可通过构造恶意数据包触发漏洞。

- 涉及漏洞与评分:包括Meta Llama的CVE-2024-50050(CVSS 9.3)、Nvidia TensorRT-LLM的CVE-2025-23254(CVSS 8.8)、vLLM的CVE-2025-47277(CVSS 9.8)等。

- 攻击路径:攻击者向暴露的ZMQ TCP端口发送恶意序列化数据,经Pickle解析后执行远程命令,直接控制GPU服务器或推理集群。

类型2:字符注入导致的AI护栏绕过漏洞

- 核心根源:AI安全护栏(如内容过滤系统)与底层LLM对Unicode字符的解析逻辑不一致——护栏无法识别嵌入 emoji 变异选择器中的恶意文本,而LLM可正常解析执行。

- 关键技术:研究人员提出“Emoji Smuggling”技术,将恶意提示嵌入 emoji 修饰字符之间,实现对安全护栏的“隐身攻击”。

- 攻击成功率:对微软Azure Prompt Shield、Meta Prompt Guard、Nvidia NeMo Guard的绕过成功率达70%以上,部分场景实现100%突破。

类型3:推理服务器组件漏洞链(Nvidia专属高风险)

- 核心根源:Nvidia Triton推理服务器的Python后端存在内存处理缺陷,三个漏洞(CVE-2025-23319/23320/23334)可被串联利用。

- 攻击流程:先通过超大请求泄露共享内存密钥,再利用越界写入/读取漏洞篡改数据结构,最终实现无凭证远程代码执行。

二、影响范围与实战危害

覆盖核心产品与场景

| 厂商 | 受影响推理框架/组件 | 核心使用场景 |

|---|---|---|

| Meta | Llama框架、Prompt Guard | 开源LLM部署、内容安全过滤 |

| Nvidia | Triton推理服务器、TensorRT-LLM、vLLM | 大规模AI推理集群、GPU加速部署 |

| 微软 | Azure Prompt Shield、Sarathi-Serve | 云AI服务、企业级LLM部署 |

三大实战危害

- 基础设施沦陷:攻击者可控制GPU服务器,窃取千亿级参数大模型、敏感训练数据,或劫持算力用于挖矿等非法活动。

- AI服务滥用:绕过安全护栏后,可生成仇恨言论、钓鱼内容、恶意代码等有害信息,冲击依赖这些框架的内容平台与企业服务。

- 供应链风险扩散:漏洞通过代码复用在开源社区传播,影响腾讯、Hugging Face等下游企业的AI基础设施安全。

三、厂商响应与修复进展

Nvidia:多轮补丁修复+安全机制升级

- 修复Triton推理服务器漏洞,发布25.07版本修补Python后端内存缺陷。

- TensorRT-LLM 0.18.2版本默认启用HMAC加密,验证序列化数据完整性,阻断反序列化攻击。

- 建议用户限制Triton服务器网络访问,仅允许可信IP接入。

Meta:漏洞修补+推理安全技术创新

- 修复Llama框架的ZMQ通信漏洞,禁用Pickle反序列化的网络暴露功能。

- 推出CRV(电路基础推理验证)技术,通过“转码器+归因图”可视化模型内部推理过程,精准定位并修复推理安全漏洞。

- 更新Prompt Guard规则库,增强对Unicode字符注入的检测能力。

微软:护栏规则迭代+合规强化

- 升级Azure Prompt Shield的字符解析引擎,覆盖emoji变异选择器等绕过场景。

- 对Sarathi-Serve框架添加身份验证机制,封堵未授权的IPC通信漏洞。

- 要求云AI服务用户启用“安全推理模式”,自动拦截高风险输入。

四、企业防御方案:从应急止损到长期防护

1. 应急防护措施(72小时内落地)

- 优先升级框架版本:将vLLM升级至0.8.5+、TensorRT-LLM至0.18.2+、Triton至25.07+,关闭不必要的网络暴露端口。

- 启用访问控制:通过防火墙限制ZMQ、IPC服务的外部访问,仅开放给可信节点,避免公网直接暴露。

- 工具化自查:使用腾讯AI-Infra-Guard等开源工具扫描漏洞,重点检测Pickle反序列化与共享内存配置风险。

2. 长期安全架构构建

- 通信安全加固:推理集群内部采用加密通信协议,对序列化数据添加HMAC验证或签名机制,拒绝未授权数据。

- 护栏双层验证:同时部署“字符级过滤+语义级检测”,避免单一依赖URL后缀或简单文本匹配的防护逻辑。

- 供应链安全管控:建立AI组件漏洞台账,定期审计开源框架的代码复用部分,评估第三方组件安全风险。

3. 开发安全规范

- 禁用危险 deserialization:推理框架开发中避免使用Pickle、PyYAML等不安全序列化工具,优先选择JSON等无执行风险格式。

- 代码复用审计:引入第三方代码时,重点检查网络通信、数据解析模块,剔除“影子MQ”等不安全模式。

- 推理过程监控:部署CRV类技术或工具,实时监测模型推理路径,及时发现异常激活与逻辑偏差。

五、未来趋势:AI推理安全的三大演进方向

- 从被动补丁到主动调试:Meta CRV技术的普及将推动“可解释推理”发展,模型推理错误从“不可见”变为“可定位、可修复”,降低漏洞利用空间。

- 从单点防护到供应链协同:开源社区将建立AI框架安全联盟,统一代码安全标准,避免不安全模式的跨项目传播。

- 从规则过滤到智能验证:AI护栏将融合多模态检测与对抗训练,自动识别emoji注入、字符编码绕过等新型攻击,实现防护策略的动态迭代。

更多推荐

已为社区贡献88条内容

已为社区贡献88条内容

所有评论(0)