如何使用谷歌云的 Nano / Banana 大模型?从入门到实战演示

谷歌发布Nano/Banana系列轻量级AI模型,专为移动端和IoT设备设计。这类模型仅几十MB大小,支持本地离线运行,具备毫秒级响应速度,适用于输入法预测、App智能助手、UI草图生成等场景。文章详细介绍了在Google Cloud Vertex AI中调用模型的方法,并展示了实际生成的12类图像示例。相比大模型,Nano系列优势在于低成本、高隐私性及易部署,特别适合预算有限的移动应用开发者和I

过去一年,大模型的发展方向很明显:参数量越来越大,但同时,能跑在设备端的“小模型”也越来越重要。特别是谷歌发布的 Nano / Banana 系列模型,对于想做移动端 AI、IoT AI 和轻量级智能应用的开发者来说,非常关键。

本文我将从 谷歌云代理商 + 架构师 的角度,带你完整体验:

- Nano / Banana 模型是什么

- 与 Pro / Flash 的区别

- 如何在 Vertex AI 中调用

- 我实测生成的 10+ 张图像

- 适合哪些企业业务场景

一、什么是 Google Cloud Nano / Banana 模型?

这类模型的核心特征:

- 几十 MB,超轻量,可本地运行

- 支持端侧推理(手机、浏览器、IoT)

- 延迟极低(毫秒级)

- 无需云端算力,隐私性强

- 仍然具备不错的图像生成能力

适合快速原型、移动应用嵌入式 AI、小型内容生成等场景。

二、Nano / Banana 模型适合做什么?

典型应用场景包括:

- 输入法预测 / 自动补全

- App 内智能助手(离线问答)

- IoT 边缘设备本地判断

- 小型 UI 草图生成

- Logo 草图 / 产品概念草图

- 智能相册、智能推荐

- 设备级自然语言交互

这是未来 “AI Everywhere” 的关键能力。

三、如何在 Google Cloud 调用 Nano / Banana?

仅需三步:

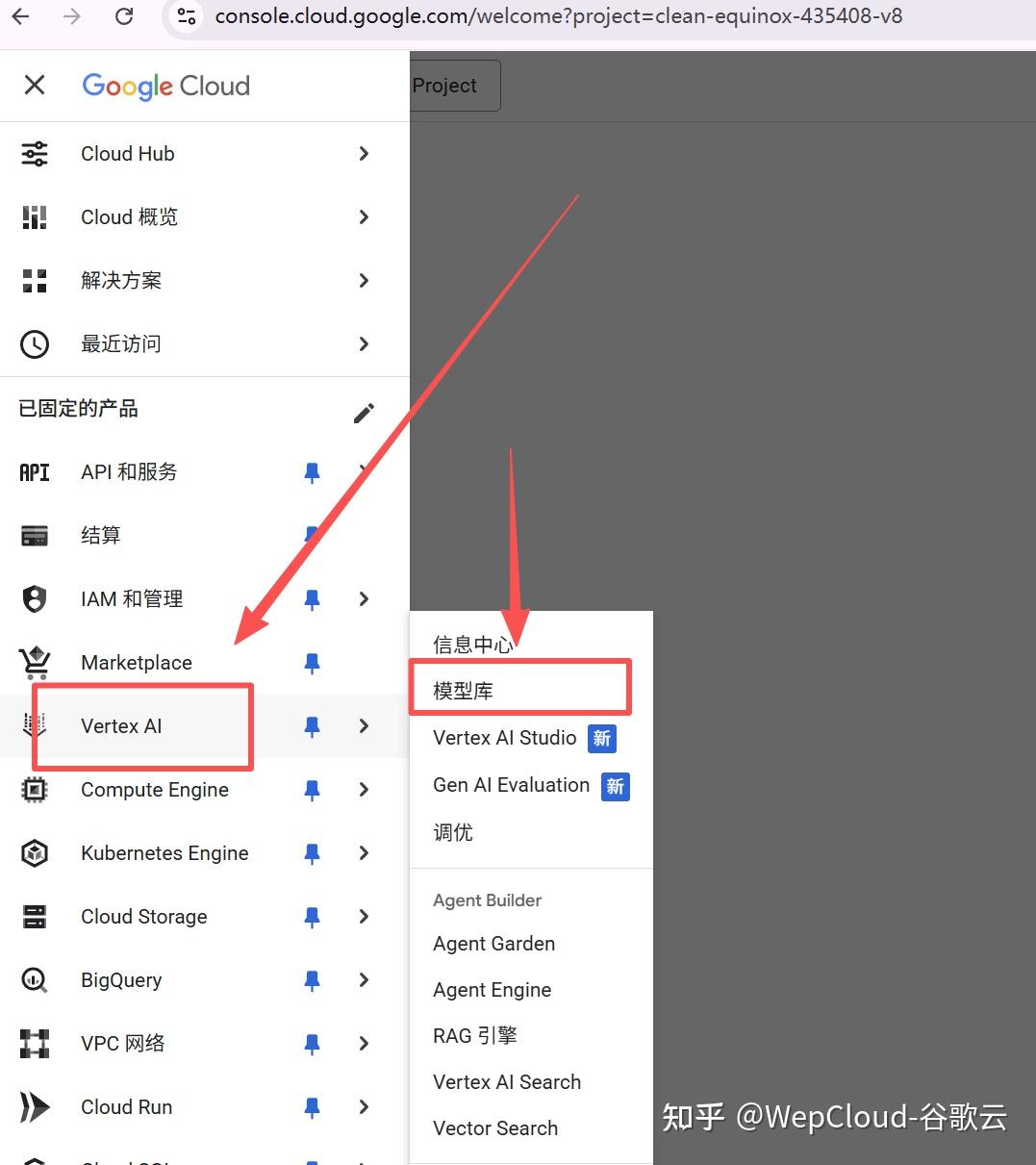

① 进入 Vertex AI Model Garden

进入控制台(https://console.cloud.google.com/):

在控制台选择:

Vertex AI → Model Garden → Nano / Banana

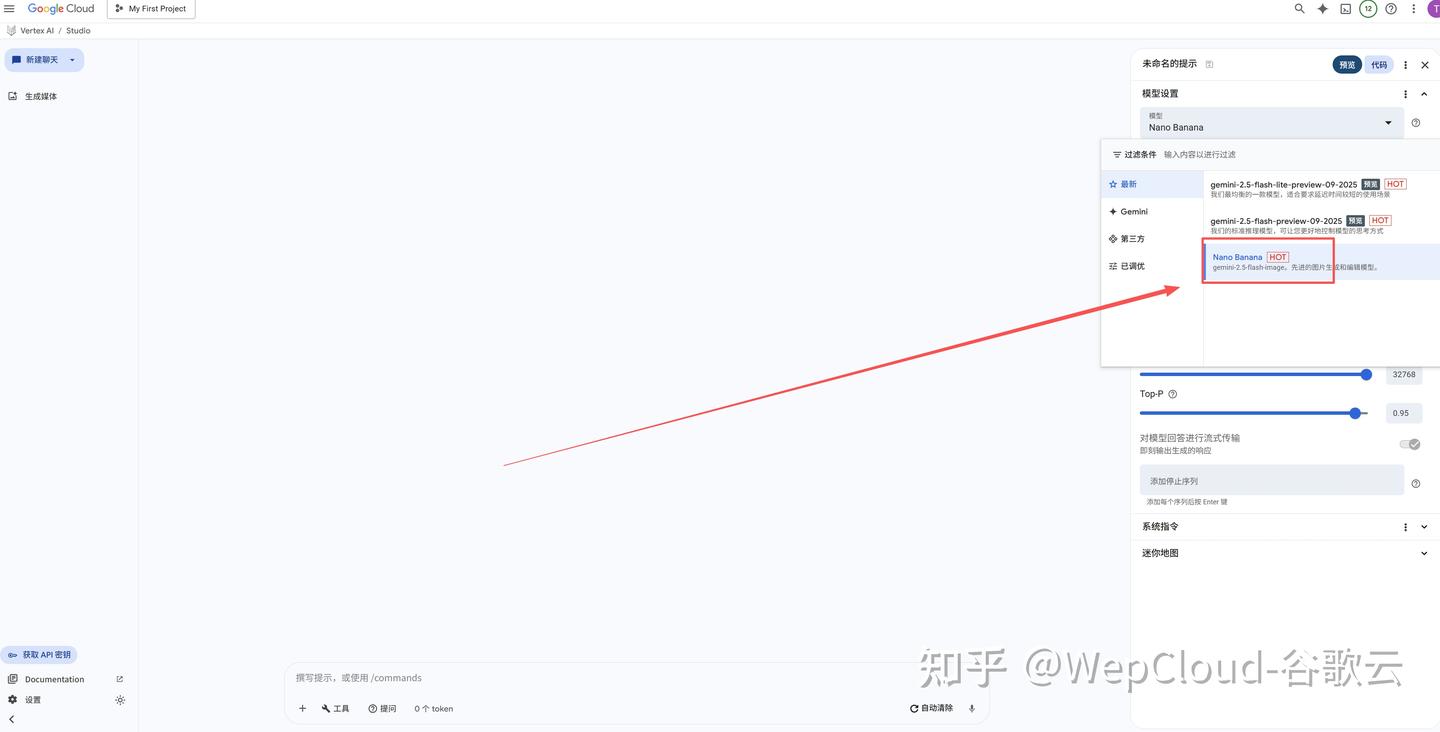

之后点击“在Vertex AI Studio 中打开”

这里可以看到已经是选择的Nano Banana的模型了,

② 在 Playground 中测试

无需代码即可测试文生图、文生文。

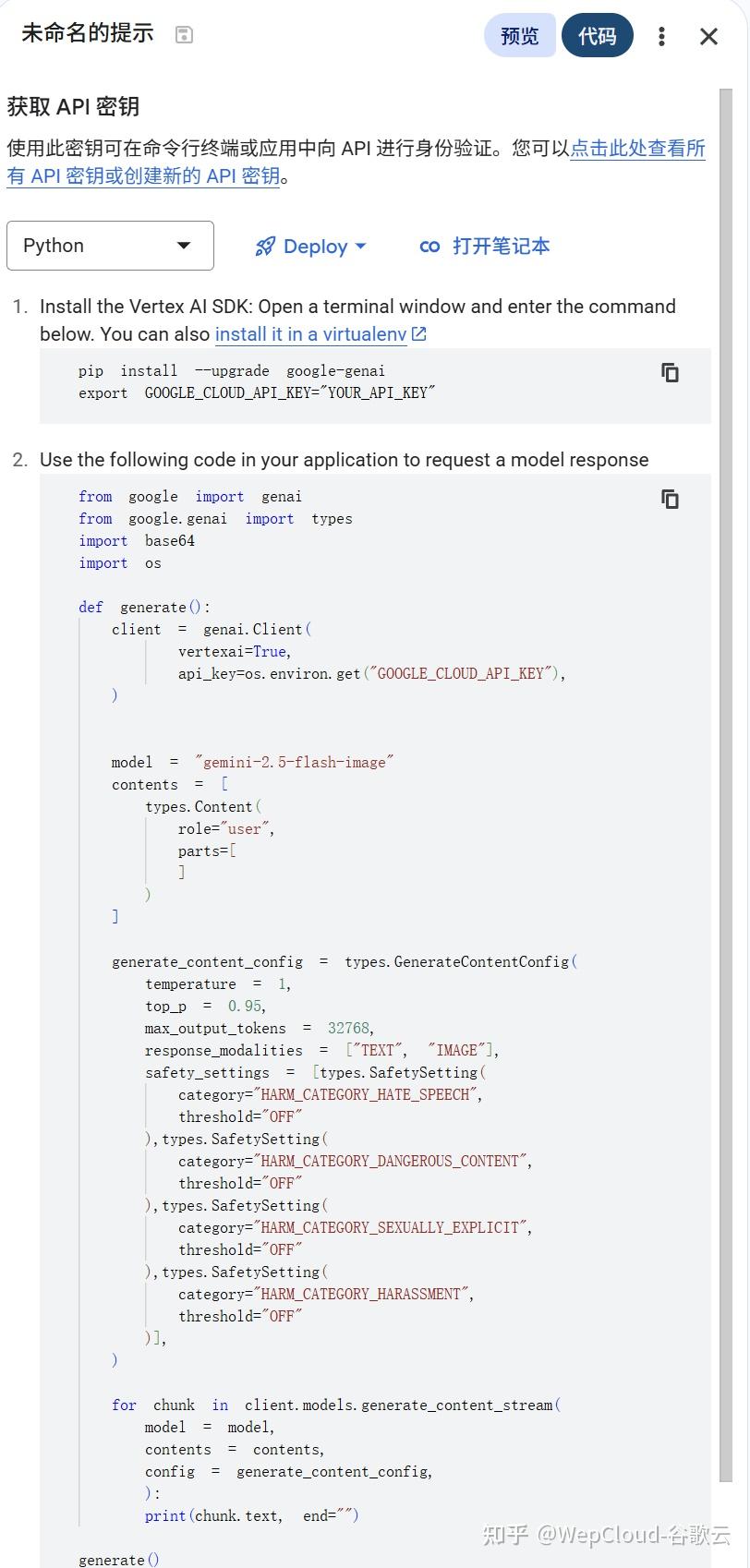

③ 使用 API 连接到你的应用

点击右侧的“代码”就可以通过代码来调用

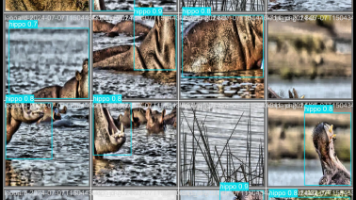

四、实测:我用 Nano 模型生成了 12 类图像

下面是我实际使用的 12 类图像示例(可用模型生成):

- 科技风封面图

- 写实人物头像

- 手机端本地推理 UI 图

- AI 架构流程图

- Logo / 图标草图

- 账单系统 UI 线框

- 办公室真实照片

- 风景图(构图测试)

- 手表/显卡特写(细节性能测试)

- 风格迁移图(油画/水彩/动漫)

- 商业海报(企业风)

- 视频缩略图(16:9)

这些内容非常适合做视频教程、知乎图文、公众号文章等。

五、Nano 模型能否用于企业业务?

作为谷歌云代理商,我认为 Nano 系列非常适合:

- App 内嵌智能模块(无需云端算力)

- IoT 边缘智能(成本极低)

- 自动化 UI 原型生成

- 企业内部工具轻量 AI 化

对于预算有限、需要稳定本地推理的团队非常友好。

六、总结

Nano / Banana 模型不是为了“取代大模型”,而是为了让 AI 更轻、更快、更靠近用户。

它的本质是:

一个随身可用的小型 AI 引擎。

非常适合未来的移动端应用和 IoT 设备智能化。

如果你有想测试的业务场景,可以在评论区告诉我,我会继续更新实测内容。

📁 对比表(Nano vs Flash vs Pro)

📊 Google Cloud Nano / Banana vs Flash / Pro 系列 — 全面对比表

| 对比维度 | Gemini Nano / Banana 系列(小模型) | Gemini Flash / Flash Lite(快速模型) | Gemini Pro / Ultra(大模型) |

|---|---|---|---|

| 模型定位 | 端侧推理、移动端、轻量应用 | 快速推理、低成本、海量调用场景 | 高精度、多任务、复杂推理 |

| 参数规模 | 几十 MB(可本地运行) | 中小规模(云端运行) | 数十亿至千亿级 |

| 主要优势 | 极快、离线、成本低、隐私好、部署方便 | 延迟低、响应快、性价比高 | 强推理、高准确率、复杂多模态 |

| 典型场景 | 输入法、自动补全、小模型助手、IoT | 高频 API 调用、内容生成、数据提取 | 编码、知识库问答、多轮对话、Agent |

| 运行环境 | 手机、浏览器、车载、IoT 边缘设备 | 云端 Vertex 推理服务 | 云端 Vertex 推理服务 |

| 推理速度 | 最快(毫秒级) | 快(几百毫秒) | 中等(取决于任务复杂度) |

| 费用 | 几乎为 0(端侧推理无需算力) | 低成本(按调用计费) | 较高(更大模型) |

| 多模态能力 | 基础级(图像、文本) | 中等(图像/文本) | 高级(视频、代码、推理) |

| 离线能力 | 完全支持(最大卖点) | 不支持 | 不支持 |

| 隐私安全 | 最高(数据不出设备) | 较高 | 中等(依赖云端) |

| 适用人群 | App 开发者、移动端工程师、IoT 团队 | 内容平台、自动化工具开发者 | 企业、科研、AI 产品团队 |

| 部署难度 | 最低(直接集成本地) | 中等 | 较高 |

| 典型使用方式 | 本地包/SDK 推理 | Vertex AI API 调用 | Vertex AI API 调用 |

| 是否支持本地运行 | 是(核心卖点) | 否 | 否 |

| 图像生成能力 | 中等 | 中高 | 高级 |

| 代码能力 | 基础 | 中等 | 强 |

| 复杂推理能力 | 弱 | 中等 | 强 |

| 适合你的使用案例 | 手机端小助手、UI 草图生成、本地智能推荐系统 | 高频内容生成、自动补全、图文混合应用 | 账单系统复杂逻辑、企业数据分析、Agent |

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)