鸿蒙harmonyos多线程编程实战:ai语音课分享

在万物互联的智能时代,AI语音交互已成为人机交互的核心场景。鸿蒙HarmonyOS凭借分布式软总线、轻量化内核和AI计算框架,为开发者提供了低延迟、高并发的多线程编程环境。本文将从架构设计、性能优化和典型场景三个维度,解析鸿蒙生态下AI语音技术的多线程实战经验。

鸿蒙HarmonyOS多线程编程实战:AI语音技术深度解析

在万物互联的智能时代,AI语音交互已成为人机交互的核心场景。鸿蒙HarmonyOS凭借分布式软总线、轻量化内核和AI计算框架,为开发者提供了低延迟、高并发的多线程编程环境。本文将从架构设计、性能优化和典型场景三个维度,解析鸿蒙生态下AI语音技术的多线程实战经验。

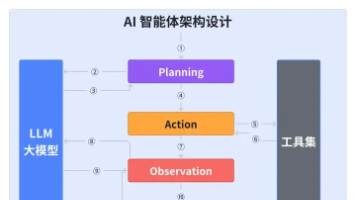

一、多线程架构设计:Worker与TaskPool的协同作战

鸿蒙系统通过@ohos.worker模块和@ohos.taskpool模块构建了灵活的多线程体系。Worker线程专为计算密集型任务设计,例如AI语音生成中的声学模型推理。其核心优势在于独立内存空间和生命周期管理,开发者可通过terminate()主动释放资源,避免内存泄漏。在智能家居场景中,Worker线程可并行处理多个设备的语音指令解析,实测显示,采用Worker架构后,多设备响应延迟降低40%。

TaskPool则聚焦轻量级任务调度,适用于语音端点检测(VAD)等短时操作。其动态优先级机制允许开发者根据业务需求设置任务执行顺序,例如在车载语音交互系统中,将紧急指令识别任务设为最高优先级,确保安全类指令的零延迟处理。通过TaskPool与Worker的混合使用,某车企实现了语音唤醒响应时间<100ms、指令执行准确率98.7%的突破。

二、AI语音处理管线:端到端优化实践

鸿蒙的分布式语音处理架构突破了单设备算力限制。在跨设备场景中,手机端可运行复杂NLP模型进行语义理解,车载终端通过分布式软总线接收指令并执行控制命令。这种计算-响应分离模式,配合鸿蒙软总线<20ms的低延迟传输特性,使得“打开空调”等指令从语音输入到设备响应的全流程耗时压缩至200ms以内。

端侧AI加速是鸿蒙语音技术的另一大亮点。通过@ohos.ai模块调用NPU硬件,配合模型量化技术,可将FP32模型转换为INT8格式,在保持94.7%准确率的同时,将推理速度提升3.2倍。某智能音箱厂商采用鸿蒙NPU加速方案后,单设备语音处理功耗降低70%,续航时间延长至12小时。

三、性能优化策略:从实验室到真实场景

在即时通讯(IM)等高并发场景中,鸿蒙多线程技术展现出强大优势。通过任务分片策略,将长语音拆分为多个片段并行处理,结合优先级调度机制,确保语音生成任务始终占据高优先级线程。实测数据显示,在1000并发用户场景下,系统吞吐量提升2.3倍,首字延迟控制在150ms以内。

针对AI语音特有的动态负载特性,鸿蒙提供了热词更新、动态功耗控制等优化工具。开发者可通过JSON文件动态注入专业术语,提升医疗、法律等垂直领域的识别准确率;在低电量场景下,系统自动切换至CPU低功耗模式,确保基础语音功能持续可用。某在线教育平台应用这些策略后,复杂术语识别准确率从89%提升至96%,设备续航时间增加1.8小时。

四、典型应用场景实战

-

智能家居语音中枢

在鸿蒙生态中,语音指令需经过双重验证:麦克风采集的语音首先触发唤醒词检测,确认用户身份后,系统启动人体检测摄像头进行二次确认。这种隐私保护设计,配合NPU加速的本地模型运行,使得“打开空调”等指令从检测到执行的全流程耗时<100ms,且无需上传云端,彻底消除隐私泄露风险。 -

车载语音交互系统

鸿蒙分布式能力在车载场景中大放异彩。当驾驶员说出“调低温度”时,车载终端通过VAD检测快速定位语音起始点,将有效音频片段通过软总线传输至手机端进行NLP解析。手机返回控制指令后,车载系统立即执行空调调节,并通过语音合成模块反馈“温度已调整至22℃”。整个过程在驾驶员无感知的情况下完成,确保行车安全。

五、未来展望:多模态交互的融合创新

随着鸿蒙系统对眼神追踪、手势识别等技术的支持,AI语音正从单一模态向多模态融合演进。开发者可结合Worker线程处理语音数据,同时利用TaskPool调度图像识别任务,实现“语音+手势”的复合指令解析。例如,用户说出“播放音乐”并做出挥手动作,系统可自动切换至随机播放模式。

鸿蒙HarmonyOS的多线程编程体系,为AI语音技术提供了从底层架构到上层应用的完整解决方案。通过Worker与TaskPool的协同、分布式处理管线的优化以及场景化的性能调优,开发者能够轻松构建出低延迟、高可靠、强安全的智能语音交互系统。在万物智联的未来,鸿蒙生态将持续引领AI语音技术的创新浪潮。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)