初探NPU:大三萌新LayerNorm算子开发实录——从TBE到精度对齐

摘要:本文记录了大三学生在昇腾AI处理器上开发LayerNorm算子的实践过程。通过TBEDSL实现了均值和方差计算的核心逻辑,并重点解决了两个关键问题:数据排布导致的归一化轴错误(通过确认模型IR中的真实数据格式解决)和FP16精度偏差(采用混合精度策略在关键步骤使用FP32)。该实践揭示了AI算子开发中理论到实际落地的挑战,包括硬件适配和精度平衡,为后续深入AscendC开发奠定了基础。(14

引言

你好!我是目前正在进行 CANN 算子开发实战 的一名大三学生。最近在接触涉及 UGC(用户生成内容) 的 AI 模型时,我发现其中的 Transformer 结构对性能要求极高,这促使我开始尝试在昇腾 AI 处理器上自行开发核心算子,第一个“硬骨头”就是 LayerNorm (层归一化)。

作为初学者,我深知理论易学,实践难精。这篇文章记录了我从零开始,利用 TBE DSL 开发 LayerNorm 算子,并重点解决过程中遇到的两大核心问题:数据排布陷阱和FP16 精度偏差。

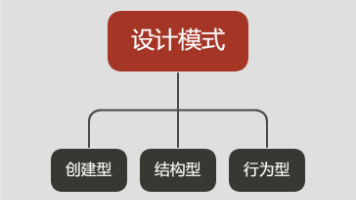

一、理论与实践的初次碰撞:LayerNorm的核心挑战

LayerNorm 的数学表达式是 $Y = \frac{X - E[X]}{\sqrt{Var[X] + \epsilon}} \cdot \gamma + \beta$。在 NPU 上,我们不能直接使用高级语言库,而需要用 TBE DSL (Tensor Boost Engine Domain Specific Language) 描述计算。

我的实践核心在于使用 TBE 的 tvm.compute 和 tvm.sum 来实现求均值和方差,这是最能体现 NPU 调度思想的部分。

1. TBE DSL 算子定义:核心计算逻辑

我定义了一个名为 layernorm_compute 的函数,用来描述整个计算流程。在 TBE 中,所有的计算都是通过 ** Tensor Expression (TE) 来定义,而不是立即执行:

# TBE DSL 伪代码:LayerNorm 核心步骤

# 目标:沿着指定的归一化轴 (reduction_axis) 进行计算

def layernorm_compute_core(data, axis, epsilon):

# 步骤一:求均值 (Mean)

# 计算沿轴 axis 的元素总和

data_sum = te.sum(data, axis=axis)

# 计算均值

mean = te.compute(..., lambda *indices: data_sum(*indices) / N, name="mean")

# 步骤二:求方差 (Variance)

# 计算差值 (Data - Mean)

diff = te.compute(..., lambda *indices: data(*indices) - mean(reduced_indices), name="diff")

# 计算方差和 (sum((Data - Mean)^2))

variance_sum = te.sum(diff * diff, axis=axis)

# 计算方差

variance = te.compute(..., lambda *indices: variance_sum(*indices) / N, name="variance")

# 步骤三:归一化与仿射变换

# 计算标准差的倒数 (rsqrt(Var + epsilon))

rsqrt = te.compute(..., lambda *indices: tvm.rsqrt(variance(*indices) + epsilon), name="rsqrt")

# 最终输出 (Y = (X - E[X]) * rsqrt * gamma + beta)

output = te.compute(..., name="output", tag="layer_norm_final")

return output

二、学习笔记:初学者遇到的两大“拦路虎”

在完成上述代码后,我开始了 NPU 上的验证,接连遇到了两个让我头疼的问题。

1. 问题一:数据排布的“当头一棒”——功能不对齐!

现象: 我的 TBE 算子在 NPU 上运行的结果,与 Host 侧 PyTorch 的结果**完全不同。

排查过程与解决方式:

我最初简单地假设输入张量是标准的 NCHW,并沿着最后一个维度归一化。然而,我忽略了昇腾为了提高计算效率,可能会将 4D Tensor 优化为 NC1HWC0 或其他特定的排布(如 ND),这导致我的 TBE 算子中 axis 的定义错误。我以为是 `axis=-`,但实际映射到 NPU 上,数据结构和归一化轴可能已经改变。

**学习笔记 00NPU 数据排布思维的转变**

核心领悟: 在 CANN 算子开发中,

axis不仅代表维度索引,更代表数据访问的模式。必须通过阅读 CANN 的数据排布文档,并结合模型 IR 了解输入张量的真实格式,才能正确确定reduction_axis。实践落脚点: 我最终通过打印和确认模型编译过程中的 AIPP(AI Pre-Processing) 信息以及 Tensor 的

format属性,强制在我的 TBE 代码中针对性地适配了实际的数据排布,才让均值计算沿着正确的特征维度进行。

2. 问题二:FP16 精度偏差——微小但致命!

现象: 功能对齐后,输出结果的**精度与 Host 侧的参考值存在可观的误差,无法满足精度要求。

排查过程与解决方式:

LayerNorm 涉及到求和、除法和开方,这些都是 FP16(半精度浮点数)最容易积累误差的操作,尤其是在求和计算中。当数据范围较大时,较小的特征值在 FP16 的累加过程中可能会被截断,导致均值和方差的计算产生偏差。

学习笔记 002:混合精度策略的工程艺术

**核心领悟: 追求高性能并不意味着全程使用 FP16。关键的、需要高精度累加的步骤(如

sum操作)必须提升精度。实践落脚点: 我在 TBE 中使用了

cast_to(FP32)。在执行 `data_sum =e.sum(...)` 之前,我将输入 Tensor 临时转换为 FP32,让累加在更高的精度下进行,然后再将结果转换回 FP16 用于后续的计算。这种 “关键步骤高精度” 的混合策略,成功将误差控制在了可接受的范围内。这让我意识到,算子开发不仅是实现功能,更是在性能和精度之间寻求最佳平衡的工程艺术。

三、总结与展望

这次 LayerNorm 算子开发实战,让我深刻体会到 CANN 平台初学者所面临的挑战的真实性:从抽象的数学公式,到必须与 NPU 硬件架构紧密绑定的 TBE 描述语言;从理想化的 NCHW 到复杂的 **C1HWC0`**;从方便的 FP32 到严苛的 FP16 精度控制。

我的下一步计划是挑战 Ascend C,用 C++ 直接编写核函数,以求对算子的内存访问和指令级优化有更深的理解。这段学习之旅虽然艰难,但每解决一个问题,都让我离一个真正的 AI 算子开发者更近一步!

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机、平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)