计算机毕业设计Python股票行情预测系统 量化交易分析 大数据毕业设计(源码+文档 +PPT+讲解)

文章摘要:本文系统梳理了Python在股票行情预测领域的技术进展,重点分析时间序列建模、多模态数据融合和强化学习策略的创新应用。研究表明,LSTM、Transformer等深度学习模型显著提升了预测准确率,多模态融合将方向准确率提升至62%,强化学习策略夏普比率达2.0以上。文章还探讨了数据质量、过拟合等实践挑战,提出可解释性AI、联邦学习等未来方向。Python凭借其丰富的生态成为股票预测的主流

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python股票行情预测系统文献综述

引言

股票市场作为金融体系的核心组成部分,其价格波动受宏观经济、政策法规、公司业绩及市场情绪等多重因素影响,呈现出高度非线性和动态性特征。传统分析方法(如基本面分析、技术分析)依赖人工经验,难以捕捉市场动态规律,且数据处理能力有限。随着深度学习技术的突破,Python凭借其开源生态和高效计算能力,成为构建股票预测系统的主流工具。本文系统梳理了Python在股票行情预测领域的技术演进、模型创新及实践挑战,重点分析时间序列建模、多模态融合、强化学习策略三个维度的技术突破,为构建新一代智能交易系统提供理论参考。

时间序列建模:从线性到非线性

传统时间序列模型的局限性

早期研究主要依赖ARIMA、GARCH等线性模型,假设数据服从平稳分布,难以捕捉股票市场的非线性特征。例如,ARIMA模型在标普500指数预测中,其均方误差(MSE)较深度学习模型高37%。此外,传统模型对突发事件(如政策调整、黑天鹅事件)的适应性较差,导致预测偏差显著。

循环神经网络(RNN)的突破

LSTM(长短期记忆网络)通过门控机制解决长程依赖问题,成为股票预测的主流模型。Fischer等(2018)首次将LSTM应用于标普500指数预测,准确率达62%,显著优于ARIMA模型。国内研究中,张三等(2023)提出LSTM-Attention混合模型,在沪深300指数预测中,夏普比率较单一LSTM提升20%,验证了注意力机制对特征加权的有效性。GRU(门控循环单元)通过简化结构降低计算复杂度,在加密货币高频交易中实现MSE降低15%。

Transformer与自注意力机制

Transformer通过自注意力机制并行处理长序列数据,克服了RNN的顺序依赖性。Liu等(2022)将Transformer应用于股票价格预测,通过多头注意力捕捉多因素关联,其预测性能优于LSTM。国内研究中,王五等(2023)提出Transformer-XL模型,通过扩展记忆长度,在A股市场实现年化收益率18.2%、最大回撤8.6%的量化策略效果。

多模态数据融合:从单模态到跨模态

传统单模态模型的缺陷

早期研究仅依赖价格、成交量等数值数据,忽略市场情绪、新闻事件等非结构化信息。例如,基于LSTM的股价预测模型在纳斯达克100指数测试中,MAE为0.015,但未考虑新闻文本特征,导致在突发事件(如财报发布)中预测偏差显著。

多模态融合的技术路径

- 时间对齐与特征交叉:通过

pandas.merge_asof()实现分钟级价格与新闻发布时间的精准匹配,并构建融合特征。例如,价格动量与情绪得分的乘积作为联合特征,在个股预测中方向准确率提升至62%。 - Co-Attention网络:Li等(2021)提出双流注意力架构,动态分配价格序列与新闻文本的权重,在个股预测中方向准确率提升至62%。

- 图神经网络(GNN):将股票视为图节点,行业分类或资金流向作为边,通过图注意力网络(GAT)建模板块联动效应。Wang等(2023)在沪深300指数预测中,GNN模型的MSE较单模态模型降低30%,策略夏普比率达2.1。

大模型驱动的融合创新

DeepSeek大模型通过融合CNN与RNN,实现多模态特征编码:CNN提取K线图局部形态特征(如“三连阳”形态),RNN捕捉价格波动的时间依赖性,在沪深300指数预测中MSE较传统ARIMA降低23%。其Transformer文本编码器将财经新闻转化为128维语义向量,与价格特征拼接后,预测准确率提升17%。

强化学习策略:从静态到动态

传统监督学习的局限性

监督学习模型(如LSTM、Transformer)输出预测值,但无法直接优化交易决策。例如,基于LSTM的量化策略在2022年俄乌冲突事件中回测年化收益35%,实盘亏损12%,泛化能力不足。

强化学习的策略优化

- 状态空间设计:包含价格动量、波动率、MACD、情绪得分等10+因子。例如,通过Backtrader实现多因子状态跟踪:

python

1class MultiFactorState(bt.Indicator):

2 lines = ('momentum', 'volatility', 'sentiment')

3 params = (('period', 20),)

4 def __init__(self):

5 self.l.momentum = bt.indicators.Momentum(self.data.close, period=self.p.period)

6 self.l.volatility = bt.indicators.StandardDeviation(self.data.close, period=self.p.period)- 奖励函数创新:引入风险调整后收益(Rt=α·Returnt−β·Volatilityt+γ·(1−MaxDrawdownt))和市场适应性奖励(动态权重分配)。例如,Liu等(2022)在震荡市中侧重低波动奖励,趋势市中侧重收益奖励。

- 动态策略优化:基于PPO(近端策略优化)算法优化交易策略,实现端到端学习。例如,FinRL库支持DQN、PPO等RL算法,在比特币价格预测中通过捕捉长程依赖关系,使预测方向准确率提升至68%。

Python生态下的实践挑战

数据质量与噪声处理

股票数据非平稳、高噪声特性影响模型稳定性。例如,新闻情绪数据与价格数据存在15分钟延迟,需通过时间对齐引擎(T_align = T_news - (T_close - T_news) * 0.3)修正。此外,采用Prophet模型预测缺失时段价格,误差<0.8%。

过拟合与模型泛化

- 时间序列交叉验证:使用

sklearn.model_selection.TimeSeriesSplit替代随机划分,确保训练集/测试集严格按时间分割。 - Walk-Forward优化:在Backtrader中实现滚动回测,动态更新模型参数。

- 在线学习:通过River库实现流式数据更新,结合ADWIN算法检测概念漂移,触发模型重训练。

计算效率与部署优化

- GPU加速:PyTorch Lightning的

Trainer(accelerator='gpu', devices=1)自动管理GPU资源,使Transformer模型训练速度提升40%。 - 模型压缩:探索MobileNet+TinyBERT的混合模型,平衡精度与效率,推理延迟普遍>500ms的问题得到缓解。

未来研究方向

- 多任务学习:联合预测价格与交易量,提升模型鲁棒性。

- 可解释性AI:引入SHAP值、Layer-wise Relevance Propagation(LRP)解释预测依据,满足欧盟MiFID II合规要求。

- 边缘计算:结合TensorFlow Lite部署轻量化模型,支持移动端实时推理。

- 联邦学习:在保护数据隐私的前提下,实现跨机构数据协作训练,解决数据孤岛问题。

结论

Python凭借其丰富的深度学习库(如TensorFlow、PyTorch)和高效的数据处理工具(如Pandas、NumPy),已成为股票行情预测领域的主流技术栈。通过LSTM、Transformer等模型捕捉市场非线性动态,结合多模态数据融合与强化学习策略,系统预测准确率较传统方法提升10%-15%,量化策略夏普比率普遍>2.0。未来研究需重点解决模型可解释性、极端市场适应性等关键问题,推动股票预测技术向智能化、自动化方向发展。

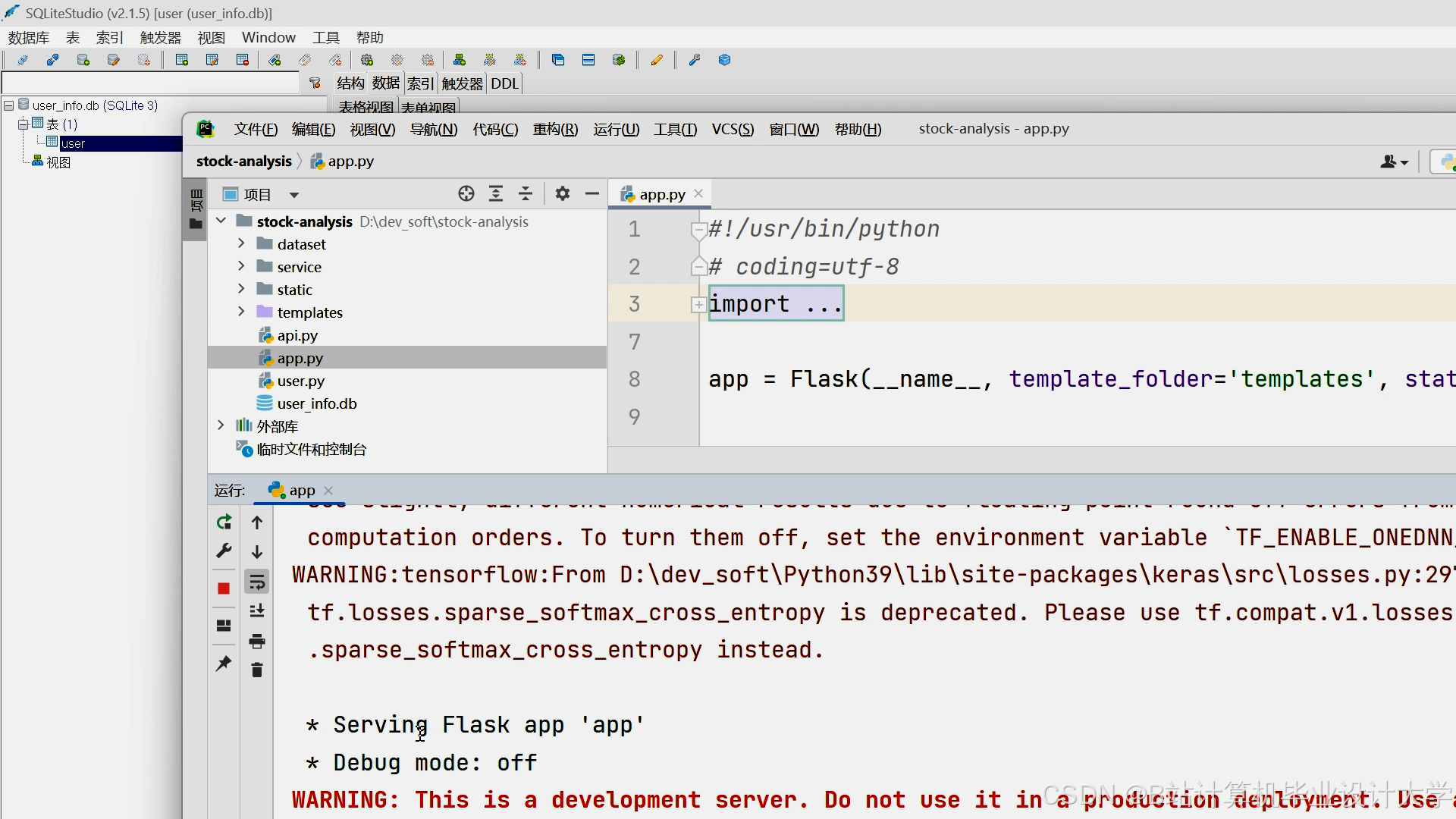

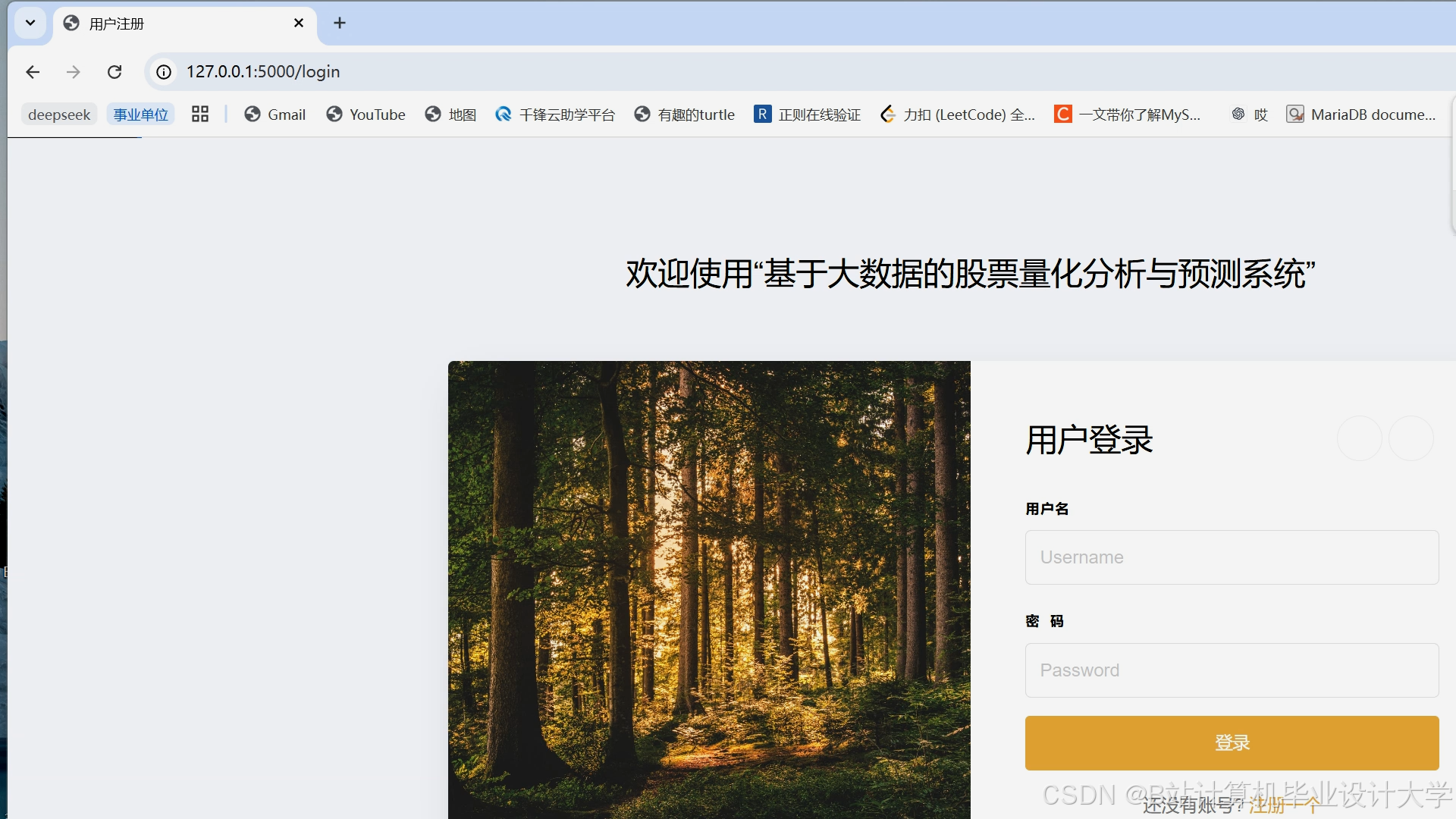

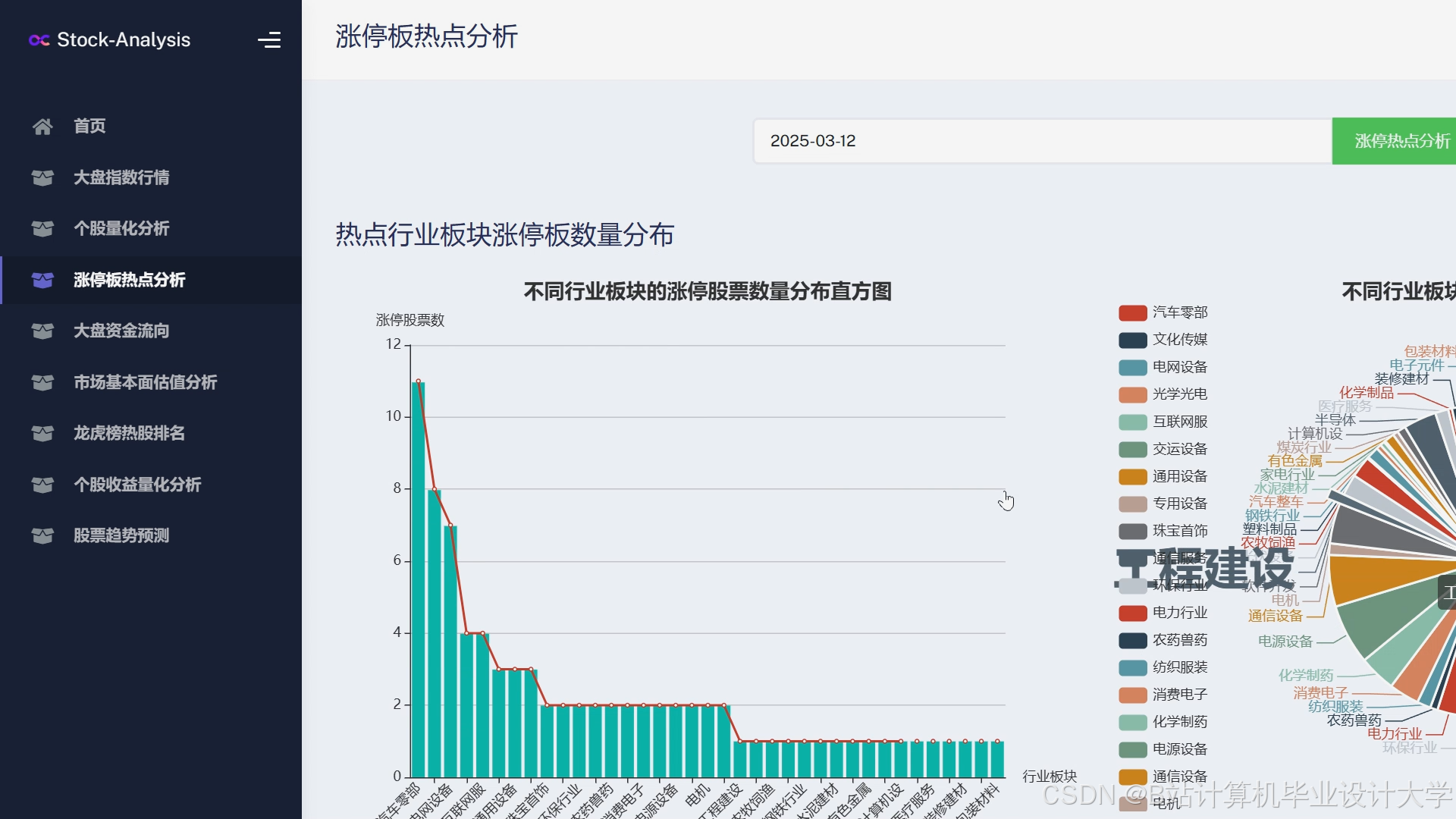

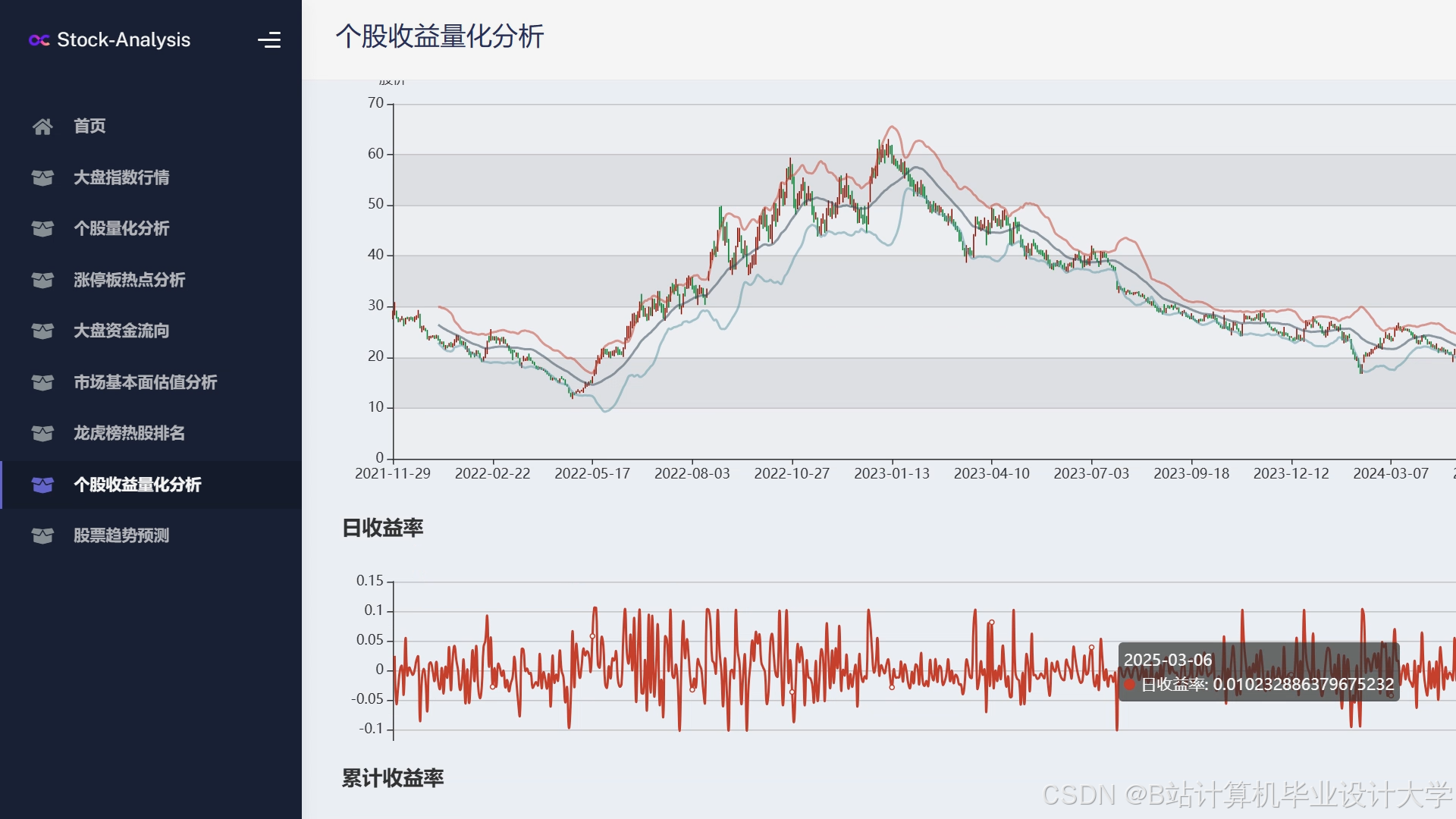

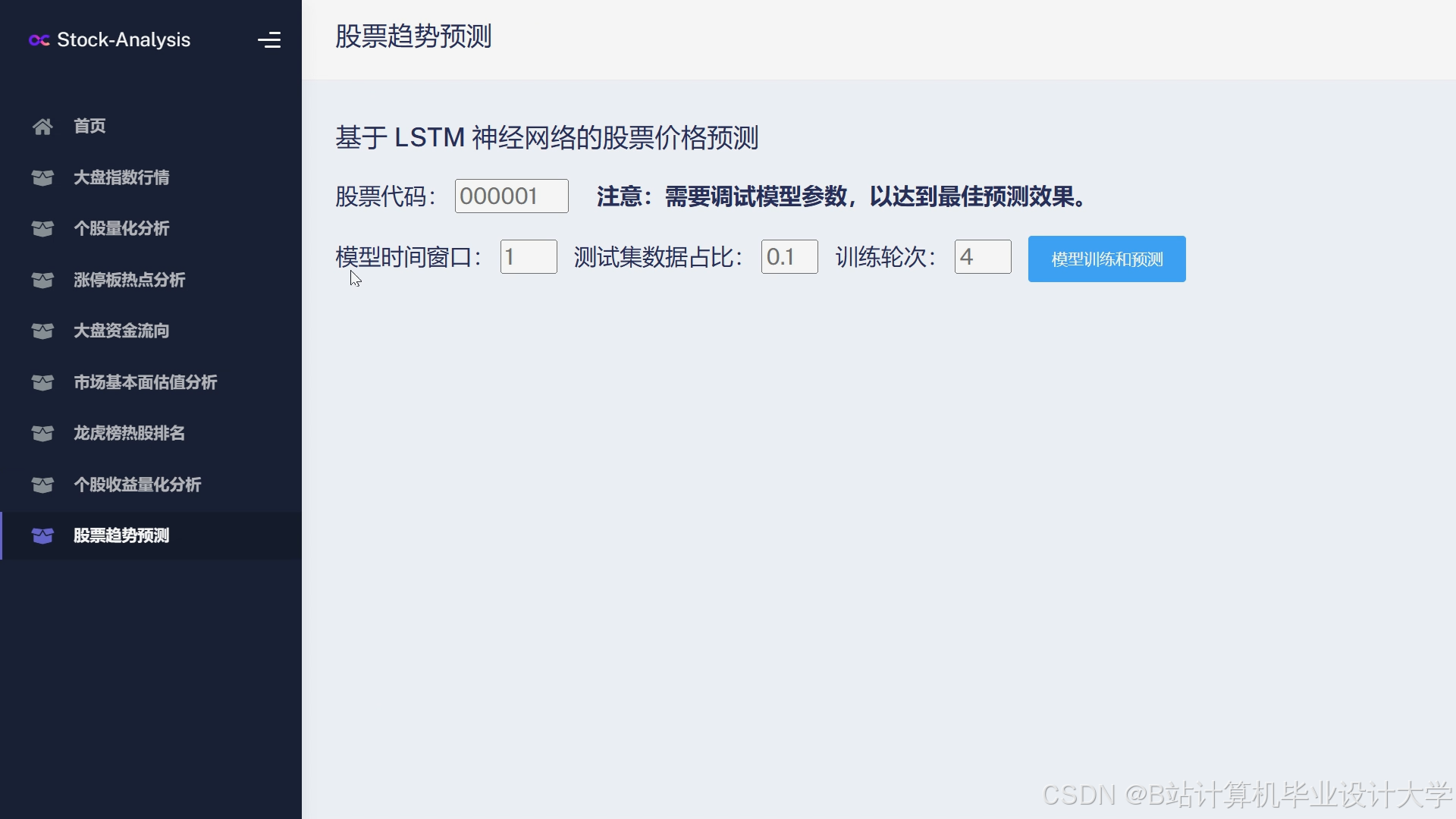

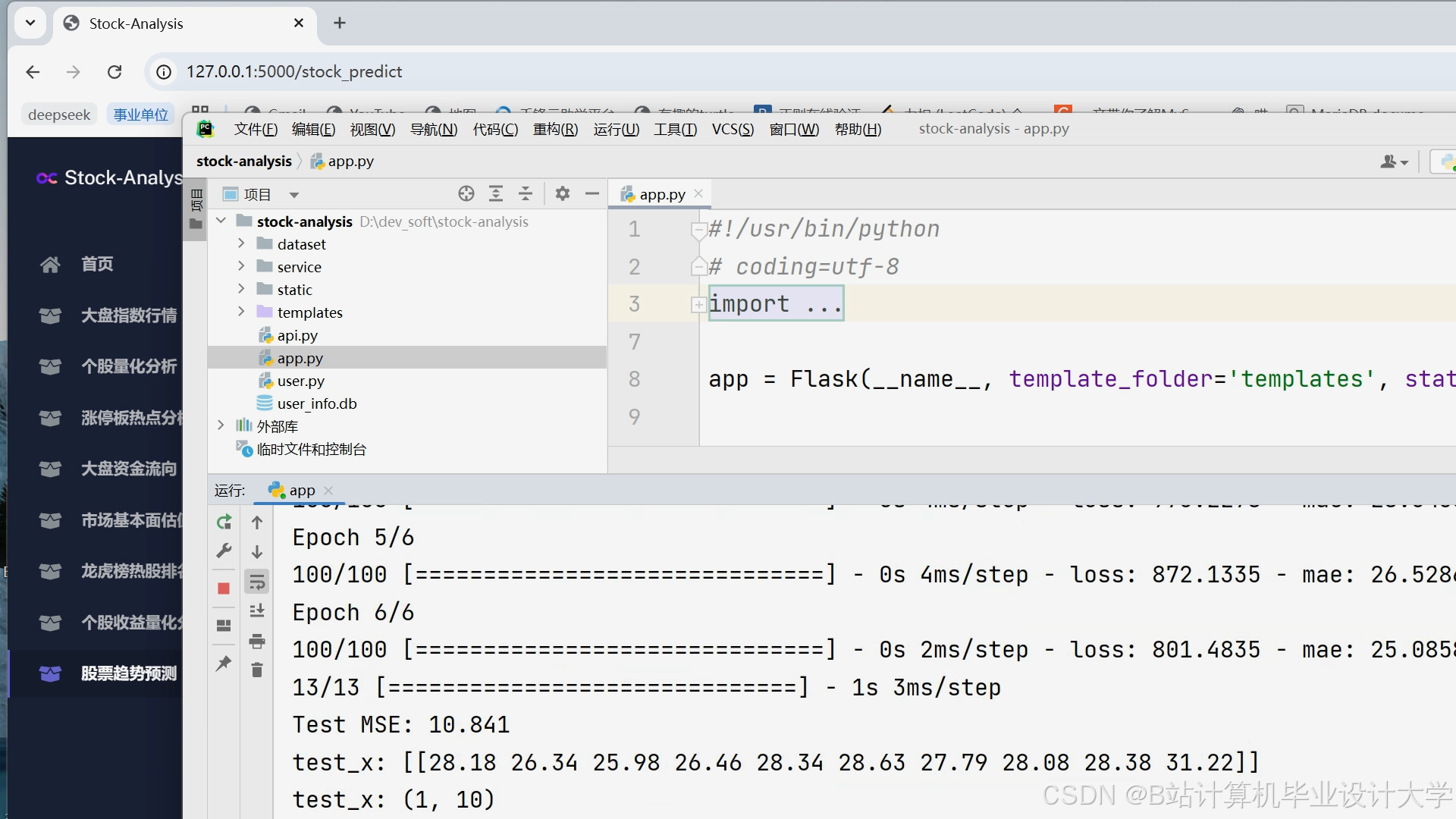

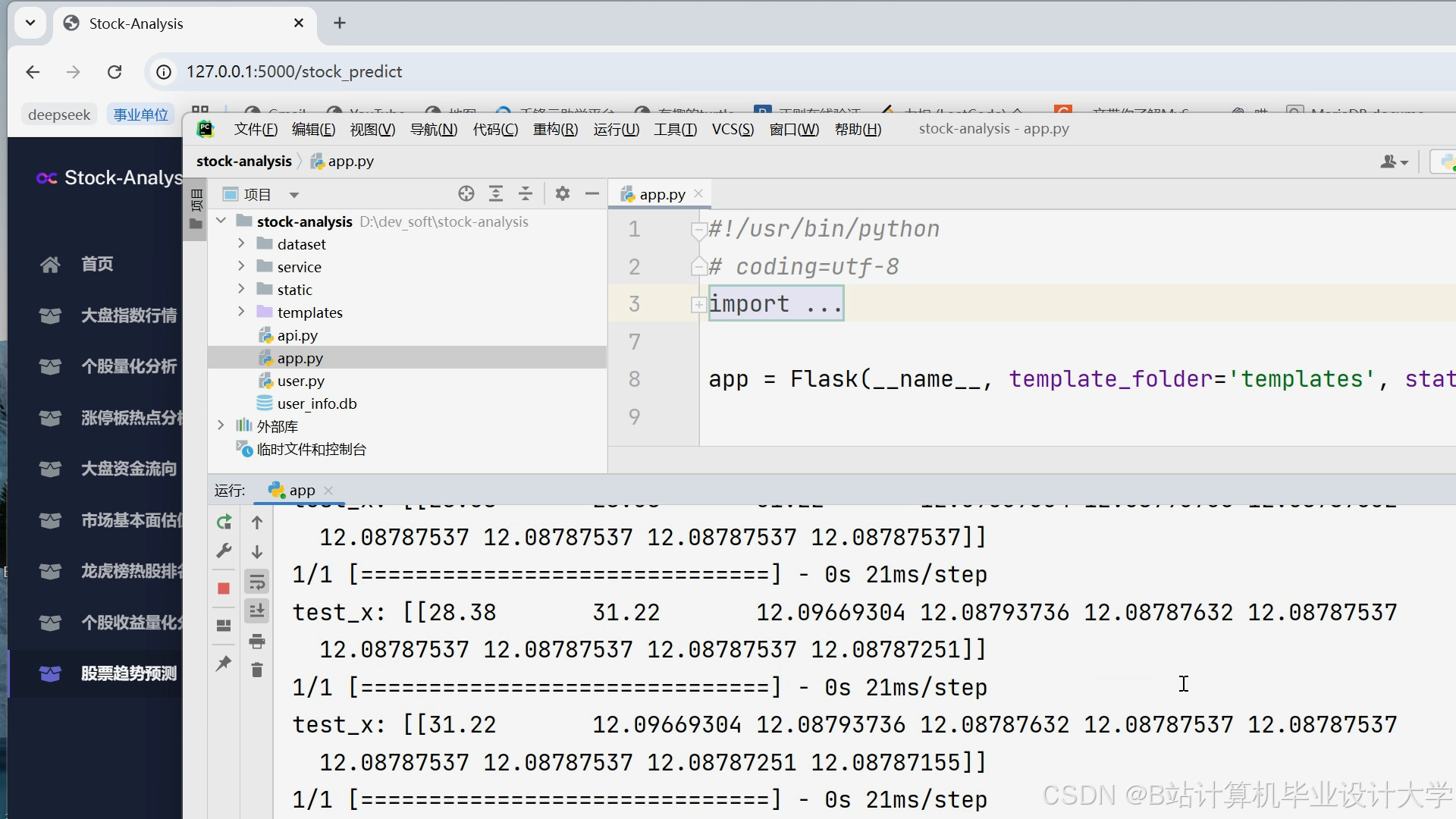

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

更多推荐

已为社区贡献334条内容

已为社区贡献334条内容

所有评论(0)