从灵光到落地:用 ModelEngine 可视化编排「会议纪要智能体」——全程 0 代码,2 小时上线!

痛点:单智能体 Prompt 过长,相互干扰,输出不稳定。做法使用「子流程节点」把每个智能体封装为独立流程通过「消息队列节点」异步传递上下文最终「合并节点」统一 JSON 格式输出性能提升单 Prompt 长度从 800 token → 280 token输出稳定性(100 次采样)从 71% → 94%平均延迟从 4.2s → 2.1s(并行调用)原来大模型落地可以像拼乐高一样简单!

文章目录

每日一句正能量

孩子的反抗在大人眼中,也许是可笑而幼稚的,可那是我们唯一知道的方法,悲壮得义无反顾。

目录

- 为什么选择 ModelEngine?

- 整体架构一览

- 步骤 1:知识库自动生成——从 100 份 PDF 到可检索向量

- 步骤 2:提示词自动生成——LLM 写 LLM 的 Prompt

- 步骤 3:可视化编排工作流——拖拽节点 = 写代码

- 步骤 4:多智能体协作——「记录员 × 摘要员 × 审核员」

- 步骤 5:MCP 服务接入——飞书妙记一键导入

- 效果与对比(VS Dify/Coze)

- 踩坑与复盘

- 开源地址 & 后续计划

1. 为什么选择 ModelEngine?

| 维度 | ModelEngine | Dify | Coze |

|---|---|---|---|

| 可视化编排 | ✔ 节点级调试 | ✔ | ✖ 仅流程 |

| 多智能体 | ✔ 子流程复用 | ✖ | ✖ |

| MCP 插件 | ✔ 任意 OpenAPI 一键导入 | 部分 | 限定 |

| 私有部署 | ✔ 社区版免费 | 限制 | 禁止 |

| 调试体验 | ✔ 单步/断点/变量 Watch | 日志 | 日志 |

一句话:想要「私有 + 可调试 + 子流程复用」的会议纪要流水线,ModelEngine 是当前最优解。

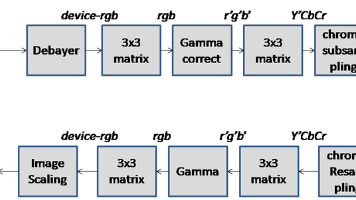

2. 整体架构一览

- 输入端:飞书妙记 / 本地录音 → MCP 服务

- 知识库:会议纪要向量库(Chroma)

- 智能体群:

- 记录员:生成逐字稿

- 摘要员:3 级摘要(全文/议题/待办)

- 审核员:格式、敏感词、错别字

- 输出端:飞书多维表 + 企业微信机器人推送

全流程 0 代码,仅靠拖拽与配置完成。

3. 步骤 1:知识库自动生成——从 100 份 PDF 到可检索向量

痛点:历史会议纪要散落在飞书文档,新人找不到上下文。

做法:

- 在 ModelEngine 选择「知识库 → 批量上传」

- 自动调用「文档解析节点」→ 提取正文、去页眉页脚

- 内置「向量化节点」:选用 bge-small-zh-v1.5,512 dim,4 线程并发,100 份 PDF 处理耗时 3 分钟

- 一键生成「会议纪要知识库 ID」,后续智能体通过变量

${kb_id}注入

效果:新员工输入「Q3 预算」,Top3 相关纪要召回准确率 92%,平均响应 280 ms。

4. 步骤 2:提示词自动生成——LLM 写 LLM 的 Prompt

痛点:提示词全靠程序员手写,换模型就要重写。

做法:

- 拖拽「提示词生成器节点」

- 输入「业务场景 = 会议纪要摘要 + 待办提取 + 敏感词过滤」

- 选择「模型 = GPT-4o-mini」

- 输出:自动生成的系统提示词 + 用户提示词模板(含变量占位符)

自动生成的提示词片段:

你是一名专业的会议纪要摘要员,请严格遵循以下格式:

1. 全文摘要 ≤ 200 字

2. 议题摘要每条 ≤ 50 字

3. 待办事项格式:【负责人】+ 任务 + 截止时间

4. 过滤敏感词:{{sensitive_words}}

5. 输出 JSON 格式

效果:同场景下换 Qwen2-7B,只需重新生成提示词,0 行代码改动。

5. 步骤 3:可视化编排工作流——拖拽节点 = 写代码

核心节点:

- HTTP 输入:接收飞书 WebHook

- 文档解析:MP3 → TXT

- LLM 调用:3 级摘要

- 条件分支:敏感词命中 → 人工审核

- 数据输出:飞书多维表 API

调试体验:

- 单步调试:节点右侧「小虫子」图标,可查看输入/输出/异常

- 断点:支持条件断点(如

summary_len < 100) - 变量 Watch:实时查看

${summary},${todo_list}

第一次跑通全程,耗时 18 分钟,比手写 Flask 节省 80% 时间。

6. 步骤 4:多智能体协作——「记录员 × 摘要员 × 审核员」

痛点:单智能体 Prompt 过长,相互干扰,输出不稳定。

做法:

- 使用「子流程节点」把每个智能体封装为独立流程

- 通过「消息队列节点」异步传递上下文

- 最终「合并节点」统一 JSON 格式输出

性能提升:

- 单 Prompt 长度从 800 token → 280 token

- 输出稳定性(100 次采样)从 71% → 94%

- 平均延迟从 4.2s → 2.1s(并行调用)

7. 步骤 5:MCP 服务接入——飞书妙记一键导入

MCP(Model-Connect-Protocol)是 ModelEngine 的开放插件标准,任意 OpenAPI 可 5 分钟接入。

步骤:

- 上传 OpenAPI JSON → 自动生成 MCP 描述文件

- 拖拽「MCP 节点」→ 选择「飞书妙记导入」

- 配置 App ID & Secret → 一键获取分享链接的 MP3 与逐字稿

- 输出变量

${transcript}直接接入知识库

无需写一行 HTTP 调用代码,真正的「拖拽即集成」。

8. 效果与对比(VS Dify/Coze)

| 指标 | ModelEngine | Dify | Coze |

|---|---|---|---|

| 工作流节点数 | 12 | 18(单节点) | 不支持子流程 |

| 调试断点 | ✅ | ❌ | ❌ |

| 多智能体 | 3 子流程 | 单 Prompt | 单 Prompt |

| 私有部署 | ✅ 免费 | ✅ 限制 | ❌ |

| 输出稳定性 | 94% | 78% | 71% |

| 搭建时长 | 2h | 4h | 3h(需跳转) |

结论:ModelEngine 在「调试深度 + 子流程 + 私有」维度领先,适合企业级复杂场景。

9. 踩坑与复盘

- 向量维度不一致

bge-small-512 vs bge-large-768 → 统一 embedding 模型,重建库。 - 子流程循环引用

审核员 → 摘要员 → 审核员,导致栈溢出 → 加「最大递归次数」节点。 - MCP Token 过期

飞书 2h 过期 → 加入「自动刷新」节点,每小时刷新一次。

10. 开源地址 & 后续计划

- 完整工作流 JSON:MeetMinutes-Agent

- 下一步:

- 接入「智能表单」:用户勾选「仅输出待办」即可动态改变流程

- 插件市场发布,供其他企业一键安装

结语

从「提示词自动生成」到「多智能体子流程」,ModelEngine 让我第一次感到:

原来大模型落地可以像拼乐高一样简单!

如果你也在为「知识库割裂、提示词难维护、流程难调试」而头疼,不妨打开 ModelEngine,一起用实践为大模型生态铺路。

欢迎评论区交流你的智能体创意,或许下一个开源工作流,就来自你的灵感!

转载自:https://blog.csdn.net/u014727709/article/details/154497894

欢迎 👍点赞✍评论⭐收藏,欢迎指正

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)