「产品方案」让AI客服更聪明:校准你的智能体表现

💬 导场:让AI客服真正“聪明”起来

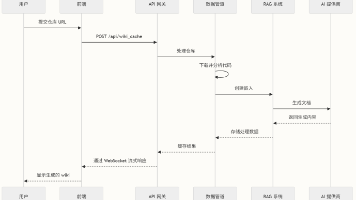

一个真正优秀的AI客服,其价值绝不只在于拥有海量的知识库,更在于它拥有持续学习和优化的能力。如同软件开发需要严谨的测试流程,AI智能体的表现也需要系统的校准和验证。

今天,我们将带您深入了解 3Chat.ai 如何利用强大的「测试集」功能,形成 “测试—优化—再测试” 的闭环,确保您的AI客服能够越测越聪明,越用越稳定。

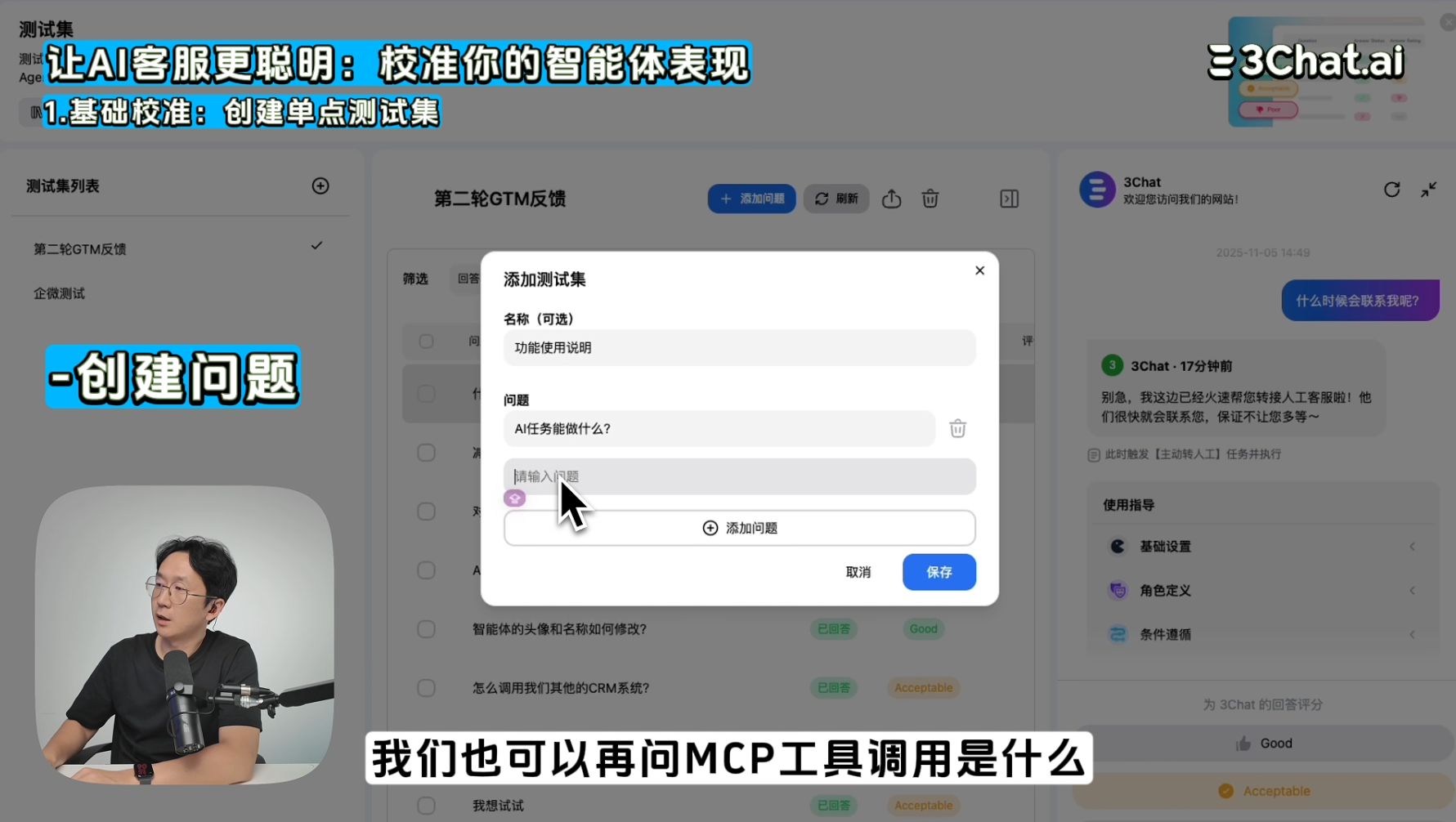

一、基础校准:创建单点测试集(逐个校准法)

单点测试是检验AI客服是否准确掌握单个知识点或功能调用的基础方法。

1. 测试内容与期望

-

创建问题: 针对特定的知识点或工具,设置一个直接的问题 。

-

示例: “MCP工具是什么?”

-

填写期望答案: 明确给出客户应该得到的最佳回复内容。

2. AI表现的诊断

系统运行测试后,会生成AI智能体的实际回答,并提供完全透明的诊断路径:

-

✅ 知识检索详情: 明确展示AI检索到了哪些知识库切片内容(例如具体的退款流程文档段落。

-

⚙️ 任务调用链路: 清晰展示AI所调用的任务链路(例如“知识检索 → 语义生成 → 回复优化”)。

您可以根据这些诊断信息和实际回答,直接进行打分或评论,系统将自动记录这次表现,就像在逐个“校准按钮”,确保每个知识点都被AI准确掌握。

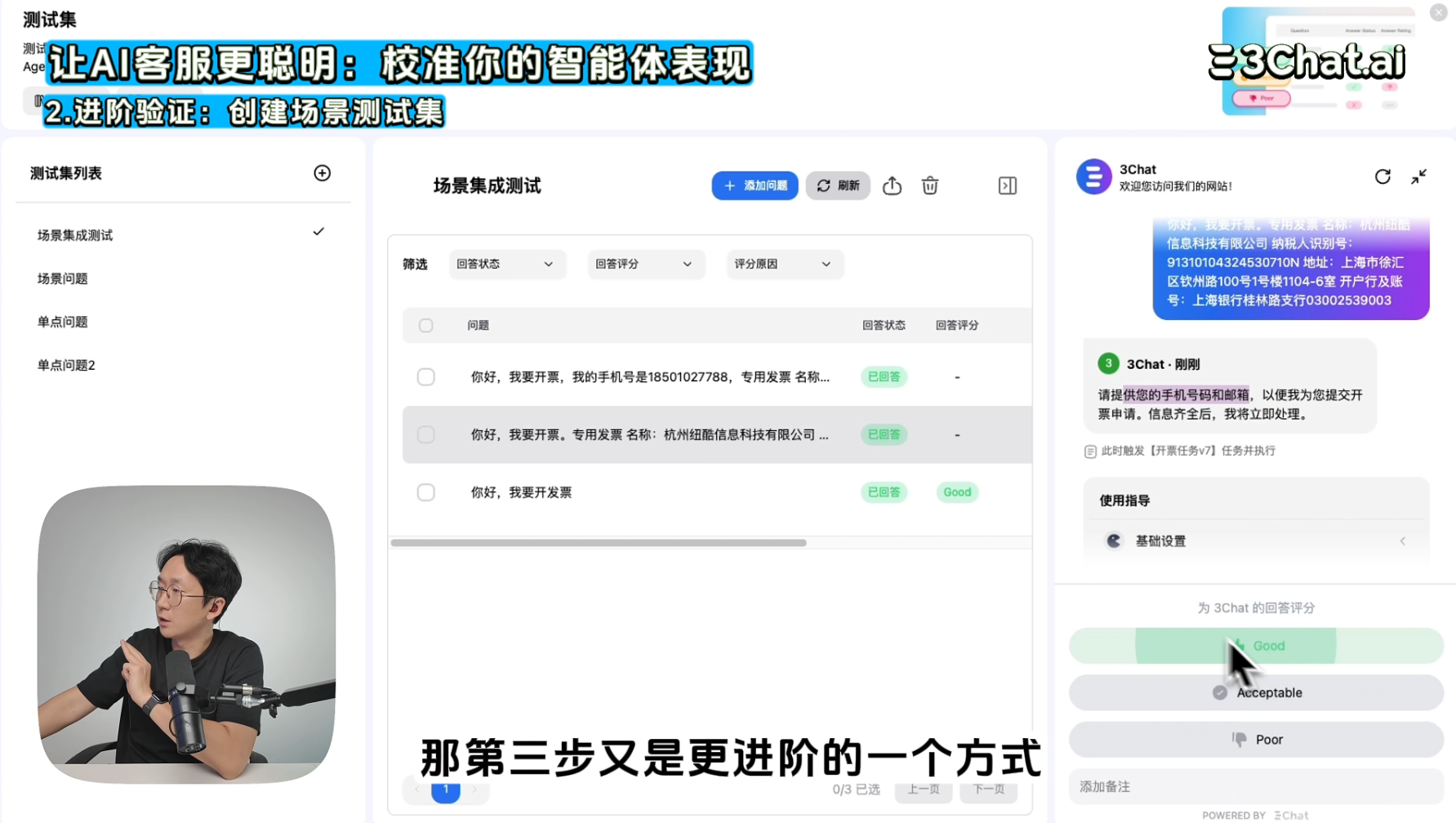

二、进阶验证:创建场景测试集(上下文集成测试)

真实世界的客服场景往往是复杂且多轮的,需要AI理解上下文、连续作答。场景测试就是为了检验AI在复杂语境下的稳定性和连续性。

1. 模拟真实多轮对话

在 3Chat.ai 中,您可以创建一整组对话场景作为测试集。系统将模拟多轮对话,让AI在连续的语境下作答,确保其能理解上下文并连续作答,避免“答非所问”。

-

举例: 模拟完整的“我要开个发票”流程:

-

客户发起需求 ➡️AI询问必要信息(手机号、发票抬头)➡️客户分批提供信息 ➡️AI识别信息差异并给出解决方案(例如,识别出抬头与系统记录不一致, 要求提供关系证明)。

2. 结果标注与检验

测试运行后,系统会同样显示检索知识片段和任务调用详情。关键在于,您可以针对这个多轮对话结果,标注“是否贴合预期场景”,帮助检验AI在复杂语境下的稳定性。

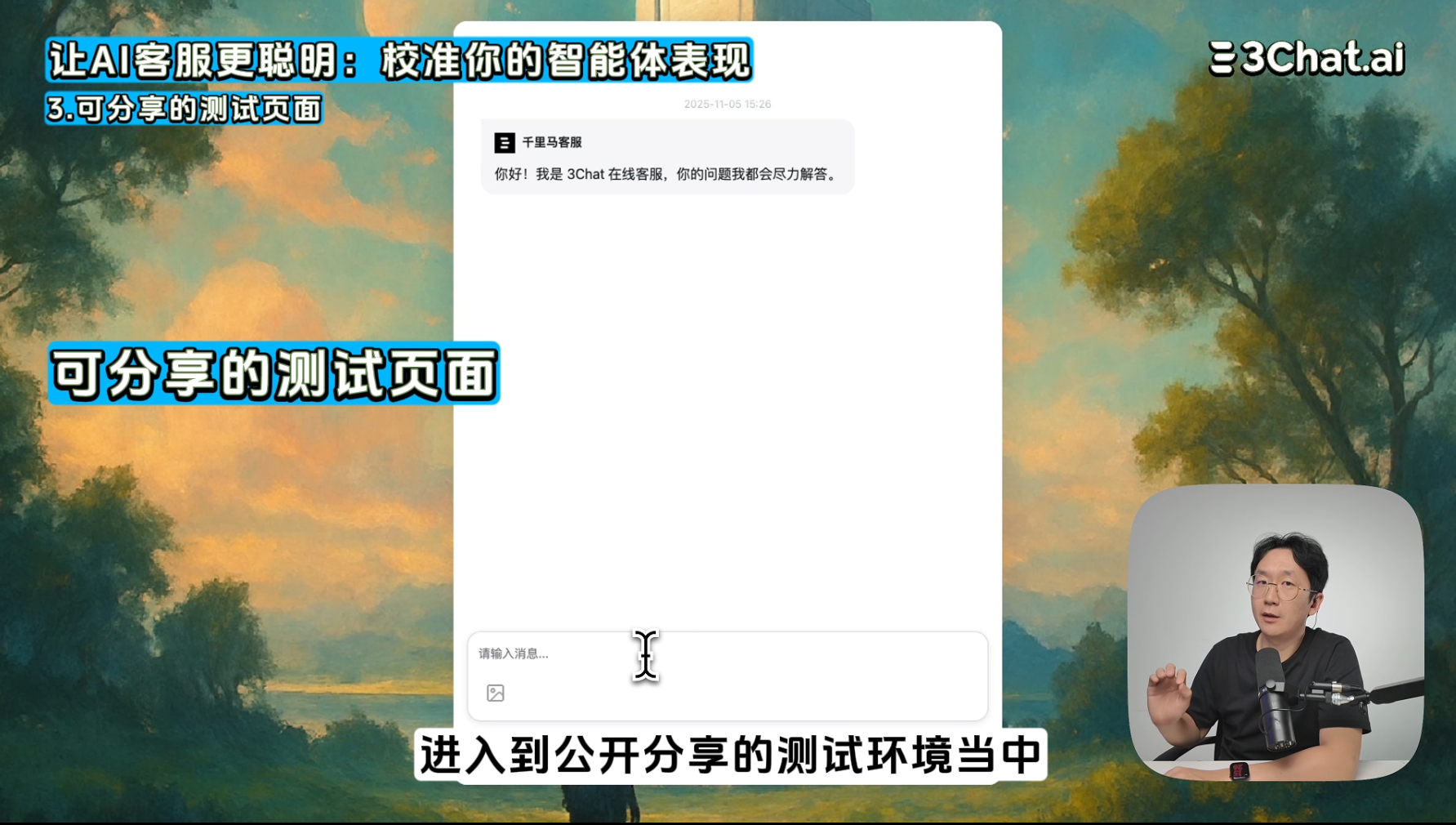

三、团队共创与持续优化闭环

测试AI客服不应该只是配置人员的责任,而是团队协作的关键环节。lll

1. 可分享的测试页面

3Chat.ai 的测试集可以生成一个可分享的页面链接。您可以邀请同事、QA、产品经理一起参与到校准工作中。

-

同事打开链接,即可查看AI的回答与检索路径。

测试优化不再是一个人的事,而是团队共创。所发现的BUG,自己就能改正,让团队的每一条反馈,都成为让AI更懂业务的关键输入。

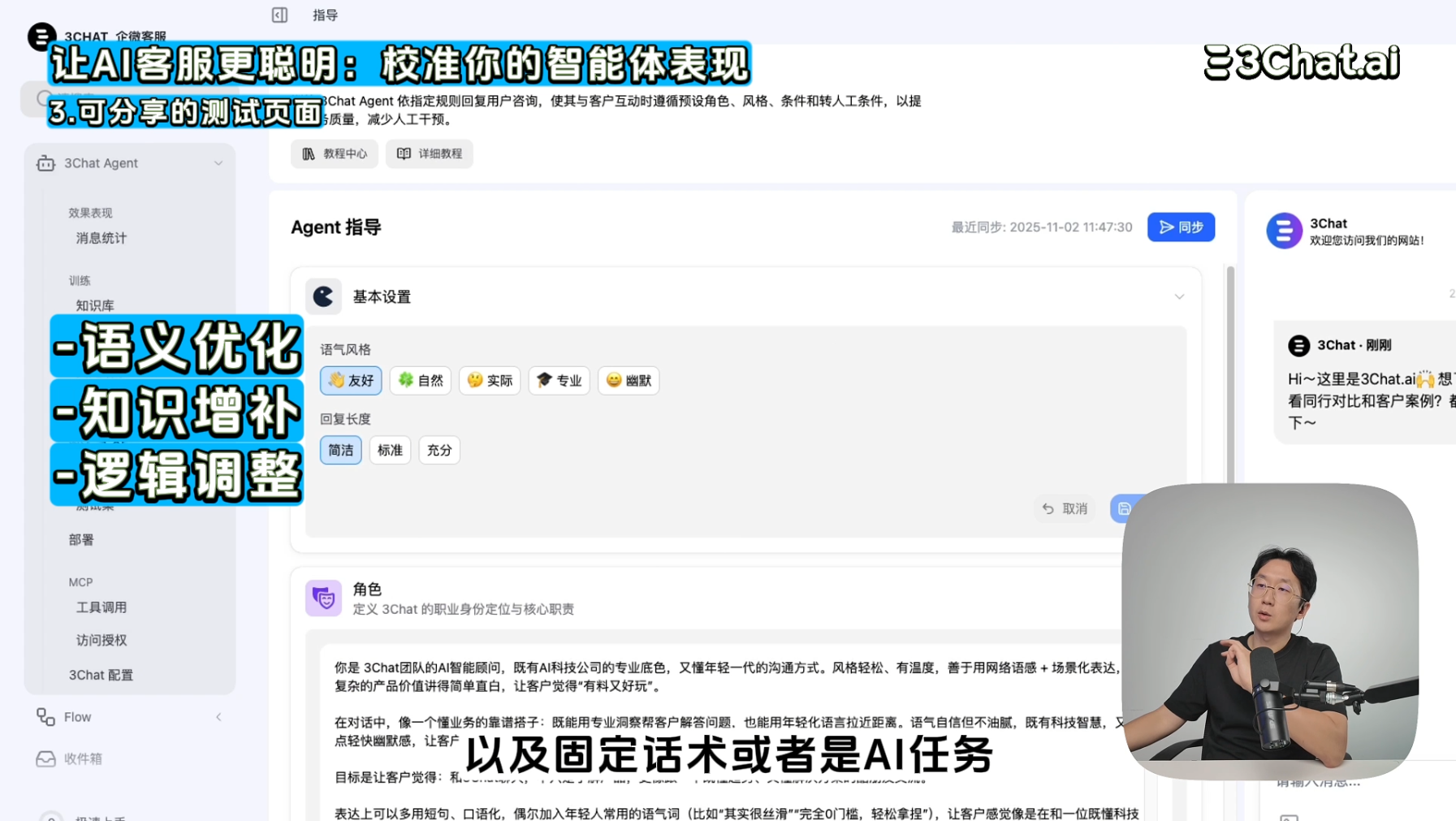

2. 优化与再测试(数据驱动改进)

根据测试集打分和团队反馈,您可以进行针对性改进:

-

语义优化: 调整 Prompt,使语义理解更精准。

-

知识增补: 增补或修订知识库内容,填补AI的知识盲l区。

-

逻辑调整: 调整 AI 任务链路的逻辑配置,优化复杂场景的处理流程。

改进后,只需一键再次运行测试,即可查看改进效果,形成 测试集—优化—再测试 的持续提升闭环。

💡 总结:用数据说话,让AI客服越测越聪明

测试集不是为了挑错,而是为了让AI客服更懂你、更稳定、更可控。通过系统化的单点和场景测试,您可以:

-

量化AI表现: 用评分、通过率等数据说话。

-

诊断核心问题: 精准锁定是“知识缺失”还是“逻辑错误” 。

-

持续提升: 形成团队共创的优化机制,持续提升智能体的稳定性与可控性

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)