投稿前的秘密武器,让论文少走弯路

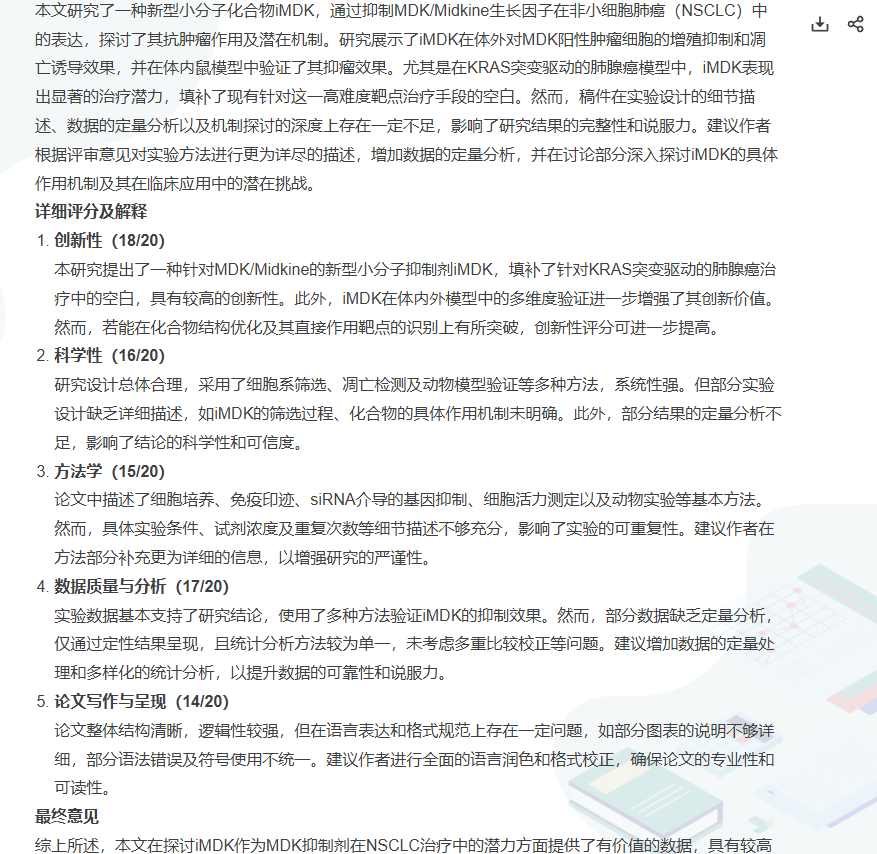

然而,许多研究者都有这样的经历:信心满满地提交论文,却在数周后收到冗长的审稿意见,甚至直接被拒。系统会通过 AI 模型自动分析论文结构、逻辑、语言、研究方法等多个维度,从“审稿人视角”出发,对论文逐章给出评审意见。MedPeer 模拟评审依先进AI,能够在论文正式投稿前,自动对稿件进行评估、打分与结构化点评,帮助科研人员快速定位问题,优化论文质量。,它为科研人员提供了一种“提前体验审稿人视角”的全

对于科研人员而言,论文能否顺利发表,往往是科研阶段性成果能否被认可的关键。然而,许多研究者都有这样的经历:信心满满地提交论文,却在数周后收到冗长的审稿意见,甚至直接被拒。问题或许并非研究本身,而是在论文的逻辑、表达、结构或规范上存在“隐蔽瑕疵”。

在正式投稿前,如果能有一个工具提前“模拟审稿人”,帮我们发现潜在问题、评估稿件质量,是否能大大提高录用率?

MedPeer 模拟评审,它为科研人员提供了一种“提前体验审稿人视角”的全新方式,让研究者在投稿前就能完成一次高质量的论文预审。

一、科研人员的共同痛点:投稿前的“盲区”

在论文完成后,大多数科研人员都会经历三个典型困扰:

1. 缺乏客观审视:作者通常太熟悉自己的研究,难以从审稿人的角度发现问题。

2. 修改方向模糊:导师或同事的反馈往往集中在学术内容,而非结构逻辑或写作规范。

3. 等待周期漫长:真正的审稿流程动辄数月,一次拒稿就意味着效率大打折扣。

这些痛点说明了一个事实:科研人员在投稿前,迫切需要一个智能化、专业化的“学术预审系统”,既能模拟审稿流程,又能给出可操作的改进意见。

二、MedPeer 模拟评审:AI驱动的“虚拟审稿人”

MedPeer 模拟评审依先进AI,能够在论文正式投稿前,自动对稿件进行评估、打分与结构化点评,帮助科研人员快速定位问题,优化论文质量。

一句话概括它的价值主张:

“让每一篇论文,在投稿前就接受一次真正的‘模拟审稿’。”

三、功能亮点:一次全面的“论文体检”

1. 智能评审引擎——像审稿人一样读你的论文

系统会通过 AI 模型自动分析论文结构、逻辑、语言、研究方法等多个维度,从“审稿人视角”出发,对论文逐章给出评审意见。无论是实验设计的合理性,还是结论的逻辑支撑,系统都能指出潜在问题。

2. 多维度质量评分——让质量可量化

模拟评审提供清晰的量化评分体系,覆盖语言表达、逻辑严密度、研究创新性、图表规范性、参考文献完整度等指标。科研人员可以一目了然地看到论文的“综合评分”及各维度得分,从而判断论文是否达到投稿标准。

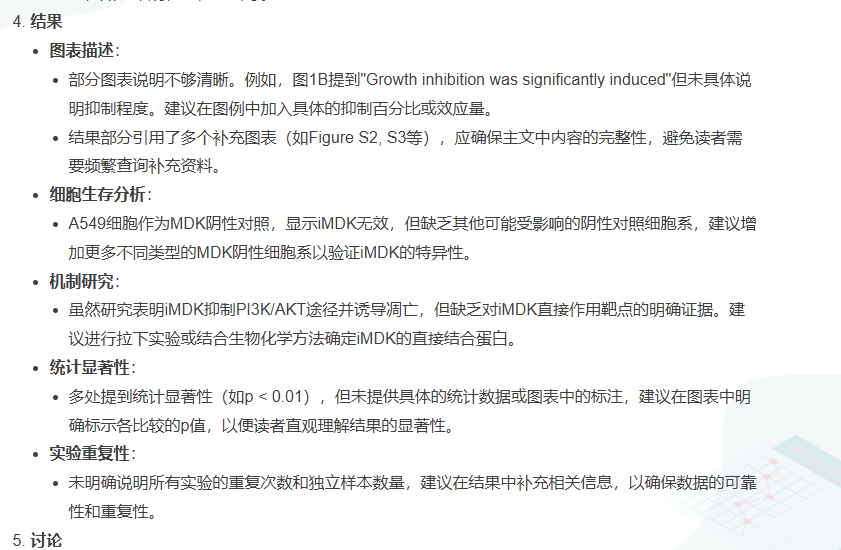

3. 模拟评审报告——结构化反馈更具指导性

系统生成的报告不仅有总评,还会给出分项建议。例如:

- “在实验方法部分,样本数量说明不足,可能影响结论可靠性”;

- “图3的说明与图中标注不一致,建议统一”;

- “讨论部分未充分对比前人研究成果,可增加2-3篇高影响力文献引用”。

这些具体化建议,能让作者明确修改方向,而不是模糊的“需要改进”。

4. 双语支持与自定义模型——适配国内外期刊标准

支持中英文双语稿件评审,适配不同学科、不同语言的论文类型。对于医学、生物学、工程学等领域,系统还能自动匹配对应的审稿标准,提供更具针对性的反馈。

四、从投稿盲区到精准改进:模拟评审如何助力科研

想象这样的场景:

你刚完成一篇论文,准备投稿国际期刊。此时只需将稿件上传至 MedPeer 模拟评审,系统在数分钟内生成详细报告:

- 语言表达评分:82/100,建议在摘要部分减少主观表述;

- 研究设计评分:75/100,提示方法部分需补充实验重复次数;

- 创新性评分:90/100,评价研究方向新颖、选题有前瞻性。

报告末尾,还附带系统生成的“修改优先级建议”:

“若计划投稿至 SCI二区期刊,建议优先完善实验方法部分,再进行语言校对。”

这种 “智能化评估 + 优化路径建议” 的组合,能显著提升论文整体质量,帮助作者以更高标准完成投稿前的最后冲刺。

更多推荐

已为社区贡献34条内容

已为社区贡献34条内容

所有评论(0)