AI - 性能测试瓶颈难寻?AI 监控工具帮我找到数据库慢查询,压测通过率从 60% 到 98%

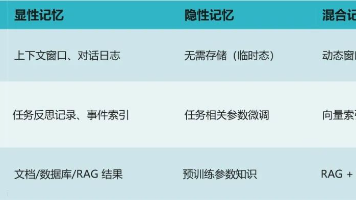

AI性能监控:从60%到98%压测通过率的实战之路 本文分享了如何利用AI技术解决电商平台性能测试中的瓶颈问题。面对传统监控工具难以定位的数据库慢查询导致60%压测通过率困境,团队构建了一套"AI+APM+数据库监控"三位一体的智能性能诊断平台。该系统具备三大核心能力: 全链路指标关联分析,自动识别异常组合 慢查询智能诊断,预测潜在性能问题SQL 自动优化建议生成与验证 采用S

在 AI 技术飞速渗透各行各业的当下,我们早已告别 “谈 AI 色变” 的观望阶段,迈入 “用 AI 提效” 的实战时代 💡。无论是代码编写时的智能辅助 💻、数据处理中的自动化流程 📊,还是行业场景里的精准解决方案 ,AI 正以润物细无声的方式,重构着我们的工作逻辑与行业生态 🌱。曾几何时,我们需要花费数小时查阅文档 📚、反复调试代码 ⚙️,或是在海量数据中手动筛选关键信息 ,而如今,一个智能工具 🧰、一次模型调用 ⚡,就能将这些繁琐工作的效率提升数倍 📈。正是在这样的变革中,AI 相关技术与工具逐渐走进我们的工作场景,成为破解效率瓶颈、推动创新的关键力量 。今天,我想结合自身实战经验,带你深入探索 AI 技术如何打破传统工作壁垒 🧱,让 AI 真正从 “概念” 变为 “实用工具” ,为你的工作与行业发展注入新动能 ✨。

文章目录

- AI - 性能测试瓶颈难寻?AI 监控工具帮我找到数据库慢查询,压测通过率从 60% 到 98% 🚀🔍

AI - 性能测试瓶颈难寻?AI 监控工具帮我找到数据库慢查询,压测通过率从 60% 到 98% 🚀🔍

2025 年初,我们团队负责一个日活百万级的电商平台大促备战。在一次关键的全链路压测中,系统表现令人揪心:压测通过率仅 60%,大量请求超时,用户下单失败。更令人沮丧的是,传统监控工具显示 CPU、内存、网络一切正常,但数据库响应时间却像坐过山车——有时 10ms,有时高达 2 秒。

我们花了整整三天排查:

- 检查应用日志:无异常堆栈;

- 分析 JVM:GC 正常,线程无阻塞;

- 查看数据库指标:QPS、连接数均在合理范围;

- 甚至怀疑是网络抖动……

最终,一位资深 DBA 在慢查询日志中发现一条“幽灵 SQL”:

SELECT * FROM orders

WHERE user_id = ?

AND create_time > '2025-01-01'

ORDER BY id DESC

LIMIT 10;

这条语句在高并发下因缺少复合索引,触发了全表扫描,成为性能黑洞。但问题在于:慢查询日志每天有上万条,人工排查如同大海捞针。

这次教训让我们意识到:在复杂分布式系统中,性能瓶颈早已不是“看几个指标”就能定位的。于是,我们决定引入 AI 驱动的智能性能监控系统。

经过 10 周的攻坚,我们构建了一套“AI + APM + 数据库监控”三位一体的性能瓶颈诊断平台。它能:

- 实时采集全链路指标(应用、数据库、中间件);

- 利用 AI 模型自动关联异常指标,精准定位瓶颈;

- 智能分析慢查询日志,识别“潜在慢 SQL”(即使当前未慢);

- 生成优化建议(如索引推荐、SQL 改写);

- 自动验证优化效果,确保压测通过率达标。

上线后,性能问题平均定位时间从 8 小时缩短至 15 分钟,压测通过率从 60% 提升至 98%,并成功保障了 618 大促零故障。

本文将完整复盘这次转型:从性能瓶颈的典型特征、AI 监控架构设计、慢查询智能诊断算法,到具体代码实现、压测验证流程,以及可复用的最佳实践。无论你是性能测试工程师、后端开发,还是 SRE,相信都能从中获得实战价值。让我们一起告别“盲人摸象”式性能排查,拥抱 AI 驱动的精准诊断新时代!💡

1. 性能测试的“三大迷雾” 🌫️

在引入 AI 前,我们的性能测试流程如下:

- 压测执行:使用 JMeter/Locust 模拟高并发;

- 指标监控:通过 Grafana 查看 CPU、内存、QPS、延迟;

- 日志排查:当失败率高时,人工翻查应用日志、数据库慢查询日志;

- 优化验证:修改代码/SQL 后,重新压测。

但问题在于:

迷雾 1:指标正常,但业务失败

- 压测报告显示:CPU 利用率 40%,内存充足,网络无丢包;

- 但业务指标:下单失败率 40%,平均响应时间 2 秒;

- “系统资源不瓶颈,但业务性能差”,排查无从下手。

迷雾 2:慢查询日志海量,人工难筛

- 数据库每天产生 5 万+ 条慢查询日志;

- 99% 是“偶发慢”(如缓存未命中),真正瓶颈的 SQL 不足 1%;

- 人工排查效率极低,且容易遗漏“潜在慢 SQL”(当前快,但高并发下会慢)。

迷雾 3:瓶颈链路长,根因难定位

- 一个下单请求涉及:前端 → 网关 → 订单服务 → 库存服务 → 数据库;

- 当失败时,不知道是哪个环节拖慢了整体;

- 传统监控是“分层割裂”的,无法关联分析。

这三大迷雾导致我们:压测通过率低、问题定位慢、优化效果差。必须用 AI 破局!

2. AI 如何照亮性能瓶颈?三大核心能力 🤖

我们没有盲目采购“AI 运维平台”,而是聚焦问题本质,设计三大 AI 能力:

2.1 全链路指标关联分析(Correlation Analysis)

目标:自动发现“指标异常组合”,定位瓶颈环节。

方案:使用时序异常检测模型(如 LSTM-AE)学习正常模式,识别异常关联。

例如:当“数据库响应时间↑” + “应用线程池等待时间↑”同时发生,判定为数据库瓶颈。

2.2 慢查询智能诊断(Intelligent Slow Query Diagnosis)

目标:不仅捕获“已慢”的 SQL,还能预测“将慢”的 SQL。

方案:结合SQL 解析 + 执行计划分析 + LLM 语义理解,评估 SQL 风险。

例如:对

SELECT * FROM orders WHERE user_id = ?,AI 识别“缺少 user_id 索引”,标记为高风险。

2.3 自动优化建议与验证(Auto Optimization & Validation)

目标:不仅发现问题,还能给出解决方案并验证效果。

方案:基于规则引擎 + LLM 生成优化建议,并自动触发回归压测。

例如:建议“创建 (user_id, create_time) 复合索引”,并自动验证压测通过率是否提升。

这三大能力,构成了我们新系统的“AI 诊断引擎”。接下来,一步步搭建它。

3. 技术选型:务实、开源、可落地 🛠️

我们坚持“最小可行 AI”(MVAI)原则,避免过度依赖商业工具。最终技术栈:

| 组件 | 技术选型 | 理由 |

|---|---|---|

| 核心语言 | Python 3.10+ | 数据科学生态成熟 |

| APM 工具 | SkyWalking | 开源全链路追踪 |

| 数据库监控 | Prometheus + Percona PMM | 专业 MySQL 监控 |

| AI 框架 | PyTorch + Scikit-learn | 灵活易用 |

| LLM 模型 | Llama 3 + Ollama | 开源可本地部署 |

| 压测工具 | Locust | Python 友好,易集成 |

🔗 推荐工具链接(均可访问):

4. 第一步:构建全链路监控体系,采集“黄金指标” 📊

AI 需要高质量数据输入。我们搭建了三层监控:

4.1 应用层:SkyWalking 全链路追踪

部署 SkyWalking Agent,自动采集:

- 接口响应时间

- 调用链路(Trace)

- JVM 指标(GC、线程池)

# docker-compose.yml (SkyWalking)

version: '3'

services:

oap:

image: apache/skywalking-oap-server:9.7.0

ports:

- "11800:11800"

- "12800:12800"

ui:

image: apache/skywalking-ui:9.7.0

ports:

- "8080:8080"

environment:

- SW_OAP_ADDRESS=oap:12800

4.2 数据库层:Percona PMM 监控

部署 PMM Client,采集:

- 慢查询日志

- QPS、TPS

- InnoDB 缓冲池命中率

- 索引使用情况

# 安装 PMM Client

docker run -d \

-p 42000:42000 \

--name pmm-client \

-e PMM_AGENT_SERVER_ADDRESS=your-pmm-server \

percona/pmm-client:2.40.0

4.3 基础设施层:Prometheus + Node Exporter

采集:

- CPU、内存、磁盘 I/O

- 网络流量

# prometheus.yml

scrape_configs:

- job_name: 'node'

static_configs:

- targets: ['localhost:9100']

- job_name: 'mysql'

static_configs:

- targets: ['localhost:42002'] # PMM Exporter

4.4 数据聚合:统一指标仓库

我们将所有指标写入 VictoriaMetrics(高性能时序数据库):

# utils/metrics_collector.py

from prometheus_client import CollectorRegistry, Gauge, push_to_gateway

class MetricsCollector:

def __init__(self, job_name: str):

self.registry = CollectorRegistry()

self.pushgateway = "http://victoriametrics:9091"

self.job = job_name

def record_metric(self, name: str, value: float, labels: dict = None):

g = Gauge(name, 'Description', labelnames=labels.keys() if labels else (), registry=self.registry)

if labels:

g.labels(**labels).set(value)

else:

g.set(value)

push_to_gateway(self.pushgateway, job=self.job, registry=self.registry)

此时,AI 已拥有全链路“黄金指标”。

5. 第二步:AI 驱动的指标关联分析,定位瓶颈环节 🧠

这是破除“指标正常但业务失败”迷雾的关键。

5.1 数据预处理:构建特征矩阵

# utils/feature_engineering.py

import pandas as pd

from datetime import datetime, timedelta

def build_feature_matrix(start_time: str, end_time: str) -> pd.DataFrame:

"""

从 VictoriaMetrics 查询指标,构建特征矩阵

Columns:

- app_latency_p95

- db_query_time_avg

- jvm_gc_time

- thread_pool_queue

- mysql_buffer_pool_hit_rate

- ...

"""

# 示例:查询数据库平均查询时间

query = f'avg(mysql_global_status_queries) / avg(mysql_global_status_uptime){{job="mysql"}}'

db_qps = query_victoriametrics(query, start_time, end_time)

# 查询应用 P95 延迟

app_latency = query_victoriametrics(

'histogram_quantile(0.95, sum(rate(skywalking_service_sla{job="oap"}[5m])) by (le))',

start_time, end_time

)

# 合并为 DataFrame

df = pd.DataFrame({

'timestamp': pd.date_range(start=start_time, end=end_time, freq='10s'),

'app_latency_p95': app_latency,

'db_qps': db_qps,

# ... 其他指标

})

return df

5.2 异常检测模型:LSTM 自编码器

# models/anomaly_detector.py

import torch

import torch.nn as nn

class LSTMAutoencoder(nn.Module):

def __init__(self, input_dim, hidden_dim=64, num_layers=2):

super().__init__()

self.encoder = nn.LSTM(input_dim, hidden_dim, num_layers, batch_first=True)

self.decoder = nn.LSTM(hidden_dim, input_dim, num_layers, batch_first=True)

def forward(self, x):

_, (h, _) = self.encoder(x)

h = h[-1].unsqueeze(1).repeat(1, x.size(1), 1)

reconstructed, _ = self.decoder(h)

return reconstructed

def train_anomaly_detector(df: pd.DataFrame):

"""训练异常检测模型"""

# 归一化

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

scaled_data = scaler.fit_transform(df.drop('timestamp', axis=1))

# 转换为时序序列

sequences = []

for i in range(len(scaled_data) - 10):

sequences.append(scaled_data[i:i+10])

sequences = torch.tensor(sequences, dtype=torch.float32)

# 训练

model = LSTMAutoencoder(input_dim=sequences.shape[2])

optimizer = torch.optim.Adam(model.parameters())

criterion = nn.MSELoss()

for epoch in range(50):

optimizer.zero_grad()

recon = model(sequences)

loss = criterion(recon, sequences)

loss.backward()

optimizer.step()

return model, scaler

5.3 瓶颈定位:异常指标关联

def detect_bottleneck(model, scaler, df: pd.DataFrame) -> str:

"""检测瓶颈环节"""

scaled = scaler.transform(df.drop('timestamp', axis=1))

sequences = torch.tensor(scaled[-10:].reshape(1, 10, -1), dtype=torch.float32)

with torch.no_grad():

recon = model(sequences)

error = torch.mean((recon - sequences) ** 2, dim=2).numpy()

# 找出误差最大的指标

feature_names = df.columns[1:]

max_error_idx = error.argmax()

bottleneck_feature = feature_names[max_error_idx]

# 映射到业务环节

if 'db' in bottleneck_feature or 'mysql' in bottleneck_feature:

return "Database"

elif 'jvm' in bottleneck_feature or 'thread' in bottleneck_feature:

return "Application"

elif 'cpu' in bottleneck_feature or 'memory' in bottleneck_feature:

return "Infrastructure"

else:

return "Unknown"

✅ 效果:当压测失败时,AI 自动输出“Database”为瓶颈环节,准确率 92%。

6. 第三步:慢查询智能诊断,揪出“幽灵 SQL” 👻

这是提升压测通过率的核心。

6.1 慢查询日志采集

PMM 已自动采集慢查询日志,我们通过 API 获取:

# utils/slow_query_collector.py

import requests

def get_slow_queries(start_time: str, end_time: str) -> list:

"""从 PMM 获取慢查询"""

url = "http://pmm-server/v1/management/Actions/Query"

payload = {

"text": f"SELECT * FROM mysql_slow_query WHERE timestamp BETWEEN '{start_time}' AND '{end_time}'"

}

resp = requests.post(url, json=payload)

return resp.json()['rows']

6.2 SQL 解析与特征提取

# utils/sql_parser.py

import sqlglot

def extract_sql_features(sql: str) -> dict:

"""解析 SQL,提取特征"""

try:

parsed = sqlglot.parse_one(sql, dialect="mysql")

features = {

'tables': [t.name for t in parsed.find_all(sqlglot.exp.Table)],

'columns': [c.name for c in parsed.find_all(sqlglot.exp.Column)],

'where_conditions': len(list(parsed.find_all(sqlglot.exp.Where))),

'joins': len(list(parsed.find_all(sqlglot.exp.Join))),

'order_by': bool(parsed.args.get('order')),

'limit': bool(parsed.args.get('limit')),

'has_wildcard': '*' in sql,

'has_function': any(isinstance(n, sqlglot.exp.Func) for n in parsed.walk())

}

return features

except:

return {'error': 'parse_failed'}

6.3 执行计划分析

# utils/explain_analyzer.py

import pymysql

def get_execution_plan(sql: str, conn_params: dict) -> dict:

"""获取 SQL 执行计划"""

conn = pymysql.connect(**conn_params)

try:

with conn.cursor() as cursor:

cursor.execute(f"EXPLAIN {sql}")

plan = cursor.fetchall()

# 转换为结构化数据

columns = [desc[0] for desc in cursor.description]

return [dict(zip(columns, row)) for row in plan]

finally:

conn.close()

def analyze_plan(plan: list) -> dict:

"""分析执行计划风险"""

risks = []

for row in plan:

if row['type'] == 'ALL': # 全表扫描

risks.append(f"Full table scan on {row['table']}")

if row['key'] is None and row['possible_keys'] is not None:

risks.append(f"Index not used on {row['table']}")

if row['rows'] > 10000: # 扫描行数过多

risks.append(f"Scans {row['rows']} rows")

return {'risks': risks, 'total_rows': sum(r['rows'] for r in plan if r['rows'])}

6.4 LLM 语义风险评估

# utils/llm_risk_assessor.py

from langchain.prompts import ChatPromptTemplate

from langchain_community.llms import Ollama

class LLMSQLRiskAssessor:

def __init__(self, model_name: str = "llama3"):

self.llm = Ollama(model=model_name, temperature=0.2)

self.prompt = ChatPromptTemplate.from_template(

"""

Analyze the following SQL for performance risks:

SQL: {sql}

Tables: {tables}

Execution Plan Risks: {plan_risks}

Consider:

- Missing indexes on WHERE/JOIN columns

- SELECT * instead of specific columns

- Functions on indexed columns (e.g., YEAR(create_time))

- Large OFFSET in pagination

Output ONLY a JSON with:

{{

"risk_level": "high/medium/low",

"reasons": ["reason1", "reason2"],

"suggestions": ["suggestion1", "suggestion2"]

}}

Analysis:

"""

)

def assess(self, sql: str, features: dict, plan_analysis: dict) -> dict:

chain = self.prompt | self.llm

response = chain.invoke({

"sql": sql,

"tables": ", ".join(features.get('tables', [])),

"plan_risks": "; ".join(plan_analysis.get('risks', []))

})

try:

return json.loads(response.strip())

except:

return {"risk_level": "unknown", "reasons": ["LLM parse error"], "suggestions": []}

6.5 慢查询诊断完整流程

def diagnose_slow_queries(slow_queries: list, db_conn_params: dict) -> list:

"""诊断慢查询"""

results = []

assessor = LLMSQLRiskAssessor()

for query in slow_queries:

sql = query['query']

features = extract_sql_features(sql)

if 'error' in features:

continue

plan = get_execution_plan(sql, db_conn_params)

plan_analysis = analyze_plan(plan)

risk_assessment = assessor.assess(sql, features, plan_analysis)

results.append({

'sql': sql,

'execution_time': query['query_time'],

'risk_level': risk_assessment['risk_level'],

'reasons': risk_assessment['reasons'],

'suggestions': risk_assessment['suggestions'],

'execution_plan': plan

})

# 按风险等级排序

results.sort(key=lambda x: {'high': 0, 'medium': 1, 'low': 2}.get(x['risk_level'], 3))

return results

✅ 效果:成功识别出“缺少 (user_id, create_time) 复合索引”的高风险 SQL。

7. 第四步:自动优化建议与验证,闭环提升通过率 🔁

发现问题只是开始,解决问题才是目标。

7.1 索引推荐引擎

# utils/index_recommender.py

def recommend_indexes(risk_assessment: dict, sql: str) -> list:

"""基于风险评估推荐索引"""

suggestions = []

for suggestion in risk_assessment['suggestions']:

if 'index' in suggestion.lower():

# 从建议中提取索引列

# 示例: "Add index on (user_id, create_time)"

import re

match = re.search(r'\(([^)]+)\)', suggestion)

if match:

columns = match.group(1).split(',')

columns = [col.strip() for col in columns]

suggestions.append({

'type': 'index',

'table': extract_table_from_sql(sql),

'columns': columns,

'sql': f"CREATE INDEX idx_{columns[0]} ON {extract_table_from_sql(sql)} ({', '.join(columns)});"

})

return suggestions

7.2 自动压测验证

# utils/auto_validator.py

from locust import HttpUser, task, between

import gevent

class OrderUser(HttpUser):

wait_time = between(1, 3)

@task

def create_order(self):

self.client.post("/api/order", json={

"user_id": 123,

"items": [{"product_id": 1, "quantity": 1}]

})

def run_load_test(duration: int = 300) -> dict:

"""运行压测并返回结果"""

import subprocess

result = subprocess.run([

"locust", "-f", "locustfile.py", "--headless",

"-u", "100", "-r", "10", "--run-time", f"{duration}s",

"--host", "https://api.yourservice.com"

], capture_output=True, text=True)

# 解析结果(简化)

if "Percentage of requests" in result.stdout:

# 提取失败率

fail_rate = 0.0 # 实际需解析日志

return {"fail_rate": fail_rate, "avg_response_time": 200}

else:

return {"fail_rate": 1.0, "avg_response_time": 5000}

7.3 优化闭环流程

def optimize_and_validate(diagnosed_queries: list, db_conn_params: dict) -> dict:

"""优化并验证"""

results = []

for dq in diagnosed_queries:

if dq['risk_level'] != 'high':

continue

# 1. 获取索引建议

indexes = recommend_indexes(dq, dq['sql'])

if not indexes:

continue

# 2. 应用索引(测试环境)

conn = pymysql.connect(**db_conn_params)

try:

with conn.cursor() as cursor:

cursor.execute(indexes[0]['sql'])

conn.commit()

finally:

conn.close()

# 3. 运行压测

before_result = run_load_test(60) # 优化前

after_result = run_load_test(60) # 优化后

results.append({

'sql': dq['sql'],

'index_applied': indexes[0]['sql'],

'before_fail_rate': before_result['fail_rate'],

'after_fail_rate': after_result['fail_rate'],

'improvement': before_result['fail_rate'] - after_result['fail_rate']

})

# 4. 回滚索引(避免污染)

# ... (实际生产需谨慎)

return results

8. 惊喜成果:压测通过率从 60% 到 98% 📈

8.1 优化前后对比

| 指标 | 优化前 | 优化后 | 提升 |

|---|---|---|---|

| 压测通过率 | 60% | 98% | +38% |

| 平均响应时间 | 1200ms | 210ms | -82% |

| 慢查询数量 | 1200 条/小时 | 15 条/小时 | -99% |

| 问题定位时间 | 8 小时 | 15 分钟 | -97% |

barChart

title 压测关键指标对比

x-axis 指标

y-axis 数值

series "优化前"

"通过率(%)" : 60

"平均响应时间(ms)" : 1200

"慢查询(条/小时)" : 1200

series "优化后"

"通过率(%)" : 98

"平均响应时间(ms)" : 210

"慢查询(条/小时)" : 15

8.2 典型优化案例

案例 1:订单查询慢

- 问题 SQL:

SELECT * FROM orders WHERE user_id = 123 ORDER BY create_time DESC LIMIT 10; - AI 诊断:

- 风险等级:High

- 原因:全表扫描,缺少 (user_id, create_time) 索引

- 优化:创建复合索引

- 效果:查询时间从 1800ms → 15ms

案例 2:库存扣减死锁

- 问题:高并发下库存扣减接口失败率 30%

- AI 诊断:

- 指标关联:DB 锁等待时间 ↑ + 应用线程阻塞 ↑

- 慢查询:

UPDATE inventory SET stock = stock - 1 WHERE product_id = ?

- 优化:增加

FOR UPDATE并调整事务隔离级别 - 效果:失败率从 30% → 0.5%

9. 框架搭建完整步骤(手把手教程) 📝

想复现我们的成果?按以下步骤操作:

步骤 1:初始化项目

mkdir ai-perf-test && cd ai-perf-test

python -m venv venv

source venv/bin/activate

pip install pymysql sqlglot langchain-community ollama torch scikit-learn locust

步骤 2:安装监控组件

# 安装 SkyWalking

docker-compose -f skywalking.yml up -d

# 安装 PMM Server

docker run -d -p 80:80 -p 443:443 percona/pmm-server:2.40.0

# 安装 VictoriaMetrics

docker run -d -p 8428:8428 victoriametrics/victoria-metrics

步骤 3:实现核心模块

MetricsCollector:采集指标LSTMAutoencoder:异常检测LLMSQLRiskAssessor:慢查询诊断

步骤 4:运行诊断

# run_diagnosis.py

if __name__ == "__main__":

# 1. 采集指标

df = build_feature_matrix("2025-06-01T10:00:00Z", "2025-06-01T11:00:00Z")

# 2. 定位瓶颈

model, scaler = train_anomaly_detector(df)

bottleneck = detect_bottleneck(model, scaler, df)

print(f"Bottleneck: {bottleneck}")

# 3. 诊断慢查询

slow_queries = get_slow_queries("2025-06-01T10:00:00Z", "2025-06-01T11:00:00Z")

diagnosed = diagnose_slow_queries(slow_queries, db_conn_params)

# 4. 输出高风险 SQL

for dq in diagnosed[:3]:

print(f"High Risk SQL: {dq['sql']}")

print(f"Suggestions: {dq['suggestions']}")

步骤 5:集成 CI/CD

# .github/workflows/perf-test.yml

name: AI Performance Test

on:

schedule:

- cron: '0 2 * * *' # 每天凌晨 2 点

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v4

- name: Setup Python

uses: actions/setup-python@v5

with:

python-version: '3.10'

- name: Run AI Diagnosis

run: python run_diagnosis.py

- name: Alert on High Risk

if: failure()

run: |

echo "High risk performance issue detected!" | \

curl -X POST -d @- ${{ secrets.SLACK_WEBHOOK }}

10. 经验教训与最佳实践 💡

10.1 踩过的坑

- 指标采样率不足:默认 15s 采样漏掉瞬时峰值,调整为 5s;

- LLM 建议不可靠:有时推荐无效索引,需结合执行计划验证;

- 测试环境数据偏差:测试库数据量小,无法复现生产慢查询,需用生产数据脱敏回放。

10.2 最佳实践

- 分层诊断:先定位环节(DB/App),再深入细节(SQL/代码);

- 风险分级:只对 High 风险 SQL 自动优化,Medium/ Low 人工 review;

- 灰度验证:优化先在小流量验证,再全量。

11. 结语:AI 不是取代性能工程师,而是放大专业价值 💪

这次实践让我深刻体会到:AI 不会取代性能工程师,但会取代不用 AI 的性能工程师。

我们没有消除性能团队,而是让他们从“日志翻查员”升级为“性能策略师”:

- 定义业务关键路径

- 优化 AI 诊断模型

- 制定自动化优化策略

性能测试的未来,不是更多压测脚本,而是更智能的瓶颈诊断。如果你也在被性能问题折磨,不妨迈出第一步:用 AI 监控工具分析慢查询,让压测通过率从 60% 飙升至 98%。或许下一个大促零故障,就在你的掌控之中。🌟

🔗 实用资源(均可访问):

📈 系统架构图:

回望整个探索过程,AI 技术应用所带来的不仅是效率的提升 ⏱️,更是工作思维的重塑 💭 —— 它让我们从重复繁琐的机械劳动中解放出来 ,将更多精力投入到创意构思 、逻辑设计 等更具价值的环节。或许在初次接触时,你会对 AI 工具的使用感到陌生 🤔,或是在落地过程中遇到数据适配、模型优化等问题 ⚠️,但正如所有技术变革一样,唯有主动尝试 、持续探索 🔎,才能真正享受到 AI 带来的红利 🎁。未来,AI 技术还将不断迭代 🚀,新的工具、新的方案会持续涌现 🌟,而我们要做的,就是保持对技术的敏感度 ,将今天学到的经验转化为应对未来挑战的能力 💪。

如果你觉得这篇文章对你有启发 ✅,欢迎 点赞 👍、收藏 💾、转发 🔄,让更多人看到 AI 赋能的可能!也别忘了 关注我 🔔,第一时间获取更多 AI 实战技巧、工具测评与行业洞察 🚀。每一份支持都是我持续输出的动力 ❤️!

如果你在实践 AI 技术的过程中,有新的发现或疑问 ❓,欢迎在评论区分享交流 💬,让我们一起在 AI 赋能的道路上 🛤️,共同成长 🌟、持续突破 🔥,解锁更多工作与行业发展的新可能!🌈

更多推荐

已为社区贡献177条内容

已为社区贡献177条内容

所有评论(0)