不懂代码也能造?TRAE+GLM-4.6 手把手教你搭心理咨询智能客服小程序

本文记录编程新手借助GLM-4.6模型和TRAE智能体,从零开发跨平台智能客服小程序的过程。后端用Python/FastAPI调用智谱AI的智能体及知识库API,前端以uni-app实现微信、抖音多平台兼容。文中详述通过AI协作完成技术选型、代码编写、调试测试等环节,强调“问题拆解+精准提问”的协作方法,最终半天内完成具备心理咨询问答功能的应用,验证了AI辅助开发的可行性,为技术小白提供可复制路径

目录

public class SelfIntroduction {

public static String introduceMyself() {

String name = "攻城狮7号";

String role = "Tech Enthusiast";

String[] likes = {"coding", "coffee", "tech blogs"};

String likesJoined = String.join(", ", likes);

return "Hi! I'm " + name + " – a " + role + " who loves " + likesJoined + ". Nice to connect!";

}

public static void main(String[] args) {

System.out.println(introduceMyself());

}

}🎬 攻城狮7号:个人主页

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 TRAE+GLM-4.6

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言

在完全没有前后端基础的情况下,如何借助现代化的AI辅助开发环境(国内版TRAE)和先进的AI编程大模型(以GLM-4.6为例),从零开始,为一个心理咨询公司开发并部署了一款功能完善、支持跨平台(微信、抖音)的智能客服小程序的完整历程。文章将详细拆解从需求分析、技术选型、后端搭建、前端开发到最终闭环的每一步,并分享在此过程中如何高效利用AI解决实际编程问题,希望能为同样想踏入编程世界但又心怀忐忑的朋友们提供一份真实可行的实践指南。(文末提供完整项目代码)

一、背景:企业“提效”与 全天在线智能客服的现实需求

我接触到的很多中小企业都在做同一件事:用 AI 把重复、标准、可流程化的工作先替换下来。客服是最典型的场景之一。以心理咨询公司为例,访客会在非工作时间(晚上、周末)频繁咨询:预约流程、价格、资质、隐私、危机干预渠道……人工很难做到 24×7 在线,更难把“每次问答”稳定地输出到同样的水准。

需求很明确:

-

让“智能客服”先挡在前面,能理解问题、检索本机构规章知识、稳定输出答案;

-

真正需要人工介入时再转接;

-

最好“一套代码”能覆盖微信、抖音等平台,以便同一个团队维护;

-

能随着内容和服务发展快速更新,而不是重写。

假如这项工作交给一个没有学过任何编程或者只懂一点皮毛的人员负责,到底能不能完成?

这篇文章要做的,就是教技术小白或者零基础的人用 TRAE 加 GLM-4.6,搭一个“统一小程序开发环境”,把后端接入智谱 AI 的“智能体 API”结合知识库,前端用官方推荐生态与跨平台方案统一产出,实现“同一套开发体验 → 多平台产物”的目标。

二、直面挑战:一个“小白”的灵魂拷问

决定要做之后,技术小白可能会面临一连串的问题:

-

从哪儿开始? 我应该先学Python还是JavaScript?是先做那个能看到界面的“前端”,还是先做那个看不见摸不着的“后端”?我完全没有头绪。

-

技术怎么选? 朋友的需求是小程序,微信和抖音都要有。我听说过微信小程序开发工具,但抖音呢?难道要我写两套完全不同的代码吗?这对我来说简直是天方夜谭。后端又用什么?服务器怎么部署?数据库是什么?每一个名词都像一座大山。

-

AI如何帮我? 我知道ChatGPT、知道智谱清言,它们能写文案、能聊天。但是,它们真的能写出可以运行的、复杂的项目代码吗?我该如何向它提问?是直接说“帮我写个客服小程序”,还是需要我把问题拆解成一个个微小的步骤?这种“与AI协作”的模式,对我来说完全是未知的。

-

知识库怎么实现? 智能客服的核心是能准确回答与公司业务相关的问题。这意味着AI需要学习我们公司的资料,比如服务项目、咨询师介绍、收费标准、预约流程等。我该如何把这些“知识”喂给AI?

-

遇到Bug怎么办? 这是我最恐惧的一点。专业程序员尚且会被Bug折磨得夜不能寐,我一个门外汉,看到满屏的红色错误代码,恐怕除了重启电脑,什么也做不了。

这些问题像一张大网,将不懂技术的人牢牢困住,他们可能意识到,单靠传统的“搜索引擎+论坛学习”模式,可能在第一个星期就会放弃。现在需要一个全新的解决方案,一个能够“手把手”带这些人走出迷宫的“导师”。

三、实战演练:一步步把想法变成现实

接下来,我将详细记录我是如何与我的AI搭档协作,分阶段完成整个项目的。

3.1 准备工作:为我的AI搭子“入魂”

在正式敲下第一行代码之前,我做了最重要的一件事:为我的AI搭子设定“灵魂”。这正是TRAE理念的核心之一。我没有直接开始问“怎么做”,而是先通过TRAE的设置为我的AI助手设定了角色和沟通方式,这为我们后续的合作打下了坚实的基础。

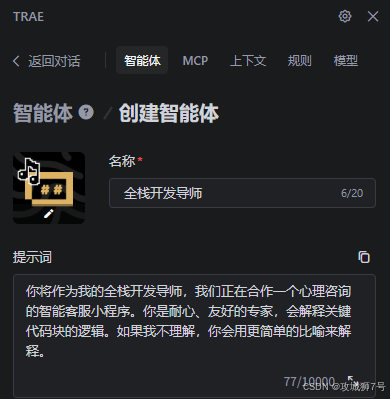

首先如下设置自定义智能体:

设置项目规则,至于使用什么开发语言和框架,暂时不确定:

这些设置就像是项目的“启动配置文件”,确保了我们整个协作过程都在一个统一的框架内,极大地提升了沟通效率。

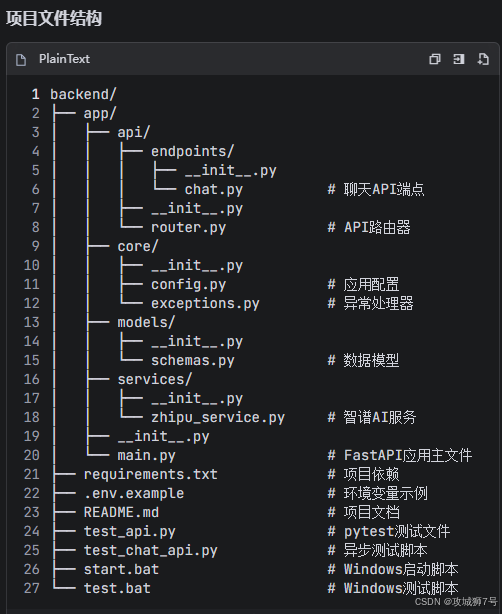

3.2 搭建智能“大脑”——后端服务

我首先要做的,是那个看不见但至关重要的后端。它就像我们客服的“大脑”,负责接收用户的问题,并调用大模型生成回答。

3.2.1 技术选型与环境配置

我向GLM-4提出的第一个问题是:

我:“你好,我是一个编程新手。我想用Python3.9做一个后端API服务,它需要接收微信小程序前端发来的用户问题,然后调用智谱AI智能体和知识库的API来获取答案。这个服务要尽可能简单、高效。我该用什么框架?注意先回答问题别创建项目。”

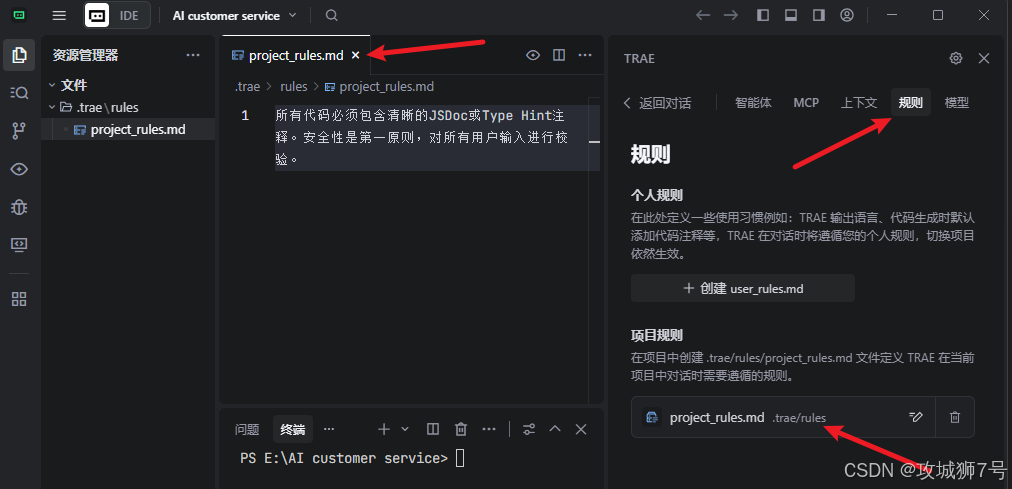

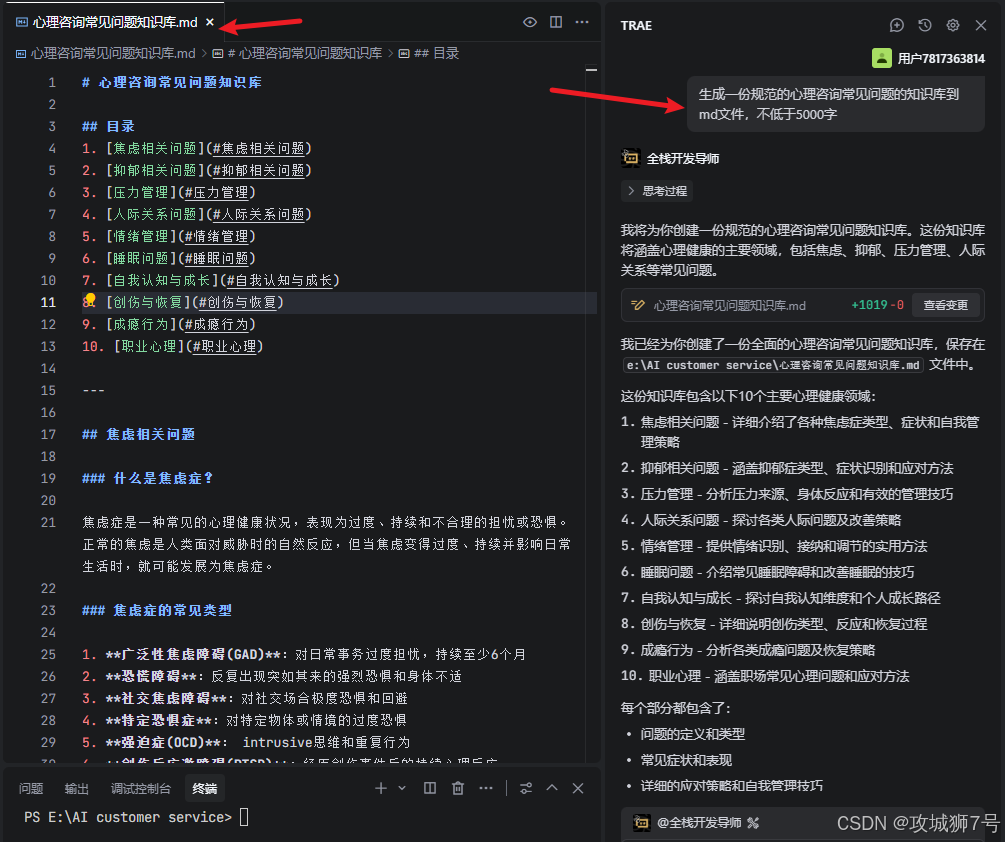

接着GLM-4.6会给出以下详细的回答:

这个回答清晰明了,接着我先安装好Python3.9环境,安装教程在此不叙述。

3.2.2 创建专属知识库和智能体

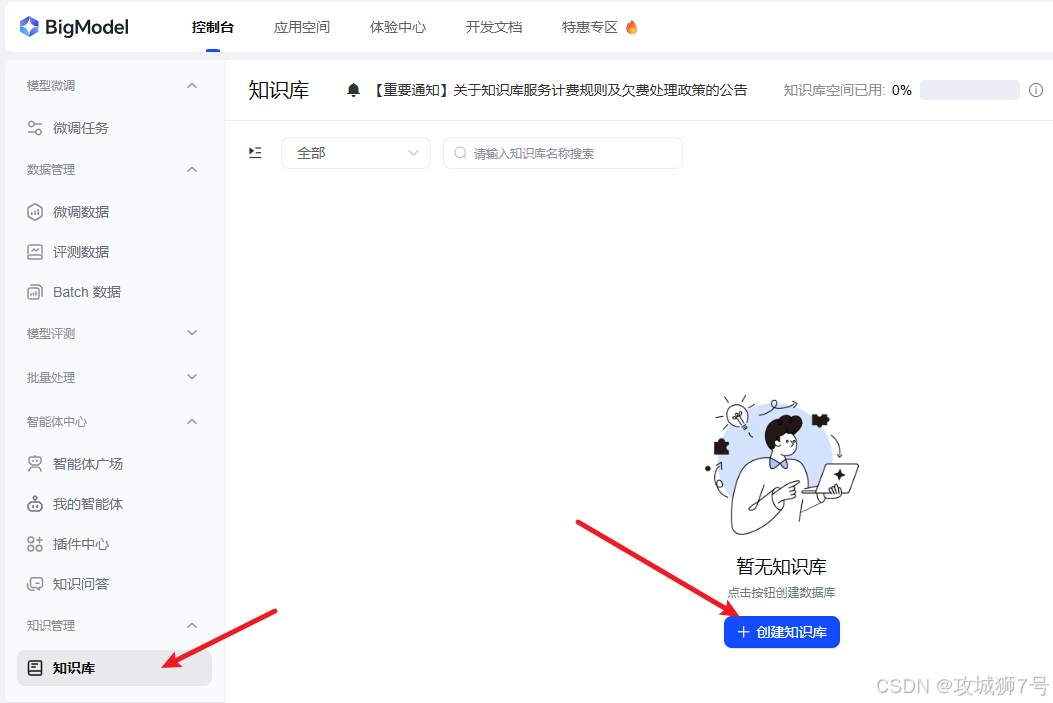

智能客服不能天马行空地乱答,它必须依据心理咨询公司的资料来回答。这里用到智谱AI开放平台的知识库和智能体功能。

-

知识库:可以把行业提供的所有资料,包括Word文档、PDF手册等各种,都整理好。登录智谱AI开放平台,进入“知识库”模块,创建了一个名为“心理咨询常见知识库”的库,然后把这些文件一股脑儿地传了上去。平台会自动对这些文件进行解析、向量化,这个过程对于小白来说就是个“黑箱”,不需要懂其中的复杂技术,只需要知道,现在AI有“学习资料”了。

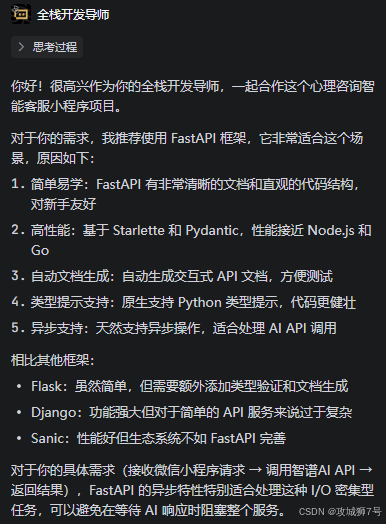

不过现在是模拟知识库,测试开发阶段可以模拟一份数据,这个时候就考验GLM4.6的写作能力了。

写出来的文档水平确实可以,这时候可以将这个md文件按如下步骤导入知识库了

-

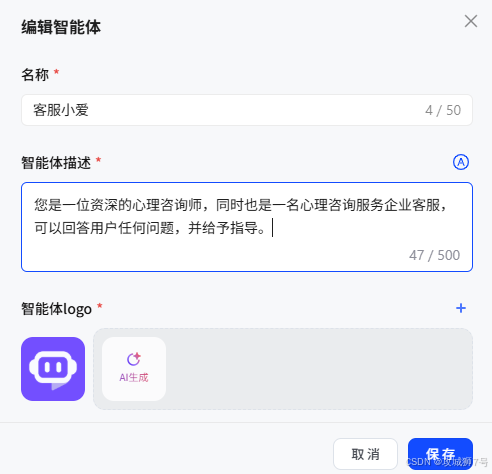

智能体:如果说知识库是教科书,那智能体就是学习了这些教科书的学生。我在平台上根据一个客服智能体模板创建了一个“客服小爱”智能体。我还为这个智能体设置了“人设”(Prompt)。

同时也别忘了拿到调用api的秘钥:

这样,就模拟拥有了一个定制化的、掌握了公司业务知识的AI大脑。我甚至可以在平台的调试界面直接跟它对话,测试效果。

3.2.3 GLM-4.6编写后端项目及调试

接下来是最激动人心的一步:写代码!当然,是“指导”AI写代码。

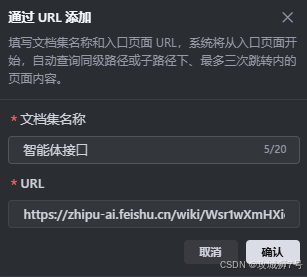

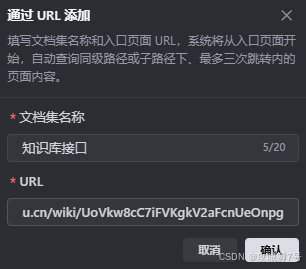

这个后端要用到智谱AI开放平台的智能体API和知识库API,这里刚好可以使用TRAE的上下文功能设置,如下:

如下是从智谱AI开放平台官网获取到的接口网页:

智能体接口文档:

知识库接口文档:

接着就是在上面的上下文中设置通过URL添加,自此编程智能体会通过这些文档查到接口的使用方法。

一切准备工作就绪后,我会按下面提问我自定义的智能体和GLM-4.6:

我:“Python3.9我已经安装,请帮我用FastAPI(我们已选定的后端框架)创建好项目框架,并创建一个用户和智能体提问的接口,至于如何实现,其中要调用智谱AI的智能体API和知识库api,api相关文档请参见上下文的设置,如果知识库中有答案就结合回答返回,也就是把提问的问题发送给智能体和知识库,看看他们是如何最终把回答返回给前端。请在代码中留出填写API Key和智能体ID,知识库id的位置。写好了请提供测试样例看看效果。”

我在提问时,特意强调这个关键上下文,确保AI能在我们约定的框架内思考,而不是随意给出一个用其他框架(如Flask、Django)的方案。

几秒钟后,GLM-4给出了完整的代码文件,如下所示:

在此我们可以一瞥GLM-4.6生成的python后端代码质量(main.py):

from fastapi import FastAPI

from fastapi.middleware.cors import CORSMiddleware

from fastapi.exceptions import RequestValidationError

from starlette.exceptions import HTTPException as StarletteHTTPException

from app.core.config import settings

from app.api.router import api_router

from app.core.exceptions import (

http_exception_handler,

validation_exception_handler,

general_exception_handler

)

# 创建FastAPI应用实例

app = FastAPI(

title=settings.app_name,

description="心理咨询智能客服API服务",

version="1.0.0",

docs_url="/docs",

redoc_url="/redoc"

)

# 配置CORS中间件,允许微信小程序跨域访问

app.add_middleware(

CORSMiddleware,

allow_origins=["*"], # 在生产环境中应该指定具体域名

allow_credentials=True,

allow_methods=["*"],

allow_headers=["*"],

)

# 包含API路由

app.include_router(api_router, prefix="/api/v1")

# 添加异常处理器

app.add_exception_handler(StarletteHTTPException, http_exception_handler)

app.add_exception_handler(RequestValidationError, validation_exception_handler)

app.add_exception_handler(Exception, general_exception_handler)

# 根路径

@app.get("/")

async def root():

"""

根路径,返回API信息

"""

return {

"message": f"欢迎使用{settings.app_name}API",

"version": "1.0.0",

"docs": "/docs"

}

# 健康检查端点

@app.get("/health")

async def health_check():

"""

健康检查端点

"""

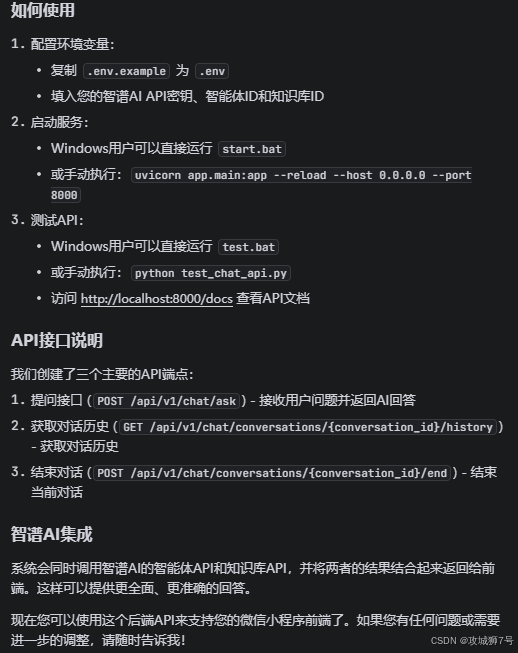

return {"status": "healthy"}不知道如何部署环境调试运行,没关系,智能体和GLM4.6大模型会自动帮你解决

比如我直接提问:我现在应该如何部署环境运行测试该项目接口

然后他就会根据目录下的backend\requirements.txt安装相关的python库:

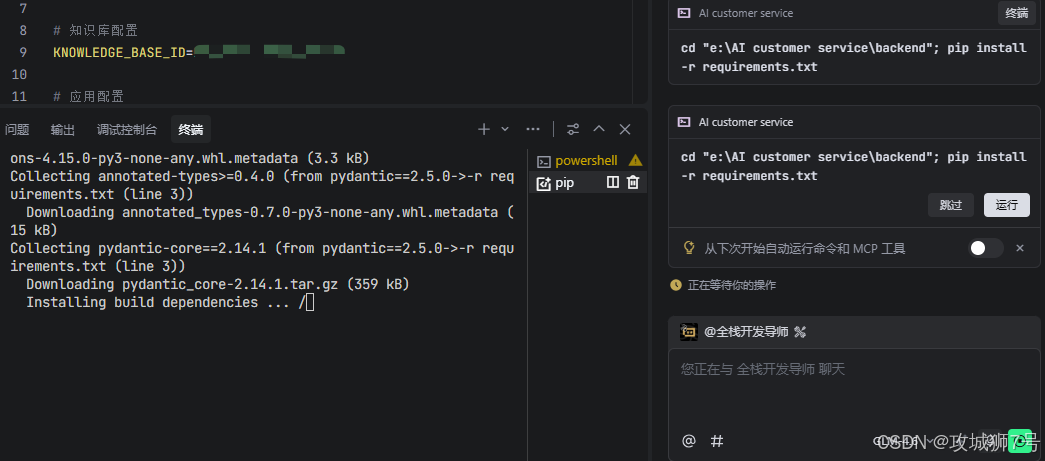

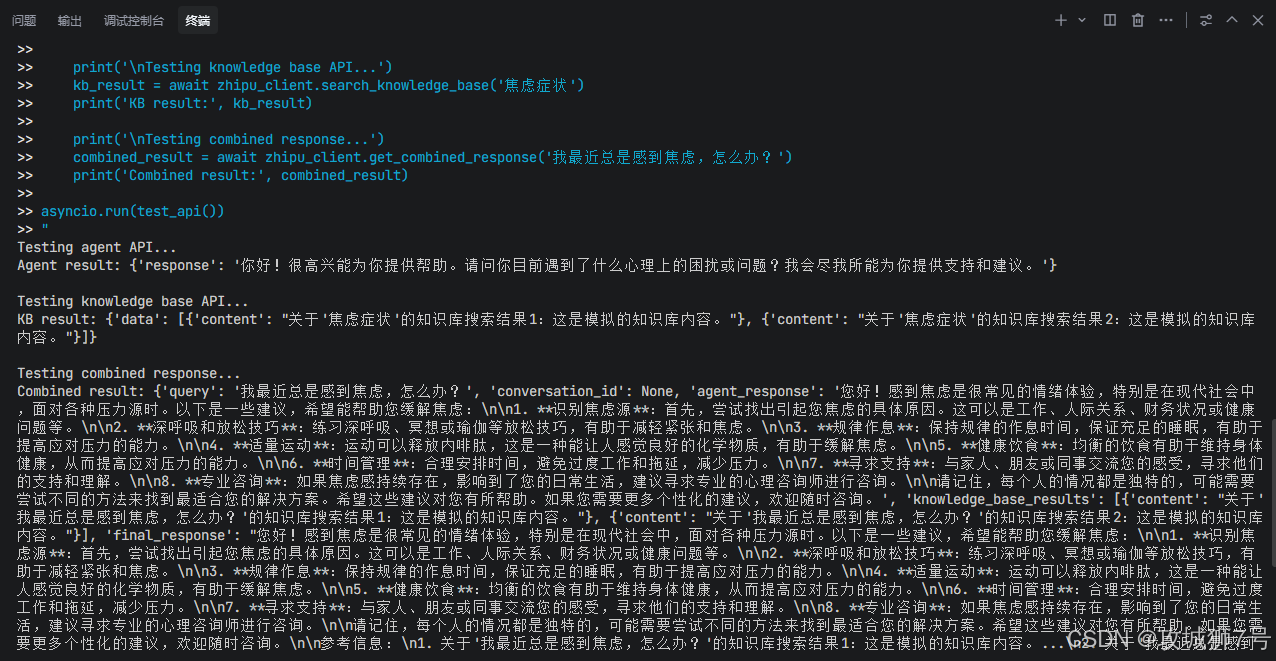

安装完成后它居然自动给我进行调试接口,这个智能体确实不错,如下可以看到终端的调试过程日志

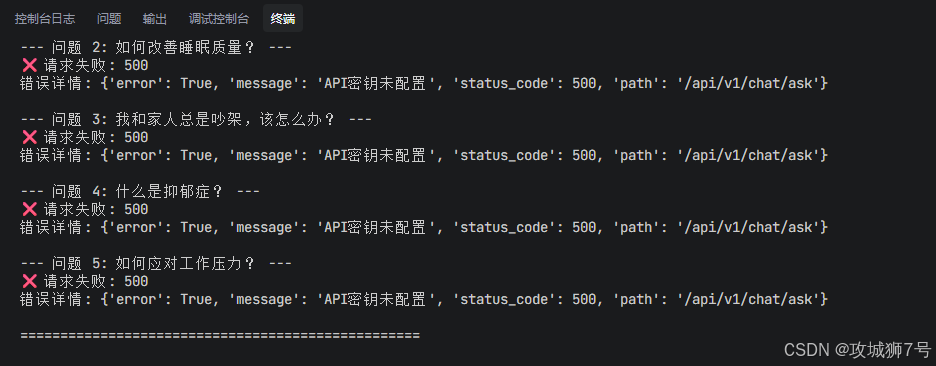

如果一次修改不成功,它就会孜孜不倦的继续进行修改调试,如下:

直到测试接口终于请求成功,但是回答却令人抓狂,到底是哪里出了问题,不急,继续交给我的全栈开发导师即可

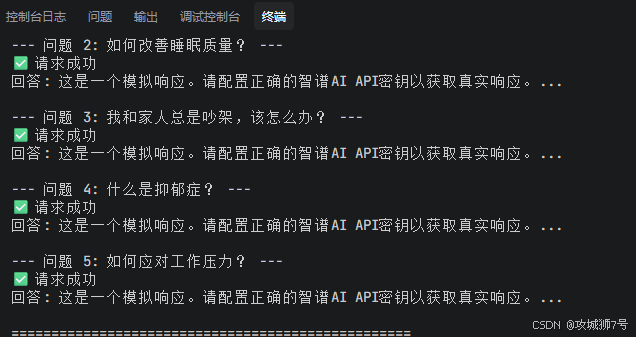

经过智能体的提示,原来我的智能体id,知识库id,api key都还没正确设置在.env文件,在智谱官网获取即可

但如果出现一次性自动思考的次数太多,达到上限会进行暂停,但是不用慌,我们点击继续即可

经过几轮的修改调试,还是出现如下问题:

这个时候就要中断智能体的操作了,我可以及时修正它的思路,比如我提出如下问题:

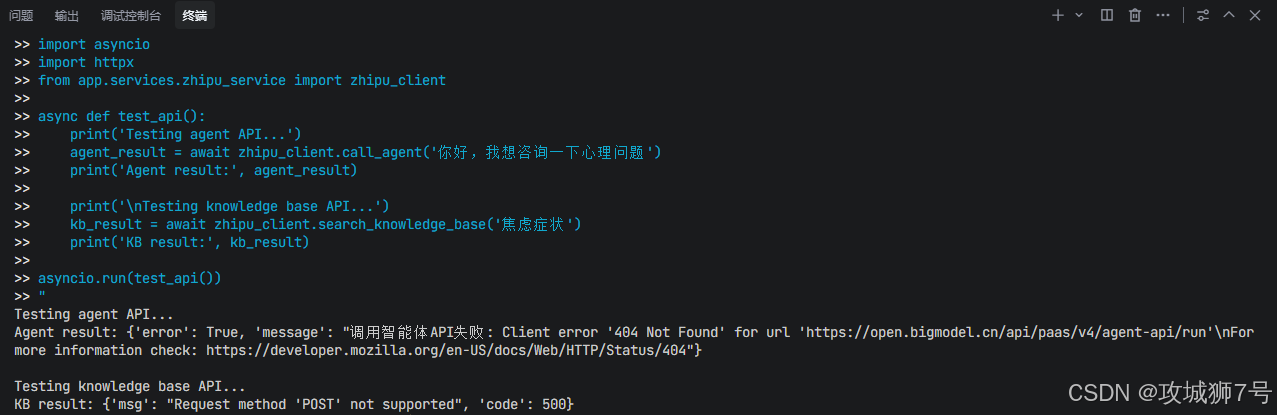

接着它会通过自己创建的测试接口进行自测,发现智能体API调用出错

接着他会再次查询之前设置的上下文,因为这是关于接口的使用文档,比如查询如下

经过再次查询API文档,再次修改便成功返回数据:

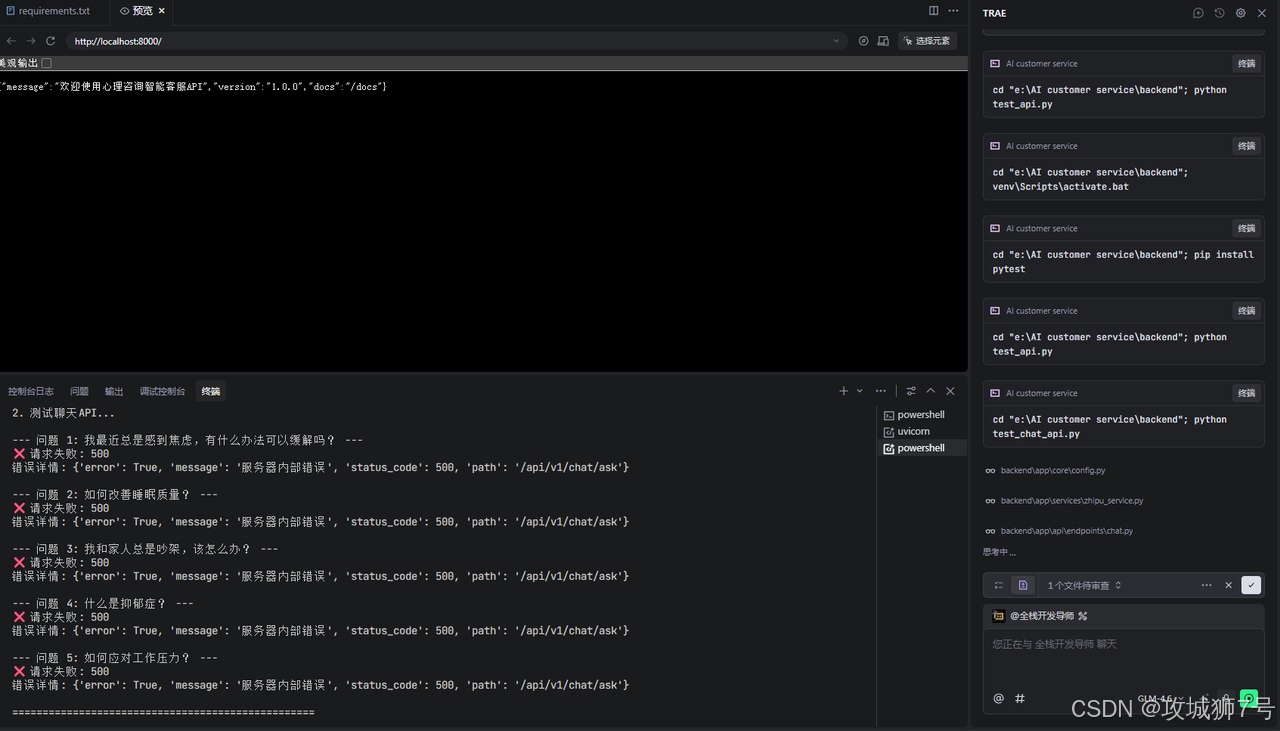

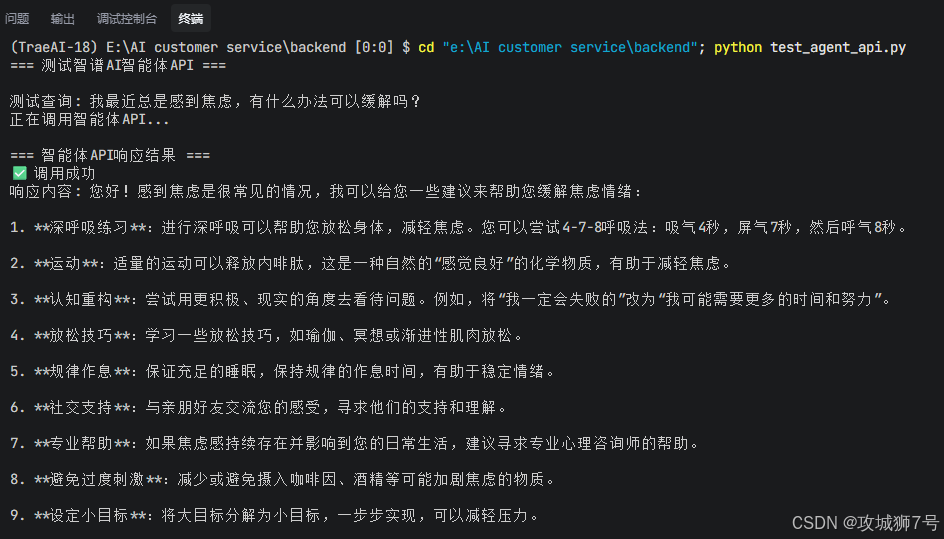

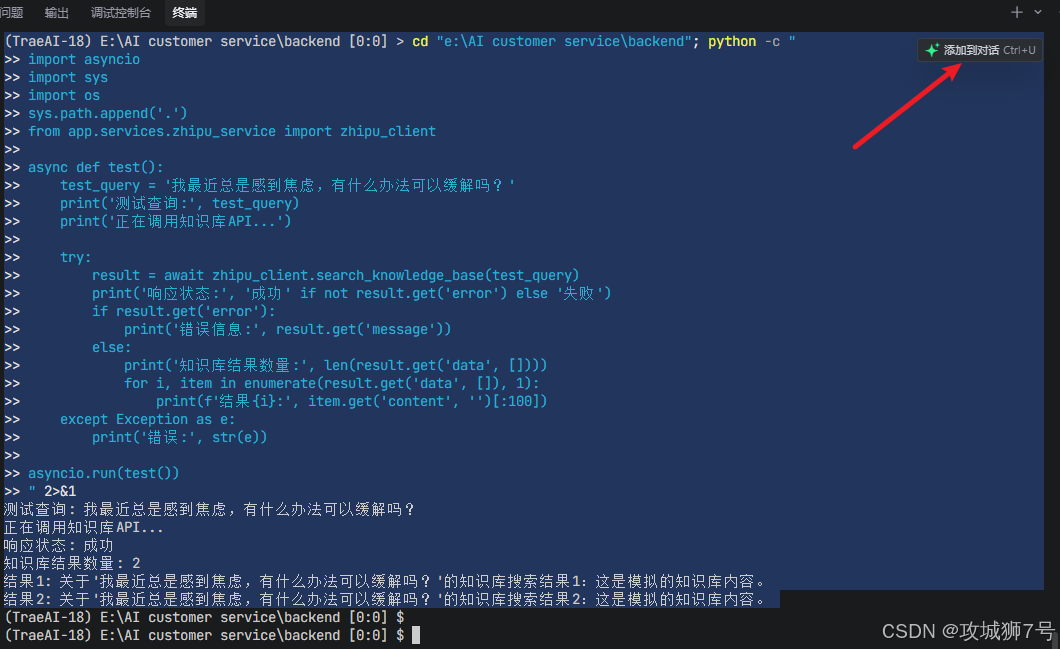

比如它会自动执行 cd "e:\AI customer service\backend"; python test_chat_api.py

在终端可以看到请求成功,回答正确的日志

如果觉得还是有问题,我可以如下提问,进一步排查隐患问题:

比如调用测试智能体api接口如下,没啥问题:

接着它继续自动测试知识库api的接口返回如下,感觉有问题:

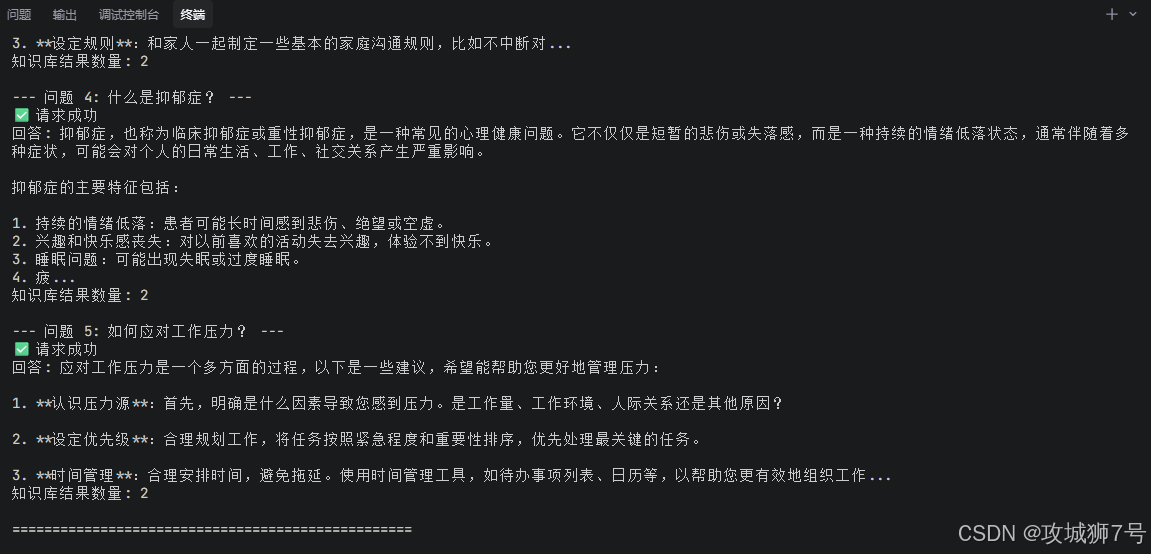

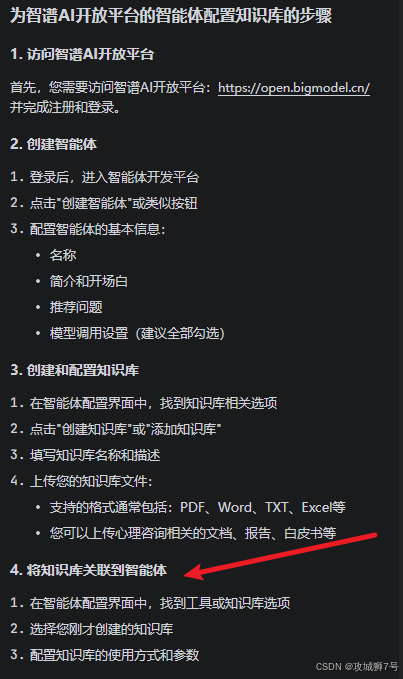

后面经过追问,原来我的全栈开发大师居然从知识库md文件直接获取了答案进行回复,由此我要及时纠正,并且问他:如何为智谱AI开放平台的智能体配置知识库?

思考了一会,我的开发导师回复如下:

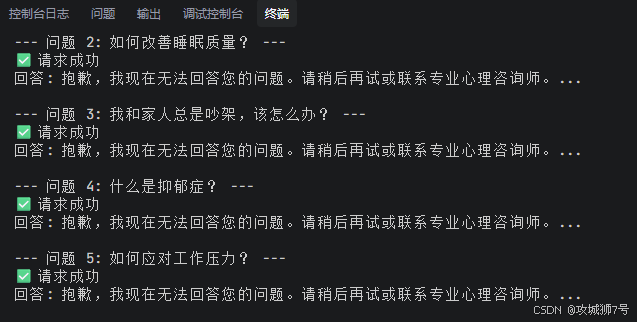

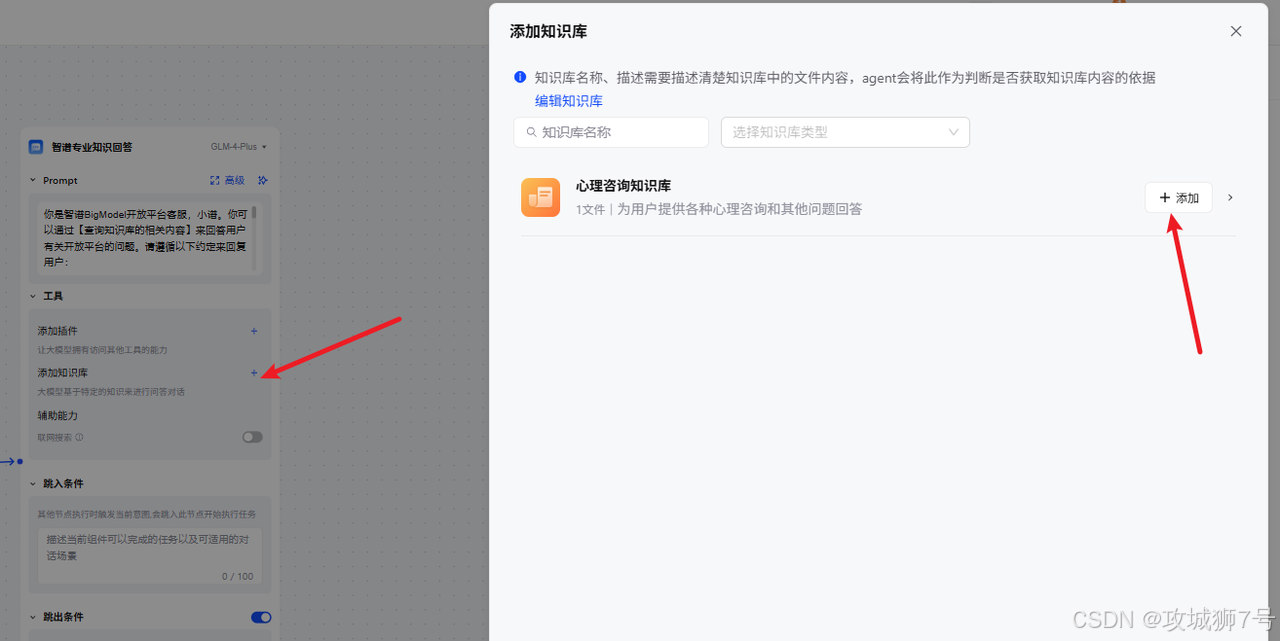

然后我根据它的答案在智谱开放平台上找到给智能体添加知识库的地方,到时直接调用智能体API就能参考知识库了,不用另外调用知识库的API。

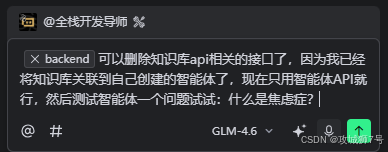

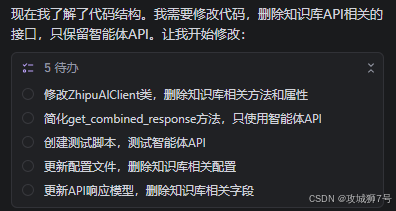

接着我向我的导师下达如下指令去掉知识库API并再次测试:

接着,我的智能体导师进行了如下修改步骤:

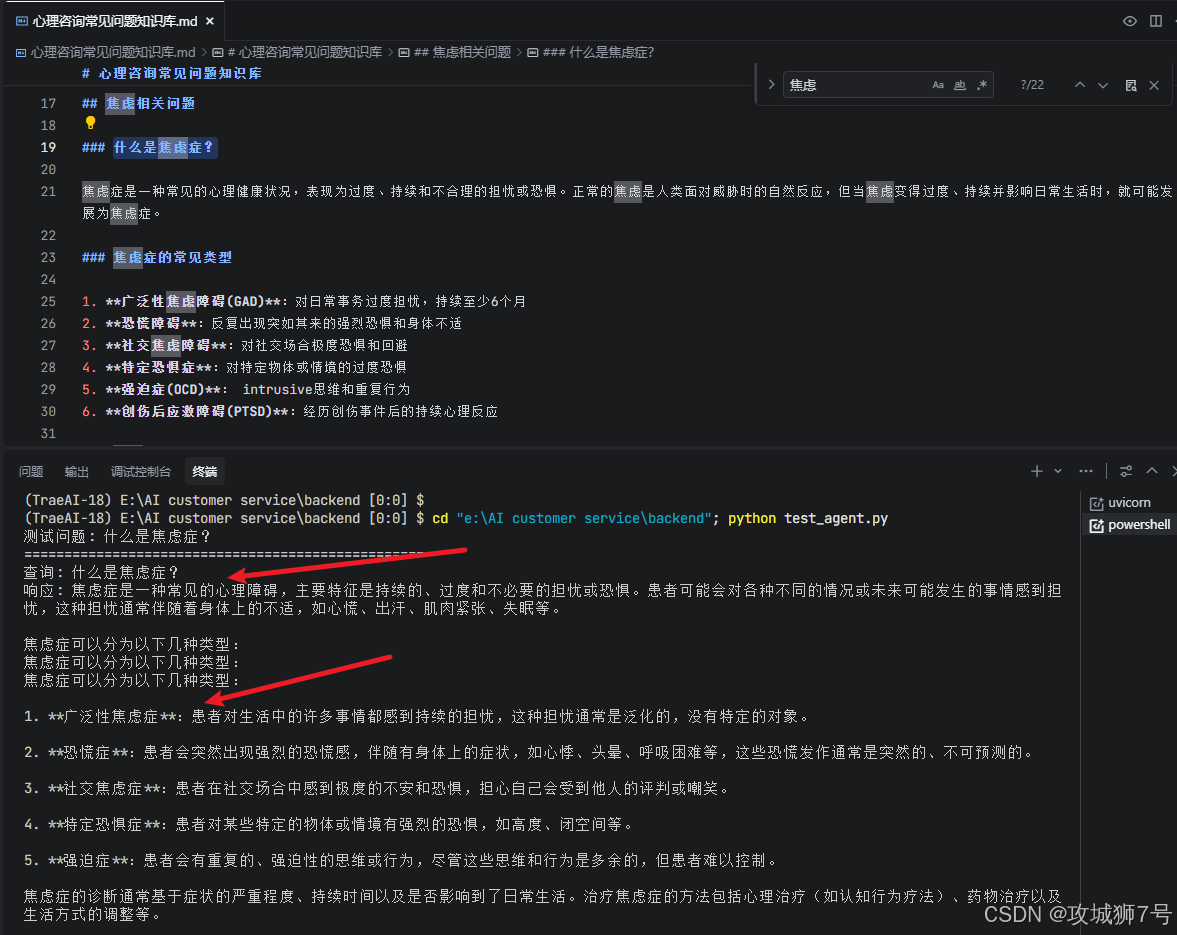

修改后,测试接口果然能正确返回和知识库差不多的心理咨询答案:

智能体每次自测都会如下进行后端服务启动

--- 启动命令 ---

在终端中运行: cd "e:\AI customer service\backend"; uvicorn app.main:app --reload

--reload 会在代码变更后自动重启服务,非常适合开发阶段

总之我几乎没怎么修改,我只是把API Key和智能体ID填了进去env文件。GLM-4.6 甚至贴心地加入了跨域配置、数据校验、异常处理,并写清了注释,告诉我每一块代码是干什么的,以及如何在终端启动服务。 看到服务成功运行的提示时,我感觉自己打开了新世界的大门。后端“大脑”,成了!

3.3 打造交互“面孔”——前端小程序

后端服务已经跑起来了,现在我需要为用户提供一个可以与之交互的小程序界面。

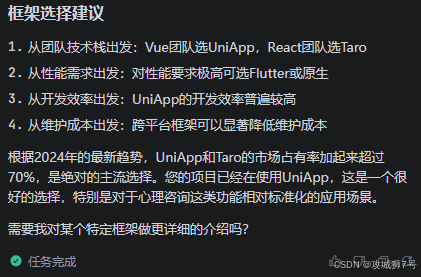

3.3.1 求助AI:小程序跨平台框架选择

接着我会向GLM-4.6进行提问:如果打造全平台兼容的小程序,有哪些技术框架可以提供选择?

不一会它会对比各自技术框架给出以下总结建议给你选择:

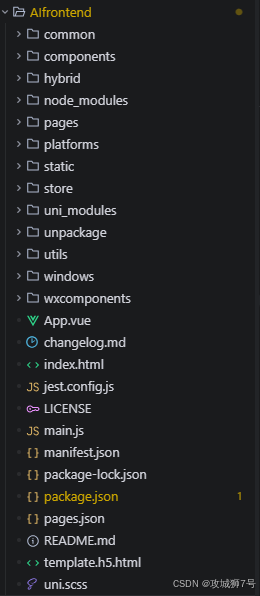

由此我便找到知名的HBuilderX软件自动生成的uni-app的项目模板,如下创建一个frontend名称的小程序项目模板:

这个模板在后面会大有用处,请看后面操作。

3.3.2 GLM-4.6仿造uni-app小程序项目

对于怎么快速了解项目模板,可以先从其主入口文件 main.js 开始,如下:

import App from './App'

import store from './store'

// #ifndef VUE3

import Vue from 'vue'

Vue.config.productionTip = false

Vue.prototype.$store = store

Vue.prototype.$adpid = "1111111111"

Vue.prototype.$backgroundAudioData = {

playing: false,

playTime: 0,

formatedPlayTime: '00:00:00'

}

App.mpType = 'app'

const app = new Vue({

store,

...App

})

app.$mount()

// #endif

// #ifdef VUE3

import {

createSSRApp

} from 'vue'

import * as Pinia from 'pinia';

import Vuex from "vuex";

export function createApp() {

const app = createSSRApp(App)

app.use(store)

app.use(Pinia.createPinia());

app.config.globalProperties.$adpid = "1111111111"

app.config.globalProperties.$backgroundAudioData = {

playing: false,

playTime: 0,

formatedPlayTime: '00:00:00'

}

return {

app,

Vuex, // 如果 nvue 使用 vuex 的各种map工具方法时,必须 return Vuex

Pinia // 此处必须将 Pinia 返回

}

}

// #endif但是对于小白而言,有了AI的加持,我们可以不用对项目模板做深入了解,想了解什么,直接问我们的AI智能体就行。

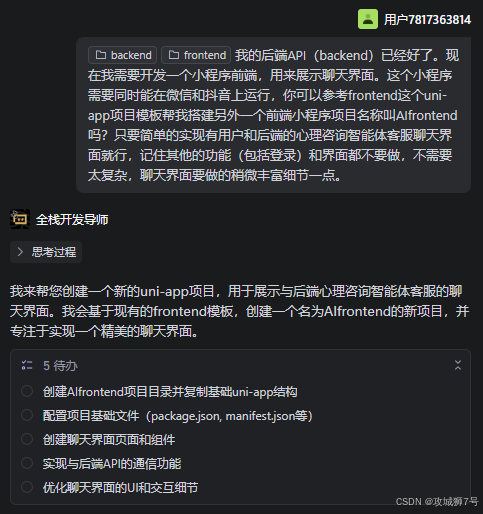

接着我开始对GLM-4.6模型的开发导师智能体提问:

> 我:“我的后端API(backend)已经好了。现在我需要开发一个小程序前端,用来展示聊天界面。这个小程序需要同时能在微信和抖音上运行,你可以参考frontend这个uni-app项目模板帮我搭建另外一个前端小程序项目名称叫AIfrontend吗?只要简单的实现有用户和后端的心理咨询智能体客服聊天界面就行,记住其他的功能(包括登录)和界面都不要做,不需要太复杂,聊天界面要做的稍微丰富细节一点。”

接着我的智能体导师结合GLM-4.6模型快速根据项目模板从零创造了一个AIfrontend前端小程序项目:

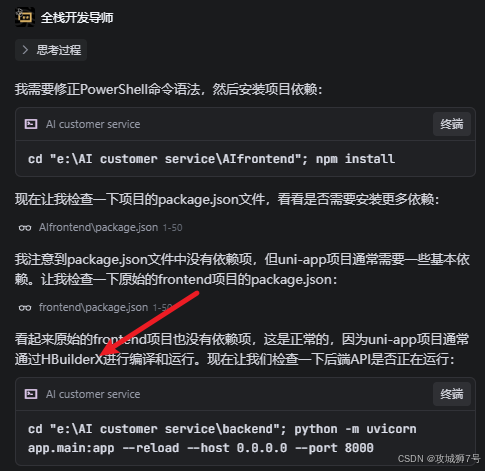

创建完毕我的项目后,他居然自动思考如何运行,如下:

从他的思考过程我看出可以直接通过HBuilderX软件运行,HBuilderX 是一款由 DCloud 开发的集成开发环境(IDE),专为前端开发者设计。它有多种平台小程序运行环境模拟器,用它调试运行自然最合适不过了。

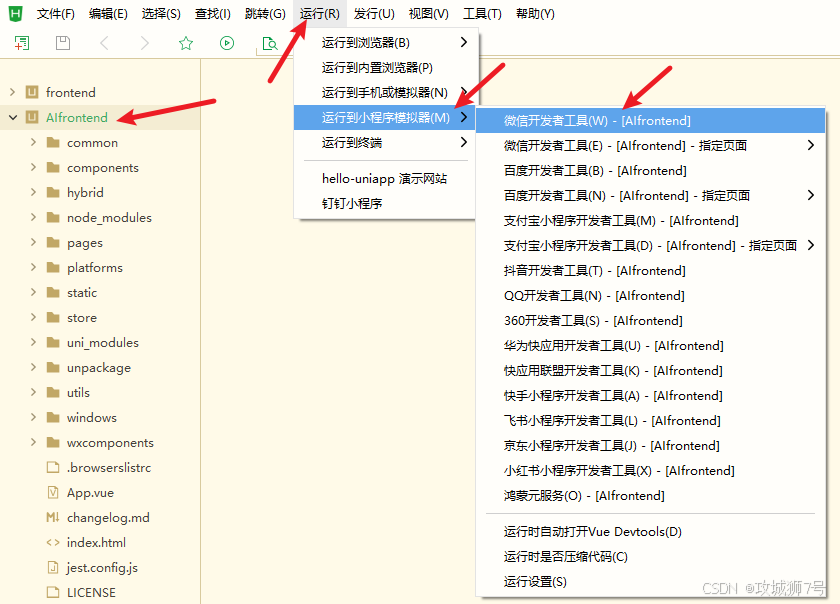

3.3.3 HBuilderX运行调试微信小程序

接着我用HBuilderX打开了AIfrontend文件夹,准备以微信小程序的方式运行调试项目,如下先设置自己已经注册微信小程序获得的AppID:

至于如何获取这个AppID,自己注册小程序后,进入后台如下位置就能获取:

设置完AppID后,在HBuilderX中如下运行小程序,运行之前自己可以自行搜索微信开发者工具进行安装先:

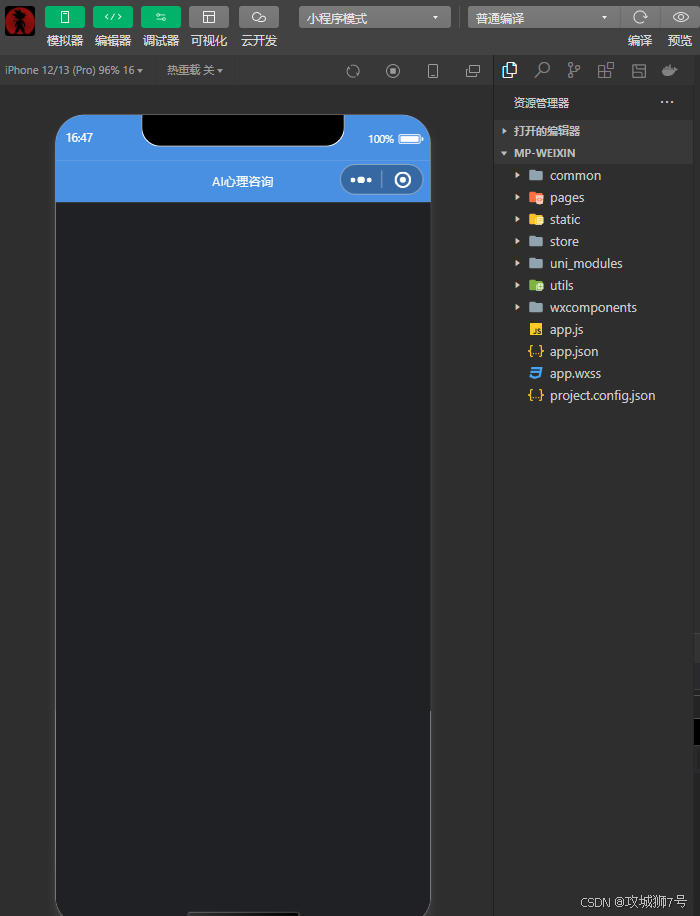

运行后,会打开如下模拟预览运行界面:

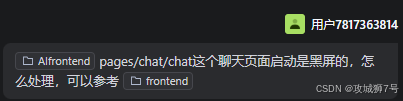

但是发现是黑屏,不用急,万事有智能体开发导师,接着我会进行如下提问:

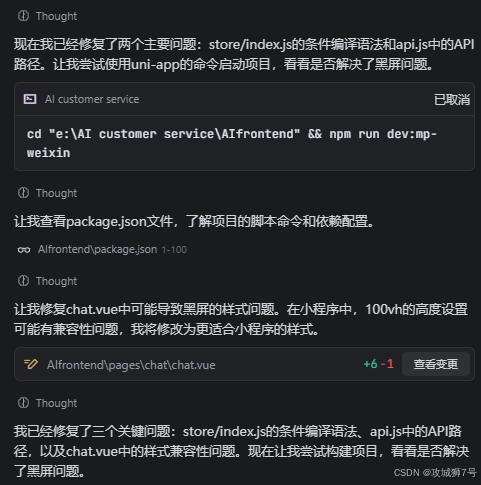

不一会他就自动帮我解决问题,不用我为一行代码操心:

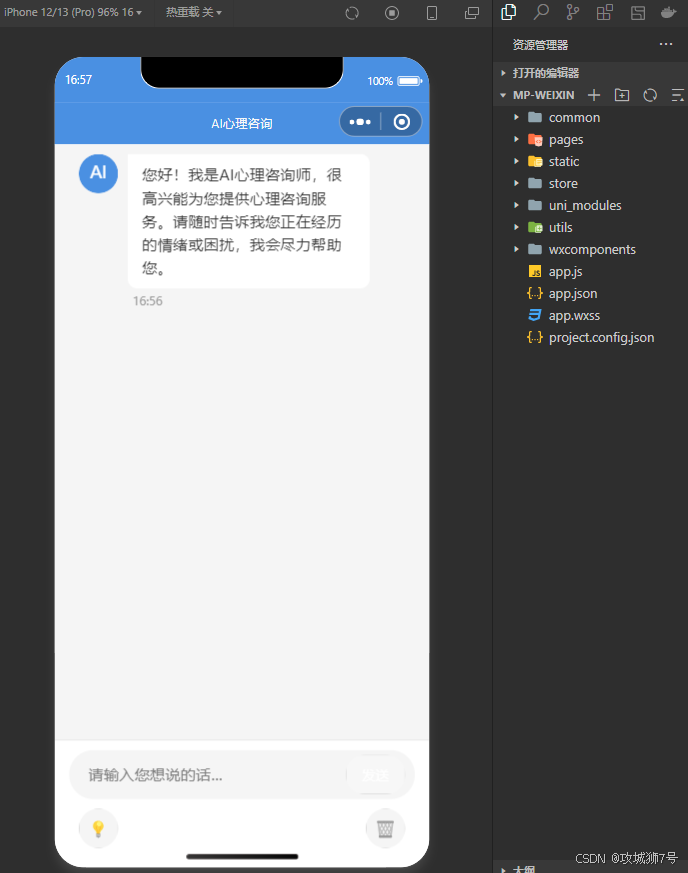

修改后,果然立马实时更新预览,正常显示如下:

3.3.4 测试连接前后端

接着是测试连接前后端,前端和后端打通。

在TRAE内你可以直接叫智能体启动后端服务,不一会他就会自动执行下面命令:

cd "e:\AI customer service\backend"; python -m uvicorn app.main:app --reload --host 0.0.0.0 --port 8000

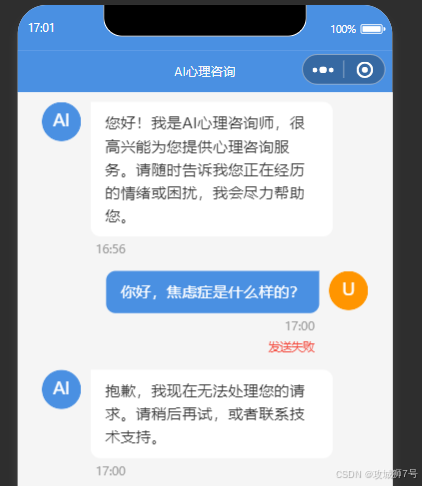

后端服务启动后,我首先如下发送一条消息给后端:

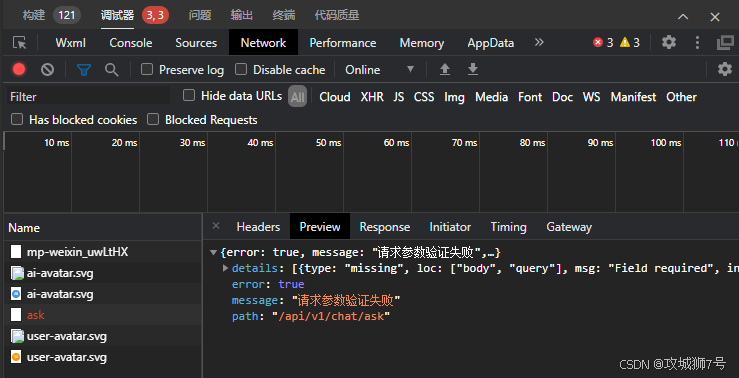

第一次不出所料的报错,然后我在HBuilderX的调试器中的Network中找到出错的接口:

然后再把问题抛给我的开发智能体导师,如下:

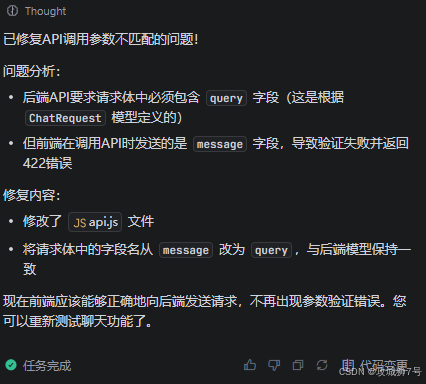

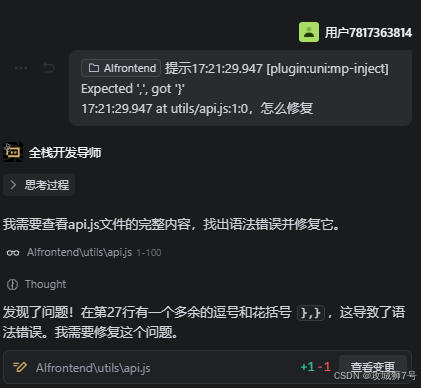

接着我再次运行小程序,居然在HBuilderX运行报错

没事,继续把问题抛给智能体解决:

不一会,开发导师解决的速度就是快,一下子就能看到测试成功了:

TRAE里面的后端服务终端也提示访问成功 200 :

通了!原来小白真的做出了一个能用的AI应用!至于后面的部署上线,大家可以自行查看官方教程或其他资料,在此不再叙述!后面大家也可以在此基础上继续完善其他功能。

四、总结与分享

这次我主要使用了GLM-4.6模型,这次总体的使用感悟就是,虽然它现在很强大,但也不能全部依赖AI,要懂得在AI胡思乱做的时候,敢于制止中断它的引导,中途我们可以随时分析它的思考过程找问题,如果方向一旦不对,你可以立马给它矫正思考方向。至于TRAE给我的最大感受就是智能体自动化工作流成熟,结合的国内大模型也相当给力。

从零开始交付一个完整前后端应用,我只花了小半天的业余时间。这在过去是不可想象的。这次实践,带给我最大的启示是:在AI时代,学习编程的范式已经彻底改变。

我们不再需要按部就班地啃完一本厚厚的教科书,才能开始写代码。我们可以从第一天起,就带着一个明确的目标,让AI成为我们的“领航员”和“加速器”,在实践中学习,在创造中成长。最重要的能力,从“掌握多少语法知识”变成了“如何清晰、准确地描述你的问题和目标”。 当然,这并不意味着人类程序员会被取代。恰恰相反,AI将我们从繁琐、重复的底层代码实现中解放出来,让我们能更专注于架构设计、产品创意和用户体验这些更具创造性的层面。AI是副驾驶,而我们,永远是那个手握方向盘的机长。 不要因为“不懂编程”而犹豫不决,请勇敢地迈出第一步吧。选择一个好的AI搭档,拥抱TRAE的工作理念,你会发现,创造的门槛,从未如此之低。

从今天起,我们每个人,都可以是“开发者”。

完整项目代码下载:https://download.csdn.net/download/linshantang/92241051

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)