如何调用硅基流动平台上免费的 LLM API

本文介绍了如何在 Python 当中调用 Silicon Flow 的 API,为 AI 开发作准备。

如何调用硅基流动平台上免费的 LLM API

对 AI 开发感兴趣的朋友们一定已经尝试过使用 Ollama 或 Xinference 在本地部署 LLM 推理平台,并加载 LLM 模型进行本地推理或 API 调用。但本地部署的 LLM 的推理速度必然是没有直接调用 LLM 供应商提供的 API 来的快的,原因有两点:

- 首先,受开发机显存的限制,本地必然无法部署参数更多的 LLM,只能部署一些

7B/8B参数左右的模型,推理效果不佳; - 其次,在通过 API 接口调用的方式调用本地部署的 LLM 提供服务时,请求通常都是被串行处理的。即使已经有了类似于 vLLM 这种可本地部署的推理平台支持单卡多请求并发,但并发数仍然不会很高(以 16 GB 显存的显卡为例,显卡能够处理的并发请求可能只有两个)。

这个时候我们就需要调用 LLM 供应商提供的 API 来处理我们的请求。调用 LLM 供应商的 API 时,我们请求的并发数不再受显卡显存的限制,并且我们可以向参数更多、更好的模型发起 API 调用的请求。但随之而来的又一个问题是成本问题,使用 LLM 供应商的接口时,每次调用都是需要费用的。

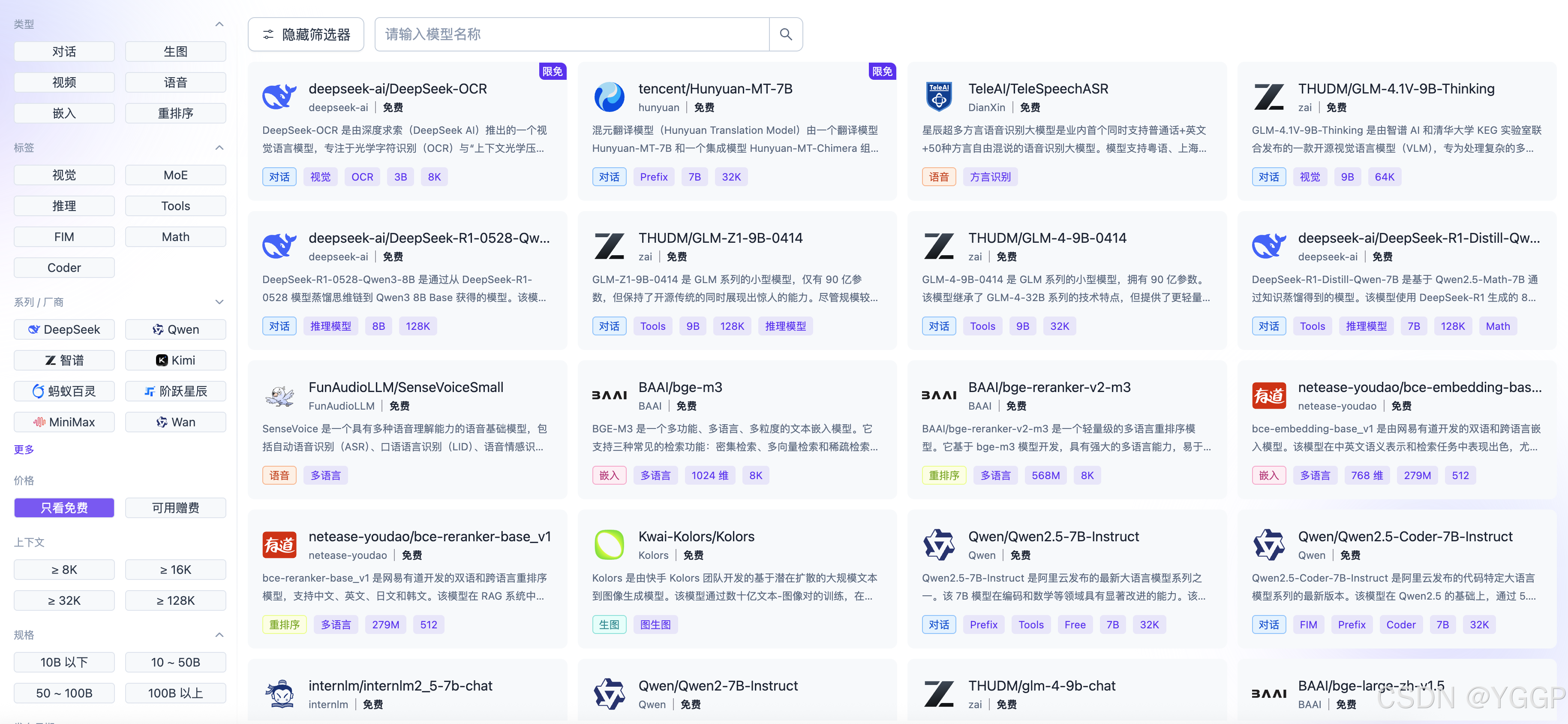

在寻找了众多 LLM 供应商平台之后,我发现硅基流动平台上提供了永久免费的 LLM API 供我们使用,比如Qwen3-8B等。尽管免费开放的模型不是各大 LLM 研究厂商参数最多、最好的模型,但是能够免费地调用最新的模型已经能够满足我们本地 AI 开发的需要了。

对于上个月刚刚发布的 Deepseek-OCR,硅基流动平台更是将该模型 API 调用设置为限时免费,以供我们体验。

可以看到,硅基流动不仅提供了免费的 LLM 模型调用,还提供了 Embedding 模型(BGE)的免费使用,使得我们在本地就可以完成诸如 RAG 等成熟 Pipeline 的开发。

针对 Dify 这种 AI Agent 低代码开发平台,其插件市场已经上架了使用硅基流动 API 的插件。我们只需要到“API 密钥”新建一个 Token,就可以使用了。接下来我将介绍如何在 Python 当中发起一次硅基流动平台的 API 调用。

在 Python 当中调用 Silicon Flow API

在硅基流动平台申请好 Token(需要先免费注册)之后,我们就可以通过下面的脚本来发起一次调用了。调用一次 API 实际上就是发起一次 POST 请求,在 headers 当中携带我们的 Token 即可。这就使得我们可以对 API 调用进行高度的定制:比如,针对需要进行多次 API 并发调用的场景,我们可以使用异步来最大程度地提高网络 I/O 的效率。需要注意的是,对于平台上的免费模型,文档中已经说明了这些模型具有每分钟最多请求数以及最多处理 Tokens 的限制,在使用时需要注意。

要运行下述代码片段,需要申请一个自己的 Token,并选择一个免费的模型,比如Qwen/Qwen3-8B(填写到 MODEL_NAME 当中)。

# main.py

import requests

API_KEY = "your_api_key_here"

MODEL_NAME = "your_model" # 示例模型,可替换为平台支持的其他模型

url = "https://api.siliconflow.cn/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

data = {

"model": MODEL_NAME,

"messages": [

{"role": "user", "content": "介绍一下 CSDN 平台。"}

],

"stream": False # 若需流式响应,设为 True 并处理 SSE

}

response = requests.post(url, headers=headers, json=data)

if response.status_code == 200:

result = response.json()

print(result['choices'][0]['message']['content'])

else:

print("Error:", response.status_code, response.text)

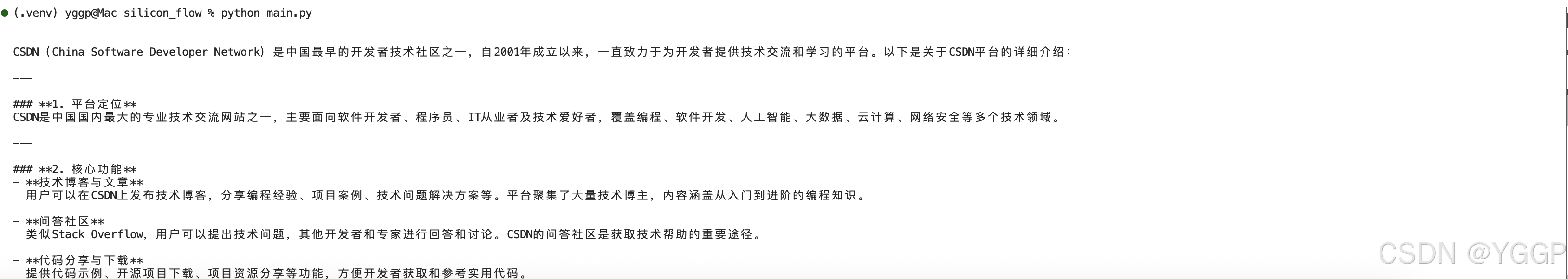

由于上述代码片没有使用“流式输出”,因此响应较慢,有需要的同学可以进行相应的改造。其调用的结果是:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)