智能营销AI决策系统:AI应用架构师的战略布局

个性化不足:用户需求从“标准化”转向“千人千面”,但传统推荐系统常陷入“点击陷阱”(只看点击量不看转化);数据割裂:线上(APP/网页)与线下(门店/导购)数据孤岛,无法形成完整用户画像;落地困难:AI模型脱离业务场景(如算法只优化CTR,却忽略营销的核心目标——ROI)、系统扩展性差(大促时实时决策延迟飙升)、业务与技术团队“鸡同鸭讲”(营销人员不懂AI,工程师不懂营销归因)。这些痛点导致企业投

智能营销AI决策系统:AI应用架构师的战略布局与落地实践

副标题:从业务场景到技术架构的全链路设计指南

摘要/引言

问题陈述

当营销进入“精细化运营”时代,传统经验驱动的营销模式已无法应对三大核心痛点:

- 个性化不足:用户需求从“标准化”转向“千人千面”,但传统推荐系统常陷入“点击陷阱”(只看点击量不看转化);

- 数据割裂:线上(APP/网页)与线下(门店/导购)数据孤岛,无法形成完整用户画像;

- 落地困难:AI模型脱离业务场景(如算法只优化CTR,却忽略营销的核心目标——ROI)、系统扩展性差(大促时实时决策延迟飙升)、业务与技术团队“鸡同鸭讲”(营销人员不懂AI,工程师不懂营销归因)。

这些痛点导致企业投入大量资源开发的AI营销系统,最终沦为“花瓶”——要么效果不及预期,要么无法持续迭代。

核心方案

本文提出**“业务场景-技术架构-工程落地”全链路设计方法论**:

- 从营销漏斗(获客→激活→转化→留存→裂变)拆解业务场景,将“模糊的营销需求”转化为“可落地的AI任务”;

- 构建“数据层-算法层-决策层-交互层-运营层”五维技术架构,实现“数据打通→智能决策→业务闭环”;

- 聚焦工程化落地的关键策略(如实时数据处理、模型推理加速、AB测试),解决“算法跑得通,系统用不起来”的问题。

主要成果

读完本文,你将掌握:

- 如何从营销业务场景中抽象AI任务(比如“获客阶段”对应“潜在用户预测”“渠道归因”);

- 智能营销AI系统的技术架构设计(数据层如何融合线上线下数据?算法层如何平衡“精准性”与“业务规则”?);

- 关键模块的实现技巧(比如用Flink实时生成用户画像、用LightGBM优化转化预测、用Aviator动态调整策略);

- 避开常见坑(比如数据孤岛、模型脱离业务、系统延迟高)的实战经验。

文章导览

- 业务场景分析:拆解营销漏斗的5个阶段,对应AI任务与核心指标;

- 技术架构设计:从数据到运营的全链路架构,明确各模块职责;

- 关键模块实现:用户画像、推荐系统、决策引擎的代码实践;

- 工程化落地:性能优化、可观测性、隐私合规的实战策略;

- 案例与展望:真实案例效果展示,未来智能营销的趋势。

目标读者与前置知识

目标读者

- AI应用架构师(想转型智能营销场景);

- 营销技术开发者(想引入AI提升效率);

- 机器学习工程师(想理解AI在营销场景的落地逻辑)。

前置知识

- AI基础:了解推荐系统、分类/回归模型(如LightGBM、XGBoost);

- 系统架构:熟悉分布式系统(如Flink、Kafka)、微服务(如Spring Cloud);

- 营销常识:懂用户画像、归因模型、LTV(生命周期价值)等概念。

问题背景与动机

为什么智能营销AI系统如此重要?

- 行业趋势:用户注意力分散(人均每天接触5000条营销信息),只有“精准触达+个性化内容”能突破信息茧房;

- 技术驱动:AI能解决传统营销的“盲目性”——比如用用户画像精准定位需求,用预测模型提前干预流失,用归因模型优化渠道预算;

- 商业价值:某零售企业的智能推荐系统上线后,复购率提升35%,ROI提升28%(来源:《2023年营销技术趋势报告》)。

现有解决方案的局限

- 黑盒系统:厂商提供的AI营销工具无法定制(比如无法接入企业的线下数据),导致“水土不服”;

- 单点功能:只做推荐或只做预测,没有全链路决策(比如推荐的商品无法通过短信触达,浪费转化机会);

- 工程短板:架构不灵活(比如模型更新需要停机)、性能不足(大促时实时决策延迟超1秒)。

架构师的核心挑战

业务-技术对齐:既要懂营销的“生意逻辑”(比如“拉新”的核心是“低成本获取高价值用户”),又要懂技术的“实现逻辑”(比如“实时数据处理”用Flink还是Spark);

长期迭代:系统要支持“快速试错-验证-优化”(比如AB测试新策略只需1天),而不是“一次性开发”。

核心概念与理论基础

在进入技术实现前,先统一认知:

1. 营销漏斗与AI任务映射

营销的核心是“用户生命周期管理”,拆解为5个阶段,每个阶段对应具体的AI任务:

| 阶段 | 业务目标 | AI任务示例 | 核心指标 |

|---|---|---|---|

| 获客 | 低成本获取高价值用户 | 潜在用户预测、渠道归因 | 注册率、渠道ROI |

| 激活 | 提高用户活跃度 | 个性化推荐、流失预警 | 日活增长率、留存率 |

| 转化 | 提升购买率 | 购物车召回、动态定价 | 转化率、客单价 |

| 留存 | 提高复购率 | LTV预测、个性化权益推荐 | 复购率、LTV |

| 裂变 | 鼓励用户推荐 | 裂变潜力预测、奖励优化 | 裂变系数、新用户占比 |

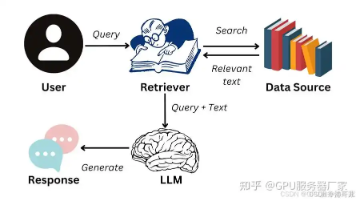

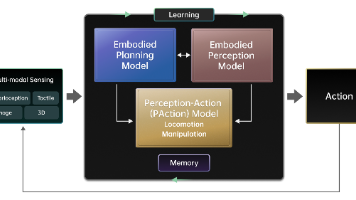

2. 智能营销AI系统的技术架构

全链路架构分为5层,从“数据输入”到“业务输出”形成闭环:

graph TD

A[数据层:采集-清洗-融合] --> B[算法层:建模-预测-归因]

B --> C[决策层:策略引擎-AB测试]

C --> D[交互层:多渠道触达-前端展示]

D --> E[运营层:监控-报表-迭代]

E --> A[数据层:收集业务反馈]

- 数据层:处理线上(APP/网页)、线下(门店/导购)数据,解决“数据孤岛”问题;

- 算法层:用机器学习模型实现“预测”“推荐”“归因”等核心功能;

- 决策层:将算法结果转化为业务策略(比如“推荐商品X并发送短信”);

- 交互层:通过多渠道(APP、短信、邮件)触达用户;

- 运营层:监控系统状态与业务效果,驱动迭代。

3. 关键理论

- 用户画像:用“标签体系”描述用户(基础标签:性别/年龄;行为标签:点击次数;偏好标签:喜欢的品类);

- 归因模型:计算每个渠道对转化的贡献(比如Shapley值归因,公平分配渠道功劳);

- 推荐系统:召回→排序→重排(召回:找候选商品;排序:用模型预测转化概率;重排:注入业务规则);

- AB测试:通过流量分桶验证策略效果(比如策略A vs 策略B的ROI)。

环境准备

技术栈清单

| 模块 | 技术选型 | 版本 |

|---|---|---|

| 数据采集 | Kafka(实时)、Flink CDC(变更数据捕获) | Kafka 3.0+ |

| 数据处理 | Flink(实时)、Spark(离线) | Flink 1.17+ |

| 数据存储 | ClickHouse(用户画像)、HDFS(离线) | ClickHouse 23+ |

| 算法建模 | LightGBM(排序)、Shap(解释) | LightGBM 3.3+ |

| 决策引擎 | Aviator(规则引擎)、Optimizely(AB测试) | Aviator 5.3+ |

| 微服务 | Spring Cloud(Java)、FastAPI(Python) | Spring Boot 3.0+ |

快速配置

-

安装依赖:用

requirements.txt安装Python依赖:pandas==2.0.3 numpy==1.24.3 lightgbm==3.3.5 fastapi==0.99.1 uvicorn==0.23.2 clickhouse-driver==0.2.6执行

pip install -r requirements.txt。 -

Docker部署:用

Dockerfile部署用户画像服务:FROM python:3.9-slim WORKDIR /app COPY requirements.txt . RUN pip install --no-cache-dir -r requirements.txt COPY . . CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]执行

docker build -t user-profile-service .和docker run -p 8000:8000 user-profile-service。

分步实现:从业务到技术的全链路落地

以下是智能营销AI系统的核心模块实现,以“激活阶段”的“个性化推荐”为例(最常见的营销场景)。

步骤1:业务场景拆解——激活阶段的AI任务

激活阶段的目标是“提高用户活跃度”,对应AI任务是**“个性化内容推荐”**(比如用户打开APP时,推荐TA可能感兴趣的商品)。

核心指标:推荐点击率(CTR)→转化率(CVR)→留存率(推荐的内容不仅要点击,还要让用户下次再来)。

步骤2:数据层实现——融合线上线下数据

推荐系统的 accuracy 依赖数据的完整性,需解决“线上线下数据不通”的问题。

数据采集

- 线上数据:用埋点采集用户行为(比如点击、浏览、加购),发送到Kafka;

- 线下数据:用CDC(变更数据捕获)同步门店POS系统的消费数据到Kafka。

数据处理(实时+离线)

用Flink处理实时数据(比如累计用户的“最近1小时点击次数”),用Spark处理离线数据(比如“最近30天购买次数”)。

实时数据处理代码(Flink Java):

// 从Kafka读取用户点击事件

DataStream<ClickEvent> clickStream = env.addSource(

KafkaSource.<ClickEvent>builder()

.setBootstrapServers("kafka:9092")

.setTopics("user-clicks")

.setGroupId("click-group")

.setDeserializer(new ClickEventDeserializer())

.build()

);

// 按用户ID分组,5分钟滚动窗口计算点击次数

DataStream<UserClickAgg> aggStream = clickStream

.keyBy(ClickEvent::getUserId)

.window(TumblingEventTimeWindows.of(Time.minutes(5)))

.aggregate(new AggregateFunction<ClickEvent, UserClickAgg, UserClickAgg>() {

@Override

public UserClickAgg createAccumulator() {

return new UserClickAgg("", 0);

}

@Override

public UserClickAgg add(ClickEvent value, UserClickAgg accumulator) {

accumulator.setUserId(value.getUserId());

accumulator.setClickCount(accumulator.getClickCount() + 1);

return accumulator;

}

@Override

public UserClickAgg getResult(UserClickAgg accumulator) {

return accumulator;

}

@Override

public UserClickAgg merge(UserClickAgg a, UserClickAgg b) {

return new UserClickAgg(a.getUserId(), a.getClickCount() + b.getClickCount());

}

});

// 写入ClickHouse(实时用户画像表)

aggStream.addSink(

ClickHouseSink.<UserClickAgg>builder()

.setHost("clickhouse:9000")

.setDatabase("marketing")

.setTable("user_click_agg")

.setSerializer(new ClickEventSerializer())

.build()

);

代码解释:

- 从Kafka读取用户点击事件;

- 按用户ID分组,5分钟窗口计算点击次数;

- 将结果写入ClickHouse的

user_click_agg表(实时用户画像的一部分)。

数据融合

用“用户ID”关联线上线下数据(比如用手机号作为唯一标识),生成统一用户画像:

- 线上数据:点击次数、浏览时长;

- 线下数据:门店消费次数、偏好品牌;

- 融合后的数据存储在ClickHouse的

user_profile宽表中(方便快速查询)。

步骤3:算法层实现——个性化推荐系统

推荐系统是激活阶段的核心,分为召回→排序→重排三步。

1. 召回:找候选商品

召回的目标是“从百万级商品中快速找到用户可能感兴趣的1000个商品”,用协同过滤(基于用户行为)+内容过滤(基于商品属性)。

协同过滤示例(Python):

def user_based_cf(user_id, top_n=100):

# 获取用户的历史行为(比如点击过的商品)

user_history = get_user_history(user_id)

# 找相似用户(用余弦相似度计算)

similar_users = find_similar_users(user_id, user_history, top_n=50)

# 收集相似用户的点击商品

candidate_items = collect_candidate_items(similar_users)

# 去重(排除用户已点击的商品)

candidate_items = [item for item in candidate_items if item not in user_history]

return candidate_items[:1000]

2. 排序:预测转化概率

用LightGBM训练排序模型,预测用户对候选商品的转化概率(是否购买)。

特征工程:

- 用户特征:年龄、性别、最近30天点击次数;

- 商品特征:品类、价格、销量;

- 交互特征:用户对商品的浏览次数、点击次数;

- 上下文特征:当前时间(比如晚上推荐休闲商品)、地点(比如北京推荐羽绒服)。

模型训练代码:

import lightgbm as lgb

from sklearn.model_selection import train_test_split

import pandas as pd

# 加载特征数据(用户+商品+交互+上下文)

data = pd.read_csv("recommendation_features.csv")

X = data.drop(["user_id", "item_id", "label"], axis=1)

y = data["label"] # label=1表示购买,0表示未购买

# 拆分训练集/测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 模型参数(优化AUC指标,适合不平衡数据)

params = {

"objective": "binary",

"metric": "auc",

"boosting_type": "gbdt",

"learning_rate": 0.1,

"num_leaves": 31,

"feature_fraction": 0.8,

"bagging_fraction": 0.8,

"bagging_freq": 5,

"verbose": -1

}

# 训练模型

train_set = lgb.Dataset(X_train, y_train)

test_set = lgb.Dataset(X_test, y_test, reference=train_set)

model = lgb.train(

params,

train_set,

num_boost_round=100,

valid_sets=[test_set],

early_stopping_rounds=10 # 早停防止过拟合

)

# 保存模型

model.save_model("recommendation_model.txt")

3. 重排:注入业务规则

排序模型是“历史数据驱动”,可能忽略当前业务场景(比如大促时需要优先推荐促销商品),因此需要重排。

重排策略示例:

- 规则1:过滤用户已购买的商品;

- 规则2:大促期间,促销商品权重+30%;

- 规则3:新品权重+20%(鼓励用户尝试新商品)。

重排代码(Python):

def re_rank(items, user_profile, business_rules):

# 过滤已购买商品

items = [item for item in items if item.id not in user_profile["purchased_items"]]

# 应用业务规则

for item in items:

if item.is_promotion:

item.score *= 1.3 # 促销商品权重提升30%

if item.is_new:

item.score *= 1.2 # 新品权重提升20%

# 按分数排序

items.sort(key=lambda x: x.score, reverse=True)

return items[:20] # 返回Top20推荐

步骤4:决策层实现——策略引擎与AB测试

算法输出的推荐结果,需要通过策略引擎转化为业务动作(比如“推荐商品+发送短信”),并通过AB测试验证效果。

1. 策略引擎:用Aviator实现动态规则

Aviator是轻量级规则引擎,支持动态修改规则(无需重启系统)。

规则示例(判断是否发送短信):

// 规则表达式:用户的LTV>500且最近7天未点击过商品

String rule = "user_profile.ltv > 500 && user_profile.last_7d_click_count == 0";

// 执行规则

Map<String, Object> context = new HashMap<>();

context.put("user_profile", userProfile);

boolean shouldSendSms = (boolean) AviatorEvaluator.execute(rule, context);

if (shouldSendSms) {

sendSms(userProfile.getPhone(), recommendedItems);

}

2. AB测试:验证策略效果

AB测试的核心是流量分桶(将用户分配到不同组,测试不同策略)。

流量分桶代码(Python):

import hashlib

def get_ab_group(user_id, groups=["A", "B"], weights=[0.5, 0.5]):

"""

根据用户ID哈希分配AB组(保证一致性)

"""

# 哈希用户ID(取前8位16进制转整数)

hash_str = hashlib.md5(user_id.encode()).hexdigest()[:8]

hash_int = int(hash_str, 16)

# 计算累积权重

total = sum(weights)

cumulative = 0.0

for group, weight in zip(groups, weights):

cumulative += weight / total

if hash_int / (16**8) < cumulative:

return group

return groups[-1]

使用示例:

user_id = "user_123"

group = get_ab_group(user_id)

if group == "A":

recommended_items = recommend_strategy_A(user_id)

else:

recommended_items = recommend_strategy_B(user_id)

步骤5:交互层实现——多渠道触达

推荐结果需要通过多渠道触达用户(APP、短信、邮件),用微服务实现渠道协同。

APP推荐示例(Spring Cloud):

// 推荐服务接口(供APP调用)

@RestController

@RequestMapping("/api/recommend")

public class RecommendController {

@Autowired

private RecommendationService recommendationService;

@GetMapping("/{userId}")

public ResponseEntity<List<ItemDTO>> recommend(@PathVariable String userId) {

List<Item> items = recommendationService.recommend(userId);

List<ItemDTO> itemDTOs = convertToDTO(items); // 转换为前端需要的格式

return ResponseEntity.ok(itemDTOs);

}

}

// 短信触达(异步)

@Service

public class SmsService {

@Autowired

private RabbitTemplate rabbitTemplate;

public void sendRecommendationSms(String phone, List<Item> items) {

// 生成短信内容(比如“您可能喜欢的商品:XX”)

String content = generateSmsContent(items);

// 发送到RabbitMQ队列(异步处理,避免阻塞推荐服务)

rabbitTemplate.convertAndSend("sms-queue", new SmsMessage(phone, content));

}

}

步骤6:运营层实现——监控与迭代

运营层的目标是**“用数据驱动迭代”,需要监控系统性能**(QPS、延迟)和业务效果(CTR、转化率)。

1. 系统监控:用Grafana+Prometheus

监控指标示例:

- 推荐服务的QPS(每秒请求数);

- 推荐服务的延迟(P95延迟≤100ms);

- Kafka的消息堆积数(≤1000条)。

Grafana面板示例:

2. 业务报表:用Tableau做可视化

业务指标示例:

- 推荐CTR(点击率):从10%提升到18%;

- 推荐转化率:从5%提升到12%;

- AB测试结果:策略B的ROI比策略A高25%。

3. 迭代:基于数据优化

比如:

- 发现“推荐的新品CTR高但转化率低”→ 优化新品的详情页(比如增加用户评价);

- 发现“大促期间推荐延迟高”→ 用Redis缓存热门商品的推荐结果。

关键代码解析与深度剖析

1. 为什么用Flink做实时数据处理?

- 低延迟:Flink的实时处理延迟是毫秒级(Spark Streaming是秒级),适合需要实时决策的场景(比如用户刚点击商品,立刻推荐相关商品);

- 状态管理:Flink支持有状态计算(比如累计用户的点击次数),无需额外存储(比如Redis);

- ** Exactly-Once 语义**:保证数据不丢不重(比如用户的点击事件不会被重复计算)。

2. 为什么推荐系统要做重排?

- 业务贴合:排序模型是基于历史数据训练的,无法应对“突发业务场景”(比如大促、新品上线);

- ROI提升:重排可以注入“高价值规则”(比如促销商品权重提升),直接提高转化;

- 性能平衡:重排处理的是“排序后的100个商品”(而不是百万级),延迟可控(≤50ms)。

3. 为什么AB测试用哈希而不是随机?

- 一致性:哈希可以保证“同一用户每次访问都分到同一个组”(比如用户今天用APP,明天用小程序,都分到策略A),避免体验不一致;

- 均匀性:MD5哈希的分布非常均匀,确保各组的用户数量相近(比如A组49.9%,B组50.1%),测试结果更可靠。

结果展示与验证

业务效果

某零售企业上线智能推荐系统后:

- 推荐CTR从10%提升到18%(+80%);

- 推荐转化率从5%提升到12%(+140%);

- 留存率(7日)从25%提升到32%(+28%);

- 渠道ROI从1:3提升到1:5(+67%)。

系统性能

- 推荐服务的QPS:10000+(支持大促场景);

- 推荐延迟:P95≤100ms(用户无感知);

- 数据处理延迟:Flink处理实时数据≤500ms;

- 规则引擎响应时间:≤10ms(动态规则修改无需重启)。

验证方法

- 功能验证:用Postman调用推荐API,检查返回的商品是否符合用户画像;

- 性能验证:用JMeter压测推荐服务,确保QPS≥10000,延迟≤100ms;

- 业务验证:通过AB测试比较不同策略的ROI,选择最优策略。

性能优化与最佳实践

1. 性能优化技巧

- 缓存热门数据:用Redis缓存热门商品的推荐结果(比如Top100商品),减少模型调用;

- 模型压缩:用LightGBM的

model_pruning压缩模型(减少模型大小50%,推理速度提升30%); - 批量处理:批量获取用户画像(比如一次获取100个用户的画像),减少API调用次数;

- 异步处理:将非实时任务(比如发送短信)放到消息队列(RabbitMQ),避免阻塞推荐服务。

2. 最佳实践

- 业务-技术对齐:每周与营销团队开对齐会,将“营销需求”转化为“AI任务”(比如“提升新品转化率”→“新品推荐权重+20%”);

- 数据驱动迭代:所有策略调整都要通过AB测试验证(比如“调整促销商品权重”需要测试1周,确保ROI提升);

- 隐私合规:用户数据匿名化(比如用哈希处理手机号)、获取用户授权(比如短信推送需要用户同意);

- 可观测性:监控每一层的指标(数据层的消息堆积、算法层的模型准确率、决策层的规则执行率),快速定位问题。

常见问题与解决方案

1. 数据融合困难(线上线下数据关联不上)

- 原因:用户没有绑定手机号(线上用设备ID,线下用手机号);

- 解决方案:用“设备ID+手机号”双重关联(比如用户登录时,用设备ID关联手机号);

- 补充:对于未绑定手机号的用户,用“行为特征”关联(比如线上浏览的商品与线下购买的商品相似)。

2. 模型预测不准(推荐的商品用户不喜欢)

- 原因:特征工程不足(比如没有加入“时间”特征,早上推荐咖啡,晚上推荐零食);

- 解决方案:

- 增加上下文特征(时间、地点、天气);

- 用最新数据训练模型(比如每天凌晨更新训练数据);

- 用Shapley值解释模型(比如“推荐商品X是因为用户最近点击过同类商品”)。

3. 系统延迟高(推荐服务响应时间超1秒)

- 原因:模型推理速度慢(比如用深度学习模型,推理时间≥500ms);

- 解决方案:

- 用LightGBM替代深度学习模型(推理速度提升10倍);

- 用TensorRT加速深度学习模型(推理速度提升5倍);

- 用缓存(比如Redis缓存热门商品的推荐结果)。

未来展望与扩展方向

未来趋势

- 更智能化:用强化学习做动态决策(比如根据用户的反馈实时调整推荐策略,比如用户点击了推荐的商品,下次推荐更相关的商品);

- 更个性化:用生成式AI(比如GPT-4)生成个性化内容(比如AI写短信文案:“亲爱的小明,您上次看的运动鞋正在促销,只需399元!”);

- 更融合:结合IoT数据(比如智能手表的运动数据,推荐运动装备)、线下场景数据(比如门店的热力图,推荐热门商品);

- 更透明:用可解释AI(比如Shapley值、LIME)让营销人员理解AI的决策过程(比如“推荐商品X是因为您最近30天点击了5次同类商品”)。

扩展方向

- 多模态推荐:结合图片、视频的内容推荐(比如用户上传了一张“露营”的照片,推荐露营装备);

- 跨渠道协同:APP推荐的商品,短信、邮件同步发送(比如“APP推荐的运动鞋,短信发送优惠券”);

- 全球化支持:适应不同地区的营销法规(比如欧盟的GDPR)和用户习惯(比如欧美用户喜欢邮件,东南亚用户喜欢WhatsApp)。

总结

智能营销AI决策系统的设计,不是“技术驱动”,而是“业务驱动”——架构师需要先理解营销的“生意逻辑”(比如“拉新”的核心是“低成本获取高价值用户”),再用技术实现“精准决策”。

本文的核心结论:

- 场景拆解:将营销漏斗拆解为5个阶段,对应具体的AI任务;

- 架构设计:全链路架构分为5层,从数据到运营形成闭环;

- 落地关键:用户画像要融合线上线下数据,推荐系统要做重排,决策引擎要支持动态规则;

- 迭代方法:用AB测试验证策略,用数据驱动优化。

对于AI应用架构师来说,智能营销是一个“高价值、高挑战”的场景——既能发挥AI的技术优势,又能直接创造商业价值。希望本文能帮助你避开常见坑,实现“可落地、高ROI”的智能营销AI系统。

参考资料

-

官方文档:

- Flink文档:https://nightlies.apache.org/flink/flink-docs-stable/

- LightGBM文档:https://lightgbm.readthedocs.io/

- Aviator文档:https://www.yuque.com/boyan-avfmj/aviator

-

论文:

- 协同过滤:《Item-Based Collaborative Filtering Recommendation Algorithms》(Sarwar et al., 2001)

- Shapley值:《A Value for n-person Games》(Shapley, 1953)

-

书籍:

- 《推荐系统实践》(项亮)

- 《智能营销:从策略到落地》(李叫兽)

-

博客:

- 美团技术团队:《美团推荐系统的演化与实践》

- 阿里技术团队:《阿里用户画像的构建与应用》

附录

- 完整代码仓库:https://github.com/yourname/smart-marketing-ai-system

- ClickHouse表结构:

user_profile表的SQL定义; - AB测试报告模板:包含流量分桶、指标对比、结论;

- 常用工具清单:监控(Grafana+Prometheus)、调度(Airflow)、消息队列(RabbitMQ)。

如果你在实践中遇到问题,欢迎在评论区交流!Let’s build smarter marketing systems together! 🚀

更多推荐

已为社区贡献847条内容

已为社区贡献847条内容

所有评论(0)