【傻子速通LLM Agent系列】读复旦米哈游综述4 原文brain Knowledge部分

3 The Birth of An Agent: Construction of LLM-based Agents

🧠 3.1 Brain: Primarily Composed of An LLM

大脑:主要由大语言模型(LLM)构成

3.1.1 Natural Language Interaction

自然语言交互

🔹 High-quality generation

高质量生成

[2023/10] Towards End-to-End Embodied Decision Making via Multi-modal Large Language Model: Explorations with GPT4-Vision and Beyond — Liang Chen et al. (arXiv)

📄 This work proposes PCA-EVAL, which benchmarks embodied decision making via MLLM-based End-to-End method and LLM-based Tool-Using methods from Perception, Cognition and Action Levels.

本研究提出了 PCA-EVAL 框架,从感知(Perception)—认知(Cognition)—行动(Action) 三个层面,对基于多模态大模型(MLLM)的端到端方法和基于LLM的工具使用方法进行评测,用于**具身决策(embodied decision making)**的基准化。

➡️ 关键词: GPT-4V、具身智能、端到端决策、感知-认知-行动一体化。

[2023/08] A Multitask, Multilingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity — Yejin Bang et al. (arXiv)

📄 This work evaluates the multitask, multilingual and multimodal aspects of ChatGPT using 21 datasets covering 8 different common NLP application tasks.

该研究使用 21 个数据集,覆盖 8 种常见 NLP 任务,从多任务(multitask)、多语言(multilingual)、多模态(multimodal)三个维度,对 ChatGPT 的推理能力(reasoning)、**幻觉问题(hallucination)与交互性(interactivity)**进行了系统评估。

➡️ 关键词: 统一评测、幻觉检测、多模态语言能力。

[2023/06] LLM-Eval: Unified Multi-Dimensional Automatic Evaluation for Open-Domain Conversations with Large Language Models — Yen-Ting Lin et al. (arXiv)

📄 The LLM-EVAL method evaluates multiple dimensions such as content, grammar, relevance, and appropriateness.

LLM-Eval 提出了一种多维自动评估框架,涵盖内容(content)、语法(grammar)、相关性(relevance)与适切性(appropriateness)等维度,用于开放域对话的全面评估。

➡️ 关键词: 对话系统评测、多维指标、自动化评估。

[2023/04] Is ChatGPT a Highly Fluent Grammatical Error Correction System? — Tao Fang et al. (arXiv)

📄 The results show ChatGPT has excellent error detection and correction capabilities, producing fluent sentences even in low-resource languages.

研究结果表明,ChatGPT 具有极强的语法错误检测与纠正能力,能够生成高度流畅的句子。即使在非英语和低资源语言场景下,其表现仍具有竞争力。

➡️ 关键词: GEC(语法纠错)、低资源语言、多语言泛化。

🔹 Deep understanding

深层理解

[2023/06] Clever Hans or Neural Theory of Mind? Stress Testing Social Reasoning in Large Language Models — Natalie Shapira et al. (arXiv)

📄 LLMs exhibit certain theory of mind abilities, but this behavior is far from being robust.

研究发现,大语言模型在某种程度上表现出“心智理论”(Theory of Mind)的能力,但这种行为尚不稳定、缺乏鲁棒性。

➡️ 关键词: ToM(心智理论)、社会推理、认知模拟。

[2022/08] Inferring Rewards from Language in Context — Jessy Lin et al. (ACL)

📄 This work presents a model that infers rewards from language and predicts optimal actions in unseen environments.

该研究提出一种模型,能够从语言中推断奖励函数(infer rewards),并在未见环境中预测最优行动,体现了语言理解与强化学习的结合。

➡️ 关键词: 语言驱动奖励建模、跨环境泛化、语义强化学习。

[2021/10] Theory of Mind Based Assistive Communication in Complex Human-Robot Cooperation — Moritz C. Buehler et al. (arXiv)

📄 This work designs an agent “Sushi” with an understanding of the human during interaction.

该研究设计了一个名为 Sushi 的智能体,能够在复杂人机协作中理解人类意图与情感,以增强交互效率与协作体验。

➡️ 关键词: 人机协作、情感理解、具身交互。

📘 综合总结与分析 | Summary & Analysis

| 主题 | 关键研究方向 | 代表论文 | 启示 |

|---|---|---|---|

| 语言生成质量评估 | 多维评测、跨模态对话质量、幻觉检测 | LLM-Eval, ChatGPT多模态评估 | Agent “Brain” 的语言输出质量与稳定性需系统量化评估 |

| 具身智能与感知-行动一体化 | 从文本→感知→行动的端到端决策 | PCA-EVAL | 对于Agentic AI,提示LLM不再是文本工具,而是“决策核心” |

| 语法纠错与语言精度 | 语言细节处理与多语言泛化 | ChatGPT GEC研究 | 展示LLM在低资源环境下的稳健性 |

| 心智理论与社会推理 | 模拟他人心理状态、ToM能力验证 | Shapira et al. | 体现LLM的社会智能萌芽,Agent交互层关键 |

| 语言驱动奖励推断 | 从自然语言推导RL-style目标函数 | Jessy Lin et al. | 为“语言即奖励”奠定基础,使LLM具备策略学习潜能 |

| 人机协作交互智能体 | 感知人类意图、情感反应 | Sushi Agent | “共情式智能体”的雏形,与Brain-Perception协作紧密 |

🧩 延伸分析:Agentic AI 中的 “Brain” 设计启示

-

从语言生成到具身决策:

这些研究逐步扩展LLM的边界,从“说得好”到“做得对”,形成从语言→认知→行动的闭环。 -

内在能力向外部交互迁移:

心智理论与奖励推断研究说明,LLM的“Brain”不只是被动响应,而能在交互中主动建模他者与环境。 -

评测体系的系统化:

从LLM-Eval到PCA-EVAL,Agentic系统需要建立贯穿语言质量、认知推理、任务完成率的统一测度框架。

🧠 3.1.2 Knowledge

知识层:模型的预训练与知识内化机制

🔹 Pretrain Model

预训练模型:知识的嵌入与表征学习

[2023/04] Learning Distributed Representations of Sentences from Unlabelled Data — Felix Hill (University of Cambridge) et al. (arXiv)

📄 Proposes unsupervised methods for learning sentence representations capturing semantics without labeled data.

提出了一种无监督学习句子分布式表征的方法,使模型能够在无标注数据下学习语义信息。

➡️ 关键词: 语义表示、无监督学习、句向量。

[2020/02] How Much Knowledge Can You Pack Into the Parameters of a Language Model? — Adam Roberts (Google) et al. (arXiv)

📄 Investigates how much factual and linguistic knowledge can be stored directly in model parameters.

研究了语言模型参数中可嵌入的知识上限,揭示了模型参数即知识载体的特性。

➡️ 关键词: 参数即知识、内隐知识容量、知识压缩。

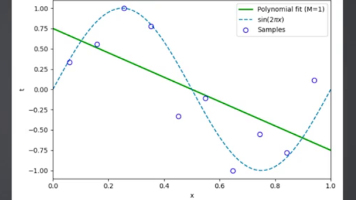

[2020/01] Scaling Laws for Neural Language Models — Jared Kaplan (Johns Hopkins University) et al. (arXiv)

📄 Proposes empirical scaling laws describing how model performance grows with data, compute, and parameters.

提出了神经语言模型的规模定律(Scaling Laws),揭示性能与模型规模、训练数据、计算量的幂律关系。

➡️ 关键词: Scaling Law、计算资源与性能、可扩展性。

[2017/12] Commonsense Knowledge in Machine Intelligence — Niket Tandon (AI2) et al. (SIGMOD)

📄 Discusses structured commonsense knowledge bases for enhancing reasoning in machine intelligence.

探讨了**常识知识库(Commonsense KB)**在提升机器推理能力中的作用。

➡️ 关键词: 常识知识、结构化知识图谱、推理增强。

[2011/03] Natural Language Processing (almost) from Scratch — Ronan Collobert (Princeton) et al. (arXiv)

📄 Introduces deep learning architectures for NLP tasks without hand-crafted features.

提出了从零开始的NLP深度学习框架,无需人工特征工程,是现代LLM预训练范式的奠基性工作之一。

➡️ 关键词: NLP深度学习、端到端学习、早期LLM雏形。

🔹 Linguistic Knowledge

语言知识:模型内化的语法与语义结构

[2023/02] A Multitask, Multilingual, Multimodal Evaluation of ChatGPT — Yejin Bang et al. (arXiv)

📄 Assesses ChatGPT’s multilingual and multimodal linguistic competence.

评估了ChatGPT在多语言、多模态任务中的语言能力。

➡️ 关键词: 多语言语言学知识、跨模态语言能力。

[2021/06] Probing Pre-trained Language Models for Semantic Attributes and their Values — Meriem Beloucif et al. (EMNLP)

📄 Probes whether LMs encode semantic attributes (e.g., color, size) and their values.

研究探测LLM是否能隐式表示语义属性及其具体值,如颜色、尺寸、功能等。

➡️ 关键词: 模型可解释性、语义属性、知识探针。

[2020/10] Probing Pretrained Language Models for Lexical Semantics — Ivan Vulić et al. (arXiv)

📄 Analyzes lexical semantic structures embedded within LMs.

分析LLM中词汇语义结构的隐式编码机制。

➡️ 关键词: 词汇语义、嵌入空间、语言表征。

[2019/04] A Structural Probe for Finding Syntax in Word Representations — John Hewitt et al. (ACL)

📄 Introduces a “structural probe” to identify syntactic hierarchies in word embeddings.

提出“结构探针”方法,用于揭示词向量中隐含的句法层级结构。

➡️ 关键词: 句法知识、结构探针、模型可解释性。

[2016/04] Improved Automatic Keyword Extraction Given More Semantic Knowledge — H. Leung (Systems for Advanced Applications)

📄 Enhances keyword extraction by leveraging richer semantic information.

通过引入更丰富的语义知识改进关键词抽取。

➡️ 关键词: 语义增强、关键词抽取、知识驱动文本挖掘。

🔹 Commonsense Knowledge

常识知识:语义世界模型与关联推理

[2022/10] Language Models of Code are Few-Shot Commonsense Learners — Aman Madaan et al. (arXiv)

📄 Shows code LMs can perform few-shot commonsense reasoning using structural priors.

揭示**代码语言模型(Code LMs)**具备小样本常识推理能力,得益于其结构化归纳偏置。

➡️ 关键词: 常识推理、代码LM、少样本学习。

[2021/04] Relational World Knowledge Representation in Contextual LMs: A Review — Tara Safavi et al. (arXiv)

📄 Reviews how contextual LMs capture relational and world knowledge implicitly.

综述了上下文语言模型如何隐式编码关系型与世界知识。

➡️ 关键词: 世界知识、关系型知识、上下文表示。

[2019/11] How Can We Know What Language Models Know? — Zhengbao Jiang et al. (arXiv)

📄 Proposes probing methods to determine factual and commonsense knowledge stored in LMs.

提出探测方法,分析语言模型中存储的事实性与常识性知识。

➡️ 关键词: 知识探测、事实性评估、模型透明性。

🔹 Actionable Knowledge

可行动知识:任务化推理与跨领域应用

[2023/07] Large Language Models in Medicine — Arun James Thirunavukarasu et al. (Nature)

📄 Surveys medical applications of LLMs, emphasizing diagnostic reasoning and clinical summarization.

综述LLM在医学中的应用,聚焦诊断推理与临床总结生成。

➡️ 关键词: 医学LLM、诊断推理、应用落地。

[2023/06] DS-1000: A Natural and Reliable Benchmark for Data Science Code Generation — Yuhang Lai et al. (ICML)

📄 Introduces DS-1000, a benchmark for evaluating data science code generation by LLMs.

提出 DS-1000 基准,用于评测LLM在数据科学代码生成任务中的表现。

➡️ 关键词: 代码生成、数据科学基准、工具使用能力。

[2022/10] Language Models of Code are Few-Shot Commonsense Learners — Aman Madaan et al. (arXiv)

📄 Shows LMs trained on code can generalize to reasoning tasks with minimal examples.

强调代码模型的泛化性与跨域推理能力。

➡️ 关键词: 代码LM、少样本推理、跨任务迁移。

[2022/02] A Systematic Evaluation of Large Language Models of Code — Frank F. Xu et al. (arXiv)

📄 Evaluates LLMs of code on correctness, efficiency, and reasoning transparency.

系统评估了代码类LLM的正确性、效率与推理可解释性。

➡️ 关键词: 代码评测、可解释AI、推理可靠性。

[2021/10] Training Verifiers to Solve Math Word Problems — Karl Cobbe et al. (arXiv)

📄 Proposes training verification models to check math reasoning of LLMs.

提出使用**验证器(verifier)**来审查LLM的数学推理过程。

➡️ 关键词: 数学推理、验证机制、自校验。

🔹 Potential Issues of Knowledge

知识的潜在问题:更新、编辑与遗忘

[2023/10] FreshLLMs: Refreshing LLMs with Search Engine Augmentation — Tu Vu (Google) et al. (arXiv)

📄 Uses search engine retrieval to dynamically refresh outdated model knowledge.

提出搜索增强机制,用于动态刷新模型中过时的知识。

➡️ 关键词: 检索增强、知识更新、RAG。

[2023/05] Editing Large Language Models: Problems, Methods, and Opportunities — Yunzhi Yao et al. (arXiv)

📄 Comprehensive survey of knowledge editing in LLMs.

系统综述LLM的知识编辑方法与挑战。

➡️ 关键词: 知识编辑、可控更新、局部修改。

[2023/05] Self-Checker: Plug-and-Play Modules for Fact-Checking with LLMs — Miaoran Li et al. (arXiv)

📄 Proposes modular fact-checking to reduce hallucinations.

通过可插拔的事实核查模块缓解幻觉问题。

➡️ 关键词: 幻觉检测、事实核查、模块化增强。

[2023/05] CRITIC: LLMs Can Self-Correct via Tool-Interactive Critiquing — Zhibin Gou et al. (arXiv)

📄 Introduces self-correction via external tool feedback.

提出工具交互式自我纠错机制(Critic),让LLM在生成后进行反思。

➡️ 关键词: 自我反思、自校验、Tool Feedback。

[2023/04] Tool Learning with Foundation Models — Yujia Qin et al. (arXiv)

📄 Explores how foundation models learn and generalize tool-use knowledge.

探讨基础模型如何学习与泛化工具使用知识。

➡️ 关键词: 工具学习、外部知识调用、可行动性。

[2023/03] SelfCheckGPT: Zero-Resource Hallucination Detection — Potsawee Manakul et al. (arXiv)

📄 Detects hallucinations without external data or human labels.

提出零资源幻觉检测方法,无需人工标注或外部知识。

➡️ 关键词: 自检机制、无监督检测、生成可靠性。

[2022/06] Memory-Based Model Editing at Scale — Eric Mitchell et al. (arXiv)

📄 Introduces scalable memory-based techniques for efficient model editing.

提出基于记忆的可扩展知识编辑框架,实现高效局部修正。

➡️ 关键词: 记忆增强、参数编辑、知识可塑性。

[2022/04] A Review on Language Models as Knowledge Bases — Badr AlKhamissi et al. (arXiv)

📄 Reviews the perspective of LMs as implicit knowledge bases.

综述了语言模型作为隐式知识库的视角及其限制。

➡️ 关键词: 内隐知识库、知识表示、可解释性。

[2021/04] Editing Factual Knowledge in Language Models — Nicola De Cao et al. (arXiv)

📄 Presents techniques for targeted factual corrections.

提出针对性事实性知识编辑方法,支持细粒度知识更新。

➡️ 关键词: 知识校正、参数微调、事实一致性。

[2017/08] Measuring Catastrophic Forgetting in Neural Networks — Ronald Kemker et al. (arXiv)

📄 Analyzes the phenomenon of catastrophic forgetting in continual learning.

分析了神经网络灾难性遗忘现象,为后续LLM持续学习提供理论基础。

➡️ 关键词: 持续学习、遗忘机制、模型稳定性。

📘 综合总结与分析 | Summary & Analysis

| 知识类型 | 研究焦点 | 代表工作 | 启示 |

|---|---|---|---|

| 预训练知识 (Pretrain) | 无监督语义表征、参数即知识、Scaling Law | Hill, Roberts, Kaplan | “知识”通过参数分布潜隐于模型中,预训练规模决定认知上限 |

| 语言知识 (Linguistic) | 语法结构、词汇语义、属性理解 | Hewitt, Beloucif | 模型隐式掌握语言层级结构,可作为语言符号系统的模拟 |

| 常识知识 (Commonsense) | 世界模型、关系性知识、常识推理 | Safavi, Jiang | LLMs可构建语义世界模型,是Agent社会智能的基础 |

| 可行动知识 (Actionable) | 医学、代码、数学等任务化推理 | Thirunavukarasu, Xu, Cobbe | “知识→行动”能力是Agent化的关键转折点 |

| 知识问题 (Issues) | 幻觉、遗忘、编辑、更新 | Yao, Gou, Vu, Kemker | Agent需要“知识生命周期管理”机制,包括刷新、编辑、自检、自校正 |

🧩 延伸分析:Agentic AI 的“Knowledge层”启示

-

从静态知识到动态知识:

FreshLLMs与Tool Learning工作表明,Agent需要持续知识更新能力,形成“长时记忆—检索—编辑—反思”循环。 -

知识的多形态融合:

语言知识、常识知识与任务知识在LLM中是融合的,这意味着Agent可以同时理解语义、逻辑与操作性内容。 -

知识可靠性的重要性:

SelfCheckGPT与CRITIC揭示了LLM知识使用中的幻觉与偏差问题,Agent Brain必须结合fact-checking loop进行自校正。 -

在你的MoA4NAD框架中:

可将“Knowledge层”作为多Agent系统的共享世界模型 (Shared World Model),为资产识别Agent提供语义上下文、规则知识与自检机制(如知识更新、异常检测、反思回路)。

✅ 建立对「LLM 知识形成机制 → 语言/常识/行动知识 → 知识更新与反思」的系统理解

✅ 为 Agentic AI 项目构建认知层(Brain + Knowledge 模块)的理论脉络

那么最关键的阅读主线如下👇

🧭 一、核心阅读主线(共 8 篇)

Ⅰ. 基础阶段:从零开始理解“知识在神经网络中的嵌入”

1️⃣ Collobert et al. (2011) Natural Language Processing (almost) from Scratch

奠定现代 LLM 的“端到端特征学习”范式。

📘 理解为何无需人工特征也能自动学习语言结构。

🕒 第 1 篇阅读。

2️⃣ Kaplan et al. (2020) Scaling Laws for Neural Language Models

揭示“性能 ∝ 规模^α”的幂律规律,是 GPT 等大模型设计的理论支撑。

📘 理解为何模型变大 → 知识与泛化能力同步增长。

🕒 第 2 篇阅读。

3️⃣ Roberts et al. (2020) How Much Knowledge Can You Pack Into the Parameters of a Language Model?

量化“参数即知识”的能力,展示模型内部可储存大量事实。

📘 理解“模型参数 = 隐式知识库”。

🕒 第 3 篇阅读。

Ⅱ. 语言与常识知识阶段:LLM 如何隐式形成语法与世界模型

4️⃣ Hewitt et al. (2019) A Structural Probe for Finding Syntax in Word Representations

证明词向量中存在可提取的句法层级结构。

📘 理解“语法知识”如何自动出现。

🕒 第 4 篇阅读。

5️⃣ Jiang et al. (2019) How Can We Know What Language Models Know?

建立知识探针(probing)方法体系,用于评估 LLM 内部知识。

📘 理解“我们如何知道模型知道什么”。

🕒 第 5 篇阅读。

6️⃣ Safavi et al. (2021) Relational World Knowledge Representation in Contextual LMs: A Review

系统梳理 LLM 如何表示关系型世界知识。

📘 理解模型内部的“世界模型(world model)”雏形。

🕒 第 6 篇阅读。

Ⅲ. 行动与应用阶段:从知识到行动

7️⃣ Cobbe et al. (2021) Training Verifiers to Solve Math Word Problems

通过“Verifier”机制让模型能自检推理正确性。

📘 理解“知识→推理→验证”闭环。

🕒 第 7 篇阅读。

8️⃣ Thirunavukarasu et al. (2023) Large Language Models in Medicine (Nature)

展示 LLM 在高风险领域中如何将知识转化为可行动决策。

📘 理解知识落地应用的边界与挑战。

🕒 第 8 篇阅读。

Ⅳ. 知识更新与反思阶段(可选进阶)

- Yao et al. (2023) Editing Large Language Models → 了解知识编辑全景。

- Vu et al. (2023) FreshLLMs → 动态知识刷新与 RAG 增强。

- Gou et al. (2023) CRITIC / Manakul et al. (2023) SelfCheckGPT → 自我反思与事实核查机制。

📘 这些可作为**Agent 自我改进机制(Reflection Loop)**的阅读延伸。

🧩 二、逻辑总图(发展脉络)

2011 ──► From-Scratch Learning (基础)

│

2017–2020 ─► Scaling Laws & Parameter-as-Knowledge (知识容量)

│

2019–2021 ─► Syntax & World Knowledge Probing (语言/常识)

│

2021–2023 ─► Verifier → Actionable Knowledge → Medical LLMs (知识行动化)

│

2023+ ─► FreshLLMs / CRITIC / SelfCheckGPT (知识更新与自反)

📘 三、推荐阅读节奏

| 周期 | 阅读主题 | 关键目标 |

|---|---|---|

| 第 1 周 | 基础与语言知识(Collobert → Roberts → Kaplan → Hewitt → Jiang) | 理解知识的形成与内部结构 |

| 第 2 周 | 世界知识与行动(Safavi → Cobbe → Thirunavukarasu) | 理解知识如何驱动推理与决策 |

| 进阶阅读 | Yao, Vu, Gou, Manakul | 学习知识编辑、自校正与反思机制 |

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)