【万字长文】大模型赋能下的具身智能革命:自主决策与具身学习技术的最新进展综述!

本文系统综述大模型如何赋能具身智能,聚焦自主决策(分层与端到端)与具身学习(模仿与强化学习)两大方向,首次将世界模型纳入研究框架。文章分析了大模型在感知、推理、行动等方面的突破,并指出数据稀缺、持续学习、计算效率等挑战,为通用人工智能发展提供理论指导与实践路径。

总结

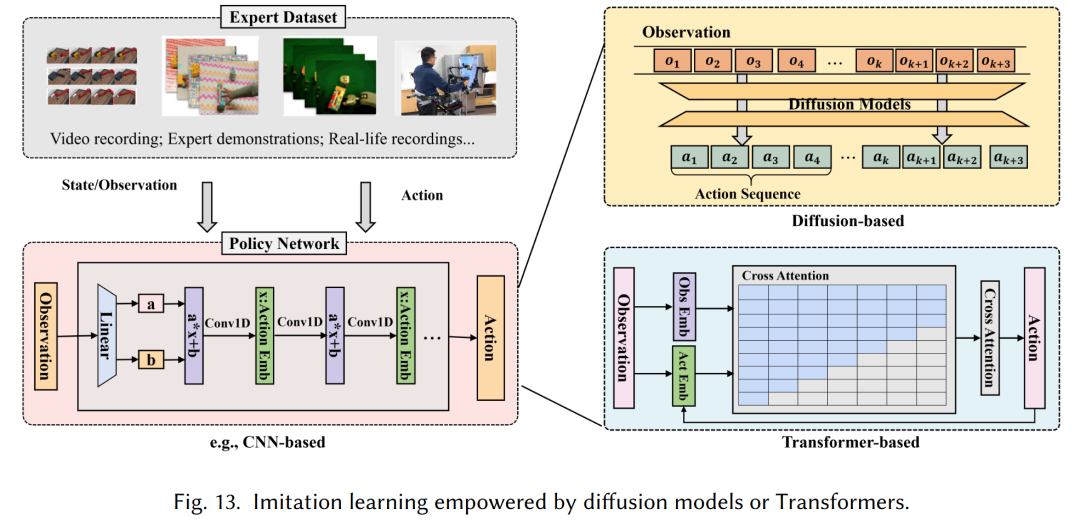

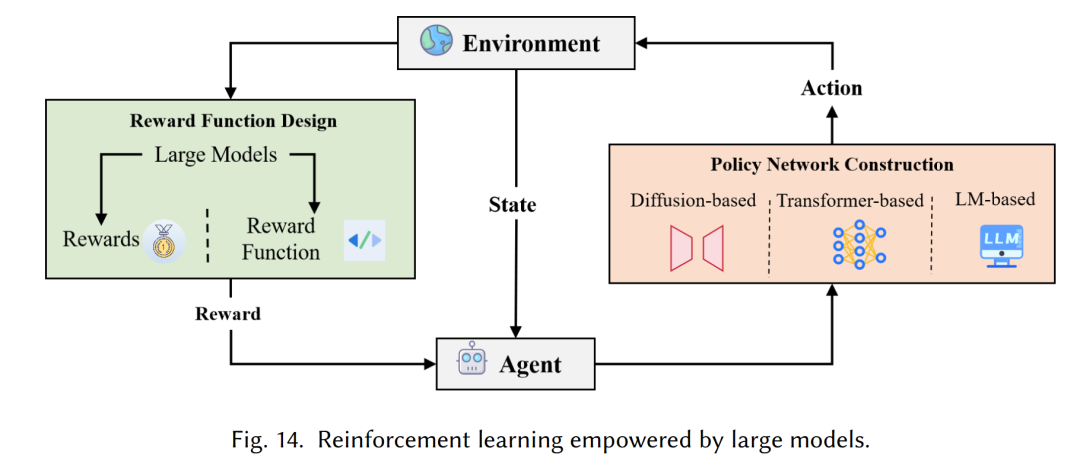

该综述聚焦大模型赋能的具身智能,系统梳理其在自主决策与具身学习两大核心方向的进展:自主决策涵盖分层决策(大模型增强高层规划、低层执行与反馈优化)与端到端决策(基于视觉-语言-动作(VLA)模型,大模型提升感知、动作生成与部署效率);具身学习重点阐述大模型对模仿学习(扩散模型、Transformer构建策略网络)与强化学习(优化奖励函数设计与策略网络)的增强作用,首次将世界模型纳入具身智能研究,分析其设计方法及对决策与学习的关键支撑,最后指出当前面临的具身数据稀缺、持续学习、计算部署效率及仿真到现实差距等挑战,为通用人工智能(AGI)方向提供理论框架与实践指导。

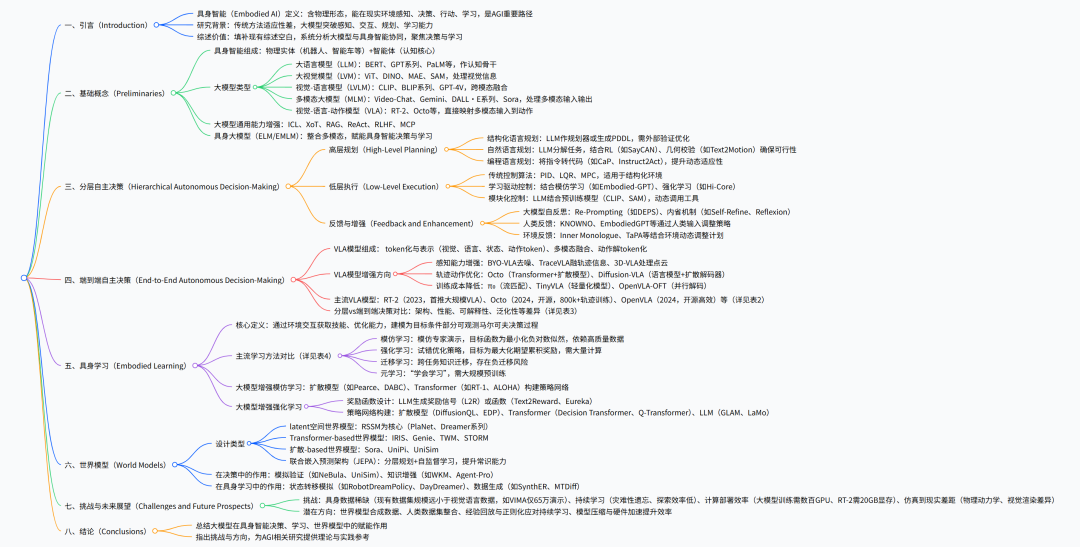

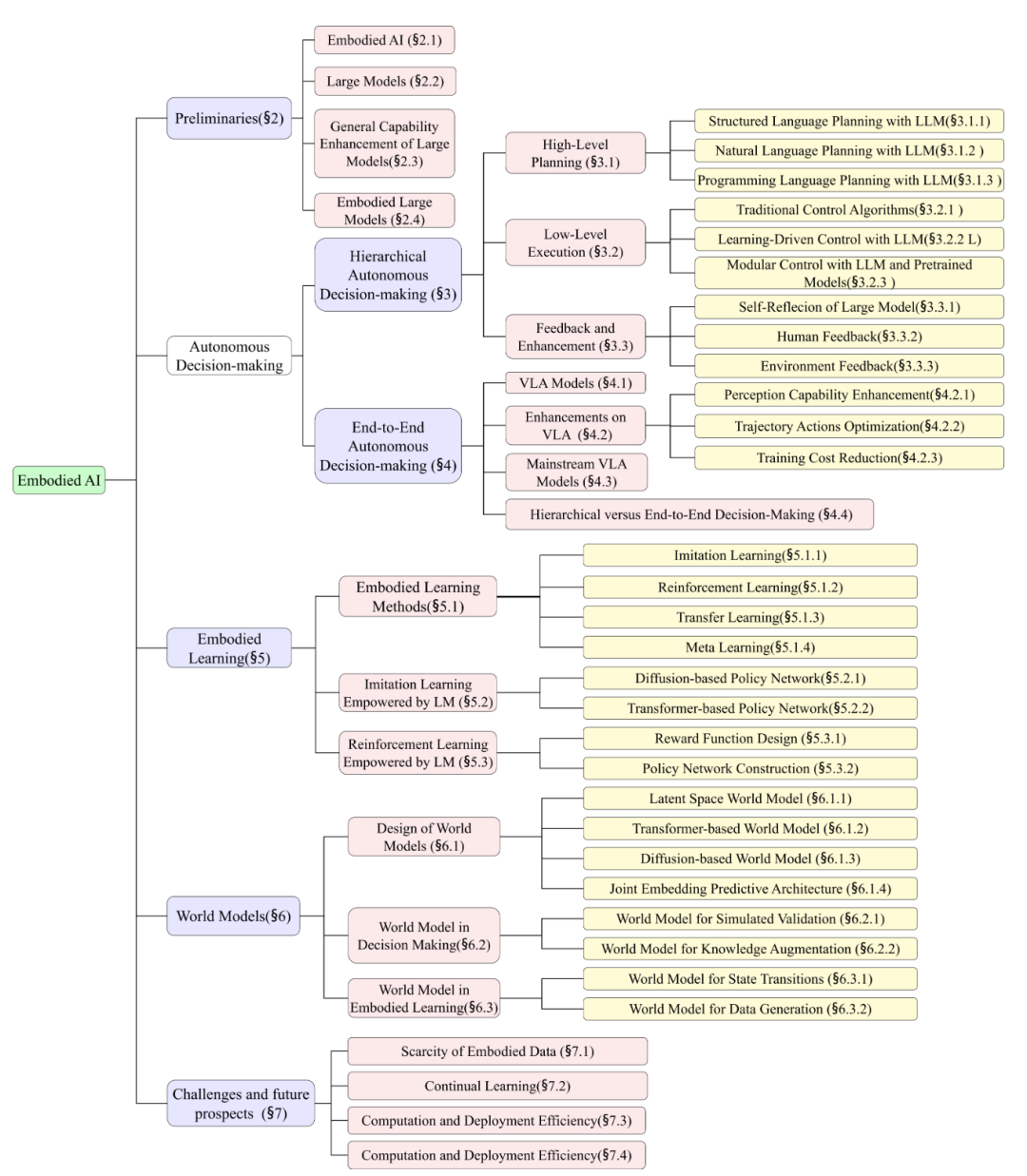

论文全览

详细总结

引言:研究背景与综述定位

具身智能核心定义:旨在开发具备物理形态的智能系统,能在现实环境中实现感知、决策、行动与学习,是通往通用人工智能(AGI) 的关键路径(参考Turing 1950年提出的智能定义)。

研究瓶颈:传统具身智能依赖预编程规则(如早期符号推理系统),适应性有限;深度学习虽降低环境建模依赖,但模型多为任务特定,泛化性与迁移性差。

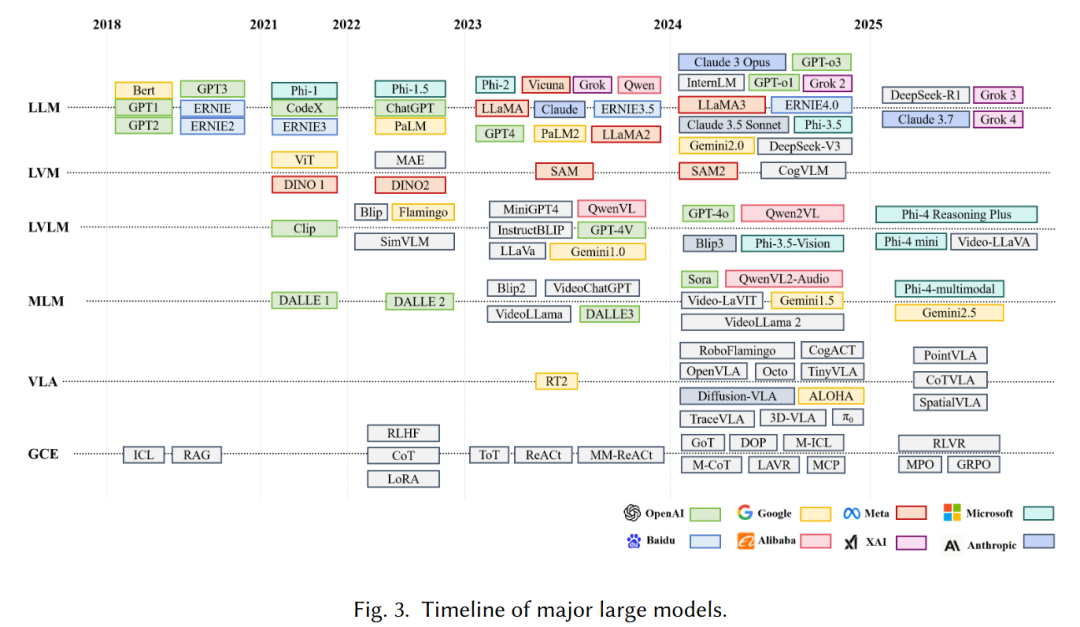

大模型的突破:以LLM(如GPT系列)、LVLM(如CLIP)、MLM(如Gemini)、VLA(如RT-2)为代表的大模型,凭借强大的感知、推理、交互能力,革新具身智能研究。

综述价值:

- 填补空白:现有综述多聚焦大模型本身或具身智能单一组件(如规划、模拟器),本文首次系统整合大模型与具身智能的协同机制。

- 核心聚焦:围绕自主决策与具身学习两大核心,同时首次将世界模型纳入具身智能研究框架。

- 分析方法:采用“水平对比+垂直追溯”双维度分析,既对比不同方法(如分层vs端到端决策),又追溯技术演进(如VLA模型从RT-2到Octo的发展)。

基础概念:具身智能与大模型基础

具身智能(Embodied AI)

- 组成结构:包含物理实体(如人形机器人、四足机器人、智能车)与智能体(认知核心,负责决策与学习)。

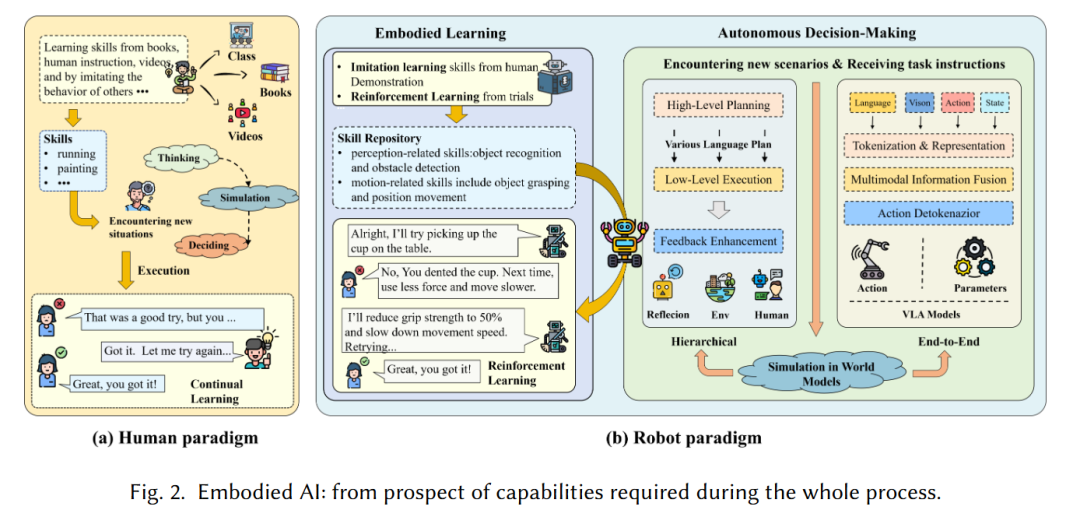

- 核心流程:模仿人类问题解决范式——通过模仿学习从演示/视频获取技能,面对新场景时分析环境、分解任务、规划策略,结合强化学习与反馈优化(见图2)。

- 核心能力:自主决策(分层/端到端两种范式)与具身学习(通过交互持续优化技能)。

主流大模型类型及演进

| 模型类型 | 核心功能 | 代表模型 | 关键进展 |

|---|---|---|---|

| 大语言模型(LLM) | 自然语言处理、认知推理 | BERT(2018)、GPT系列(GPT-3含1750亿参数,2020)、PaLM(2023)、Llama系列(7B-65B参数,2023) | GPT-3首次实现零样本/少样本学习;ChatGPT(基于GPT-3.5)支持自然交互;Llama系列推动开源研究 |

| 大视觉模型(LVM) | 视觉信息处理(识别、分割等) | ViT(2020)、DINO/DINOv2(2021-2023)、MAE(2022)、SAM(2023,训练于1100万图像) | ViT将Transformer引入视觉;SAM支持语义/实例/目标分割,可通过用户反馈微调 |

| 视觉-语言模型(LVLM) | 跨模态(视觉+语言)融合 | CLIP(2021)、BLIP/BLIP-2(2022-2023)、GPT-4V(2023) | CLIP通过对比学习对齐图文特征;BLIP-2引入QFormer实现高效跨模态融合;GPT-4V支持图文联合输入推理 |

| 多模态大模型(MLM) | 处理多模态(文本、视觉、音频等) | Video-Chat(2023)、Gemini(2023)、DALL·E系列(DALL·E3 2023)、Sora(2024,生成60秒视频) | DALL·E系列实现文本到图像生成;Sora通过扩散模型生成高质量长视频;Gemini高效处理多模态输入 |

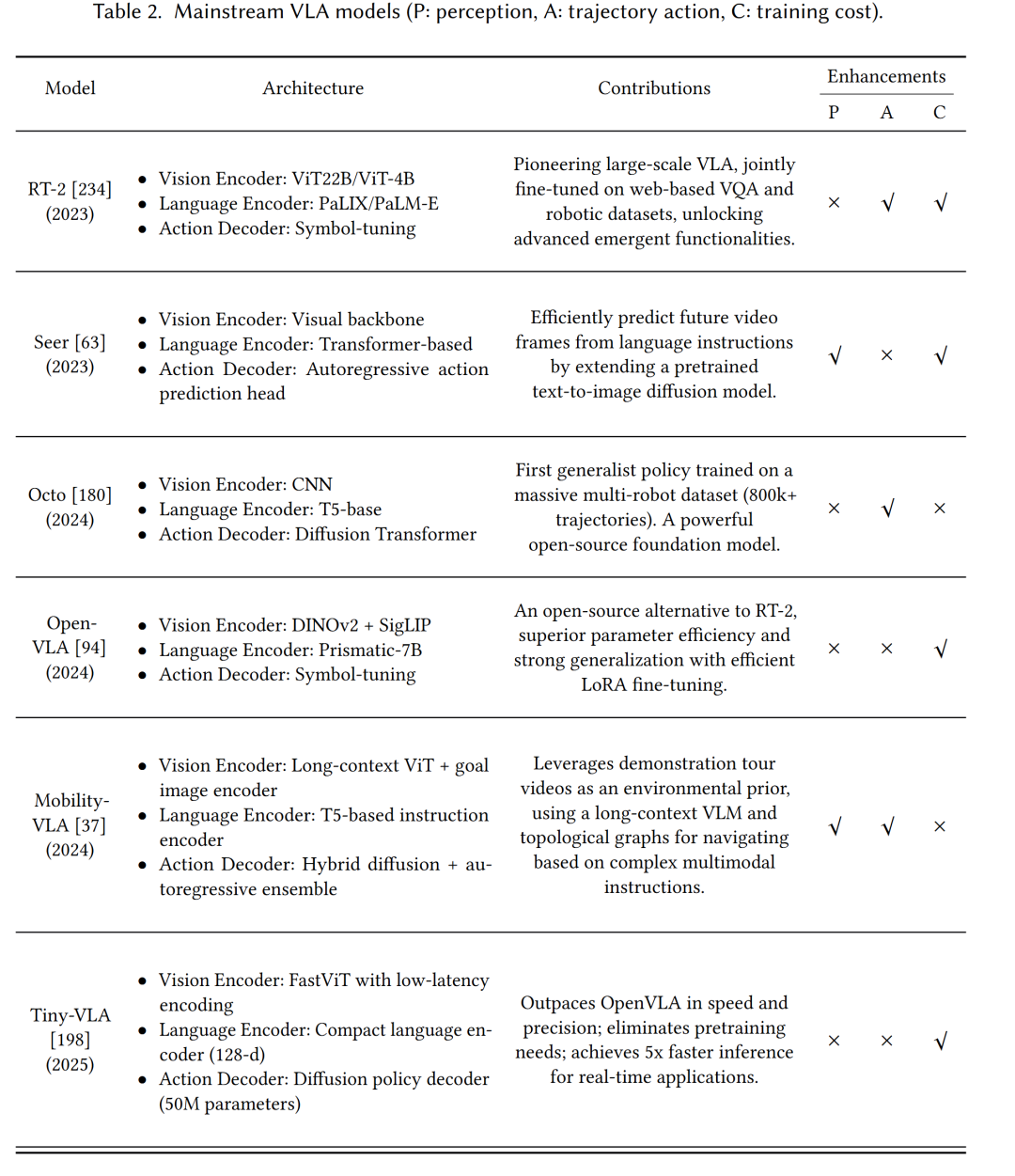

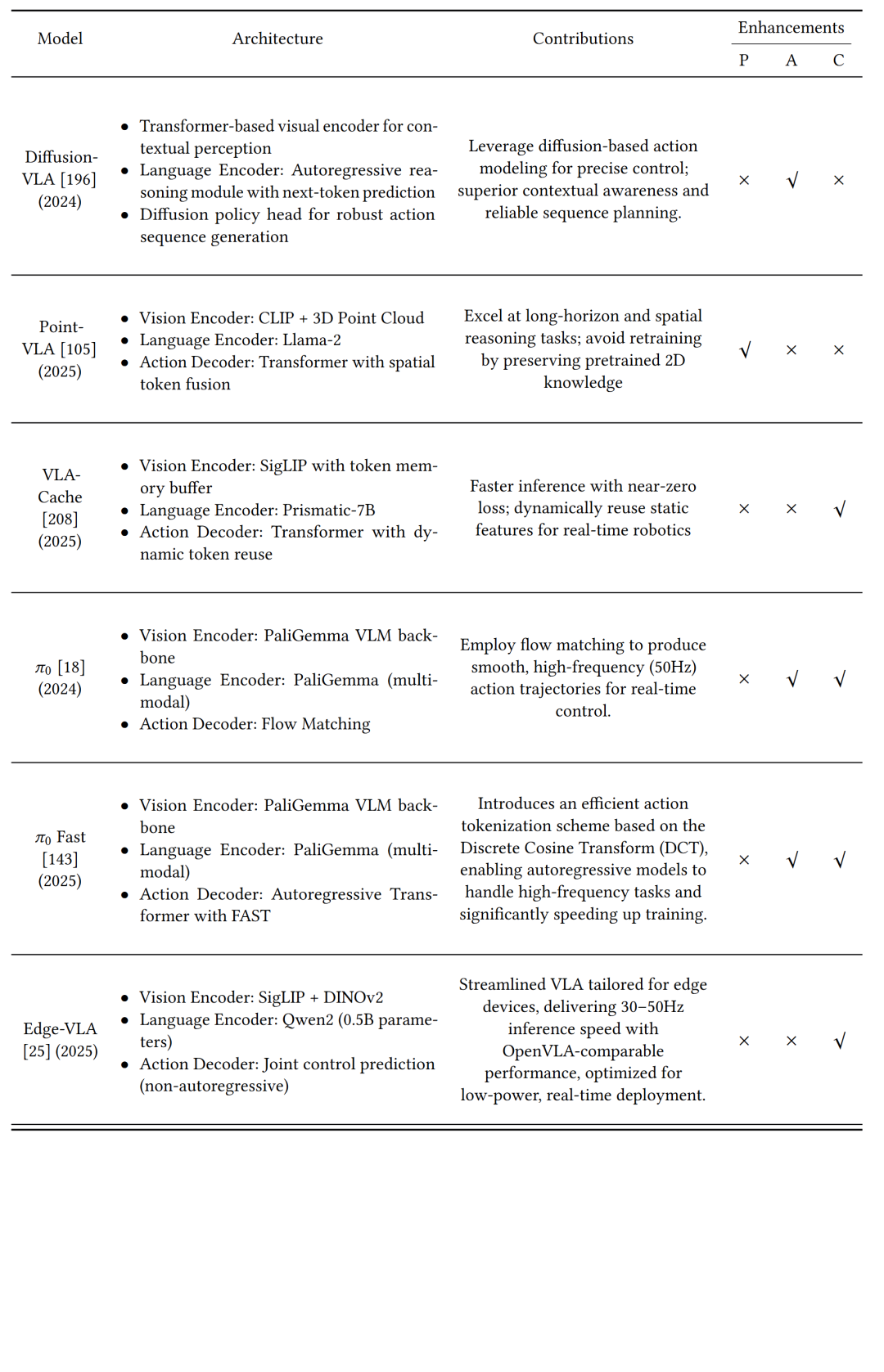

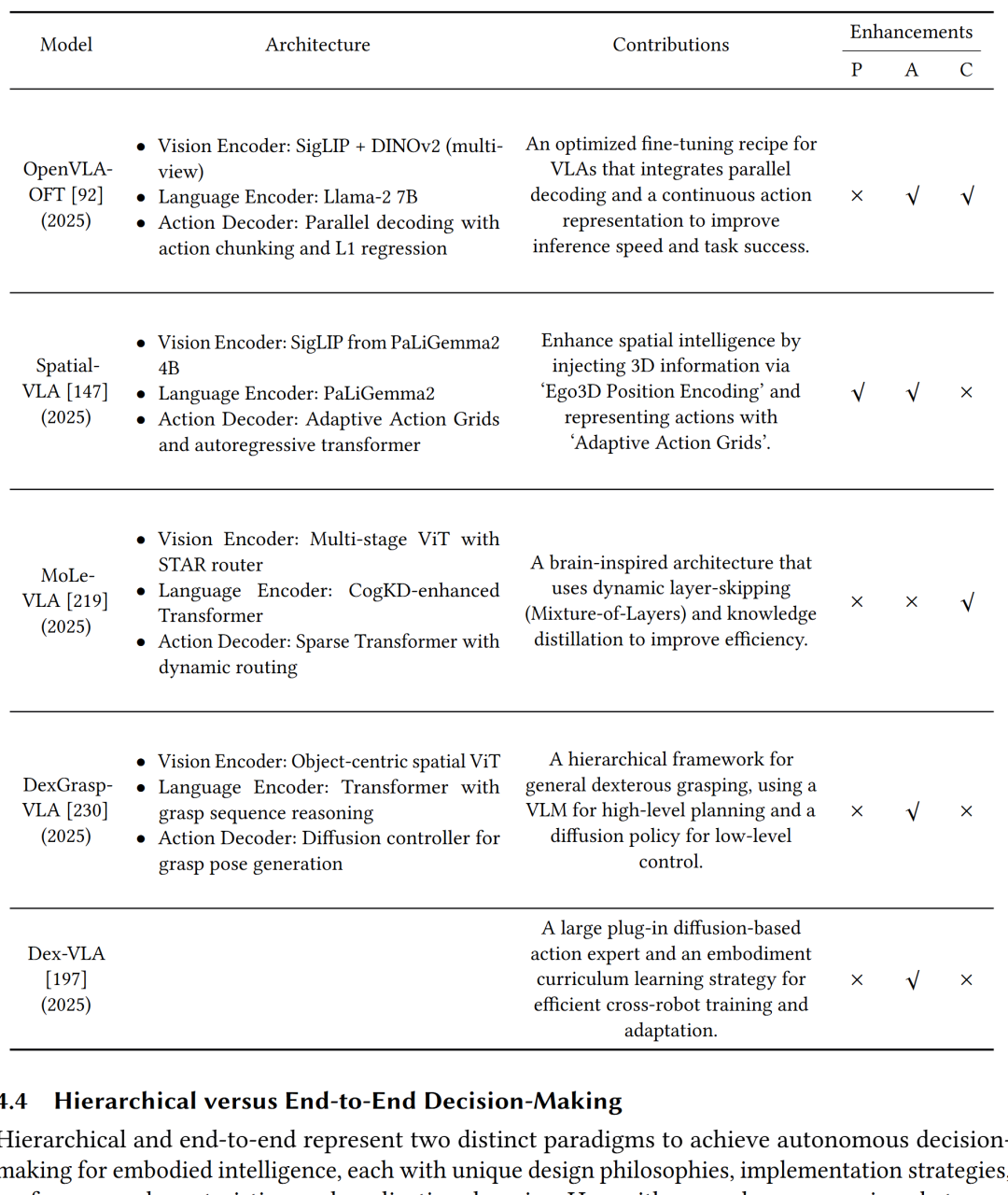

| 视觉-语言-动作模型(VLA) | 映射多模态输入到动作 | RT-2(2023,首提VLA)、Octo(2024,800k+轨迹训练)、OpenVLA(2024,开源) | RT-2离散化动作空间;Octo用扩散模型优化动作序列;OpenVLA通过LoRA提升参数效率 |

如果你也想通过学大模型技术去帮助就业和转行,可以扫描下方链接👇👇

大模型重磅福利:入门进阶全套104G学习资源包免费分享!

大模型通用能力增强技术

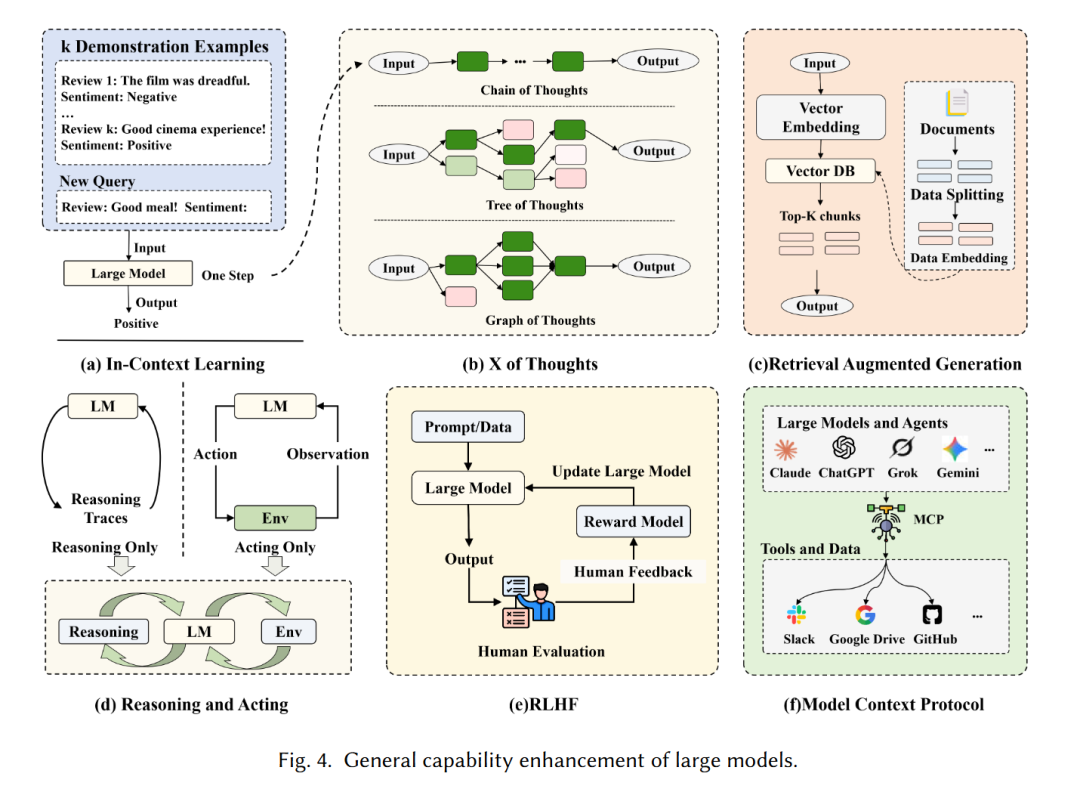

- In-Context Learning(ICL):通过设计提示词实现零样本泛化,无需额外训练。

- X of Thoughts(XoT):含CoT(链式推理)、ToT(树状推理)、GoT(图状推理),提升复杂问题解决能力。

- Retrieval Augmented Generation(RAG):从外部知识库检索信息,缓解大模型知识过时问题。

- Reinforcement Learning from Human Feedback(RLHF):结合人类偏好训练,使模型输出更符合人类意图。

- Model Context Protocol(MCP):标准化大模型与外部工具交互接口,提升 interoperability。

具身大模型(ELM/EMLM)

- 核心作用:整合多模态(文本、视觉、音频、触觉),赋能具身智能的感知、推理与行动,是自主决策与具身学习的核心支撑。

- 分工差异:LLM作认知骨干,LVM负责视觉感知,LVLM/MLM增强跨模态理解,VLA实现端到端感知-动作映射。

自主决策:分层与端到端范式

分层自主决策(Hierarchical Paradigm)

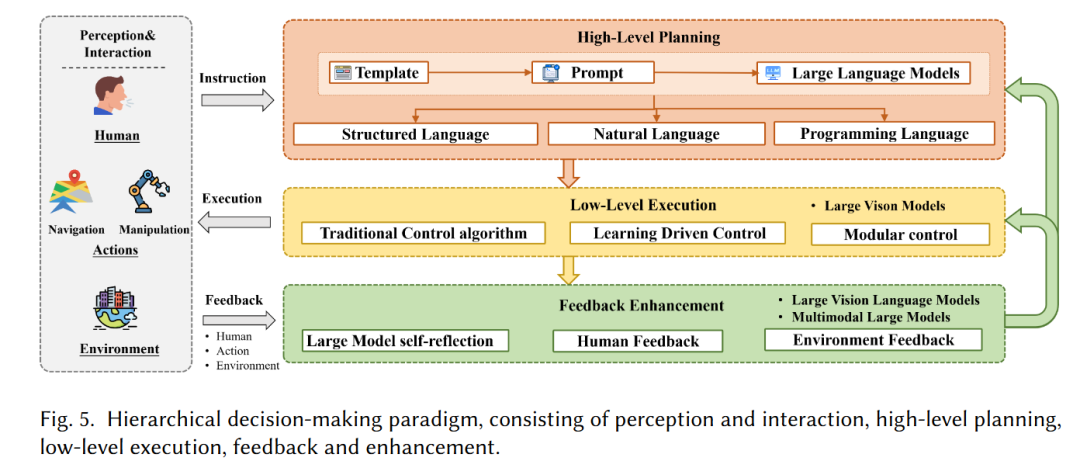

- 核心架构:分为感知交互层(依赖视觉模型)、高层规划层(分解任务)、低层执行层(执行动作)、反馈增强层(优化决策)(见图5)。

高层规划(High-Level Planning)

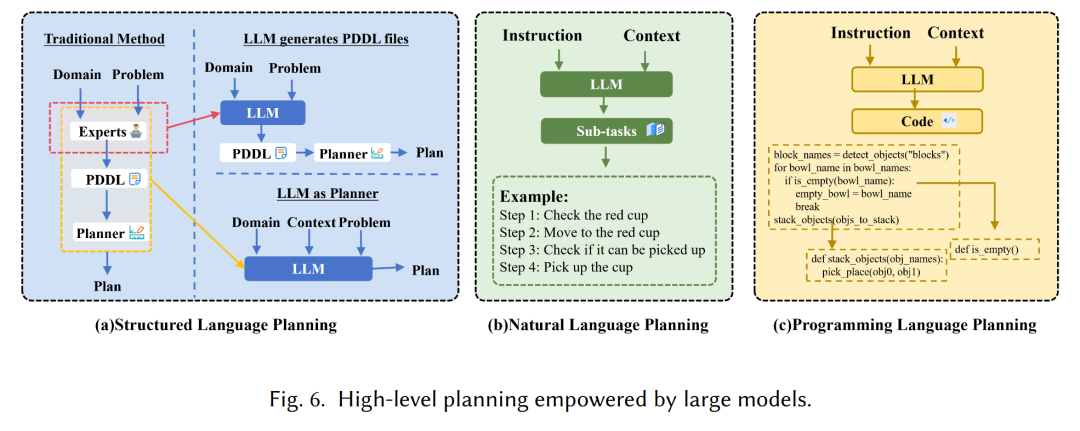

| 规划类型 | 实现方式 | 代表方法 | 优势与局限 |

|---|---|---|---|

| 结构化语言规划 | LLM作规划器或生成PDDL | LLV(引入外部验证器)、LLM+P(生成PDDL) | 提升规划自动化,但需处理PDDL语法错误 |

| 自然语言规划 | LLM分解任务,结合可行性校验 | SayCAN(LLM+RL评估动作价值)、Text2Motion(几何校验) | 灵活性高,但依赖固定技能库;Grounded Decoding动态校验可行性,适配开放任务 |

| 编程语言规划 | 将指令转可执行代码 | CaP(生成Python函数库)、Instruct2Act(多模态模型+代码生成) | 动态适应性强,ProgPrompt通过结构化提示减少无效代码 |

低层执行(Low-Level Execution)

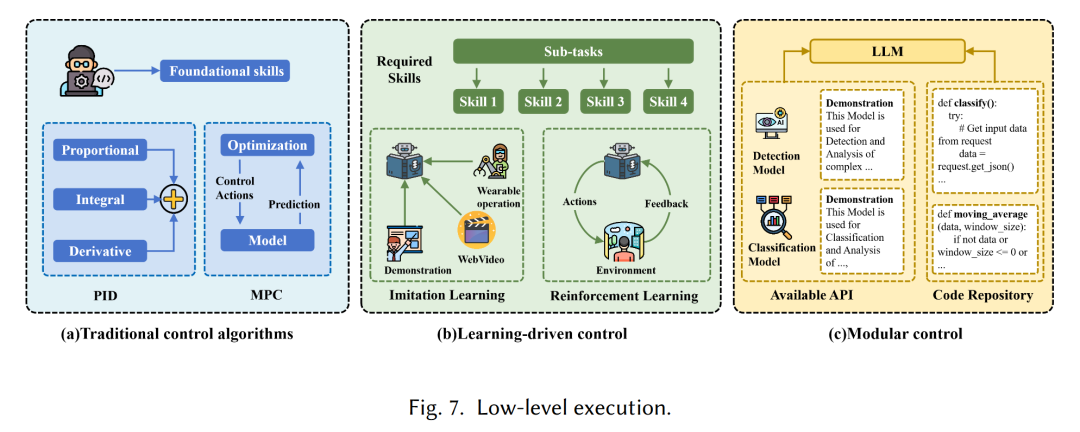

- 传统控制算法:PID(关节控制)、LQR(状态反馈优化)、MPC(无人机路径跟踪),优势是实时性强、可解释性高,局限是动态环境适应性差。

- 学习驱动控制:

- 模仿学习:Embodied-GPT用7B LLM规划,模仿学习生成低层策略。

- 强化学习:Hi-Core分两层,LLM设高层策略,RL生成低层动作。

- 模块化控制:LLM调用预训练模型(如CLIP检测、SAM分割),如DEPS、PaLM-E,优势是可复用性强,局限是可能引入通信延迟。

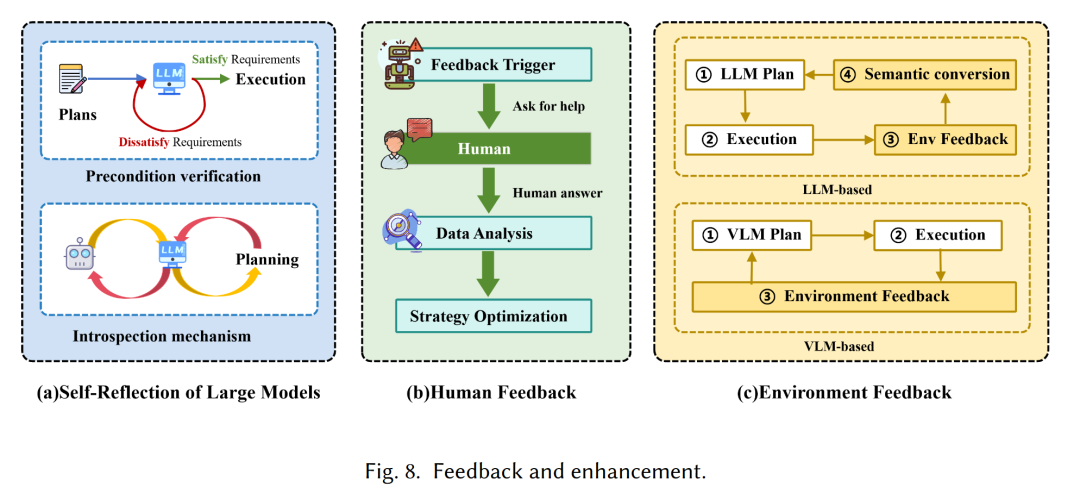

反馈与增强(Feedback and Enhancement)

| 反馈来源 | 实现方式 | 代表方法 |

|---|---|---|

| 大模型自反思 | Re-Prompting(基于错误反馈调整提示)、内省机制(自主评估优化) | DEPS(描述-解释-规划-选择框架)、Self-Refine(多轮自反馈)、Reflexion(结合长期记忆) |

| 人类反馈 | 建立人机交互闭环,人类提供指导 | KNOWNO(识别知识缺口求助人类)、EmbodiedGPT(控制失败时请求人类输入)、YAY Robot(实时语言修正) |

| 环境反馈 | 结合环境动态调整计划 | Inner Monologue(将多模态输入转语言推理)、TaPA(开放词汇目标检测)、DoReMi(检测计划-执行差异) |

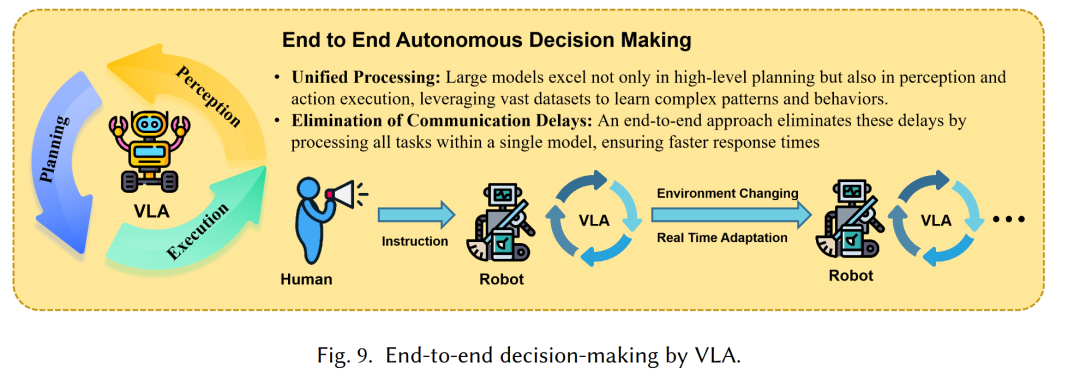

端到端自主决策(End-to-End Paradigm)

- 核心载体:视觉-语言-动作(VLA)模型,直接映射多模态输入(视觉+语言)到动作,避免分层范式的误差累积(见图9)。

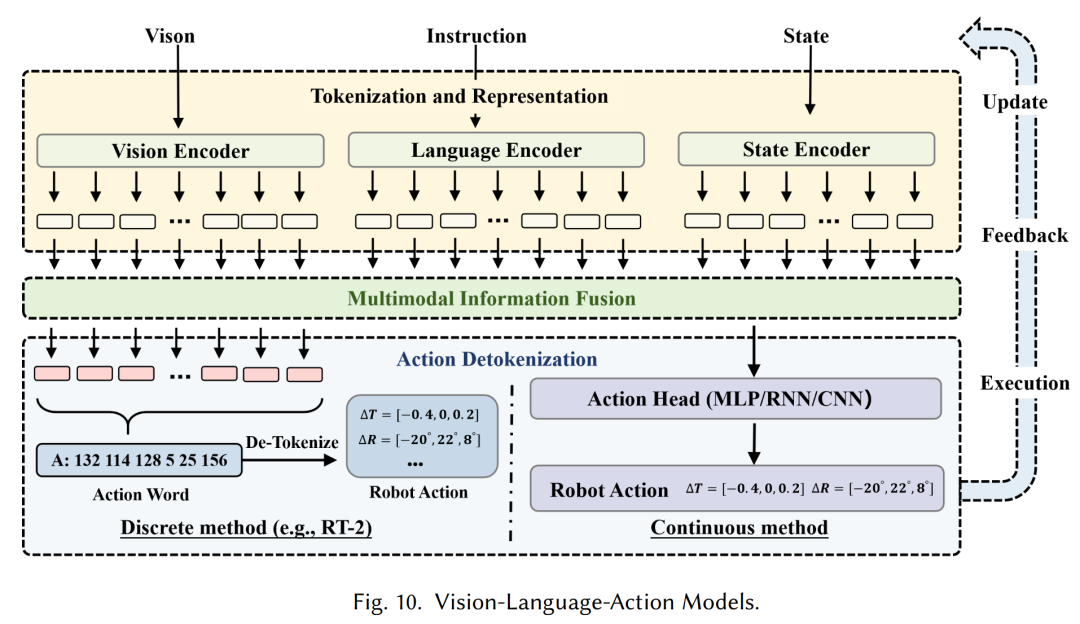

VLA模型核心组件

- token化与表示:将视觉(环境图像)、语言(任务指令)、状态(机器人关节/ gripper状态)、动作(控制信号)编码为token。

- 多模态信息融合:通过Transformer的交叉注意力机制,融合多模态token为统一嵌入向量。

- 动作解token化: autoregressive解码器生成动作token,分离散(如RT-2,8维动作空间,每维256个区间)与连续(如Octo,扩散模型生成)两种方式。

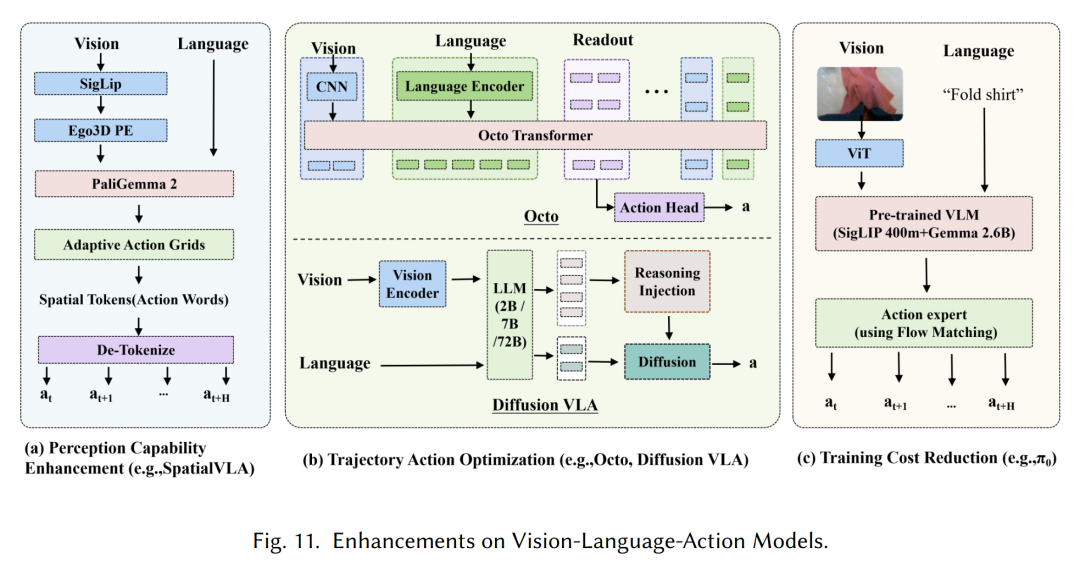

VLA模型增强方向

| 增强目标 | 技术手段 | 代表方法 | 效果 |

|---|---|---|---|

| 感知能力提升 | 图像预处理、轨迹信息融合、3D感知 | BYO-VLA(去噪预处理)、TraceVLA(视觉轨迹提示)、3D-VLA(点云处理) | 提升视觉鲁棒性,3D-VLA优于2D模型的空间理解 |

| 轨迹动作优化 | 扩散模型、Transformer | Octo(Transformer+扩散解码器)、Diffusion-VLA(语言模型+扩散解码器) | 生成平滑精准动作,Diffusion-VLA适合语义-动作深度融合任务 |

| 训练成本降低 | 流匹配、轻量化模型、并行解码 | π₀(流匹配,50Hz动作生成)、TinyVLA(知识蒸馏,10M参数)、OpenVLA-OFT(并行解码) | π₀降低计算开销;TinyVLA推理速度提升5倍;OpenVLA-OFT减少推理时间 |

主流VLA模型对比(部分关键模型)

##### 3.2.4 分层vs端到端决策对比 | 对比维度 | 分层决策(Hierarchical) | 端到端决策(End-to-End) | |----------|--------------------------|--------------------------| | 架构 | 感知(SLAM/CLIP)、高层规划(结构化/自然/编程语言)、低层执行(技能库)、反馈(多源) | 感知(token化)、规划(VLA预训练隐含)、动作生成(自回归/扩散)、反馈(闭环内置) | | 性能 | 结构化任务可靠,动态环境受限 | 复杂开放任务表现优,依赖训练数据 | | 可解释性 | 高(模块设计清晰) | 低(黑箱模型) | | 泛化性 | 有限(依赖人工设计结构) | 强(大规模预训练驱动),对数据缺口敏感 | | 实时性 | 低(模块通信延迟) | 高(直接感知-动作映射) | | 计算成本 | 中等(模块独立优化) | 高(训练需大量资源) | | 应用场景 | 工业自动化、无人机导航、自动驾驶 | 家用机器人、虚拟助手、人机协作 |

##### 3.2.4 分层vs端到端决策对比 | 对比维度 | 分层决策(Hierarchical) | 端到端决策(End-to-End) | |----------|--------------------------|--------------------------| | 架构 | 感知(SLAM/CLIP)、高层规划(结构化/自然/编程语言)、低层执行(技能库)、反馈(多源) | 感知(token化)、规划(VLA预训练隐含)、动作生成(自回归/扩散)、反馈(闭环内置) | | 性能 | 结构化任务可靠,动态环境受限 | 复杂开放任务表现优,依赖训练数据 | | 可解释性 | 高(模块设计清晰) | 低(黑箱模型) | | 泛化性 | 有限(依赖人工设计结构) | 强(大规模预训练驱动),对数据缺口敏感 | | 实时性 | 低(模块通信延迟) | 高(直接感知-动作映射) | | 计算成本 | 中等(模块独立优化) | 高(训练需大量资源) | | 应用场景 | 工业自动化、无人机导航、自动驾驶 | 家用机器人、虚拟助手、人机协作 |

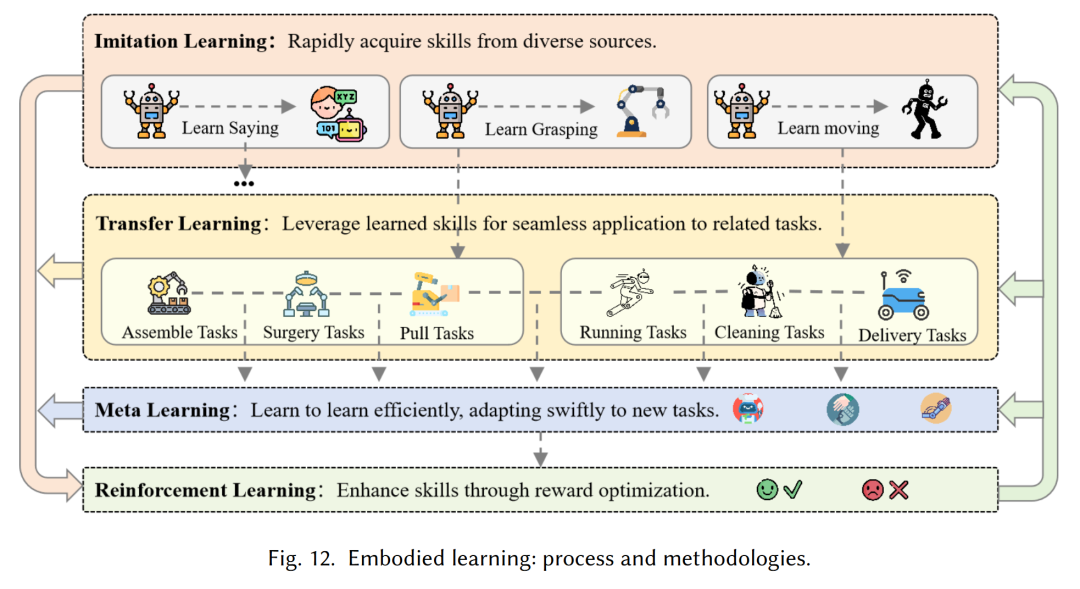

具身学习:从模仿到强化,大模型全面提效

具身学习基础框架

- 数学建模:定义为8元组 ((S, A, G, T, R, , O, )),其中:

- (S):环境状态集,(A):动作集,(G):目标集,(T):状态转移概率,®:目标条件奖励函数,():观测集,(O):观测概率,():折扣因子(0≤γ<1)。

- 核心目标:通过交互获取技能,优化策略 (),分层决策中含高层子目标生成(())与低层动作映射(())。

主流具身学习方法对比

| 学习方法 | 核心逻辑 | 优势 | 局限 | 典型应用 |

|---|---|---|---|---|

| 模仿学习(IL) | 模仿专家演示,最小化负对数似然: | 样本效率高,快速获取初始策略 | 依赖高质量演示,泛化性差 | 机器人操作、结构化导航 |

| 强化学习(RL) | 试错交互,最大化期望累积奖励 | 动态环境适应性强 | 需大量样本与计算,奖励函数设计难 | 自主导航、动态任务优化 |

| 迁移学习(TL) | 源任务知识迁移到目标任务,最小化KL divergence | 加速学习,复用技能 | 任务差异大时负迁移 | 跨环境导航、共享结构操作 |

| 元学习(Meta-L) | “学会学习”,MAML优化初始参数 | 少样本快速适配新任务 | 预训练需大量任务与样本 | 多场景导航、操作适配 |

大模型增强模仿学习

- 核心方向:构建更鲁棒的策略网络,解决传统模仿学习泛化性差、演示依赖强的问题。

- 扩散模型-based策略网络:处理复杂多模态动作分布,如Pearce框架(迭代加噪去噪)、DABC(两阶段训练)、Diffusion Policy(U-Net去噪,视觉驱动)、3D-Diffusion(3D输入提升空间理解)。

- Transformer-based策略网络:建模轨迹序列依赖,如RT-1(130k+轨迹训练)、RT-Trajectory(轨迹草图增强泛化)、ALOHA(双机械臂操作)、RoboCat(跨任务模仿,VQ-GAN token化视觉)。

大模型增强强化学习

奖励函数设计(解决人工设计难问题)

| 方法 | 实现逻辑 | 代表工作 | 优势 |

|---|---|---|---|

| 奖励信号生成 | LLM从文本提示生成奖励 | L2R(少样本)、Kwon et al.(零样本) | 无需人工设计,但奖励稀疏 |

| 奖励函数生成 | LLM生成可解释函数,迭代优化 | Text2Reward(Python函数+人类反馈)、Eureka(GPT-4生成+自动优化)、Auto MC-Reward(Minecraft全自动化) | 奖励密集,Eureka超越人类设计奖励 |

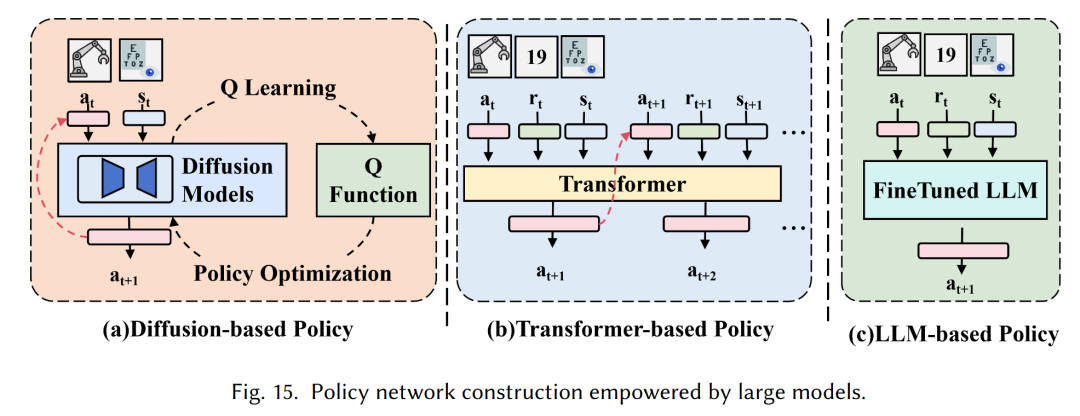

策略网络构建(提升离线RL的泛化性与表达性)

| 网络类型 | 技术手段 | 代表方法 | 效果 |

|---|---|---|---|

| 扩散模型-based | 建模复杂动作分布 | DiffusionQL(Q-learning框架)、EDP(单步采样降成本) | 适配多模态动作分布,EDP提升采样效率 |

| Transformer-based | 捕捉轨迹长依赖 | Decision Transformer(序列建模)、Prompt-DT(提示增强少样本泛化)、ODT(离线预训练+在线微调) | 规划一致性强,Q-Transformer结合Q值估计 |

| LLM-based | 利用预训练知识 | GLAM(LLM+PPO)、LaMo(GPT-2+LoRA)、Reid(BERT+外部知识库) | Reid在D4RL基准上超越Decision Transformer,训练时间减少 |

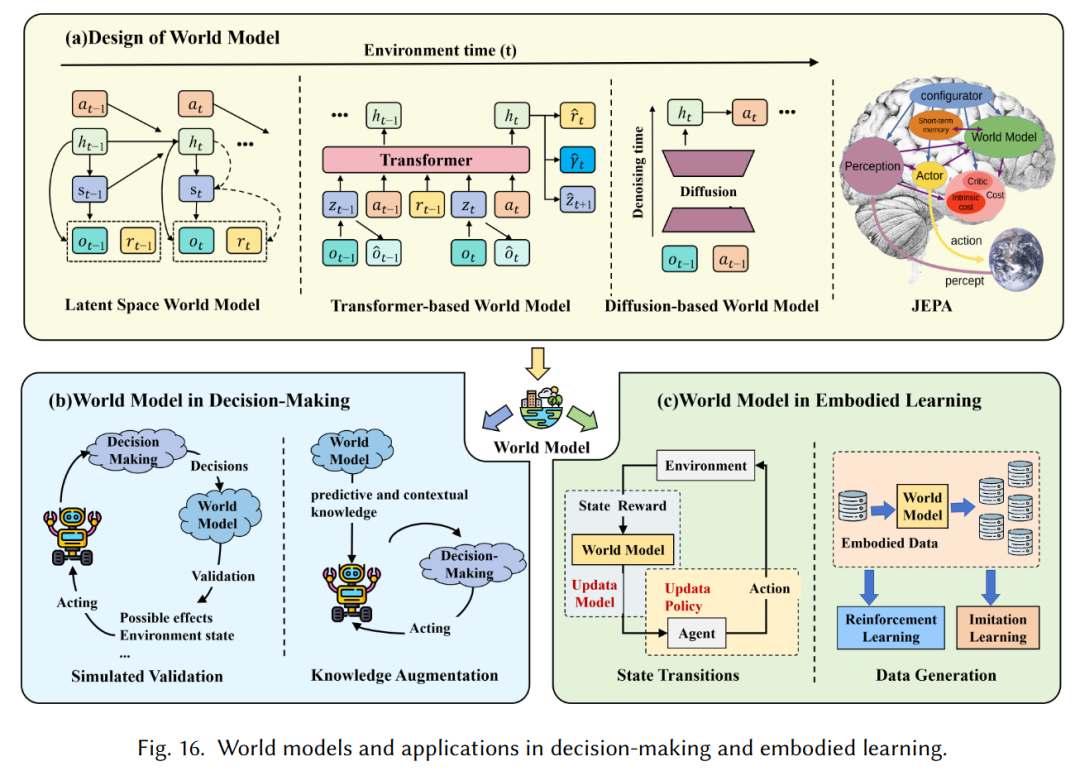

世界模型:设计与具身智能应用

世界模型设计类型

| 类型 | 核心原理 | 代表模型 | 优势 |

|---|---|---|---|

| latent空间世界模型 | 编码观测到 latent空间,预测动态 | RSSM(基础)、PlaNet(CVAE+GRU)、Dreamer系列(Dreamer V3用symlog提升稳定性) | 连续控制任务表现优,样本效率高 |

| Transformer-based | 注意力机制建模多模态与长依赖 | IRIS(VQ-VAE token化+自回归Transformer)、Genie(时空Transformer,互联网视频预训练)、TWM(Transformer-XL,长依赖) | 复杂记忆交互任务优,Genie生成可交互环境 |

| 扩散-based | 加噪去噪生成预测序列 | Sora(视频生成,60秒)、UniPi(轨迹视频生成)、UniSim(联合训练互联网与机器人数据) | 高保真预测,Sora支持语言驱动视频生成 |

| JEPA(联合嵌入预测架构) | 分层规划+自监督学习,聚焦语义特征 | Meta JEPA(Yann LeCun提出) | 提升常识能力,平衡快速反应与深度推理 |

世界模型在具身智能中的作用

辅助自主决策

- 模拟验证:在虚拟环境测试决策,降低现实成本,如NeBula(贝叶斯滤波构建信念空间)、UniSim(生成高/低层控制的视觉结果)。

- 知识增强:提供环境常识与全局知识,如WKM(整合全局任务知识与局部状态知识)、Agent-Pro(建模“信念”理解社交环境)。

辅助具身学习

- 状态转移模拟:减少现实交互,如RobotDreamPolicy(世界模型内训练策略)、DayDreamer(Dreamer V2生成 latent状态预测)、SWIM(互联网人类视频预训练,理解交互)。

- 数据生成:合成稀缺数据,如SynthER(生成离线RL轨迹)、MTDiff(生成多任务轨迹)、VPDD(人类操作数据预训练,减少机器人数据需求)。

挑战与未来展望

核心挑战

- 具身数据稀缺:现有数据集规模远小于视觉语言数据(如VIMA 65万演示、RT-1 13万演示 vs LAION-5B 57.5亿图文对),原因是机器人设计多样、现实交互复杂。

- 持续学习(Continual Learning):

- 灾难性遗忘:学习新任务导致旧技能丢失(如机器人平地导航训练后,崎岖地形导航能力下降)。

- 探索效率低:难平衡新经验探索与旧知识利用。

- 现实不确定性:传感器退化、机械磨损影响学习。

- 计算与部署效率:

- 训练成本高:Diffusion-VLA需数百GPU训练数周,计算量达PFlops级。

- 部署受限:RT-2需20GB显存,边缘设备(如机器人)资源有限;云端部署存在隐私与实时性问题。

- 仿真到现实差距(Sim-to-Real Gap):仿真环境的物理动力学(摩擦、碰撞)与视觉渲染(光照、材质)无法完全匹配现实,导致策略迁移失败。

潜在解决方向

- 数据稀缺:世界模型合成数据(如SynthER)、整合人类数据集(如Ego4D),需解决现实差距与动作对齐问题。

- 持续学习:经验回放(缓解遗忘)、正则化(约束权重更新)、自监督学习(内在动机驱动探索)、多智能体协作。

- 效率优化:参数高效微调(LoRA,成本降为全微调的1/10)、模型压缩(知识蒸馏、量化,如TinyVLA 10M参数)、硬件加速(定制芯片)。

- 仿真到现实:高精度模拟器(如Genesis,可微渲染)、域适应技术。

AI大模型从0到精通全套学习大礼包

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

只要你是真心想学AI大模型,我这份资料就可以无偿共享给你学习。大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!

如果你也想通过学大模型技术去帮助就业和转行,可以扫描下方链接👇👇

大模型重磅福利:入门进阶全套104G学习资源包免费分享!

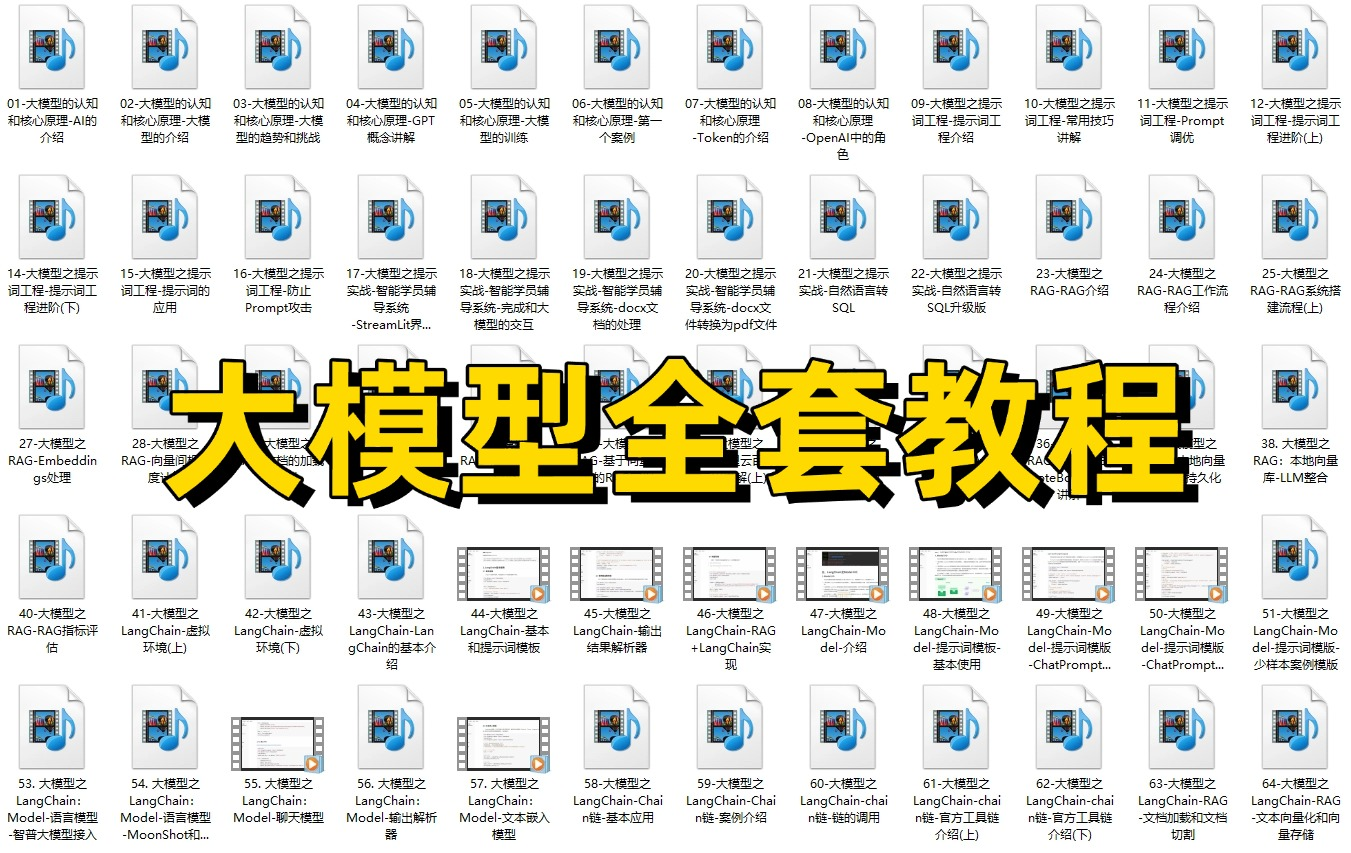

01.从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

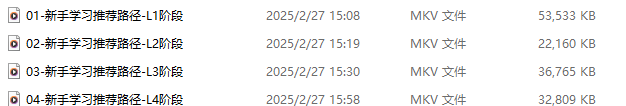

02.AI大模型学习路线图(还有视频解说)

全过程AI大模型学习路线

03.学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

04.大模型面试题目详解

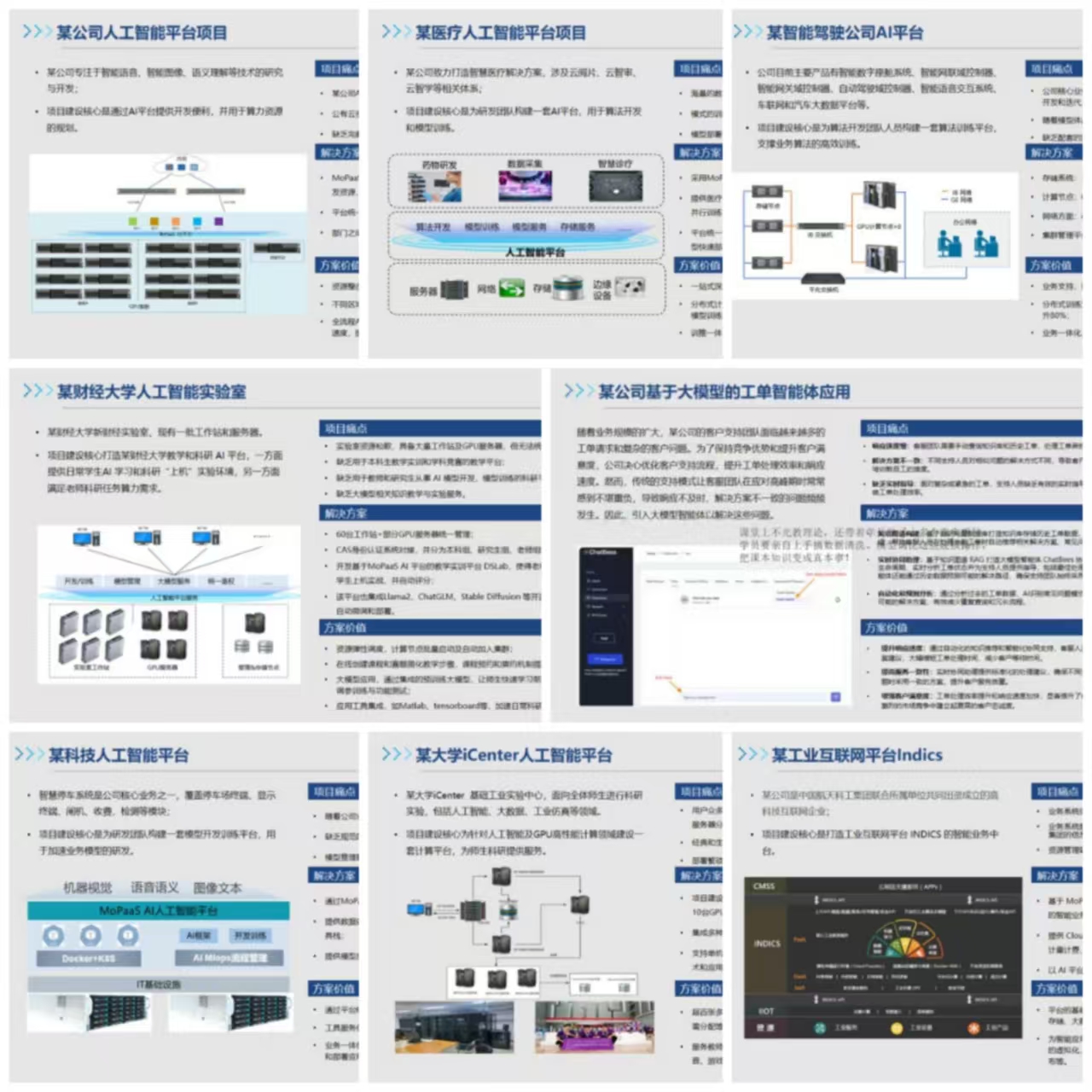

05.这些资料真的有用吗?

这份资料由我和鲁为民博士共同整理,鲁为民博士先后获得了北京清华大学学士和美国加州理工学院博士学位,在包括IEEE Transactions等学术期刊和诸多国际会议上发表了超过50篇学术论文、取得了多项美国和中国发明专利,同时还斩获了吴文俊人工智能科学技术奖。目前我正在和鲁博士共同进行人工智能的研究。

所有的视频由智泊AI老师录制,且资料与智泊AI共享,相互补充。这份学习大礼包应该算是现在最全面的大模型学习资料了。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

智泊AI始终秉持着“让每个人平等享受到优质教育资源”的育人理念,通过动态追踪大模型开发、数据标注伦理等前沿技术趋势,构建起"前沿课程+智能实训+精准就业"的高效培养体系。

课堂上不光教理论,还带着学员做了十多个真实项目。学员要亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献326条内容

已为社区贡献326条内容

所有评论(0)