Python自动化从入门到实战(30) Dify实战:私有化部署与AI智能体搭建全攻略

Dify是一款开源大语言模型应用开发平台,支持私有化部署和AI智能体搭建。本文详细介绍了Dify的核心功能,包括可视化工作流编排、多模型兼容性、企业级RAG引擎和灵活的Agent框架,并提供了Windows/Linux系统部署指南。通过Dify可快速构建企业知识库问答、智能客服、数据分析助手等应用,同时确保数据安全可控。文章还分享了创建AI智能体的完整流程和安全建议,帮助开发者高效利用这一低代码A

Python自动化从入门到实战(30) Dify实战:私有化部署与AI智能体搭建全攻略

在当今AI时代,企业如何安全、高效地应用大语言模型已成为关键问题。今天,我要向大家介绍一款强大的开源AI应用开发平台——Dify,并详细讲解如何进行私有化部署和搭建AI智能体,让即使是技术小白也能轻松上手!

Dify平台界面概览,直观展示其低代码开发环境

📋 Dify是什么?

Dify是一款面向开发者的开源大语言模型(LLM)应用开发平台,定位为"生成式AI应用创新引擎"。简单来说,它是一个人人都能用的AI开发工具箱,让你像搭积木一样快速构建各种AI应用。

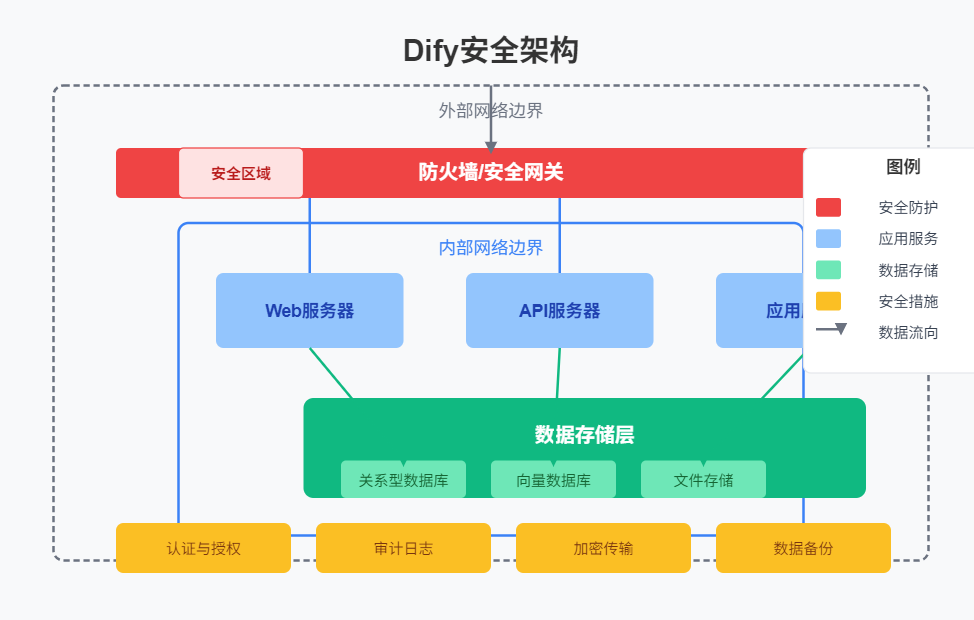

Dify平台架构示意,展示其核心组件和数据流

Dify的最大特点是低代码/无代码开发,即使不懂编程也能上手,同时它完全开源,可以进行私有化部署,让企业数据更安全。

核心价值

- 数据安全可控:私有化部署确保企业敏感数据不出域

- 开发门槛低:拖拽式界面,非技术人员也能参与

- 功能全面:从模型集成到应用部署的全流程管理

- 灵活扩展:支持自定义工具和API集成

- 企业级特性:支持权限管理、监控日志、模型切换等

✨ Dify核心功能

1. 可视化工作流编排

- 拖拽式设计界面,轻松构建AI应用逻辑

- 内置Prompt IDE,可调试提示词、对比模型性能

- 无需深入底层代码,非技术人员也能快速上手

2. 强大的模型兼容性

- 支持数百种主流模型(GPT-4、DeepSeek、Llama3、通义千问等)

- 兼容OpenAI API协议,可灵活切换云端或本地私有模型

- 通过OneAPI协议动态路由请求,优化模型调用成本

3. 企业级RAG引擎

- 支持长文档解析(PDF/PPT等)

- 结合向量数据库和混合检索,提升知识库问答准确性

- 支持引用溯源和人工干预,减少模型"幻觉"

4. 灵活的Agent框架

- 基于ReAct策略(推理+行动)

- 可调用50+内置工具(如谷歌搜索、DALL·E)

- 支持自定义API扩展复杂任务处理能力

5. 全链路LLMOps支持

- 提供模型监控、日志分析、A/B测试等功能

- 支持Kubernetes私有化部署

- 满足金融、医疗等高合规场景需求

🚀 私有化部署前的准备

硬件要求

- 最低配置:2核CPU、4GB内存、10GB可用硬盘空间

- 推荐配置:4核CPU、8GB内存、20GB可用硬盘空间

- 企业级配置:根据并发用户数和数据量进行调整

系统要求

- Windows:Windows 10/11 (64位),需开启WSL2

- Linux:Ubuntu 20.04+ 或其他主流Linux发行版

- NAS设备:支持Docker的NAS设备(如极空间Z4S等)

必要软件

- Docker:用于容器化部署

- Docker Compose:用于管理多容器应用

🖥️ Windows系统部署步骤

Windows系统部署Dify的流程图示*

第一步:安装Docker Desktop

- 访问Docker官方网站:https://www.docker.com/products/docker-desktop/

- 下载Windows版本的Docker Desktop安装程序

- 双击安装程序,勾选"Use WSL 2 instead of Hyper-V"选项

- 等待安装完成,重启计算机

- 启动Docker Desktop,等待状态显示为绿色"Running"

第二步:验证Docker安装

- 打开PowerShell或命令提示符

- 执行命令:

docker --version,验证Docker版本 - 执行命令:

docker compose version,验证Docker Compose版本 - 执行命令:

docker run hello-world,测试Docker是否正常运行

第三步:下载Dify源码

- 访问Dify的GitHub仓库:https://github.com/langgenius/dify

- 下载最新版本的源码(可通过git克隆或直接下载ZIP包)

第四步:部署Dify

- 解压下载的源码包

- 进入源码目录,找到docker-compose.yml文件

- 执行命令:

docker-compose up -d,启动所有服务 - 等待部署完成(可能需要几分钟时间)

第五步:访问Dify平台

- 打开浏览器,访问:http://localhost:3000

- 注册管理员账号并登录

- 配置系统设置和模型连接

🐧 Linux系统部署步骤

Linux系统部署Dify的命令行操作流程*

第一步:安装Docker(以Ubuntu为例)

# 更新系统软件包列表

sudo apt update

# 安装必要的依赖工具

sudo apt install apt-transport-https ca-certificates curl software-properties-common

# 添加Docker官方GPG密钥

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg

# 添加Docker软件源

echo "deb [signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

# 再次更新软件包列表

sudo apt update

# 安装Docker引擎

sudo apt install docker-ce docker-ce-cli containerd.io

# 启动Docker服务

sudo systemctl start docker

# 设置Docker开机自启

sudo systemctl enable docker

第二步:安装Docker Compose

# 下载Docker Compose

sudo curl -L "https://github.com/docker/compose/releases/download/v2.21.0/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# 赋予执行权限

sudo chmod +x /usr/local/bin/docker-compose

第三步:下载并部署Dify

# 克隆Dify源码

git clone https://github.com/langgenius/dify.git

# 进入源码目录

cd dify

# 启动所有服务

docker-compose up -d

🔧 搭建你的第一个AI智能体

AI智能体搭建的完整流程,从知识库创建到应用发布

第一步:创建知识库

- 登录Dify平台管理界面

- 点击"知识库",然后点击"创建知识库"

- 选择数据源类型(导入文本、同步Notion内容或Web站点)

- 上传或选择你需要的文档

- 设置文本分段和清洗选项

- 选择合适的Embedding模型(中文推荐bge-m3)

- 选择检索设置(推荐"混合检索")

- 点击"处理并完成",等待知识库构建完成

第二步:创建聊天助手

Dify平台上创建聊天助手的界面示例

- 切换到"工作室"标签页

- 点击"创建空白应用"

- 编写合适的提示词,定义AI助手的行为和功能

- 在上下文设置中,添加刚刚创建的知识库

- 根据需要,配置其他参数如温度、最大令牌数等

第三步:调试与发布

- 使用平台提供的调试工具测试AI助手的回答效果

- 根据测试结果调整提示词和知识库

- 确认无误后,点击"发布"按钮

- 选择发布方式(Web界面、API或嵌入到其他应用)

💡 实用场景示例

Dify的主要应用场景分类和使用示例

场景一:企业知识库智能问答

- 功能:将企业文档、手册、FAQ导入知识库,员工可通过自然语言查询

- 应用:新员工培训、内部知识共享、减少重复问题解答

- 价值:提高知识获取效率,降低培训成本,加速问题解决

场景二:智能客服机器人

- 功能:基于企业产品信息和服务流程构建的自动客服系统

- 应用:客户咨询、问题解答、订单查询、售后服务

- 价值:7×24小时服务,降低人力成本,提升客户体验

场景三:数据分析助手

- 功能:连接企业数据,提供数据解读和决策支持

- 应用:销售数据分析、市场趋势预测、业务报告生成

- 价值:让非技术人员也能进行数据分析,辅助业务决策

场景四:内容创作辅助工具

- 功能:辅助撰写邮件、报告、营销文案等内容

- 应用:市场推广、内部沟通、文档撰写

- 价值:提升内容创作效率,确保内容质量和一致性

🛡️ 安全与最佳实践

Dify私有化部署的安全架构示意

数据安全建议

- 定期备份:定期备份知识库和应用配置

- 访问控制:合理设置用户权限,限制敏感操作

- 审计日志:开启操作日志记录,监控系统使用情况

- 网络隔离:在生产环境中,考虑将Dify部署在隔离网络中

使用小贴士

- 模型选择:根据需求选择合适的模型,平衡效果和成本

- 提示词优化:精心设计提示词,提高AI回答质量

- 知识库维护:定期更新知识库内容,确保信息准确性

- 性能监控:关注系统性能,及时调整资源配置

🎯 为什么选择Dify?

与其他平台对比

| 特性 | Dify | 其他平台 |

|---|---|---|

| 开发门槛 | 低,支持无代码开发 | 较高,需要编程知识 |

| 私有化部署 | 支持,数据安全可控 | 部分不支持,或复杂 |

| 模型支持 | 数百种主流模型 | 通常支持有限 |

| 企业级功能 | 内置权限、监控、日志 | 需额外开发 |

| 社区支持 | 活跃的开源社区 | 部分闭源,支持有限 |

选择理由

- 开源透明:代码公开,可自定义修改,安全可信

- 易用性强:可视化界面,拖拽式操作,上手简单

- 功能全面:从模型管理到应用部署的全流程支持

- 安全可控:私有化部署确保数据不出企业边界

- 灵活扩展:支持自定义工具和API集成,满足多样化需求

📝 总结

Dify作为一款强大的开源AI应用开发平台,为企业提供了安全、高效地应用大语言模型的解决方案。通过私有化部署,企业可以在保护数据安全的前提下,充分发挥AI的价值。

无论是知识库智能问答、智能客服、数据分析还是内容创作,Dify都能帮助你快速构建符合业务需求的AI应用。最重要的是,它的低代码特性让更多人能够参与到AI应用的开发中来,真正实现"AI民主化"。

如果你也想在企业内部构建安全可控的AI应用,不妨试试Dify,开启你的AI创新之旅!

获取Dify:

- GitHub仓库:https://github.com/langgenius/dify

- 支持系统:Windows、Linux、支持Docker的NAS设备

让AI为你的业务赋能,从Dify开始!

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)