【收藏】BEIT-3:20亿参数多模态大模型,实现图像与文本的统一建模与应用

BEIT-3是一款突破性的多模态基础模型,采用统一Transformer架构处理图像、文本及图文对数据。该模型通过"图像即外语"理念,将图像块与文本词元统一编码,仅使用掩码预测任务进行预训练。BEIT-3具备以下创新点:1)采用多路Transformer实现模态特异性处理与跨模态融合;2)参数规模达20亿,展现强大表征能力;3)简洁架构适配多种下游任务无需修改。实验证明,BEI

【收藏】BEIT-3:20亿参数多模态大模型,实现图像与文本的统一建模与应用

BEIT-3是一种统一的多模态基础模型,将图像视为"外语",通过共享Transformer架构对图像、文本和图文对进行掩码语言建模。该模型拥有近20亿参数,采用简洁的"单塔"结构,无需修改即可应用于图像分类、目标检测、视觉问答、图文检索等多种下游任务。实验表明,BEIT-3在20余个权威数据集上取得SOTA性能,证明了"统一架构+蒙面数据建模+超大模型"技术路线的有效性,为构建通用多模态基础模型指明了方向。

一,BEIT-3

BEIT-3提出了一种统一的框架,将图像和文本都看作是一种“语言”(即“Image as a Foreign Language”),使用一个共享的Transformer结构进行预训练,在各类视觉和视觉-语言任务上都取得了state-of-the-art (SOTA) 的性能。

核心思想与动机

-

大一统的“蒙面数据”建模:受BERT在NLP领域成功的启发,BEIT系列一直坚持“蒙面数据建模”(Masked Data Modeling)作为核心预训练任务。BEIT-3将这一思想统一应用于图像、文本以及图像-文本对数据。

对文本:像BERT一样,随机掩盖一些词元(Token),让模型预测被掩盖的词。

对图像:将图像切分成块(Patches),随机掩盖一些图像块,让模型预测被掩盖图像块的视觉特征(由预训练的“视觉词典”VQ-VAE提供)。

对图文对:随机掩盖文本中的词元或图像中的块,进行联合预测。

-

多模态统一的Transformer架构:BEIT-3没有为不同模态设计复杂的、特定的模型结构,而是采用了极其简洁的“单塔”结构:

一个共享的Transformer编码器:同时处理图像、文本以及图文对输入。图像块和文本词元被当作同一种类型的“Token”输入到同一个Transformer中。

模态特定的嵌入层:在输入Transformer之前,图像块和文本词元会分别通过一个图像嵌入层(Image Embedder)和一个文本嵌入层(Text Embedder) 被投影到同一个语义空间。这使得不同模态的信息可以被同一个模型理解。

-

“Bigger is Better”:论文再次证明了扩大模型规模的有效性。BEIT-3是一个拥有近20亿参数的巨型模型,巨大的参数量使其能够吸收和理解海量的多模态信息,这是其强大性能的关键基础。

主要优势与特点

-

简洁性 (Simplicity):架构非常统一和简洁,避免了之前多模态模型中复杂的融合器、交叉注意力模块等设计。

-

可扩展性 (Scalability):统一的架构使其能够轻松地在各种数据(纯图像、纯文本、图文对)上进行大规模预训练。

-

通用性 (Versatility):同一个预训练模型,无需任何结构修改,就可以通过提供不同的输入(如图像+文本、仅图像、仅文本)来直接适用于各种下游任务,包括:

-

视觉任务 (Vision Tasks):如图像分类(ImageNet)、目标检测和分割(COCO)。

-

视觉-语言任务 (Vision-Language Tasks):如图文检索(Image-Text Retrieval)、视觉推理(VQA, Visual Question Answering)、视觉蕴涵(SNLI-VE)。

-

多模态生成任务:如图说生成(Image Captioning)。

实验结果与意义

-

SOTA性能:在包括ImageNet(分类)、COCO(检测/分割)、COCO & Flickr30K(检索)、VQAv2 & NLVR2(推理)等超过20个权威数据集上取得了最先进的性能。

-

开创性意义:BEIT-3证明了“统一架构”+“蒙面数据建模”+“超大模型” 这条技术路线的巨大潜力。它将NLP中的成功范式非常有效地推广到了视觉乃至多模态领域,为构建通用 multimodal foundation model(多模态基础模型)指明了方向。后来的许多模型(如微软的Florence、谷歌的PaLI等)都受到了这一思想的影响。

总而言之,BEIT-3是一个里程碑式的工作,它用一个简单而强大的模型证明了“大道至简”的力量,是实现“一个模型解决所有问题”愿景的重要一步。

二,论文翻译

摘要

语言、视觉与多模态预训练领域正呈现大规模融合的趋势。本研究提出了通用多模态基础模型BEIT-3,其在视觉与视觉-语言任务上均实现了最先进的迁移性能。具体而言,我们从三个维度推动这一融合进程:主干网络架构、预训练任务和模型规模化。我们引入多路Transformer(Multiway Transformers)实现通用建模,其模块化架构同时支持深度融合与模态特异性编码。基于共享主干网络,我们以统一方式对图像(Imglish)、文本(English)以及图像-文本对(“平行语句”)执行掩码"语言"建模。实验结果表明,BEIT-3在目标检测(COCO)、语义分割(ADE20K)、图像分类(ImageNet)、视觉推理(NLVR2)、视觉问答(VQAv2)、图像描述生成(COCO)和跨模态检索(Flickr30K、COCO)任务上均取得了最先进的性能。

1、引言:大融合趋势

近年来,语言、视觉与多模态预训练领域呈现出大规模融合的趋势。通过在海量数据上进行大规模预训练,我们可以轻松地将模型迁移到各种下游任务中。构建一个能够处理多模态的通用基础模型具有重大意义。本研究从以下三个方面推动视觉-语言预训练的融合进程。

首先,Transformer架构成功从语言领域扩展到视觉和多模态领域。网络架构的统一使我们能够无缝处理多模态数据。针对视觉-语言建模,由于下游任务的性质差异,Transformer的应用方式多种多样:例如双编码器架构用于高效检索,编码器-解码器网络用于生成任务,融合编码器架构用于图像-文本编码。然而,现有基础模型通常需根据特定架构手动调整任务格式,且参数在多模态间未能有效共享。本研究采用多路Transformer实现通用建模,即使用统一架构处理各种下游任务。该模块化网络同时兼顾模态特异性编码与跨模态融合。

其次,基于掩码数据建模的预训练任务已成功应用于文本、图像和图像-文本对等多种模态。当前视觉-语言基础模型通常需联合训练其他预训练目标(如图文匹配),导致扩展性差且效率低下。与此相反,我们仅使用"掩码-预测"这一预训练任务来训练通用多模态基础模型。通过将图像视为"外语"(即Imglish),我们以统一方式处理文本和图像,消除了根本性的建模差异。图像-文本对由此成为学习模态间对齐的"平行语句"。实验证明,这种简洁而有效的方法能学习到强可迁移表征,在视觉和视觉-语言任务上均达到最先进性能,充分证明了生成式预训练的优越性。

第三,扩大模型规模和数据量能普遍提升基础模型的泛化能力,使其更好地迁移至下游任务。我们遵循这一理念,将模型参数量扩展至数十亿级别。同时,在仅使用公开可获取数据的前提下,我们扩大了预训练数据规模以保障学术可复现性。尽管未使用任何私有数据,我们的方法仍以明显优势超越依赖内部数据的最先进基础模型。这种扩展优势得益于将图像视为外语的策略,使我们能直接复用为大语言模型预训练开发的流程。

本研究综合上述思想,预训练出通用多模态基础模型BEIT-3。我们通过对图像、文本和图像-文本对进行掩码数据建模,训练多路Transformer。预训练过程中随机掩码部分文本标记或图像块,自监督学习目标是根据损坏的输入恢复原始标记(文本标记或视觉标记)。该模型的通用性体现在:无论输入模态或输出格式如何,都能适配各种任务。

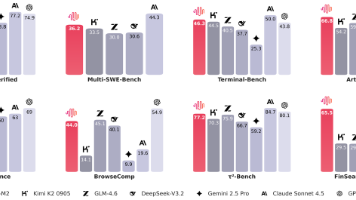

图1:与其他定制化模型或基础模型相比,BEIT-3在广泛任务中实现了最先进的性能。I2T/T2I是图像到文本/文本到图像检索(image-to-text/text-to-image retrieval)的缩写。

表1:BEIT-3在各种视觉与视觉-语言基准测试中的结果概览。我们与之前最先进的模型进行比较,包括FD-SwinV2、DINO、Mask DINO、FD-CLIP、CoCa、OFA、Florence等模型。对于检索任务,我们报告了图像到文本和文本到图像检索结果的Top-1平均值。"†“表示仅使用公开可获取资源的ImageNet结果,”‡"表示未经过CIDEr优化的图像描述生成结果。

如图1和表1所示,BEIT-3在广泛的视觉和视觉-语言任务中实现了最先进的迁移性能。我们在大量下游任务和数据集上进行了评估,包括:目标检测(COCO)、实例分割(COCO)、语义分割(ADE20K)、图像分类(ImageNet)、视觉推理(NLVR2)、视觉问答(VQAv2)、图像描述生成(COCO)以及跨模态检索(Flickr30K、COCO)。值得注意的是,尽管仅使用公开资源进行预训练和微调,我们的模型仍超越了之前强大的基础模型,甚至优于专用模型。此外,BEIT-3不仅在视觉-语言任务上表现优异,在视觉任务(如目标检测和语义分割)同样取得了卓越成果。

2、BEIT-3:通用多模态基础模型

如图2所示,BEIT-3通过共享的多路Transformer网络,在单模态和多模态数据上进行掩码数据建模预训练。该模型可迁移至各种视觉与视觉-语言下游任务。

2.1 主干网络:多路Transformer

我们采用多路Transformer作为主干网络来编码不同模态。如图2所示,每个多路Transformer块包含一个共享自注意力模块和一组用于不同模态的前馈网络(即模态专家)。我们根据输入标记的模态将其路由至相应的专家。具体实现中,每层包含一个视觉专家和一个语言专家,顶部三层还设有专为融合编码器设计的视觉-语言专家(详细结构布局见图3(a)(b)©)。使用模态专家池可促使模型捕获更多模态特异性信息,而共享自注意力模块则能学习不同模态间的对齐关系,并为多模态(如视觉-语言)任务实现深度融合。

图3:BEIT-3可迁移至各种视觉与视觉-语言下游任务。通过共享的多路Transformer,我们可以将模型重用作:(a)(b)视觉或语言编码器;©融合编码器——联合编码图像-文本对以实现深度交互;(d)双编码器——分别编码不同模态以实现高效检索;(e)序列到序列学习——用于图像到文本生成任务。

如图3所示,统一架构使BEIT-3能够支持广泛的下游任务。例如,BEIT-3可作为图像主干网络用于各种视觉任务,包括图像分类、目标检测、实例分割和语义分割;也可微调为双编码器用于高效图文检索,或作为融合模型处理多模态理解与生成任务。

2.2 预训练任务:掩码数据建模

我们通过统一的掩码数据建模目标,在单模态数据(即图像和文本)和多模态数据(即图像-文本对)上预训练BEIT-3。预训练过程中随机掩码部分文本标记或图像块,并训练模型恢复被掩码的标记。这种统一的"掩码-预测"任务不仅能学习表征,还能学习不同模态间的对齐关系。具体而言:

- 文本数据通过SentencePiece分词器进行标记化。

- 图像数据通过BEIT v2的标记器获取离散视觉标记作为重建目标。

- 对单模态文本随机掩码15%的标记,对图文对中的文本掩码50%的标记。

- 对图像采用块状掩码策略(如BEIT系列方法),掩码40%的图像块。

我们仅使用单一预训练任务,这使得训练过程更易于扩展。相比之下,以往的视觉-语言模型通常需要联合训练多个预训练任务(如图文对比学习、图文匹配、词-块/区域对齐等)。实验证明,采用"掩码-预测"任务时仅需更小的预训练批次大小,而基于对比学习的模型通常需要极大的批次大小,这会带来GPU内存成本等工程挑战。

2.3 规模化:BEIT-3预训练

主干网络 BEIT-3是遵循ViT-giant配置的超大规模基础模型。如表2所示,该模型采用40层多路Transformer结构,包含1408维隐藏大小、6144维中间层大小和16个注意力头。所有层均配备视觉专家和语言专家,顶部三层还增设视觉-语言专家。自注意力模块在不同模态间共享。BEIT-3总参数量达19亿,其中视觉专家6.92亿参数,语言专家6.92亿参数,视觉-语言专家0.52亿参数,共享自注意力模块3.17亿参数。需注意的是,当模型作为视觉编码器时,仅激活视觉相关参数(约10亿,与ViT-giant规模相当)。

表3:BEIT-3的预训练数据。所有数据均可在学术领域公开获取。

预训练数据 BEIT-3使用表3所示的单模态与多模态数据进行预训练。多模态数据包含从五个公开数据集收集的约1500万图像和2100万图文对:Conceptual 12M (CC12M)、Conceptual Captions (CC3M)、SBU Captions (SBU)、COCO和Visual Genome (VG)。单模态数据包括ImageNet-21K的1400万图像,以及来自英文维基百科、BookCorpus、OpenWebText、CC-News和Stories的160GB文本语料。

预训练设置 预训练进行100万步,每批次包含6144个样本(图像、文本和图文对各2048个)。该批次大小远小于对比学习模型。BEIT-3采用14×14图像块大小,在224×224分辨率下预训练,使用与BEIT相同的图像增强策略(包括随机缩放裁剪、水平翻转和颜色抖动)。文本数据采用词汇量64K的SentencePiece分词器处理。优化器使用AdamW(β1=0.9, β2=0.98, ε=1e-6),采用余弦学习率衰减策略(峰值学习率1e-3,线性预热1万步),权重衰减为0.05。使用0.1比率的随机深度正则化,并采用BEiT初始化算法以稳定Transformer训练。

3、视觉与视觉-语言任务实验

我们在主流公开基准上对BEIT-3进行了全面评估,涵盖视觉-语言和视觉两大任务范畴。表1展示了整体结果概览:BEIT-3在广泛的视觉与视觉-语言任务中均取得了最先进的性能表现。

3.1 视觉-语言下游任务

我们在广泛使用的视觉-语言理解与生成基准上评估BEIT-3的能力,包括视觉问答、视觉推理、图文检索和图像描述生成。

视觉问答(VQA)

表4:视觉问答、视觉推理与图像描述生成任务结果。我们在VQAv2测试开发集(test-dev)和测试标准集(test-standard)上报告vqa-score;在NLVR2开发集和公开测试集(test-P)上报告准确率;对于COCO图像描述任务,我们在Karpathy测试集划分上报告BLEU@4(B@4)、METEOR(M)、CIDEr(C)和SPICE(S)指标。为简化表述,此处报告的图像描述结果未使用CIDEr优化。

该任务要求模型回答关于输入图像的自然语言问题。我们在VQA v2.0数据集上开展微调实验,将其构建为分类问题:模型从训练集中最常出现的3129个候选答案中预测答案。BEIT-3作为融合编码器进行微调,建模图像与问题的深度交互。具体方法是将给定问题和图像的嵌入向量拼接后输入多路Transformer进行联合编码,最终池化输出送入分类器预测答案。如表4所示,BEIT-3以显著优势(超过1.7分)超越所有现有模型,将单模型性能推升至84.03的新高度。

视觉推理

该任务需要模型对图像和自然语言描述进行联合推理。我们在NLVR2基准上评估模型性能,其目标是判断文本描述是否与图像对相符。基于三元组输入构建两个图文对后,将BEIT-3作为融合编码器对图文对进行联合编码,两个池化输出拼接后送入分类器预测标签。如表4所示,BEIT-3在视觉推理任务上创造了新纪录,以约5.6分的优势超越CoCa模型,首次在NLVR2上实现90%以上的性能表现。

图像描述生成

该任务旨在为给定图像生成自然语言描述。我们在COCO数据集上采用Karpathy划分进行微调和评估。借鉴UNILM和s2s-ft方法,BEIT-3通过掩码微调作为条件生成模型:

-

使用特殊自注意力掩码:图像标记(图像块)在图像序列内双向注意力交互,描述标记可关注图像标记、左侧描述标记及自身。

-

微调时随机掩码部分描述标记,训练模型基于图像和左侧上下文恢复被掩码标记。

-

同时掩码边界标记[SEP]以学习生成终止机制。

采用简单交叉熵损失训练(未使用CIDEr优化),推理时通过自回归方式逐词生成描述。如表4所示,BEIT-3在仅使用交叉熵损失的模型中表现最优,创造了图像描述生成的新纪录,证明了其在视觉-语言生成任务中的卓越性能。

图文检索

该任务旨在衡量图像与文本之间的相似度,包含两个方向的检索:图像到文本检索(I2T)和文本到图像检索(T2I)。我们在两个主流检索基准(COCO和Flickr30K)上采用Karpathy划分进行评估。BEIT-3作为双编码器进行微调以实现高效图文检索:双编码器模型分别编码图像和文本获取表征后,通过计算余弦相似度得分实现检索。这种架构比融合编码器更高效,无需联合编码所有可能的图文对。

表5:COCO和Flickr30K数据集上图像到文本检索与文本到图像检索的微调结果。需要注意的是,对于检索任务,双编码器模型比基于融合编码器的模型具有更高的计算效率。

尽管未使用图文对比损失进行预训练,BEIT-3在COCO和Flickr30K上直接微调后仍超越之前的最优模型——仅需少量对比训练即可实现此效果,证明掩码数据建模能有效学习图文对齐关系。为提升性能,我们在预训练图文对上采用图文对比目标进行中间微调(步数远少于预训练),随后评估零样本和微调后的图文检索性能。微调结果如表5所示:双编码器BEIT-3以显著优势超越所有现有模型,在COCO的Top-1图像到文本/文本到图像检索上分别提升3.0/4.0个绝对百分点,在Flickr30K上分别提升0.8/2.4个绝对百分点。同时,BEIT-3显著优于基于融合编码器的模型(后者需要更高推理计算成本)。具体数据见表6。BEIT-3在Flickr30K零样本检索任务上也实现了优于之前所有模型的性能表现。

表6:Flickr30K数据集上的零样本图像到文本检索与文本到图像检索结果

3.2 视觉下游任务

除视觉-语言下游任务外,BEIT-3还可迁移至多种视觉下游任务,包括目标检测、实例分割、语义分割和图像分类。当作为视觉编码器使用时,其有效参数量与ViT-giant相当(约10亿参数)。

目标检测与实例分割

表7:COCO基准测试中目标检测与实例分割的结果。BEIT-3采用Cascade Mask R-CNN作为检测头,结果报告采用多尺度评估策略。我们标注了训练时使用的最大图像尺寸。需说明的是,FLOD-9M和FourODs数据集也包含Object365数据。对比系统的结果来自paperswithcode.com排行榜(统计截止时间:2022年8月22日)。

我们在COCO 2017基准上开展微调实验(含11.8万训练图像、5000验证图像和2万测试开发图像)。以BEIT-3为主干网络,采用ViTDet方法(包括简单特征金字塔和窗口注意力机制)处理目标检测与实例分割任务。遵循通用实践,先在Objects365数据集上进行中间微调,再在COCO数据集上微调,推理时使用Soft-NMS。如表7所示,BEIT-3在COCO测试开发集上以更小的微调图像尺寸取得最佳性能:达到63.7 box AP和54.8 mask AP。

语义分割

表8:ADE20K语义分割结果。"MS"是多尺度评估(multi-scale)的缩写。对比系统的结果来自paperswithcode.com 排行榜(统计截止时间:2022年8月22日)。

该任务旨在预测图像每个像素的类别标签。我们在ADE20K数据集(包含150个语义类别,2万训练图像和2000验证图像)上评估BEIT-3。直接采用ViT-Adapter的任务迁移设置,使用密集预测任务适配器并集成Mask2Former分割框架。如表8所示,BEIT-3以62.8 mIoU创造新纪录,较拥有30亿参数的FD-SwinV2巨型模型提升1.4个点,证明了其在密集预测任务上的卓越性能。

图像分类

表9:ImageNet-1K上的Top-1准确率

我们在ImageNet-1K(包含128万训练图像和5万验证图像,1000个类别)上评估模型。不同于传统视觉编码器追加任务层的做法,我们将该任务构建为图像-文本检索任务:使用类别名称作为文本构建图文对,以双编码器方式训练模型为图像寻找最相关标签。推理时通过计算图像特征与类别名称特征的余弦相似度来预测标签。如表9所示,先在ImageNet-21K上进行中间微调,再在ImageNet-1K上训练。在与仅使用公开图像-标签数据的模型公平对比中,BEIT-3超越所有现有模型,创造了该条件下的最新性能纪录。

四、结论

本文提出了BEIT-3,一种通用多模态基础模型,在广泛的视觉与视觉-语言基准测试中实现了最先进的性能。BEIT-3的核心思想是将图像视为一种“外语”,从而能够以统一的方式对图像、文本以及图像-文本对进行掩码“语言”建模。我们还证明了多路Transformer(Multiway Transformers)能够有效建模不同的视觉及视觉-语言任务,使其成为通用建模的一个理想选择。BEIT-3简洁高效,为扩展多模态基础模型指明了有前景的方向。在未来工作中,我们将致力于训练多语言版本的BEIT-3,并引入更多模态(如音频),以促进跨语言与跨模态迁移,推动任务、语言与模态的大规模预训练融合。我们还将探索结合BEIT-3与MetaLM的优势,为多模态基础模型赋予上下文学习能力。

为什么要学习大模型?

在科技飞速发展的当下,大模型已成为推动AI变革的核心引擎。2025年,大模型应用已经深入各行各业,从日常办公使用的DeepSeek、豆包、千问,到下游应用的自动驾驶/具身智能VLA,再到AIGC生成。大模型产业正经历技术普惠化、应用垂直化、生态开源化的深度变革,学习大模型成为把握人工智能革命主动权的关键。

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

普通人如何学习大模型

最近收到不少留言:

- 我是做后端开发的,能转大模型方向吗?

- 看了很多教程,怎么判断哪些内容是真正有用的?

- 自己尝试动手搭模型,结果踩了不少坑,是不是说明我不适合这个方向?

其实这些问题,我几年前也都经历过。

那时我还是一名传统后端工程师,对大模型一知半解。刚开始接触时也很迷茫,常常不知道从哪里下手、该学哪些内容才算“有用”,搭建模型时也是各种踩坑、反复重来。

但正是一步步摸索、不断试错,我才走到了今天,从0起步,成功转型为大模型开发者。

所以我想跟你说:问题不在你,而是在学习方法。

今天我就以“过来人”的身份,分享一份亲测有效的大模型学习资源。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

01. 大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

02. 大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

03. 大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

04. 大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献212条内容

已为社区贡献212条内容

所有评论(0)