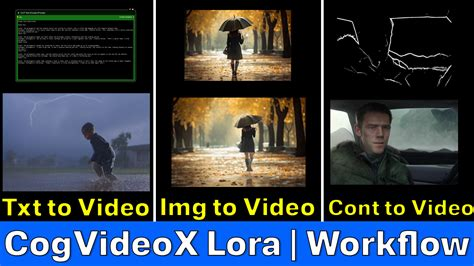

从Text到Video:多模态大模型在短视频营销中的应用

摘要:针对短视频营销面临创意产出慢、成本高、个性化难等痛点,利用多模态大模型实现文本到视频的智能生成。

·

背景与痛点

短视频平台的内容更新速度极快,营销人员往往需要在数小时甚至数分钟内完成创意策划、脚本撰写、素材拍摄、剪辑包装等全链路工作。传统流程面临:

- 创意产出瓶颈——文案到画面的转化依赖人工构思与拍摄。

- 成本高、周期长——专业摄制组、后期编辑费用不菲。

- 个性化难——同一产品需要针对不同受众生成多版本素材,人工难以规模化。

这些痛点正好与 多模态大模型 的 文本‑‑视频 能力相契合:只需提供结构化的营销文案或脚本,即可自动生成符合品牌调性的短视频片段,实现 “一键生成、快速迭代”。

技术原理概览

| 步骤 | 关键技术 | 参考文献 |

|---|---|---|

| 文本解析 | 使用 mT5‑XXL 或 Multimodal LLM 将营销文案转化为结构化脚本(场景、动作、情感标签) | |

| 跨模态对齐 | CLIP / GPT‑4V 将文本要素映射到视觉特征空间,实现 文本‑视觉语义对齐 | |

| 时序建模 | 采用 VideoDiT(基于 DiT 的时序注意力)或 Slow‑Fast Token 结构,生成连续帧的动态表示 | |

| 解码生成 | 3D VAE 解码器将视觉 token 还原为 720P、24fps 视频片段,支持 5‑10 秒 短视频输出 | |

| 后处理 | 自动配音、字幕、品牌水印(可调用 TTS 与 OCR)并输出 MP4 供平台直接发布。 |

注:图片来源网络

思考

| 经验 | 执行 |

|---|---|

| 脚本结构化 | 采用统一的 JSON schema(scene、action、object、emotion),便于模型复用与微调。 |

| 多模态对齐 | 在微调阶段加入 CLIP‑style 对齐损失,提升文本‑视觉一致性。 |

| 质量闭环 | 人工抽检 + 自动指标(SSIM、BLEU)双重过滤,确保目标不受低质量生成影响。 |

| 算力调度 | 将 VideoDiT 部署在 GPU‑8×(A100)节点,使用 Tensor Parallel 分片。 |

| 业务集成 | 将生成 API 封装为内部 REST 服务,营销系统直接调用,形成 “文案 → 脚本 → 视频” 的一键流。 |

实时交互:结合提示词工程(Prompt Engineering),可在 UI 中即时调节风格、配色、节奏,实现 “对话式生成”。

多语言扩展:利用 mT5‑XXL 的多语言能力,支持 中英双语 视频,打开海外市场。

跨模态广告:将生成的视频与 音频、交互式弹幕 进一步融合,打造沉浸式短视频广告。

通过 多模态大模型 的 Text‑to‑Video 能力,短视频营销可以实现高效、低成本、可规模化的内容生产闭环。

》》》 待完善。。。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)