【AI论文】当模型说谎时,我们亦能有所收获:基于PsiloQA的多语言跨度级幻觉检测

摘要:本研究推出PsiloQA数据集,针对大型语言模型(LLMs)在多语言环境下的幻觉检测难题,构建了覆盖14种语言的细粒度标注资源。通过自动化三阶段流程(问答对生成、多模型答案收集、GPT-4o跨度级标注)创建数据集,相比人工标注显著降低成本。实验表明,微调后的编码器模型(如mmBERT)在多语言场景表现最优,且PsiloQA展现出优异的跨语言泛化能力。当前局限包括单一标注源偏差和任务类型覆盖不

摘要:幻觉检测对于大型语言模型(LLMs)安全可靠地部署而言仍是一项基础性挑战,尤其是在需要事实准确性的应用场景中。现有的幻觉检测基准通常在序列层面进行操作,且仅限于英语,缺乏全面评估所需的细粒度、多语言监督。在本研究中,我们推出了PsiloQA数据集,这是一个大规模、多语言的数据集,涵盖了14种语言,并标注了跨度级(span-level)的幻觉信息。PsiloQA通过一个自动化的三阶段流程构建而成:首先,利用GPT-4o从维基百科生成问答对;其次,在无上下文的环境中,从各种大型语言模型中引出可能存在幻觉的答案;最后,通过将答案与标准答案及检索到的上下文进行对比,利用GPT-4o自动标注出存在幻觉的跨度。我们评估了多种幻觉检测方法,包括不确定性量化、基于大型语言模型的标注以及微调后的编码器模型,结果表明,基于编码器的模型在各种语言上均取得了最佳性能。此外,PsiloQA展示了有效的跨语言泛化能力,并支持稳健地向其他基准进行知识迁移,同时其成本效益显著高于人工标注的数据集。我们的数据集和研究成果推动了多语言环境下可扩展、细粒度幻觉检测的发展。Huggingface链接:Paper page,论文链接:2510.04849

研究背景和目的

研究背景:

随着大型语言模型(LLMs)在各种文本生成任务中的广泛应用,如摘要生成、翻译和问答系统,其产生的幻觉(即生成与事实不符的信息)问题日益凸显。

这些幻觉不仅影响了模型的可靠性,还在对安全性要求极高的领域(如医学)中带来了潜在危害。现有的幻觉检测基准通常在序列级别进行操作,且主要限于英语,缺乏多语言环境下的细粒度监督,这使得全面评估幻觉检测方法变得困难。因此,开发一个能够支持多语言、细粒度幻觉检测的数据集和评估方法成为迫切需求。

研究目的:

本研究旨在通过构建一个大规模、多语言的幻觉检测数据集PsiloQA,解决现有幻觉检测方法在多语言环境和细粒度检测上的不足。

具体目标包括:

- 引入一个自动化且可扩展的数据集生成和标注流程,以降低人工标注的成本和时间。

- 提供一个支持14种语言、标注了细粒度跨度级别幻觉的数据集,以促进多语言幻觉检测方法的研究和评估。

- 评估不同类型幻觉检测方法在多语言环境下的性能,推动更可靠、更安全的LLMs部署。

研究方法

本研究采用了一系列系统化的方法来构建PsiloQA数据集,并评估不同幻觉检测方法的性能。

主要研究方法包括以下几个方面:

1. 数据集构建流程:

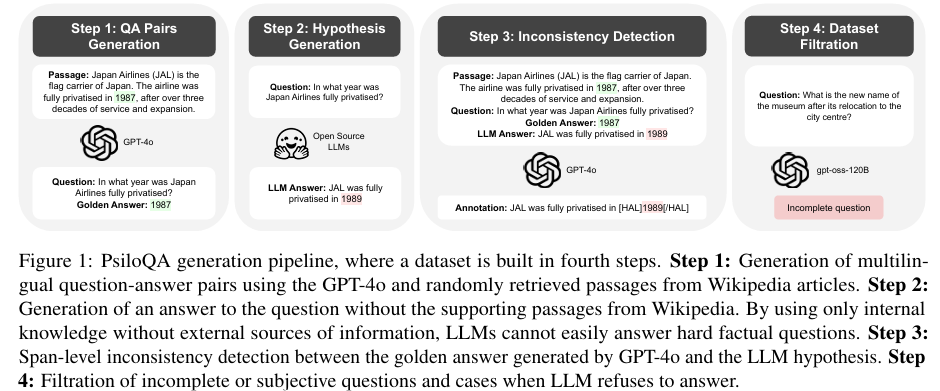

PsiloQA数据集的构建通过一个自动化的三阶段流程完成:

- 问题-答案对生成:利用GPT-4o从维基百科文章中生成多语言的问题-答案对。通过控制问题的复杂度(简单、中等、困难),生成多样化的问题。

- 假设生成:在无上下文的环境下,使用多种LLMs生成问题的答案,这些答案可能包含幻觉。

- 不一致性检测与标注:通过比较LLMs生成的答案与GPT-4o生成的标准答案及检索到的上下文,自动标注出包含幻觉的跨度。使用GPT-4o进行跨度级别的不一致性检测,并标记出幻觉部分。

2. 数据集过滤与质量控制:

- 基于规则的过滤:移除标注不一致、空跨度或与初始LLM答案不一致的样本。

- 基于提示的过滤:移除主观性问题、不完整问题及LLM拒绝回答的情况。使用gpt-oss-120B模型进行提示驱动的过滤。

3. 幻觉检测方法评估:

评估了多种幻觉检测方法,包括:

- 不确定性量化(UQ)方法:如Maximum Token Probability (MaxProb)、Claim Conditioned Probability (CCP) 和 Focus。

- 基于编码器的模型:如ModernBERT和mmBERT,通过微调这些模型来检测细粒度幻觉。

- 基于LLM的方法:如FActScore和Qwen2.5-32B-Instruct,利用外部知识或少量样本学习来检测幻觉。

4. 跨语言迁移与知识转移:

- 跨语言迁移:比较了在完整多语言PsiloQA数据集上训练的mmBERT模型与在各语言子集上单独训练的模型的性能,以评估跨语言泛化能力。

- 知识转移:评估了在不同数据集(如PsiloQA和RAGTruth)上训练的模型在其他基准测试上的泛化性能。

研究结果

1. 数据集统计与质量:

- PsiloQA数据集包含63,792个训练样本和2,897个测试样本,覆盖14种语言。

- 英语样本最多,接近23,000个,其他语言样本数量在5,000到7,000之间不等。

- 手动验证研究显示,GPT-4o在幻觉跨度标注上表现出较高的准确率(AP为84.3%,IoU为71.0%)。

2. 幻觉检测方法性能:

- 不确定性量化方法:Focus方法在所有语言中表现最佳,但IoU分数仍然较低,表明在跨度级别检测上存在局限性。

- 基于编码器的模型:微调后的mmBERT模型在所有语言中表现最优,显示出多语言预训练对于跨语言幻觉检测的重要性。

- 基于LLM的方法:FActScore在某些语言中表现出色,但IoU性能较差;Qwen2.5-32B-Instruct在特定语言中表现优异,但整体IoU分数适中。

3. 跨语言迁移与知识转移:

- 在完整多语言PsiloQA数据集上训练的mmBERT模型在跨语言泛化上表现更好,甚至在语言脚本和家族不同的语言中也表现出色。

- PsiloQA数据集在知识转移实验中表现优于RAGTruth,尽管其生成成本显著低于RAGTruth的人工标注成本。

研究局限

1. 标注源偏差:

PsiloQA数据集完全依赖于GPT-4o进行问题-答案对生成和幻觉跨度标注,这可能引入标注偏差。

单个模型的判断可能无法全面反映广泛共识或适应各种使用场景。

2. 任务狭窄性:

当前版本的PsiloQA仅限于问答任务,而其他生成任务(如摘要、对话和数据到文本生成)同样存在幻觉问题,需要类似的处理。

3. 幻觉类型覆盖不足:

与注入控制幻觉类型的数据集(如FAVA)不同,PsiloQA中的幻觉自然产生于LLMs的错误,可能导致幻觉类型分布不均,某些错误类型代表性不足。

4. 语言资源不平衡:

尽管覆盖14种语言,但样本分布不均,低资源语言的高质量样本较少。

此外,许多基线方法主要针对英语进行优化,可能低估其他语言的性能。

5. 依赖维基百科:

使用维基百科作为唯一上下文来源限制了数据集的主题、风格和文化多样性。

维基百科的覆盖不均可能导致模型继承这些偏差,影响实际应用中的泛化能力。

未来研究方向

1. 减少标注源偏差:

未来的工作可以考虑使用多个先进模型的集成来进行标注,通过跨模型投票或平均来减少单个模型的偏差,提高标注的多样性和准确性。

2. 扩展任务类型:

将PsiloQA的构建流程扩展到其他生成任务,如摘要、对话和数据到文本生成,以提供更全面的幻觉检测基准。

3. 增强幻觉类型覆盖:

设计方法以生成和控制更多样化的幻觉类型,确保数据集能够全面覆盖各种可能的幻觉情况,提高模型的鲁棒性。

4. 平衡语言资源:

增加低资源语言的高质量样本,优化非英语语言的基线方法,确保所有语言在评估中得到公平对待。

5. 多样化数据来源:

引入更多样化的数据来源,如新闻文章、社交媒体和专业领域文本,以增加数据集的多样性和文化包容性,提高模型在实际应用中的泛化能力。

更多推荐

已为社区贡献164条内容

已为社区贡献164条内容

所有评论(0)