[论文阅读] AI+软件工程(安全) | LLM 与专业经验对Web应用安全需求评估的影响

本研究旨在探究LLM使用和专业软件开发经验对网络应用安全需求评估的影响。通过对23名研究生的分组实验,结合MoSCoW优先级法和8项评估标准,运用非参数检验进行数据分析。结果表明,LLM使用对评估无显著影响,而专业经验对成本、用户体验、风险评估有显著作用。研究填补了相关领域空白,强调了专业经验在 cybersecurity 决策中的重要性,为软件工程领域的人才培养和实践工作提供了有价值的参考。

LLM 与专业经验对Web应用安全需求评估的影响

论文信息

- 论文原标题:Selecting Cybersecurity Requirements: Effects of LLM Use and Professional Software Development Experience

- 主要作者及研究机构:来自卢布尔雅那大学计算机与信息科学学院的研究者团队

arXiv:2510.04274

Selecting Cybersecurity Requirements: Effects of LLM Use and Professional Software Development Experience

Damjan Fujs, Damjan Vavpotič, Tomaž Hovelja, Marko Poženel

Comments: 5 pages, 1 figure, 2 tables, presented at IARIA CYBER 2025

Journal-ref: The Tenth International Conference on Cyber-Technologies and Cyber-Systems (CYBER 2025), September 28, 2025 to October 02, 2025 - Lisbon, Portugal

Subjects: Software Engineering (cs.SE)

一段话总结

该研究以23名卢布尔雅那大学计算机与信息科学学院的研究生为对象,探究大型语言模型(LLM)使用和专业软件开发经验对网络应用安全需求(SR)优先级排序及评估的影响。参与者被分为两组(实验组12人可使用LLM,对照组11人不可使用),通过MoSCoW方法对15个SR进行优先级划分(筛选2个“Must-have”、2个“Should-have”、2个“Could-have”),并基于8项标准进行5分制评估。结果显示,Mann-Whitney U检验表明LLM使用对SR评估无显著差异(H1不成立) ,而Kruskal-Wallis检验显示专业经验对“估计开发成本(EC)”“用户体验影响(UX)”“未实现风险(RM)”3项标准有显著影响(H2部分成立) :经验更丰富的参与者对UX影响评分更高、风险估计更低,且能更准确估计成本。研究最终为软件工程领域的后续实证研究提供指导,强调了从业者专业经验在 cybersecurity 决策中的重要性。

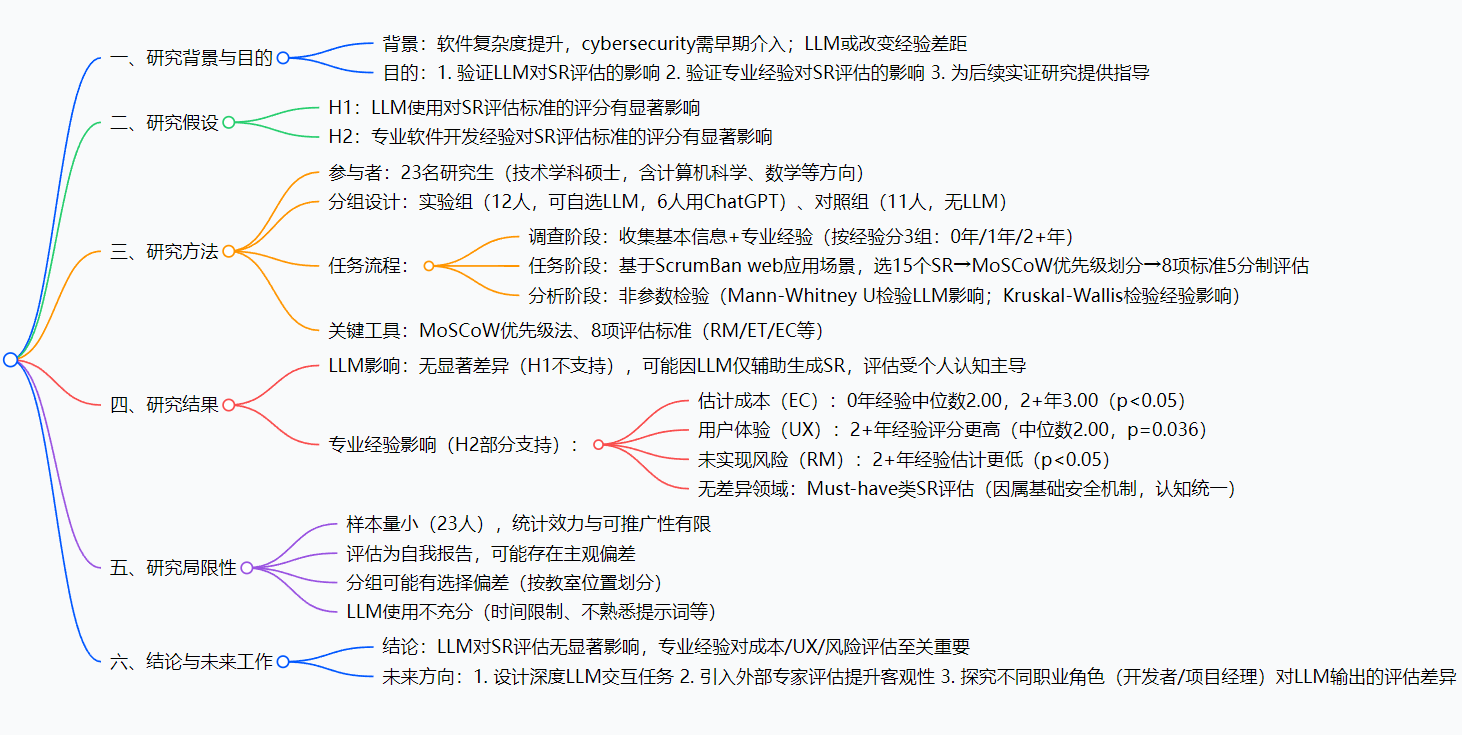

思维导图

研究背景

在当下数字化时代,软件就像我们生活中的“基础设施”,小到手机里的社交APP,大到企业的管理系统,复杂度都在不断飙升。而网络安全,就像是软件的“防盗门”,必须在开发早期就考虑周全,否则一旦出现漏洞,可能会导致用户信息泄露、系统瘫痪等严重问题。

以前,大家普遍认为,有经验的开发人员在评估软件安全需求时会更靠谱,毕竟他们见过更多“坑”。但随着大型语言模型(LLM)的兴起,不少人猜测,LLM或许能像“外挂”一样,帮助经验不足的人也做出准确的安全评估,缩小经验差距。就像新手厨师跟着智能菜谱可能做出不错的菜一样,新手开发者是不是用了LLM就能在安全评估上媲美老手呢?可现实中,这个问题一直没有明确答案,现有研究要么只看LLM的作用,要么只关注经验,却没人把两者放在一起好好研究。这篇论文就是为了填补这个空白,看看LLM和专业经验到底谁对网络应用安全需求评估影响更大。

创新点

- 双变量研究视角:突破以往单一变量研究的局限,首次将LLM使用和专业软件开发经验作为两个关键变量,共同探究它们对网络应用安全需求评估的影响,更贴近实际开发场景。

- 聚焦准从业者群体:选择研究生作为研究对象,他们既有一定理论基础,又即将进入职场,研究结果对行业人才培养和实际工作具有更强的参考价值,避免了仅研究新手或老手的片面性。

- 多维度评估体系:不仅采用MoSCoW方法划分安全需求优先级,还从“未实现风险”“估计成本”“用户体验影响”等8个维度进行评估,让研究结果更全面、更具说服力。

研究方法和思路、实验方法等

1. 参与者与分组

- 参与者:23名卢布尔雅那大学计算机与信息科学学院的研究生,均参与过“高级软件开发方法”课程,有ScrumBan web应用开发基础。

- 经验分组:根据“非教育类专业软件开发年限”分为3组:0年(10人)、1年(6人)、2+年(7人)。

- LLM分组:实验组(12人)可自选LLM(6人用ChatGPT,2人用DeepSeek等);对照组(11人)不可使用LLM。

2. 任务设计(3个阶段)

| 阶段 | 核心内容 | 关键细节 |

|---|---|---|

| 调查阶段 | 知情同意+信息收集 | 收集基本信息和专业软件开发经验 |

| 任务阶段(2小时) | 选SR→优先级划分→评估 | 1. 从ScrumBan web应用场景中选15个安全需求(SR); 2. 用MoSCoW法选2个“Must-have”(必须有)、2个“Should-have”(应该有)、2个“Could-have”(可以有),剩余9个为“Won’t have”(暂不有); 3. 基于8项标准对选中的SR进行5分制评估 |

| 分析阶段 | 数据统计与检验 | 用Mann-Whitney U检验比较LLM组与对照组差异,用Kruskal-Wallis检验比较不同经验组差异,报告中位数和p值 |

3. 8项SR评估标准(5分制)

| ID | 评估项 | 1分(最低) | 5分(最高) |

|---|---|---|---|

| RM | 未实现风险 | 风险极小 | 严重安全风险 |

| ET | 估计时间 | <1小时 | >10小时 |

| EC | 估计成本 | 无成本(易实现) | 高成本(需外部工具/专家) |

| TC | 技术复杂度 | 极简单(无需研究) | 极复杂(需重构/专业知识) |

| UX | 用户体验影响 | 几乎无影响 | 高影响 |

| SV | 安全价值 | 极小安全收益 | 应用安全必需 |

| CP | 生产环境必要性 | 无需上线 | 上线前必需 |

| AL | 滥用可能性 | 极不可能 | 极可能(无此功能时) |

主要成果和贡献

主要成果(表格归纳)

| 研究问题(RQ) | 研究方法 | 结论 |

|---|---|---|

| RQ1:LLM使用对SR评估有何影响? | Mann-Whitney U检验(LLM组vs对照组) | 无显著差异(H1不成立) |

| RQ2:专业经验对SR评估有何影响? | Kruskal-Wallis检验(不同经验组) | 对“估计开发成本(EC)”“用户体验影响(UX)”“未实现风险(RM)”有显著影响(H2部分成立) |

核心价值

这篇研究的厉害之处在于,它用实实在在的实验打破了“LLM能轻松提升安全评估能力”的幻想。对于企业来说,以后不能指望靠LLM就让新手开发者独立完成重要的安全评估,还是得重视老员工的经验传承;对于学校来说,培养计算机专业学生时,要更注重实践经验的积累,不能只依赖AI工具。而且,研究还指出了专业经验具体在哪些方面起作用,比如经验丰富的人能更准确估计成本、更关注用户体验、更理性判断风险,这为针对性培养开发者的安全评估能力提供了方向。

详细总结

一、引言(研究背景、假设与贡献)

-

研究背景

- 软件开发动态性增强,需结构化决策;随着系统复杂度与AI融合提升,cybersecurity需在开发早期介入,但决策仍以人为主导。

- 现有认知:专业经验可能提升决策有效性(文献支持[4]),但Agentic AI或可承担部分cybersecurity决策([5]),需验证LLM是否缩小经验差距。

-

研究假设

- H1:LLM使用对参与者评估SR的8项标准有显著影响。

- H2:专业软件开发经验对参与者评估SR的8项标准有显著影响。

-

研究贡献

- C1:实证表明LLM对研究生的cybersecurity决策影响有限,不显著改变SR优先级与评估结果。

- C2:验证专业经验显著影响SR评估(成本、UX、风险),强调从业者经验对cybersecurity策略的重要性。

二、相关工作(现有研究缺口)

| 研究者(年份) | 研究内容 | 核心结论 |

|---|---|---|

| Ronanki et al.(2023) | ChatGPT辅助需求获取 | ChatGPT生成的需求质量高于人类需求工程专家 |

| Krishna et al.(2024) | LLM生成软件需求规格说明书 | LLM输出质量可媲美入门级软件工程师 |

| Perry et al.(2023) | AI辅助代码编写与安全性 | 使用AI助手的参与者编写的代码安全性更低(过度依赖风险) |

| Jalali et al.(2019) | 专业经验与cybersecurity决策 | 未发现专业经验显著影响cybersecurity决策的明确证据 |

| 本研究 | LLM+专业经验对SR评估的影响 | 填补“LLM与经验如何共同影响SR优先级/评估”的研究缺口 |

三、研究方法(实验设计与流程)

-

参与者与分组

- 样本:23名研究生(卢布尔雅那大学,技术学科硕士项目,含计算机科学、数学、多媒体方向),均参与“高级软件开发方法”课程,有ScrumBan web应用开发基础(含登录功能的安全实现经验)。

- 分组:

- 实验组(N=12):可自选LLM(6人用ChatGPT,2人用DeepSeek,2人用Gemini,1人用Perplexity,1人用Claude);

- 对照组(N=11):无LLM使用权限。

- 经验分组:基于“非教育类专业软件开发年限”分为3组——0年(N=10)、1年(N=6)、2+年(N=7) 。

-

任务设计(3阶段)

阶段 核心内容 关键细节 调查阶段 知情同意+信息收集 收集基本信息、专业经验(问题:“非教育类专业软件开发年限”) 任务阶段(2小时) 1. 选SR→2. 优先级划分→3. 评估 1. 基于ScrumBan web应用,选15个SR;

2. 用MoSCoW法选2个“Must-have”、2个“Should-have”、2个“Could-have”,剩余9个为“Won’t have”;

3. 基于8项标准(表1)进行5分制评估分析阶段 数据统计与检验 用Mann-Whitney U检验(LLM组vs对照组)、Kruskal-Wallis检验(经验组间比较),报告中位数与p值 -

8项SR评估标准(5分制)

表1:SR评估标准详情ID 评估项(Item) 1分(最低) 5分(最高) RM 未实现风险 风险极小 严重安全风险 ET 估计时间 <1小时 >10小时 EC 估计成本 无成本(易实现) 高成本(需外部工具/专家) TC 技术复杂度 极简单(无需研究) 极复杂(需重构/专业知识) UX 用户体验影响 几乎无影响 高影响 SV 安全价值 极小安全收益 应用安全必需 CP 生产环境必要性 无需上线 上线前必需 AL 滥用可能性 极不可能 极可能(无此功能时)

四、结果与讨论

-

LLM使用的影响(H1验证)

- 结论:H1不成立——Mann-Whitney U检验显示,LLM组与对照组在8项评估标准上均无显著差异(p>0.05)。

- 原因分析:

- LLM仅辅助生成SR,未影响参与者对自身方案的评估(评估基于自我认知,而非LLM反馈);

- 研究生缺乏行业经验,难以批判性评估SR质量,导致两组评估趋同;

- 实验组可自主选择是否使用LLM,未强制使用,可能存在LLM利用不充分的情况。

-

专业经验的影响(H2验证)

- 结论:H2部分成立——Kruskal-Wallis检验显示,仅3类评估项(EC、UX、RM)存在显著差异(p<0.05),且仅“Should-have”和“Could-have”类SR有差异,“Must-have”类无差异(因属基础安全机制,认知统一)。

- 显著差异详情(表2):

表2:专业经验对SR评估的显著影响(中位数与p值)ID 评估项 经验分组(中位数) p值 核心发现 S1 EC 估计成本 0年:2.00;1年:2.50;2+年:3.00 0.010 经验越丰富,成本估计越准确(无经验者低估) S1 UX 用户体验影响 0年:1.00;1年:1.00;2+年:2.00 0.036 2+年经验者对UX影响评分更高(更关注用户体验) S2 RM 未实现风险 0年:4.00;1年:4.00;2+年:3.00 0.049 2+年经验者风险估计更低(更了解风险边界) C1 RM 未实现风险 0年:3.00;1年:2.00;2+年:3.00 0.003 经验组间风险认知差异显著(p<0.01) C2 EC 估计成本 0年:1.50;1年:2.50;2+年:2.00 0.018 无经验者显著低估成本(与S1 EC一致)

五、研究局限性

- 样本量有限:仅23人,统计效力低,结果可推广性受限。

- 主观偏差:评估为自我报告,参与者可能依赖直觉而非系统分析,结果准确性受影响。

- 分组偏差:按教室位置分组(前11人对照组,后12人实验组),可能聚类相似特征(如学术能力),影响组间可比性。

- LLM利用不充分:参与者可能因时间限制、不熟悉提示词或怀疑工具价值,未充分发挥LLM功能。

六、结论与未来工作

-

核心结论

- LLM对研究生评估SR无显著影响,暂无法缩小经验差距;

- 专业软件开发经验显著影响成本、UX、风险评估,是cybersecurity决策的关键因素。

-

未来研究方向

- 设计需深度LLM交互的任务,更精准评估LLM对SR评估的影响;

- 引入外部专家评估或同行评审,提升SR评估的客观性;

- 探究不同职业角色(如开发者、项目经理、利益相关者)对LLM输出的评估差异。

4. 关键问题

问题1:该研究中LLM的使用为何未对参与者评估网络应用安全需求(SR)产生显著影响?核心原因有哪些?

答案:研究通过Mann-Whitney U检验发现,LLM使用对SR的8项评估标准均无显著影响(H1不成立),核心原因包括3点:

- LLM的角色定位有限:LLM仅被用于辅助生成15个SR,未参与后续评估环节,而参与者的评估基于对自身方案的自我认知(如个人经验、信心),而非LLM的反馈;

- 参与者经验不足:23名参与者均为研究生,缺乏正式行业经验,难以批判性评估SR的质量(如技术复杂度、实际风险),导致无论是否使用LLM,评估逻辑与结果趋同;

- LLM使用非强制:实验组可自主选择是否使用LLM,未被强制要求依赖工具,可能存在部分参与者未充分使用LLM(如不熟悉提示词、时间限制),削弱了LLM对评估的潜在影响。

问题2:专业软件开发经验对参与者评估SR的哪些具体维度有显著影响?不同经验组的评估差异具体表现为何?

答案:通过Kruskal-Wallis检验,专业经验仅对3类评估维度(估计成本EC、用户体验影响UX、未实现风险RM)有显著影响(p<0.05),且仅“Should-have”和“Could-have”类SR存在差异(“Must-have”类因属基础安全机制,认知统一),具体差异如下:

- 估计成本(EC):经验越丰富,成本估计越准确——0年经验组中位数仅2.00(S1 EC)/1.50(C2 EC),2+年经验组中位数达3.00(S1 EC)/2.00(C2 EC),无经验者显著低估开发成本(如忽视预算、资源分配或集成复杂度);

- 用户体验影响(UX):经验更丰富者更关注UX——2+年经验组对S1 UX的中位数评分(2.00)显著高于0年/1年组(均为1.00),反映其在安全需求设计中更重视用户体验与安全性的平衡;

- 未实现风险(RM):经验更丰富者风险估计更理性——2+年经验组对S2 RM的中位数评分(3.00)低于0年/1年组(均为4.00),因他们更了解实际场景中的风险边界,避免过度估计风险。

问题3:该研究在方法设计上存在哪些关键局限性?这些局限性可能如何影响研究结果的可靠性与可推广性?

答案:研究存在4项关键局限性,对结果的可靠性与可推广性产生显著影响:

- 样本量过小:仅23人参与,统计检验的效力低(如非参数检验对样本量敏感),难以排除偶然因素,结果可能无法推广到更大规模的开发者群体(如行业从业者);

- 评估方式主观:SR评估为自我报告,参与者可能依赖直觉或 heuristics(而非系统分析),且可能存在“社会期望偏差”(如高估自身方案的安全价值),导致评估结果准确性下降;

- 分组存在选择偏差:按教室位置分组(前11人对照组,后12人实验组),未采用随机抽样,可能聚类相似特征(如学术能力强的学生集中在某一组),破坏组间可比性,影响LLM影响结论的可靠性;

- LLM使用不充分:参与者未被强制使用LLM,且可能因时间限制(2小时任务)、不熟悉提示词技巧或怀疑工具价值,未充分发挥LLM功能,导致无法真实评估LLM对SR评估的潜在作用,可能低估LLM的实际影响。

总结

本研究旨在探究LLM使用和专业软件开发经验对网络应用安全需求评估的影响。通过对23名研究生的分组实验,结合MoSCoW优先级法和8项评估标准,运用非参数检验进行数据分析。结果表明,LLM使用对评估无显著影响,而专业经验对成本、用户体验、风险评估有显著作用。研究填补了相关领域空白,强调了专业经验在 cybersecurity 决策中的重要性,为软件工程领域的人才培养和实践工作提供了有价值的参考。

更多推荐

已为社区贡献51条内容

已为社区贡献51条内容

所有评论(0)